爬取《政府工作报告》词云展示并做词频统计

爬取《政府工作报告内容代码:

from requests import *

from bs4 import BeautifulSoup

r=get("http://www.hgnu.edu.cn/2020/0531/c1112a61314/page.htm",timeout=10)

r.encoding="utf-8"

s=BeautifulSoup(r.text,"html.parser")

f=open("报告.txt","w",encoding="utf-8")

L=s.find_all("p")

for c in L:

f.write("{}\n".format(c.text))

f.close()

词云展示:

引用图:

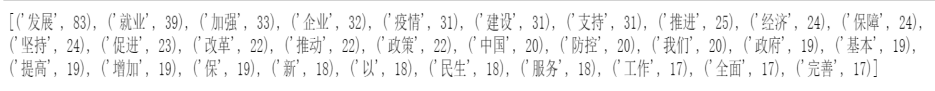

词频统计

import re

import collections # 词频统计库

import numpy as np # numpy数据处理库

import jieba # 结巴分词

import wordcloud # 词云展示库

from PIL import Image # 图像处理库

import matplotlib.pyplot as plt # 图像展示库

# 读取文件

fn = open("C:/python/pythonchengxu/报告.txt","r",encoding="utf-8")

string_data = fn.read()

fn.close()

# 文本预处理

# 定义正则表达式匹配模式

pattern = re.compile(u'\t|,|/|。|\n|\.|-|:|;|\)|\(|\?|"')

string_data = re.sub(pattern,'',string_data) # 将符合模式的字符去除

# 文本分词

# 精确模式分词

seg_list_exact = jieba.cut(string_data,cut_all=False)

object_list = []

# 自定义去除词库

remove_words = [u'的',u'要', u'“',u'”',u'和',u',',u'为',u'是',

'以' u'随着', u'对于', u'对',u'等',u'能',u'都',u'。',

u' ',u'、',u'中',u'在',u'了',u'通常',u'如果',u'我',

u'她',u'(',u')',u'他',u'你',u'?',u'—',u'就',

u'着',u'说',u'上',u'这', u'那',u'有', u'也',

u'什么', u'·', u'将', u'没有', u'到', u'不', u'去']

for word in seg_list_exact:

if word not in remove_words:

object_list.append(word)

# 词频统计

# 对分词做词频统计

word_counts = collections.Counter(object_list)

# 获取前30最高频的词

word_counts_top30 = word_counts.most_common(30)

print(word_counts_top30)

# 词频展示

# 定义词频背景

mask = np.array(Image.open('E:/An3/2.png'))

wc = wordcloud.WordCloud(

font_path='C:\\Windows\\Fonts\\msyh.ttc',# 设置字体

mask = mask,# 背景图设置

background_color="white",#设置背景图颜色

width=1600, height=1200,#设置长宽

max_words=300,# 最多显示词数

max_font_size=100,min_font_size=4)# 字体最大最小值

wc.generate_from_frequencies(word_counts)# 从字典生成词云

image_colors = wordcloud.ImageColorGenerator(mask)# 从背景图建立颜色方案

wc.recolor(color_func=image_colors) # 将词云颜色设置为背景图方案

plt.figure(dpi=300)# 通过分辨率放大或缩小图片

plt.imshow(wc)# 显示词云

plt.axis('off') # 关闭坐标轴

plt.show() # 显示图像

词频统计结果:

本文介绍了如何使用Python爬取《政府工作报告》,进而生成词云展示,并进行了词频统计,展示了统计结果。

本文介绍了如何使用Python爬取《政府工作报告》,进而生成词云展示,并进行了词频统计,展示了统计结果。

1223

1223

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?