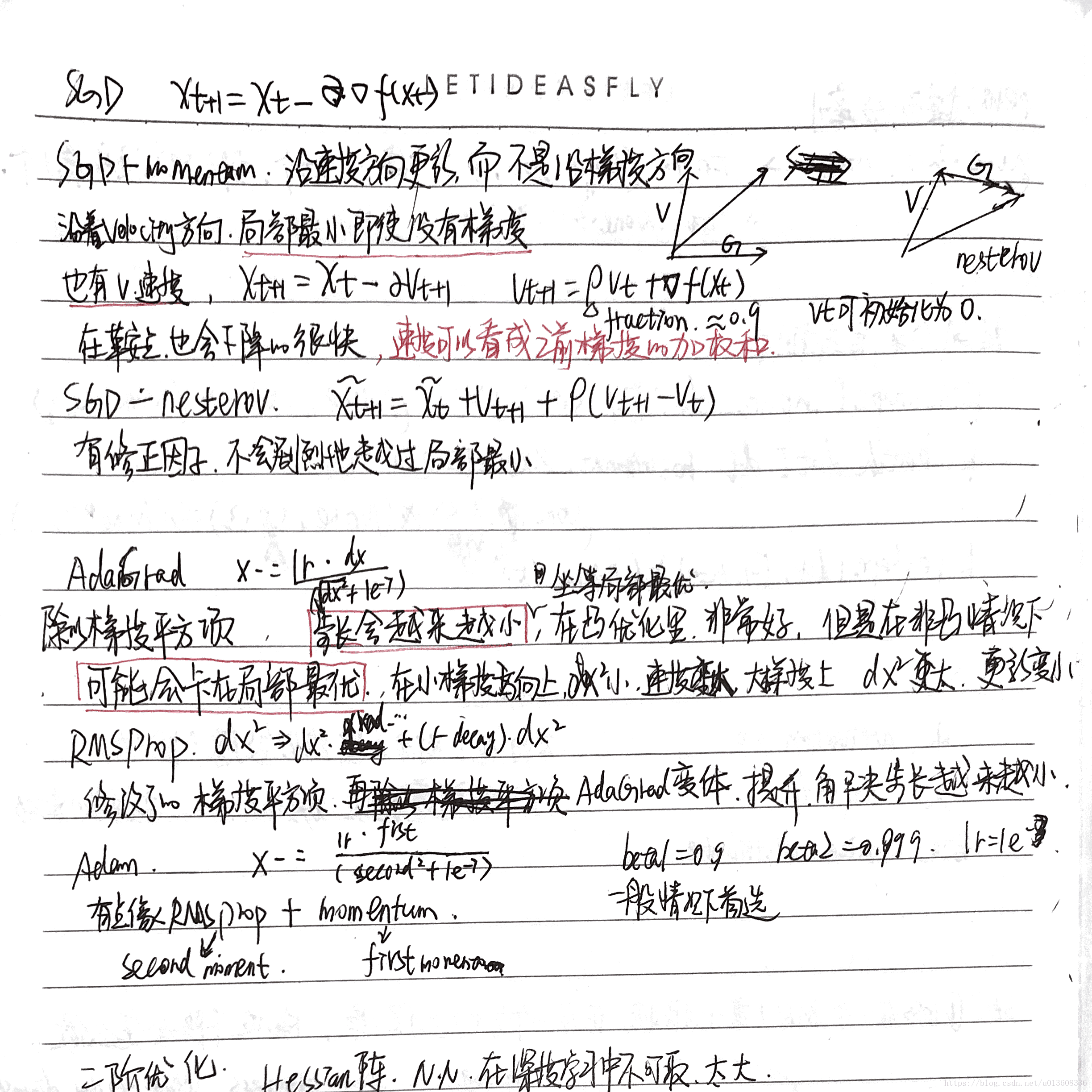

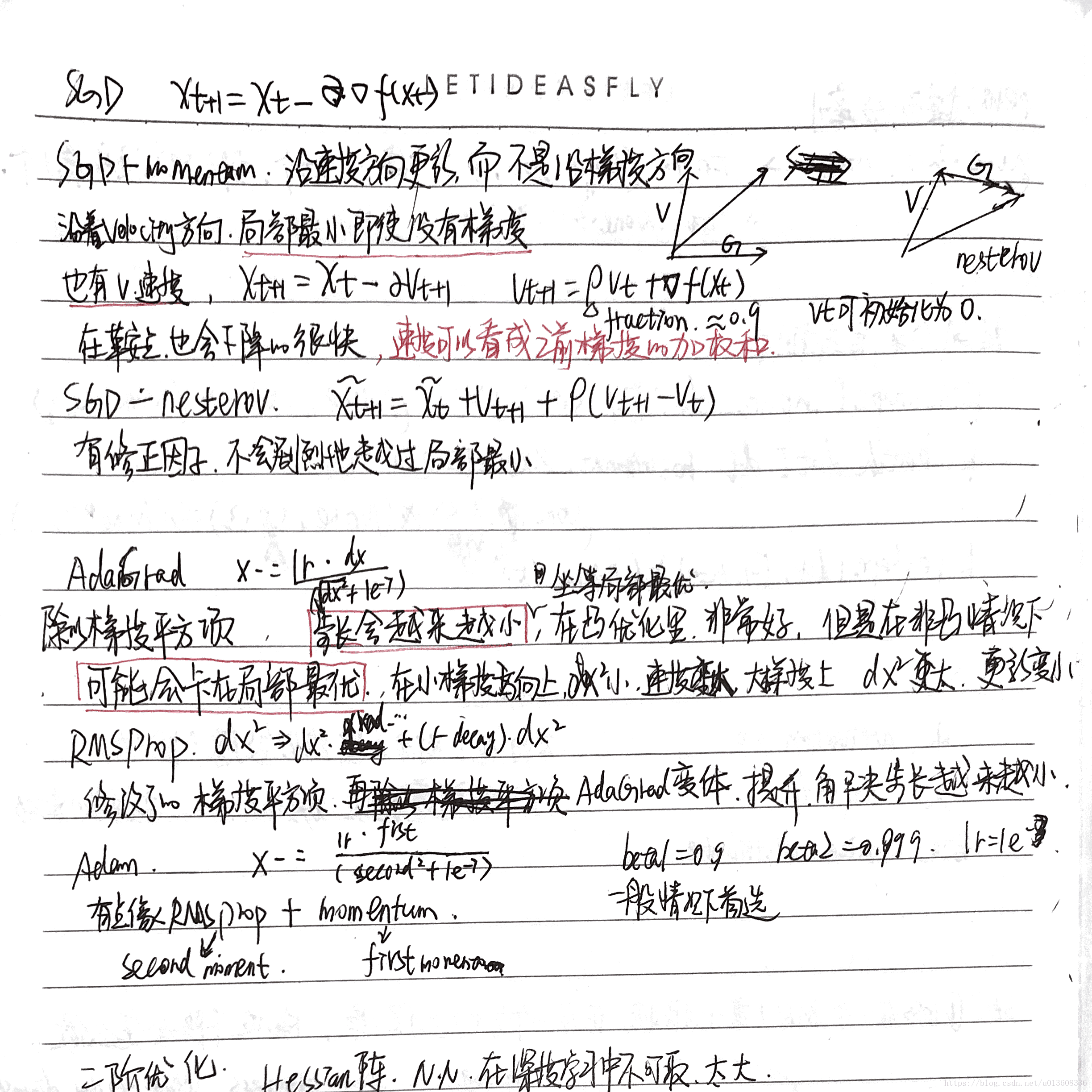

SGD: 沿梯度方向更新

SGD+momentum : 沿速度方向更新,而不是沿梯度方向更新

AdaGrad : 除以梯度平方项。步长会越来越小,可能会卡再局部最优

RMSProp:修改了AdaGrad的梯度平方项,解决步长越来越小的问题

Adam : 相当于Rms prop + momentum

评论

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?

查看更多评论

添加红包

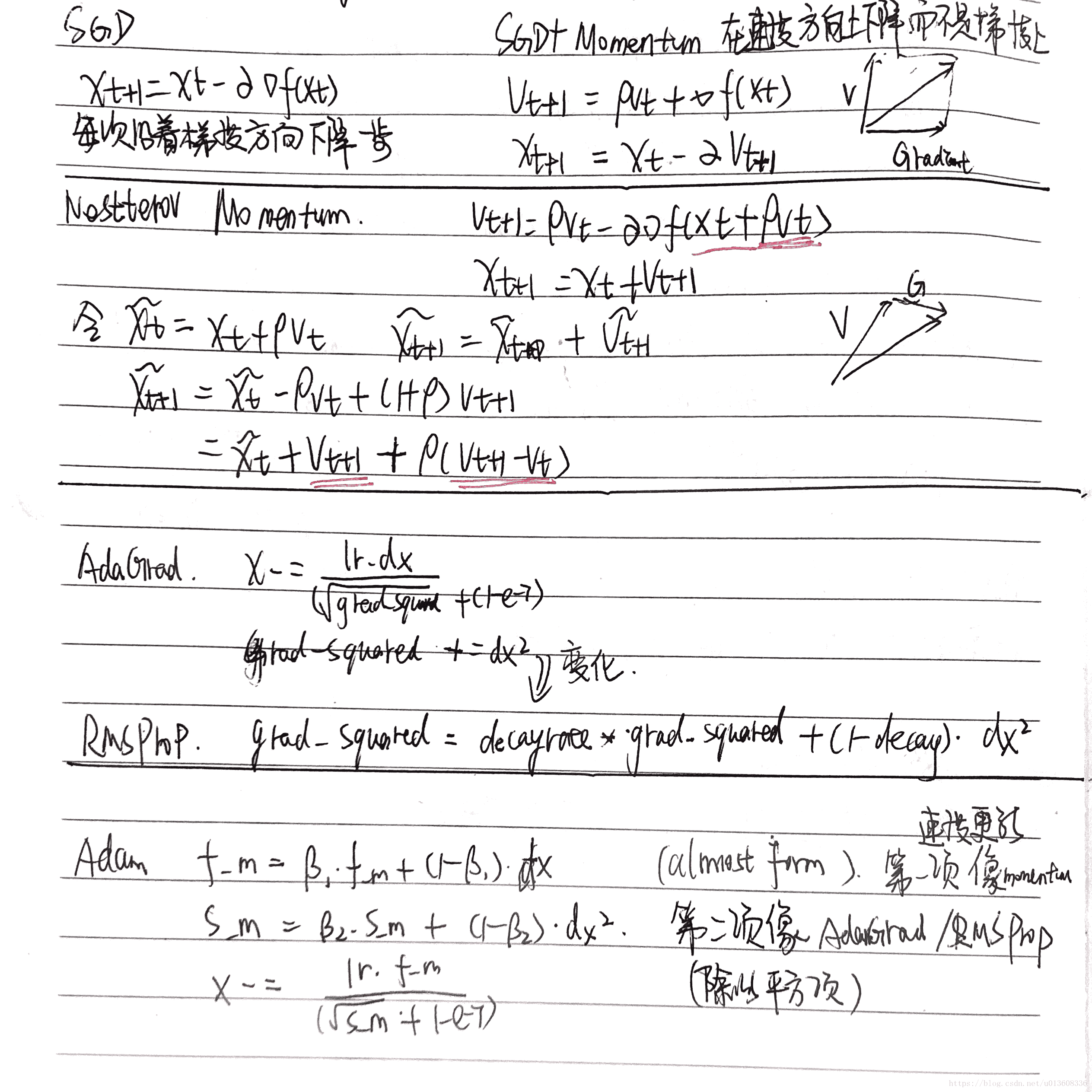

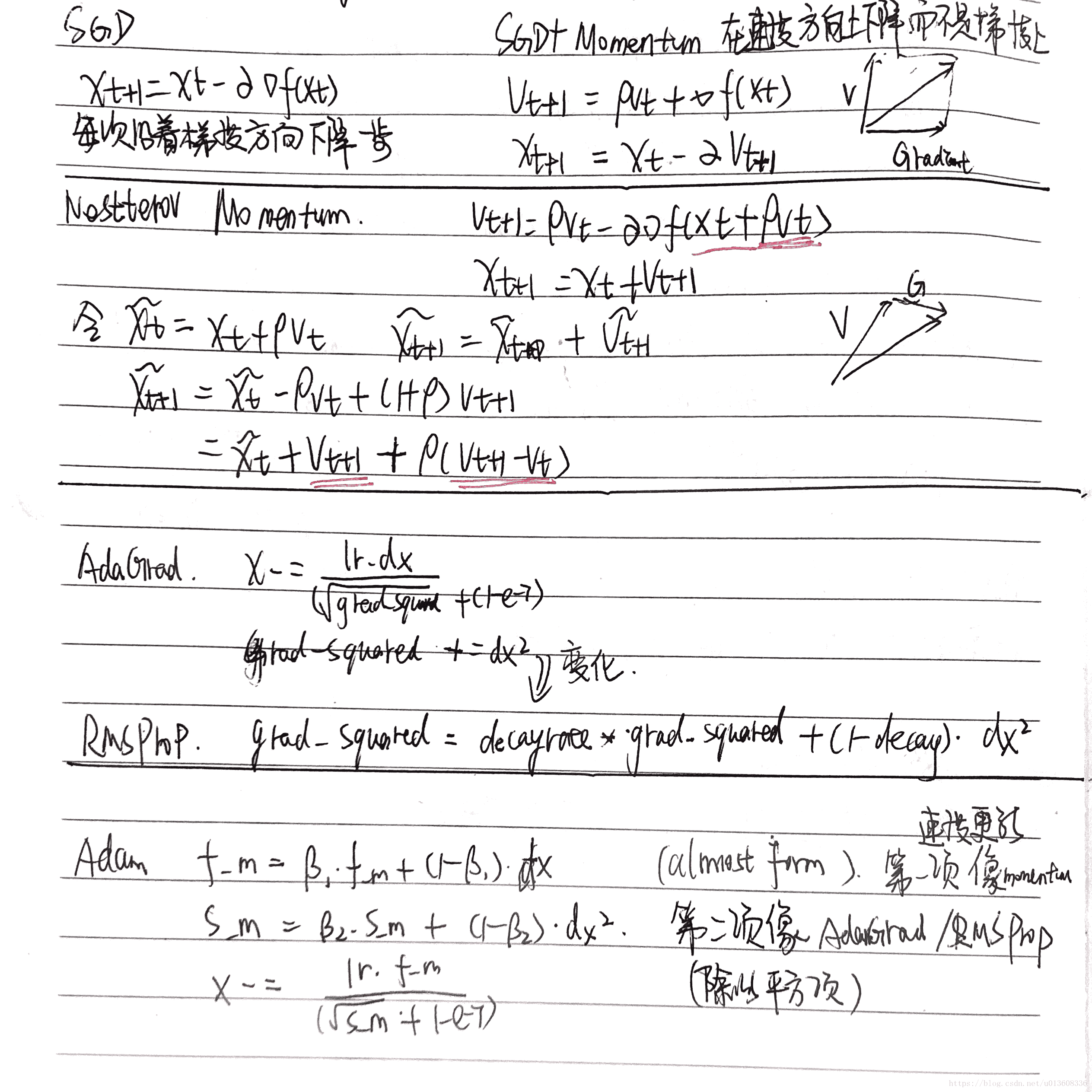

SGD: 沿梯度方向更新

SGD+momentum : 沿速度方向更新,而不是沿梯度方向更新

AdaGrad : 除以梯度平方项。步长会越来越小,可能会卡再局部最优

RMSProp:修改了AdaGrad的梯度平方项,解决步长越来越小的问题

Adam : 相当于Rms prop + momentum

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?