1、用nvidia-smi也好,top也好都找不到kill掉的进程了,但是显存仍然占用没有被释放,怎么办呢?毕竟top也找不到进程号呀

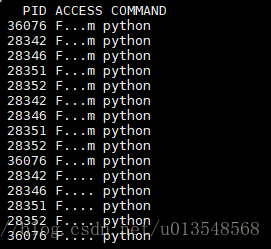

用以下指令查找出top没有而他有的进程

fuser -v /dev/nvidia*

逐个kill掉top中不显示的进程就可以了

2、pytorch杀不干净

ps aux|grep lk|grep python|awk '{print $2}'|xargs kill

3、更加暴力的方法是直接删除该用户的所有的进程

killall -u usrname

这时候该用户的所有进程都没了

4、也可以用下面的命令找出僵尸进程

ps aux | grep username

本文介绍了当GPU显存被占用但无法通过常规方式找到占用进程时的解决方法。提供了几种实用的命令来查找和终止这些进程,包括使用fuser命令定位到具体的设备文件并逐个kill掉top中不显示的进程、使用ps和kill组合命令来专门针对PyTorch进程进行清理以及采用更为激进的方法如killall命令等。

本文介绍了当GPU显存被占用但无法通过常规方式找到占用进程时的解决方法。提供了几种实用的命令来查找和终止这些进程,包括使用fuser命令定位到具体的设备文件并逐个kill掉top中不显示的进程、使用ps和kill组合命令来专门针对PyTorch进程进行清理以及采用更为激进的方法如killall命令等。

2755

2755

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?