Bounding Box是目标检测中一个重要概念。常见格式是边界框左上角坐标、右下角坐标,即[xmin,ymin,xmax,ymax];或者边界框中心坐标,宽高,即[x_center,y_center,w,h]。

Bounding Box Regression的作用

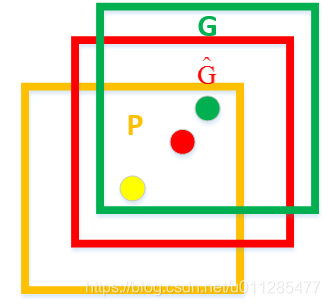

以下图为例,红色框表示Ground Truth, 蓝色框为网络输出的候选区域框Region Proposal。蓝色框被分类器识别为person,但因框定位不准(IoU<阈值), 则也是检测失败。 Bounding Box Regression的目的就是对蓝色框微调,使得经过微调后的窗口跟真实边界框更接近[1]。

如何进行Bounding Box Regression

以四维向量(x,y,w,h) 表示的Bounding Box为例, 即窗口的中心点坐标[x,y]和宽高[w,h]。P=表示原始的Region Proposal, G=

表示Ground Truth,Bounding Box Regression的目标是寻找一种函数关系使得输入原始的窗口 P 经过映射得到一个跟真实窗口G更接近的回归窗口

。[2]

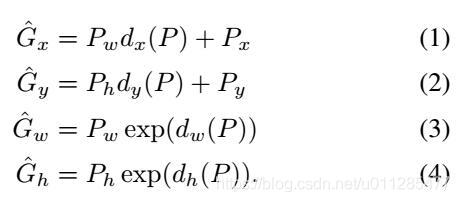

P通过线性变换得到,对x,y做平移,对w,h做缩放。

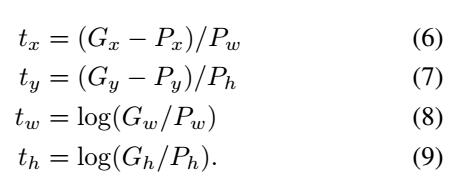

边框回归就是学习这四个变换。RCNN中,对P经过pool5的特征层学习一个线性变换,参数为

。最后网络输出

。该回归任务的target

如下:

参考资料:

[1]边框回归(Bounding Box Regression)详解

[2]Rich feature hierarchies for accurate oject detection and semantic segmentation

本文深入解析BoundingBox回归在目标检测中的作用及其实现方法。详细介绍了从候选区域到精确边界框的调整过程,以及如何通过线性变换实现边界框的微调。

本文深入解析BoundingBox回归在目标检测中的作用及其实现方法。详细介绍了从候选区域到精确边界框的调整过程,以及如何通过线性变换实现边界框的微调。

4617

4617

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?