一、部署前准备

1. 硬件要求

-

最低配置:8GB RAM + 4GB显存(GPU加速)

-

推荐配置:16GB RAM + 8GB显存(NVIDIA显卡)

-

纯CPU模式需要至少16GB内存(速度较慢)

2. 版本选择建议

| 模型类型 | 推荐版本 | 适用场景 | 硬件要求 |

| 基础版 | deepseek-7b-v1.5 | 通用问答/文本生成 | 8GB显存 |

| 量化版 | deepseek-7b-q4_0 | 低显存设备(4-6GB显存) | 4GB显存 |

| 中量级 | deepseek-13b-v1.5 | 复杂逻辑推理 | 12GB显存 |

| 最新版 | deepseek-7b-chat-v2 | 对话场景优化 | 8GB显存 |

二、部署步骤

1. 安装Ollama

-

命令行安装

# Linux一键安装

curl -fsSL https://ollama.com/install.sh |

sh # Windows(需管理员权限启动PowerShell):

winget install ollama.ollama

-

使用安装包进行安装 https://ollama.com/

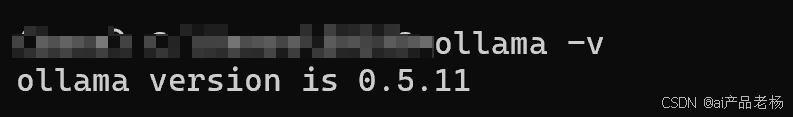

安装完后,验证是否安装成功:

“win+r”输入cmd

命令行输入如下:

ollama -v

能显示ollama版本说明安装成功。

-

修改models文件夹路径(可选)

模型默认会下载到: C:\Users\你的用户名\.ollama 目录下的 models文件夹

如果想修改模型的存放位置,做如下配置:

步骤1:拷贝models文件夹到你指定的目录,比如我剪切到

步骤2:添加环境变量

右键“我的电脑”,选择“属性”,按如下方式配置:

步骤3:重启Ollama客户端生效

注意:修改完之后,需要重启Ollama客户端,右键图标,选择退出,重新运行Ollama

验证是否生效:重新运行Ollama之后,重新打开命令行,输入命令 ollama list 查看

2. 下载模型

-

选择r1模型 https://ollama.com/library/deepseek-r1

b代表10亿参数量,7b就是70亿参数量。

这里的671B是 HuggingFace 经过4-bit 标准量化的,所以大小是404GB。

这里我们以7B为例,大多数的电脑都能够运行起来。

3. 启动模型服务

在命令行中,输入如下命令:

ollama run deepseek-r1:7b

首次运行会下载对应模型文件:

下载完成后,自动进入模型,直接在命令行输入问题,即可得到回复。

三、使用方式

1. 命令行交互

# 直接输入问题

>>> 请用Python写一个快速排序算法

# 流式输出控制

按 Ctrl+C 停止生成

2. API调用

curl http://localhost:11434/api/generate -d '

{ "model": "deepseek-r1:8b",

"prompt": "hello",

"stream": false

}'

3. 参数调节

# 示例Python调用

import requests

response = requests.post(

"http://localhost:11434/api/generate",

json={

"model": "deepseek-r1:8b",

"prompt": "写一篇关于AI伦理的短文",

"options": {

"temperature": 0.8, # 创造性(0-1)

"num_predict": 500, # 最大输出长度

"top_p": 0.9 # 输出多样性

}

}

)

4. 使用客户端工具

https://github.com/deepseek-ai/awesome-deepseek-integration/blob/main/README_cn.md

此处以Cherry Studio为例

Cherry Studio的下载地址:https://cherry-ai.com/

以Cherry Studio为例访问8b的蒸馏模型:

四、进阶配置

1. 多GPU分配

# 指定使用两个GPU

OLLAMA_NUM_GPU=2 ollama run deepseek-13b-v1.5

2. 自定义模型配置

创建 Modelfile:

FROM deepseek-7b-q4_0

PARAMETER temperature 0.5

PARAMETER num_ctx 4096

SYSTEM "你是一个专业的技术助手"

构建自定义模型:

ollama create my-deepseek -f Modelfile

五、常见问题解决

-

显存不足:

-

使用量化版本:

deepseek-7b-q4_0 -

添加

--num_gpu 20参数限制显存使用比例

-

-

中文支持:

ollama run deepseek-7b-chat-v2 --system "你使用简体中文回答" -

性能监控:

watch -n 1 "nvidia-smi | grep 'Default'"

六、技术支持

遇到部署问题可扫码添加技术专家

[备用联系方式:WeChat ID: Celeste_Jq]

1785

1785

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?