Flink 提交jar,报错no class Configuration not find

最新推荐文章于 2025-01-07 15:19:01 发布

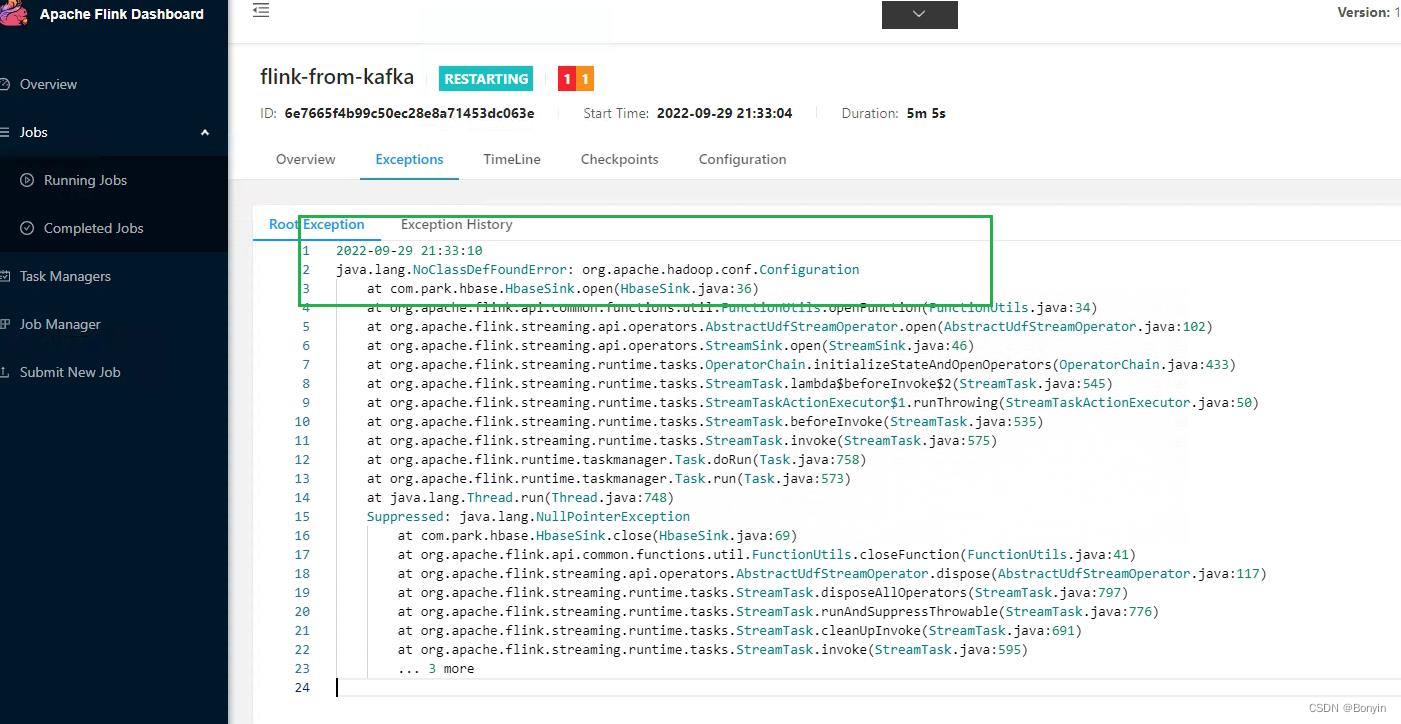

博客内容描述了在使用Flink将数据sink到Hbase时遇到的错误,以及解决问题的两个步骤:配置环境变量和替换特定的jar包。重点在于Uber jar与非Uber jar的区别,作者指出Uber jar解决了问题,但未详细说明具体差异。

博客内容描述了在使用Flink将数据sink到Hbase时遇到的错误,以及解决问题的两个步骤:配置环境变量和替换特定的jar包。重点在于Uber jar与非Uber jar的区别,作者指出Uber jar解决了问题,但未详细说明具体差异。

1251

1251

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?