ELK+Kafka+Beats实现海量日志收集平台(三)

目录

六、将日志数据存储到Elasticsearch

通过前面的步骤实现了日志数据的生产、收集和过滤。接下来就将收集之后的日志数据信息持久化到ElasticSearch上,然后在结合Kibana最终显示。

启动ElasticSearch集群,之前提供的ES集群安装链接是7.6.2版本,所以要自己替换版本到6.6.0进行安装,6.6.0的安装配置和7.6.2版本的有些区别,配置信息如下:

搭建好之后的信息如下:

Elasticsearch Head 插件显示如下:

七、Kibana展示

启动Kibana,进如Kibana安装过后的目录下使用如下命令启动

nohup ../bin/kibana &

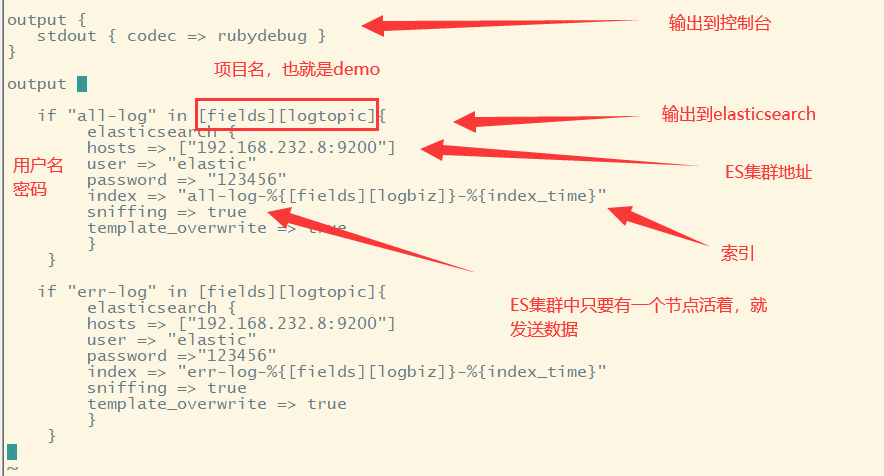

紧接着来修改一下logstash的配置文件,在之前的基础上我们将收集到的日志数据输出控制台上了,现在我们要将日志数据存储到ES集群上。打开logstash配置文件添加如下:

在配置文件中,配置了输出到Elasticsearch上。重启logstash,可以看到启动日志输出如下表明logstash连接ES成功。

接着通过访问 /err 、/index两个方法来产生日志信息,随后利用Elasticsearch head插件查看ES集群信息如下:

发现建立了两个索引,err-log-demo-* 、all-log-demo-* 这两个索引分别就是之前设置的错误日志索引和全量日志索引。

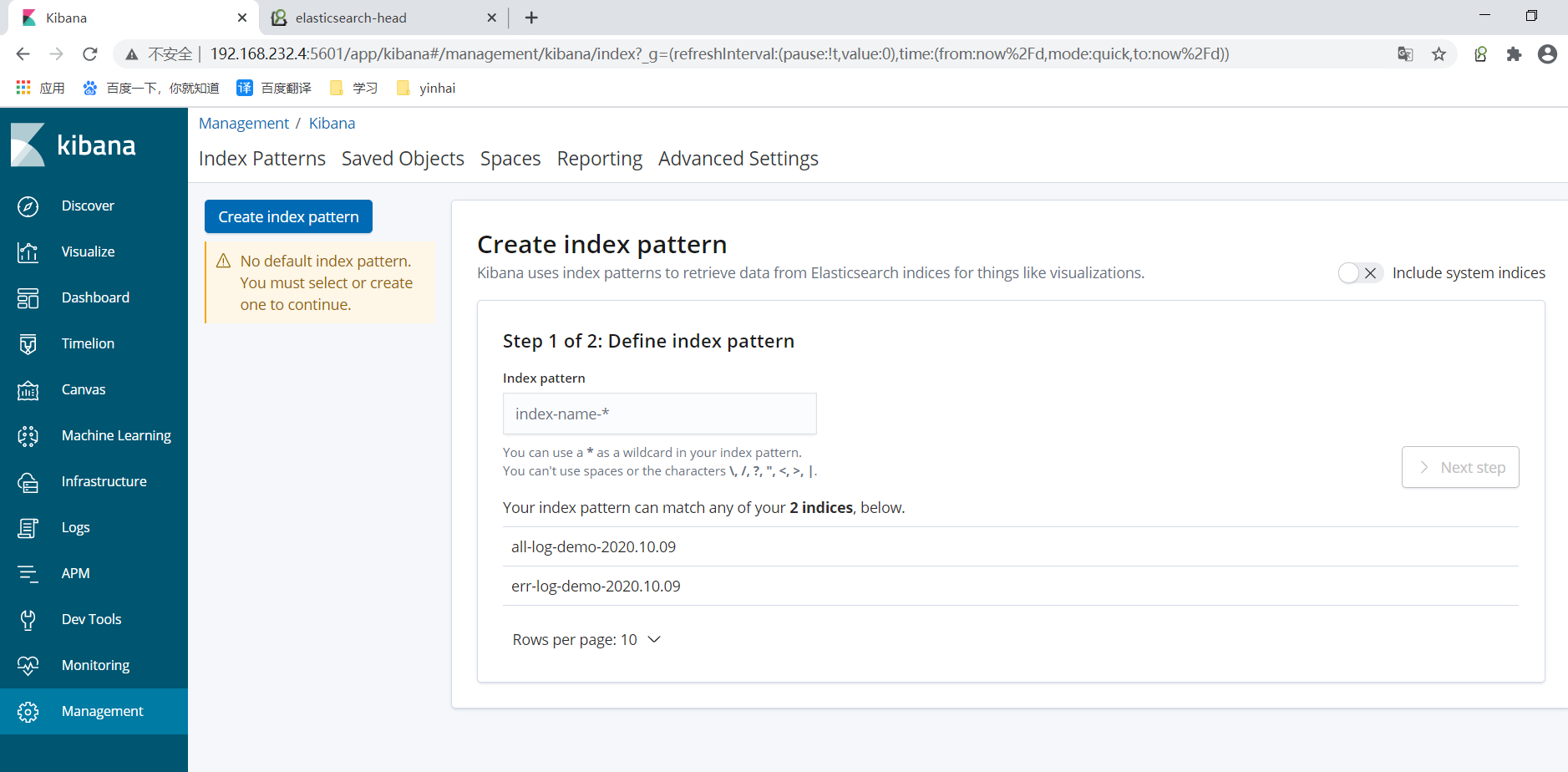

再进入到Kibana界面查看,安装下列步骤进入界面

随后,看到如下界面:

创建index,比如all-log-demo* 如果有对应的索引就会进行匹配

接着下一步:

同理创建err-log-demo*,随后按照如下操作进行查看:

查看的是err-log-demo*,这里其实就记录了我们访问demo.jar 的 /err 方法产生的那条错误日志。

至此,咋们的ELK环境搭建及日志收集彻底实现了。

本文详细介绍如何使用ELK+Kafka+Beats搭建日志收集平台,包括配置Elasticsearch集群、Kibana展示及Logstash日志处理流程。

本文详细介绍如何使用ELK+Kafka+Beats搭建日志收集平台,包括配置Elasticsearch集群、Kibana展示及Logstash日志处理流程。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?