最近,AIM 评测了在计算机上本地运行大语言模型(LLM)的最佳工具,Ollama 脱颖而出,成为最高效的解决方案,提供了无与伦比的灵活性。Ollama 是 Jeffrey Morgan 开发的一款开源工具,它正在彻底改变爱好者在本地终端上运行大语言模型的方式。

Ollama 具有友好的用户界面,并与 LLaMA 2 和 Mistral 等流行模型兼容,希望安全、经济、高效地进行大语言模型实验的用户可以轻松考虑使用 Ollama。它能让用户利用先进人工智能模型的力量,而无需依赖云服务或昂贵的硬件。

AIM 通过在 Linux (Pop!_OS)、macOS 和 Windows 等多个操作系统上运行多个大语言模型对 Ollama 进行了测试,以便让读者全面了解这款实用工具。

Ollama:在本地快速运行大语言模型的工具

奥拉马运行猎鹰 2 号

奥拉马运行猎鹰 2 号

虽然它是在终端上本地运行大语言模型的最快解决方案,但如果你不习惯这样做,也可以使用图形用户界面,但它需要一些额外的步骤(大多数基本用户都希望避免这些步骤)。

Ollama 可以直接从其库中获取大量大语言模型,只需执行一条命令即可下载。下载完成后,只需执行一条命令即可开始使用。这对那些工作负荷主要围绕终端窗口的用户很有帮助。如果他们在某个地方卡住了,无需切换到另一个浏览器窗口就能得到答案。

在 Linux 上使用 Ollama 时,我们发现其开发人员采用了一种令人惊讶的方法。当你执行安装脚本时,它会自行处理所有 GPU 驱动程序,无需额外步骤。

另一方面,我们发现 macOS 的安装程序是三个平台中最精致的,因为它非常易于浏览和使用。当然,你最终必须切换到终端,但它带你进入终端的方式非常流畅。

不过,如果你想通过图形用户界面使用 Ollama,可以使用 Open Web UI。但它只能通过 Docker 容器安装,这对于不熟悉容器概念的用户来说可能会很麻烦。

AIM 指出,Ollama 唯一的缺点是没有提供官方文档,说明如何使用已经下载的大语言模型。

模型最重要

最肯定的是,使用像 Ollama 这样的最小实用工具在本地运行大语言模型,会让你比其他工具更有优势,但归根结底,你使用的是什么模型最重要。

例如,我们在 Ollama 上并排使用了 Llama 2 和 Llama 3,结果让我们大吃一惊。

在 Ollama 中运行 llama2 和 llama3

在 Ollama 中运行 llama2 和 llama3

正如您所看到的,Llama 2 在几秒钟内就开始回答我们的问题,而 LLaMA 3 则花了很长时间,但却针对给定的标准给出了令人信服的详细答案。我们在多个实用工具上测试了 LLaMA 2,但 Llama + 终端给出的结果最快,因此我们得出结论:在终端中使用时,Ollama 的速度最快。

此外,如果你尝试加载一个超出你的规格所能承受的非常大的模型,就像其他工具一样,Ollama 将无法加载给定的模型。更可悲的是,它甚至不会通知你 Ollama 已经停止加载模型。

解决这个问题的唯一办法就是密切关注系统资源。当你看到资源消耗突然下降时,说明 Ollama 加载模型失败,你可以停止整个过程(否则会无休止地显示加载动画)。

总之,我们发现 Ollama 灵活而快速。它既能让你使用图形用户界面,又能在终端中快速响应,可谓一举两得。不过,如果你想使用一些简单的工具,我们很快就会向你介绍 Jan,这是一款能让你在本地运行大语言模型的工具,可以让你事半功倍。

AI大模型应用怎么学?

这年头AI技术跑得比高铁还快,“早学会AI的碾压同行,晚入门的还能喝口汤,完全不懂的等着被卷成渣”!技术代差带来的生存压力从未如此真实。

兄弟们如果想入门AI大模型应用,没必要到处扒拉零碎教程,我整了套干货大礼包:从入门到精通的思维导图、超详细的实战手册,还有模块化的视频教程!现在无偿分享。

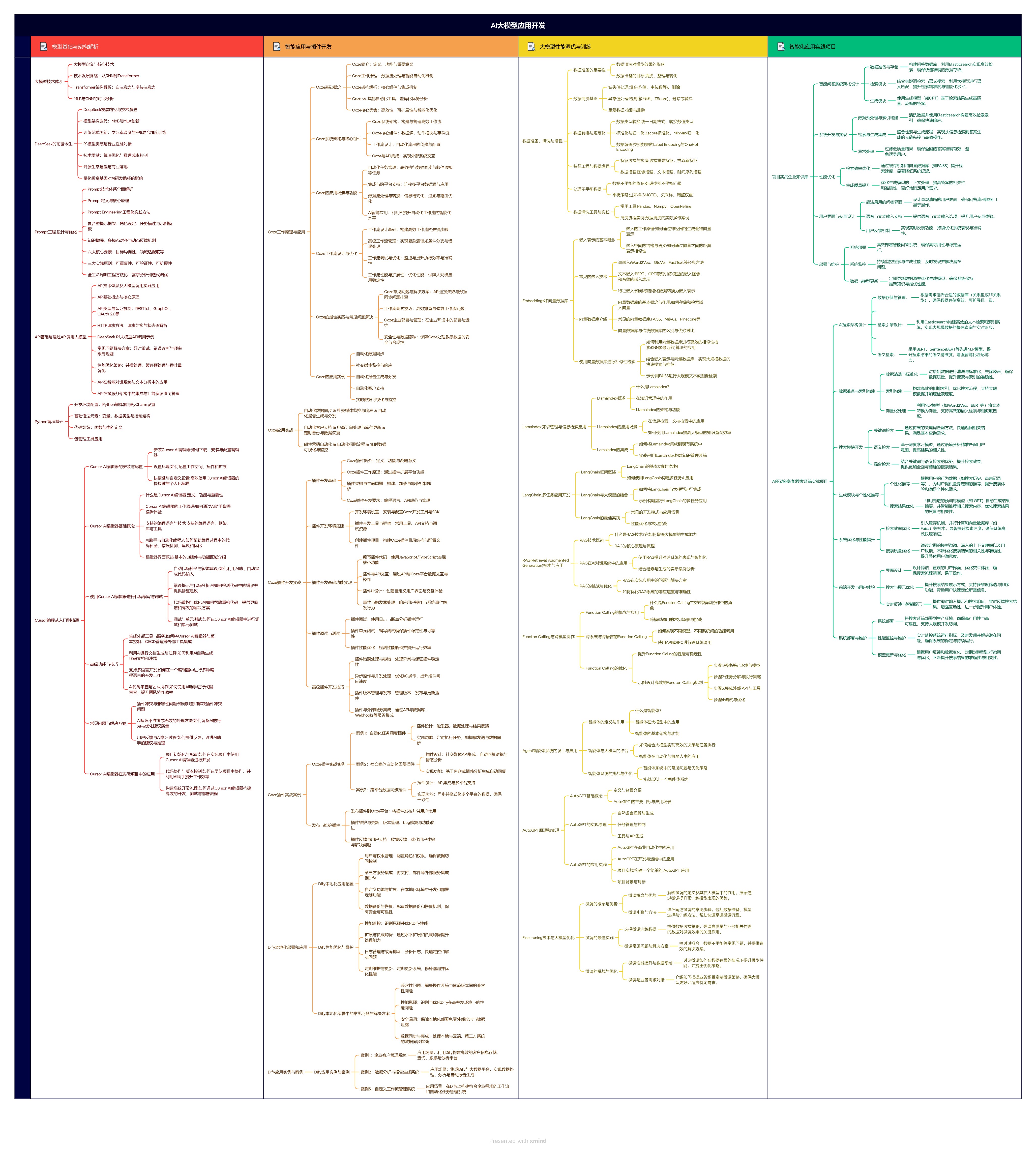

1.学习思维导图

AI大模型应用所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

2.从入门到精通全套视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

3.技术文档和电子书

整理了行业内PDF书籍、行业报告、文档,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

朋友们如果有需要全套资料包,可以点下面卡片获取,无偿分享!

3068

3068

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?