大家好我是AIGC阿道夫

大家好!今天我很高兴与大家分享一个使用 Flux 模型放大图片的 ComfyUI 工作流。在这篇文章中,我们将介绍如何设置这个工作流、其独特功能,并一步一步教你如何使用它来获得高质量的放大效果。

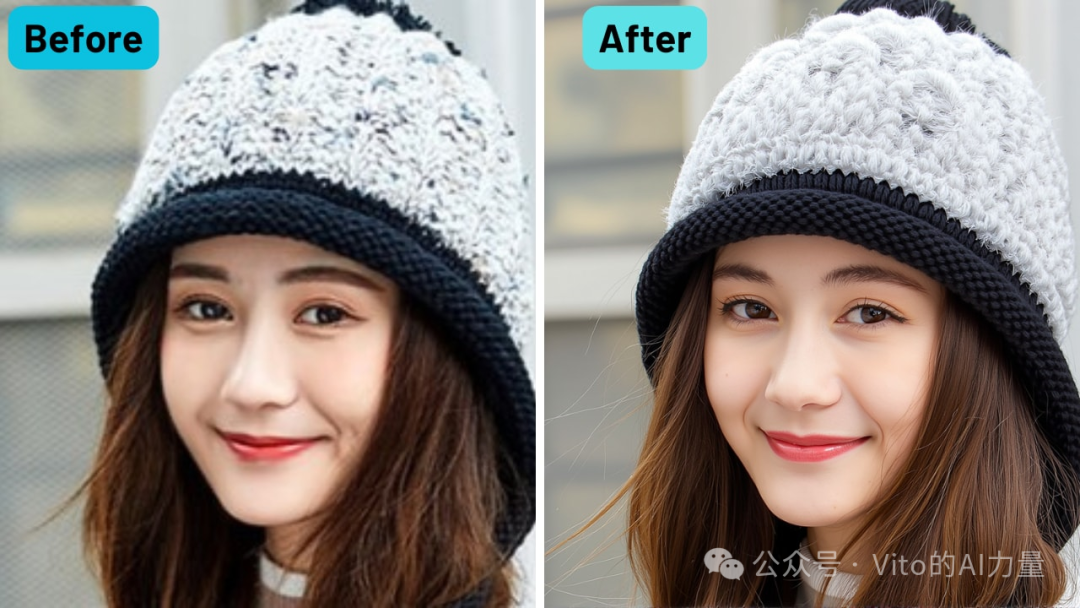

效果展示:

# 工作流简介

该工作流使用 Flux 模型对图片进行放大,同时保持高倍放大后的细节和清晰度。它具有一些独特的功能,如支持低显存的硬件设备以及使用 Florence2 自动生成提示词。

这份完整版的AI绘画(SD、comfyui、AI视频)整合包已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

-

使用的模型:用于图像放大的 Flux 模型

-

主要功能:

-

支持低显存设备,提供量化的 GGUF 版本。

-

集成 Florence2 自动生成提示词。

-

结合 ControlNet 模型,增强细节保留。

接下来,让我们深入了解如何在 ComfyUI 中设置和使用这个工作流。

# 第一步:设置工作流

下载必要文件

该工作流的关键部分是 ControlNet 节点,它使用 Jasper AI 开发的 ControlNet 放大模型。请按照以下步骤下载并设置相关文件:

-

前往 ControlNet 放大模型的 HuggingFace 页面。

-

下载文件名为

diffusion_pytorch_model.safetensors的文件。 -

将文件重命名为

Flux.1-dev-Controlnet-Upscaler.safetensors。 -

将重命名后的文件移动到你的 ControlNet 文件夹中:

`ComfyUI/models/controlnet `完成以上步骤后,ControlNet 模型就可以在 ComfyUI 工作流中使用了。

# 第二步:在 ComfyUI 中配置工作流

下载并配置好文件后,接下来我们来逐步配置和使用放大工作流。

上传图像

-

上传你希望放大的图像到 ComfyUI 中。

-

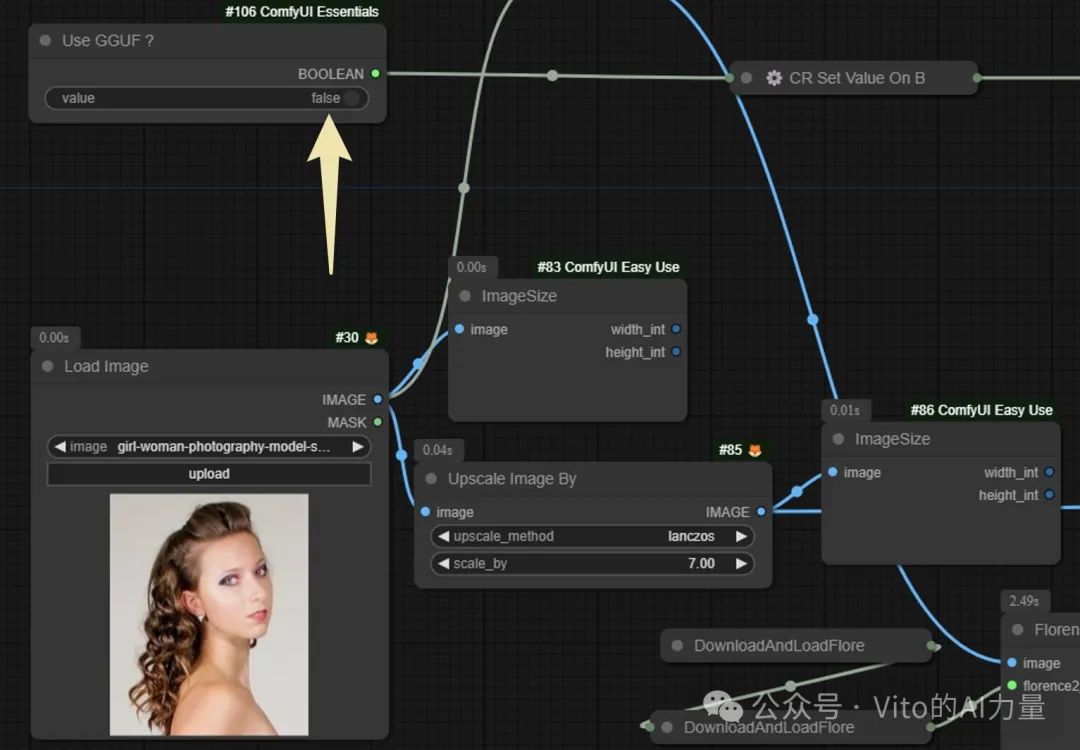

根据你的硬件配置选择:

-

如果使用 量化版本的 Flux 模型,将

Quantized Flux按钮切换为True。 -

如果使用 标准版本,则将该选项保持为

False。

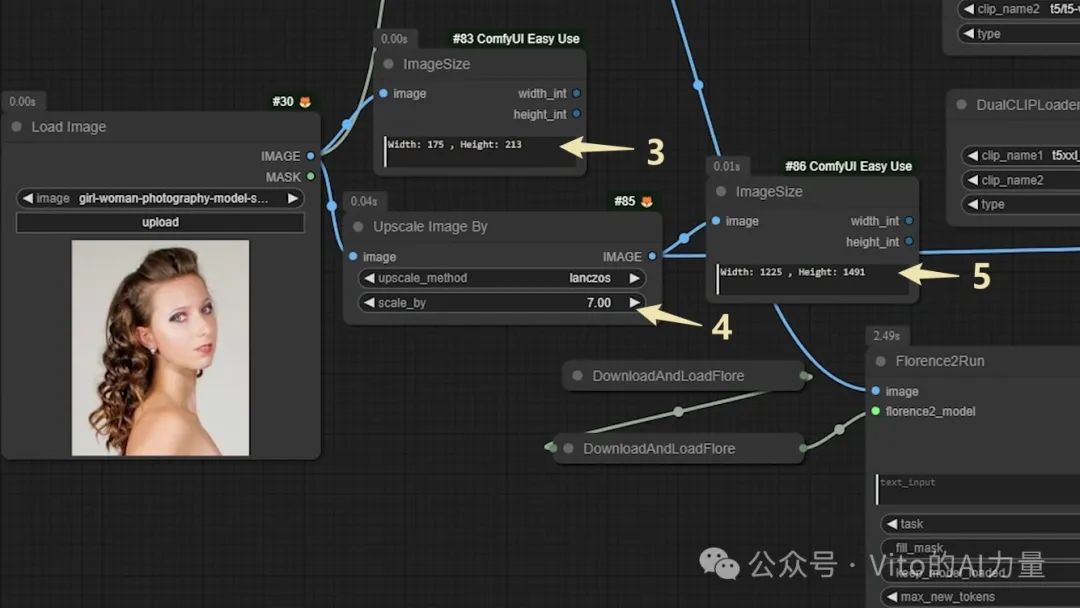

设置放大倍数

-

找到

Image Size节点,它显示你当前图像的尺寸。 -

在

Upscale Image By节点中设置你想要的放大倍数。例如:

- 设置为

7表示图像放大 7 倍。

- 运行工作流。右侧的

Image Size节点将显示放大后的新尺寸。

调整放大尺寸

如果放大后的尺寸不符合你的预期,可以暂停工作流,并调整放大倍数,直到达到理想的输出尺寸。

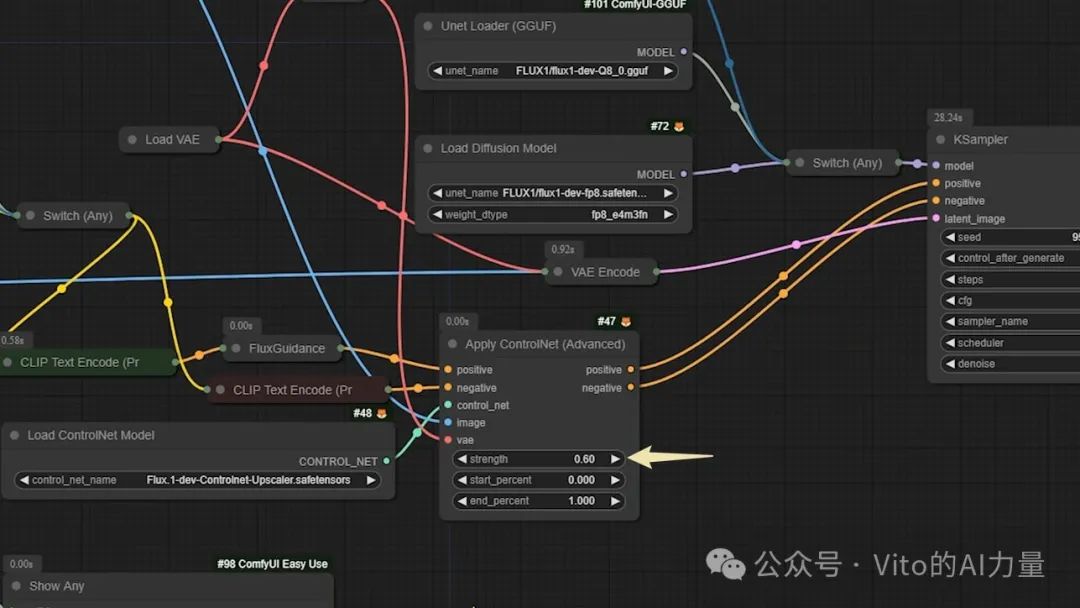

# 第三步:配置 ControlNet

这里是我们前面下载的 ControlNet 放大模型的应用部分。按照以下步骤进行设置:

-

在工作流中找到 ControlNet 模型节点。

-

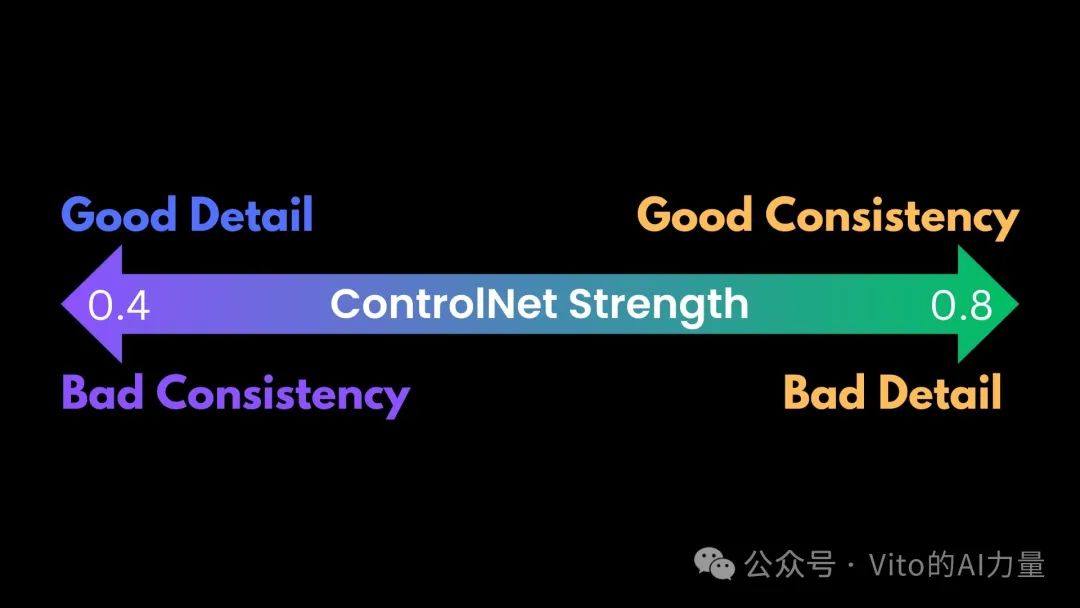

设置 ControlNet 强度在 0.4 到 0.8 之间:

-

**较低的强度(例如 0.4)**会导致最终图像与原图差异更大,但细节损失较少。

-

**较高的强度(例如 0.8)**会使放大后的图像更接近原始图像,但可能会出现更多不需要的细节。

选择 Clip 加载节点

根据工作流左上角的 布尔值(Boolean value),ComfyUI 会自动选择合适的节点来加载 Clip 文件。如果你在Clip 配置上遇到问题,请检查该布尔值是否与当前设置相匹配。

# 第四步:结果对比

运行工作流后,最后一个节点是 图像比较器(Image Comparer),它会显示放大前后图像的并排对比视图。该工具非常适合评估放大效果,并根据需要进一步调整设置。

# 优化工作流的小贴士

-

如果你发现放大图像的细节过于锐利或柔和,可以逐渐调整 ControlNet 强度,直到找到合适的平衡点。

-

尝试不同的放大倍数,观察 Flux 模型如何处理不同程度的放大效果。

# 结论

以上就是使用 Flux 模型放大图片的 ComfyUI 工作流指南!通过结合 ControlNet 和低显存量化的支持,该工作流在多种硬件配置下都能够提供灵活性和高质量的输出效果。

如果你对使用 Flux 模型的更多工作流感兴趣,可以查看我之前的文章,了解其他技术和配置方案。想要更多免费的工作流教程,请继续关注,并在 ComfyUI 中探索更多可能性!

这份完整版的AI绘画(SD、comfyui、AI视频)整合包已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

4396

4396

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?