在AIGC的文生图领域中, Midjourney(MJ)和stable diffusion(SD)都算是顶流存在,他们两家说自己是第三,估计没人敢说自己是冠亚军。这两款最强文生图大模型,到底有什么区别?

原理不同

MJ技术基于深度学习算法,通过训练大量图像数据来生成画作,具有较强的整体感和艺术性,但可能在细节表现上略显不足。

SD技术基于风格迁移算法,通过提取图片的风格特征并将其应用到另一张图片上,实现风格的转换,更加注重风格的多样性和细腻的风格表现。

使用方式不同

MJ对设备没有特别要求,不需要所谓的安装,在电脑、pad甚至手机上打开discord即可使用,没有任何限制。

SD只能在电脑上使用,需要手动安装部署,并且对电脑的性能有一定要求,尤其是对显卡,要求比较高。具备计算机编程基础的人用起SD来会更容易上手。

出图效果不同

MJ更加发散灵活,能轻松驾驭各种画风,图片审美成熟稳定,非常适合用来做创意灵感图片素材。

SD在审美上处于劣势,但是可以精细控制局部细节,保持一致性(这一点在MJ里面就有点头痛),所以SD非常适合用来做线稿上色、线稿转立体等效果,这个过程中线稿的元素保持一致,不被扭曲变形。

对了,还有一个不同之处差点忘了,MJ收费、SD开源免费。综合来看,MJ和SD各有所长。具体实践中,大家还是需要基于自身基础和实际需求来做选择。

所有的AI绘画工具,模型和插件资源·,AI学习资料及教程都已经整理好了

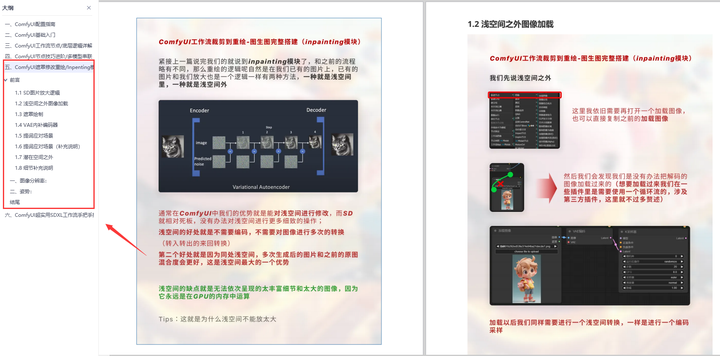

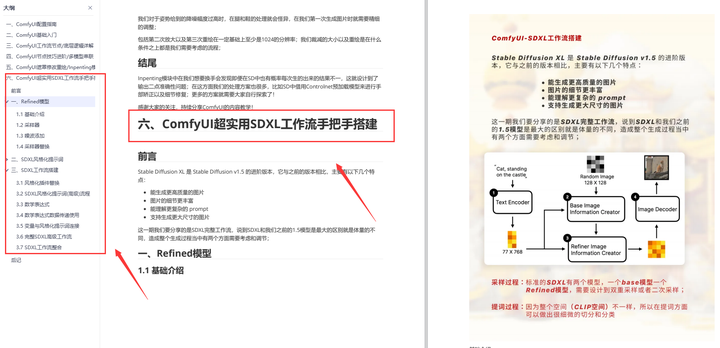

为了帮助大家更好地掌握 ComfyUI,我在去年花了几个月的时间,撰写并录制了一套ComfyUI的基础教程,共六篇。这套教程详细介绍了选择ComfyUI的理由、其优缺点、下载安装方法、模型与插件的安装、工作流节点和底层逻辑详解、遮罩修改重绘/Inpenting模块以及SDXL工作流手把手搭建。

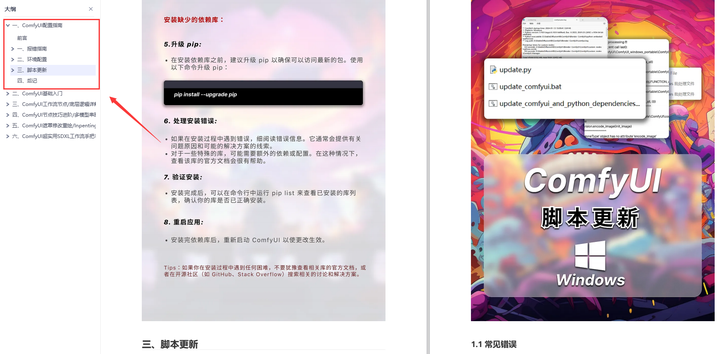

一、ComfyUI配置指南

- 报错指南

- 环境配置

- 脚本更新

- 后记

- …

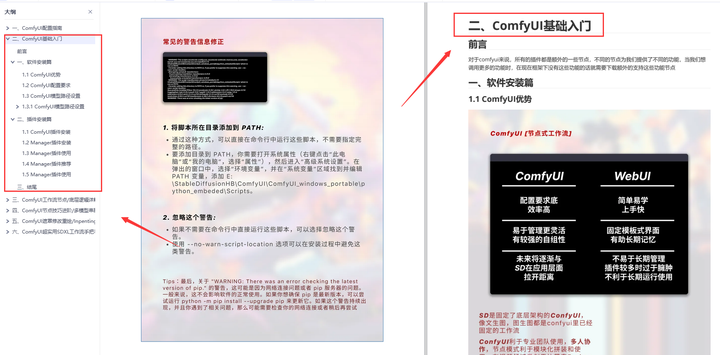

二、ComfyUI基础入门

- 软件安装篇

- 插件安装篇

- …

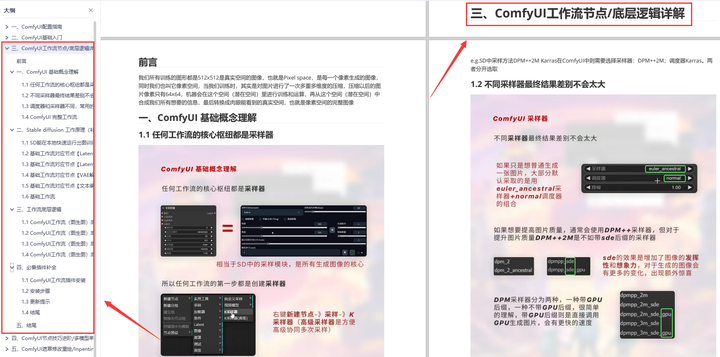

三、 ComfyUI工作流节点/底层逻辑详解

- ComfyUI 基础概念理解

- Stable diffusion 工作原理

- 工作流底层逻辑

- 必备插件补全

- …

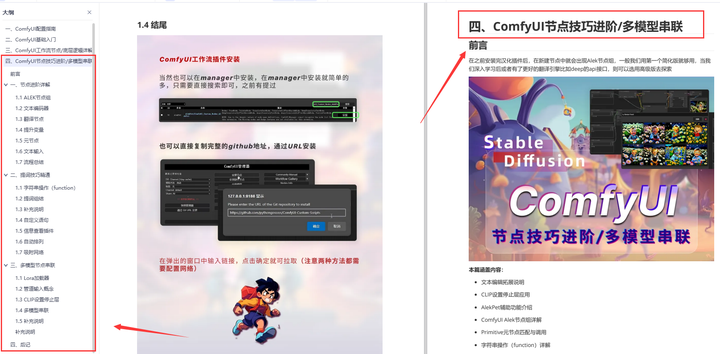

四、ComfyUI节点技巧进阶/多模型串联

- 节点进阶详解

- 提词技巧精通

- 多模型节点串联

- …

五、ComfyUI遮罩修改重绘/Inpenting模块详解

- 图像分辨率

- 姿势

- …

六、ComfyUI超实用SDXL工作流手把手搭建

- Refined模型

- SDXL风格化提示词

- SDXL工作流搭建

- …

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?