千呼万唤始出来!就在昨天,WebUI的ControlNet1.1.4版本终于更新,这次的更新支持了SDXL1.0的模型。我怀着兴奋的心情,打开了网站开始下载模型。这次总共出了四种控制类型,分别是Canny、Depth、Sketch和Openpose。

来到Hugging Face的网址:https://huggingface.co/lllyasviel/sd_control_collection/tree/main。可以看到这里有相当多的模型,当然,我们不需要全部都下载下来,因为它们之间有很多功能是重复的,是不同的作者做出来的。

但是呢,为了帮你们提前踩雷,我把他们全部都下载了,而且逐个做了测试,看到我这么辛苦的份上,你们一定会要给我一个“点赞”和“在看”的吧。

接下来,让我们来分类看一下吧。

#Canny硬边缘

首先是canny,它有几个不同的型号,体积越大,速度越慢。

我使用的是4080ti的笔记本进行的测试,12G显存。

-

模型sdxl base+refiner

-

提示词:masterpiece,best quality,1girl

-

采样方法:euler a

-

尺寸1024*1024

使用diffusers的2.5Gfull模型绘制的图片,一张图花了2分57秒,从这个效率上来看,这个大尺寸基本可以弃了。

使用diffusers的320Mb的small模型,用时34s,质量上差距不大,主要是时间优势很明显。

我们可以再看看其他作者的,这张是kohya的,用时33秒,更接近真实质感。

sai的canny分为128lora和256lora,分别用时39秒和1分08秒,这个模型比较偏绘画的感觉。

最后还有一个t2i的canny模型,用时34s,也是偏插画一点。

你们觉得哪个效果更好呢?时间上基本都在30秒以上,如果关掉refiner的话,能节省一半左右的时间,平均在17秒左右。

#Depth深度

接下来测试一些depth模型,图形尺寸664*1024。

使用diffusers的full模型,用时2分48秒,sdxl给我随机到了一个拼贴画的风格。

使用diffusers的small模型,用时23s。

使用kohya模型,用时42秒。这……好像和我的图片没什么关系。

使用sai模型,用时1分12秒,画质还可以,稍微有点慢。

Sketch草图

接下来测试一下sketch模型,画一只可爱的小猫,图形尺寸1024*624。

使用kohya模型,用时30秒,这是个啥???

使用sai模型,没找到小猫具体的位置,用时32秒,画质还可以。

使用t2i模型,用时28秒,唯一一个准的。

Openpose骨架

最后测试一下openpose模型,图形尺寸1024*624。

使用kohya模型,画很好看,但姿势不对,用时40秒。

很好看,但姿势不对,用时40秒。

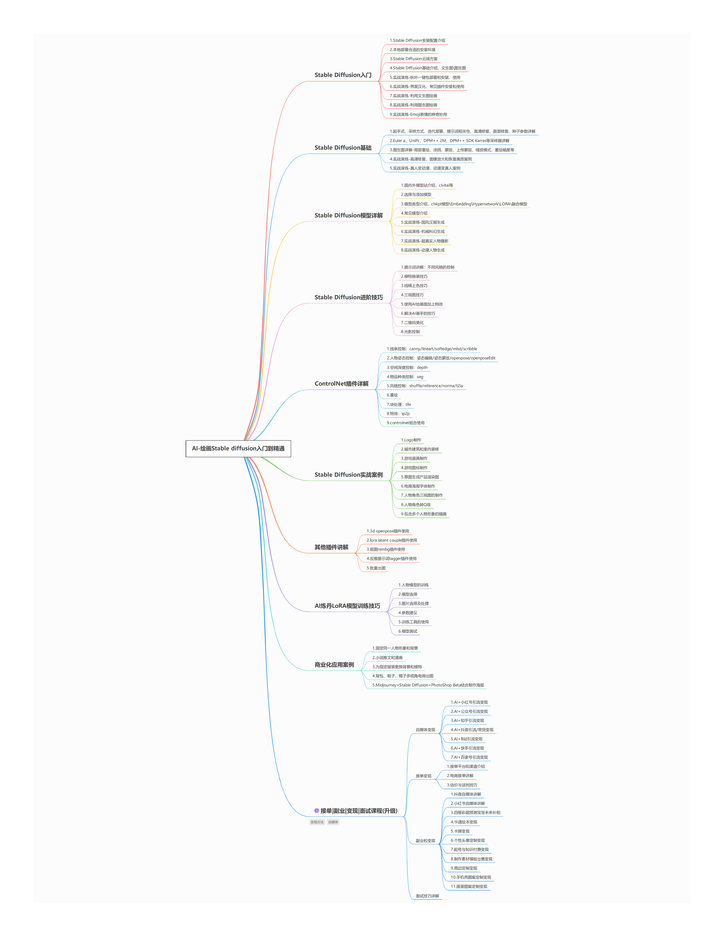

目前 ControlNet 已经更新到 1.1 版本,相较于 1.0 版本,ControlNet1.1 新增了更多的预处理器和模型,每种模型对应不同的采集方式,再对应不同的应用场景,每种应用场景又有不同的变空间

我花了一周时间彻底把ControlNet1.1的14种模型研究了一遍,跑了一次全流程,终于将它完整下载好整理成网盘资源。

其总共11 个生产就绪模型、2 个实验模型和 1 个未完成模型,现在就分享给大家,点击下方卡片免费领取。

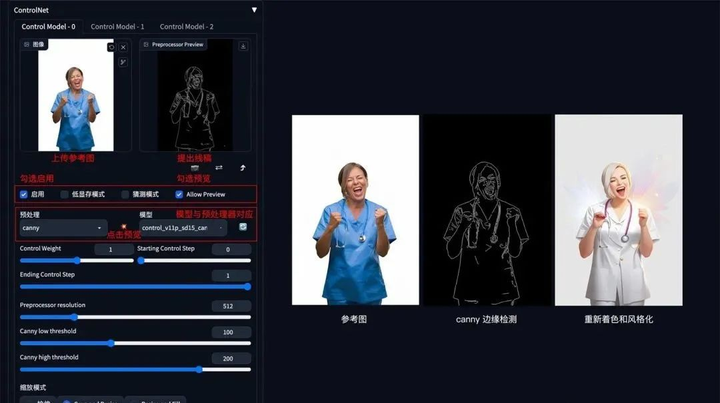

1. 线稿上色

**方法:**通过 ControlNet 边缘检测模型或线稿模型提取线稿(可提取参考图片线稿,或者手绘线稿),再根据提示词和风格模型对图像进行着色和风格化。

**应用模型:**Canny、SoftEdge、Lineart。

Canny 示例:(保留结构,再进行着色和风格化)

2. 涂鸦成图

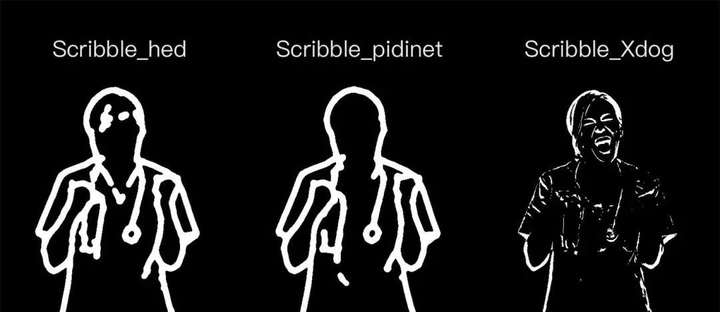

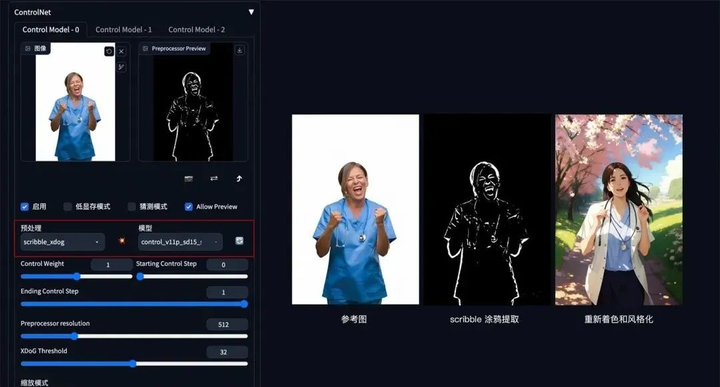

方法:通过 ControlNet 的 Scribble 模型提取涂鸦图(可提取参考图涂鸦,或者手绘涂鸦图),再根据提示词和风格模型对图像进行着色和风格化。

应用模型:Scribble。

Scribble 比 Canny、SoftEdge 和 Lineart 的自由发挥度要更高,也可以用于对手绘稿进行着色和风格处理。Scribble 的预处理器有三种模式:Scribble_hed,Scribble_pidinet,Scribble_Xdog,对比如下,可以看到 Scribble_Xdog 的处理细节更为丰富:

Scribble 参考图提取示例(保留大致结构,再进行着色和风格化):

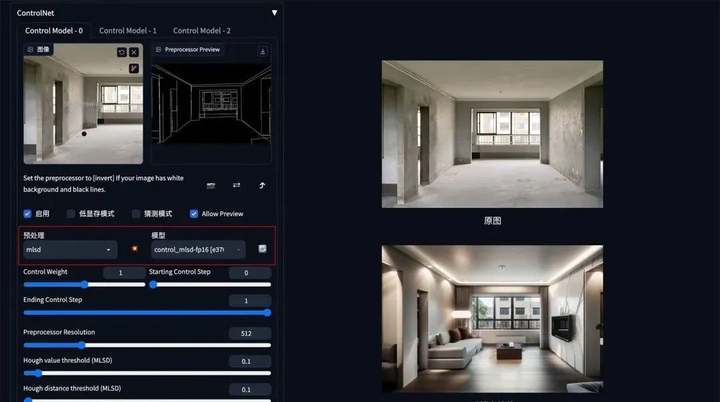

3. 建筑/室内设计

**方法:**通过 ControlNet 的 MLSD 模型提取建筑的线条结构和几何形状,构建出建筑线框(可提取参考图线条,或者手绘线条),再配合提示词和建筑/室内设计风格模型来生成图像。

**应用模型:**MLSD。

MLSD 示例:(毛坯变精装)

这份完整版的ControlNet 1.1模型我已经打包好,需要的点击下方插件,即可前往免费领取!

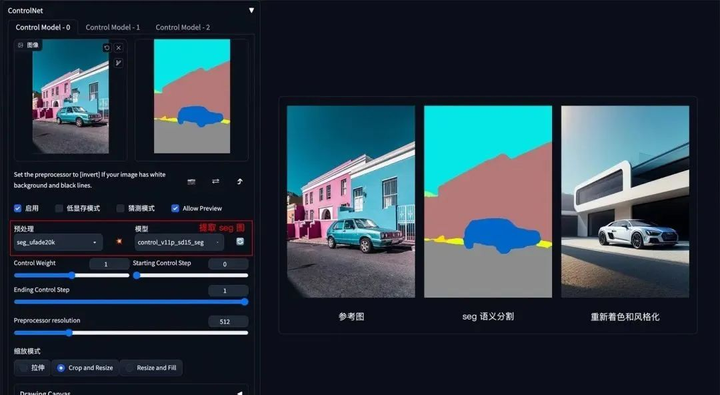

4. 颜色控制画面

**方法:**通过 ControlNet 的 Segmentation 语义分割模型,标注画面中的不同区块颜色和结构(不同颜色代表不同类型对象),从而控制画面的构图和内容。

**应用模型:**Seg。

Seg 示例:(提取参考图内容和结构,再进行着色和风格化)

如果还想在车前面加一个人,只需在 Seg 预处理图上对应人物色值,添加人物色块再生成图像即可。

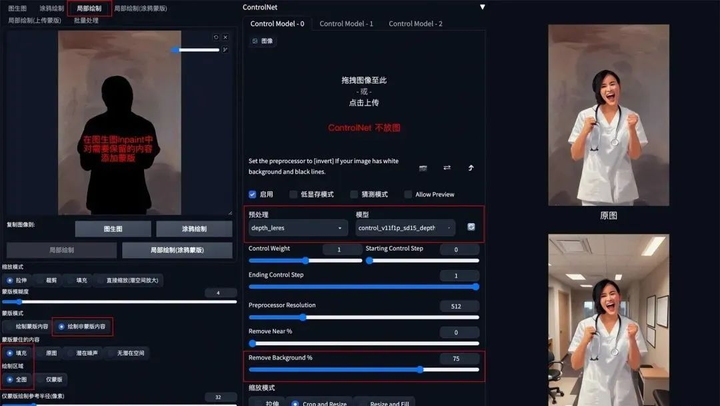

5. 背景替换

**方法:**在 img2img 图生图模式中,通过 ControlNet 的 Depth_leres 模型中的 remove background 功能移除背景,再通过提示词更换想要的背景。

**应用模型:**Depth,预处理器 Depth_leres。

**要点:**如果想要比较完美的替换背景,可以在图生图的 Inpaint 模式中,对需要保留的图片内容添加蒙版,remove background 值可以设置在 70-80%。

Depth_leres 示例:(将原图背景替换为办公室背景)

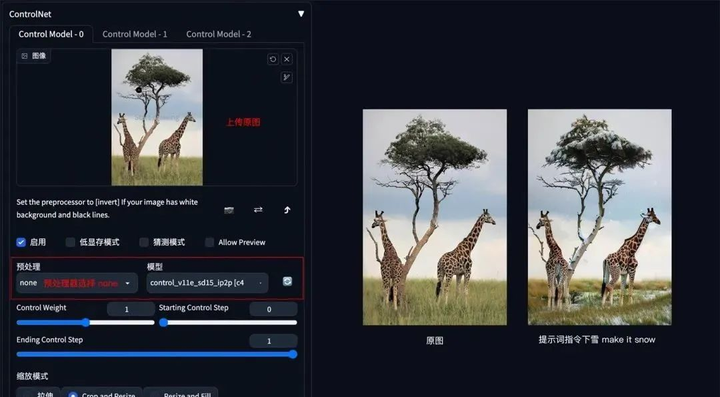

6. 图片指令

**方法:**通过 ControlNet 的 Pix2Pix 模型(ip2p),可以对图片进行指令式变换。

应用模型:ip2p,预处理器选择 none。

**要点:**采用指令式提示词(make Y into X),如下图示例中的 make it snow,让非洲草原下雪。

Pix2Pix 示例:(让非洲草原下雪)

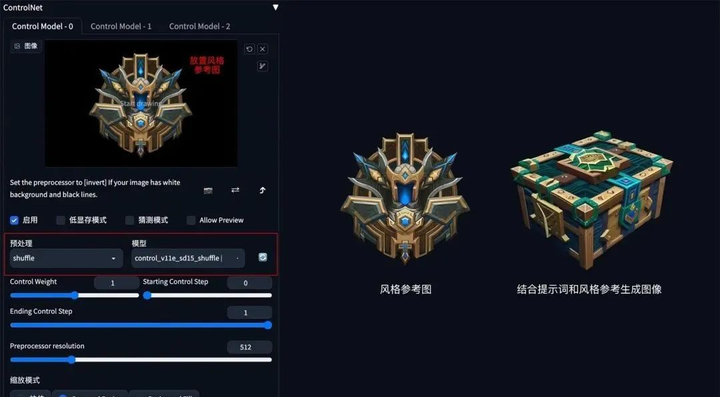

7. 风格迁移

**方法:**通过 ControlNet 的 Shuffle 模型提取出参考图的风格,再配合提示词将风格迁移到生成图上。

**应用模型:**Shuffle。

Shuffle 示例:(根据魔兽道具风格,重新生成一个宝箱道具)

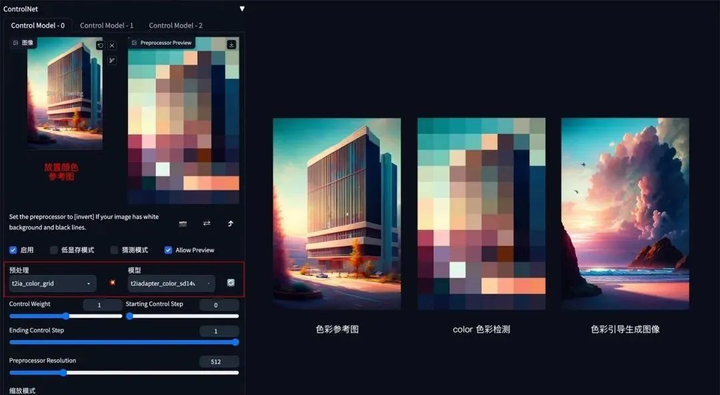

8. 色彩继承

**方法:**通过 ControlNet 的 t2iaColor 模型提取出参考图的色彩分布情况,再配合提示词和风格模型将色彩应用到生成图上。

**应用模型:**Color。

Color 示例:(把参考图色彩分布应用到生成图上)

这份完整版的ControlNet 1.1模型我已经打包好,需要的点击下方插件,即可前往免费领取!

这里就简单说几种应用:

1. 人物和背景分别控制

2. 三维重建

3. 更精准的图片风格化

4. 更精准的图片局部重绘

以上就是本教程的全部内容了,重点介绍了controlnet模型功能实用,当然还有一些小众的模型在本次教程中没有出现,目前controlnet模型确实还挺多的,所以重点放在了官方发布的几个模型上。

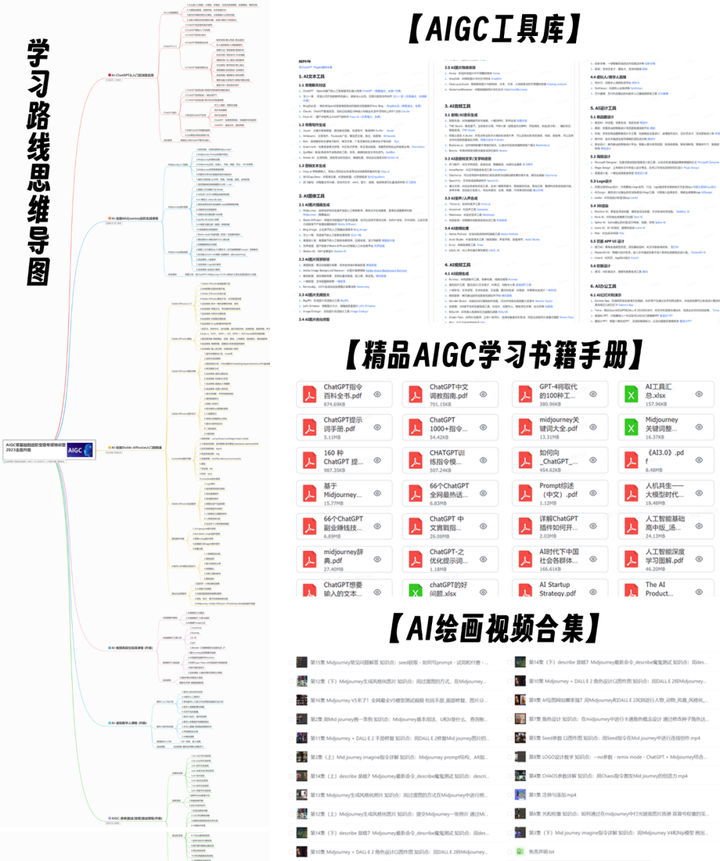

同时大家可能都想学习AI绘画技术,也想通过这项技能真正赚到钱,但是不知道该如何开始学习,因为网上的资料太多太杂乱了,如果不能系统的学习就相当于是白学,因为自身做副业需要,我这边整理了全套的Stable Diffusion入门知识点资料,大家有需要可以直接点击下边卡片获取,希望能够真正帮助到大家。

现在AI绘画还是发展初期,大家都在摸索前进。

但新事物就意味着新机会,我们普通人要做的就是抢先进场,先学会技能,这样当真正的机会来了,你才能抓得住。

如果你对AI绘画感兴趣,我可以分享我在学习过程中收集的各种教程和资料。

学完后,可以毫无问题地应对市场上绝大部分的需求。

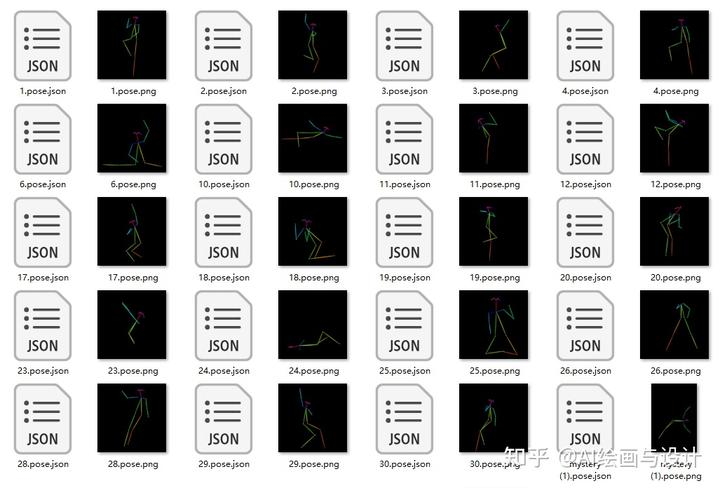

这份AI绘画资料包整理了Stable Diffusion入门学习思维导图、Stable Diffusion安装包、120000+提示词库,800+骨骼姿势图,Stable Diffusion学习书籍手册、AI绘画视频教程、AIGC实战等等。

完整版资料我已经打包好,点击下方卡片即可免费领取!

【Stable Diffusion学习路线思维导图】

【Stable Diffusion安装包(含常用插件、模型)】

【AI绘画12000+提示词库】

【AI绘画800+骨骼姿势图】

【AI绘画视频合集】

这份完整版的stable diffusion资料我已经打包好,点击下方卡片即可免费领取!

980

980

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?