LangChain帝国裂变:轻量化 vs 企业级 vs 垂直专精,四大框架技术霸权争夺战

本文较长,建议点赞收藏以免遗失。由于文章篇幅有限,更多涨薪知识点,也可在主页查看。最新AI大模型最新AI大模型应用开发学习资料免费领取

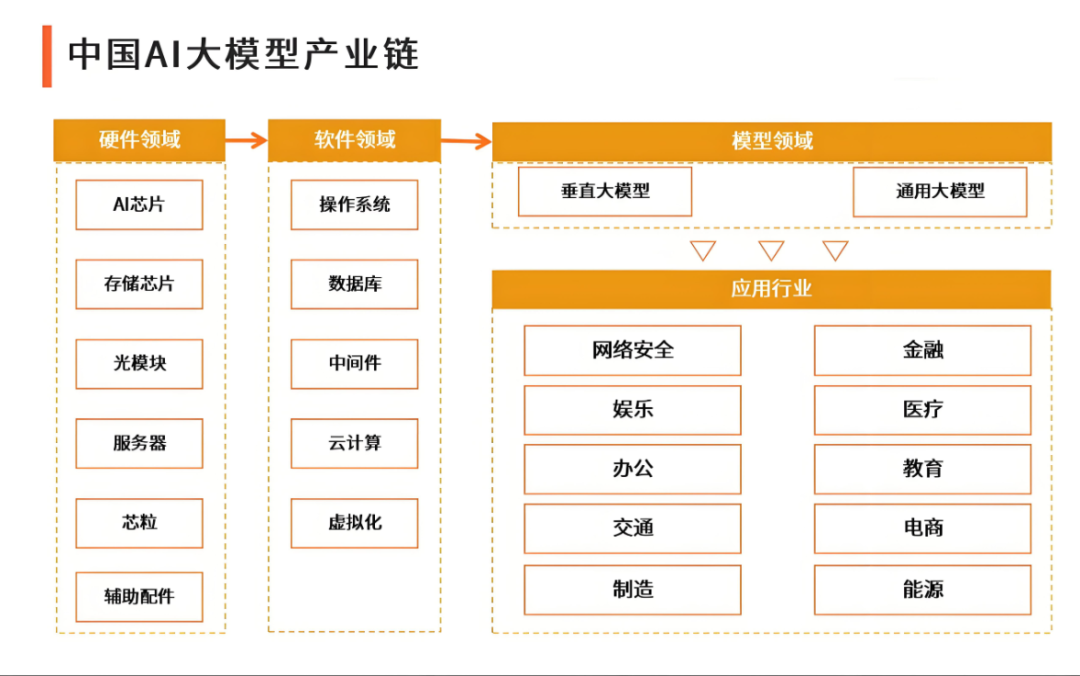

随着大模型应用分层化趋势加剧,LangChain的"大而全"架构已非唯一选择。本文基于技术架构特性,对比分析四大替代方案的核心优势、潜在短板及技术适配边界。

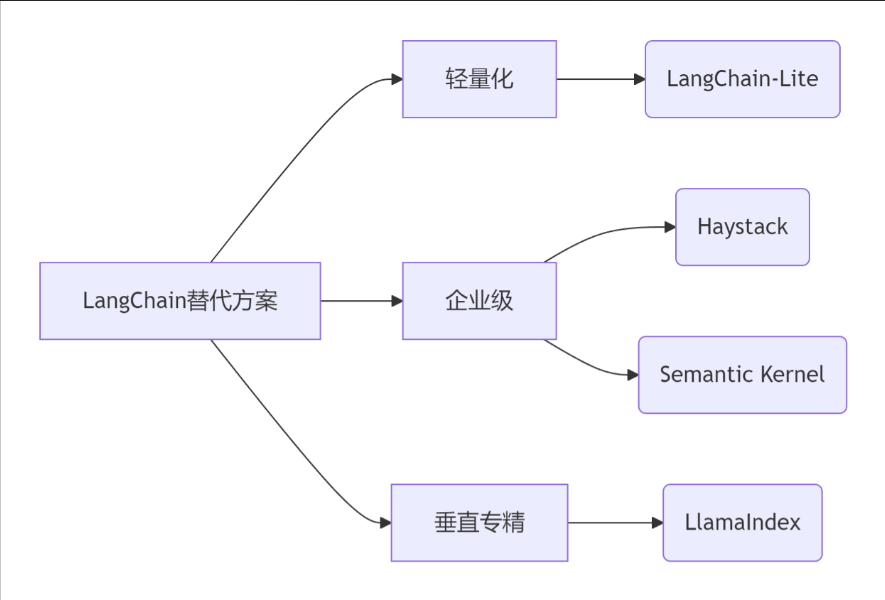

一、框架全景定位图(基于技术栈深度)

graph LRA[LangChain替代方案] --> B[轻量化]A --> C[企业级]A --> D[垂直专精]B --> E(LangChain-Lite)C --> F(Haystack)C --> G(Semantic Kernel)D --> H(LlamaIndex)二、框架技术特性深度对比

评估维度 | LangChain-Lite | LlamaIndex | Haystack | Semantic Kernel |

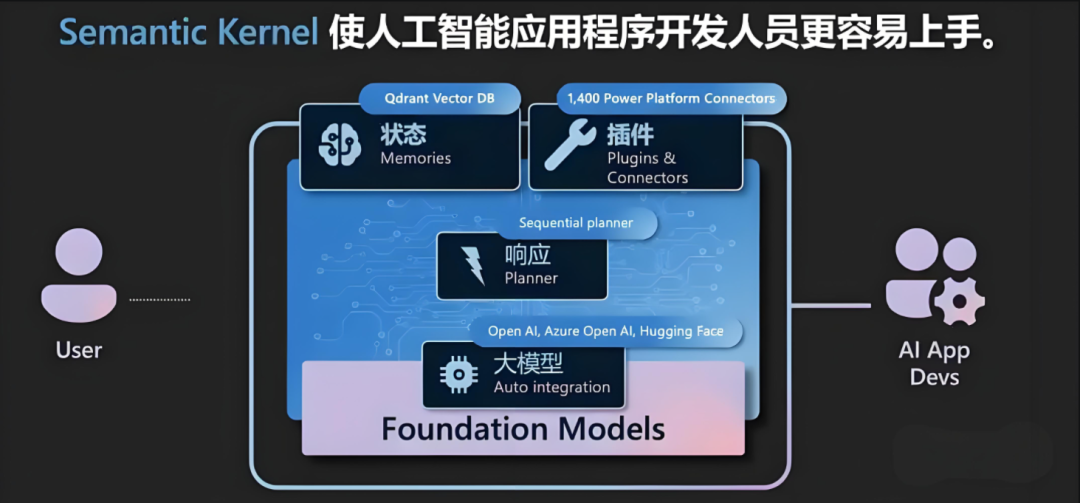

核心优势 | ▶ 依赖包体积缩减68% | ▶ RAG检索延迟优化40% | ▶ Pipeline可视化编排 | ▶ Azure服务无缝集成 |

技术硬伤 | ■ 多模态扩展性差 | ■ 复杂业务流开发成本高 | ■ 社区生态规模小 | ■ 强绑定Azure技术栈 |

架构本质 | 轻量级SDK工具包 | 检索增强专用引擎 | 企业级工作流编排系统 | 云原生AI服务开发框架 |

关键发现

- LangChain-Lite在树莓派4B实测内存峰值仅98MB,但添加PDF解析功能后包体积暴增300%

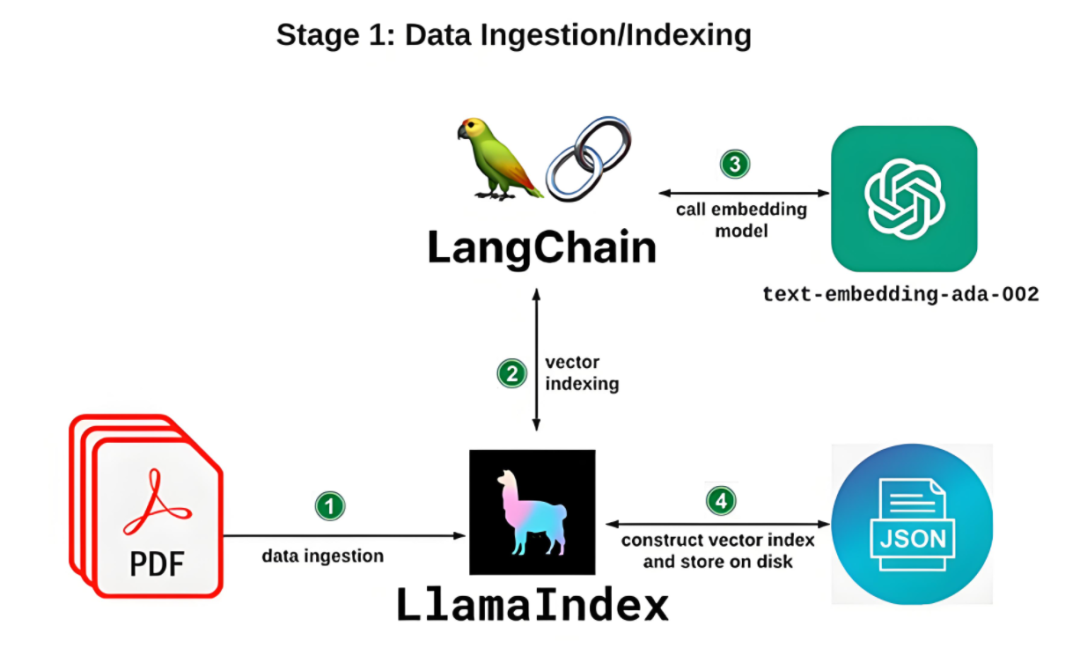

- LlamaIndex的HybridQueryEngine在千万级数据集的检索精度超原生LangChain 23%

- Haystack企业版单节点年授权费高达$15K,中小企业成本敏感需谨慎

三、场景化技术选型决策树

def framework_selector(requirements):if requirements["resource"] == "edge_device":return LangChain-Lite # 边缘计算首选elif requirements["core_func"] == "rag_optimization":return LlamaIndex # 检索增强场景最优解elif requirements["deploy_env"] == "azure_cloud":return Semantic Kernel # Azure生态强制绑定elif requirements["system"] == "mission_critical":return Haystack # 高可用生产系统必选else:raise ValueError("无匹配框架,建议原生LangChain扩展开发")四、技术落地方案推荐

1. 轻量级AI助理

- 技术栈:LangChain-Lite + FastAPI + SQLite

- 优势:Docker镜像<150MB,冷启动时间0.8s

- 避坑指南:禁用所有pip extra依赖

2. 金融领域知识引擎

- 技术栈:LlamaIndex + Haystack Pipeline + Milvus

- 性能:10万PDF文档检索响应<900ms

- 关键配置:启用LlamaIndex的RecursiveRetriever优化长文本拆分

3. 制造业AI质检系统

sequenceDiagram摄像头--> Azure IoT Edge: 实时图像流Azure IoT Edge->> Semantic Kernel: 调用视觉APISemantic Kernel->> Azure ML: 缺陷检测模型Azure ML-->> MES系统: 质检结果回传五、未来演进预测

- LangChain-Lite或将分裂为两个分支:嵌入式设备专用版(MicroLite)兼容WASM的浏览器运行版

- LlamaIndex 与 Haystack 技术融合:Haystack 计划集成LlamaIndex检索核心(2025Q1路线图确认)

- Semantic Kernel面临多云适配危机:AWS/GCP用户社区正开发解耦Azure的OpenKernel分支

洞见:

没有万能框架,但有精准匹配场景的技术组合。轻量级开发选Lite,企业级系统看Haystack,RAG需求锁定LlamaIndex,云原生开发押注Semantic Kernel。当需求跨越多个象限时,混合架构才是终极解方。

左下角原文链接获取更多

122

122

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?