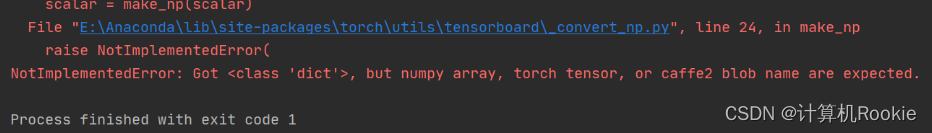

报错信息:

NotImplementedError: Got <class ‘dict’>, but numpy array, torch tensor, or caffe2 blob name are expected.

报错原因:

writer.add_scalars要加“S”

单个变量的可视化是不用加s的,例如:

- writer.add_scalar(‘test_acc’, test_acc, test_step)

多个变量共同可视化就要加S,例如: - writer.add_scalars(

‘epoch_loss’,

{

‘train’: np.mean(train_loss_lis),

‘test’: np.mean(test_loss_lis)

},

epoch

)

最终生成的效果图:

分析:就是自己太不仔细了,也太依赖编译器,出来啥就点啥了

3825

3825

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?