在 policy gradient 中讲解到的多种评估指标已经涵盖了下面要介绍的 Actor-Critic 的思想,梯度策略算法往往采用回合更新的模式,即每轮结束后才能进行更新。

如某盘游戏,假如最后的结果是胜利了,那么可以认为其中的每一步都是好的,反之则认为其中的每一步都是不好的。

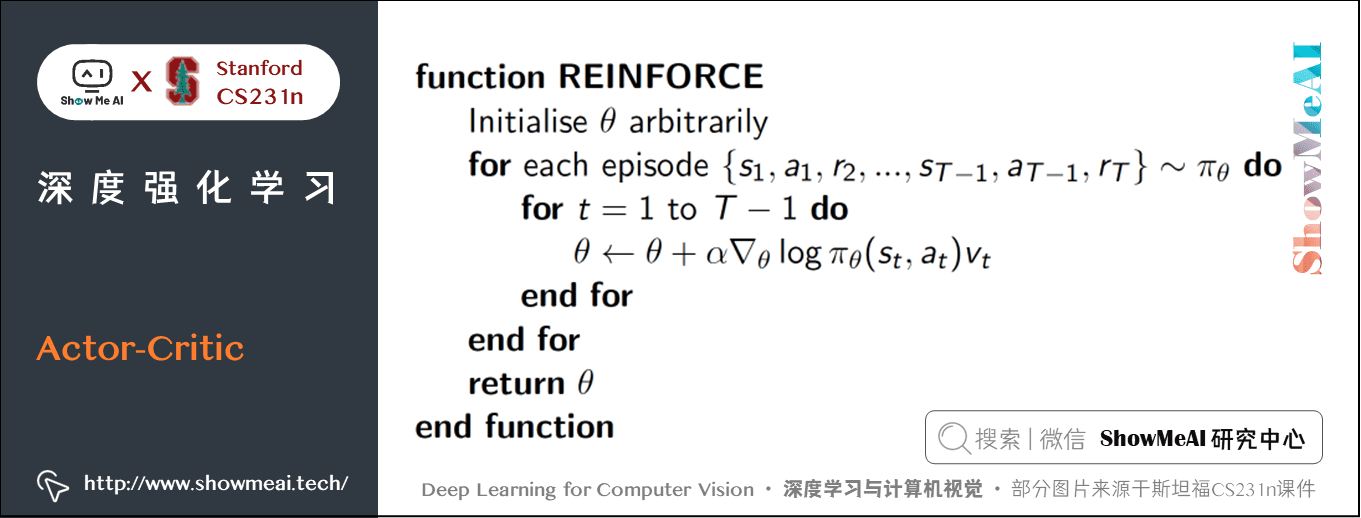

下图 Monte-Carlo Policy Gradient 方法

Reinforce Policy Gradient

上图中的 ![]() 是 policy network 输出的概率, Vt 是当前这一局的结果。这是 policy gradient 最基本的更新形式。

是 policy network 输出的概率, Vt 是当前这一局的结果。这是 policy gradient 最基本的更新形式。

但我们前面也分析了:最后的结果好 并不能说明其中每一步都好。我们能不能抛弃回合更新的做法,加快到单步更新呢,Actor-Critic 算法就做了这个调整。

但要采用单步更新,我们就需要为每一步都即时做出评估。Actor-Critic 算法中的 Critic 负责的就是评估这部分工作,而 Actor 则是负责选择出要执行的动作。这就是 Actor-Critic 的思想。Critic 的输出有多种形式,可以采用 Q 值、V 值 或 TD 等。

总结一下Actor-Critic算法核心思想:

在 Actor-Critic 算法中,Critic 是评判模块(多采用深度神经网络方法),它会对动作的好坏评价,然后反馈给 Actor(多采用深度神经网络方法),让 Actor 更新策略。

从具体的训练细节来说,Actor 和 Critic 分别采用不同的目标函数进行更新。

文章探讨了PolicyGradient中的回合更新模式及其局限性,引出了Actor-Critic算法。该算法通过Critic即时评估每一步动作的效果,以实现单步更新,加快学习进程。Actor-Critic的核心是分离出Actor(选择动作)和Critic(评价动作),两者基于不同的目标函数进行更新,且Critic通常用深度神经网络实现。

文章探讨了PolicyGradient中的回合更新模式及其局限性,引出了Actor-Critic算法。该算法通过Critic即时评估每一步动作的效果,以实现单步更新,加快学习进程。Actor-Critic的核心是分离出Actor(选择动作)和Critic(评价动作),两者基于不同的目标函数进行更新,且Critic通常用深度神经网络实现。

1502

1502

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?