再次之前,已经在扎实学习PPO与GRPO原理(上)——基础前奏-优快云博客里详细介绍了actor-critic的相关概念和两个网络(策略和价值)模型迭代过程中的梯度计算。在超级玛丽这个游戏中,我们很容易理解超级玛丽就是Agent,当前画面可以被看做是state状态,策略空间也已知(比如向上、向下等),奖励由环境发放……但是当这些概念迁移到NLP领域里的时候,尤其是大语言模型的后训练上时,上述强化学习方法actor-critic的相关概念该如何解释呢?

1. 概念迁移

这是理解的重要前提,可以结合上一篇一起看。

| 强化学习通用术语 | 超级玛丽场景里的含义 | 大语言模型后训练场景里的含义 |

|---|---|---|

| 环境 Environment | 整个《超级玛丽》游戏模拟器(关卡物理、敌人生成、得分规则) | 由「静态语言模型(固定参数)+ 人类/RM 打分器 + 任务/对话数据集」共同组成的“打分环境”。它接收文本并返回标量奖励,但本身不会再改变模型参数。 |

| 智能体 Agent | 正在玩的“超级玛丽”这个角色 | 正在做后训练的那个大语言模型(Actor),也就是我们的目标模型。 |

| 状态 State | 当前屏幕像素帧或游戏内部 RAM | 当前输入给模型的上下文窗口(prompt + 已生成 token 序列)。 |

| 动作 Action | 手柄按键:{上, 下, 左, 右, A, B, …} | 词表中的下一个 token(或整个句子/片段,取决于动作粒度的设计)。动作空间=词表大小≈5~20 万。 |

| 策略函数 Policy π | 给定像素帧→按键概率 | 给定上下文→下一个 token 的概率分布(即语言模型本身)。 |

| 奖励 Reward r_t | 吃蘑菇 +1,通关 +500,掉坑 -100 | 由人类偏好标注或奖励模型(RM)给出的标量:回答有用、诚实、无害、格式正确等维度。可以是模型也可以是规则函数,自定义。 |

| 回报 Return G_t | 从当前时刻到游戏结束累积折扣得分 | 从当前 token 位置到序列结束累积折扣奖励(∑ γ^k r_{t+k})。 |

| 动作价值函数 Q(s,a) | 在状态 s 按 a 按键后,期望最终得分 | 在上下文 s 生成 token a 后,整条回复的期望累积奖励。 |

| 状态价值函数 V(s) | 当前画面 s 下的期望最终得分 | 当前上下文 s 的期望累积奖励(衡量“从这开始我写得有多好”)。 |

| Critic 网络 | 一个额外网络:输入像素帧与动作→输出 Q(s,a) | 一个额外网络:输入上下文→输出Q(s,a),用来估计人类偏好得分。 |

| Actor-Critic 交互 | 像素→Actor 选键→环境反馈→Critic 更新→Actor 更新 | 上下文→Actor 选 token→RM/人打分→Critic 更新→Actor 更新(PPO、RLHF 流程)。 |

2. 梯度计算过程从理论到实践的演变

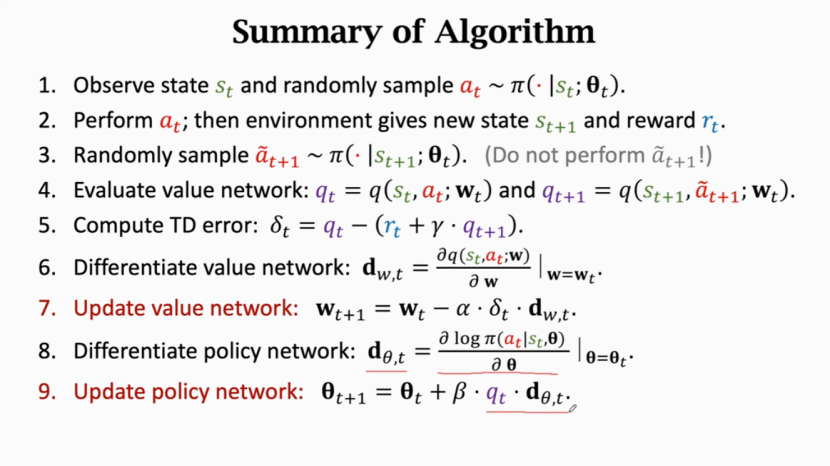

回顾一下上篇文章的策略梯度计算方法actor-critic,

上面这个计算过程理论上是正确的,但是实践中效果却不理想,

所以在A2C、PPO方法中上面图中最后一步关于梯度的计算,q_t被替换成了优势函数,定义为A(s, a) = Q(s, a) - V(s) (用优势函数代替这种方法可以被理论证明是对策略梯度的无偏估计,这里略

引入优势函数后:

策略梯度变为:∇J(θ) ≈ E[ ∇log π(a|s) * A(s, a) ]

-

妙处:

A(s, a) = Q(s, a) - V(s)。-

如果

A(s, a) > 0,说明动作a比平均水平好,应该强化这个动作。 -

如果

A(s, a) < 0,说明动作a比平均水平差,应该弱化这个动作。 -

如果

A(s, a) = 0,说明动作a就是平均水平。

-

-

核心好处: 优势函数将“动作本身的好坏”与“状态本身的好坏”分离开了。V(s)作为一个基线,扣除了状态价值的固有影响,使得梯度估计的方差大大降低。训练变得更加稳定,收敛更快。

简单比喻:

-

没有A(s, a) (用TD Error): 评价一个员工。公司今年利润超高(状态s好),所以发给这个员工的奖金(TD Error)也很多,但这可能掩盖了他其实表现很差(动作a差)的事实。

-

有A(s, a): 评价同一个员工。用他带来的价值(Q(s,a))减去公司的平均利润(V(s)),得到他的“优势”。如果结果是负的,说明他拖了后腿,即使公司整体赚钱,也要给他差评。

但是!!!我们不知道真实的Q和V,只能靠估计:

- (1)如果采用蒙特卡洛的方法来估计,就是直接把整条回报和 V 的差作为 Advantage,无偏方差大:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?