AI浪潮下,人人都在谈论大模型,但如何让高大上的AI真正落地业务,创造价值,而不是成为昂贵的“玩具”?这恐怕是许多企业心中的痛。尤其对于研发团队,更是肩负着双重使命:既要将AI集成到产品业务中提升竞争力,又要利用AI提高研发本身的效率和质量。

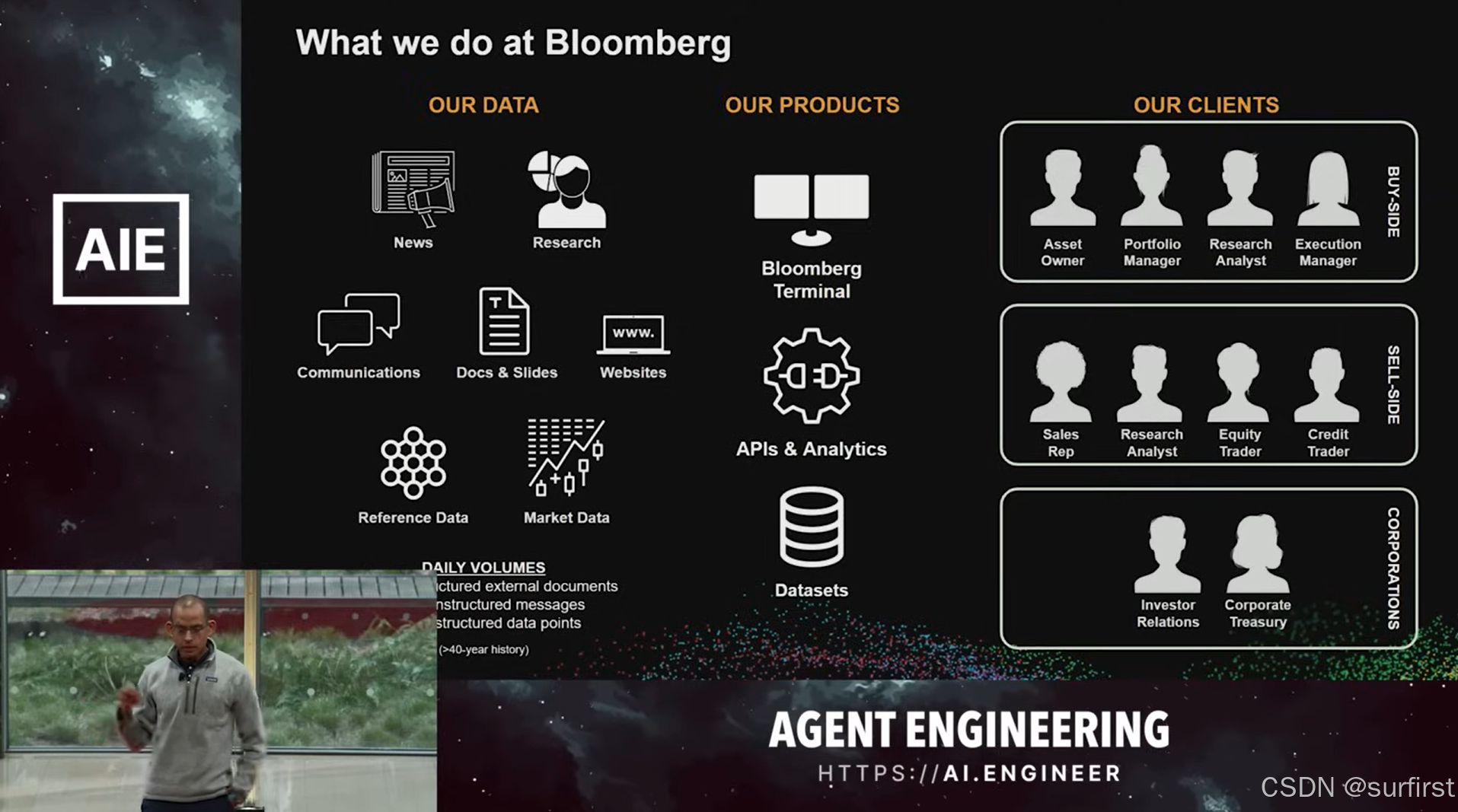

最近,金融科技巨头彭博社(Bloomberg)的AI工程负责人 Anju Kambadur 博士,在AI Engineering大会上分享了他们团队(拥有近400名AI专家)的“血泪与智慧”。今天,我们就来深度解析一下,看看彭博社这位“家里有矿”(每天处理千亿级数据,坐拥40年金融数据)的玩家,是如何在GenAI时代乘风破浪,他们的经验又给正在AI路上摸索的我们带来哪些启发。

启示一:战略务实——“放弃”自研,拥抱生态也许更快

你没听错,彭博社也曾雄心勃勃。早在2022年,他们就投入重兵,基于自身海量高质量金融数据打造了BloombergGPT。这个过程让他们收获颇丰,深刻理解了数据、训练、评估的种种不易。

然而,随着ChatGPT和开源社区的爆发式增长,彭博社做出了一个关键决策:战略转向(Pivot)。Anju博士坦言,虽然自研工作仍在继续,但核心策略已调整为“基于现有可用模型(开源或商业)进行构建”。

划重点: 这不仅是技术路线的选择,更是研发资源的聚焦。与其耗费巨资追赶日新月异的基础模型,不如集中火力打磨贴合业务的应用层创新。对于追求效率的企业而言,务实地利用外部成熟技术和生态,有时比“重复造轮子”更明智,这本身就是一种研发效能的提升。

启示二:原则先行——高标准严守“非协商”底线

在深入技术细节前,必须先了解彭博社开展业务的基石——那些**“不可协商(Non-negotiable)”的原则**。因为身处金融行业,任何失误都可能代价巨大。这些原则,无论用不用AI,都必须坚守:

- 核心性能: 精确性(Precision)、全面性(Comprehensiveness)、速度(Speed)、吞吐量(Throughput)、可用性(Availability)——这些是金融信息服务的生命线。

- 数据安全: 保护客户和贡献者数据是最高优先级。

- 透明可信: 保证系统决策过程的透明度(Transparency)和事实性(Factuality)。

- 合规底线: 明确业务边界,例如,绝不提供金融投资建议。

划重点: 这些原则是彭博社AI产品设计的“紧箍咒”,也是质量的“定盘星”。它们决定了技术选型和架构设计,比如后面会提到的强制性“防护栏”。企业在拥抱AI时,切忌为了“智能”而牺牲原则,必须将核心业务标准和合规要求嵌入AI开发的每一个环节。

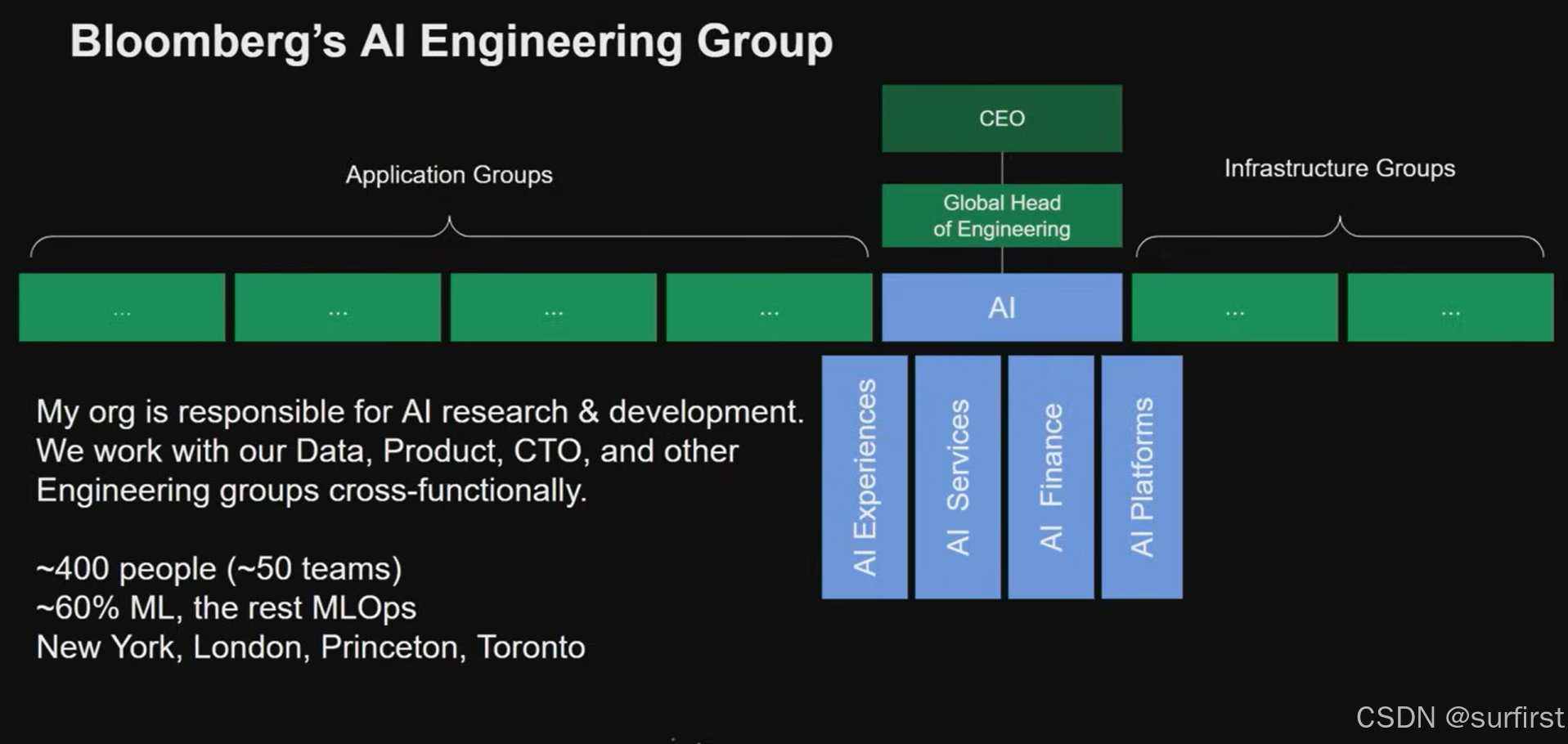

启示三:组织保障——打造专注高效的“AI能力中枢”

彭博社并未将AI专家分散到各个角落,而是组建了一个近400人、50个团队的独立AI工程部门,直接向全球工程负责人汇报。这个部门像一个**“AI能力中枢”**,与数据部门、产品部门、CTO办公室等紧密进行跨职能协作。

这样做的好处显而易见:

- 专注专业: 集中顶尖人才攻克AI难题,沉淀核心技术。

- 避免重复: 统一建设AI基础设施和通用能力(如模型训练平台、评估框架),避免各部门重复造轮子,大大提升了AI基础设施和核心能力的研发效率。

- 战略协同: 更容易推动AI在全公司的落地,确保与顶层战略一致。

- 赋能业务: 作为核心技术提供方,高效地将AI能力赋能给具体业务场景,如服务研究分析师。

划重点: 建立一个集中化、专业化的AI核心团队,并辅以有效的跨部门协作机制,是企业加速AI创新和规模化落地的关键组织保障。

启示四:架构韧性——拥抱“脆弱”,构建“半智能体”安全网

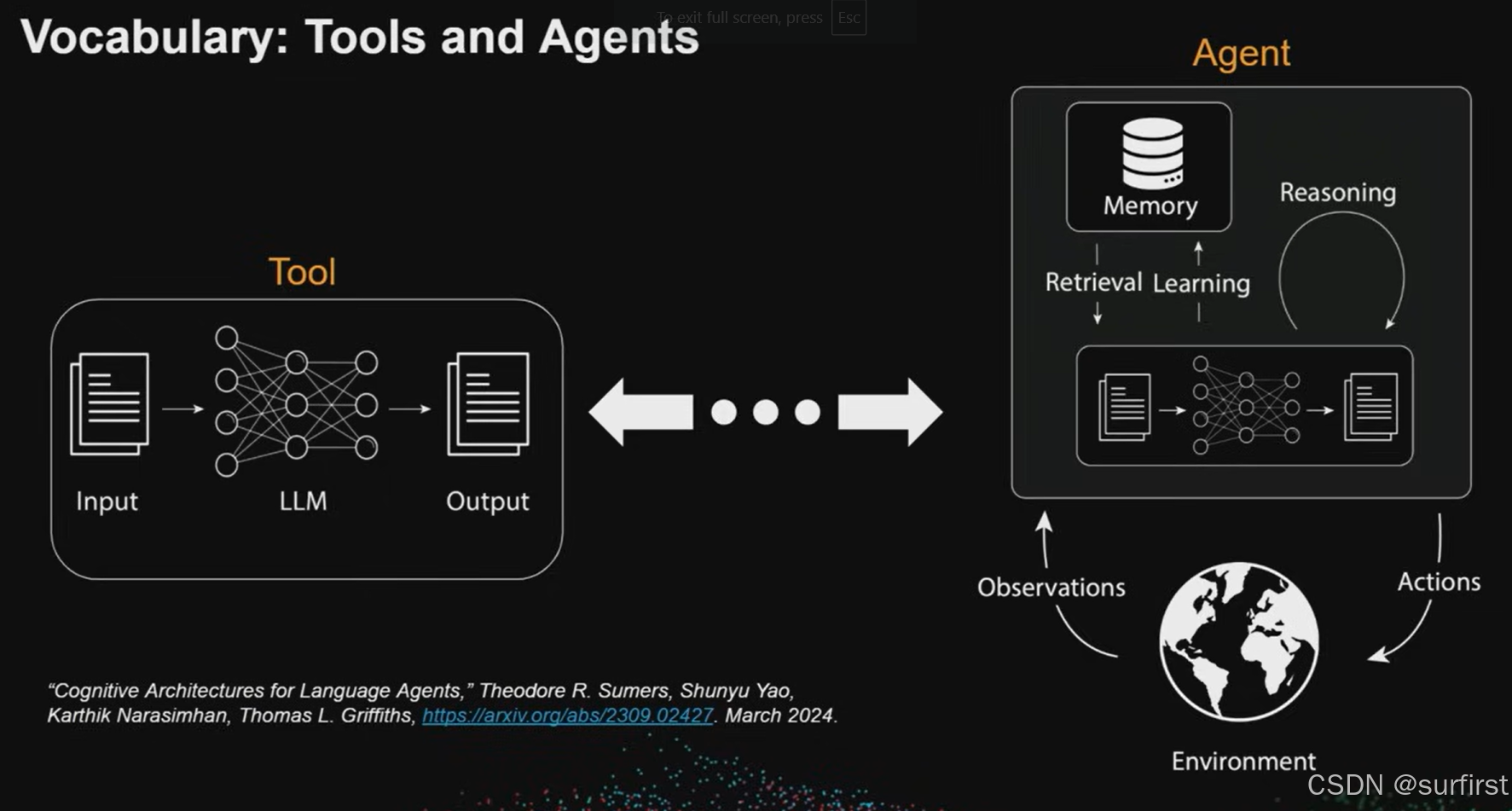

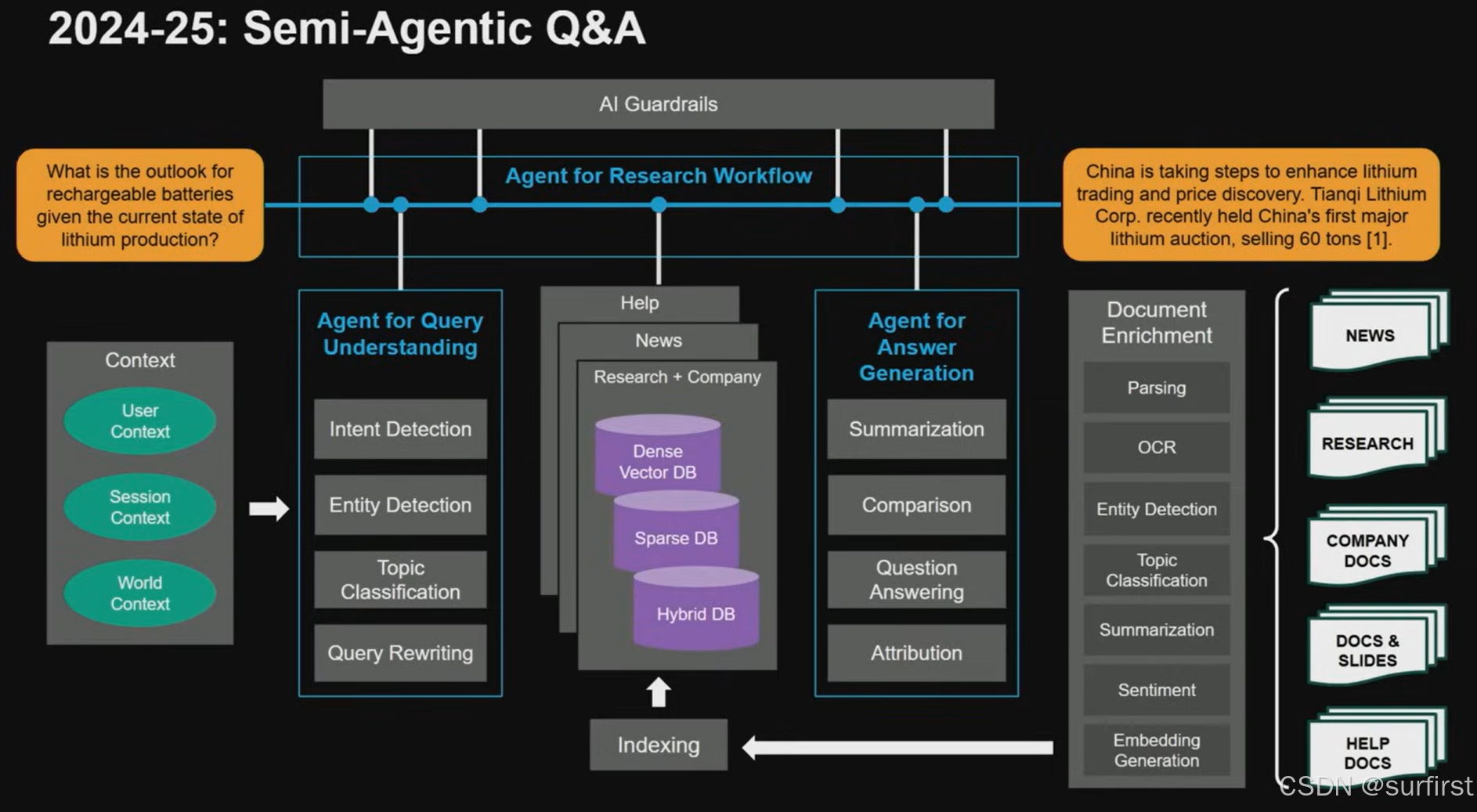

Anju博士区分了“工具(Tool)”和“智能体(Agent)”。彭博社目前的做法,他称之为**“半智能体化(Semi-agentic)”**架构。这意味着系统既有一定自主性(理解任务、调用工具),又受到严格控制。

这背后是对LLM系统**“脆弱性(Fragility)”**的深刻认识。想象一下精密的多米诺骨牌,上游一个小小的晃动(比如依赖的模型API微调),就可能导致下游结果全盘崩溃。

彭博社的应对之道:

- 强制防护栏(Guardrails): 基于第二点的“非协商原则”,设置大量强制性检查点。比如,严禁生成投资建议,严格核查输出内容的事实性。这些防护栏不是可选项,而是系统必须通过的关卡。

- 内置韧性(Resilience): 不完全信任上游系统永远正确。Anju博士强调,要假设上游会出错、会变化,并为此做好准备。这就像防御性驾驶——你不能假设路上其他车都完美遵守规则,必须自己做好预判和防护。同样,在AI系统中,与其祈祷上游不出错,不如在自己的环节内置安全检查和冗余验证。

技术框架简述: 用户输入 -> 理解意图与上下文 -> 规划分发任务 -> 调用内部工具/API -> 整合生成答案 -> (贯穿全程的)防护栏检查 -> 输出。

划重点: 在高风险领域,完全自主的AI Agent风险太高。“半智能体化”+ 强力防护栏 + 内置韧性思维,是在创新与风险间取得平衡的务实之道。 不要害怕系统的“脆弱”,要为脆弱而设计。

启示五:实践检验——从真实场景打磨AI能力

理论再好,也要落地跑起来。彭博社AI团队并非闭门造车,而是深入业务一线,解决实际问题。

- 案例1:财报电话会议摘要: 分析师需要在短时间内消化大量会议信息。AI团队开发了自动摘要工具。初期面临准确性、事实性挑战,团队投入大量精力进行MLOps实践(持续监控、错误修复、熔断机制),不断迭代优化,最终显著提升了分析师效率。

- 案例2:研究分析师智能助手: 当分析师查询“过去五个季度的美国CPI”时,智能体需理解查询、调用数据API,并通过防护栏检查(例如,确保拿到的是季度而非月度数据——Anju提到一个因此出错的例子),最终给出准确答案。

划重点: AI的价值在于解决真实的业务痛点。 从具体场景切入,与业务方紧密合作,通过快速迭代和持续优化(MLOps),才能将AI技术转化为实实在在的生产力。

启示六:演进思维——规模化需要技术与组织的协同进化

当AI应用从点状尝试走向规模化时,新的挑战随之而来。Anju博士分享了两点关于“规模化(Scaling)”的思考:

- 技术韧性促迭代: 前面提到的为“脆弱性”设计,构建本地安全检查,不仅仅是为了安全,更是为了效率。当每个组件都具备一定的“防御力”后,就不再需要繁琐的跨团队同步和审批,各个智能体或模块可以更独立地“小步快跑”,整体研发速度反而更快。

- 组织结构随需而变:

- 初期探索: 垂直整合团队(端到端负责)利于快速迭代。

- 成熟扩展: 当通用能力(如防护栏、评估框架)沉淀下来,应考虑建立水平化团队,提供共享服务,提升整体效率。同时,可能需要拆分大型复杂智能体,让团队职责更聚焦。

- 关键: 组织架构并非一成不变,需要根据技术栈、产品阶段和业务需求动态调整。彭博社也经历过组织调整(reorg)。

划重点: 规模化AI应用,不仅是技术的挑战,更是组织协同的挑战。技术上要拥抱韧性,组织上要灵活演进,两者相辅相成。

结语:给你的AI之旅带来什么启示?

彭博社的AI实践,给我们带来了一本宝贵的“实战手册”。总结几点核心启示:

- 战略要务实: 动态平衡自研与集成,聚焦应用价值。

- 原则要先行: 将核心业务标准与合规要求置于AI应用的核心。

- 组织要保障: 建立专业AI团队,辅以高效协作机制。

- 架构要韧性: 接受AI的“脆弱”,设计安全、可控、有冗余的系统。

- 思维要演进: 技术架构与组织结构需随发展阶段协同进化。

- 落地要场景: 从真实业务痛点出发,用实践打磨AI能力。

彭博社的经验表明,即使是资源雄厚的巨头,在AI浪潮中也需要不断调整航向,务实前行。他们的探索,无疑为所有期望通过AI提升竞争力的企业,提供了宝贵的镜鉴。

那么,读完彭博社的故事,你认为在你的企业中,落地AI最需要突破的“非协商原则”或者说最大的“坎”是什么? 欢迎在评论区留下你的思考,一起交流!

免责声明: 本文内容基于公开信息(Anju Kambadur博士在AI Engineering大会的分享)整理和解读,仅代表博主个人观点,不构成任何投资或决策建议。

参考链接

- https://www.youtube.com/watch?v=b2GqTDWtg6s

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?