我的系统

-

操作系统: Windows 11

-

显卡: NVIDIA GeForce RTX 4060 8G

-

内存: 32GB

-

存储: 100GB 固态硬盘

-

模型 8B

第一步:下载并安装 Ollama

-

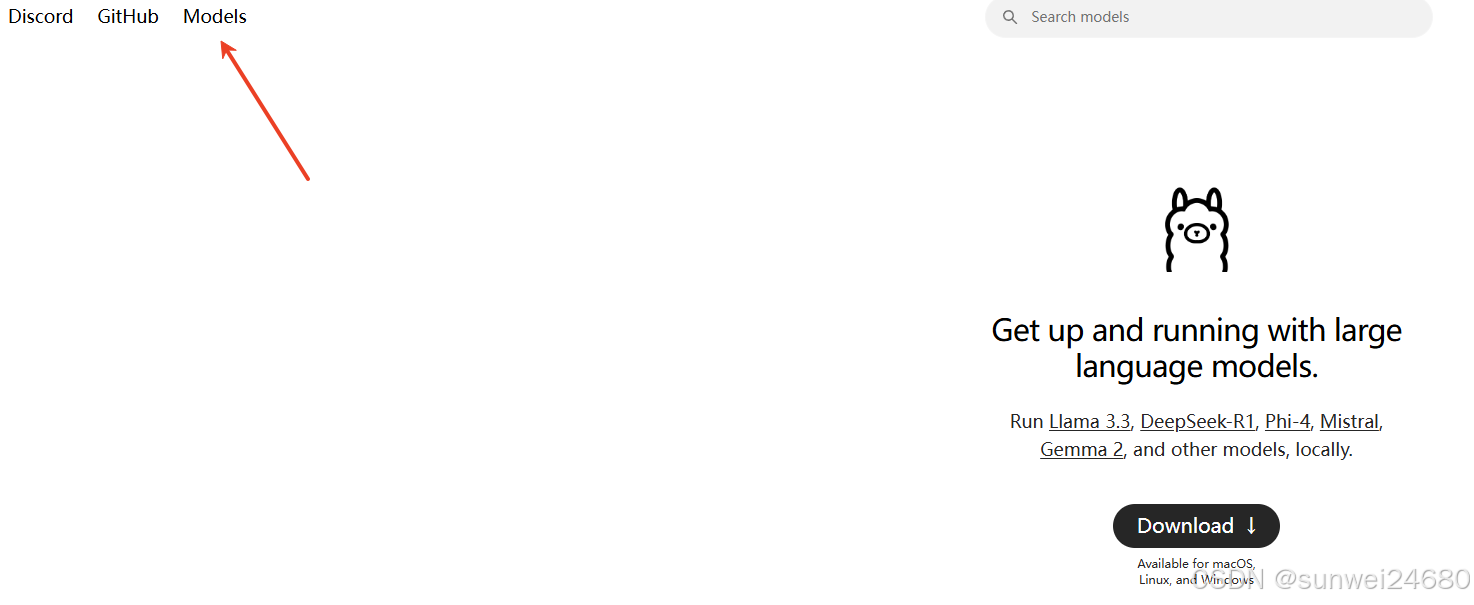

下载 Ollama:

-

访问 Ollama 官方网站 下载最新版本的安装程序。

-

如果无法访问官网,可以直接从 GitHub 发布页面 下载。

-

-

安装 Ollama:

-

下载完成后,双击

OllamaSetup.exe进行安装。请注意,Ollama 会默认安装在 C 盘。

-

-

检查安装是否成功:

-

打开命令提示符(cmd),输入以下命令:

-

where ollama如果安装成功,系统会返回 Ollama 的安装路径。

-

第二步:下载并运行 DeepSeek 模型

-

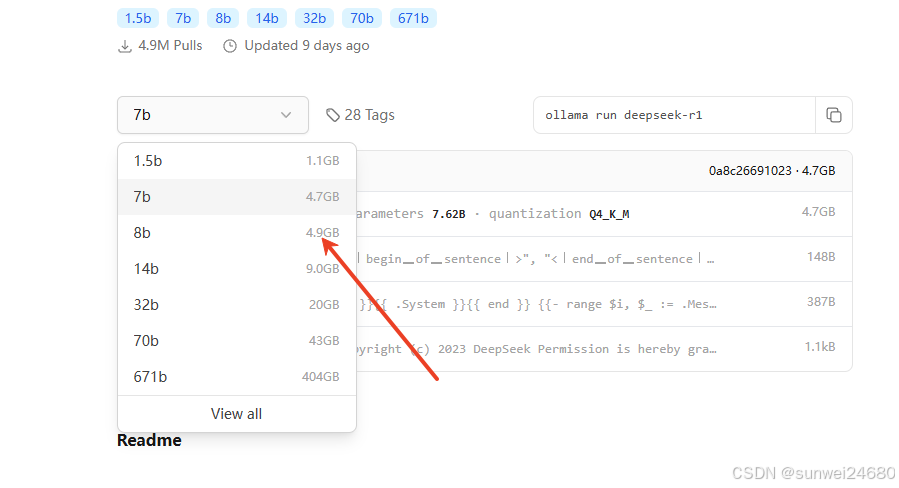

选择模型:

访问 DeepSeek 模型页面 选择合适的模型。

- 以下是推荐的模型及其对应的显存要求:

-

显存大小 推荐模型 8GB 7B, 8B 12GB 14B 16GB 14B, 勉强 32B 24GB+ 32B 32GB+ 70B

-

懒得找的,我这给大家列出来,自己复制哦

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b3、找一个合适的

推荐啊,显卡 主要看现存,别问我 6040 跑多少,没钱,买不起

选一个合适的。

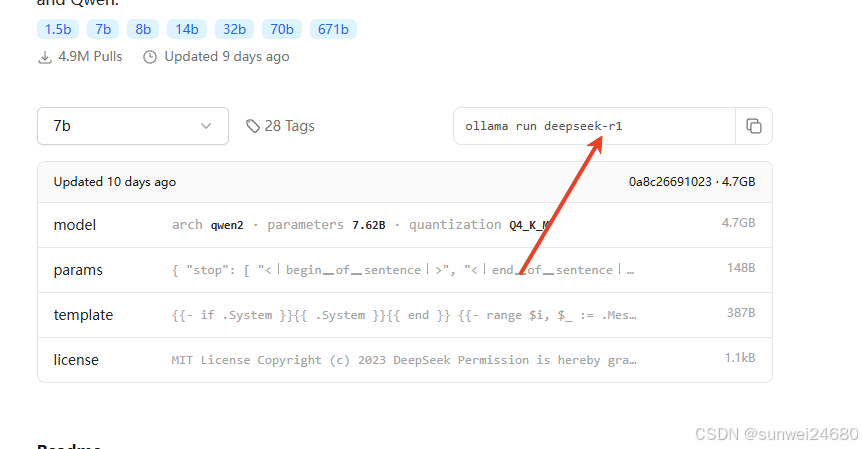

复制这段

复制这段

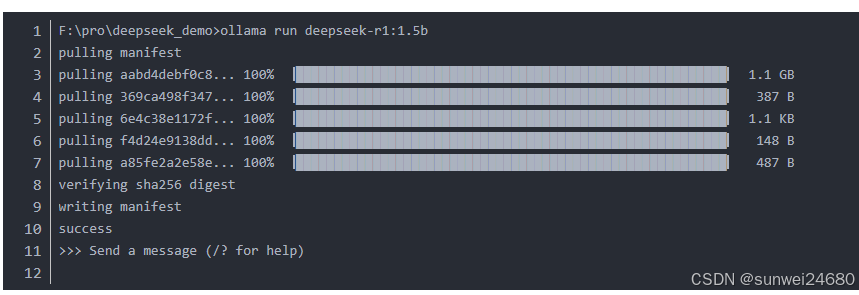

粘贴到命令行,就OK了 下载有点慢哦,不急。

下载安装自动的,完成就可以对话了。

啥,你问我下次怎么启动。 好好好,我告诉你,下次启动,第一步打开 ollama ,第二部,还是这段代码,就启动了,你问啥,他说啥。 不想写了,怎么实现webUI,有人需要我再补充吧。

如何使用 chatbox 启动可视化界面

-

确保 Ollama 已启动

-

在命令行运行以下命令,启动 Ollama 服务并加载 DeepSeek 模型(例如

deepseek-r1:7b):bash

复制

ollama run deepseek-r1:7b

-

Ollama 默认会在本地启动 API 服务,端口为

11434。

-

-

安装 Chatbox

-

从 Chatbox 官网 下载并安装客户端。

-

配置 Chatbox 连接 Ollama

-

打开 Chatbox 设置

-

启动 Chatbox,点击左下角的 设置(齿轮图标)。

-

-

添加自定义 API 配置

-

在 模型提供商 中选择 Custom OpenAI API。

-

填写以下信息:

字段 值 API 地址 (Endpoint) http://localhost:11434/v1模型名称 (Model) 例如 deepseek-r1:7bAPI Key 留空(无需填写)

-

-

保存并测试连接

-

点击 保存,返回主界面输入问题测试交互。

-

如果返回正常响应,说明连接成功!

-

常见问题

-

连接失败

-

检查 Ollama 是否正在运行(命令行中应有模型加载日志)。

-

确保端口

11434未被占用,可通过以下命令验证:bash

复制

curl http://localhost:11434

-

如果提示

404 page not found,说明 Ollama 服务已启动。

-

-

模型名称不匹配

-

在 Chatbox 中填写的模型名称需与 Ollama 中已下载的模型完全一致。

-

可通过

ollama list查看本地模型列表。

-

-

防火墙或网络限制

-

确保防火墙允许 Chatbox 与本地

11434端口的通信。

-

进阶配置(可选)

-

修改 Ollama API 地址

如果需要通过局域网访问,可修改 Ollama 的启动参数:bash

复制

OLLAMA_HOST=0.0.0.0 ollama serve

然后在 Chatbox 中将 API 地址改为

http://[你的IP]:11434/v1。 -

使用 WebUI 替代 Chatbox

如果更喜欢网页界面,可尝试 Open WebUI,它专为 Ollama 设计。

14万+

14万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?