自 3 月 6 日发布以来,通义千问 QwQ-32B 以雷霆之势席卷全球 AI 界。这款由中国团队打造的开源大模型,不仅连续三周稳居 HuggingFace 趋势榜榜首,更掀起全球技术平台的接入浪潮。据悉,SambaNova Systems、SGlang、Ollama 等十余家海外知名 AI 平台都已接入阿里千问 QwQ-32B。

通义千问 Qwen 的衍生模型数量目前已突破 10 万大关,一举超越 Meta 的 Llama 系列,这场始于杭州的 AI 智能浪潮,正以开源代码为纽带,重构全球人工智能版图。

国产AI在今年真的进入了高光时代:上线即爆火至今的 DeepSeek-R1,再到现在的 QwQ-32B 都令业界赞叹不已。

QwQ-32B VS DeepSeek-R1

同样属于国产的硬实力模型,这两者有什么区别?

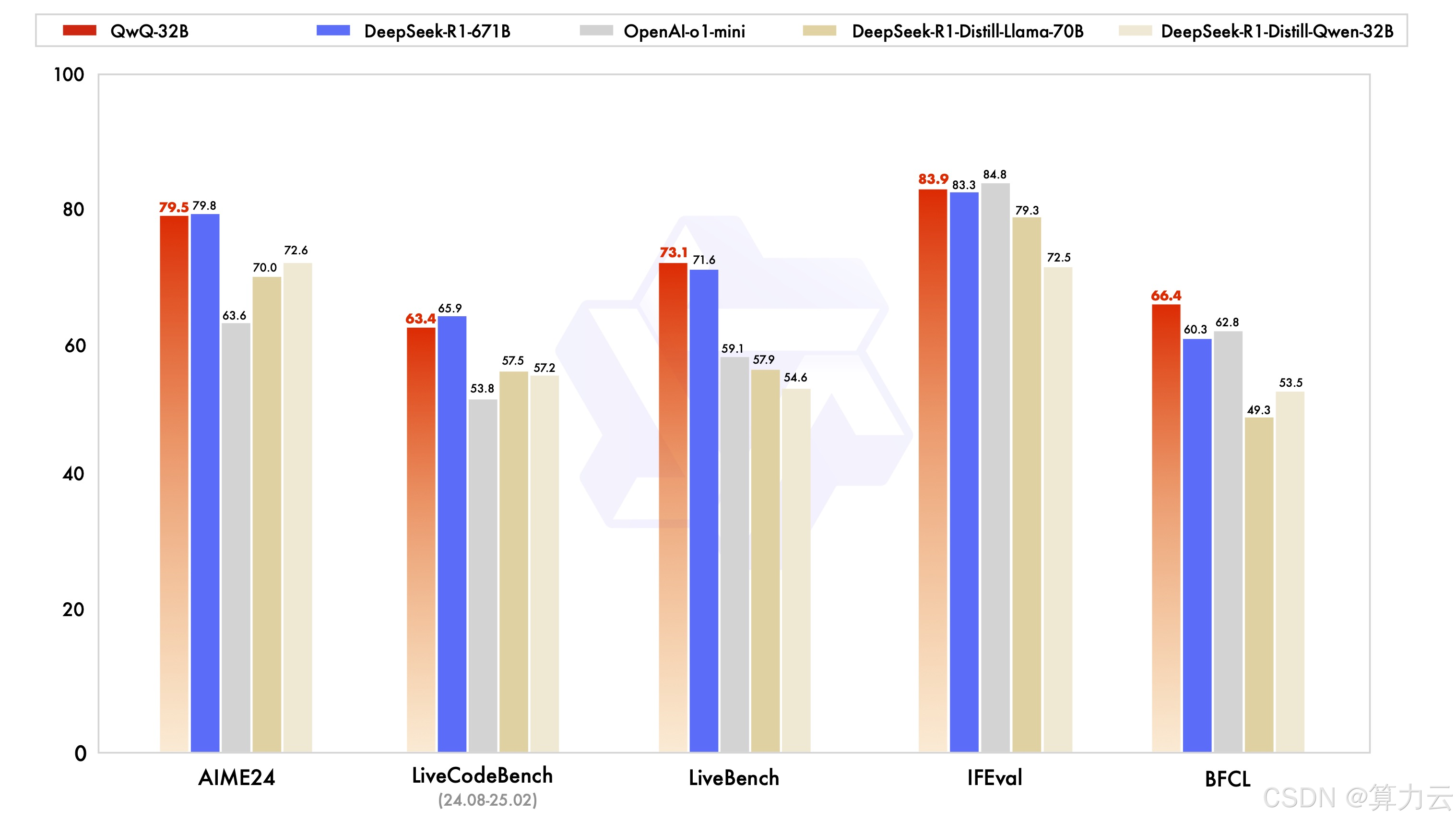

DeepSeek-R1 可通过整合冷启动数据和多阶段训练实现了最先进的性能,使其能够进行深度思考和复杂推理。而阿里云最新发布的开源推理模型QwQ-32B(Qwen with Questions)则是一个实验性研究模型,专注于增强 AI 推理能力。据说仅用32B,就击败o1-mini追平671B满血版DeepSeek-R1!被称为“开源全球最顶尖模型”。

QwQ-32B模型发布及登上热门榜单,以320亿参数规模实现性能比肩6710亿参数的DeepSeek-R1,甚至还在多项基准测试中全面超越o1-mini。

不仅如此,QwQ-32B模型还将部署成本压缩至消费级显卡可承载范围。在数学推理、代码生成等核心场景表现卓越,并通过全量开源Apache2.0协议加速端侧AI生态构建,标志着超低密度智能时代的范式革命。种种实力让QwQ-32B被称为「推理能力天花板」与「实用性典范」的完美结合。

目前,阿里以宽松的Apache2.0协议将QwQ-32B全面开源,全球开发者与企业均可免费下载、商用。国内不少算力平台也接入了QwQ-32B开源模型供所有用户使用。

如何启动QwQ-32B模型?

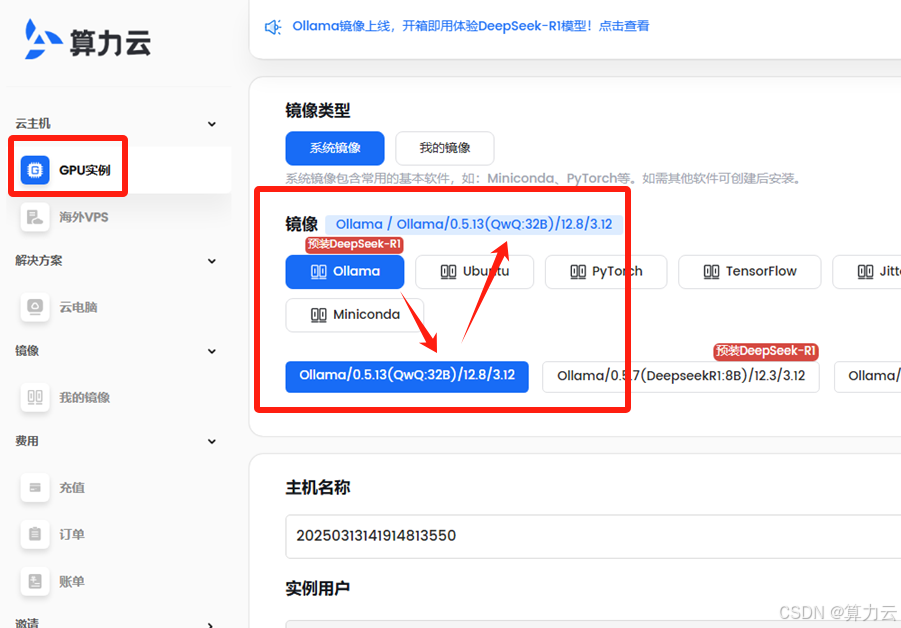

进入算力云控制台(www.suanlix.cn),选择「GPU实例」并「创建」实例,在创建过程中的「镜像」部分会看到相关提示,根据提示进行选择即可。

创建GPU实例后,在连接方式下方点击“Ollama WebUI"进入页面

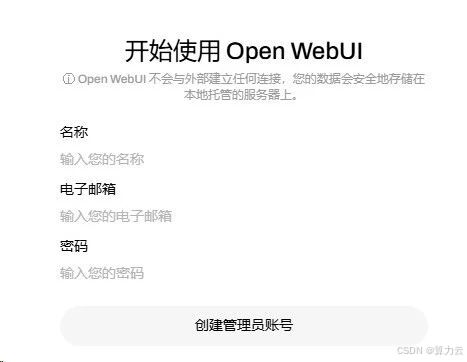

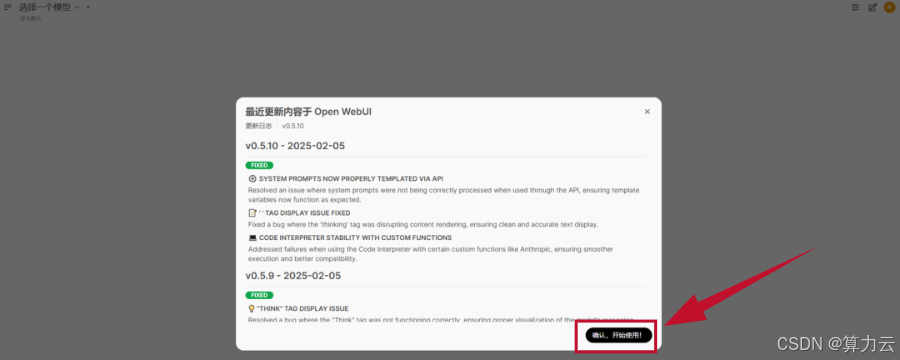

进入网页的用户创建管理员账号与密码后,点击「确认,开始使用!」

在左上角的输入框中输入想要的模型模型名称以及参数或者直接粘贴复制的ollama run命令,从Ollama.com拉取模型。本教程选择“QwQ-32B”并开始下载模型。

模型下载完成后,Ollama将自动启动QwQ-32B,并进入交互模式。

此时,你可以直接在终端中输入问题或指令,与QwQ-32B进行对话:在终端中输入你的问题或指令,模型会立即生成回复。

205

205

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?