什么是LLaMA Factory?

LLaMA Factory 是一个开源的大语言模型微调框架,它提供了一套高效、易用的工具集,支持多种主流大语言模型(如LLaMA、ChatGLM、Qwen 等)的微调与部署。该框架具有以下突出特点:

·支持模型丰富:兼容100+ 种大语言模型,涵盖LLaMA、Baichuan、ChatGLM、Qwen 等主流架构

·训练效率高:集成多种高效微调技术(LoRA、QLoRA 等),大幅降低显存需求

·界面友好:提供直观的Web UI,支持零代码操作的模型训练与推理

·功能完整:覆盖模型预训练、指令微调、奖励模型训练等全流程

无论您是研究者、开发者还是企业用户,LLaMA Factory 都能帮助您快速构建和定制专属的大语言模型应用。

环境安装与LLaMA Factory配置

一、安装git

在终端中执行以下命令,安装Git 工具:

sudo apt install git

二、下载LLama-factory

二、下载LLama-factory

使用Git 克隆LLaMA Factory

项目仓库:git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

三、安装conda

1、安装Conda 所需依赖:

sudo apt install libgl1-mesa-glx libegl1-mesa libxrandr2 libxrandr2 libxss1 libxcursor1 libxcomposite1 libasound2 libxi6 libxtst6

2、下载conda 安装包

wget https://repo.anaconda.com/archive/Anaconda3-2024.10-1-Linux-x86_64.sh

3、安装conda

bash Anaconda3-2024.10-1-Linux-x86_64.sh

一路回车和yes,注意: 终端出现Anaconda3 will now be installed into this location:可输入自定义路径进而支持自定义conda安装路径(直接回车会默认安装到HOME目录)。

4、conda配置环境,默认没有配置环境(如下图)

查看conda安装位置

输入nano ~/.bashrc

在bashrc文件的最后一行加入:export PATH=/home/ad/anaconda3/bin:$PATH (ad是自己的用户名)。按Ctrl+x

保存并退出编辑

配置生效

用conda -V查看版本正常了

四、创建环境

1、创建llama-factory微调环境

conda create -n llama-factory python=3.10

激活环境

conda activate llama-factory

我这里配置环境后直接进入激活环境报错(要先初始化)

解决:

source activate(重新进入虚拟环境)

conda deactivate (退出性能环境)

conda activate llama-factory(重新激活虚拟环境)

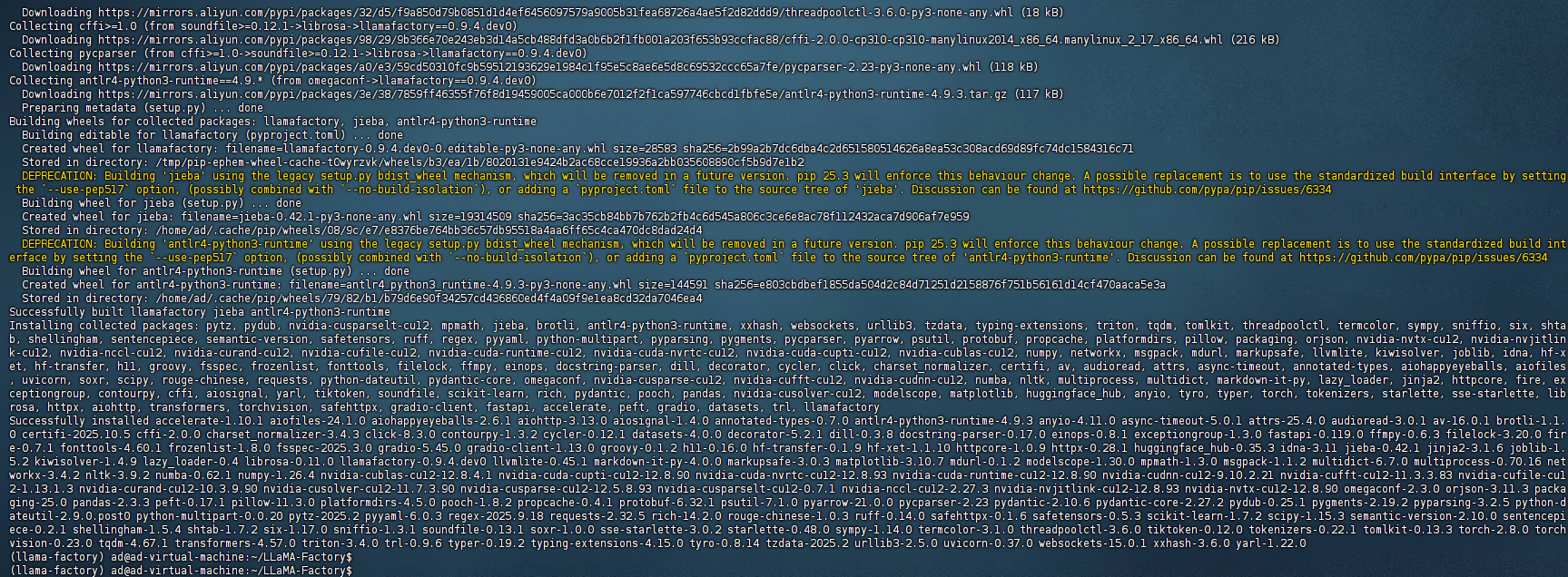

2、进入llama-factory环境后,进入到LLama-Factory文件下,安装相关依赖

pip install -e “.[torch,metrics]” --no-build-isolation -i https://mirrors.aliyun.com/pypi/simple

3、启动LLama-Factory

(这里我用的是虚拟机ubuntu20.4安装LLama-Factory,可以在win系统下通过虚拟机IP地址访问LLama-Factory界面)

ubuntu可视化系统也能访问LLama-Factory

五、gradio公开域名微调

如果ubuntu是服务器版本没有桌面的,你又想使用图形化微调,可以通过

gradio创建公开域名链接进行微调

0表示第一张显卡:CUDA_VISIBLE_DEVICES=0

1表示创建1个域名链接:GRADIO_SHARE=1

查看有多少张卡:nvidia-smi -L

1、启动命令行:

CUDA_VISIBLE_DEVICES=0 GRADIO_SHARE=1 llamafactory-cli

gradio报错:

解决:

创建目录:mkdir -p /home/ad/.cache/huggingface/gradio/frpc

进入目录:cd /home/ad/.cache/huggingface/gradio/frpc

这个下载方式可能有问题:

wget https://github.com/gradio-app/gradio/raw/main/gradio/frpc_linux_amd64-O frpc_linux_amd64_v0.3

我用win浏览器下载,然后手动上传到frpc文件下:

链接:https://cdn-media.huggingface.co/frpc-gradio-0.3/frpc_linux_amd64

上传进frpc文件里,然后重命名

mv frpc_linux_amd64 frpc_linux_amd64_v0.3

添加权限 chmod +x frpc_linux_amd64_v0.3

启动 CUDA_VISIBLE_DEVICES=0 GRADIO_SHARE=1 llamafactory-cli webui

这样就生成了一条公开域名,你也可以分享给其他人用:

https://265175b551a47a2dd5.gradio.live/

六、下载模型

方法一:从Hugging-Face上下载

1、创建文件夹存放模型:mkdir Hugging-Face

2、临时修改HuggingFace镜像源(加速下载)

export HF_ENDPOINT=https://hf-mirror.com

3、临时修改模型默认下载位置

export HF_HOME=/home/ad/Hugging-Face

4、2和3是临时会话的,永久配置教程:

进入配置文件: sudo vi ~/.bashrc

写入内容:

export HF_ENDPOINT=https://hf-mirror.com

export HF_HOME=/data/Hugging-Face

按i编辑,按Esc再按:wq (保存退出)退出后,配置生效:

source ~/.bashrc

5、验证生效

echo $HF_HOMEecho

$HF_ENDPOINT

6、安装HuggingFace官方下载工具

pip install -U huggingface_hub -i https://mirrors.aliyun.com/pypi/simple

7、选择模型:

https://huggingface.co/Qwen/Qwen1.5-4B-Chat

8、下载模型:

huggingface-cli download --resume-download Qwen/Qwen1.5-4B-Chat

黄色是警告,这里说旧命令已经被弃用:⚠️ Warning: ‘huggingface-cli download’ is deprecated. Use ‘hf download’ instead.

8、模型加载成功(如果下载模型后没有自动显示路径,则需要自己到ubuntu找到模型下载的路径进行复制放到Model Path)

方法二:git lfs 下载模型方式

1、安装命令:sudo apt install git-lfs

2、魔塔找需要的模型链接:https://modelscope.cn/models

3、下载模型:

git clone https://www.modelscope.cn/Qwen/Qwen1.5-0.5B-Chat.git

方法三:modelscope下载模型方式

1、在llama-factory环境下载modelscope库,通过库下载:pip install modelscope

2、下载Qwen模型

modelscope download --model Qwen/Qwen3-VL-30B-A3B-Instruct --local_dir ‘root/qwen/qwen’ (–local_dir 'root/qwen/qwen’修改下载地址到qwen文件)

完成以上步骤,至此你就可以微调大模型了

1966

1966

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?