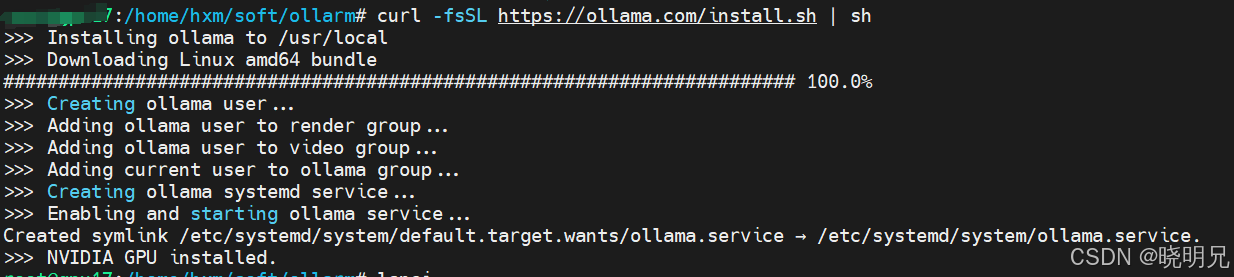

一、安装ollama

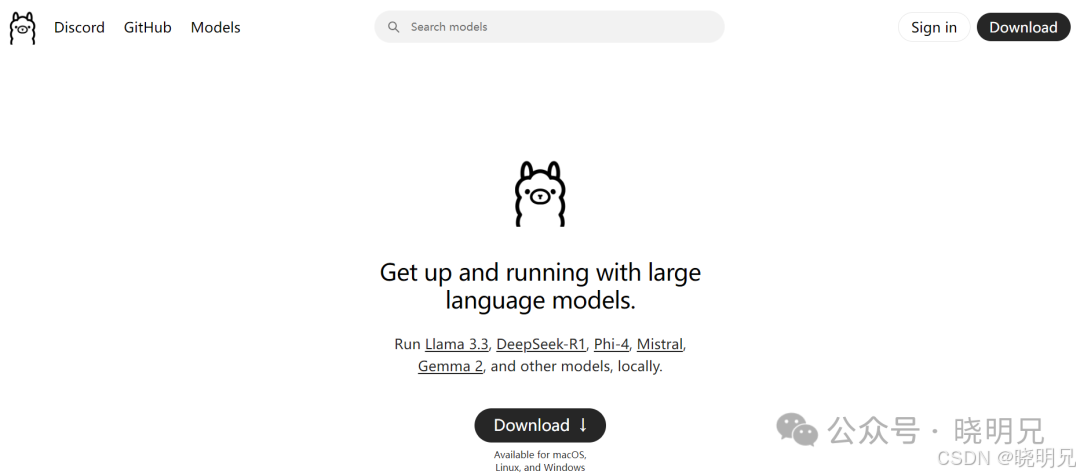

网址:https://ollama.com/

我这里是Linux系统,使用链接方式下载。

这是windos方法

安装完成后,桌面右下角会显示ollama图标

官网地址:https://ollama.com 安裝包可以回复:6020 进行下载

二、下载DeepSeek-R1 模型

2.1 找模型

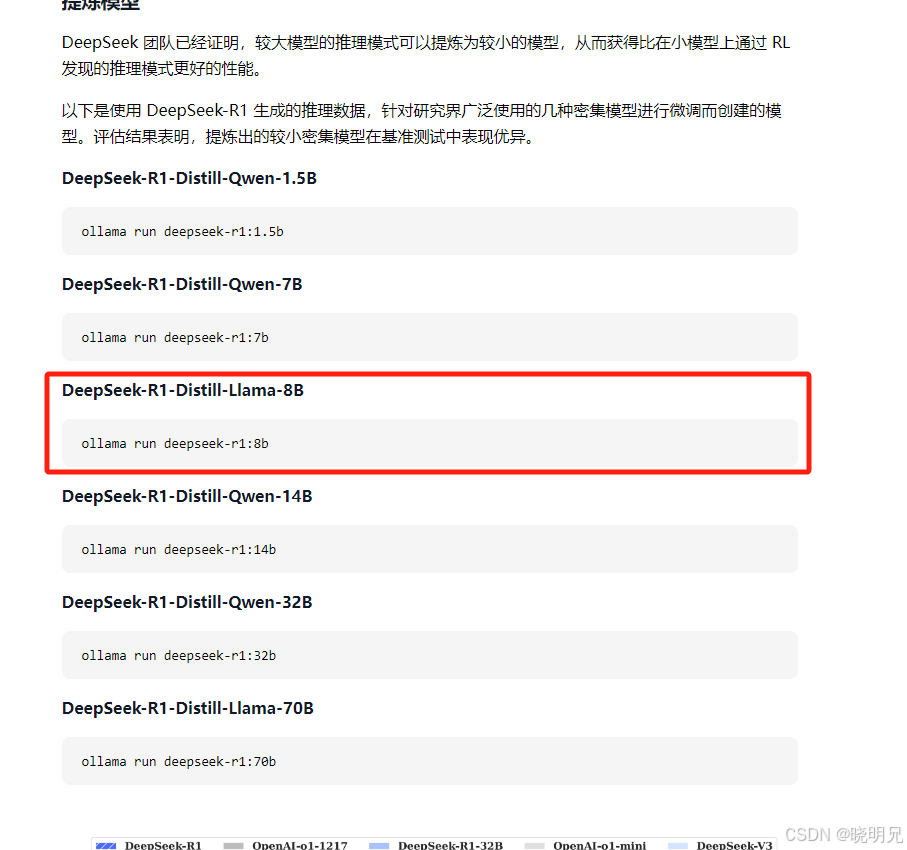

可以看到模型有根据参数分为1.5b,7b,8b,14b,32b,70b,671b等,我们需要根据自己电脑选择下载对应参数的模型。

我们可以问题下deepseek

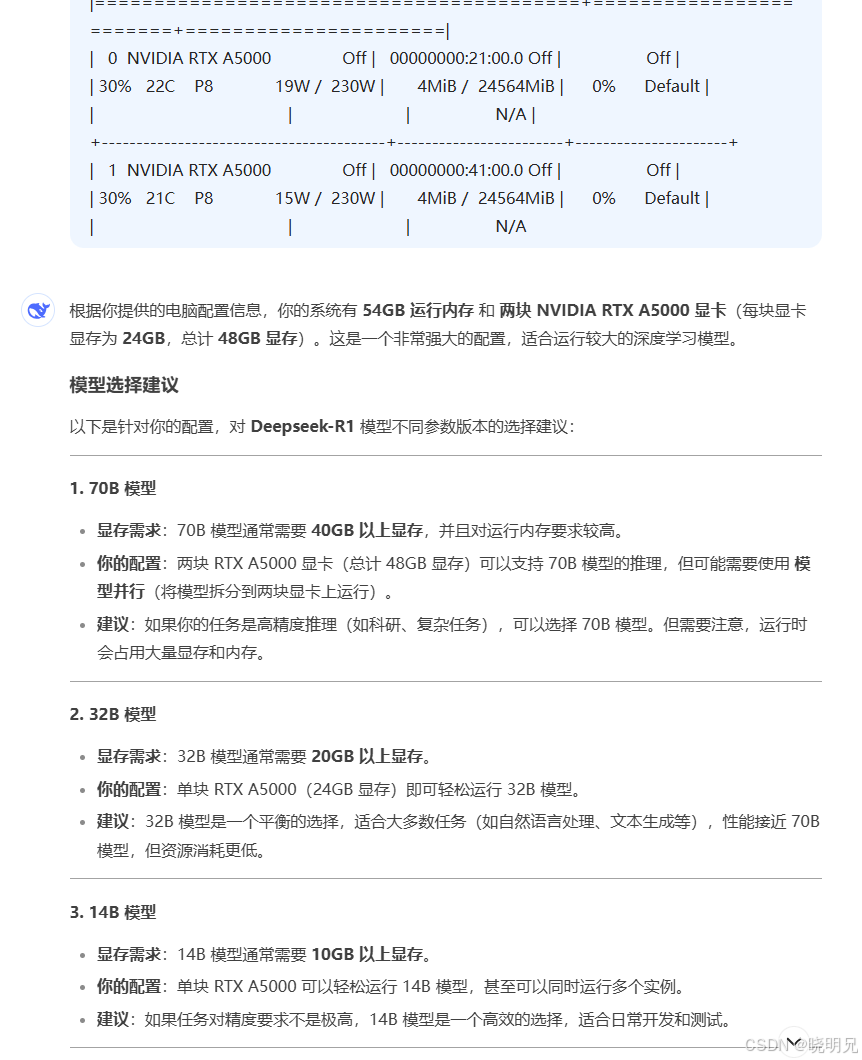

2.2 询问配置适合哪个模型

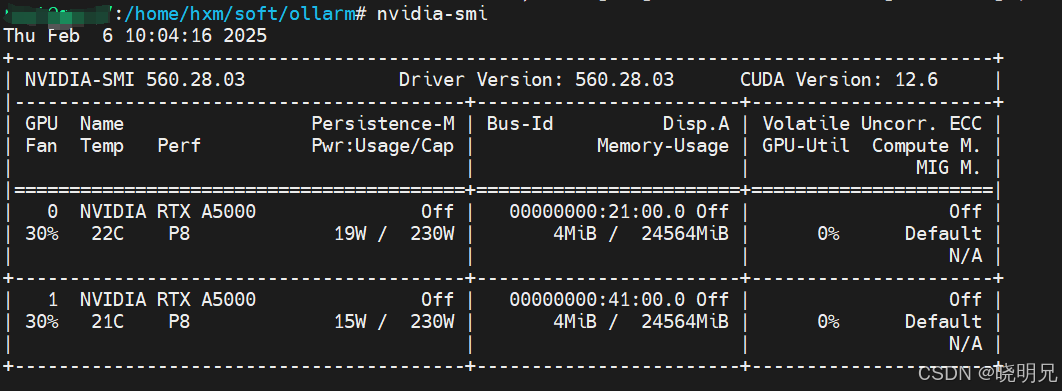

2.2.1 查询本机配置

内存大小和显卡大小

提示词如下:

我现在正在使用ollama部署deepseek-r1模型,但是模型分为1.5b,7b,8b,14b,32b,70b,671b等,我不知道该怎么选择适合我电脑配置模型了,我现在把我电脑的配置信息告诉你,你帮我选择一下吧

个人电脑信息如下:

系统:centos

运行内存:54G

英伟达显卡:

|=========================================+========================+======================|

| 0 NVIDIA RTX A5000 Off | 00000000:21:00.0 Off | Off |

| 30% 22C P8 19W / 230W | 4MiB / 24564MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 1 NVIDIA RTX A5000 Off | 00000000:41:00.0 Off | Off |

| 30% 21C P8 15W / 230W | 4MiB / 24564MiB | 0% Default |

| | | N/A

根据建议,我选择使用8B的。

2.2.3 安装模型

这个时间会比较长,需要耐心等待

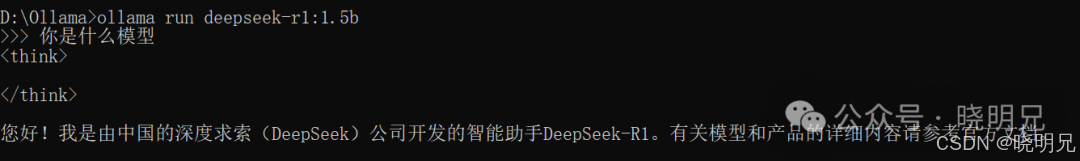

2.2.4 测试

安装完成后 需要测试一下。

项目体验展示:

直接用ollama run deepseek-r1:1.5b命令启动。运行起来很流畅,回答得又快又好,简直就像有个智能助手在身边。

总结

Ollama真的是一个非常实用且易用的开源项目。它让我们这些“小白”也能轻松地在本地部署和管理大语言模型。无论你是开发者、研究人员还是爱好者,只要你对AI感兴趣,Ollama都是一个值得尝试的工具。

项目已经打包好了,关注“晓明兄”公众号,回复:6020 。里面有模型内容,拷贝到.ollama 文件夹中(例如 C:\Users<YourUsername>.ollama\models)

1381

1381

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?