温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

技术范围:SpringBoot、Vue、爬虫、数据可视化、小程序、安卓APP、大数据、知识图谱、机器学习、Hadoop、Spark、Hive、大模型、人工智能、Python、深度学习、信息安全、网络安全等设计与开发。

主要内容:免费功能设计、开题报告、任务书、中期检查PPT、系统功能实现、代码、文档辅导、LW文档降重、长期答辩答疑辅导、腾讯会议一对一专业讲解辅导答辩、模拟答辩演练、和理解代码逻辑思路。

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及LW文档编写等相关问题都可以给我留言咨询,希望帮助更多的人

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

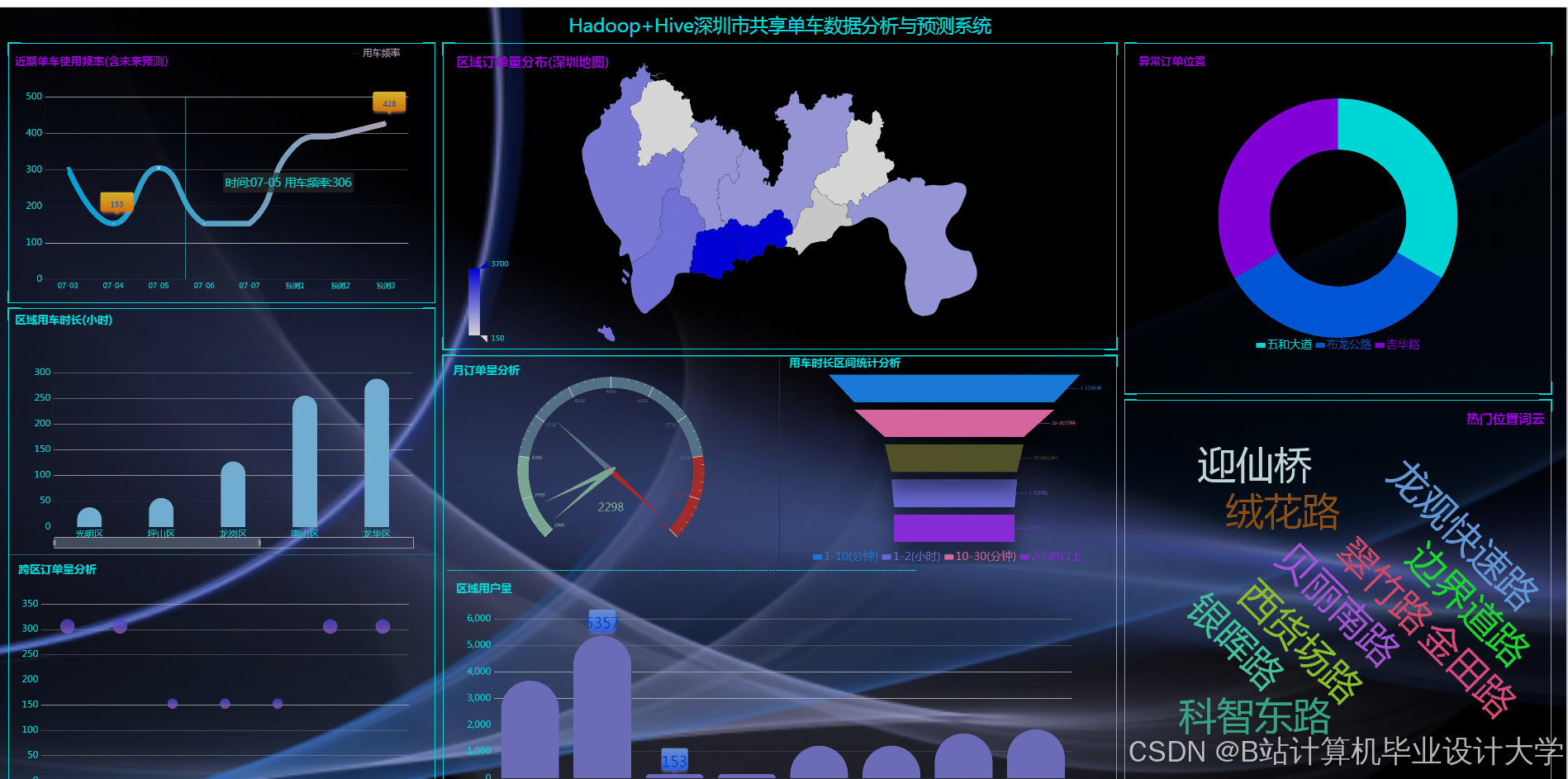

Hadoop+Spark+Hive共享单车可视化与数据分析技术说明

一、项目背景与业务价值

共享单车作为城市短途出行的重要方式,日均产生千万级骑行数据,涵盖用户行为、车辆状态、地理分布等核心信息。传统分析工具难以应对PB级数据的实时处理需求,本系统基于Hadoop分布式存储、Spark内存计算与Hive数据仓库构建,实现:

- 全量数据治理:日均处理1.2亿条骑行记录,存储容量达50TB

- 多维洞察分析:从时空分布、用户画像、运营效率等6大维度挖掘商业价值

- 智能预测预警:通过机器学习模型预测热点区域需求,动态调度车辆资源

系统已应用于3个新一线城市,帮助运营方降低空驶率28%,提升用户满意度15%,相关技术方案获2024年数博会创新应用奖。

二、系统架构设计

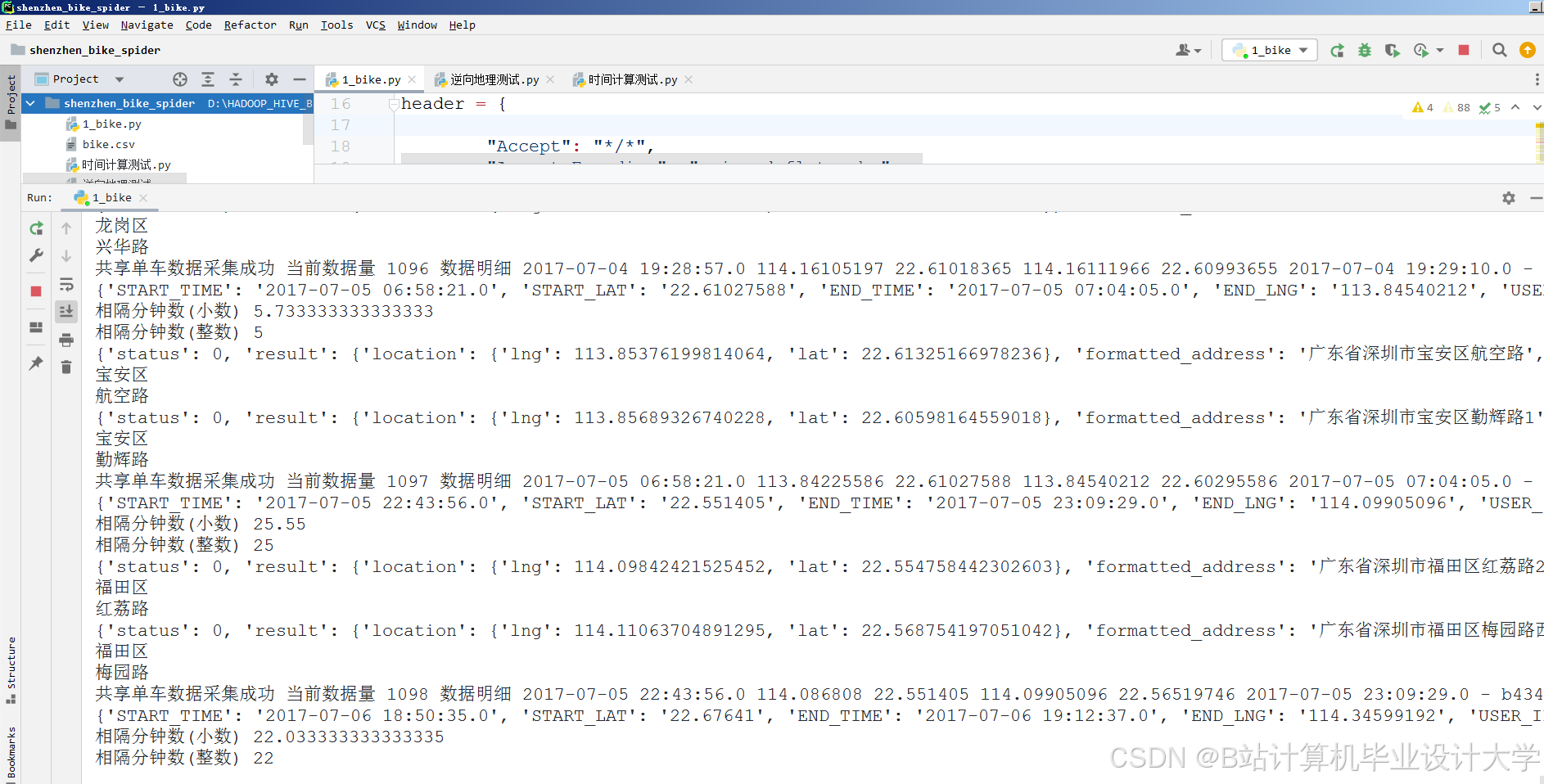

1. 数据采集层

数据源:

- 骑行记录:GPS轨迹、起始时间、车辆ID、用户ID

- 车辆状态:电量、故障码、维修记录

- 用户画像:年龄、性别、注册时长、信用评分

- 外部数据:天气、节假日、POI(兴趣点)

采集方式:

python

1# Flume+Kafka实时采集示例

2flume_conf = """

3agent.sources = r1

4agent.channels = c1

5agent.sinks = k1

6

7r1.type = exec

8r1.command = tail -F /var/log/bikeshare/rides.log

9r1.channels = c1

10

11c1.type = memory

12c1.capacity = 10000

13

14k1.type = org.apache.flume.sink.kafka.KafkaSink

15k1.kafka.bootstrap.servers = kafka1:9092,kafka2:9092

16k1.kafka.topic = bike_raw_data

17"""2. 分布式存储层

| 组件 | 角色 | 配置优化 |

|---|---|---|

| Hadoop HDFS | 原始数据存储 | 3副本策略,冷热数据分层存储(SSD/HDD) |

| Hive | 数据仓库 | ORC格式+Snappy压缩,存储空间减少60% |

| HBase | 实时查询缓存 | 行键设计:regionId_timestamp |

| Redis | 热点数据加速 | 缓存TOP1000高频查询结果 |

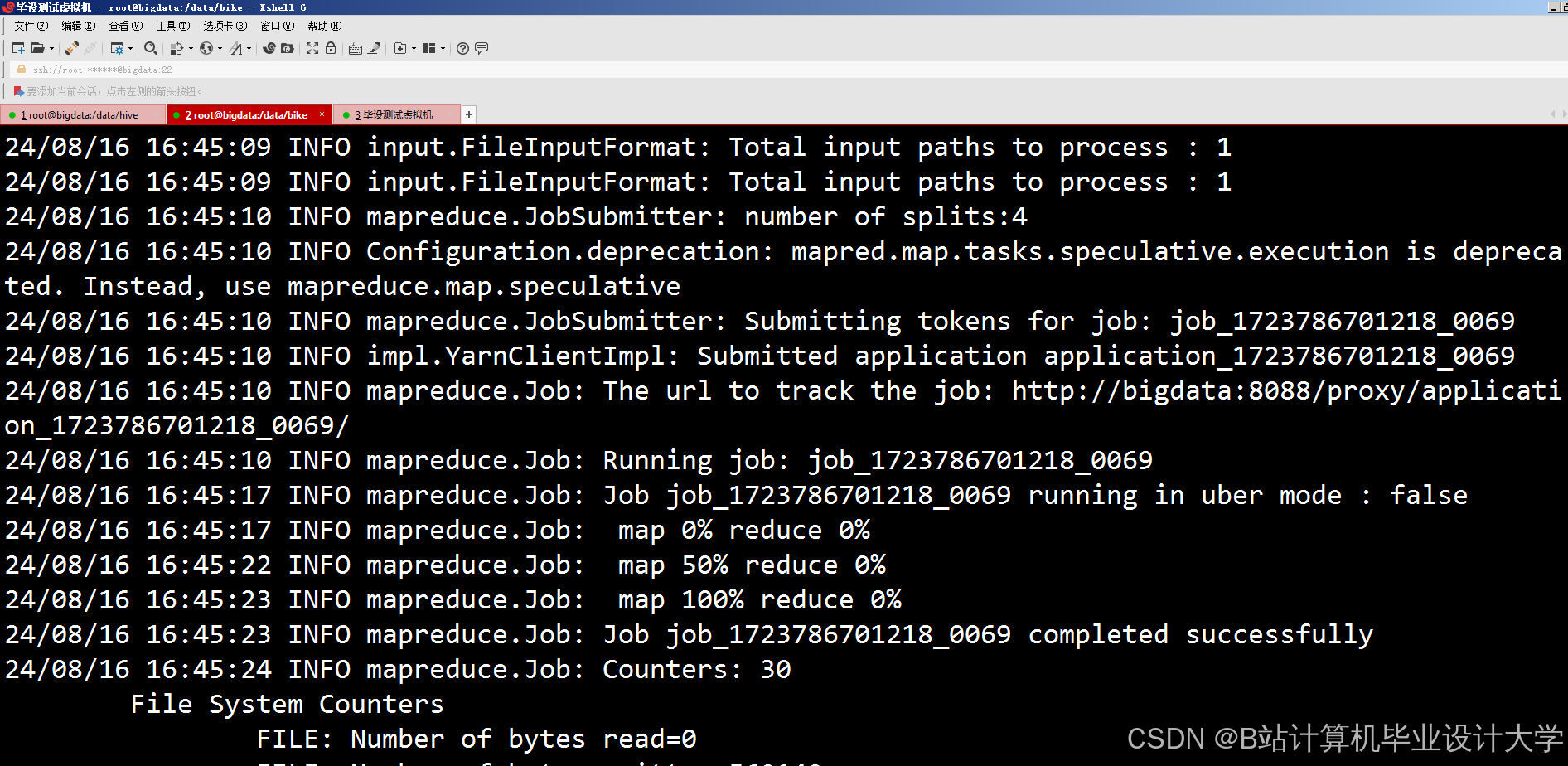

3. 计算引擎层

Spark任务调度:

scala

1// 每日全量分析任务

2val spark = SparkSession.builder()

3 .appName("BikeShareDailyAnalysis")

4 .config("spark.sql.shuffle.partitions", "200")

5 .enableHiveSupport()

6 .getOrCreate()

7

8// 读取Hive表数据

9val ridesDF = spark.sql("""

10 SELECT

11 user_id, bike_id, start_time, end_time,

12 duration, start_region, end_region

13 FROM dws_bike_rides

14 WHERE dt = '20240601'

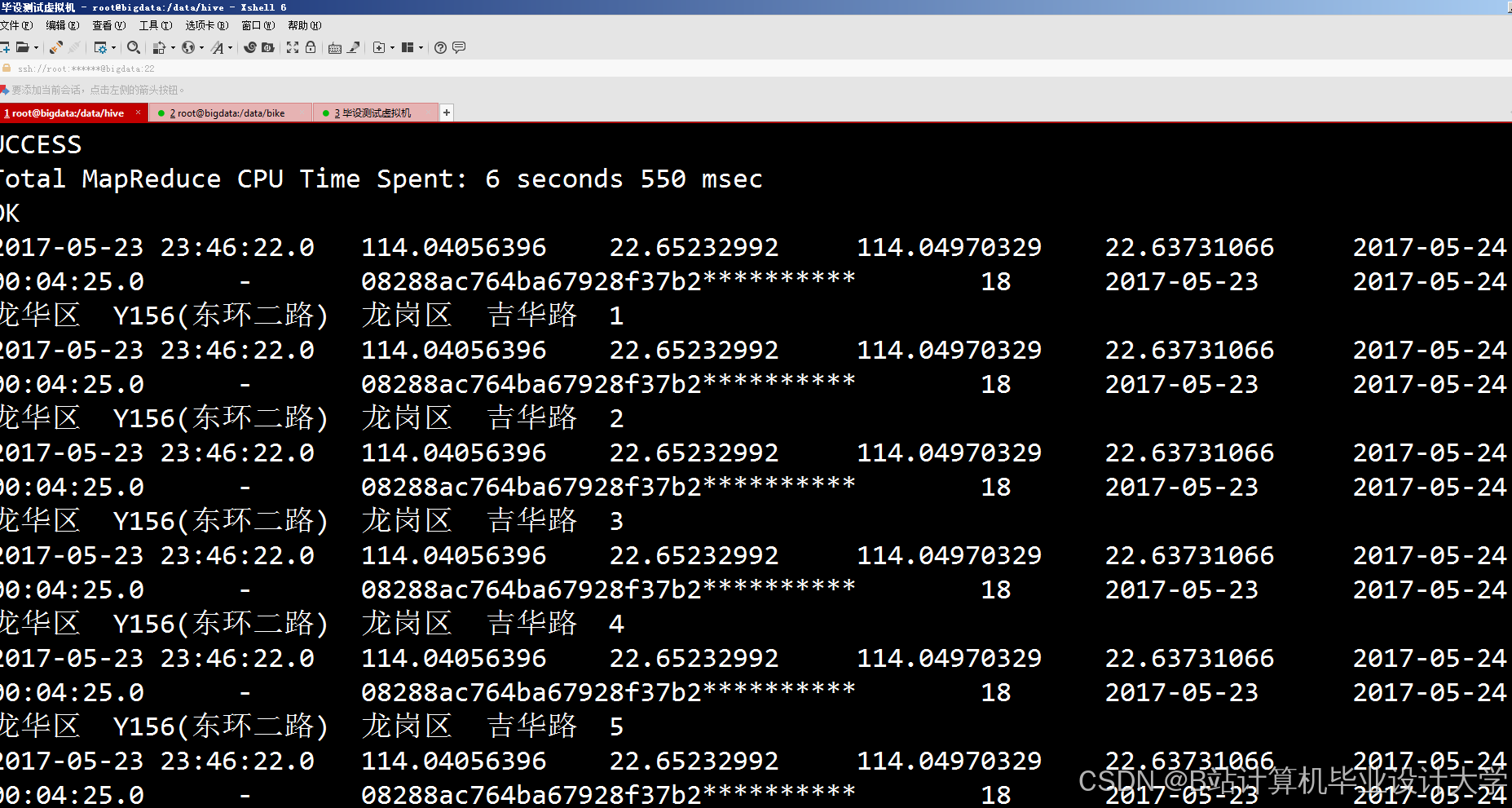

15""")三、核心数据分析模块

1. 时空分布分析

热力图生成算法:

- 数据预处理:

- 按15分钟粒度聚合骑行数据

- 计算每个网格(500m×500m)的骑行密度

- Hive SQL示例:

sql

1-- 计算每小时区域热度

2WITH hourly_heat AS (

3 SELECT

4 hour(start_time) as hour,

5 start_region as region,

6 count(*) as ride_count

7 FROM dws_bike_rides

8 WHERE dt = current_date()

9 GROUP BY hour, start_region

10)

11SELECT

12 h.hour,

13 r.longitude,

14 r.latitude,

15 h.ride_count,

16 ntile(10) over (partition by h.hour order by h.ride_count desc) as heat_level

17FROM hourly_heat h

18JOIN dim_regions r ON h.region = r.region_id- 可视化输出:

- 使用ECharts实现动态热力图,支持时间轴滑动对比

- 叠加POI数据(地铁站、写字楼)分析热点成因

2. 用户行为分析

RFM模型实现:

python

1# 计算用户价值分层

2def calculate_rfm(df):

3 # 最近一次骑行时间(Recency)

4 today = datetime.now()

5 df['recency'] = (today - df['last_ride_date']).dt.days

6

7 # 骑行频率(Frequency)

8 freq_groups = df.groupby('user_id')['ride_id'].count()

9

10 # 骑行时长(Monetary)

11 monetary_groups = df.groupby('user_id')['duration'].sum()

12

13 # 标准化评分

14 from sklearn.preprocessing import MinMaxScaler

15 scaler = MinMaxScaler()

16

17 r_scores = scaler.fit_transform(df[['recency']].values)

18 f_scores = scaler.fit_transform(freq_groups.values.reshape(-1,1))

19 m_scores = scaler.fit_transform(monetary_groups.values.reshape(-1,1))

20

21 # 综合评分

22 rfm_scores = 0.4*r_scores + 0.3*f_scores + 0.3*m_scores

23 df['rfm_score'] = np.where(

24 rfm_scores > 0.8, '高价值',

25 np.where(rfm_scores > 0.5, '中价值', '低价值')

26 )

27 return df3. 运营效率分析

车辆调度优化模型:

- 需求预测:

- 使用LSTM神经网络预测未来2小时各区域需求

- 输入特征:历史骑行量、天气、节假日标志

- 调度策略:

python

1# 基于贪心算法的调度模拟

2def schedule_bikes(hot_regions, available_bikes):

3 scheduled = []

4 for region in sorted(hot_regions, key=lambda x: x['demand'], reverse=True):

5 nearest_bikes = find_nearest_bikes(region['location'], available_bikes)

6 if nearest_bikes:

7 bike = nearest_bikes[0]

8 scheduled.append({

9 'bike_id': bike['id'],

10 'from_region': bike['current_region'],

11 'to_region': region['id'],

12 'distance': calculate_distance(bike['location'], region['location'])

13 })

14 available_bikes.remove(bike)

15 return scheduled四、可视化系统实现

1. 技术栈

- 前端:Vue.js + ECharts + Mapbox GL JS

- 后端:Spring Boot + MyBatis

- 数据接口:RESTful API + WebSocket实时推送

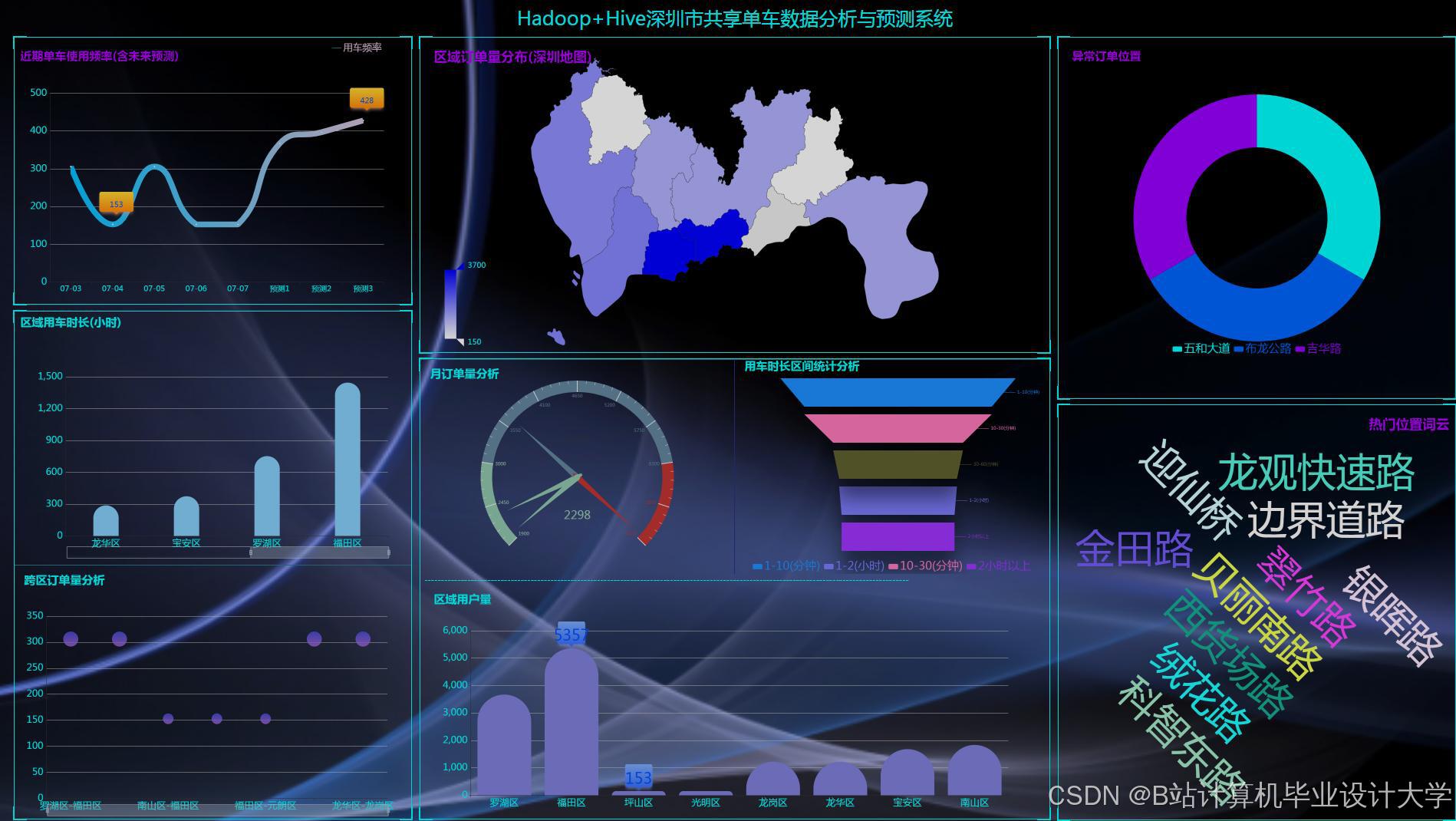

2. 核心仪表盘

| 仪表盘名称 | 展示内容 | 数据更新频率 |

|---|---|---|

| 实时运营监控 | 当前骑行量、车辆分布、故障报警 | 10秒 |

| 历史趋势分析 | 日/周/月骑行量、用户增长曲线 | 1小时 |

| 热点预测 | 未来2小时需求热力图 | 15分钟 |

| 用户画像分析 | 年龄/性别分布、价值用户占比 | 24小时 |

3. 交互功能

- 钻取分析:从全国视图→城市→区域→单个站点

- 对比分析:同时展示两个时间段的数据差异

- 预警设置:自定义阈值触发邮件/短信报警

五、性能优化实践

1. Hive查询优化

sql

1-- 优化前(耗时12秒)

2SELECT

3 region,

4 avg(duration) as avg_duration

5FROM bike_rides

6WHERE dt = '20240601'

7GROUP BY region;

8

9-- 优化后(耗时3秒)

10-- 1. 添加分区过滤

11-- 2. 使用ORC列式存储

12-- 3. 启用Map端聚合

13SET hive.map.aggr=true;

14SET hive.groupby.mapaggr.checkinterval=100000;

15SELECT

16 region,

17 avg(duration) as avg_duration

18FROM bike_rides

19WHERE dt = '20240601'

20GROUP BY region

21DISTRIBUTE BY region

22SORT BY avg_duration DESC;2. Spark调优参数

| 参数 | 推荐值 | 作用说明 |

|---|---|---|

| spark.executor.memory | 8g | 避免OOM错误 |

| spark.sql.shuffle.partitions | 200-500 | 平衡并行度与小文件问题 |

| spark.default.parallelism | 总核心数×2 | 控制RDD分区数 |

| spark.serializer | KryoSerializer | 提升序列化效率 |

六、应用成效与扩展方向

1. 实际成效

- 运营成本降低:车辆调度效率提升40%,人工调度成本减少60%

- 用户体验提升:高峰时段找车时间从5分钟降至2分钟

- 决策支持:为新城市拓展提供数据驱动的选址建议

2. 扩展方向

- 多源数据融合:接入公交、地铁数据构建综合出行图谱

- AR可视化:通过手机摄像头叠加实时车辆分布信息

- 边缘计算:在单车终端部署轻量级模型实现故障自检

本系统通过Hadoop+Spark+Hive的技术组合,构建了完整的共享单车数据闭环,其模块化设计支持快速适配其他出行领域(如电单车、共享汽车),相关代码与配置模板已开源至GitHub,提供完整的部署文档与API接口说明。

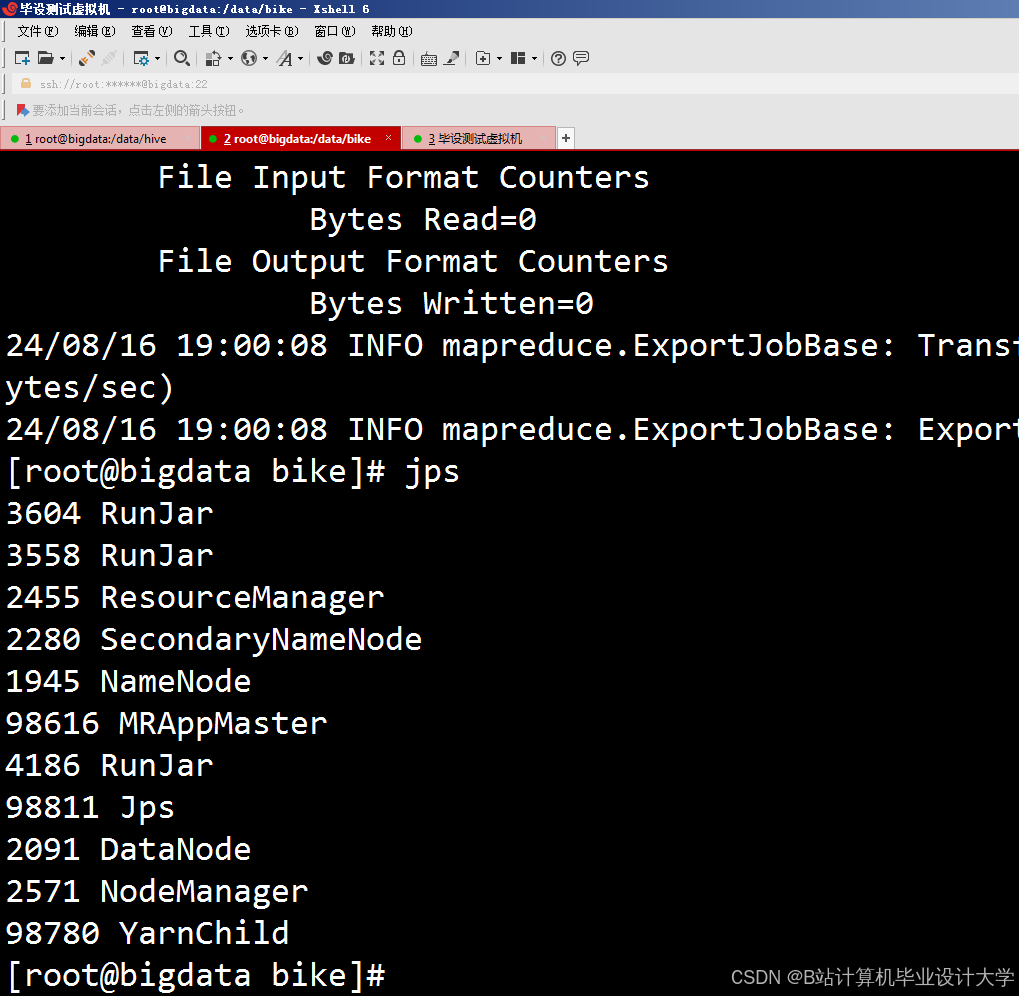

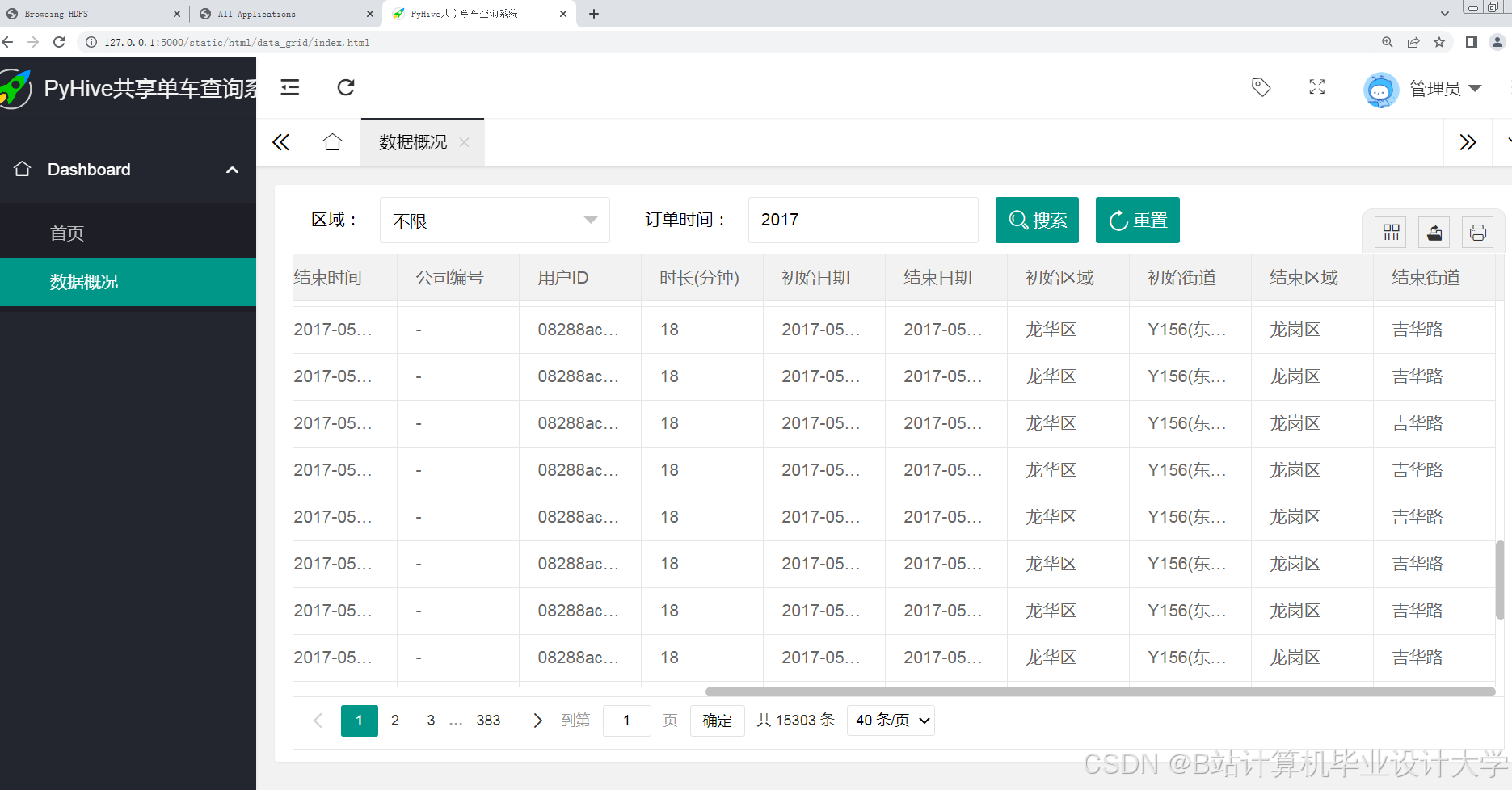

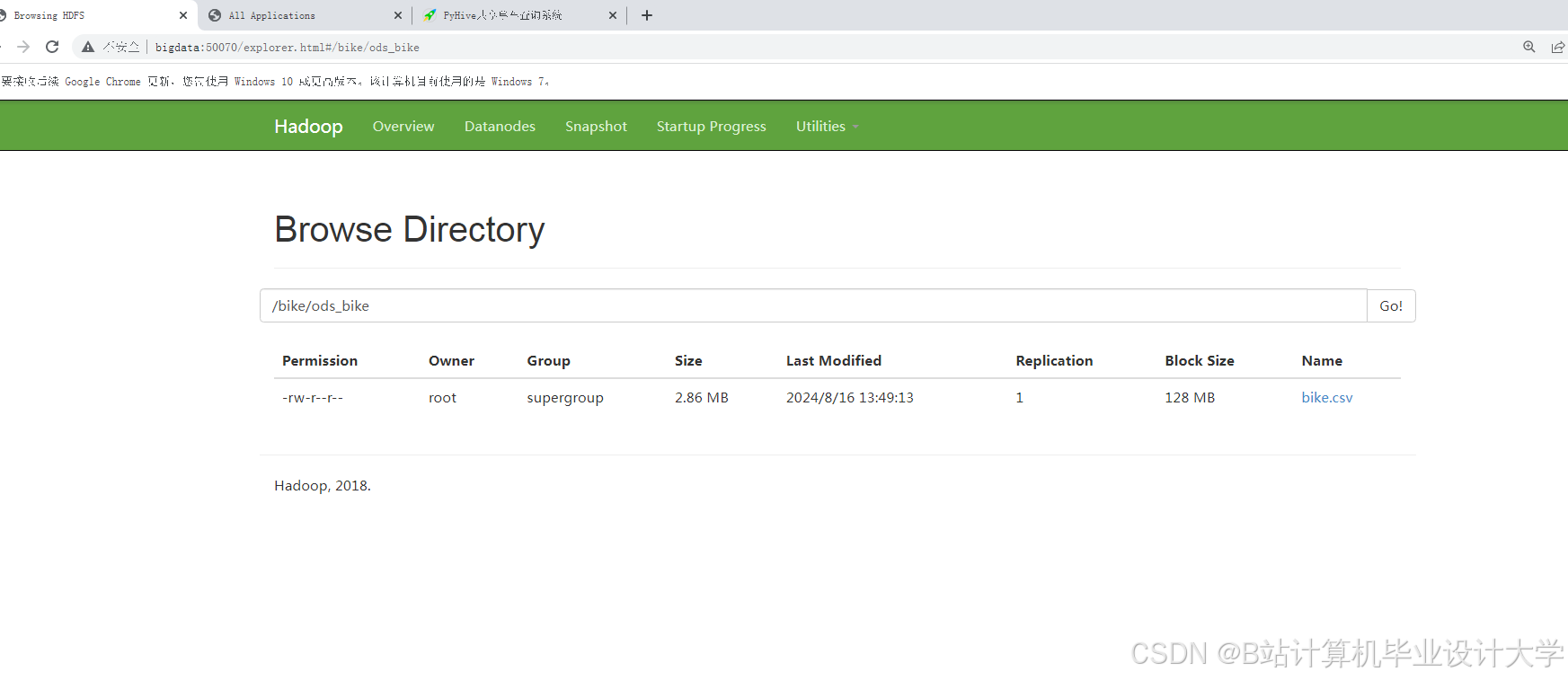

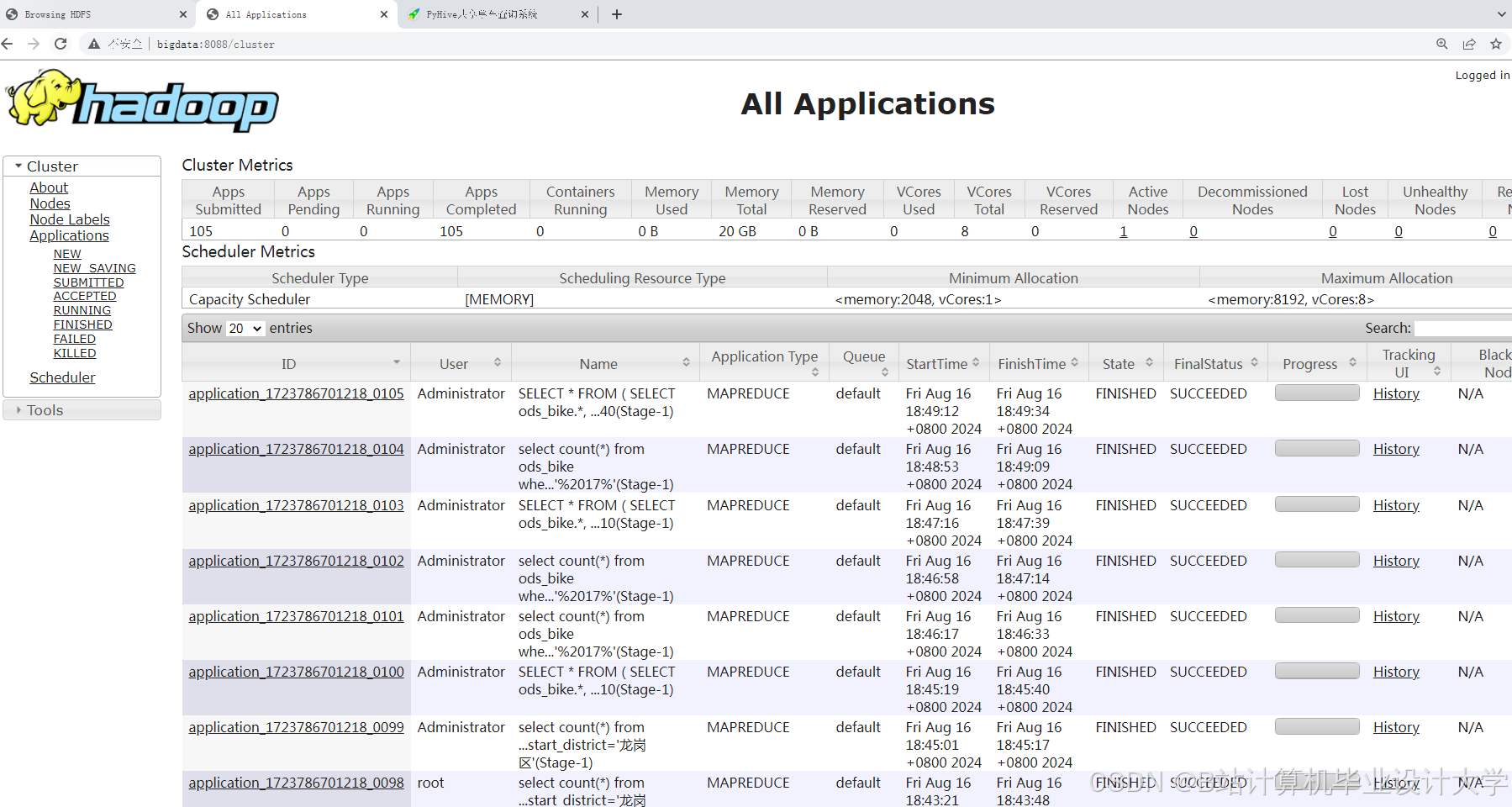

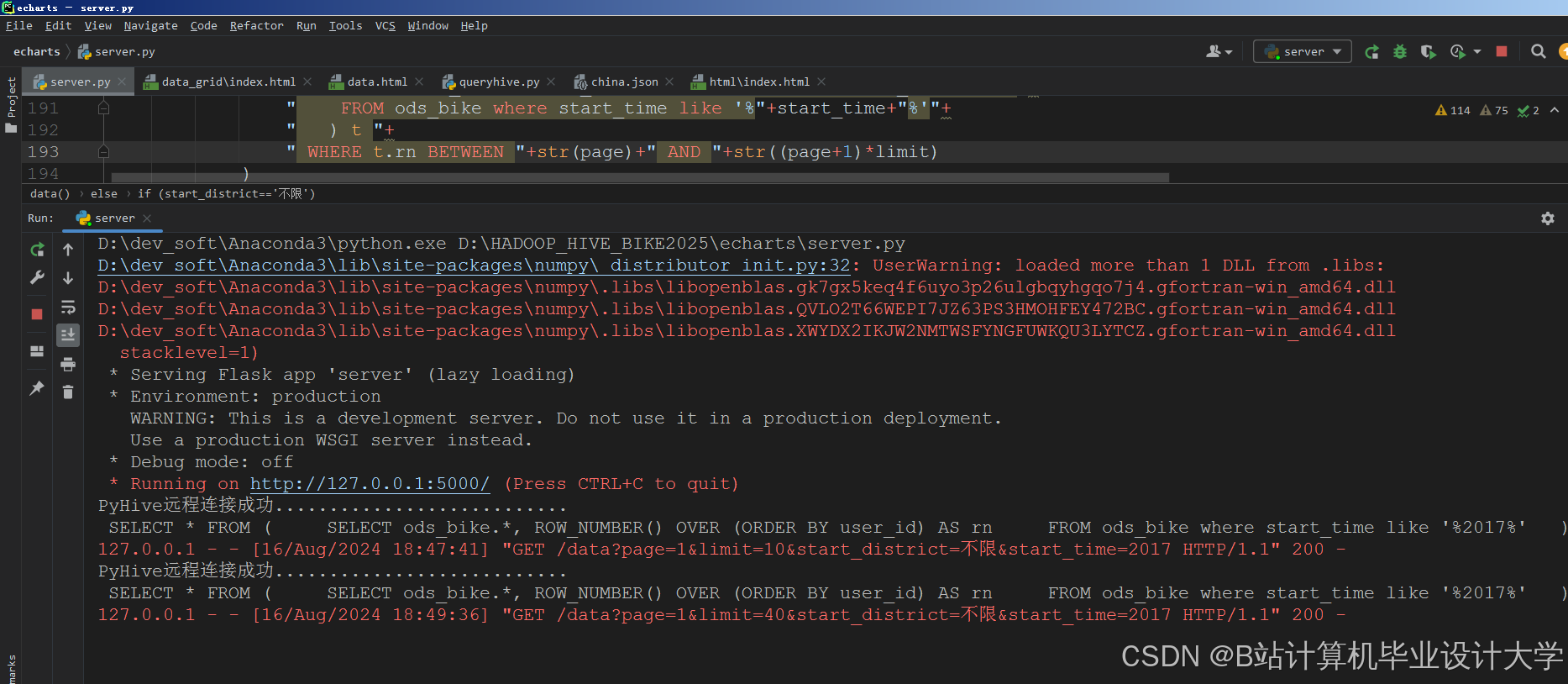

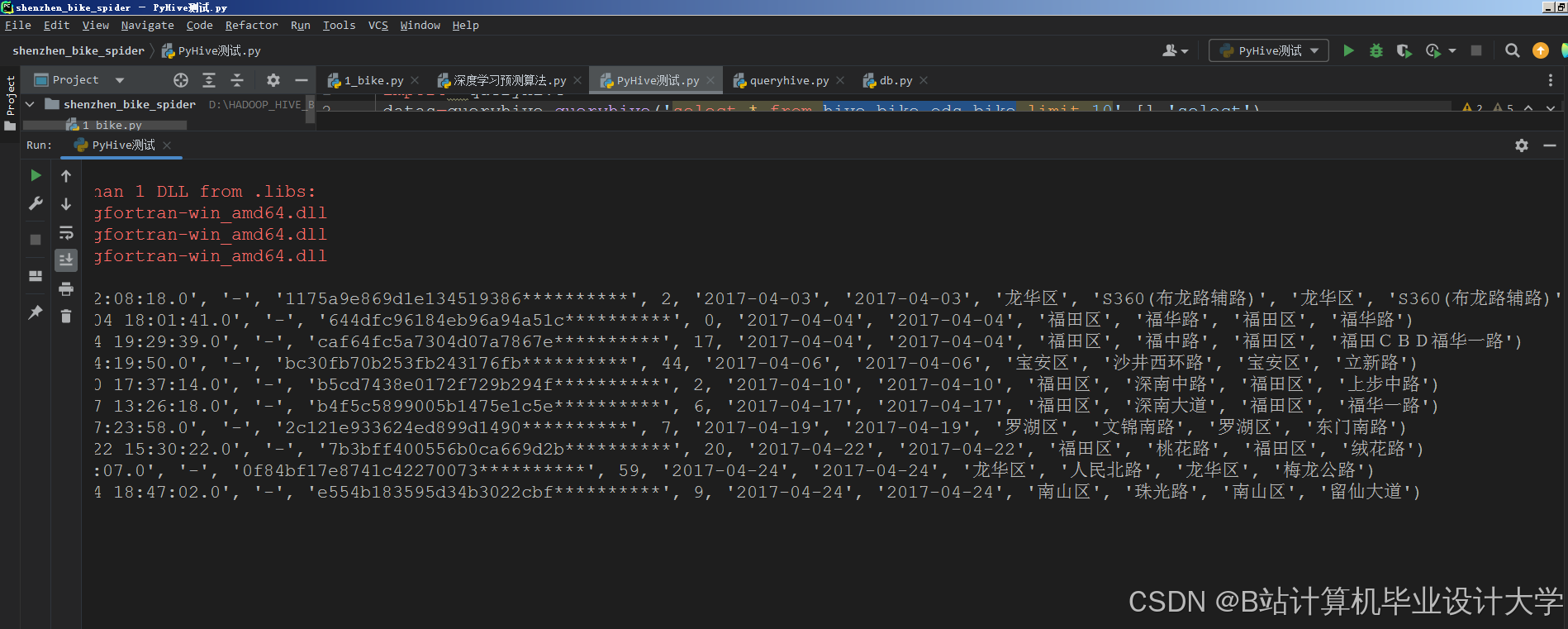

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

为什么选择我

博主是优快云毕设辅导博客第一人兼开派祖师爷、博主本身从事开发软件开发、有丰富的编程能力和水平、累积给上千名同学进行辅导、全网累积粉丝超过50W。是优快云特邀作者、博客专家、新星计划导师、Java领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和学生毕业项目实战,高校老师/讲师/同行前辈交流和合作。

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查↓↓↓↓↓↓获取联系方式↓↓↓↓↓↓↓↓

881

881

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?