温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份关于《Python+百度千问大模型微博舆情分析预测》的任务书模板,结合技术实现与业务需求设计,可根据实际场景调整内容:

任务书:Python+百度千问大模型微博舆情分析预测系统

一、项目背景与目标

- 背景

- 微博作为中国主流社交媒体平台,日均产生数亿条舆情数据,涵盖热点事件、公众情绪、品牌口碑等关键信息。

- 传统舆情分析依赖关键词匹配与简单情感分类,难以处理复杂语义、多模态内容(如图片、视频)及动态趋势预测。

- 百度千问大模型(QianWen)具备强大的自然语言理解与生成能力,结合Python的数据处理与机器学习生态,可构建智能化舆情分析预测系统。

- 目标

- 设计并实现一个基于Python与百度千问大模型的微博舆情分析系统,支持实时数据采集、情感分析、主题聚类与趋势预测。

- 通过大模型提取深层语义特征,提升舆情分类准确率与预测时效性,辅助政府、企业决策。

二、任务内容与要求

1. 系统功能模块

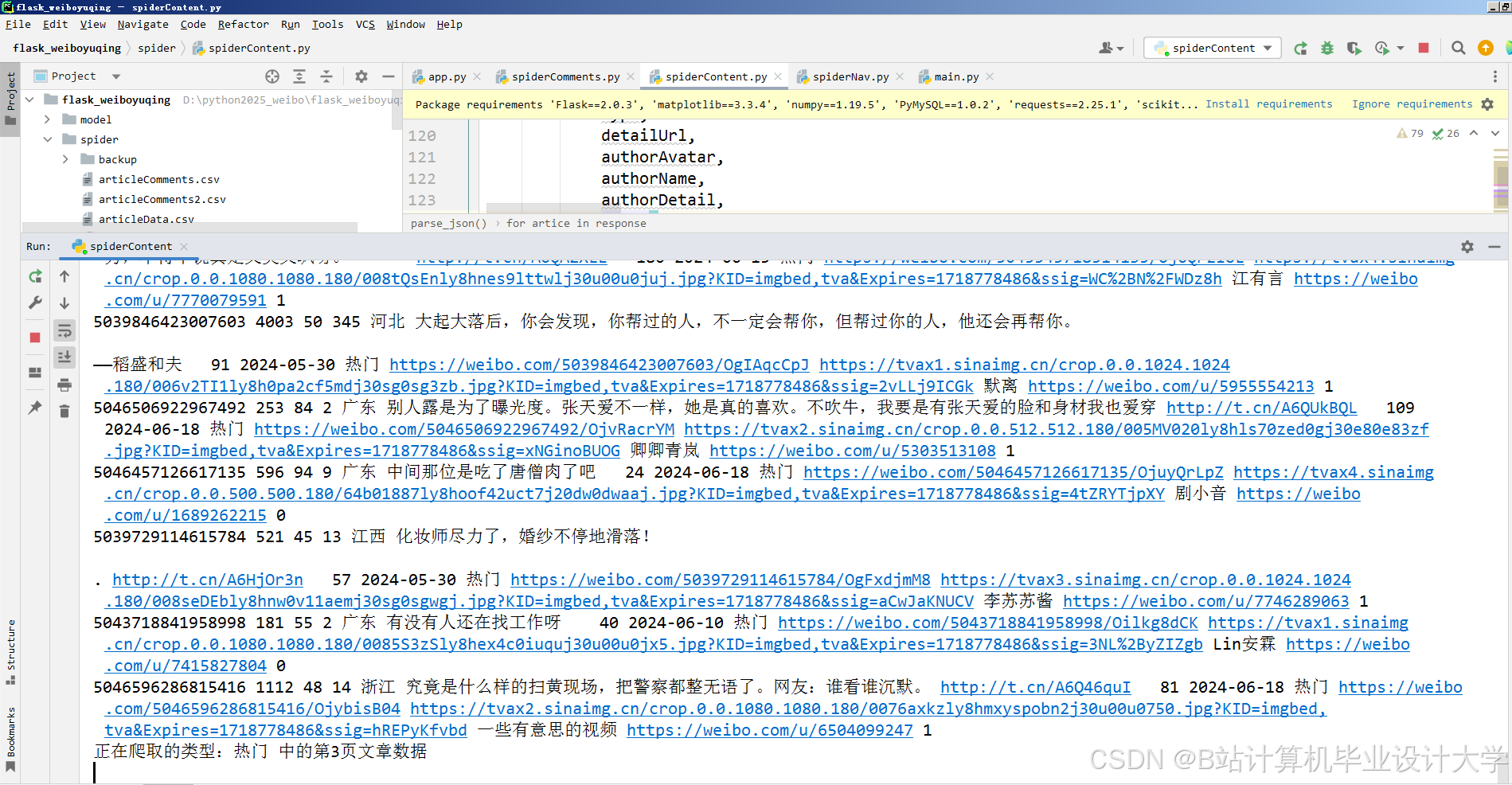

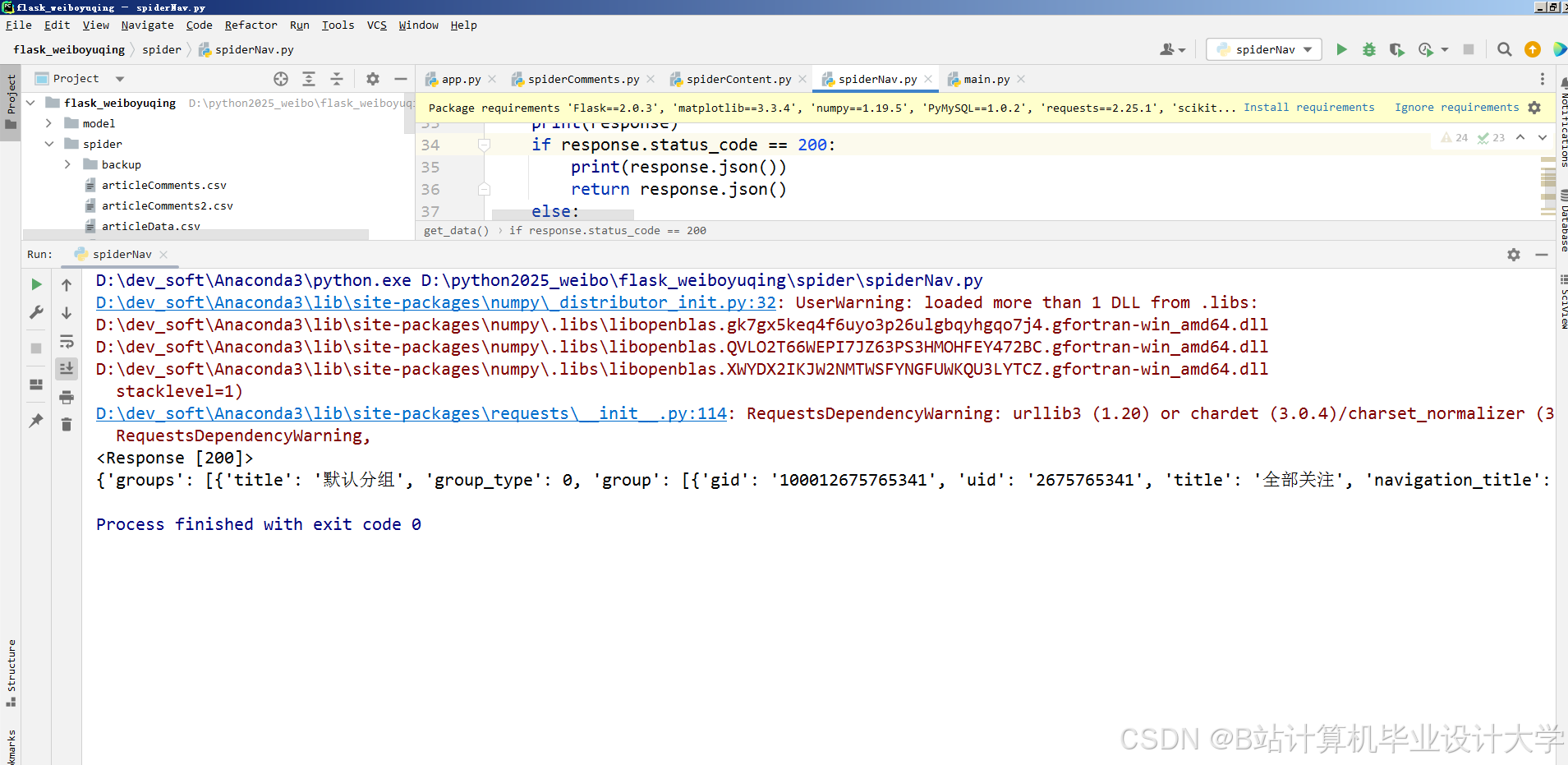

(1) 数据采集与预处理模块

- 任务:

- 通过微博开放API或爬虫工具(如Scrapy)采集指定话题、关键词或用户群体的微博数据(文本、图片、视频)。

- 清洗数据(去重、过滤广告、敏感词屏蔽),提取结构化信息(发布时间、用户属性、互动量)。

- 要求:

- 支持增量采集与定时更新,确保数据时效性。

- 使用Python库(如Pandas、Re)完成数据清洗与特征提取。

(2) 舆情语义理解模块(百度千问大模型集成)

- 任务:

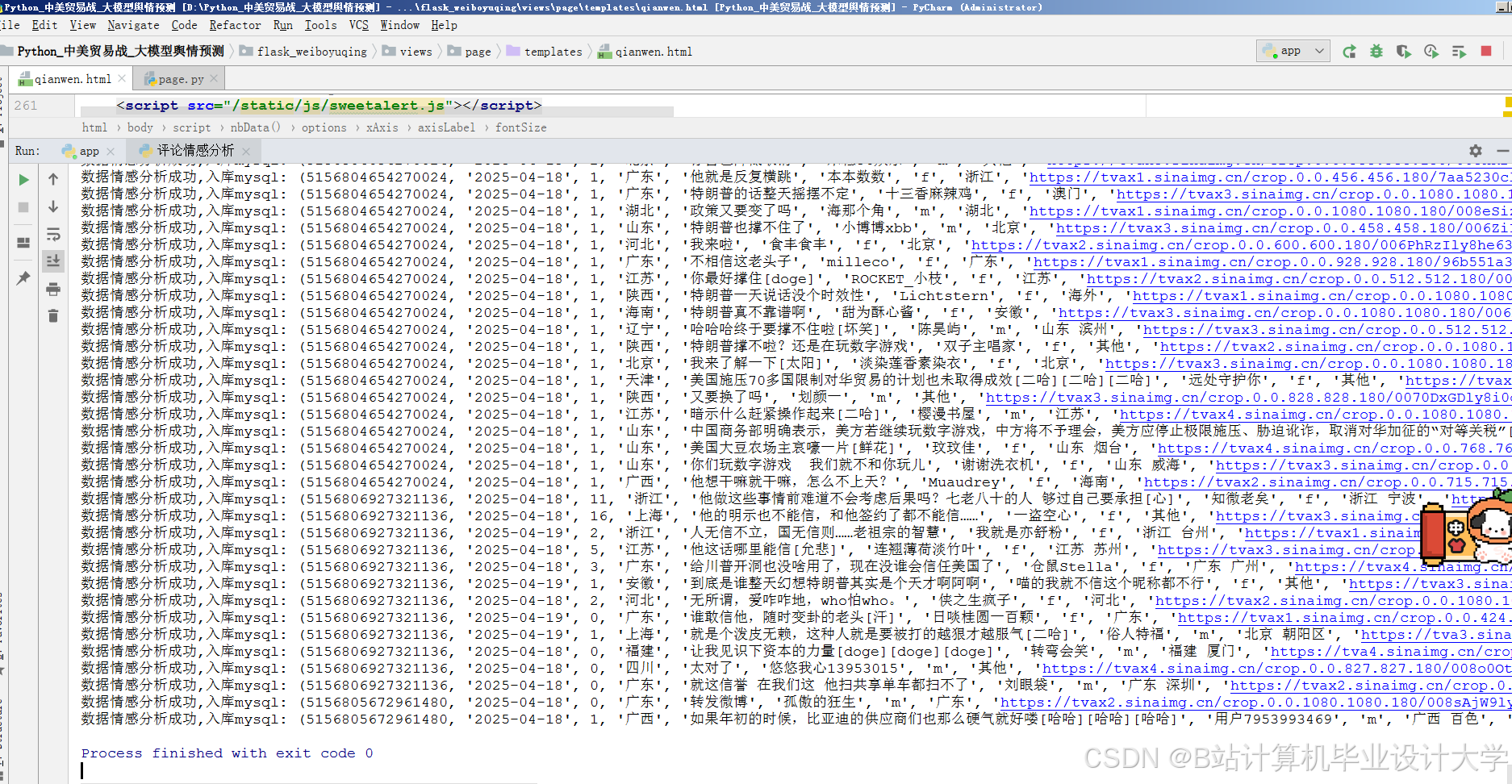

- 情感分析:调用百度千问API,对微博文本进行细粒度情感分类(积极/消极/中性,或更复杂标签如愤怒、喜悦)。

- 主题识别:通过大模型提取微博核心主题(如“政策解读”“产品投诉”),生成标签体系。

- 实体关联:识别文本中的人名、地名、品牌名等实体,构建舆情关联网络。

- 要求:

- 优化Prompt设计,明确分析维度(如“分析以下微博的情感倾向,并给出理由”)。

- 处理多模态数据(如结合图片OCR识别补充文本信息)。

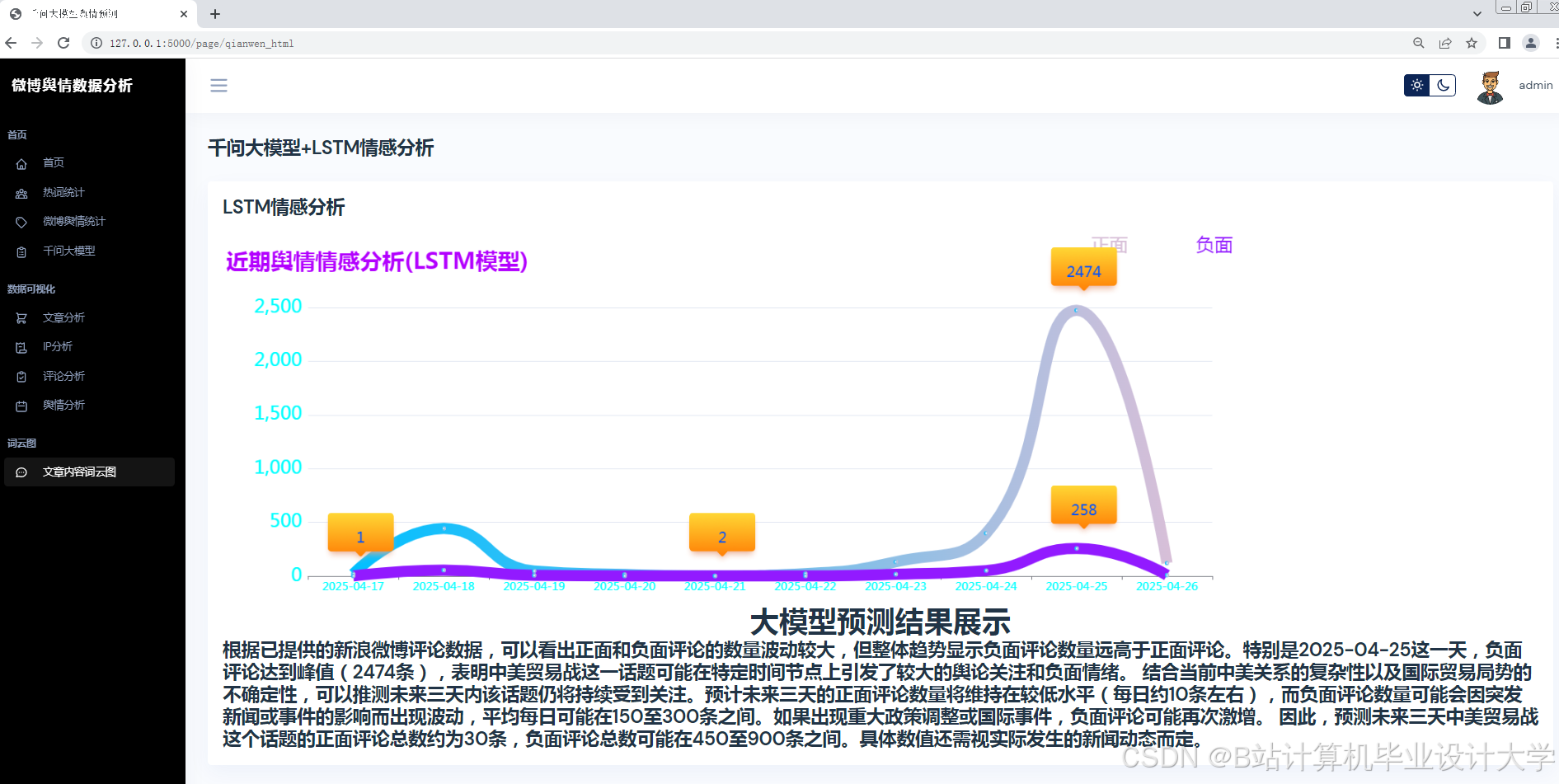

(3) 舆情趋势预测模块

- 任务:

- 基于历史舆情数据(情感分布、主题热度、传播路径),构建时间序列预测模型(如LSTM、Prophet)。

- 结合大模型生成的语义特征,预测未来24-72小时舆情热度变化与风险等级(低/中/高)。

- 要求:

- 融合多维度数据(情感、互动量、用户影响力)提升预测精度。

- 提供可视化预测结果(如折线图、热力图)。

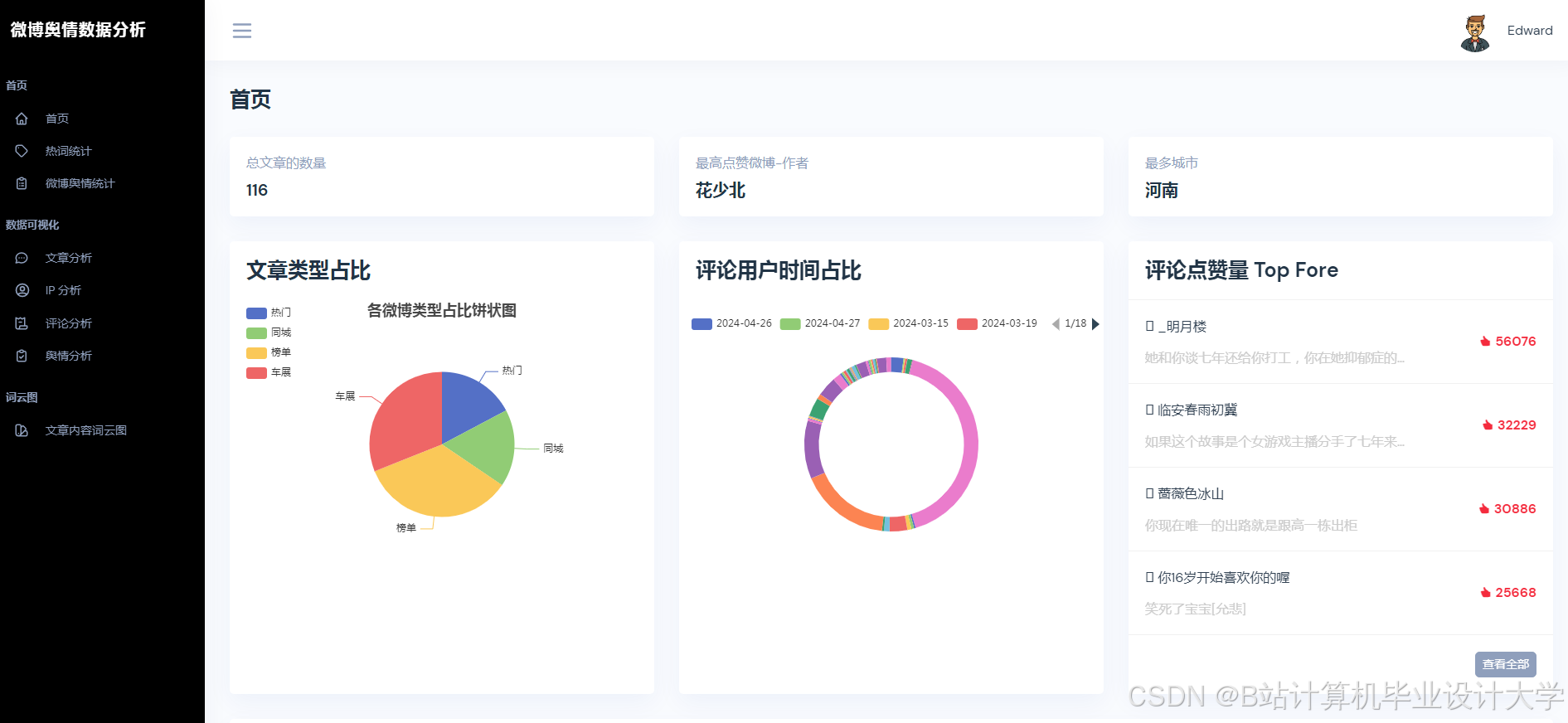

(4) 可视化与告警模块

- 任务:

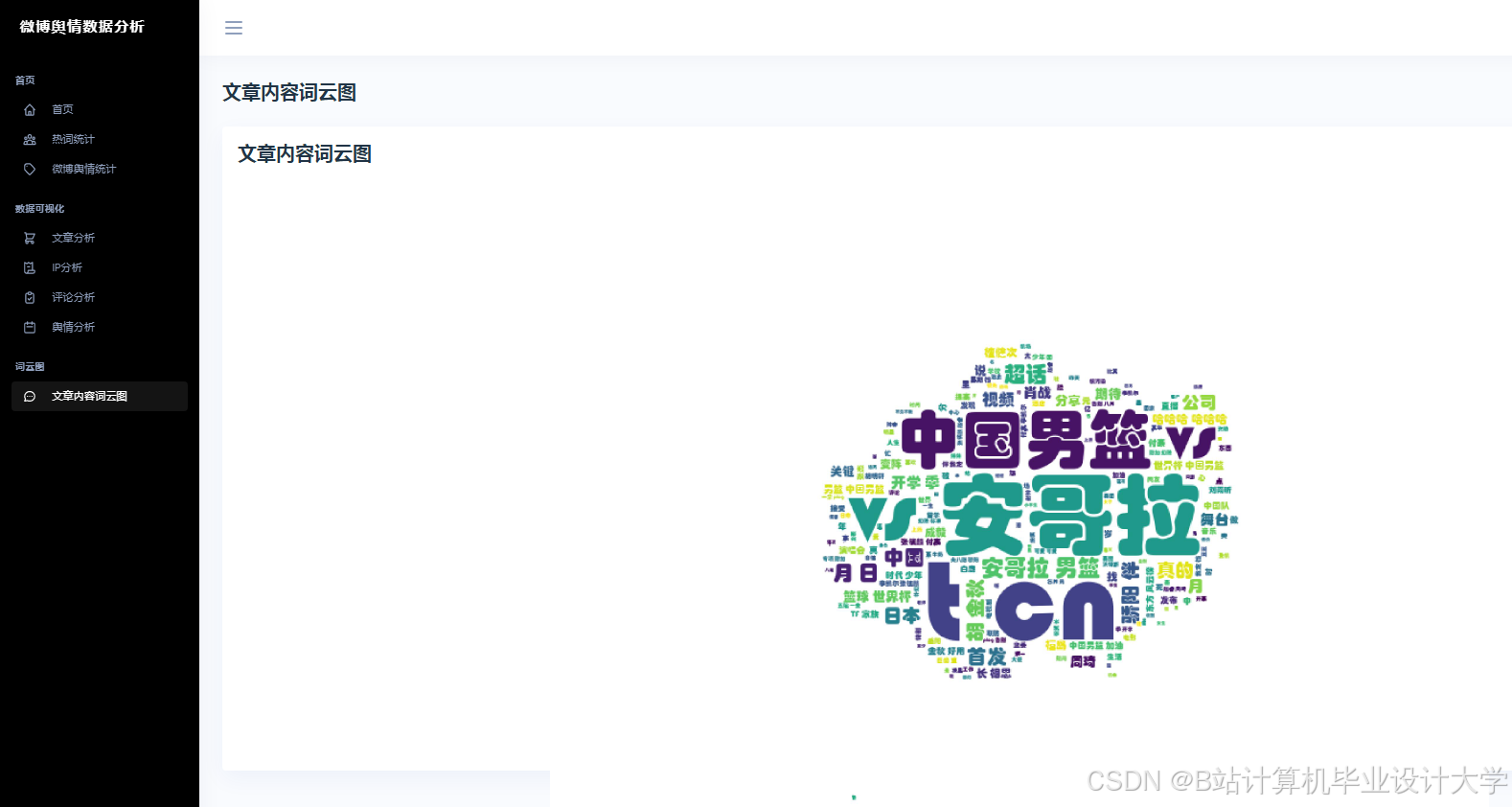

- 使用Python库(如Pyecharts、Matplotlib)生成实时舆情看板,展示情感分布、热点话题TOP10、传播路径图。

- 设置阈值告警机制(如负面舆情占比超30%时触发邮件/短信通知)。

- 要求:

- 支持交互式筛选(按时间、地域、关键词过滤数据)。

- 响应时间 ≤5秒(常规查询场景)。

2. 技术要求

- 编程语言:Python 3.8+

- 核心库/工具:

- 数据采集:

requests、Scrapy、微博API SDK - 数据处理:

Pandas、NumPy、JSON - 大模型调用:百度千问API、

Hugging Face Transformers(可选本地化部署) - 机器学习:

Scikit-learn、TensorFlow/PyTorch(趋势预测模型) - 可视化:

Pyecharts、Streamlit(快速原型开发)

- 数据采集:

- 开发环境:Jupyter Notebook/PyCharm,支持GPU加速(如CUDA优化LSTM训练)。

三、任务分工与进度安排

| 阶段 | 时间 | 任务内容 | 负责人 |

|---|---|---|---|

| 需求分析 | 第1周 | 调研微博舆情分析场景,明确功能需求(如政府监管、品牌监测)与技术选型。 | 全体成员 |

| 数据采集 | 第2-3周 | 完成微博数据采集工具开发,构建初始数据集(至少10万条有效微博)。 | 数据组 |

| 大模型集成 | 第4-5周 | 调用百度千问API实现情感分析、主题识别,优化Prompt与结果解析逻辑。 | 算法组 |

| 预测模型开发 | 第6-7周 | 构建并训练趋势预测模型,验证模型在历史数据上的准确率(MAE≤10%)。 | 算法组 |

| 系统集成 | 第8周 | 将各模块整合为完整系统,优化接口性能(如并发处理能力)。 | 开发组 |

| 测试与优化 | 第9周 | 功能测试(如情感分类准确率≥85%)、压力测试(如支持1000QPS查询),迭代优化。 | 测试组 |

| 文档撰写 | 第10周 | 完成技术文档(系统架构、API说明)、用户手册与项目报告。 | 文档组 |

四、预期成果

- 系统原型:一个可运行的Python程序,支持微博舆情实时分析、预测与可视化。

- 数据集:标注好的微博舆情数据集(含情感标签、主题标签),可用于后续研究。

- 实验报告:验证系统有效性(如情感分析F1值、预测MAE),对比传统方法优势。

- 演示视频:展示系统核心功能(如实时舆情看板、风险告警)。

五、验收标准

- 功能完整性:系统需覆盖数据采集、分析、预测、可视化全流程。

- 性能指标:

- 情感分析准确率 ≥85%(基于人工标注测试集)。

- 趋势预测MAE ≤10%(对比真实舆情热度变化)。

- 系统响应时间 ≤5秒(常规查询场景)。

- 代码规范:符合PEP 8标准,注释清晰,模块化设计。

六、注意事项

- 数据合规性:严格遵守《网络安全法》与微博平台数据使用政策,匿名化处理用户信息。

- 大模型成本控制:优化API调用频率(如批量处理文本),避免超额费用。

- 模型可解释性:预测结果需提供可解释依据(如“因负面舆情增速超阈值,预测风险等级为高”)。

- 扩展性设计:预留接口支持多平台数据接入(如微信、抖音)与多语言分析。

项目负责人(签字):

日期:

此任务书可根据实际项目规模、团队分工和资源调整细节,例如增加预算、硬件需求(如服务器配置)或合规性审查等条款。

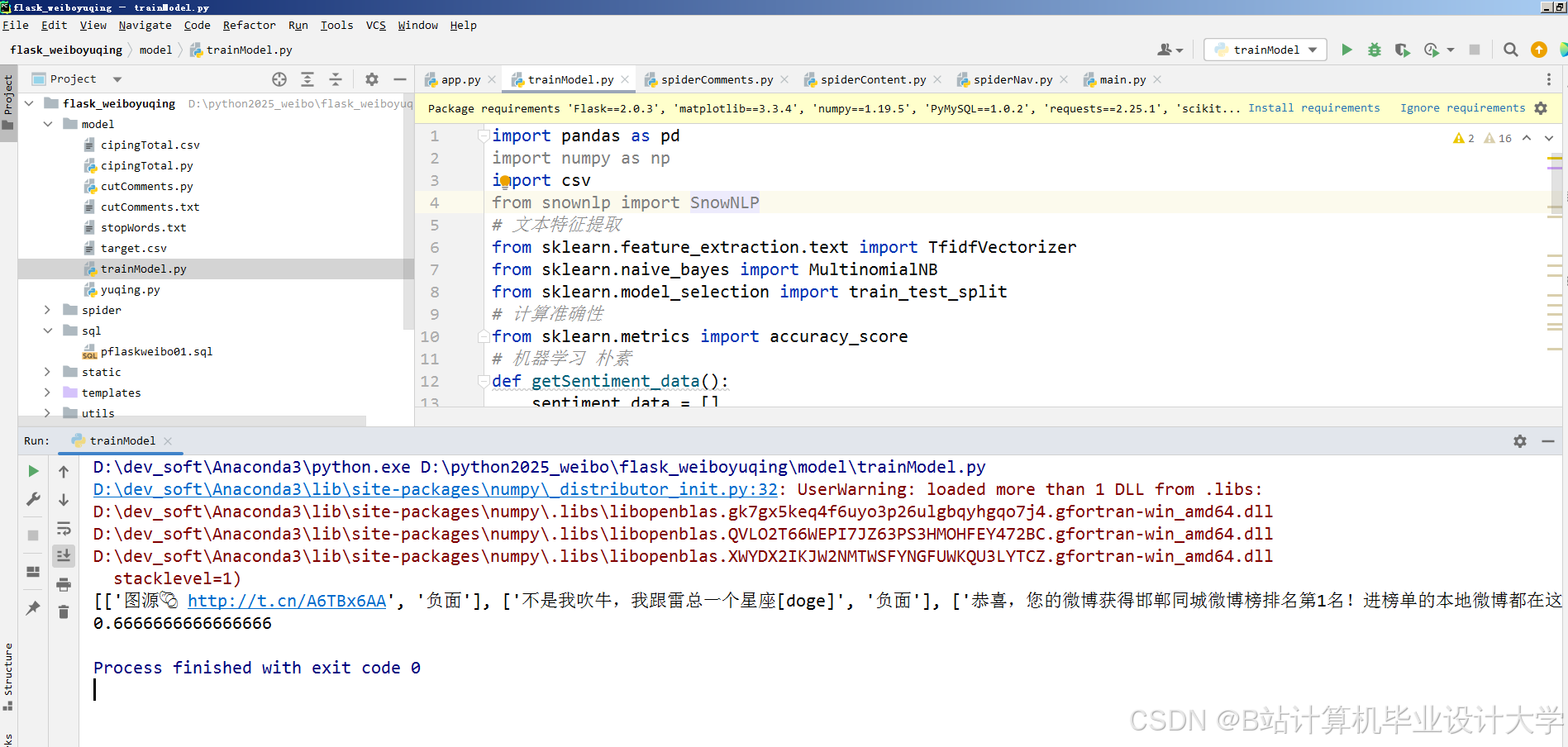

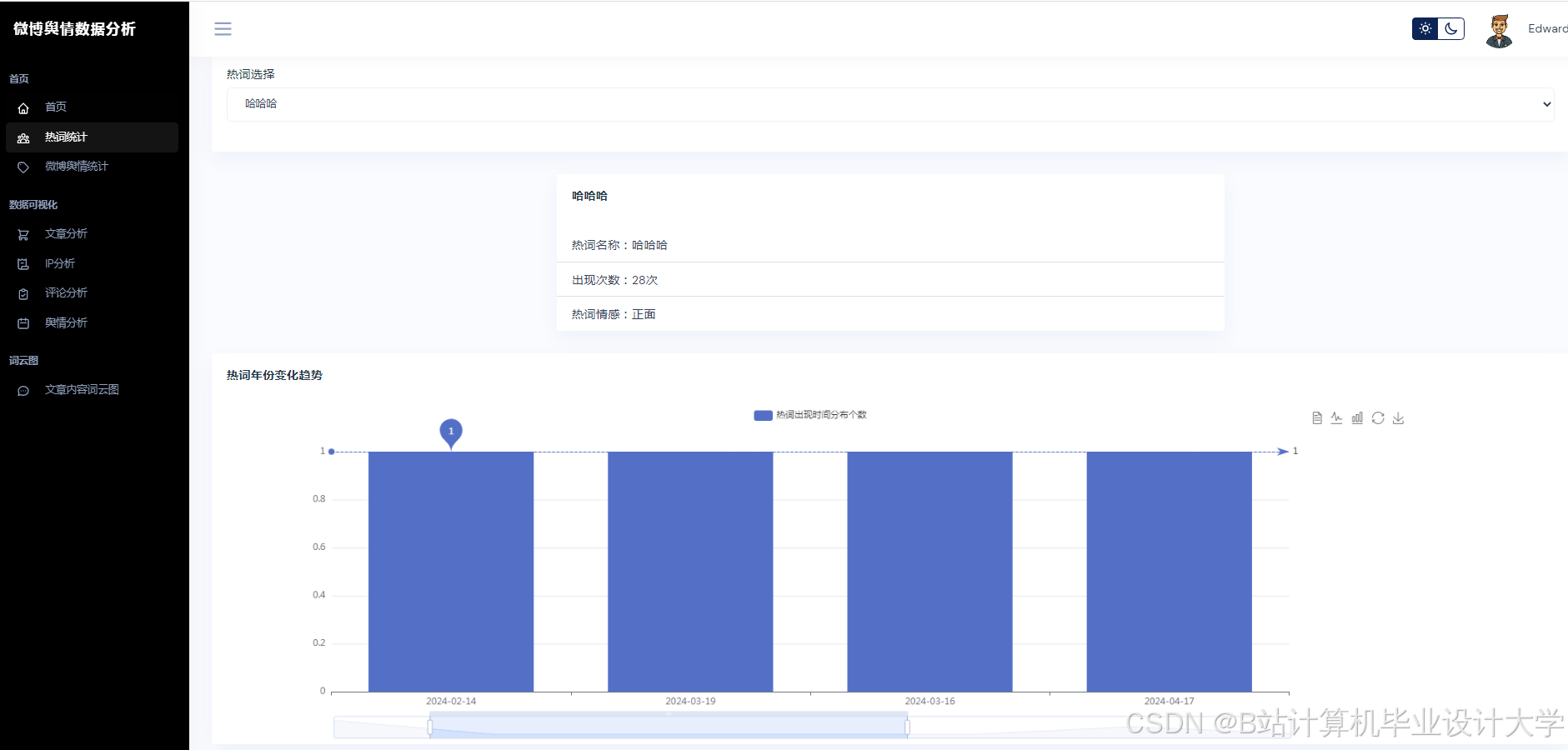

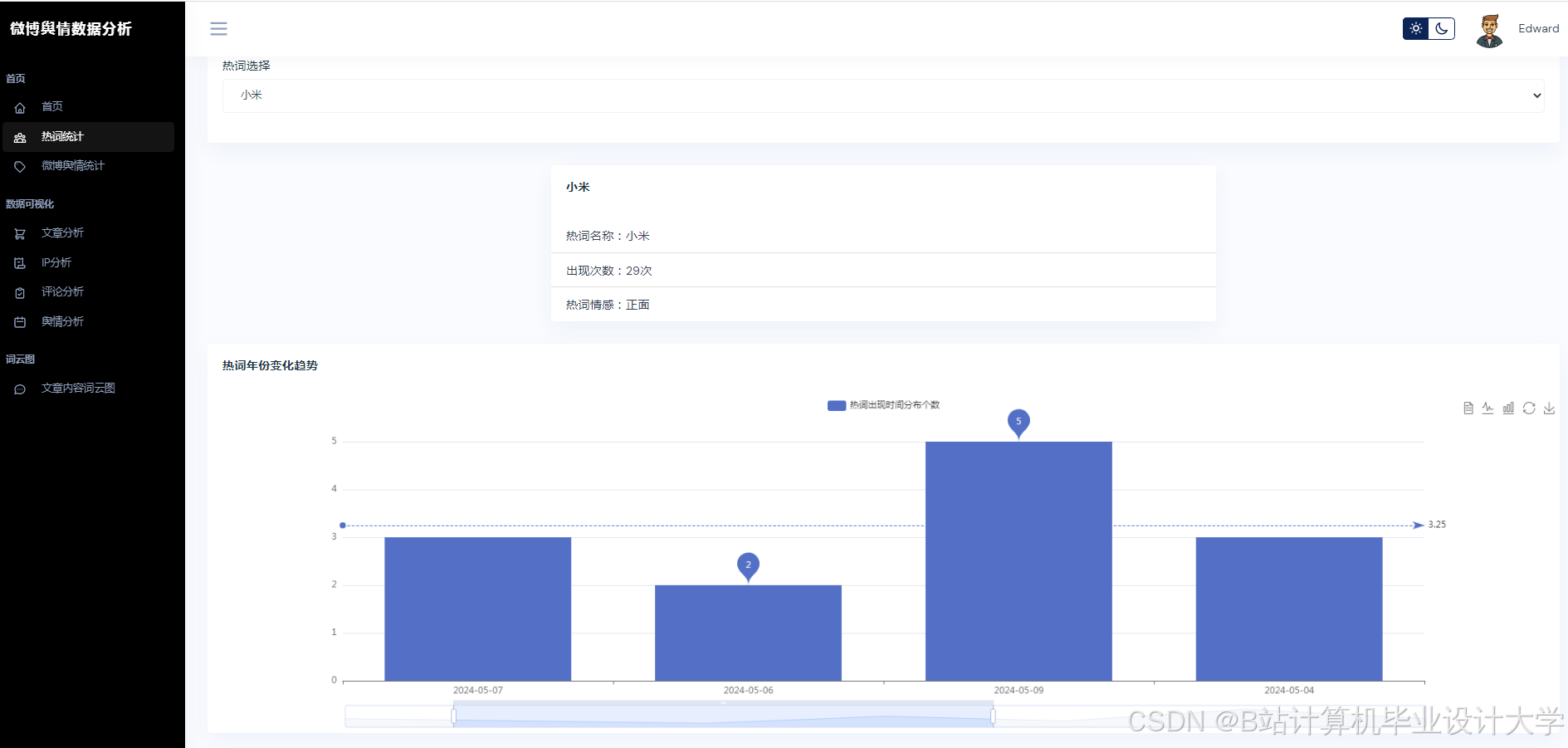

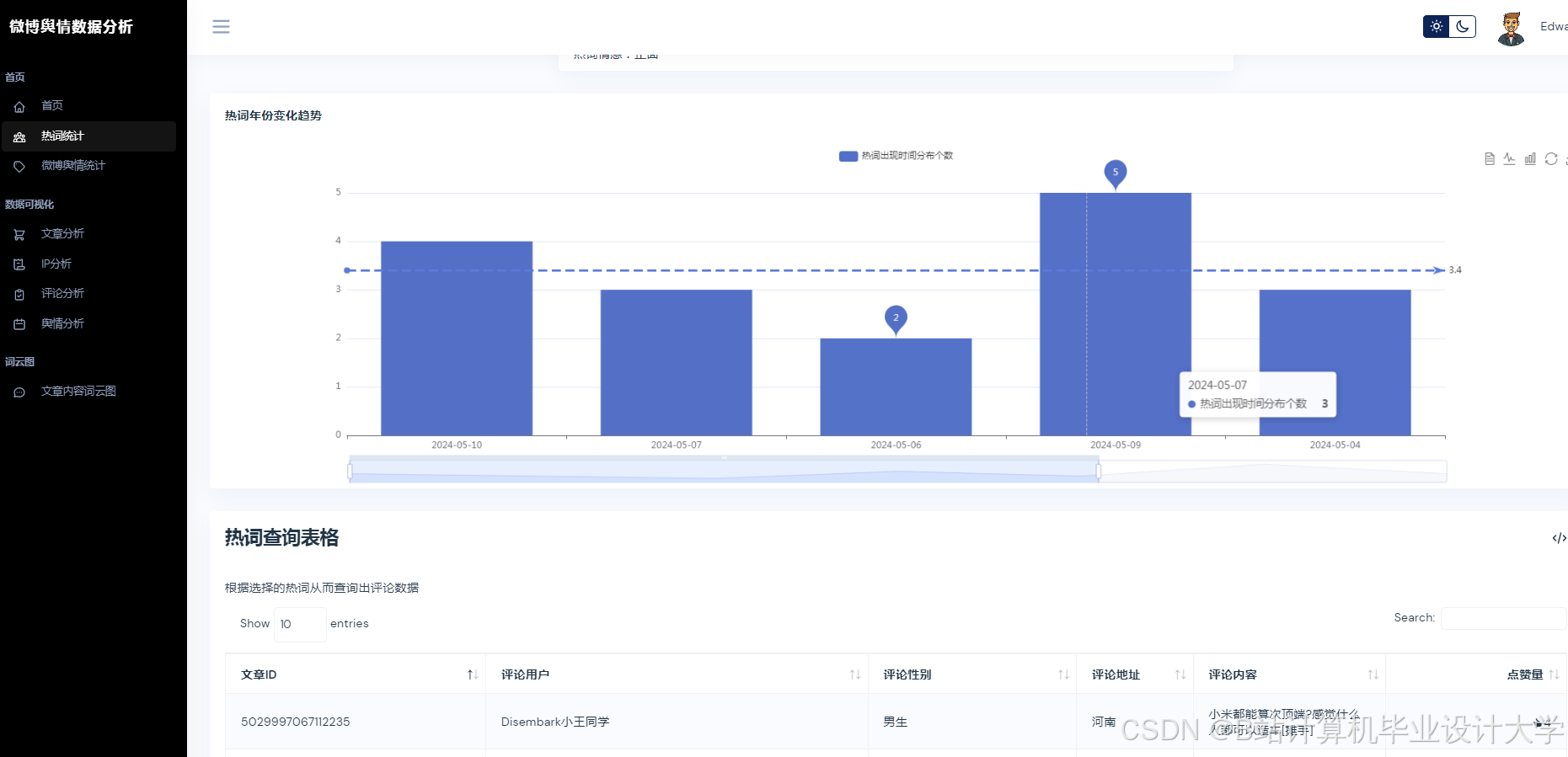

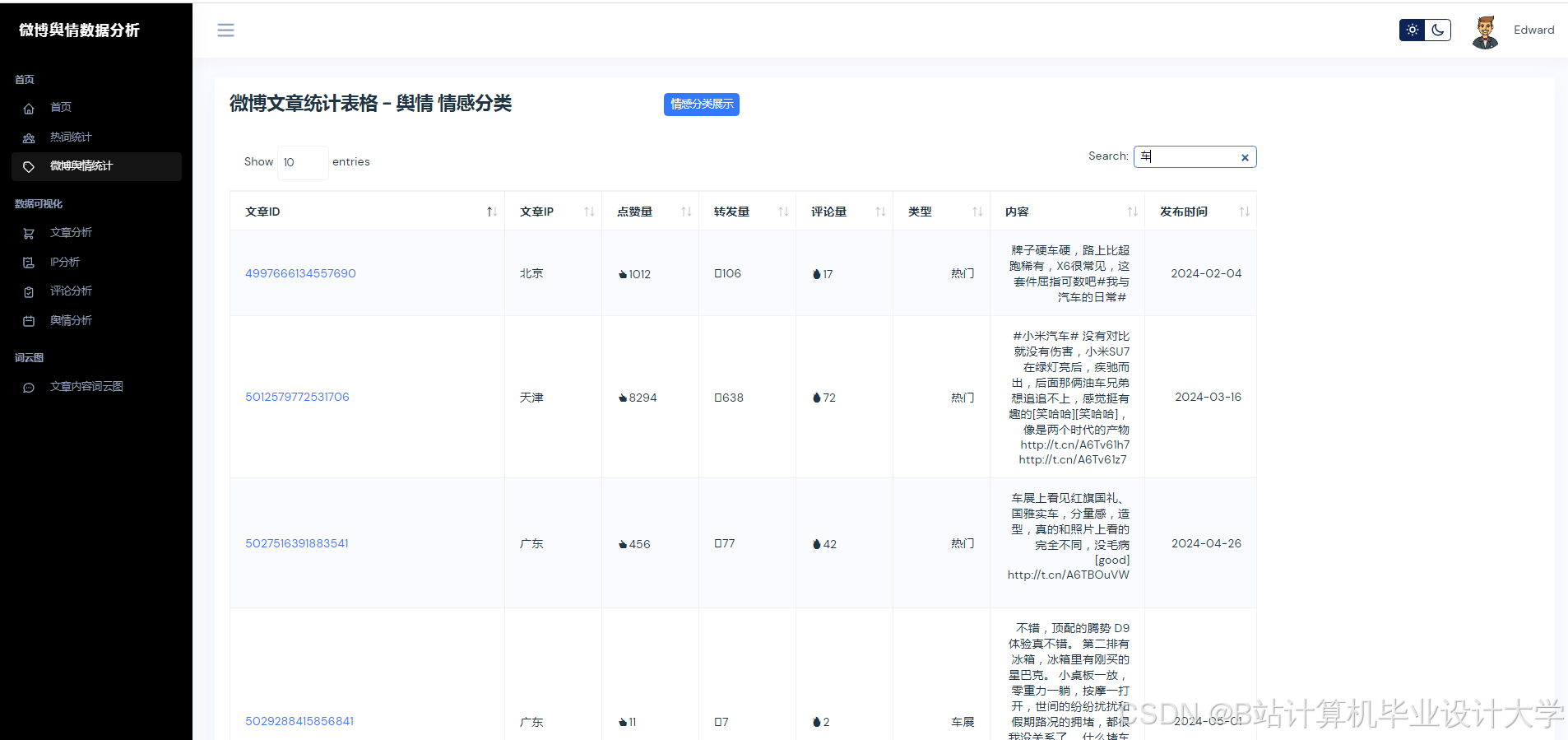

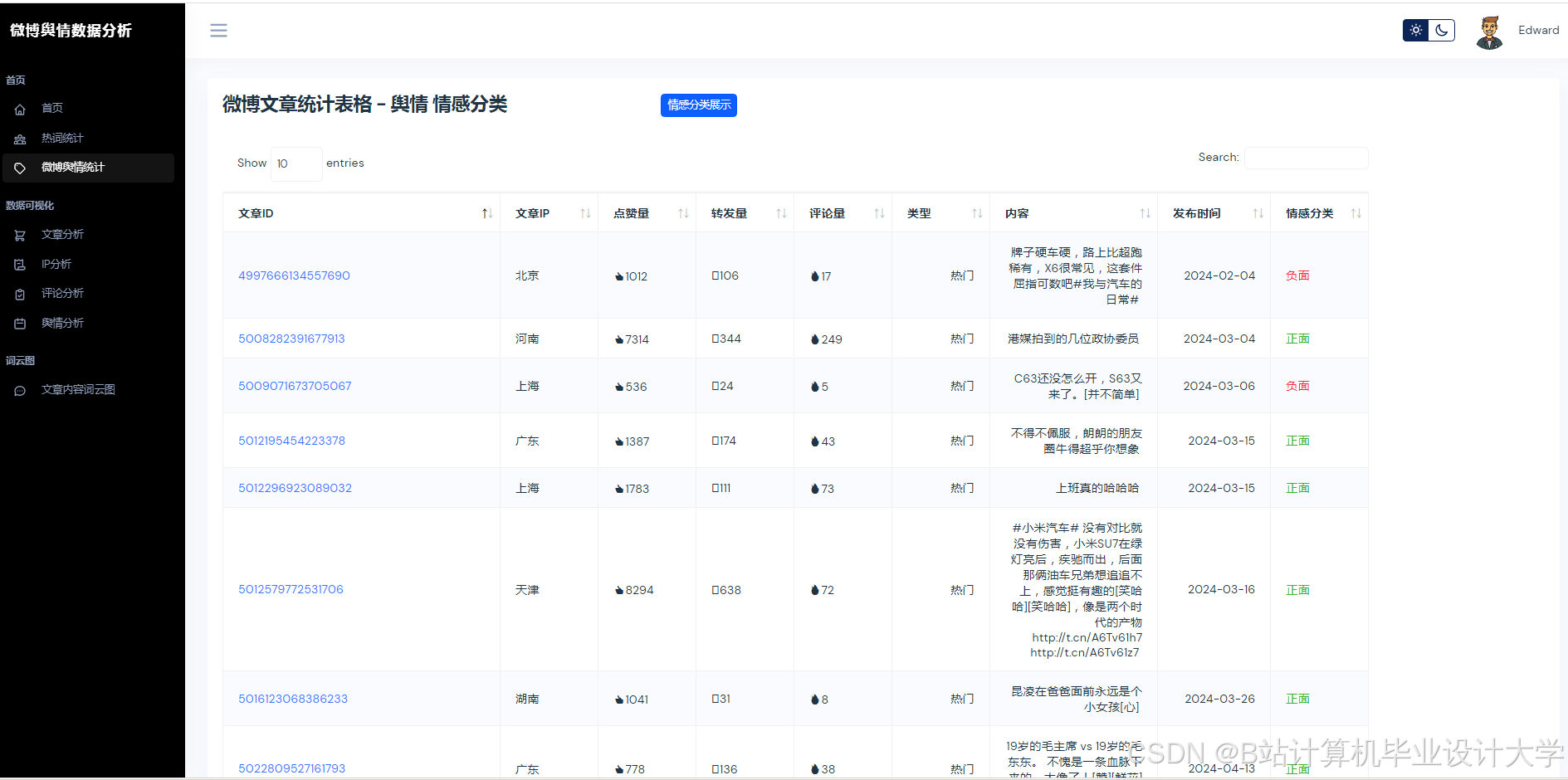

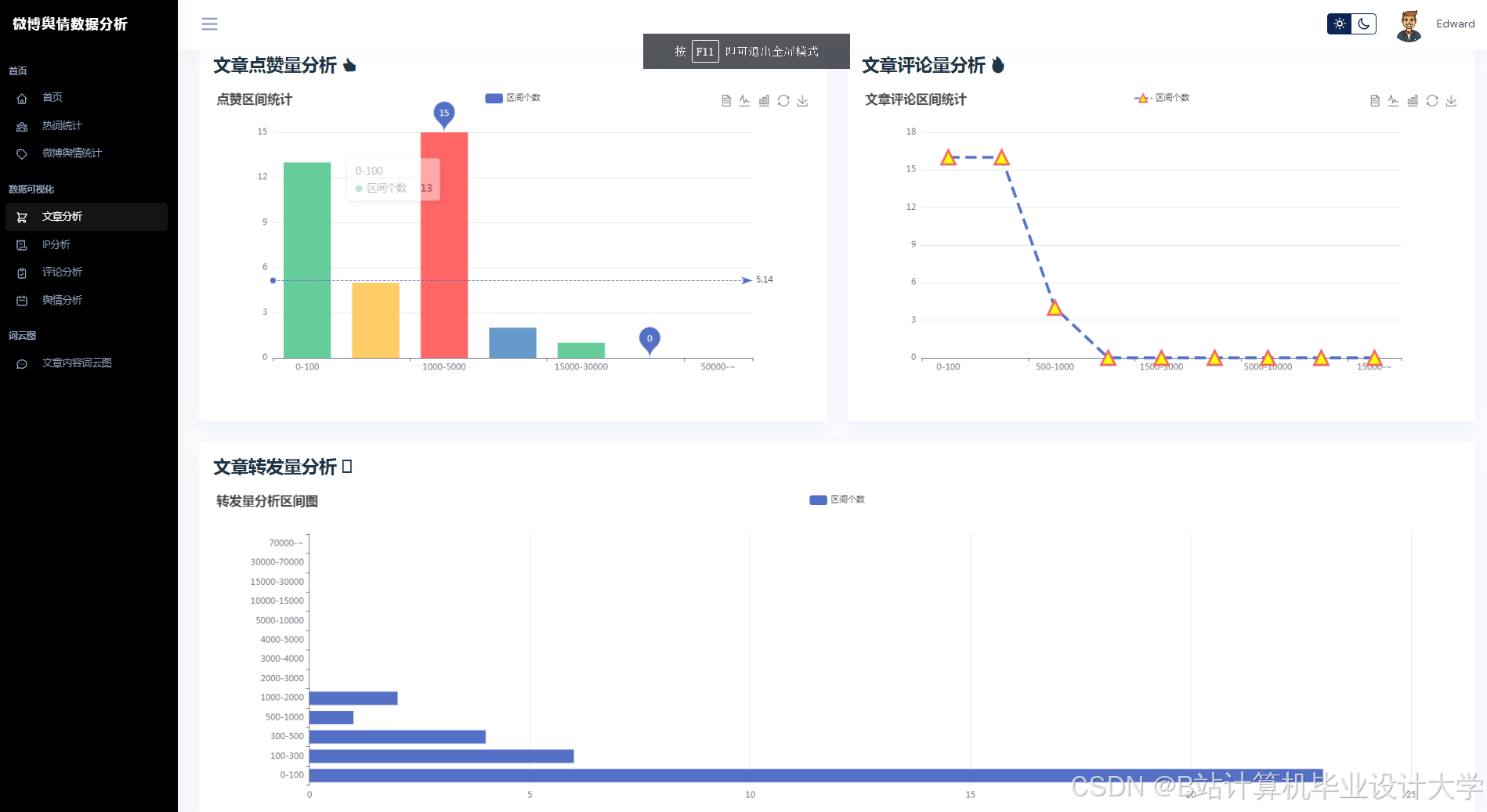

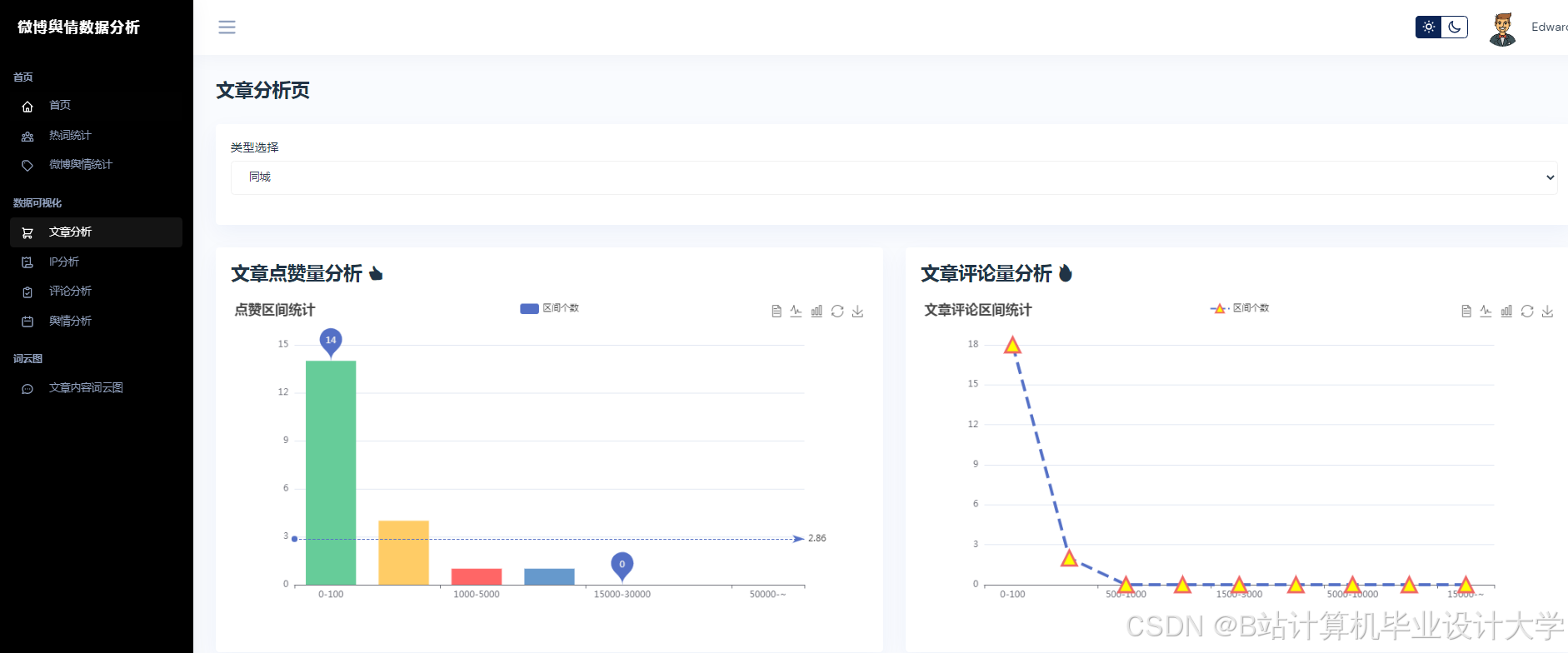

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

1024

1024

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?