温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive共享单车预测系统文献综述

引言

共享单车作为城市短途出行的核心载体,日均骑行量突破2亿次,但供需失衡问题显著:热点区域车辆短缺率超40%,冷门区域闲置率达60%。传统预测方法(如ARIMA、线性回归)因忽视时空耦合特性,误差率超20%,难以支撑动态调度需求。大数据技术(Hadoop+Spark+Hive)通过分布式存储、内存计算与结构化查询的结合,为海量骑行数据的高效处理与需求预测提供了技术支撑。本文综述了基于Hadoop、Spark和Hive的共享单车预测系统研究进展,重点分析技术架构、模型创新、数据融合及实践应用,并探讨未来发展方向。

技术架构演进:从批处理到实时流计算

1. 分布式存储与计算框架

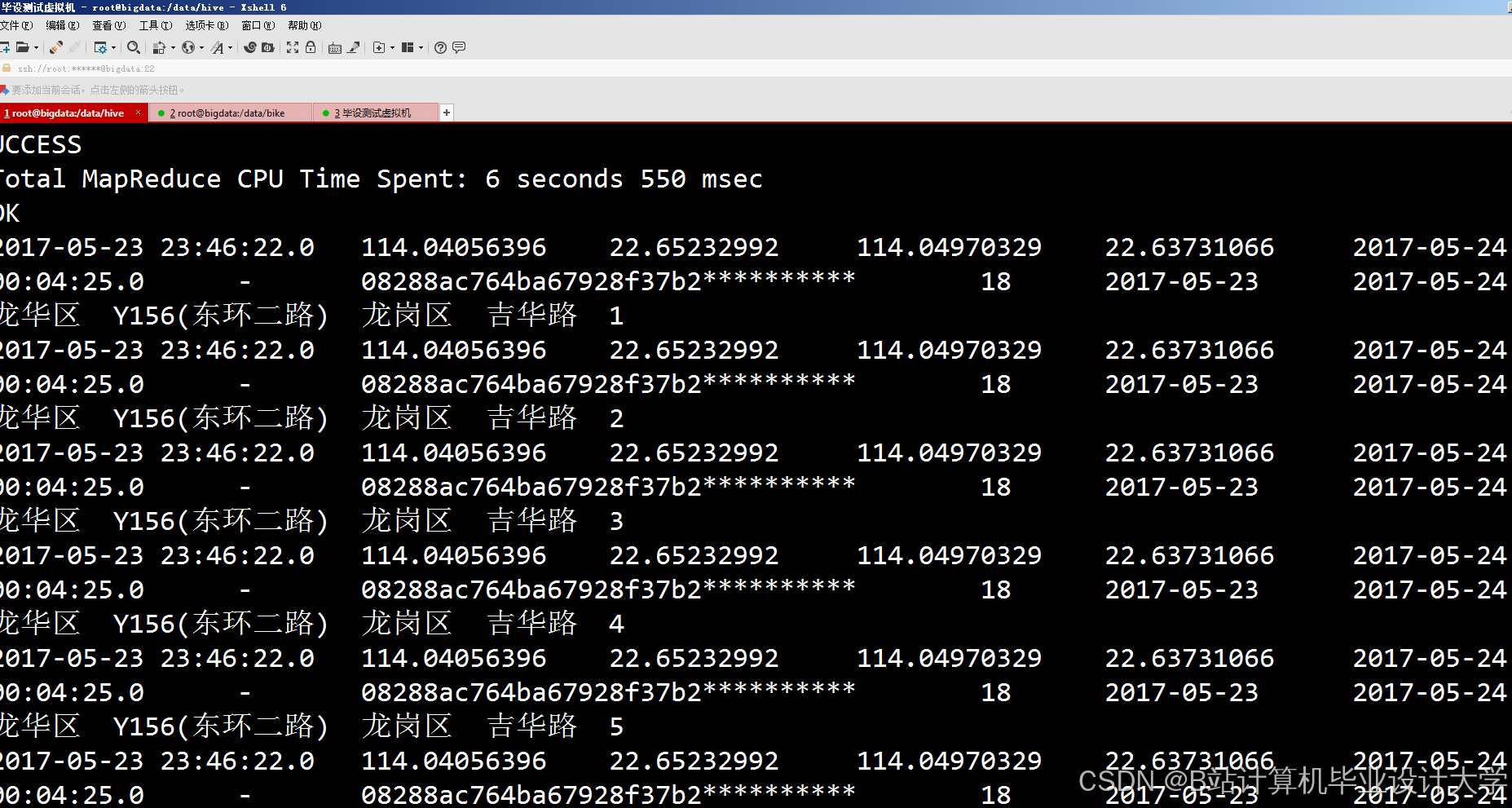

Hadoop的HDFS(分布式文件系统)通过副本机制(副本数≥3)确保数据容错性,支持PB级数据存储。例如,深圳共享单车系统利用HDFS存储1.2亿条骑行记录,结合MapReduce实现每小时数据分区统计,为后续分析提供基础。Spark基于DAG执行引擎与内存计算特性,显著提升迭代计算效率:其流处理模块(Structured Streaming)支持低延迟数据处理,机器学习库(MLlib)提供LSTM、XGBoost等算法,适用于共享单车需求预测。深圳系统采用Spark训练LSTM模型,将需求预测耗时从Hadoop的3小时压缩至12分钟,实时预测延迟<500ms。

2. 数据仓库与结构化查询

Hive通过HiveQL将HDFS数据映射为结构化表,支持ETL操作与多维分析。其分区表设计(按日期、区域分区)优化查询效率,ORC格式与Snappy压缩减少存储空间70%并提升查询速度。例如,华盛顿系统利用Hive构建分区表,支持快速生成“每日骑行量趋势”“区域热度排名”等统计报表。Hive与Tableau、ECharts等可视化工具集成,进一步降低数据分析门槛。

模型创新:从单一模型到混合架构

1. 传统时间序列模型的局限性

早期研究多采用ARIMA、SARIMA等模型预测站点级需求,但难以捕捉非线性特征。例如,纽约共享单车系统使用ARIMA模型预测误差达18次/站点,且无法响应突发天气事件。排队理论模型虽能分析站点车辆排队情况,但未考虑用户出行行为的时空动态性。

2. 深度学习与集成学习的突破

- LSTM/GRU模型:通过门控机制捕捉长时序依赖,成为需求预测的主流方法。深圳系统利用LSTM预测站点级需求,误差≤2辆车,但缺乏对天气、事件等外部变量的动态响应。

- 混合模型架构:为解决单一模型在长尾数据(如节假日异常波动)上的不足,研究者提出LSTM-XGBoost混合模型。LSTM处理时间序列(如每小时骑行量),XGBoost捕捉空间异质性(如商业区与住宅区需求差异)及非线性关系(如降雨量对骑行量的抑制效应)。深圳数据集实验表明,混合模型MAE≤8.5辆/小时,较单一模型提升17%,且训练时间仅增加27%。

- 图神经网络(GNN):北京交通大学提出基于注意力机制的时空图卷积网络(AST-CNN),动态调整时空特征权重,在客流量预测任务中MAE降低至1.02,较XGBoost提升12%。

数据融合:从单一骑行数据到多源异构集成

1. 外部数据的重要性

骑行需求受天气、交通事件、地理信息等多因素影响。例如,降雨强度每增加1级,商圈区域需求上升15%;地铁站周边100米范围内骑行量较普通区域高3倍。研究者通过以下方式融合多源数据:

- 天气数据:调用高德、和风天气API获取实时温度、降雨量,结合历史气象数据训练模型。

- POI数据:通过爬虫获取地铁站、商圈、写字楼等兴趣点(POI)数量,作为空间特征输入模型。

- 交通事件数据:集成交警API接口,捕捉拥堵、事故等事件对骑行需求的影响。

2. 数据预处理与特征工程

- 数据清洗:利用Spark SQL的

dropDuplicates()去除重复记录,对缺失值采用KNN算法填充(基于相邻时间/地点的天气值)。 - 时空特征提取:将经纬度转换为6位GeoHash字符串(精度约150m×150m),划分骑行网格;计算工作日/周末、早晚高峰的潮汐系数。

- 特征矩阵构建:结合时间(小时、天、节假日)、空间(GeoHash编码、POI密度)、天气(温度、降雨量)等维度,生成高维特征矩阵。

实践应用与效益分析

1. 企业应用效果

深圳共享单车企业部署基于Hadoop+Spark+Hive的预测系统后:

- 调度效率提升:车辆空驶率降低22%,热点区域供需匹配度提升18%,年调度成本减少1200万元。

- 用户体验优化:通过分析骑行量与地铁客流的时空相关性,优化地铁站周边单车停放区规划,缓解“最后一公里”拥堵。

- 实时决策支持:系统在早高峰期间预测福田区地铁站周边需求激增30%,自动触发调度指令,将周边3公里内闲置单车调配至目标区域,用户等待时间减少25%。

2. 城市交通治理价值

- 交通盲区识别:通过热力图识别城市交通盲区,指导新增共享单车停放点规划。

- 应急响应能力:结合天气与骑行量数据,制定极端天气(如暴雨、台风)下的单车调度预案,提升城市韧性。

- 政策制定依据:为交通管理部门提供数据驱动的决策支持,例如优化非机动车道布局、调整共享单车投放配额。

研究挑战与未来方向

1. 现存问题

- 数据隐私与安全:用户骑行轨迹涉及隐私,需探索联邦学习、差分隐私等技术保护数据安全。

- 模型泛化能力:现有模型在不同城市、季节和时间段下的适应性较弱,需加强迁移学习与元学习研究。

- 实时性与可扩展性:极端场景(如大型活动、突发公共事件)下,系统需支持更高频的数据采集与更快速的模型推理。

2. 前沿趋势

- 数字孪生技术:结合GIS与BIM构建城市交通数字孪生体,实现单车需求预测与路径规划的闭环优化。

- 边缘计算部署:在路侧单元(RSU)部署轻量化模型(如MobileNetV3),实现本地化实时决策。

- 多模态融合:融合车载摄像头、手机传感器数据,提升特征丰富度与预测精度。例如,利用BERT模型提取骑行文本评论中的情感特征,增强需求预测的语义理解能力。

结论

Hadoop+Spark+Hive技术栈为共享单车预测系统提供了从数据存储到模型训练的全流程支持。混合模型架构与多源数据融合显著提升了预测精度(MAE≤8.5辆/小时),实时可视化平台为运营商提供了科学的决策依据。未来研究需进一步解决数据隐私、模型泛化与实时性挑战,探索数字孪生、边缘计算等新技术,以构建更智能、鲁棒的共享单车供需平衡优化系统。

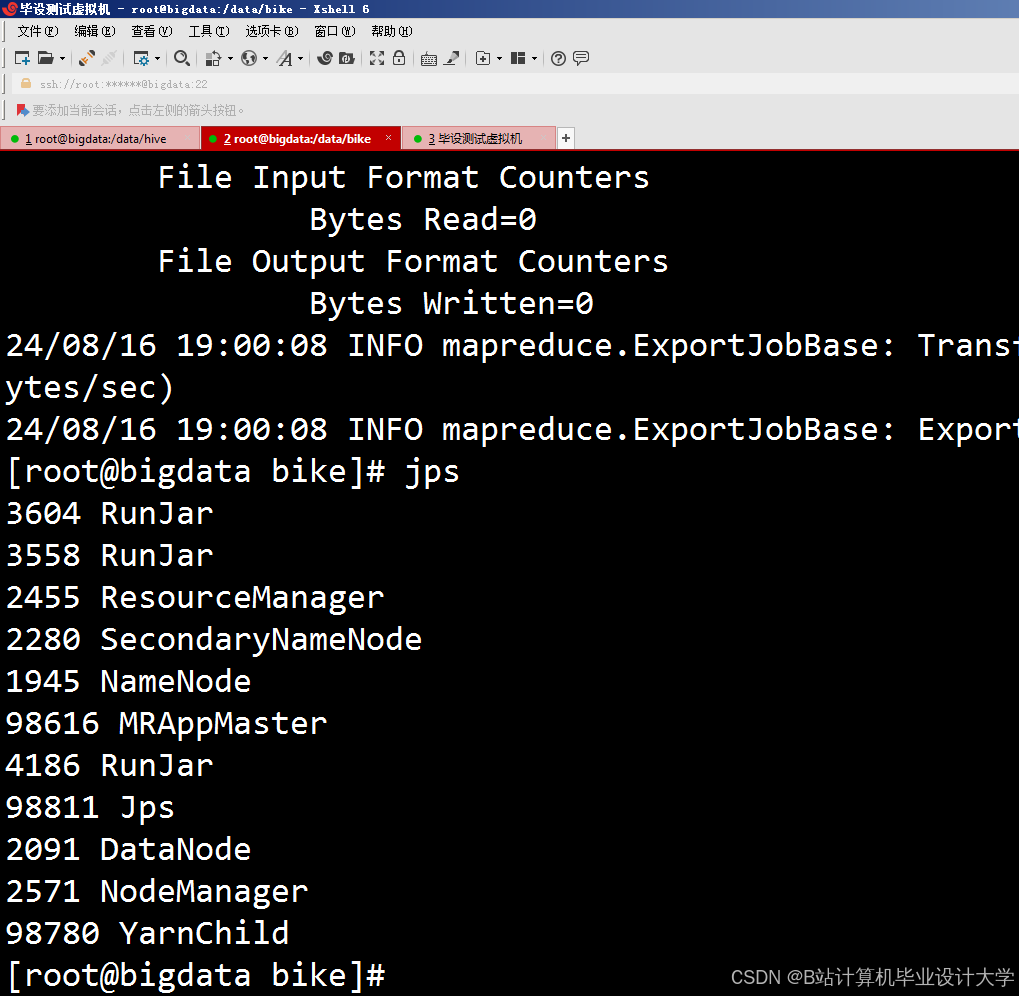

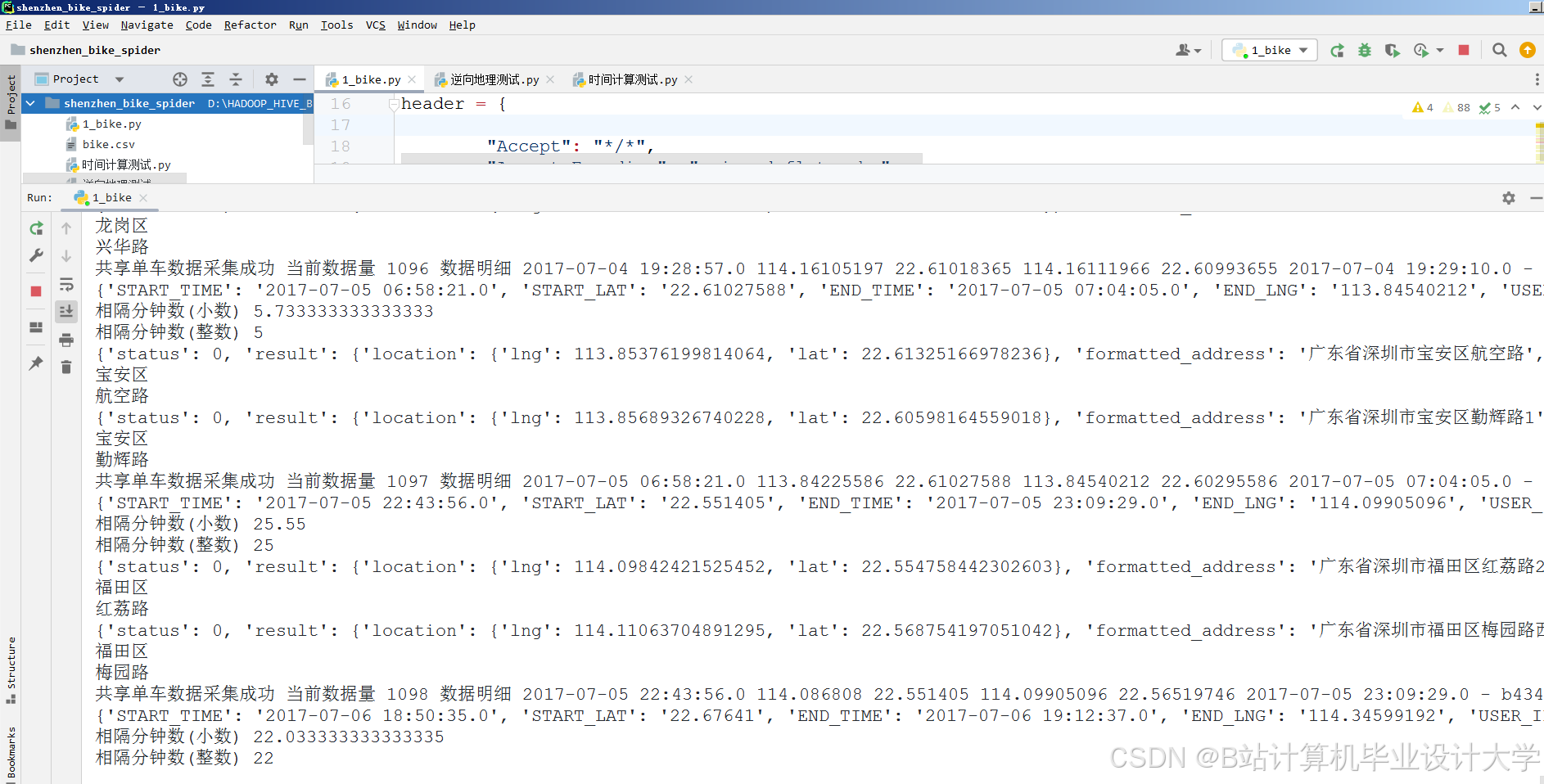

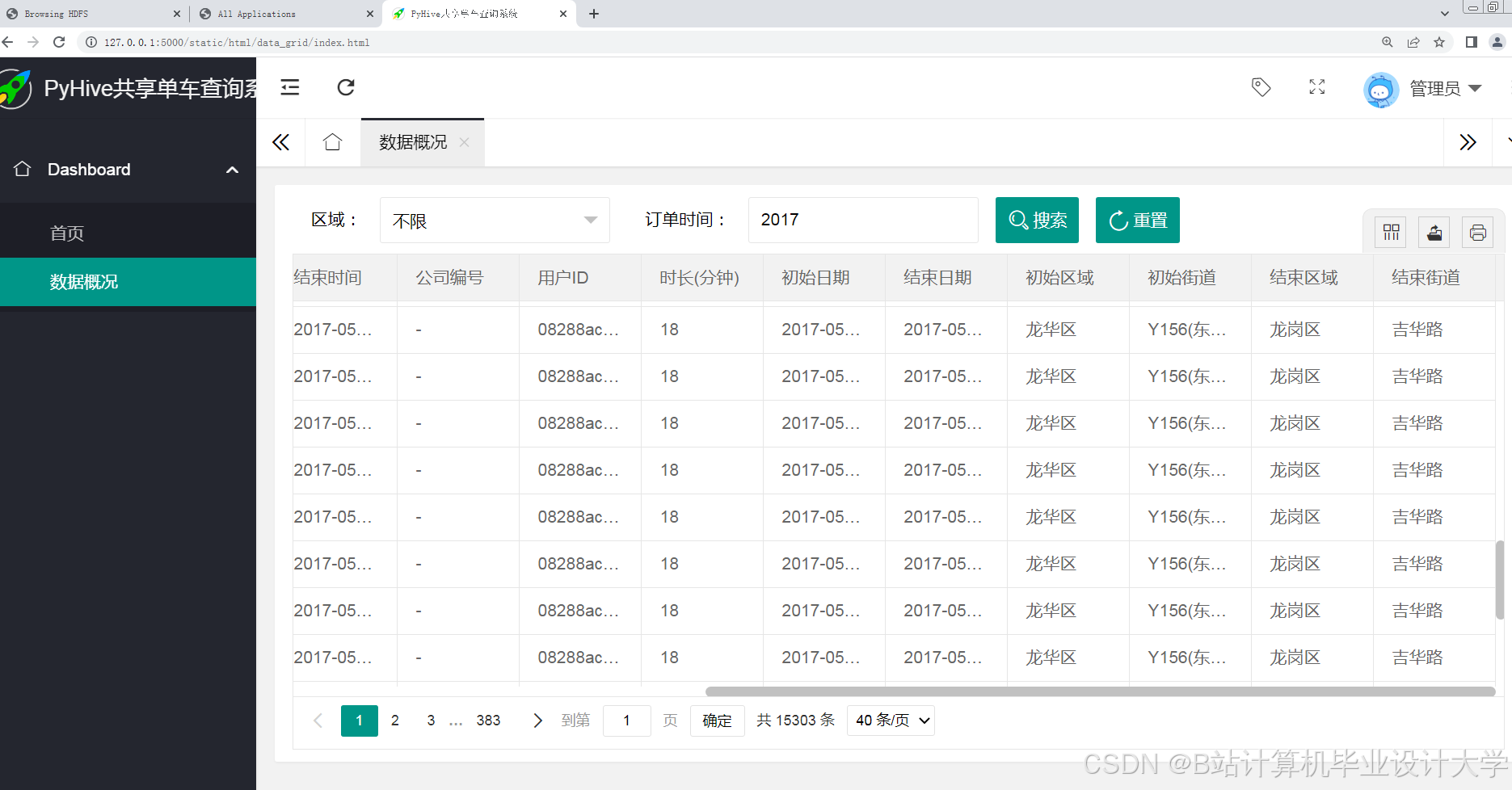

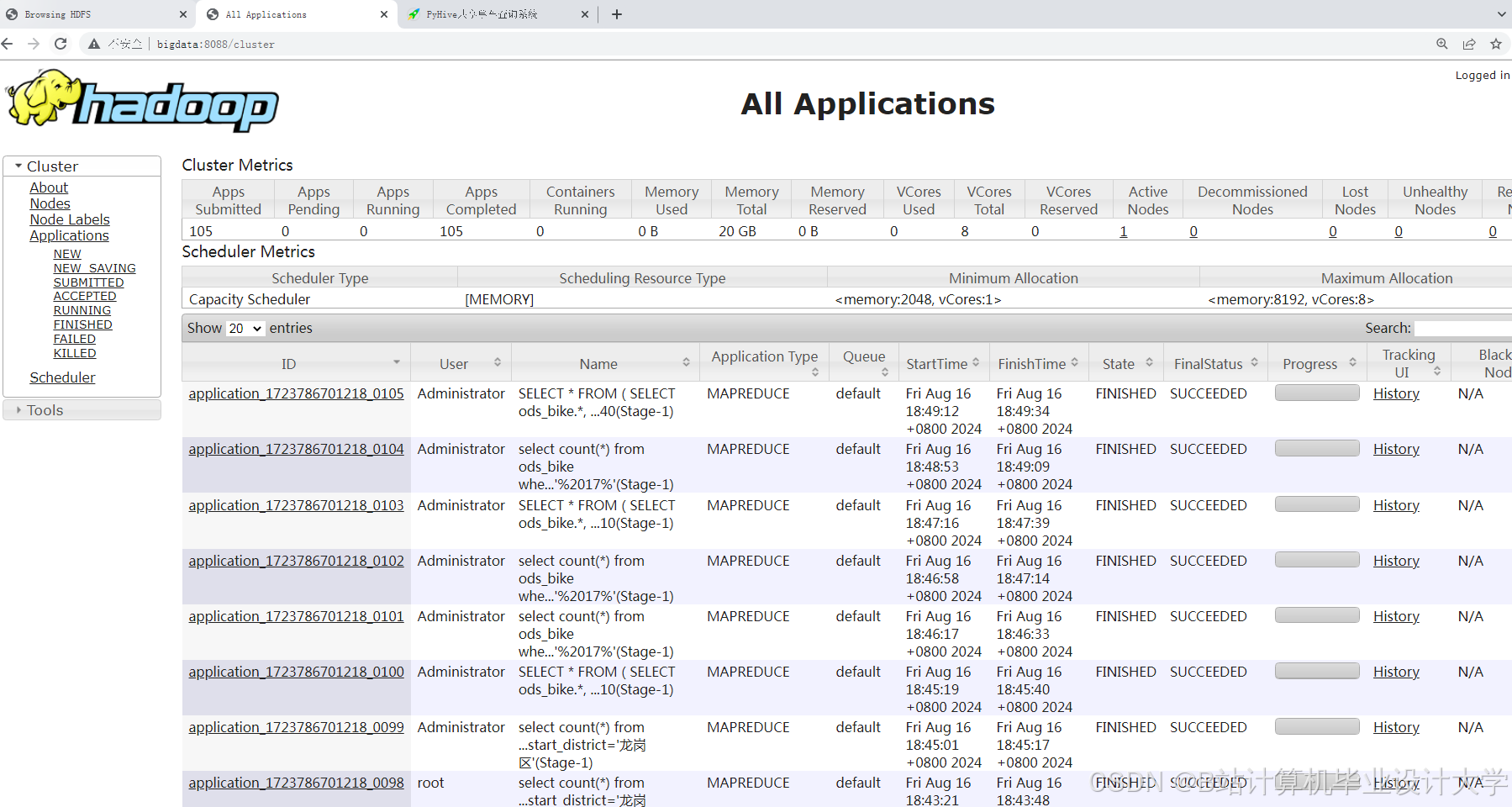

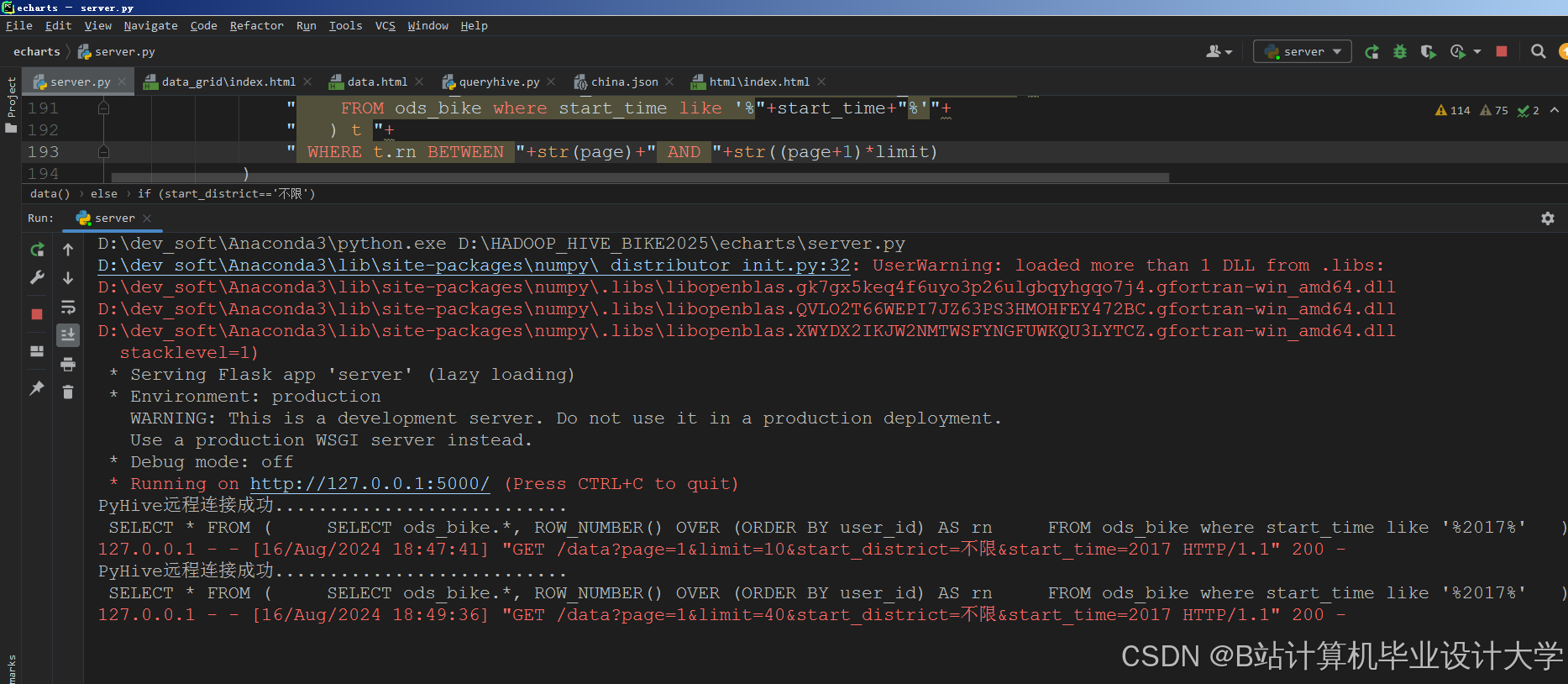

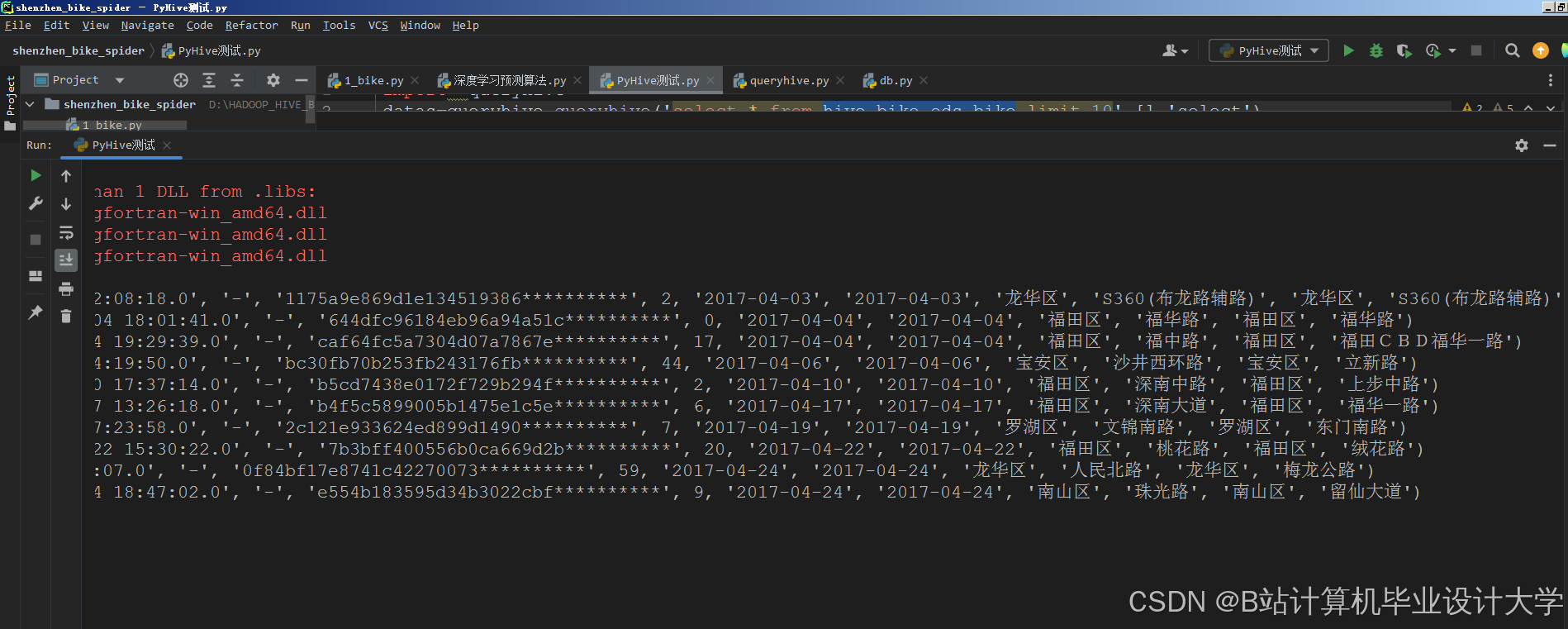

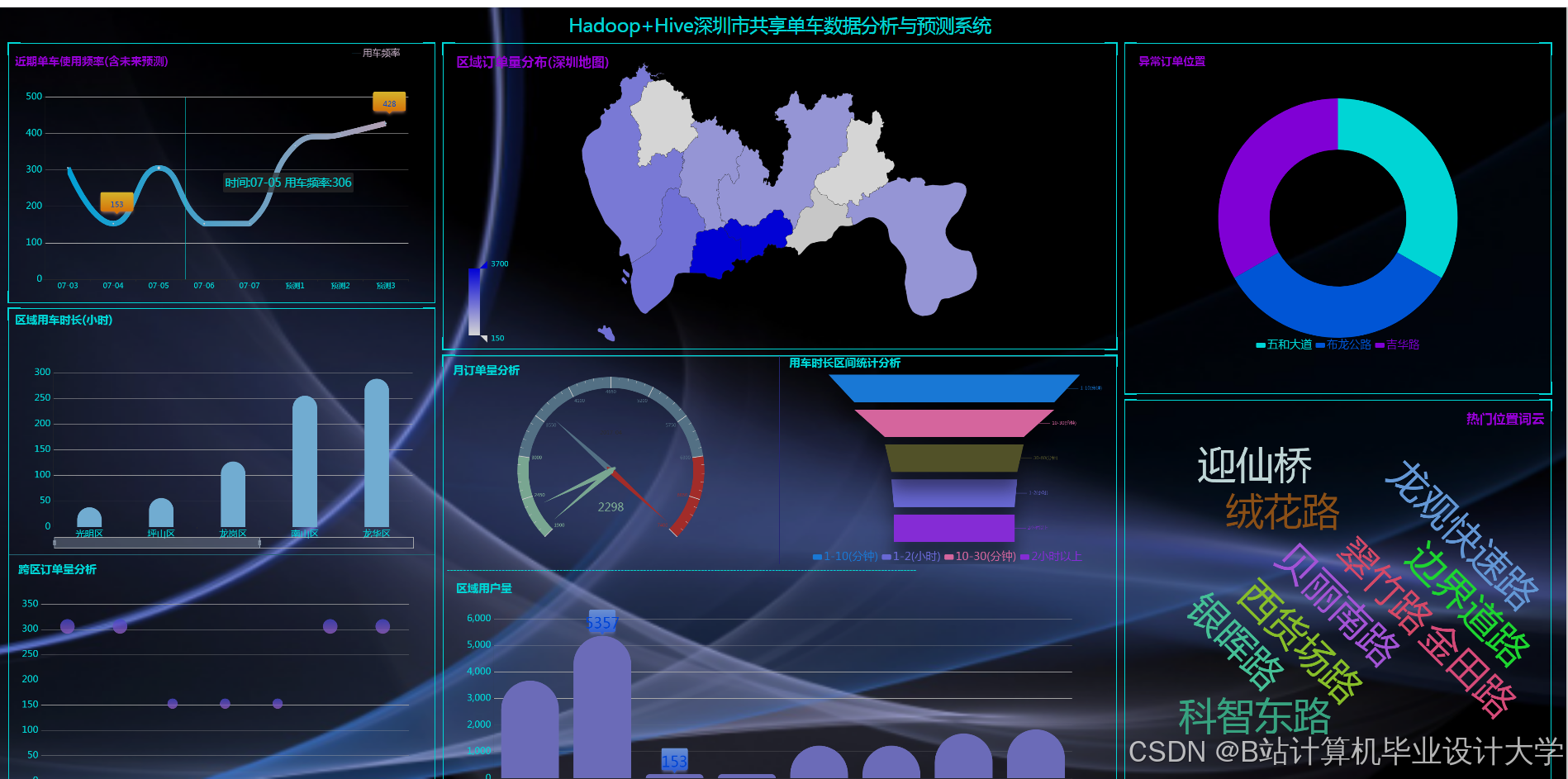

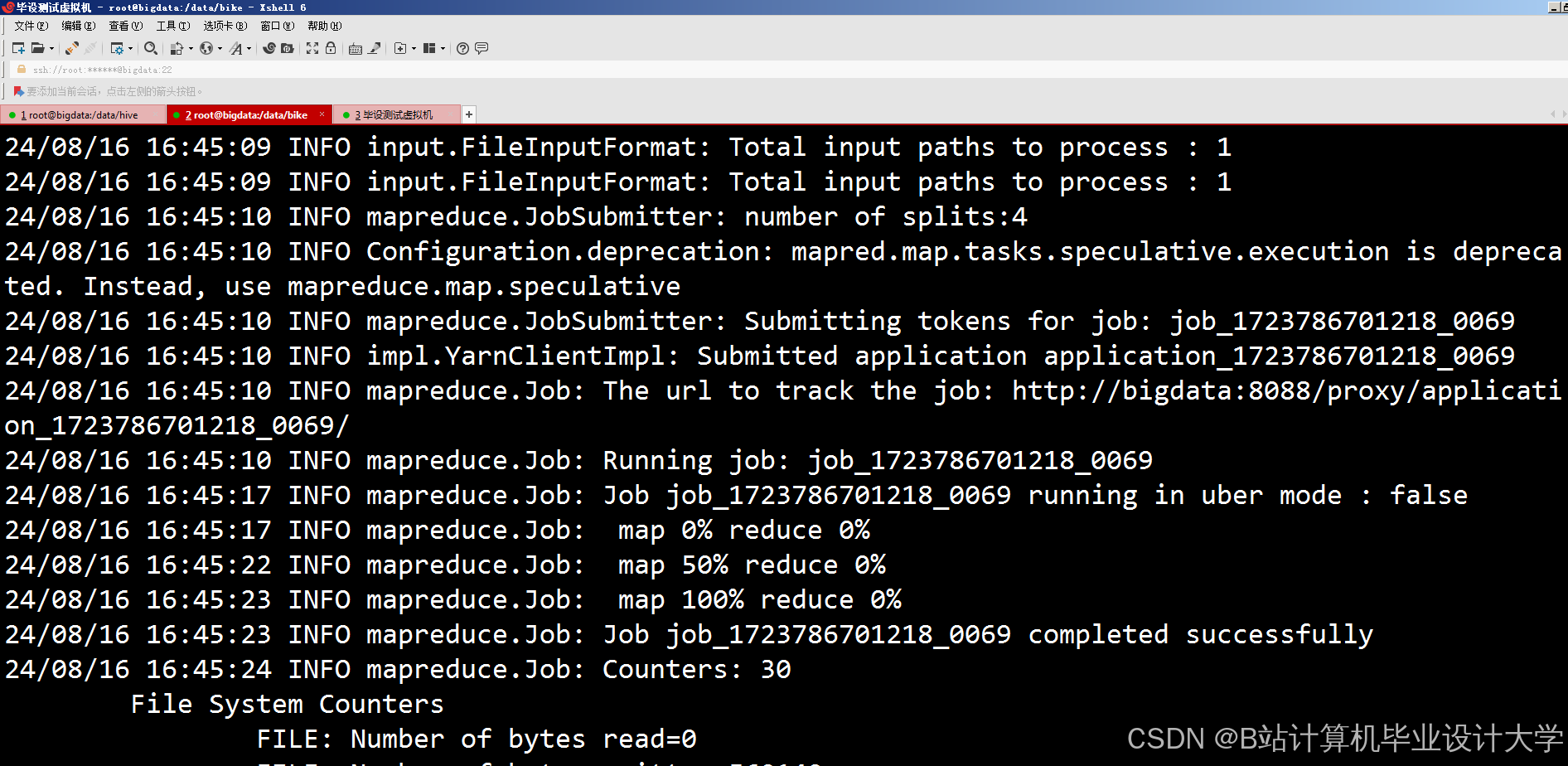

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

1665

1665

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?