温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份关于《Python+PySpark+Hadoop图书推荐系统》的任务书模板,结合大数据处理与推荐算法,适用于分布式计算场景:

任务书:Python+PySpark+Hadoop图书推荐系统

一、项目背景与目标

-

背景

随着在线图书平台用户量和图书数量的快速增长,传统推荐系统面临数据规模大、计算效率低等问题。利用Hadoop分布式存储与PySpark分布式计算框架,可高效处理海量用户行为数据,结合协同过滤、内容过滤等算法实现个性化图书推荐,提升用户满意度和平台转化率。 -

目标

开发一套基于Python+PySpark+Hadoop的分布式图书推荐系统,实现以下功能:

- 分布式存储用户行为数据(浏览、收藏、评分、购买记录)和图书元数据;

- 基于协同过滤与内容过滤的混合推荐引擎;

- 支持大规模数据下的实时与离线推荐;

- 可视化推荐结果与系统监控。

二、任务内容与技术要求

1. 系统功能模块

(1) 数据采集与存储(Hadoop生态)

- 数据来源:

- 用户行为数据:日志文件(点击流、评分、评论);

- 图书元数据:标题、作者、出版社、分类标签、简介;

- 外部数据:公开数据集(如Book-Crossing、Amazon图书评论)。

- 存储方案:

- HDFS:存储原始日志文件和结构化数据(Parquet/ORC格式);

- HBase:实时查询用户历史行为数据(如用户-图书评分矩阵);

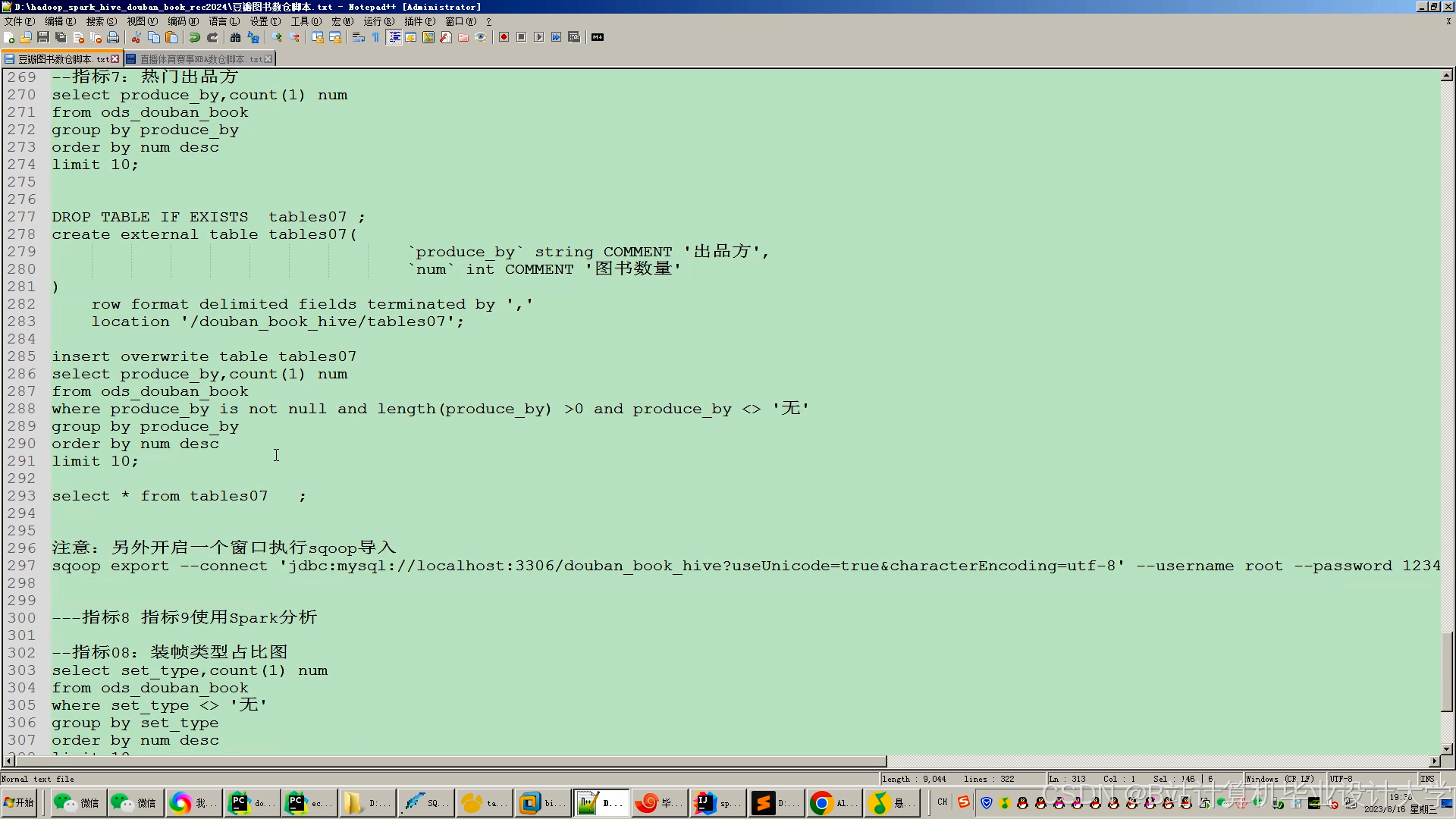

- Hive:构建数据仓库,支持SQL查询分析。

(2) 数据预处理与特征工程(PySpark)

- 处理流程:

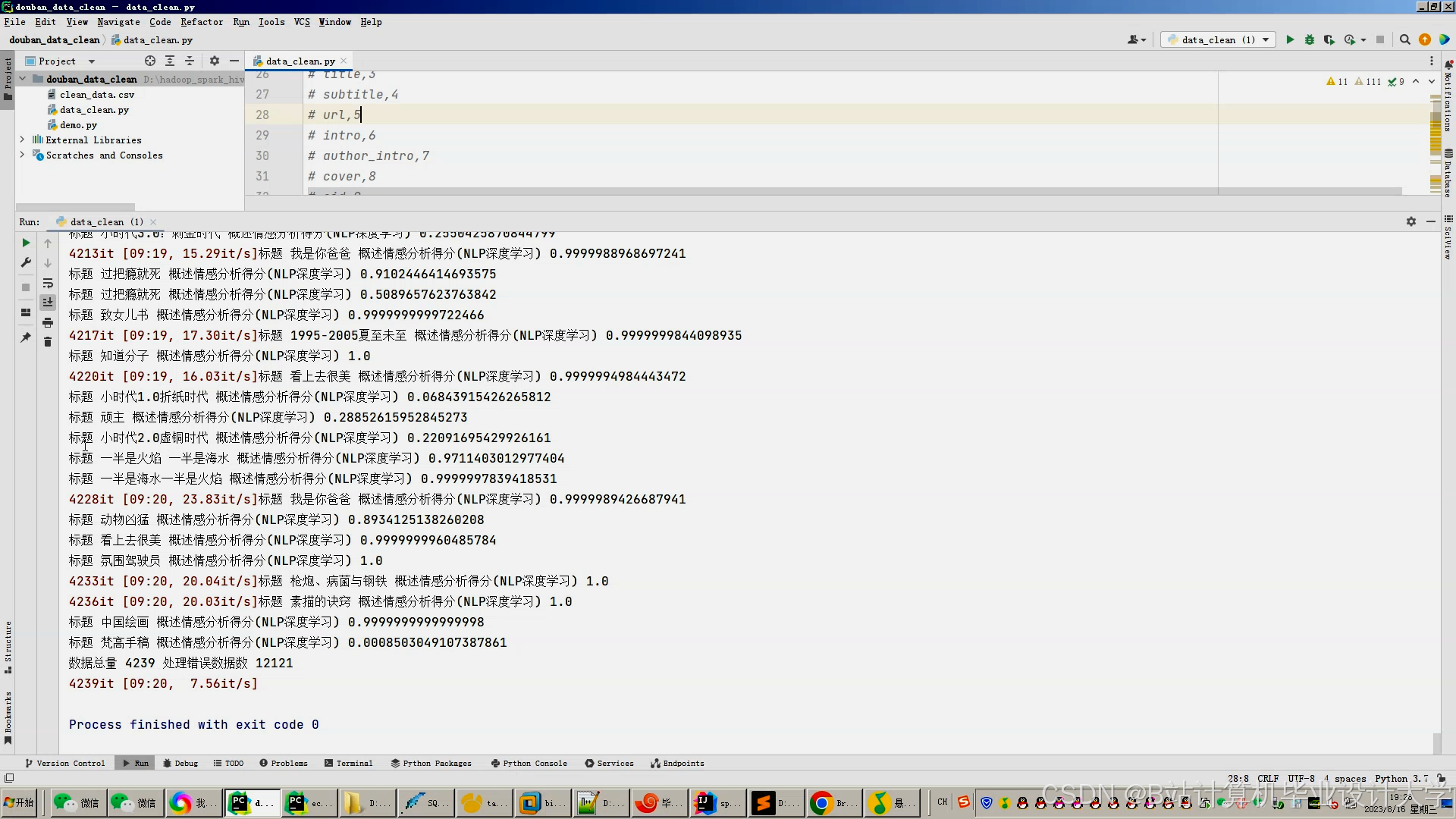

- 数据清洗:过滤无效记录、处理缺失值;

- 特征提取:

- 用户特征:年龄、性别、历史偏好标签(TF-IDF/Word2Vec);

- 图书特征:分类标签、关键词向量、作者影响力;

- 数据转换:生成用户-图书评分矩阵、图书相似度矩阵。

- 技术要求:

- 使用PySpark RDD/DataFrame进行分布式计算;

- 调用MLlib库实现特征向量化(CountVectorizer、TF-IDF)。

(3) 推荐算法实现(PySpark MLlib)

- 算法选择:

- 协同过滤:

- ALS(交替最小二乘法)实现矩阵分解;

- 基于用户的协同过滤(User-Based CF);

- 基于物品的协同过滤(Item-Based CF)。

- 内容过滤:

- 基于图书关键词/标签的余弦相似度计算;

- 结合用户历史偏好过滤推荐结果。

- 混合推荐:加权融合协同过滤与内容过滤结果。

- 协同过滤:

- 优化方向:

- 冷启动处理:新用户推荐热门图书或基于人口统计学的推荐;

- 实时推荐:增量更新用户行为数据(Spark Streaming)。

(4) 后端服务与API开发(Python Flask/FastAPI)

- 功能:

- 接收用户请求(用户ID),返回Top-K推荐图书列表;

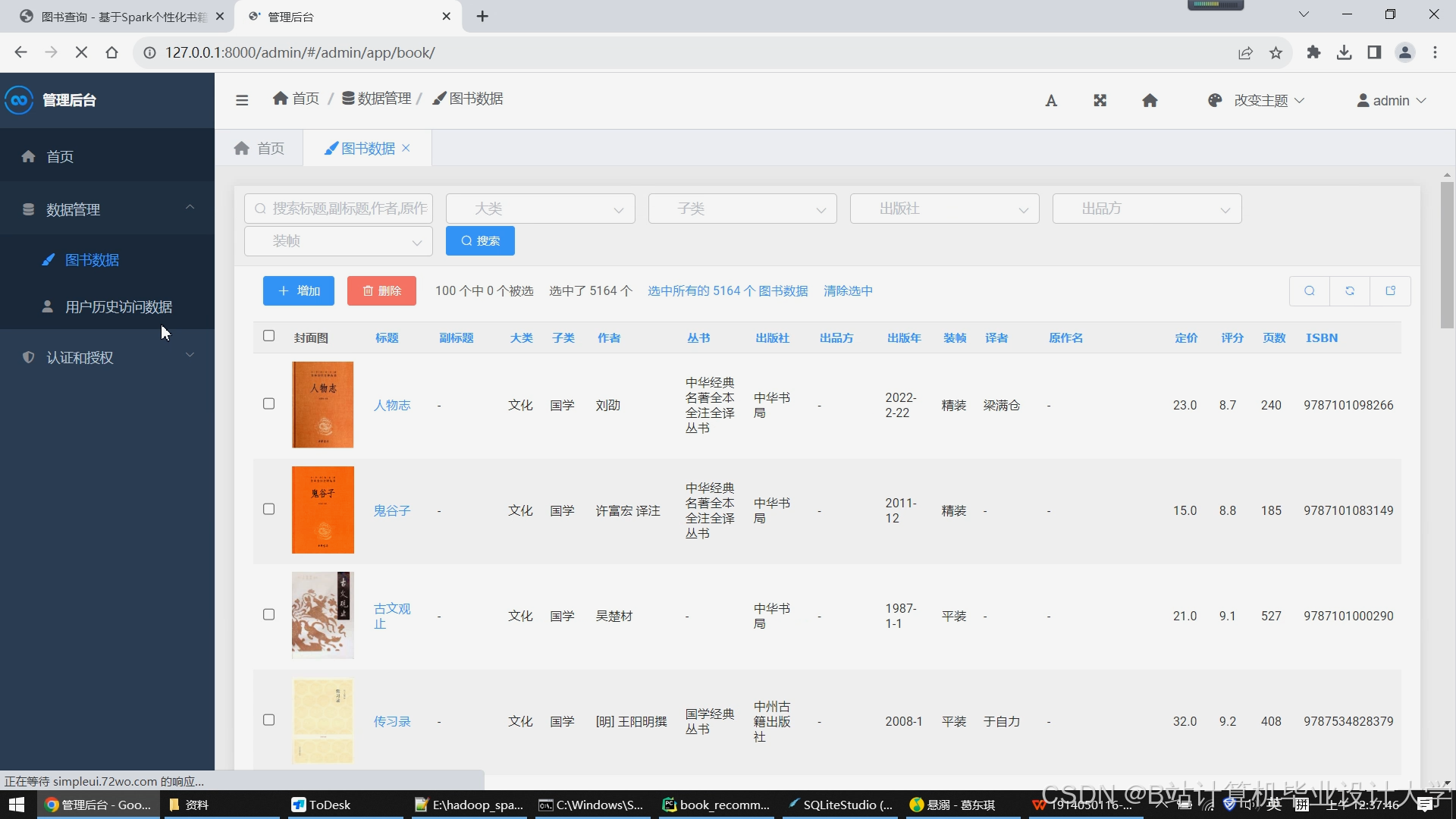

- 管理接口:数据上传、算法参数配置、推荐结果监控;

- 日志记录:记录推荐请求与效果(用于A/B测试)。

- 技术要求:

- 使用Flask/FastAPI构建轻量级服务;

- 与Hadoop/Spark集群交互(通过PySpark或REST API)。

(5) 前端展示与监控(可选)

- 功能:

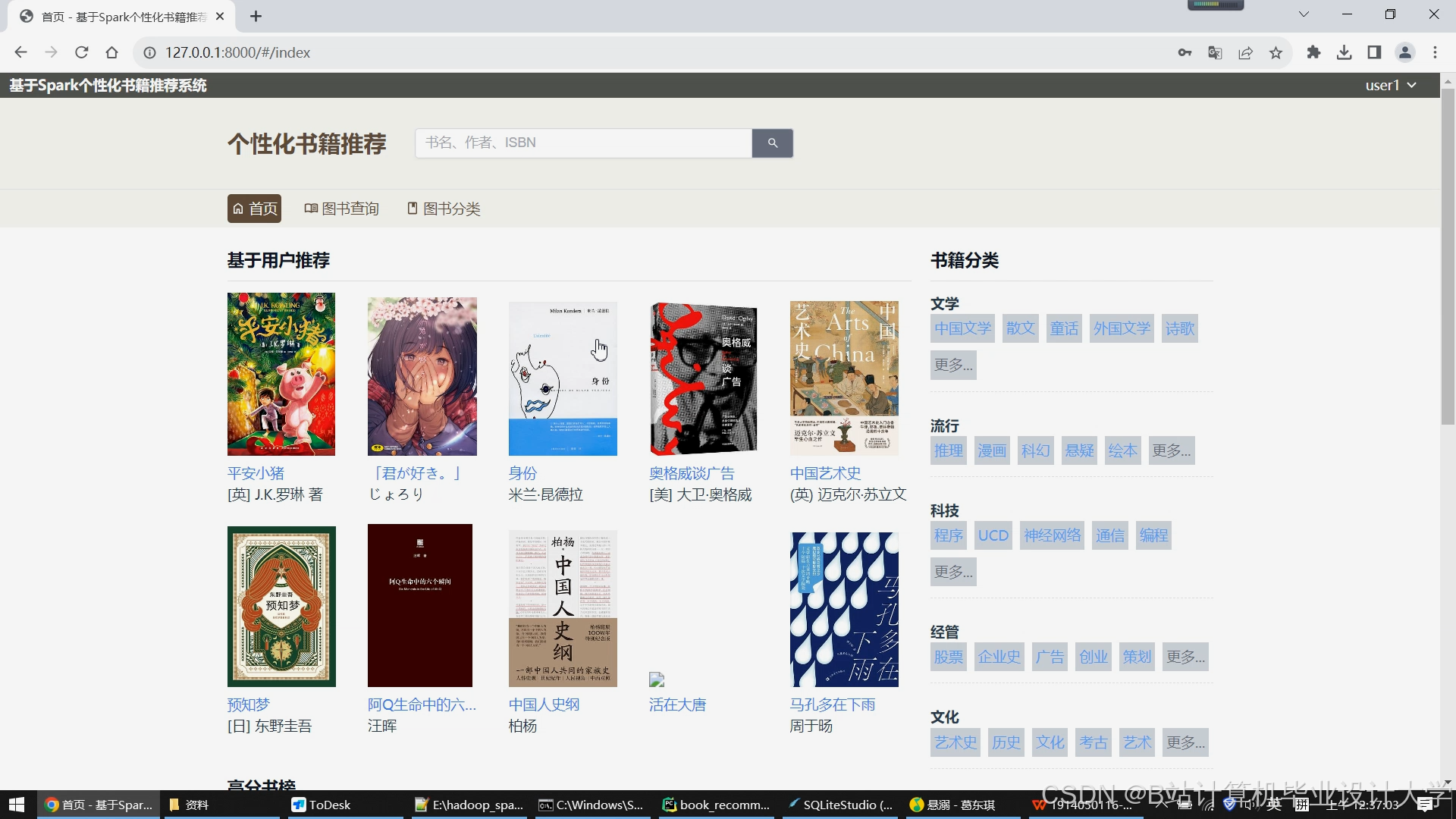

- 用户端:展示推荐图书列表(封面、标题、评分、简介);

- 管理端:推荐效果仪表盘(点击率、转化率、算法性能)。

- 技术要求:

- 前端框架:Vue.js/React + ECharts;

- 数据可视化:实时监控推荐系统指标。

2. 技术栈

- 大数据生态:Hadoop 3.x(HDFS/HBase/Hive)、Spark 3.x(PySpark);

- 编程语言:Python 3.8+(PySpark、Flask/FastAPI);

- 机器学习库:PySpark MLlib、Scikit-learn(辅助特征处理);

- 数据库:HBase(实时查询)、MySQL(元数据存储);

- 部署环境:Linux服务器集群(或云平台如AWS EMR、阿里云MaxCompute)。

三、任务分工与时间计划

1. 任务分工

| 模块 | 负责人 | 职责 |

|---|---|---|

| 数据采集与存储 | 张三 | Hadoop集群搭建、数据导入与存储优化 |

| 数据预处理 | 李四 | PySpark数据清洗、特征工程实现 |

| 推荐算法开发 | 王五 | ALS/协同过滤算法实现、混合推荐策略设计 |

| 后端服务开发 | 赵六 | Flask API开发、与Spark集群交互 |

| 前端与监控 | 陈七 | 前端页面开发、推荐效果可视化 |

| 系统测试与部署 | 周八 | 集成测试、性能调优、集群部署 |

2. 时间计划

| 阶段 | 时间 | 任务内容 |

|---|---|---|

| 环境搭建与数据准备 | 第1-2周 | Hadoop/Spark集群部署,数据采集与存储 |

| 数据预处理与特征工程 | 第3-4周 | PySpark清洗数据、生成特征矩阵 |

| 推荐算法开发与测试 | 第5-6周 | ALS模型训练、协同过滤实现、冷启动优化 |

| 后端服务与API开发 | 第7周 | Flask接口开发、与Spark任务集成 |

| 前端开发与系统集成 | 第8周 | 页面展示、前后端联调、监控仪表盘 |

| 测试与优化 | 第9周 | 性能测试(吞吐量、延迟)、A/B测试 |

| 文档撰写与验收 | 第10周 | 技术文档、用户手册、项目验收 |

四、预期成果

- 可运行系统:

- 分布式存储与计算集群(Hadoop+Spark);

- 推荐服务API(支持高并发请求);

- 用户端与管理端前端页面。

- 技术文档:

- 系统架构设计文档;

- 算法说明与调优报告;

- 部署与运维手册。

- 开源代码:GitHub仓库(含Docker部署脚本)。

五、验收标准

- 功能完整性:

- 支持100万级用户与图书数据的推荐;

- 推荐准确率(Precision@10)≥65%,冷启动场景覆盖率≥90%。

- 性能指标:

- 离线推荐任务处理时间≤1小时(100万用户数据);

- API响应时间≤500ms(QPS≥100)。

- 可扩展性:

- 支持横向扩展(增加Spark Worker节点);

- 算法模块可替换(如未来接入深度学习模型)。

六、备注

- 需定期同步进度,解决集群资源分配问题;

- 推荐算法需对比基线模型(如随机推荐、热门推荐);

- 考虑数据隐私合规性(如用户评分匿名化处理)。

项目负责人:__________

日期:__________

此任务书可根据实际项目需求调整技术细节(如是否引入深度学习模型、是否使用Kafka处理实时数据流)。如需进一步细化某部分内容(如HDFS存储方案设计、Spark任务调优参数),可补充说明。

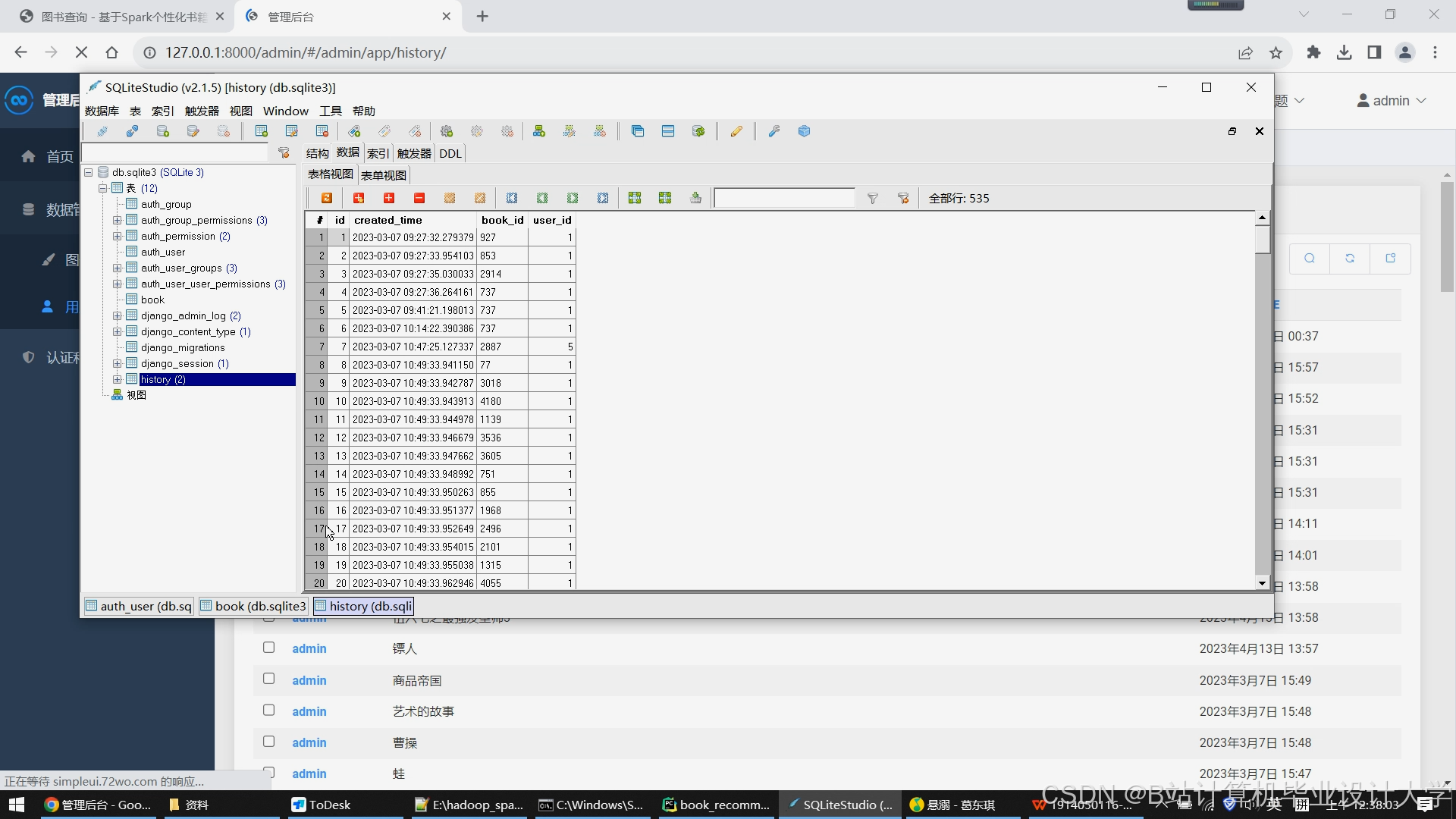

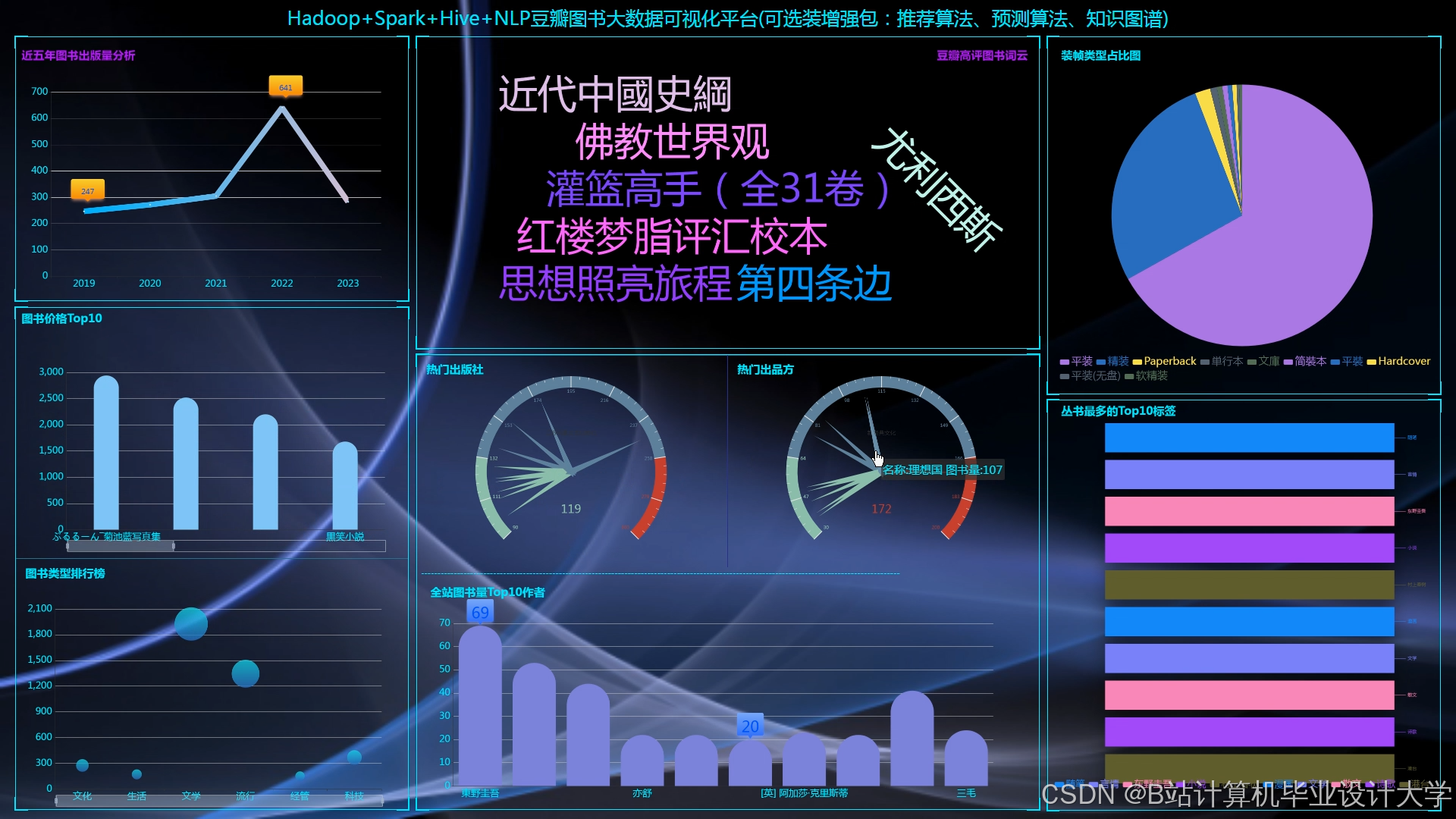

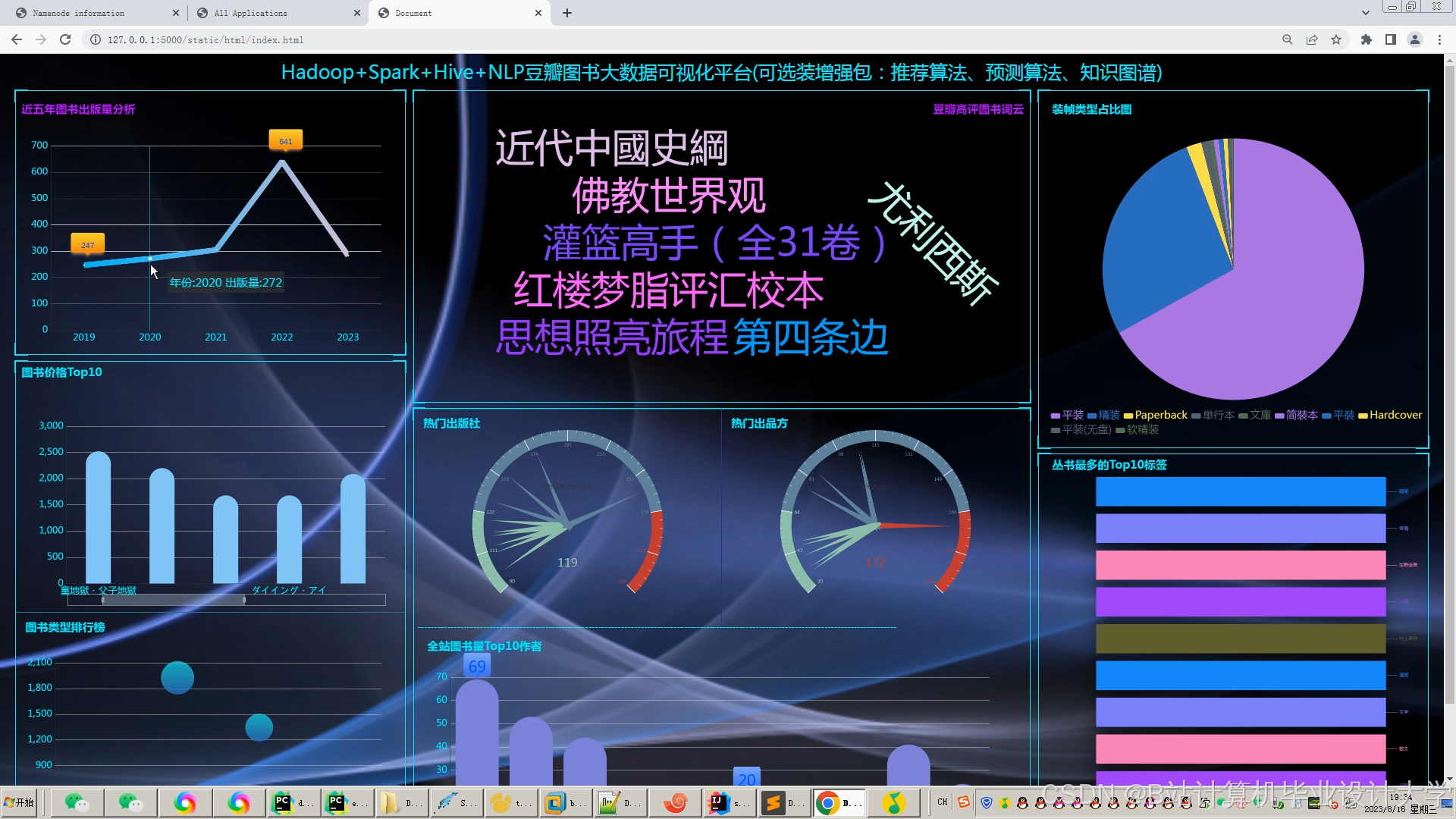

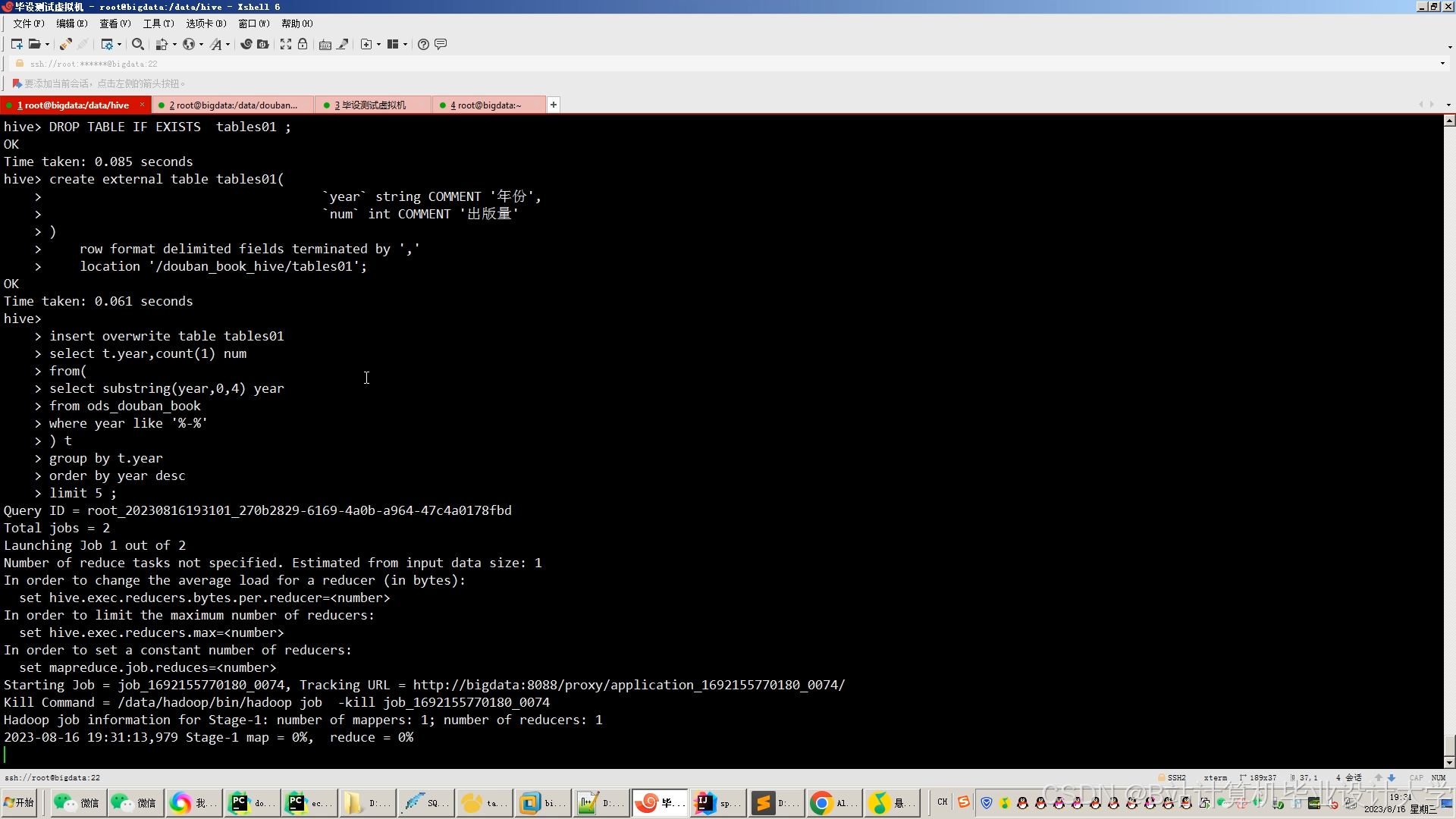

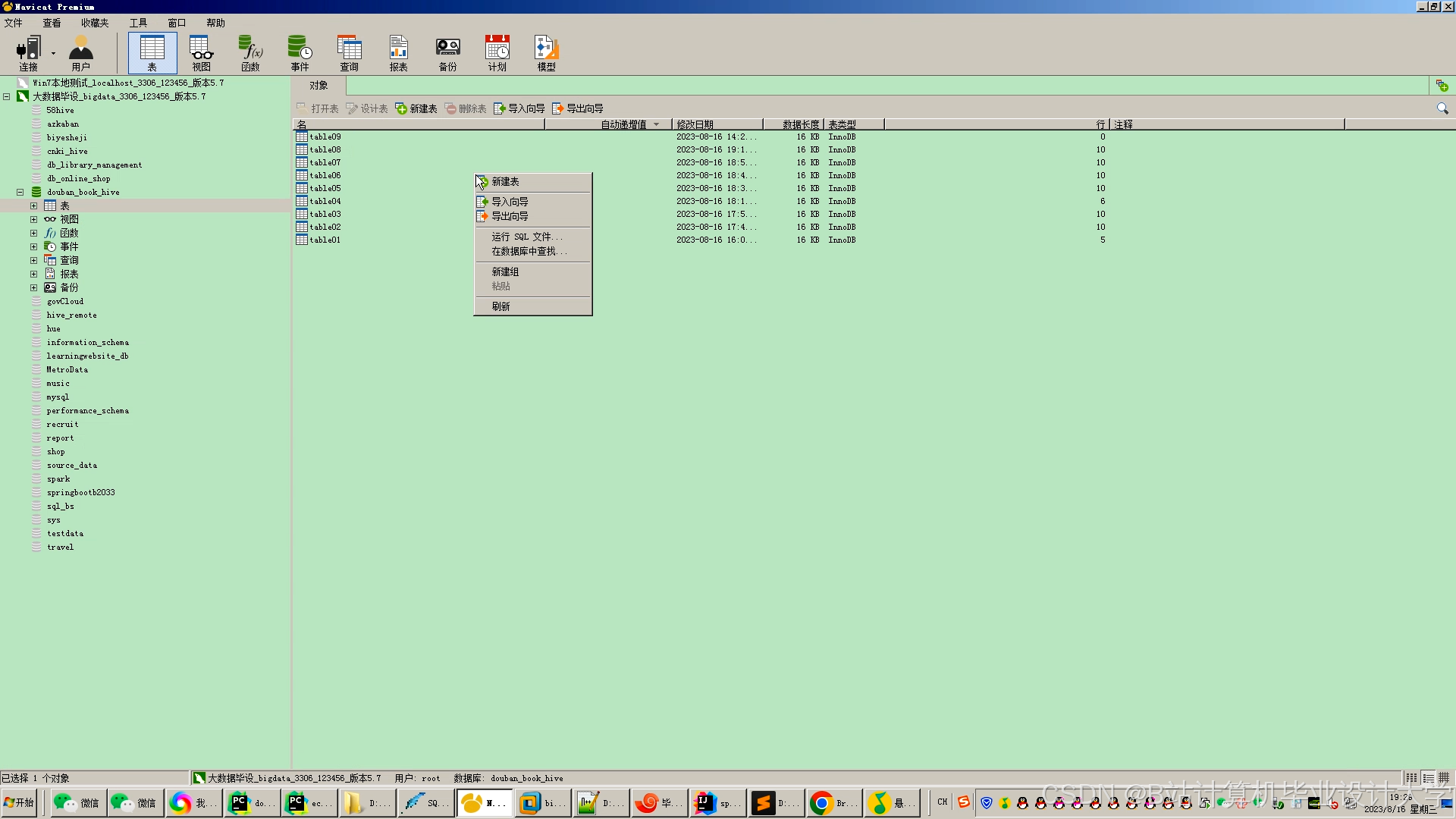

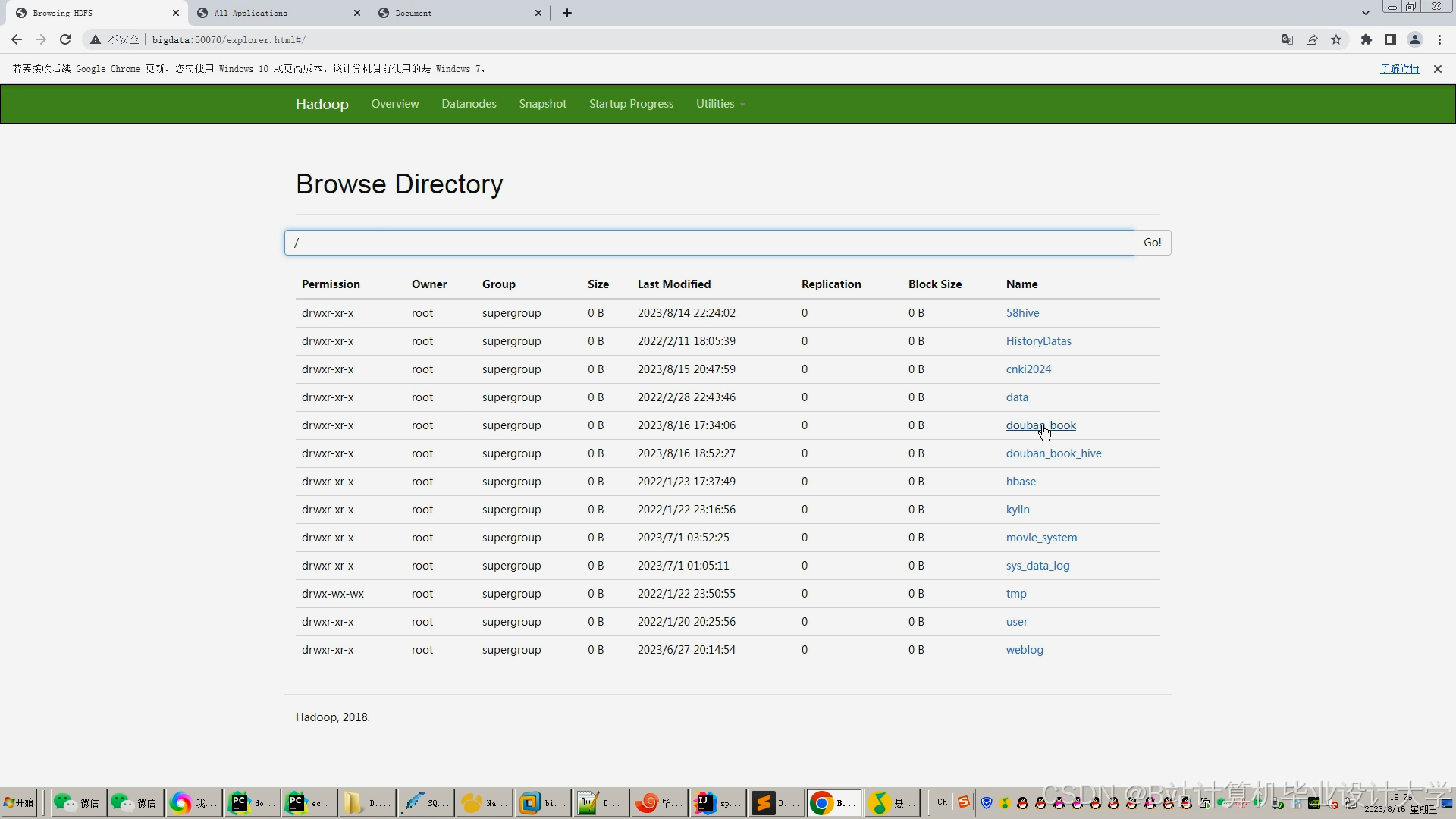

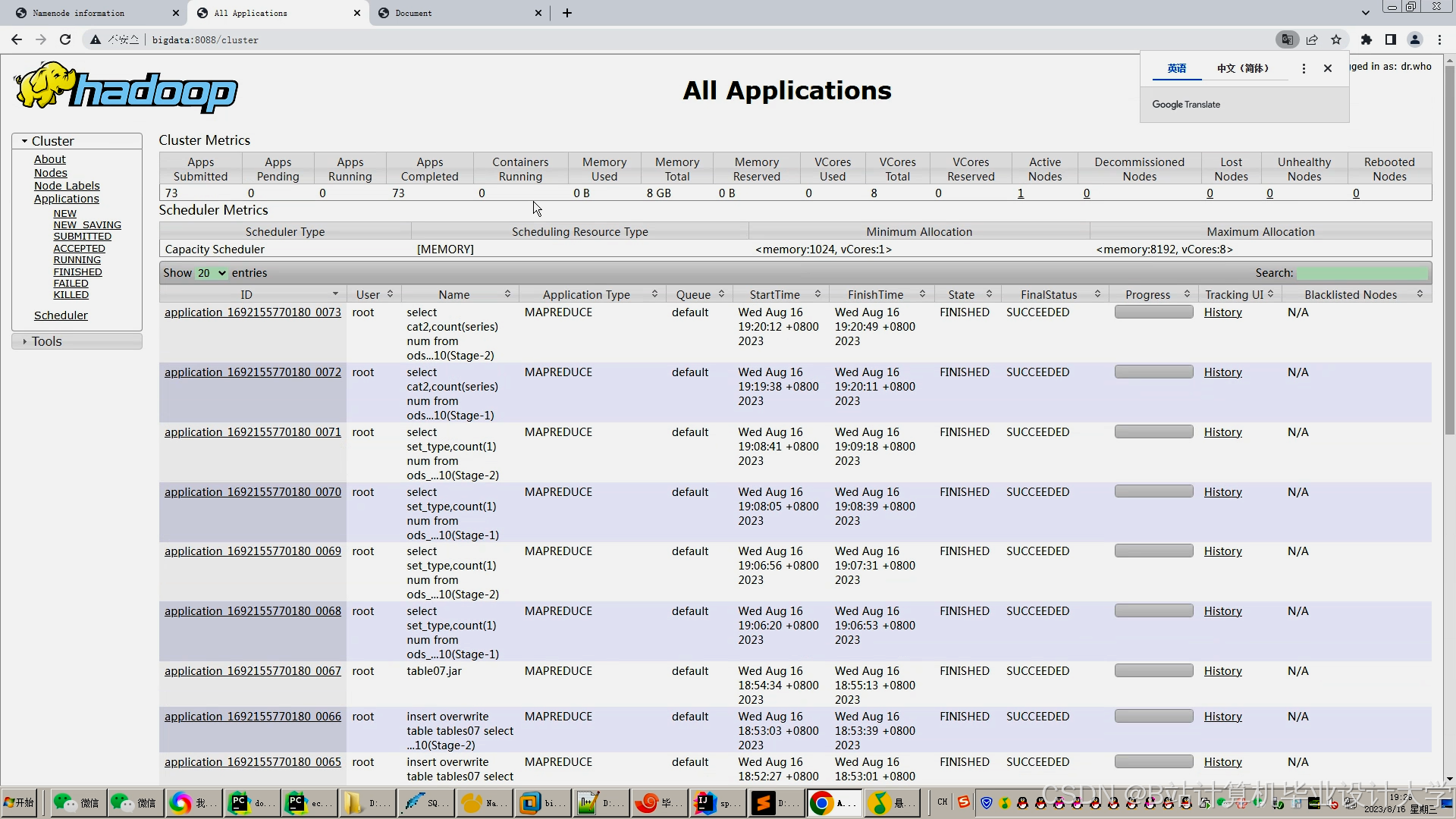

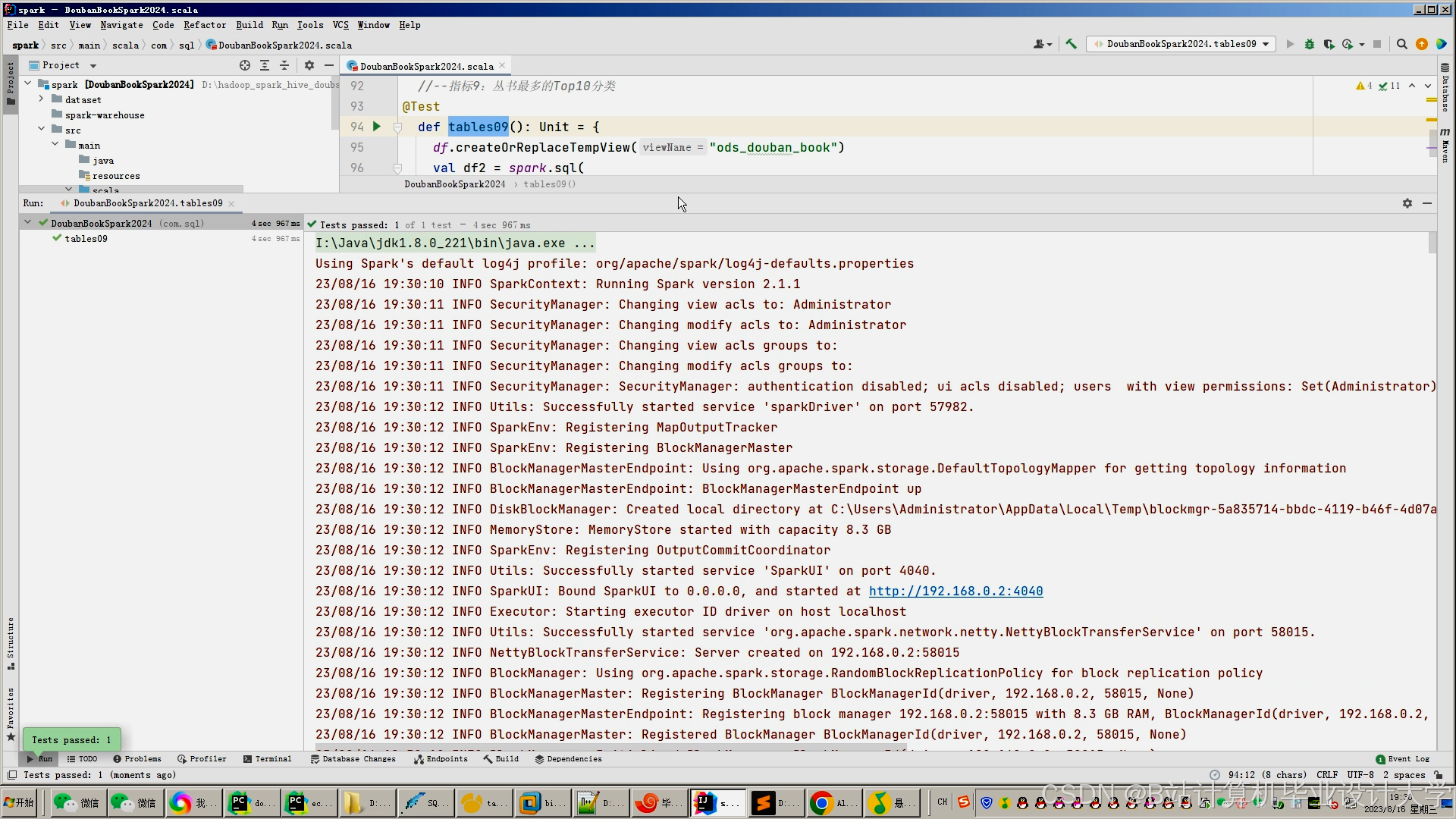

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

1846

1846

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?