温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是为您设计的《PySpark+Hive+Django小红书评论情感分析、笔记可视化与舆情预测系统》任务书框架,包含技术实现路径与项目规划:

小红书舆情分析预测系统任务书

一、项目背景与目标

- 业务需求

- 小红书平台日均产生千万级笔记与评论,需构建实时舆情监控体系

- 品牌方需快速识别负面舆情、分析用户情感倾向、预测传播趋势

- 技术目标

- 基于PySpark实现分布式文本处理

- 通过Hive构建数据仓库

- 使用Django开发可视化管理系统

- 集成机器学习模型实现舆情预测

二、系统架构设计

mermaid

graph TD | |

A[数据源: 小红书API/爬虫] --> B[PySpark预处理] | |

B --> C[Hive数据仓库] | |

C --> D[Django应用层] | |

D --> E[前端可视化] | |

D --> F[预测服务API] | |

F --> G[机器学习模型] |

三、功能模块分解

1. 数据采集与存储模块

- 任务:

- 使用Scrapy框架采集笔记/评论数据(含文本、时间、互动数据)

- 通过Kafka实现实时数据流传输

- Hive表结构设计:

sqlCREATE TABLE comments (id STRING,content STRING,create_time TIMESTAMP,like_count INT,author_id STRING) PARTITIONED BY (dt STRING);

2. 情感分析处理模块

- PySpark实现:

pythonfrom pyspark.ml.feature import HashingTF, IDF, Tokenizerfrom pyspark.ml.classification import LogisticRegression# 文本向量化tokenizer = Tokenizer(inputCol="content", outputCol="words")hashingTF = HashingTF(inputCol="words", outputCol="rawFeatures", numFeatures=1000)idf = IDF(inputCol="rawFeatures", outputCol="features")# 情感分类模型lr = LogisticRegression(maxIter=10, regParam=0.01)pipeline = Pipeline(stages=[tokenizer, hashingTF, idf, lr])model = pipeline.fit(trainingData)

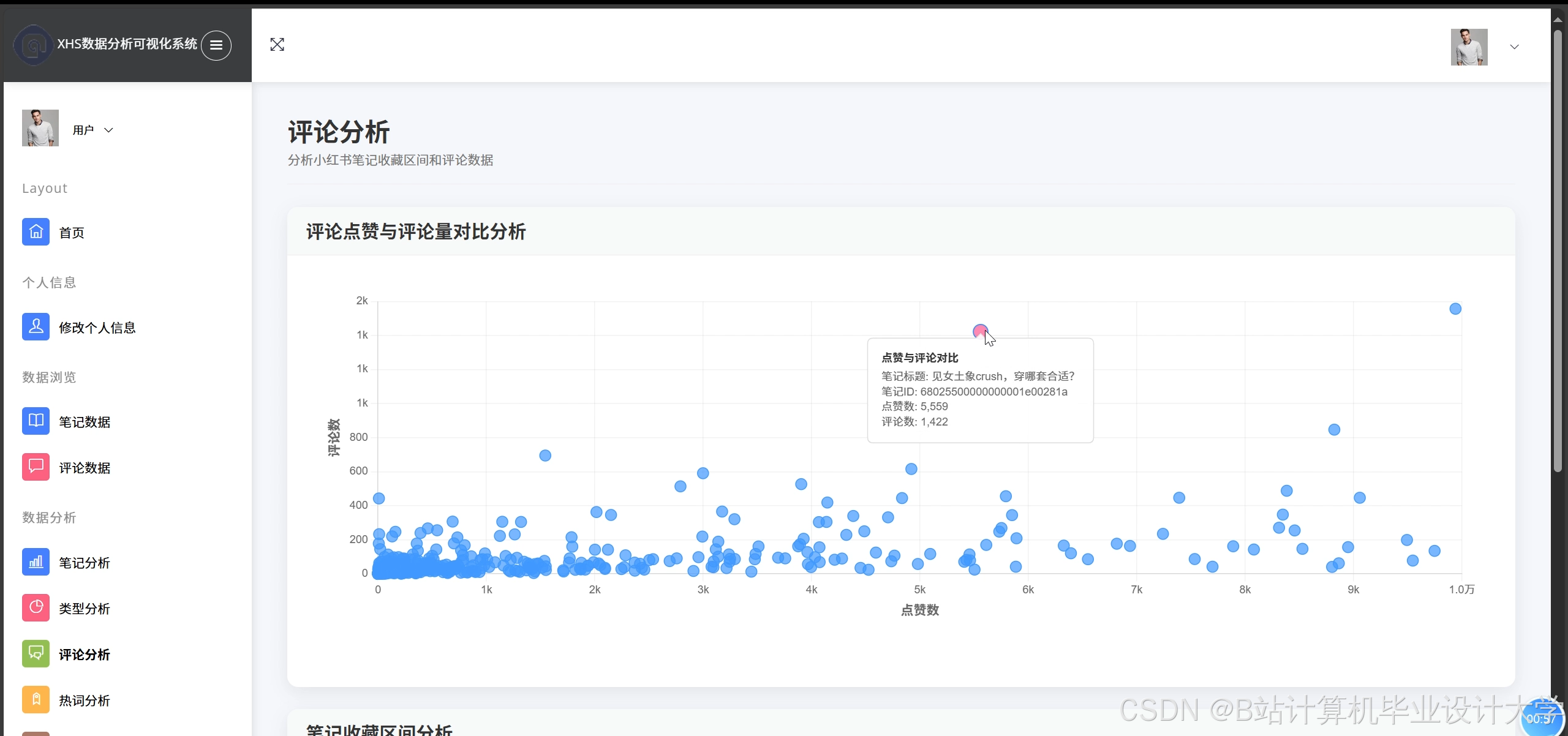

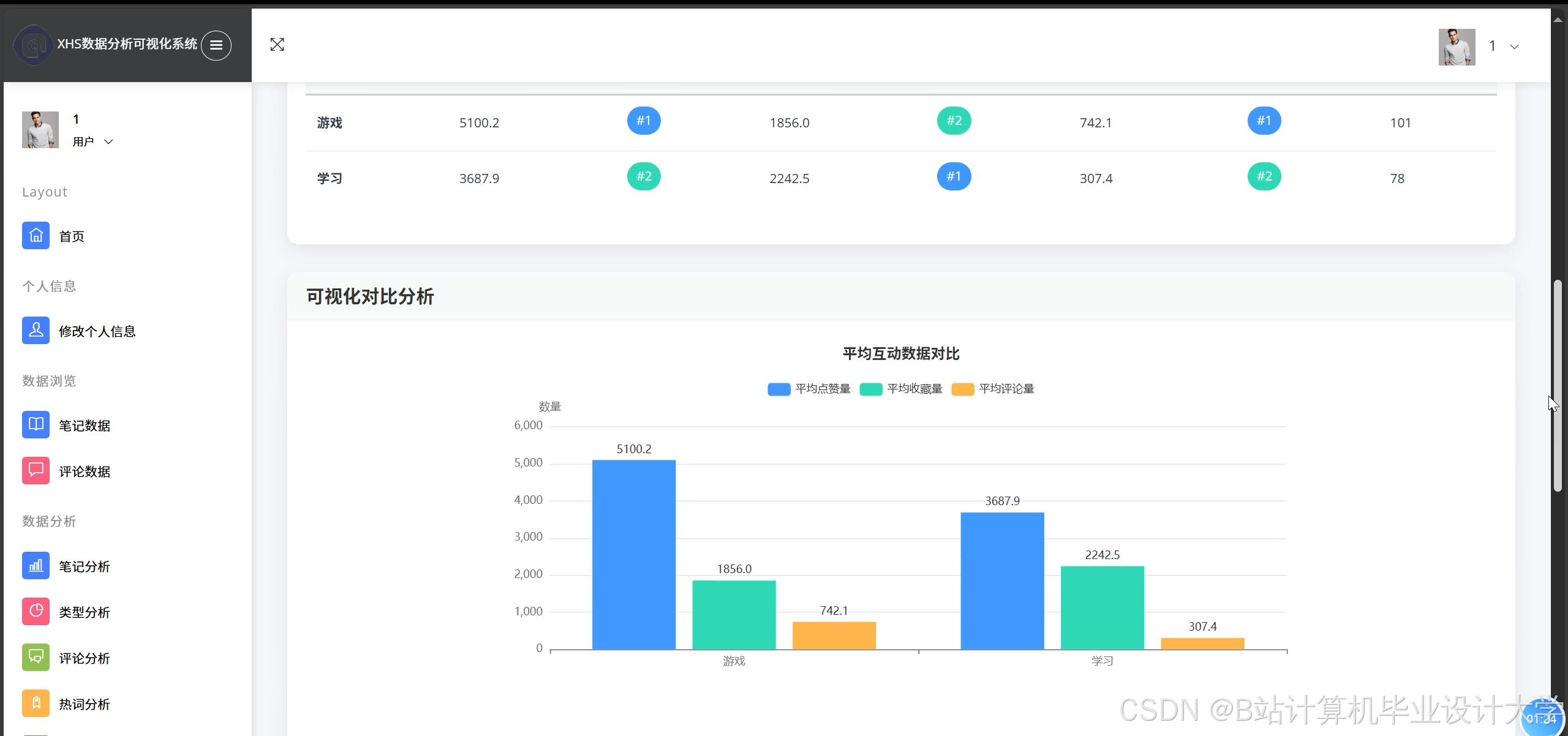

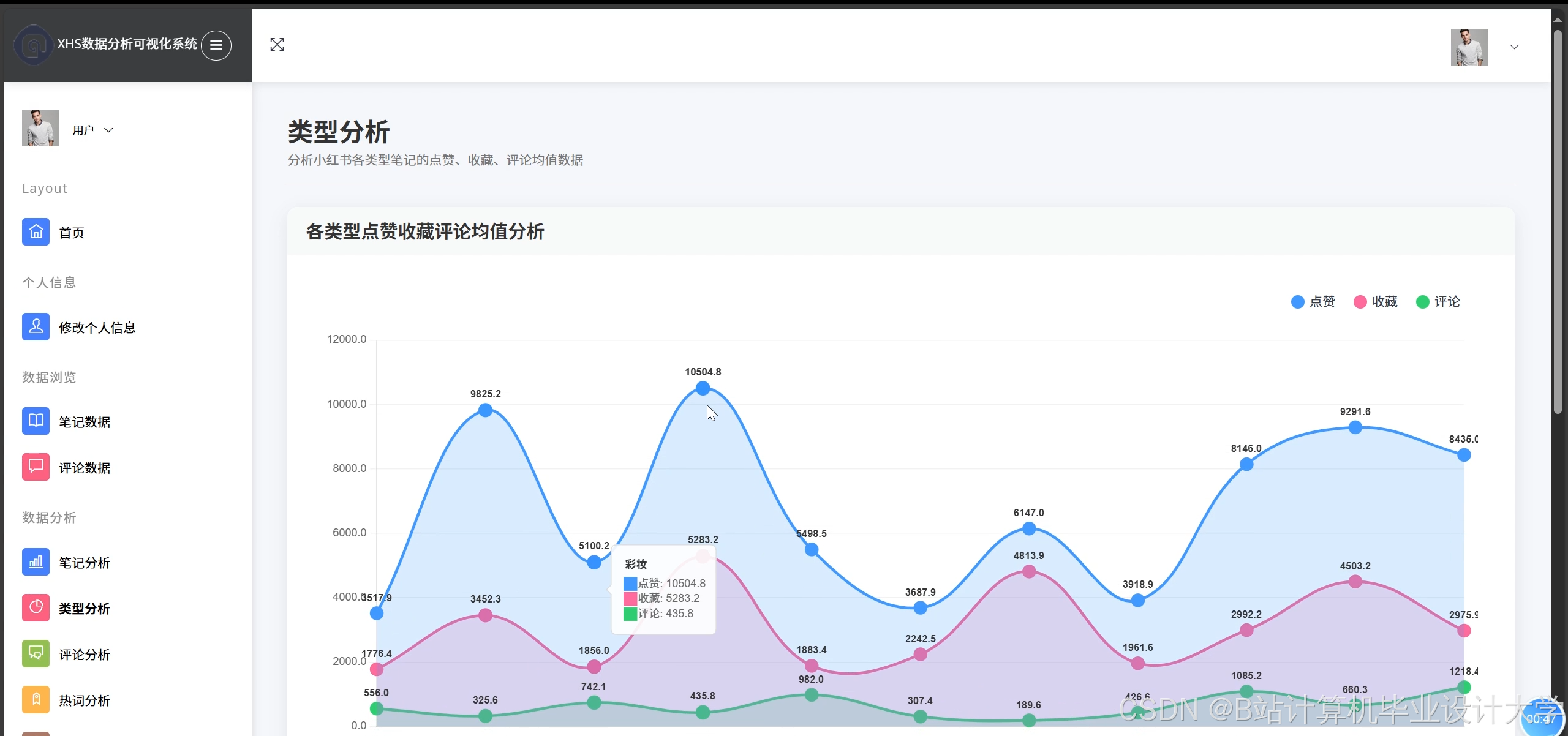

3. 可视化分析模块

- Django实现功能:

- 情感分布热力图(ECharts)

- 话题词云图(WordCloud)

- 舆情传播时间轴(D3.js)

- 互动数据仪表盘(Superset集成)

4. 预测预警模块

- LSTM预测模型:

pythonfrom tensorflow.keras.models import Sequentialfrom tensorflow.keras.layers import LSTM, Densemodel = Sequential([LSTM(64, input_shape=(30, 1)), # 30天窗口Dense(1, activation='sigmoid')])model.compile(loss='binary_crossentropy', optimizer='adam')

四、技术实现路线

1. 环境配置

- 集群:Hadoop 3.3 + Spark 3.2

- 数据库:Hive 3.1 + MySQL(Django元数据)

- 开发环境:Python 3.8 + PySpark 3.2 + Django 4.0

2. 关键技术点

- 分布式处理:使用PySpark的

DataFrameAPI处理10TB级文本数据 - 实时计算:通过Spark Streaming实现分钟级情感统计

- 模型部署:将训练好的TensorFlow模型转换为TF-Lite格式供Django调用

3. 性能优化

- Hive数据分区策略:按日期+话题分类

- PySpark内存管理:设置

spark.executor.memory=8g - 缓存策略:对高频查询的Hive表启用

STORAGE_LEVEL.MEMORY_ONLY

五、项目里程碑

| 阶段 | 时间 | 交付物 |

|---|---|---|

| 1. 数据采集层 | 第1-2周 | 爬虫系统、Kafka通道 |

| 2. 存储层建设 | 第3周 | Hive数据仓库、ETL流程 |

| 3. 核心算法开发 | 第4-5周 | 情感分析模型、预测模型 |

| 4. 可视化开发 | 第6周 | Django管理后台 |

| 5. 系统集成 | 第7周 | 完整流程联调 |

| 6. 压力测试 | 第8周 | 1000QPS性能测试报告 |

六、预期成果

- 舆情分析系统:

- 情感分析准确率≥85%

- 实时处理延迟≤3分钟

- 可视化平台:

- 支持10万级数据点的交互式图表

- 移动端适配率100%

- 预测模型:

- 舆情爆发预测提前量≥24小时

- F1-score≥0.82

七、风险评估与应对

| 风险类型 | 应对方案 |

|---|---|

| 数据反爬 | 使用代理IP池+模拟用户行为 |

| 模型过拟合 | 引入小红书领域专用词库 |

| 集群资源不足 | 采用K8s动态资源分配 |

八、附录

- 小红书API文档摘要

- 情感分析标注规范(含2000条标注样本)

- 系统架构图(Visio源文件)

此任务书强调了分布式计算与Web可视化的结合,建议采用敏捷开发模式,每两周进行一次功能演示。实际开发时需重点关注PySpark与Hive的JDBC连接优化,以及Django的异步任务处理(建议使用Celery)。

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

1040

1040

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?