温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份关于《Python+Hadoop+Spark知网文献推荐系统》的任务书模板,结合分布式计算、自然语言处理和推荐算法,适用于学术文献的个性化推荐场景:

任务书:基于Python+Hadoop+Spark的知网文献推荐系统开发

一、项目背景与目标

-

背景

知网(CNKI)等学术平台存在文献数量庞大、用户检索效率低的问题,传统关键词匹配难以满足个性化需求。本系统通过整合文献元数据、用户行为日志和全文内容,利用大数据和NLP技术构建智能推荐引擎,实现"文献-研究者精准匹配"。 -

目标

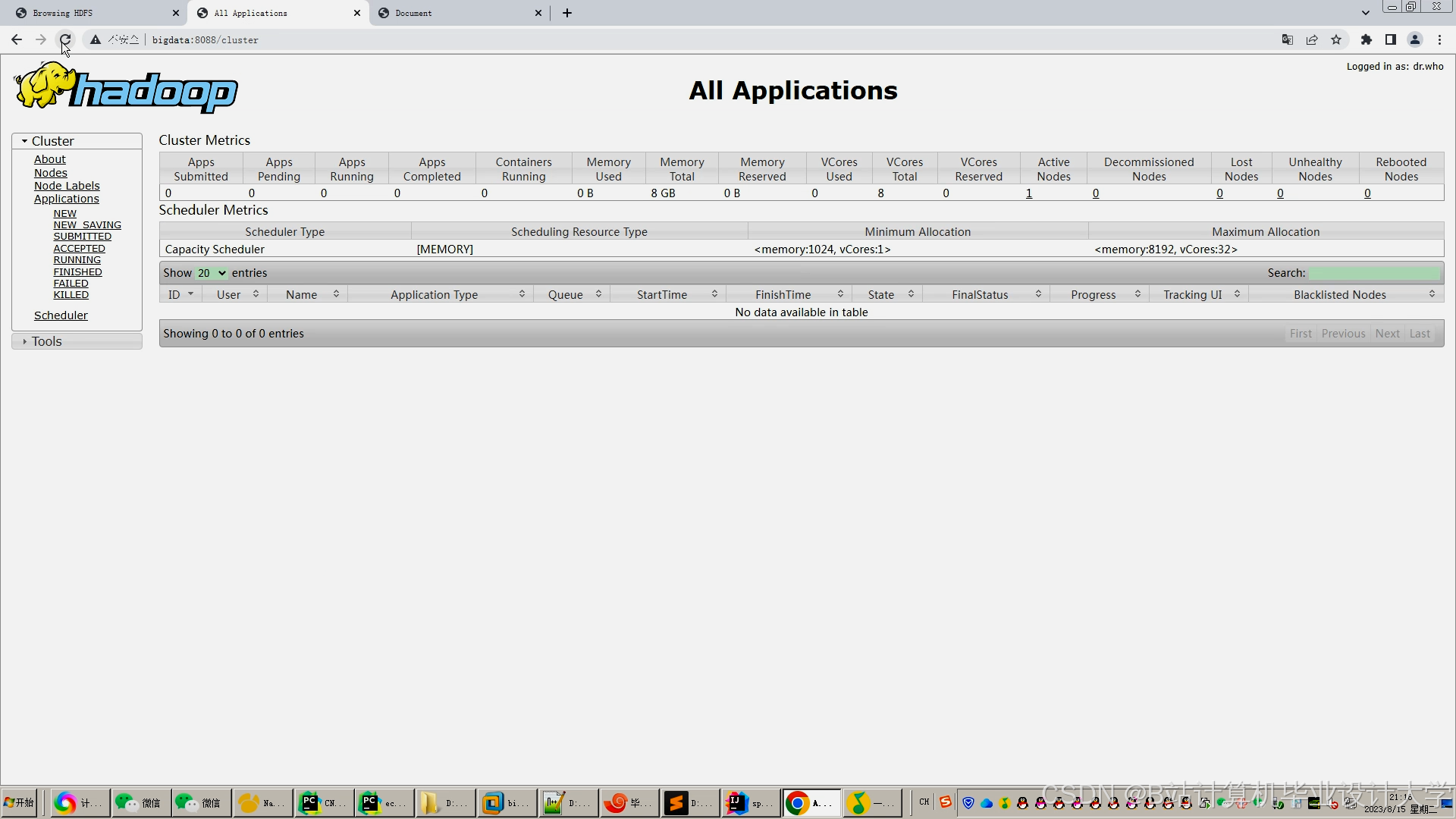

- 搭建分布式文献存储与处理平台(Hadoop+Spark),支持TB级学术数据高效处理

- 基于Python实现NLP特征提取(主题模型、语义向量)和推荐算法(混合推荐)

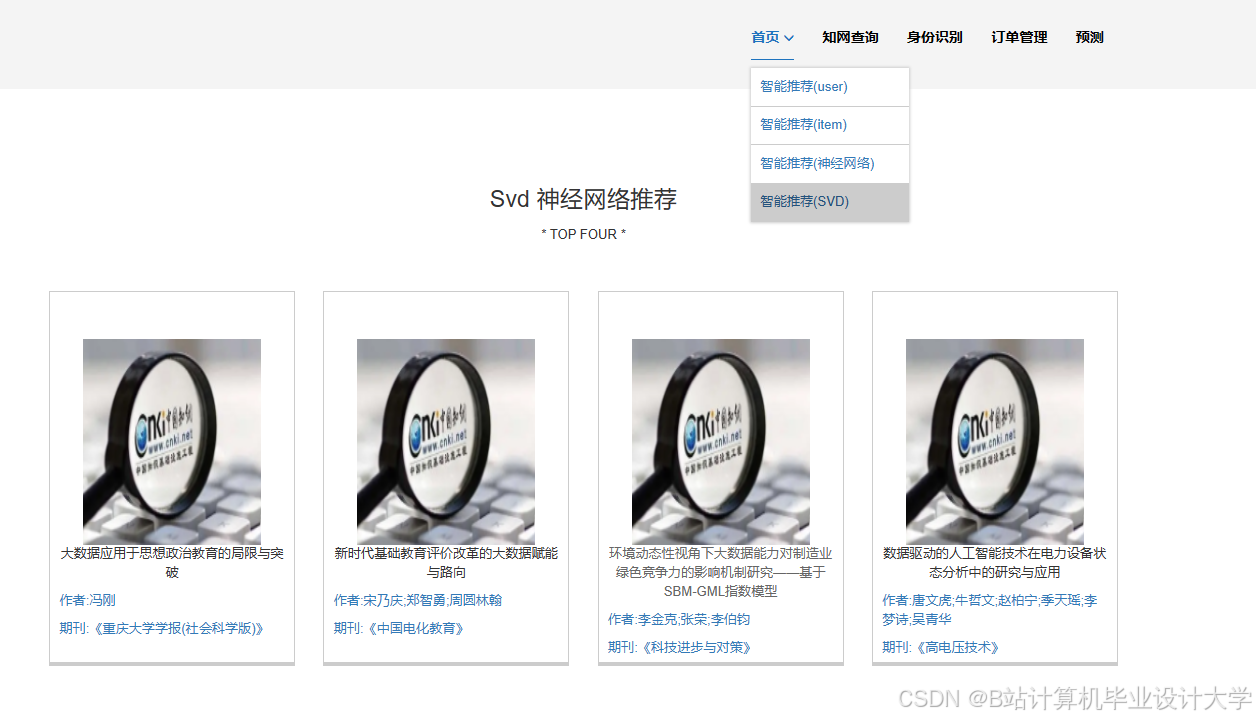

- 构建实时推荐服务,支持学者个性化文献推荐和热点趋势分析

- 提供可视化分析界面,辅助科研决策优化

二、系统架构设计

┌───────────────────────────────────────────────────────┐ | |

│ 数据源层 │ | |

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ │ | |

│ │ 知网API │ │ 机构库 │ │ 用户日志 │ │ | |

│ └─────────┘ └─────────┘ └─────────┘ │ | |

└───────────────┬───────────────────────────────────────┘ | |

│ 数据采集(Python爬虫+Flume) | |

▼ | |

┌───────────────────────────────────────────────────────┐ | |

│ 存储计算层 │ | |

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ │ | |

│ │ HDFS │←───│ Hive │←───│ Spark │ │ | |

│ └─────────┘ └─────────┘ └─────────┘ │ | |

│ ↑ ↑ ↑ │ | |

│ 原始文献存储 数据仓库 分布式计算 │ | |

└───────────────────────┬───────────────────────────────┘ | |

│ 特征工程与模型训练 | |

▼ | |

┌───────────────────────────────────────────────────────┐ | |

│ 应用服务层 │ | |

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ │ | |

│ │ 推荐API │ │ 分析看板 │ │ 用户反馈 │ │ | |

│ └─────────┘ └─────────┘ └─────────┘ │ | |

└───────────────────────────────────────────────────────┘ |

三、任务分工与职责

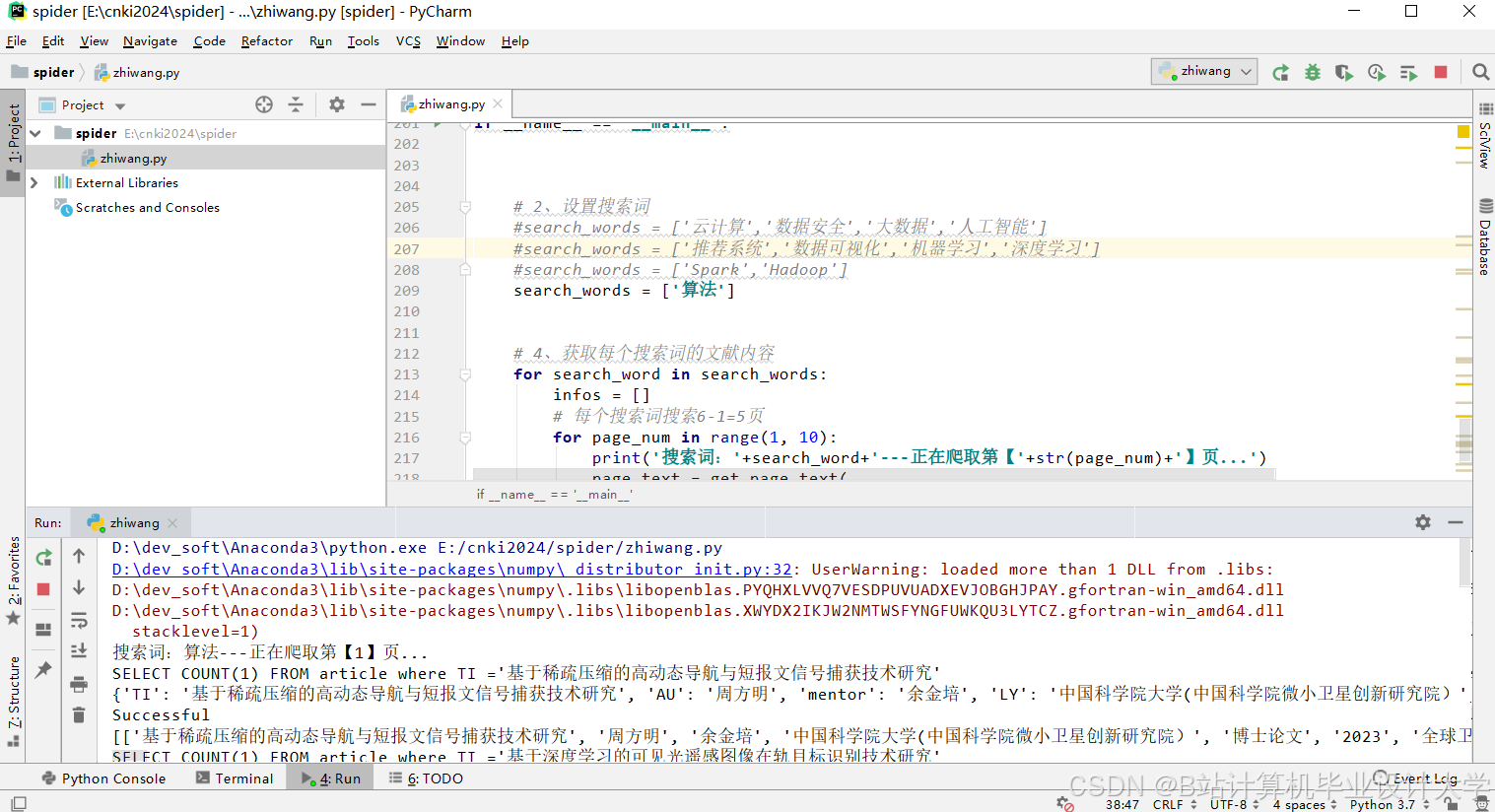

1. 数据采集与预处理组

- 任务:

- 使用Python编写知网API爬虫(Scrapy框架),获取文献元数据(标题、作者、摘要、关键词、引用量)

- 通过Flume实时采集用户行为日志(检索、浏览、下载、收藏)

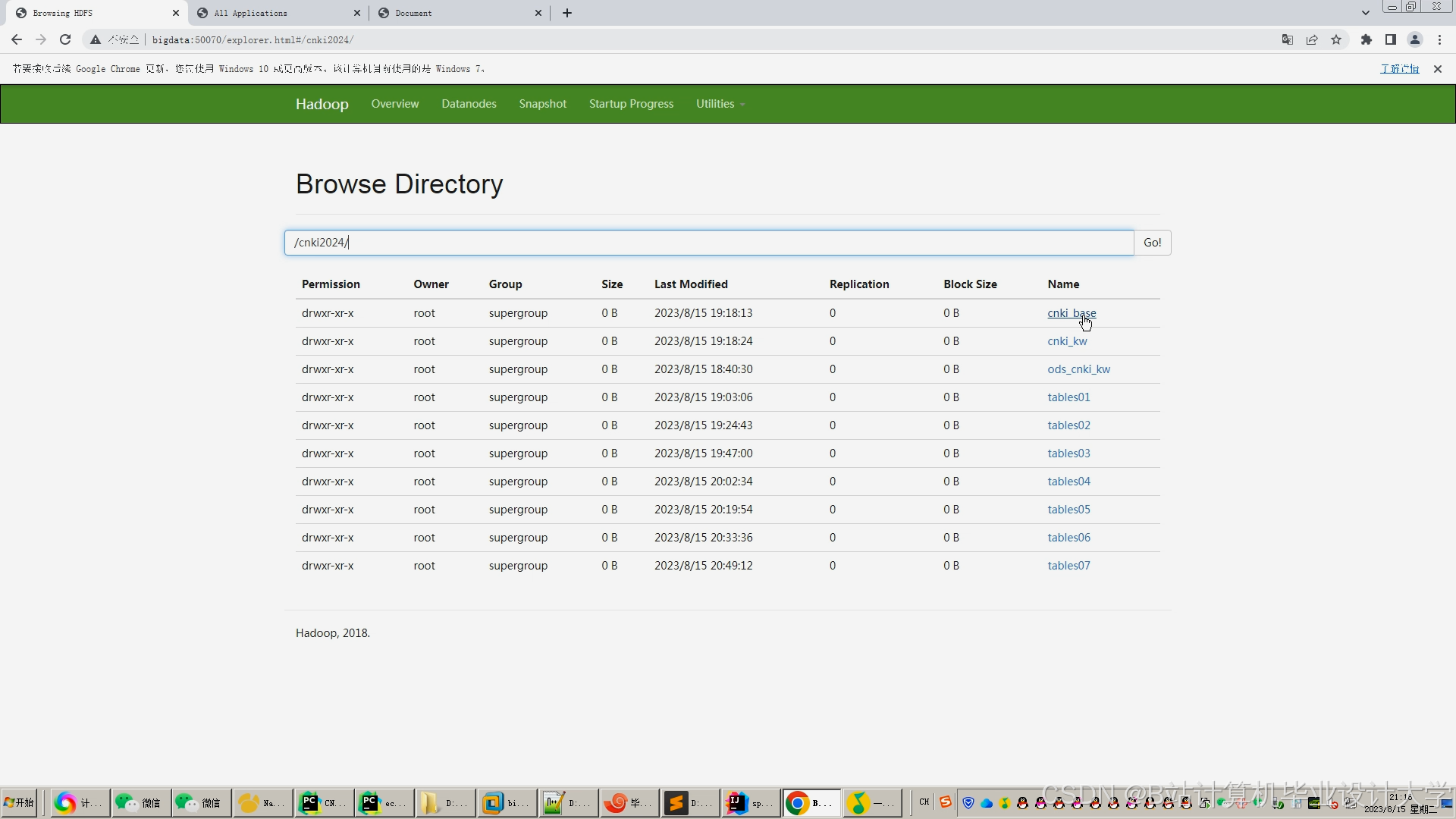

- 在HDFS建立分区存储结构:

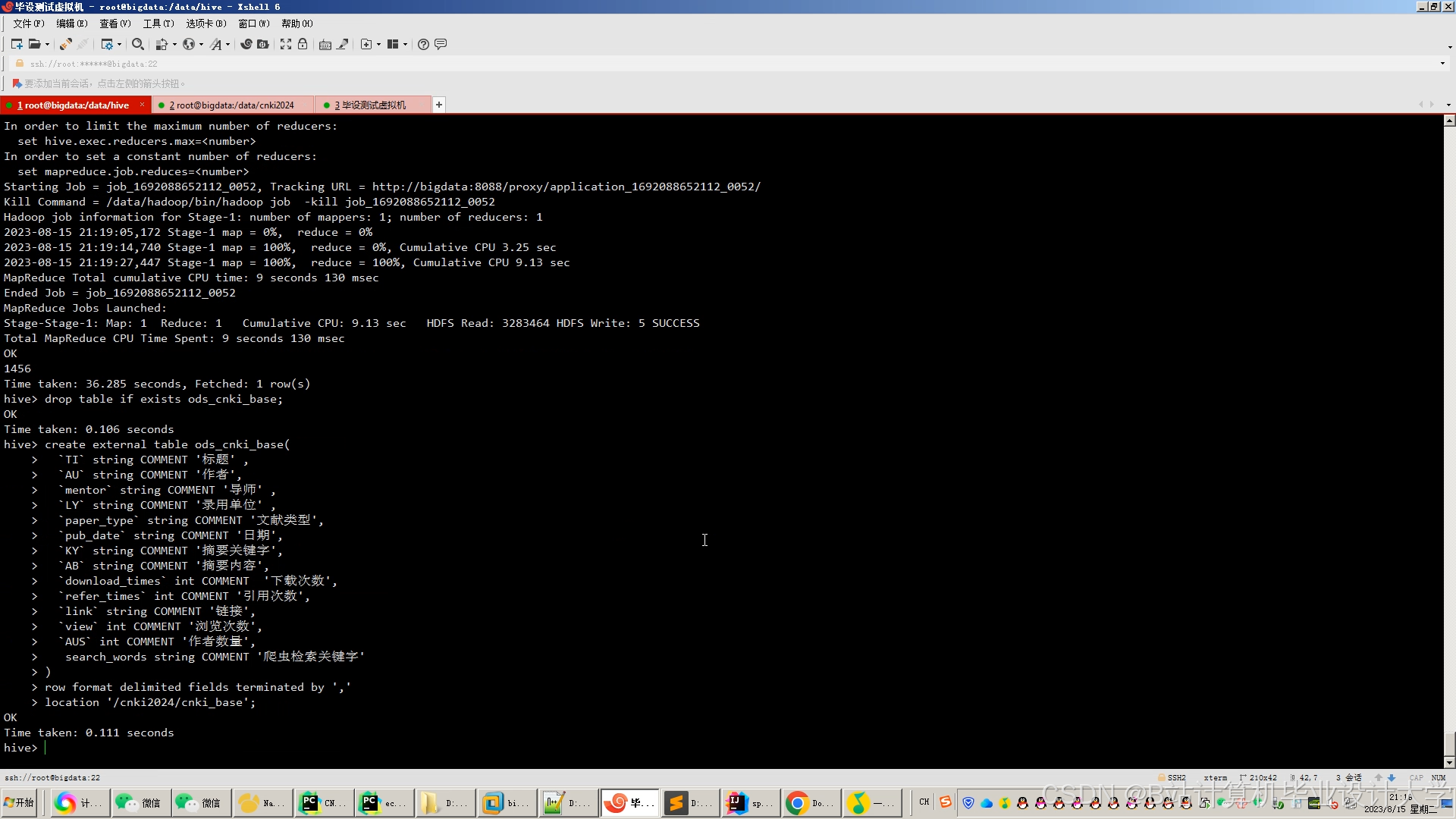

/data/literature/├── metadata/ # 元数据(Parquet格式)├── fulltext/ # 全文内容(Text格式)└── logs/ # 用户日志(JSON格式) - 使用Hive创建外部表映射数据:

sqlCREATE EXTERNAL TABLE literature_metadata (doc_id STRING,title STRING,authors ARRAY<STRING>,abstract STRING,keywords ARRAY<STRING>,cite_count INT) STORED AS PARQUET LOCATION '/data/literature/metadata';

- 输出:

- 数据采集脚本及调度配置(Airflow)

- Hive表结构设计文档

2. 特征工程组(Python+Spark)

- 任务:

- 文献特征提取:

- 使用Spark NLP(PySpark)实现:

- TF-IDF关键词权重计算

- LDA主题模型(主题数=50)

- BERT语义向量(768维)

- 示例代码:

pythonfrom pyspark.ml.feature import Word2Vecword2vec = Word2Vec(vectorSize=100, minCount=5)model = word2vec.fit(tokenized_df)

- 使用Spark NLP(PySpark)实现:

- 用户特征建模:

- 基于用户行为日志构建兴趣图谱(GraphX)

- 计算用户对各主题的偏好权重

- 将特征存入Hive特征表(启用ZLIB压缩)

- 文献特征提取:

- 输出:

- 特征提取脚本(Python/PySpark)

- 特征维度说明文档

3. 推荐算法开发组

- 任务:

- 实现混合推荐策略:

- 内容过滤:基于文献-用户语义向量相似度(Cosine相似度)

- 协同过滤:使用Spark ALS算法计算用户-文献隐语义矩阵

- 热点推荐:结合引用量、下载量、时间衰减因子

- 通过Hive SQL实现推荐结果融合与重排序:

sqlSELECT doc_id,0.5*content_score + 0.3*cf_score + 0.2*hot_score AS final_scoreFROM recommendation_resultsORDER BY final_score DESCLIMIT 20; - 模型评估指标:准确率、召回率、NDCG、用户点击率

- 实现混合推荐策略:

- 输出:

- 推荐算法代码(Python/PySpark)

- A/B测试方案与评估报告

4. 系统集成与服务组

- 任务:

- 开发推荐服务API(FastAPI + Uvicorn):

python@app.post("/recommend")async def recommend(user_id: str):spark = SparkSession.builder.getOrCreate()df = spark.sql(f"CALL get_recommendations('{user_id}')")return df.toPandas().to_dict('records') - 集成Redis缓存热门推荐结果(TTL=1小时)

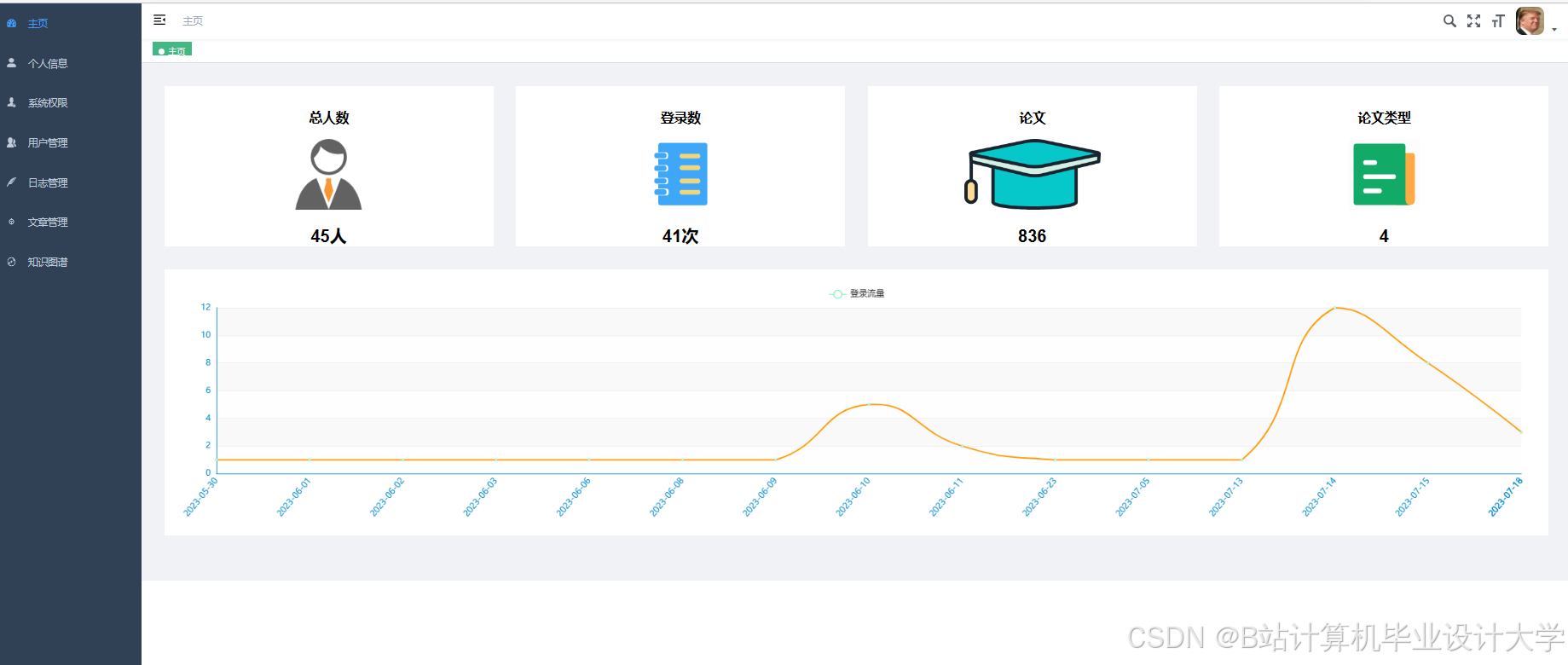

- 构建管理后台(Streamlit + Plotly):

- 推荐效果监控看板

- 用户兴趣分布可视化

- 文献主题热力图

- 开发推荐服务API(FastAPI + Uvicorn):

- 输出:

- API文档及接口测试用例

- 前端可运行Demo

5. 测试与优化组

- 任务:

- 性能测试:

- Spark任务优化(调整executor内存、并行度)

- Hive查询优化(分区裁剪、谓词下推)

- 推荐效果优化:

- 冷启动解决方案(新用户推荐高引用文献+领域专家精选)

- 多样性控制(MMR算法,λ=0.7)

- 性能测试:

- 输出:

- 性能测试报告

- 系统优化建议文档

四、技术栈

| 组件 | 技术选型 |

|---|---|

| 存储层 | Hadoop 3.3.4 (HDFS) + Hive 3.1.3 |

| 计算层 | Spark 3.3.0 (PySpark 3.9) |

| NLP处理 | Spark NLP 4.2.0 + Gensim 4.3.0 |

| 服务开发 | FastAPI 0.95.0 + Redis 7.0 |

| 前端展示 | Streamlit 1.22.0 + ECharts 5.4 |

| 调度系统 | Airflow 2.6.0 |

五、时间计划

| 阶段 | 时间 | 里程碑 |

|---|---|---|

| 需求分析 | 第1周 | 完成系统架构设计、数据字典定义 |

| 数据准备 | 第2-3周 | 完成历史数据导入及Hive表建设 |

| 特征工程 | 第4周 | 实现文献语义向量提取和用户画像构建 |

| 算法开发 | 第5-6周 | 完成混合推荐算法原型及离线评估 |

| 系统集成 | 第7周 | 完成API开发及前端界面联调 |

| 测试优化 | 第8周 | 完成压力测试、模型调优及上线准备 |

六、交付成果

- 完整源代码仓库(GitLab管理)

- 系统部署文档(含集群配置参数)

- 测试报告(性能测试+推荐效果评估)

- 用户操作手册(研究者端+管理员端)

七、验收标准

- 性能指标:

- 推荐API平均响应时间 ≤300ms

- Hive查询复杂分析场景 ≤2s

- Spark处理1000万篇文献特征 ≤1小时

- 推荐效果:

- 用户点击率提升 ≥25%

- 文献下载转化率提升 ≥15%

- 用户满意度评分 ≥4.2/5.0

- 系统扩展性:

- 支持横向扩展(增加DataNode/Worker节点)

- 支持多学科领域独立建模

八、风险控制

- 数据版权风险:

- 解决方案:仅存储文献元数据,全文通过知网API授权访问

- 语义理解偏差:

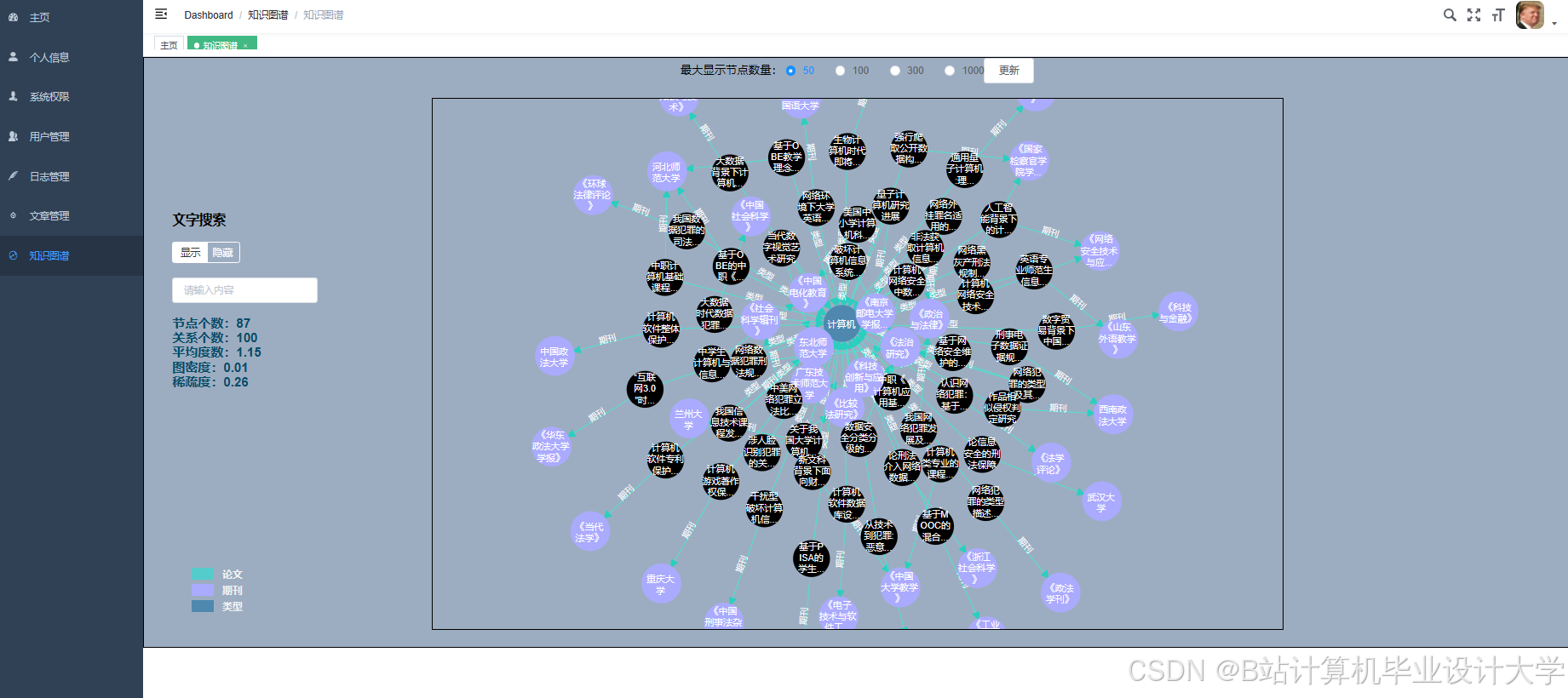

- 解决方案:引入领域知识图谱(如CNKI学科分类体系)增强特征表示

- 模型更新延迟:

- 解决方案:建立增量学习机制,每日更新用户兴趣模型

任务书负责人:XXX

日期:XXXX年XX月XX日

可根据实际需求调整技术方案(如引入Flink实现实时推荐流处理,或使用Neo4j构建文献引用关系图谱增强推荐效果)。

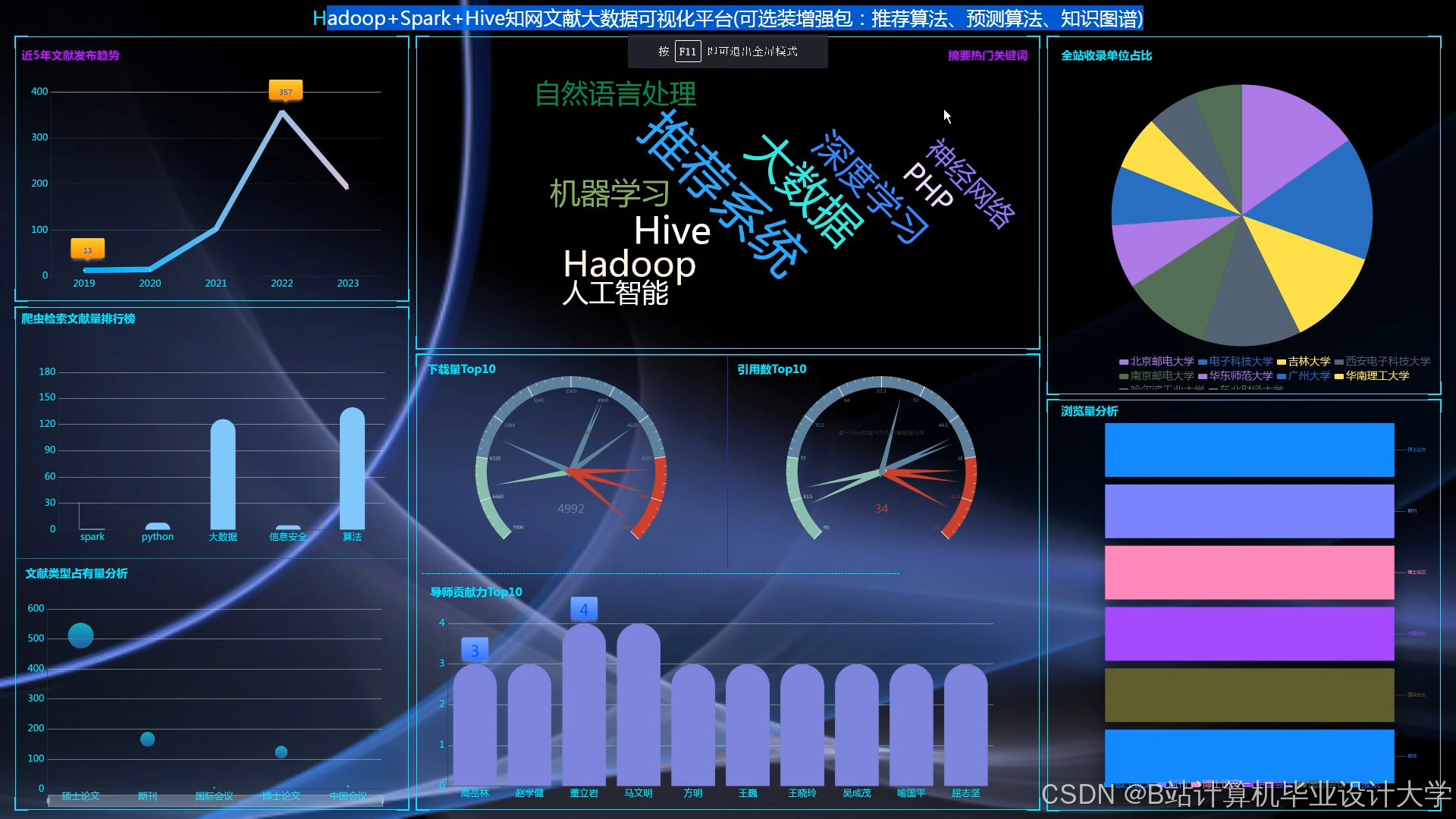

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

721

721

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?