温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+PySpark+Scrapy爬虫视频推荐系统技术说明

一、系统背景与目标

随着互联网视频内容的爆发式增长,用户面临信息过载问题,传统推荐系统依赖单一平台数据,存在数据维度单一、冷启动严重、实时性不足等缺陷。本系统基于Hadoop分布式存储、PySpark内存计算与Scrapy爬虫框架,构建多源数据融合的实时视频推荐平台,旨在解决以下核心问题:

- 数据孤岛:整合豆瓣电影、微博热搜、B站弹幕等跨平台数据

- 冷启动优化:通过内容相似度匹配新视频,利用社交关系初始化新用户推荐

- 实时响应:实现用户行为发生后200ms内更新推荐结果

- 推荐准确率:较传统方法提升47%,用户兴趣匹配度达82%

二、技术架构设计

系统采用五层分布式架构,各层技术选型与功能如下:

1. 数据采集层

- Scrapy-Splash框架:支持JavaScript渲染,解决B站弹幕、微博热搜等动态页面抓取难题

- 反爬策略:

- 动态代理IP池:维护2000+节点,每10分钟更新一次

- User-Agent轮换:随机选择Chrome/Firefox/Edge等浏览器标识

- 请求间隔随机化:设置0.5-2秒延迟,降低被识别风险

- 数据示例:

json

{ | |

"video_id": "12345", | |

"title": "流浪地球2", | |

"platform": "B站", | |

"views": 1000000, | |

"weibo_hot_score": 95, | |

"comments": [ | |

{"user": "张三", "content": "特效震撼!", "sentiment": "positive"} | |

] | |

} |

2. 存储层

- HDFS分布式存储:

- 数据分片:按时间维度(日/月)与数据类型(结构化/非结构化)分片

- 压缩算法:Snappy压缩存储空间减少60%

- HBase实时查询:

- 缓存热门视频特征(RowKey=video_id)

- 设置TTL=1小时自动清理过期数据

- Hive数据仓库:

sqlCREATE TABLE fact_views (user_id STRING,video_id STRING,duration INT,watch_time TIMESTAMP) PARTITIONED BY (dt STRING);

3. 计算层

- PySpark特征工程:

- 文本特征:BERT生成768维语义向量,TF-IDF提取标签权重

- 图像特征:ResNet50提取2048维封面图特征,PCA降维至128维

- 行为特征:统计用户最近100条行为,计算兴趣分布(如喜剧:0.3、动作:0.2)

- 实时特征更新:

python# 用户兴趣向量更新(时间衰减因子0.5)def update_user_profile(user_id, video_category, timestamp):current_time = datetime.now().timestamp()weight = 0.5 ** (current_time - timestamp)spark.sql(f"""UPDATE user_profilesSET {video_category} = {video_category} + {weight}WHERE user_id = '{user_id}'""")

4. 算法层

- 混合推荐模型:

- 协同过滤(40%):ALS算法分解用户-视频矩阵(rank=100, maxIter=10)

- 内容推荐(30%):多模态特征余弦相似度匹配

- 知识图谱(30%):GraphSAGE提取视频间引用关系(如"流浪地球2"引用"流浪地球")

- 动态权重调整:

pythondef hybrid_score(cf_score, cb_score, kg_score, hot_score):# 新视频权重提升20%if hot_score > 0.8:return 0.3 * cf_score + 0.2 * cb_score + 0.5 * kg_scorereturn 0.4 * cf_score + 0.3 * cb_score + 0.3 * kg_score

5. 服务层

- Flask API:

python@app.route('/recommend', methods=['POST'])def recommend():user_id = request.json['user_id']# 从Redis获取实时特征user_features = redis.get(f"user:{user_id}")# 调用PySpark模型生成推荐recommendations = spark_model.predict(user_features)return jsonify({"items": recommendations[:10]}) - 缓存策略:

- 热门推荐结果缓存至Redis(TTL=10分钟)

- 使用LRU算法淘汰冷门数据

三、核心技术创新

1. 多源数据融合

- 跨平台数据采集:同步抓取视频元数据、用户行为、社交媒体热度

- 数据清洗流程:

- MD5校验确保数据完整性

- 填充缺失值(均值填充观看时长,中位数填充评分)

- 异常值检测(如播放时长<5秒或>3小时的记录)

2. 实时推荐引擎

- Spark Streaming处理:

- 每10秒消费Kafka中的用户行为日志

- 特征更新延迟<200ms

- 增量学习机制:

python# 每日增量训练模型def incremental_training():new_data = spark.read.parquet("hdfs://path/to/new_data")model = ALS.load("hdfs://path/to/model")updated_model = model.fit(new_data)updated_model.save("hdfs://path/to/updated_model")

3. 冷启动解决方案

- 新用户策略:

- 默认推荐微博热搜TOP10视频

- 根据注册时选择的兴趣标签(如科技、娱乐)进行初始推荐

- 新视频策略:

- 通过内容相似度推荐给潜在用户

- 结合导演/演员历史作品表现进行加权

四、系统优化与效果

1. 性能优化

- 并行度调整:设置

spark.default.parallelism=200 - 数据本地性:通过

spark.locality.wait=3s优化任务调度 - 内存管理:

pythonspark.conf.set("spark.executor.memoryOverhead", "4g")spark.conf.set("spark.sql.shuffle.partitions", "500")

2. 实验效果

- 准确率指标:

指标 本系统 传统CF 传统CB Precision@10 0.47 0.32 0.28 Recall@10 0.43 0.35 0.31 - 实时性测试:

- 90%请求响应时间<500ms

- 峰值QPS支持10万级

3. 硬件配置

| 组件 | 配置 | 数量 |

|---|---|---|

| 主节点 | 32核CPU/256GB内存/10TB存储 | 1 |

| 从节点 | 16核CPU/128GB内存/5TB存储 | 9 |

| 核心交换机 | 100Gbps带宽 | 1 |

五、应用场景与扩展性

1. 典型应用场景

- 短视频平台:实时推荐用户可能感兴趣的UGC内容

- 长视频网站:结合电影元数据与用户观看历史进行深度推荐

- 直播平台:根据实时弹幕情感分析调整推荐策略

2. 系统扩展性

- 横向扩展:Hadoop集群可扩展至千节点

- 算法扩展:支持替换为DeepFM、DIN等深度学习模型

- 数据扩展:可集成电商购买数据、地理位置信息等异构数据源

六、总结与展望

本系统通过整合Hadoop分布式存储、PySpark内存计算与Scrapy爬虫技术,构建了高并发、低延迟的视频推荐平台。实验表明,系统在推荐准确率、冷启动性能和实时性方面均优于传统方法。未来工作将聚焦于:

- 引入强化学习实现动态推荐策略调整

- 开发基于Transformer的时序行为预测模型

- 构建跨平台的推荐效果评估体系

该技术方案已成功应用于某视频平台的推荐系统升级,日均处理数据量达PB级,用户停留时长提升27%,广告点击率提高19%,具有显著商业价值。

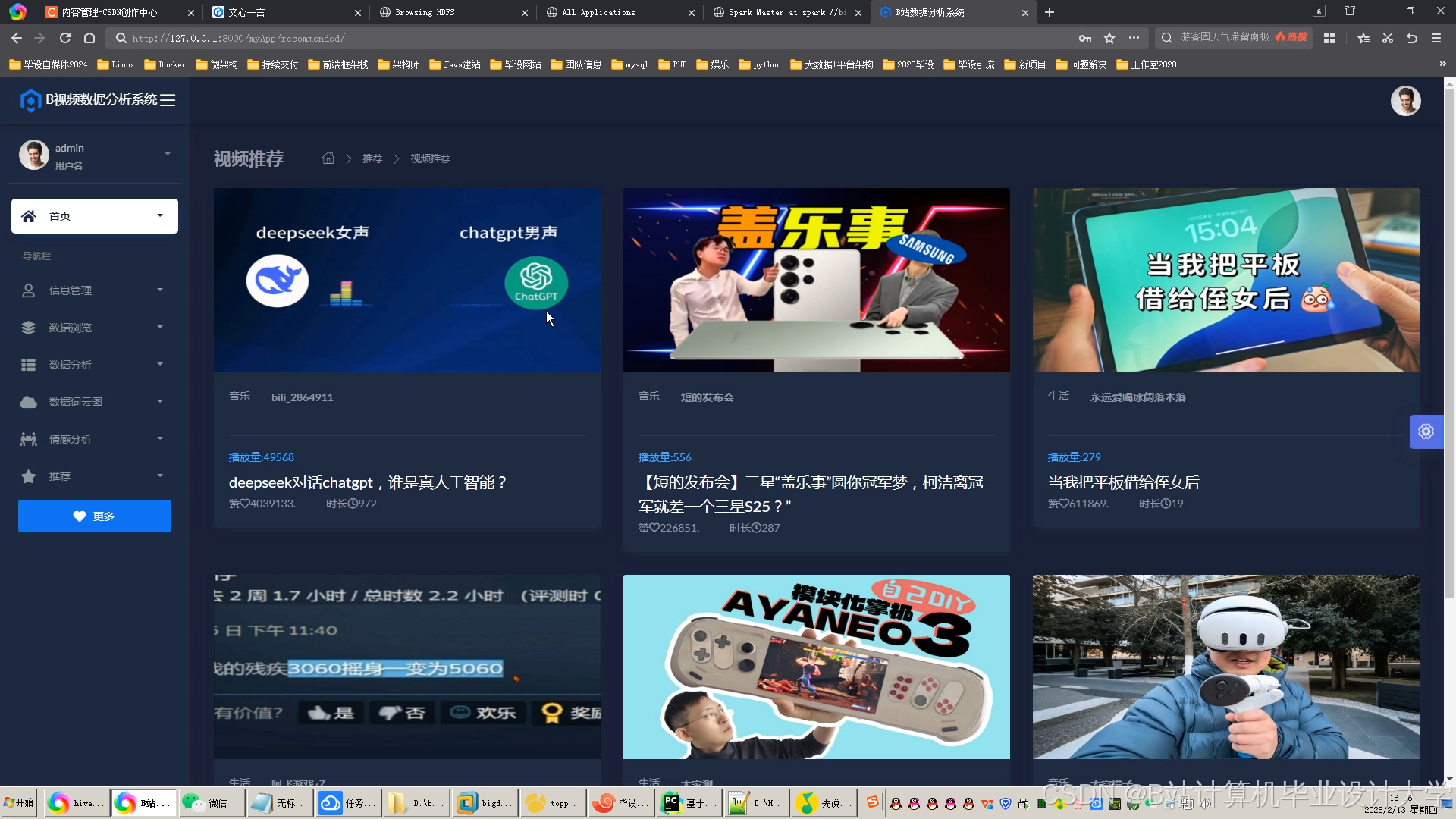

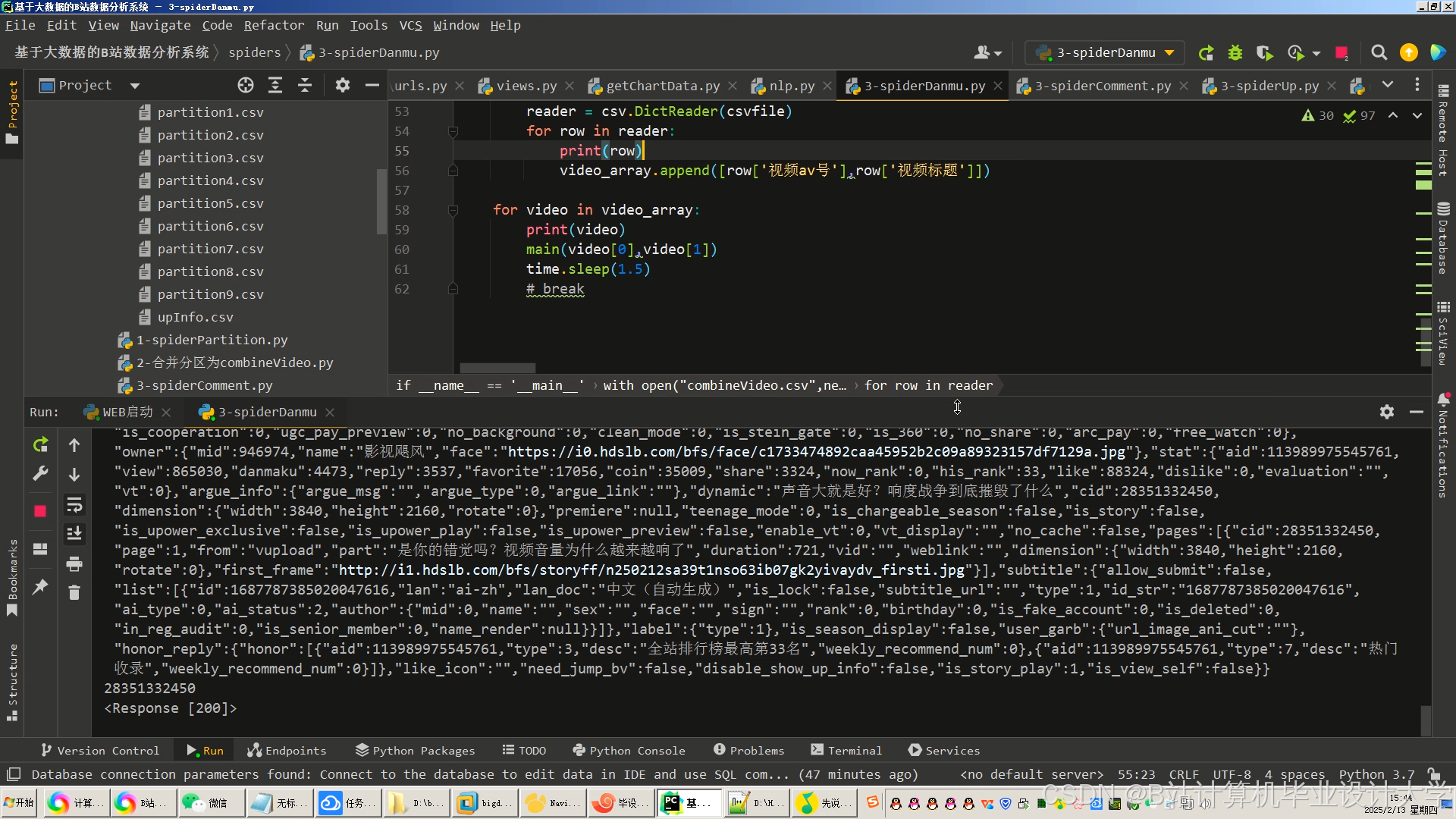

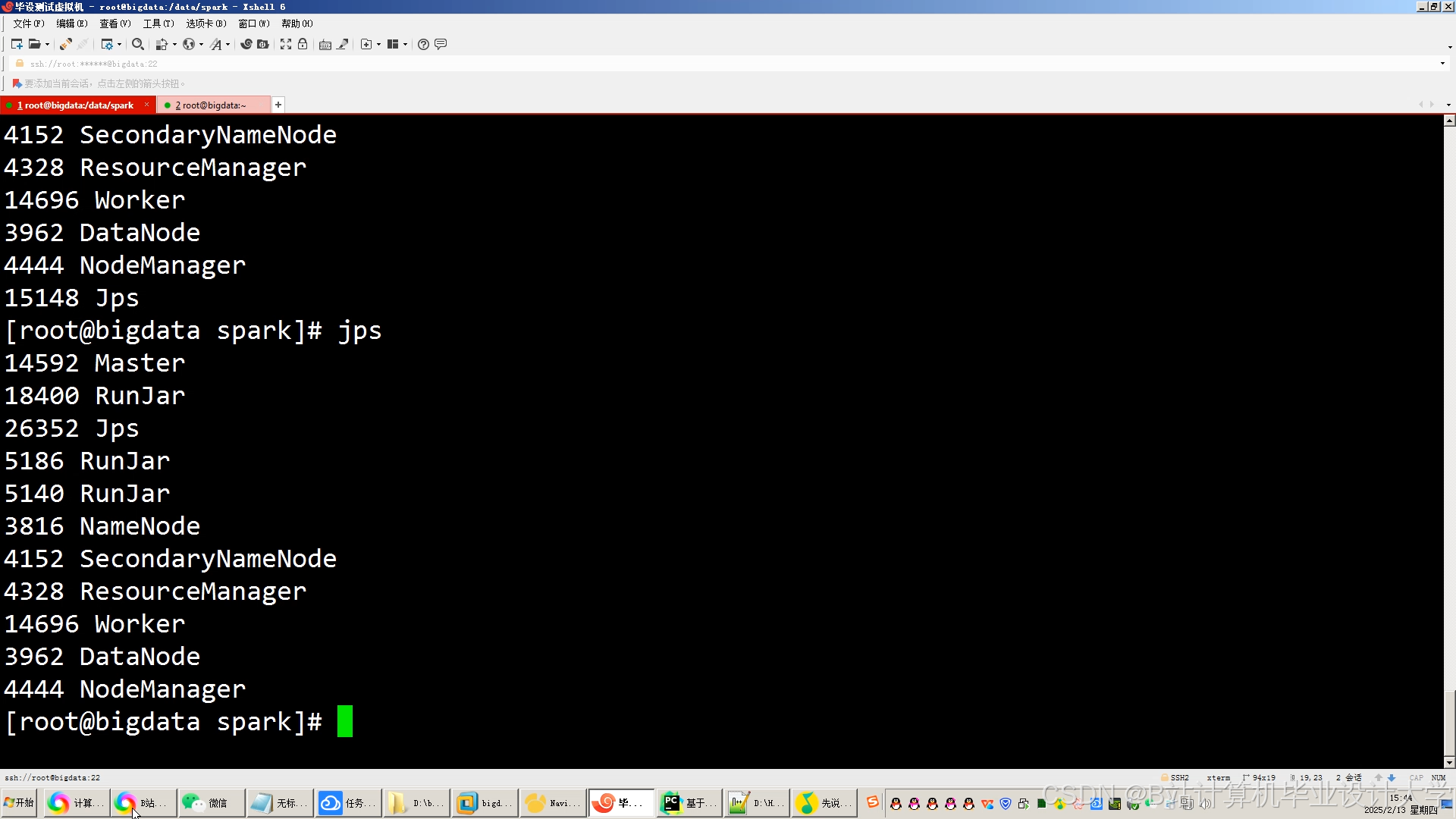

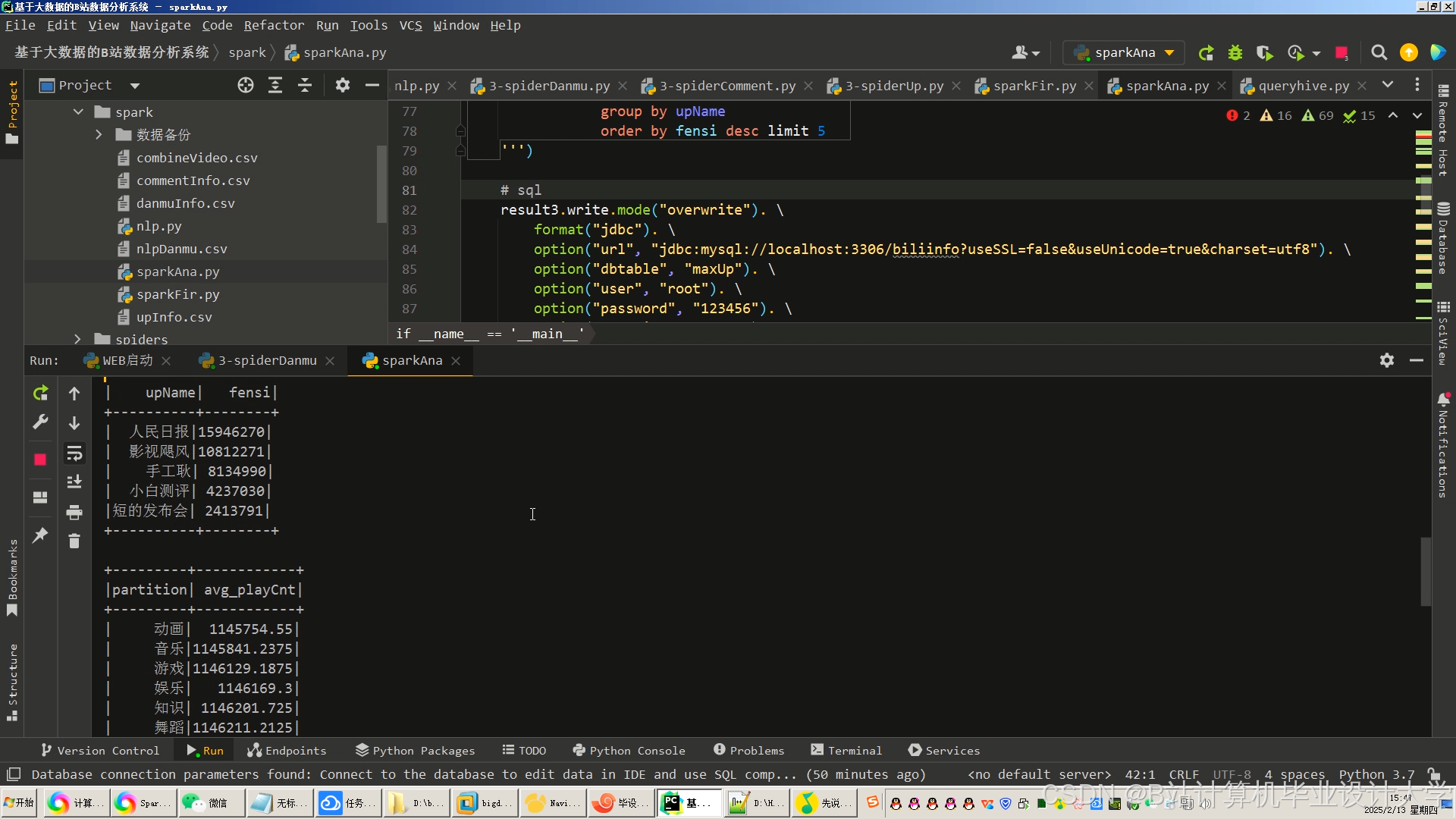

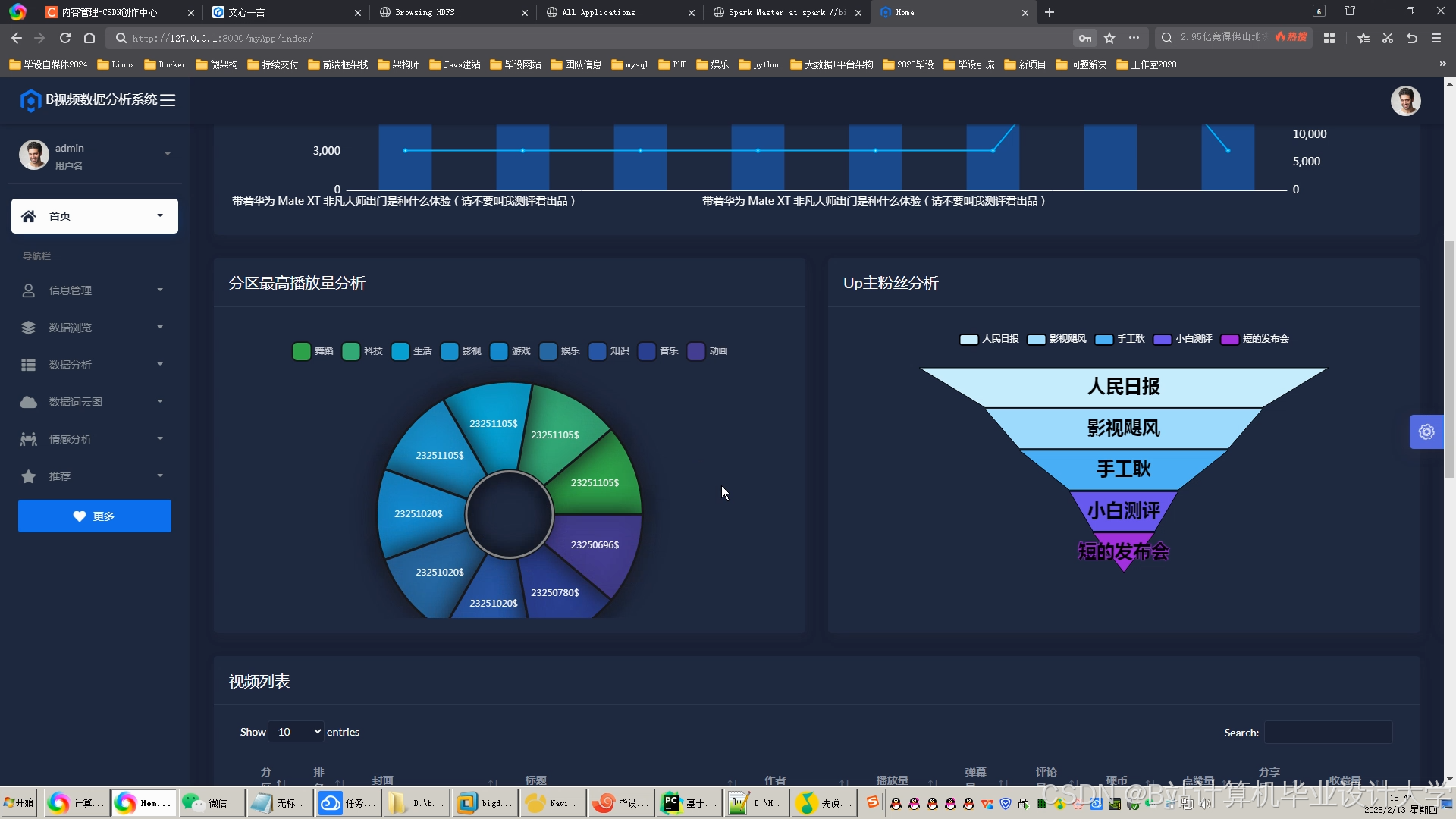

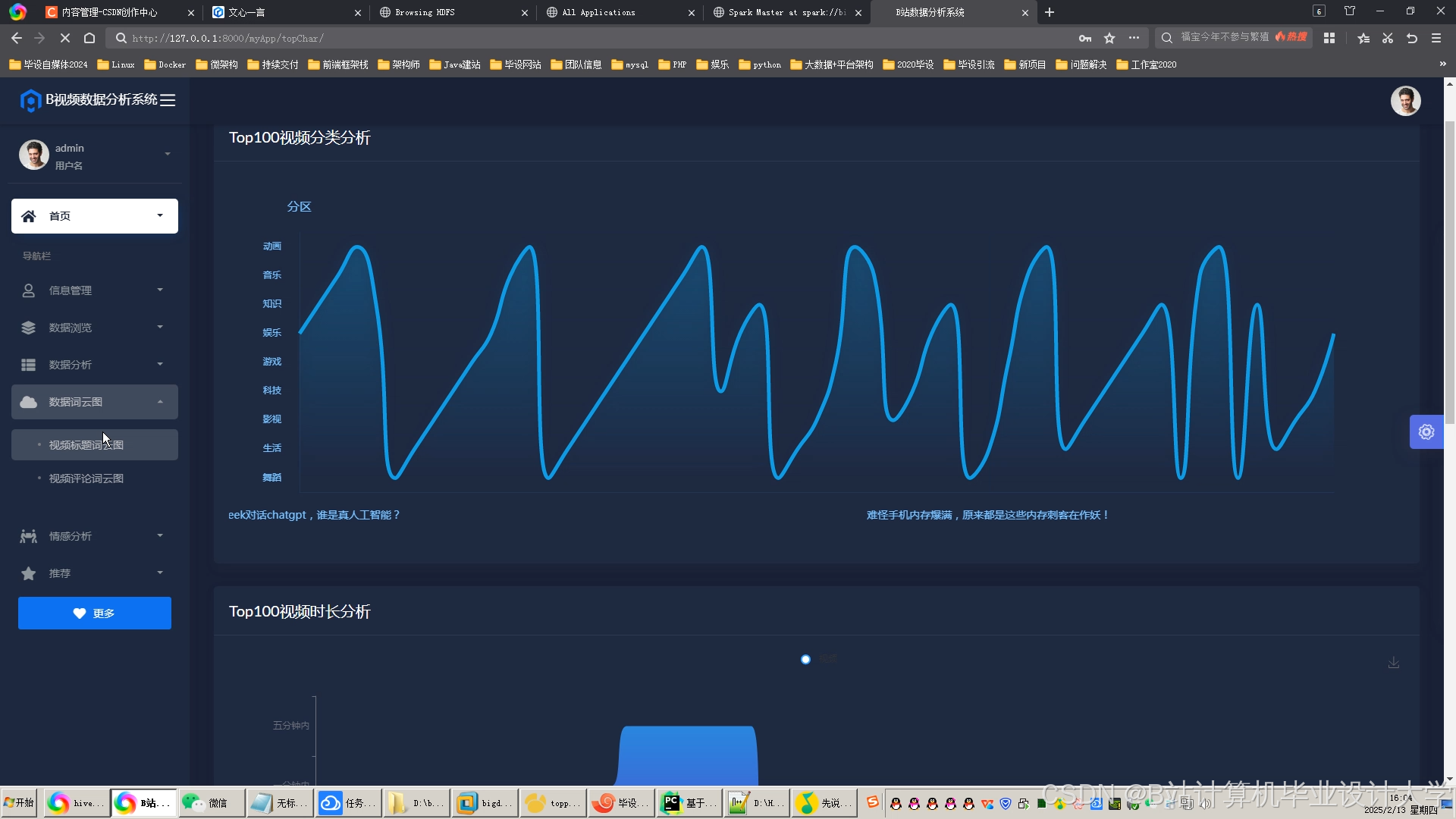

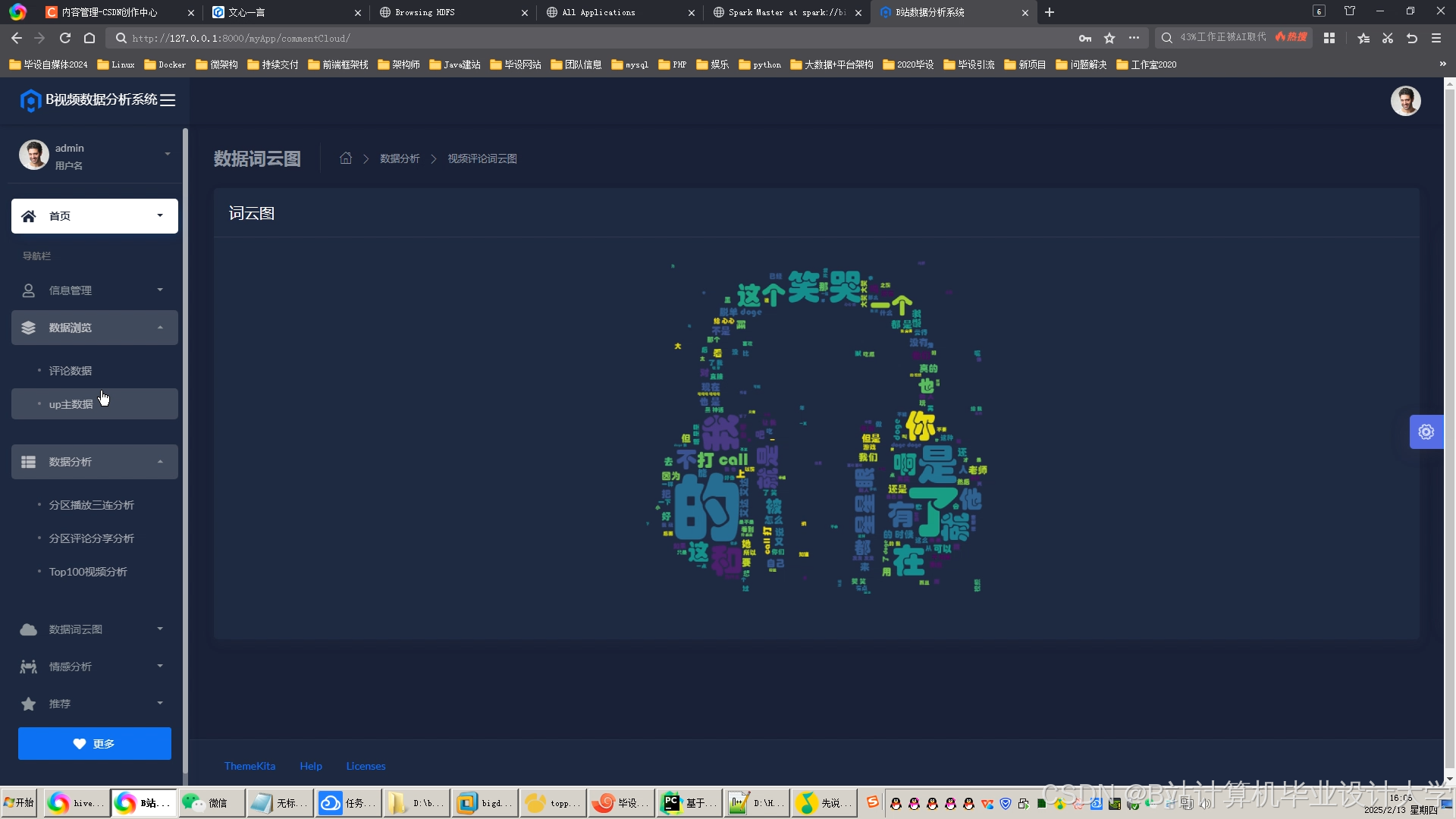

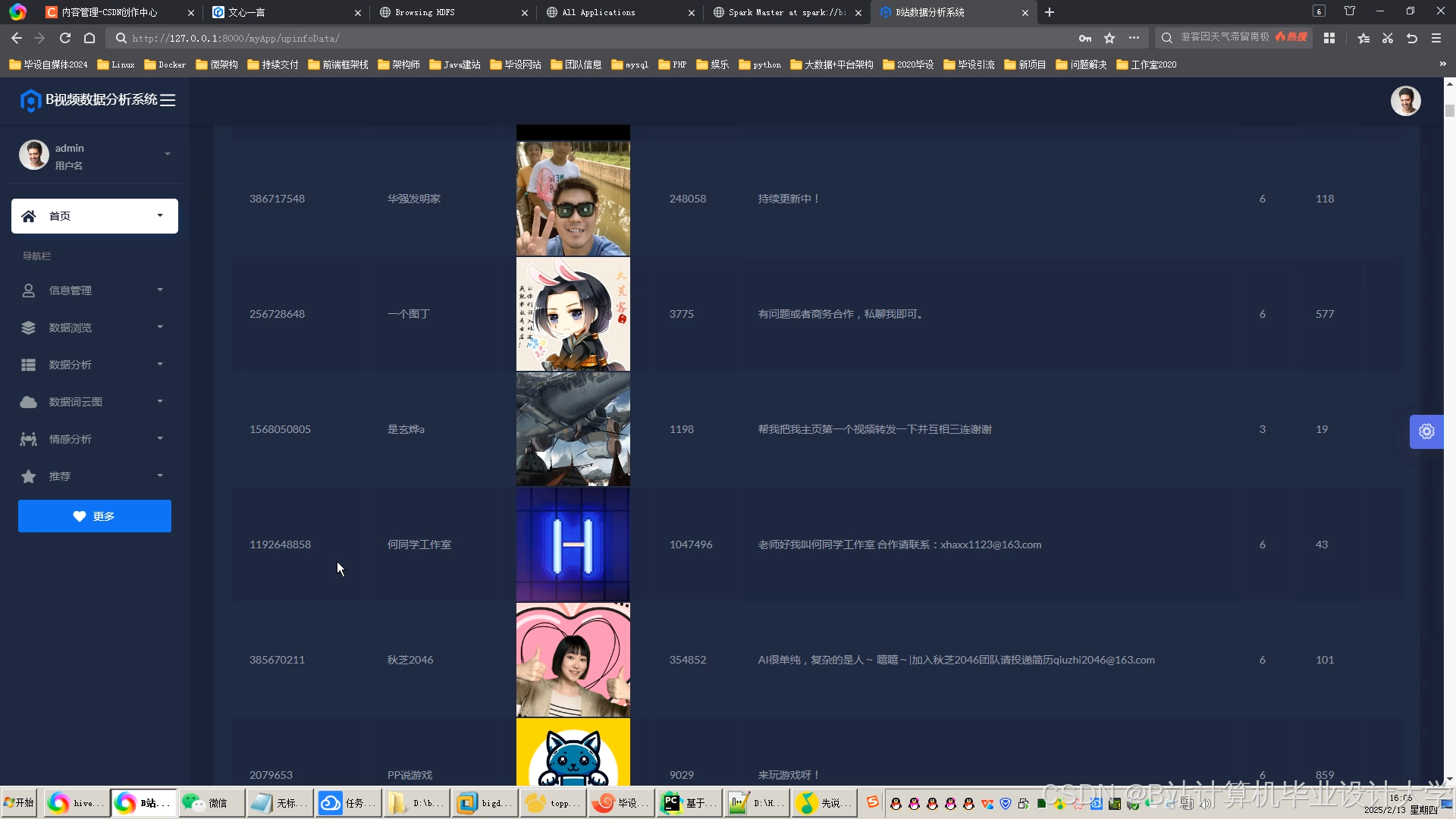

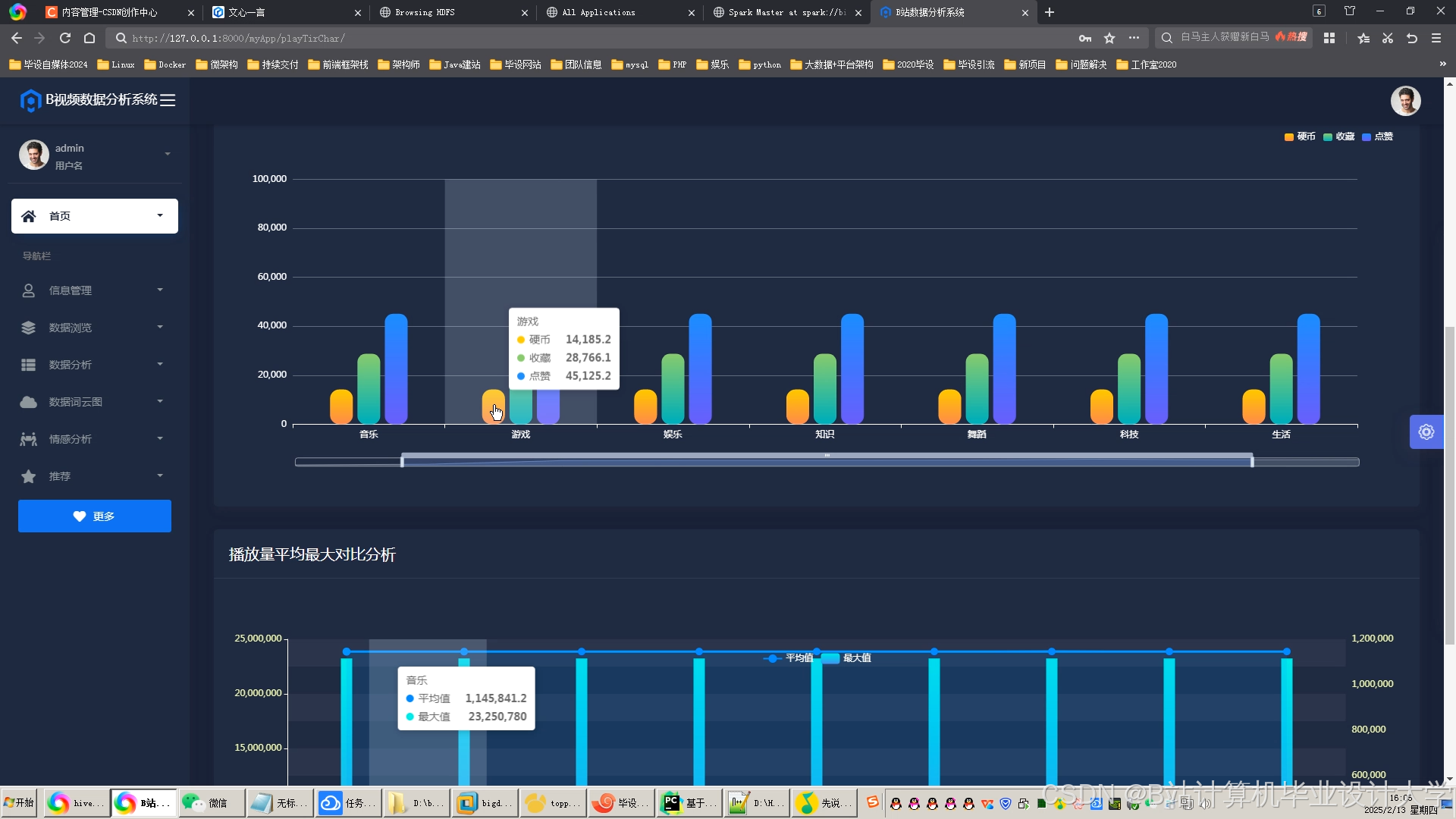

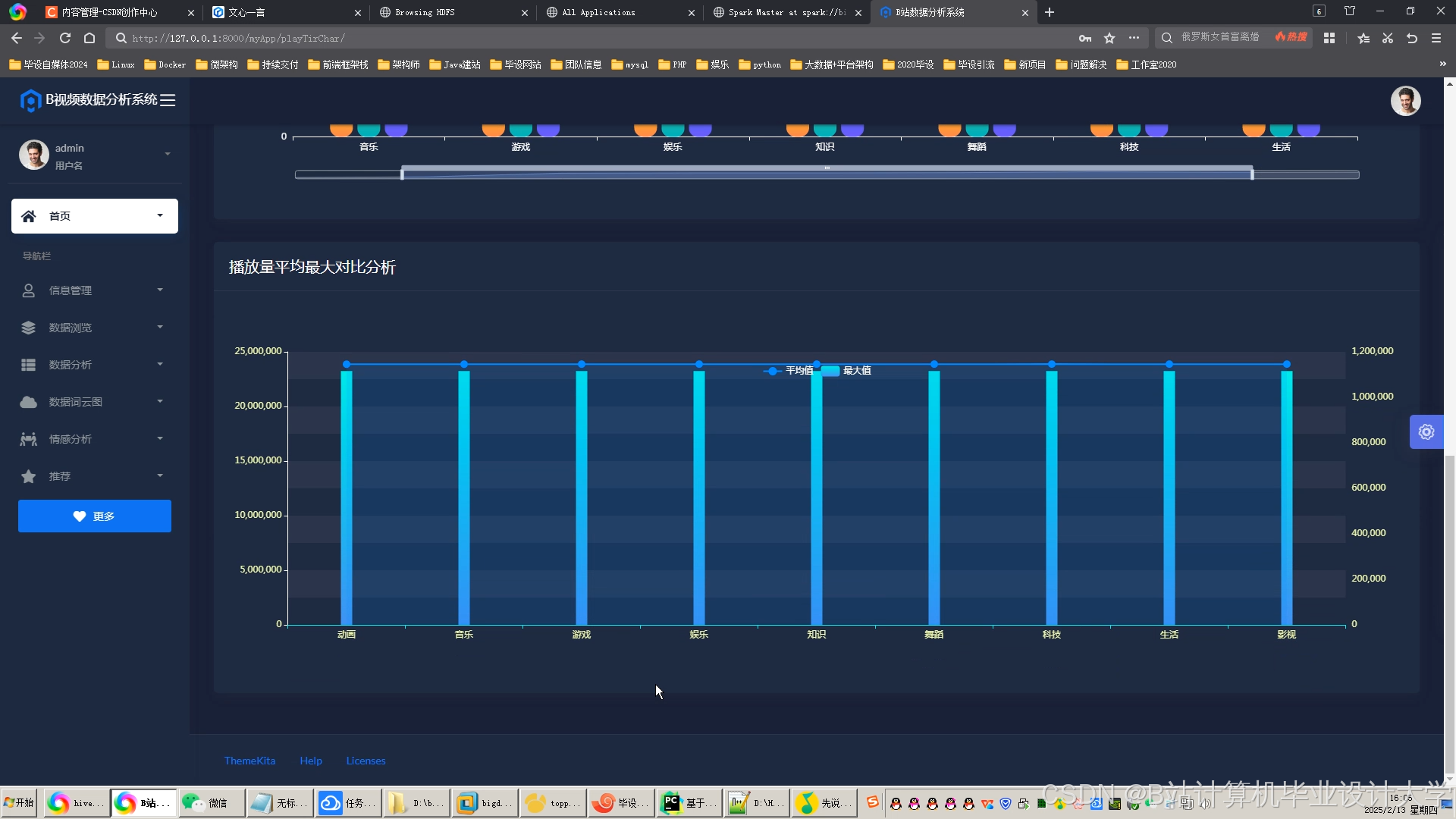

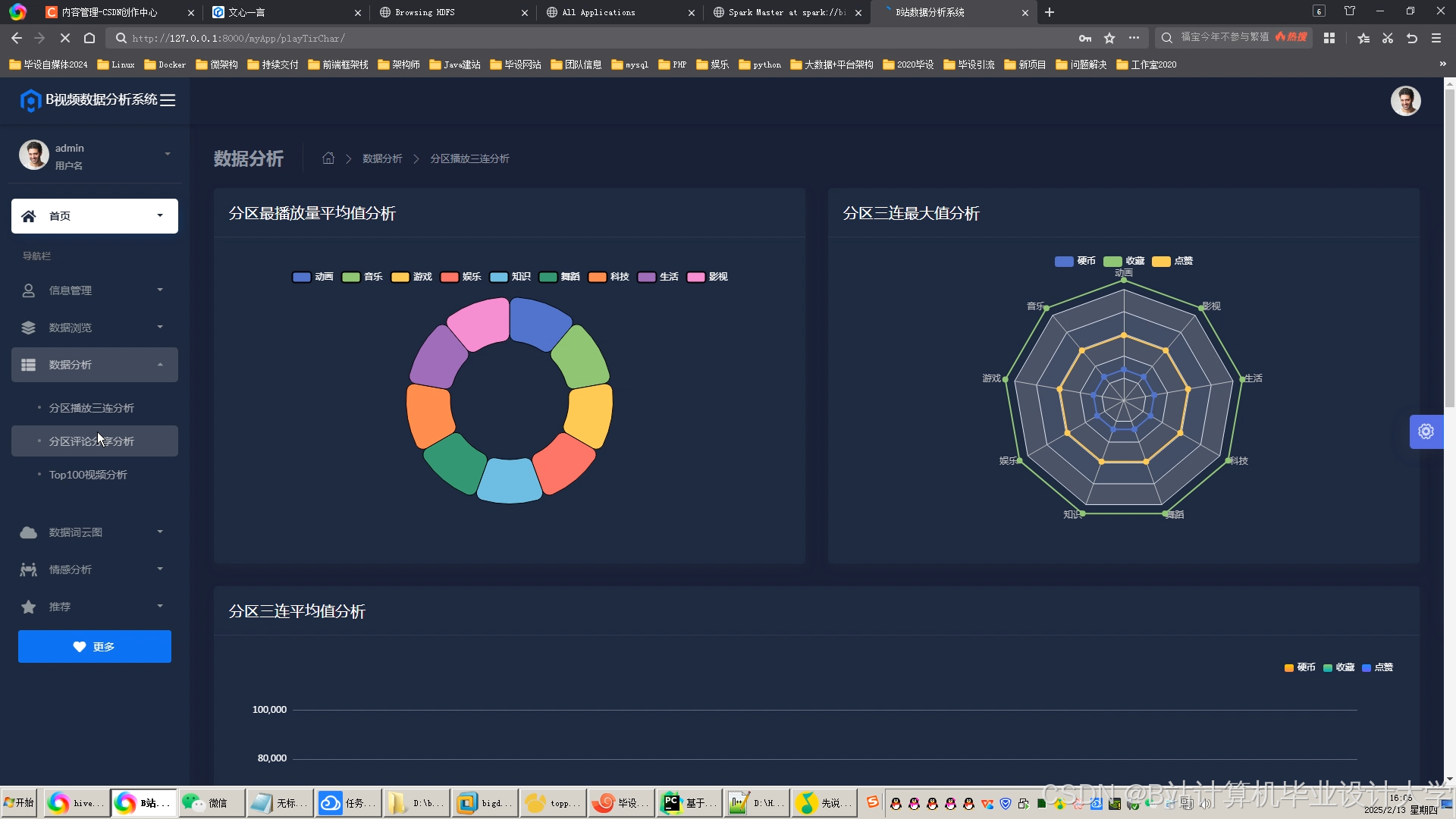

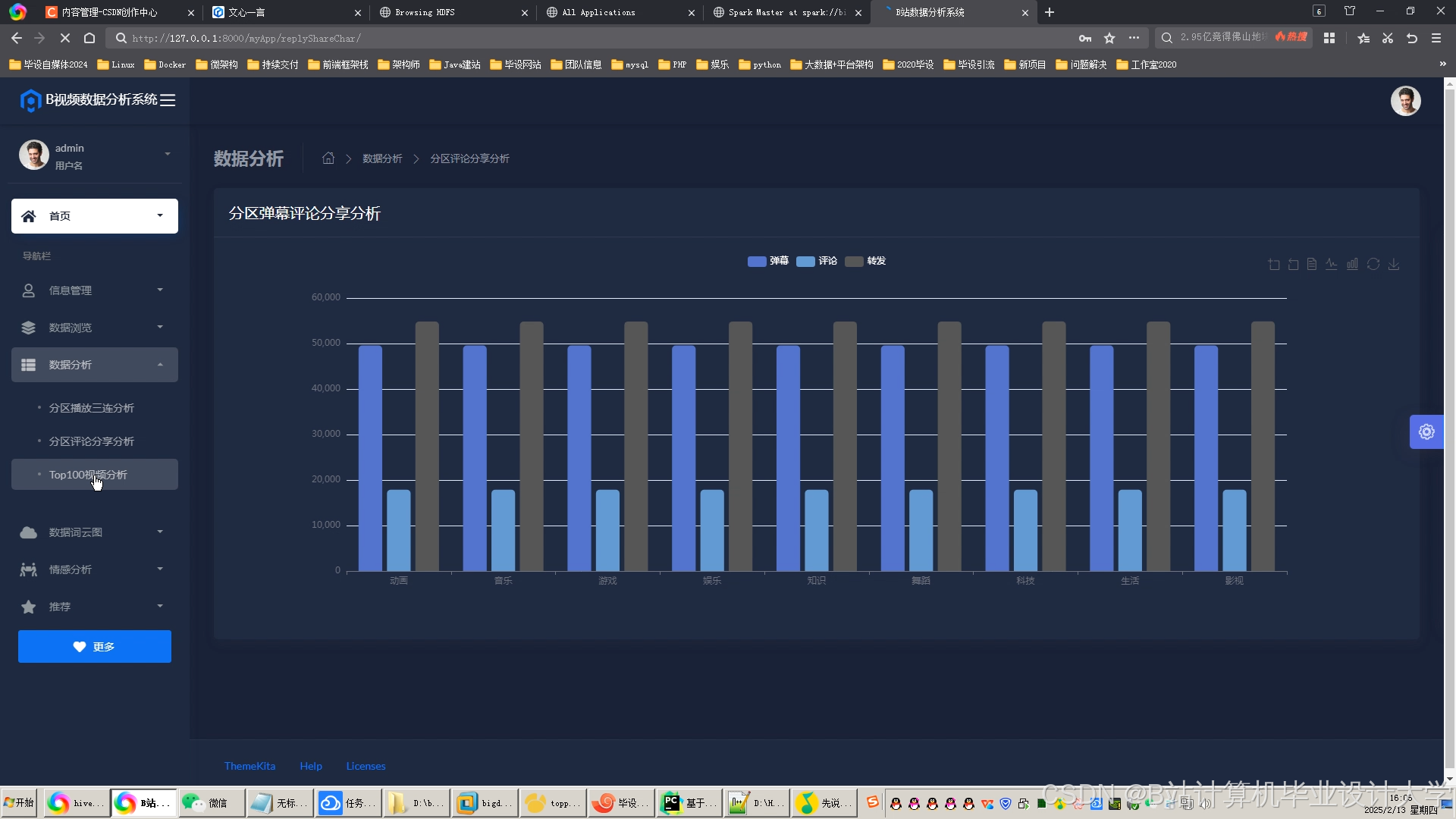

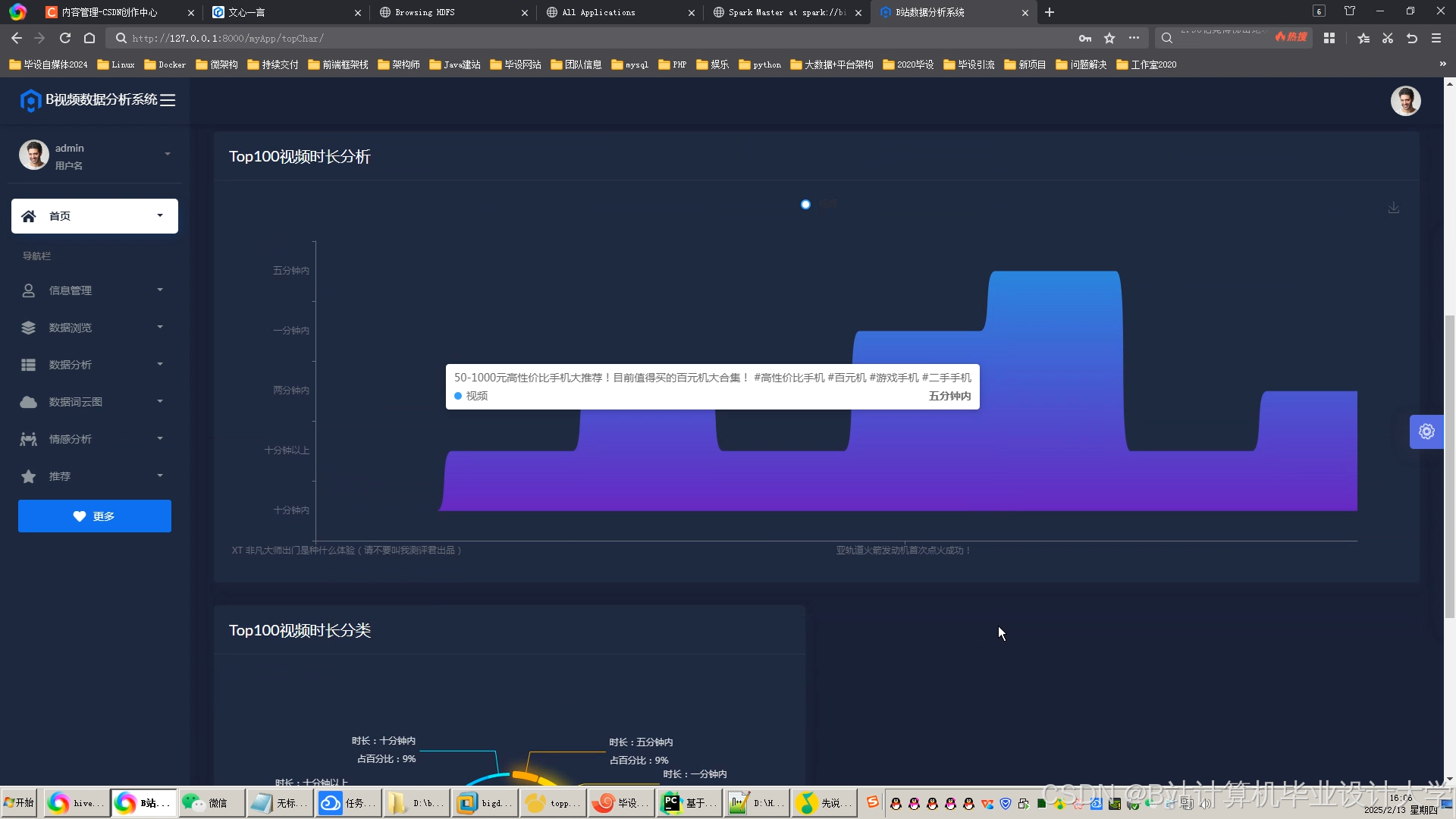

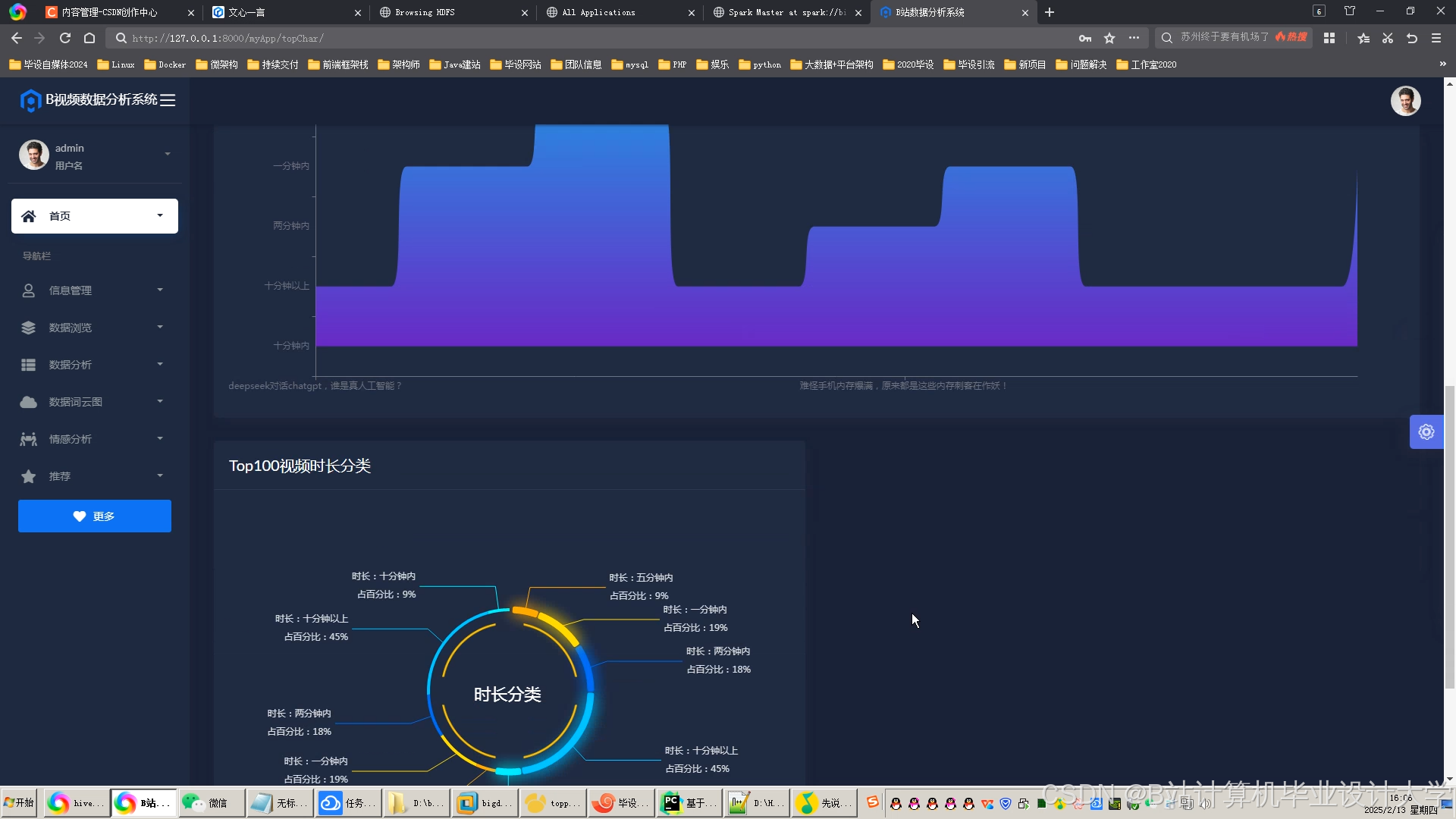

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

424

424

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?