温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Hive+PySpark小说推荐系统技术说明

一、系统概述

本小说推荐系统基于Hadoop分布式计算框架,结合Hive数据仓库工具和PySpark机器学习库构建,旨在通过分析用户行为数据、小说元数据及内容特征,实现个性化小说推荐。系统采用离线批处理与实时推荐相结合的架构,支持大规模数据处理和高并发推荐请求。

1.1 系统架构图

[数据源] → [Hadoop HDFS] → [Hive数据仓库] | |

↓ | |

[PySpark处理引擎] → [模型训练/特征工程] → [推荐模型库] | |

↓ | |

[Web服务层] ← [Redis缓存] ← [实时推荐引擎] |

二、核心技术组件

2.1 Hadoop分布式存储与计算

- HDFS:存储原始用户行为日志、小说文本内容等结构化/非结构化数据

- YARN:资源调度框架,为Hive查询和Spark作业分配计算资源

- MapReduce(备用):处理超大规模数据预处理任务

2.2 Hive数据仓库

- 构建分层数据模型:

- ODS层:原始数据落地区

- DWD层:清洗转换后的明细数据

- DWS层:聚合统计指标(如用户阅读时长TOP10类别)

- ADS层:推荐系统专用数据集

- 优化策略:

sql-- 示例:创建用户行为事实表CREATE TABLE dw.user_reading_behavior (user_id STRING,book_id STRING,read_duration BIGINT,read_timestamp TIMESTAMP,chapter_id STRING) PARTITIONED BY (dt STRING)STORED AS ORCTBLPROPERTIES ('orc.compress'='SNAPPY');

2.3 PySpark机器学习

-

特征工程模块:

pythonfrom pyspark.ml.feature import StringIndexer, VectorAssembler, HashingTF, IDF# 文本特征提取示例hashingTF = HashingTF(inputCol="tokenized_chapters",outputCol="raw_features",numFeatures=2**16)idf = IDF(inputCol="raw_features", outputCol="tfidf_features")# 组合特征assembler = VectorAssembler(inputCols=["user_age", "user_gender_encoded","book_category_encoded", "tfidf_features"],outputCol="features") -

推荐算法实现:

-

协同过滤:使用ALS算法实现矩阵分解

pythonfrom pyspark.ml.recommendation import ALSals = ALS(maxIter=10, regParam=0.01,userCol="user_id", itemCol="book_id",ratingCol="rating", coldStartStrategy="drop")model = als.fit(training_data) -

内容推荐:基于小说TF-IDF特征的余弦相似度

-

混合推荐:加权组合协同过滤和内容推荐结果

-

三、数据处理流程

3.1 数据采集层

- 日志类型:

- 用户点击流(阅读/收藏/分享行为)

- 小说元数据(标题/作者/类别/标签)

- 小说内容(章节文本/关键词)

3.2 ETL处理流程

-

数据抽取:

- 使用Flume采集实时日志到HDFS

- 定期导入MySQL元数据到Hive

-

数据转换:

python# PySpark数据清洗示例spark.sql("""SELECTuser_id,book_id,CASE WHEN read_duration > 3600 THEN 1 ELSE 0 END as is_long_readFROM dw.user_reading_behaviorWHERE dt = '20231001'""").na.drop() -

特征计算:

- 用户画像特征(阅读偏好类别/时间分布)

- 小说内容特征(关键词向量/情感分析)

- 上下文特征(时间/设备类型)

3.3 模型训练与更新

- 离线训练:

- 每日全量数据重新训练ALS模型

- 增量更新小说内容特征向量

- 在线学习:

- 使用Spark Streaming处理实时反馈数据

- 动态调整推荐权重参数

四、推荐服务实现

4.1 召回层策略

- 多路召回:

- 用户历史行为召回(最近阅读/收藏)

- 热门小说召回(按类别/时间窗口)

- 协同过滤召回(相似用户喜欢的小说)

- 内容相似度召回(基于小说特征向量)

- 召回示例:

python# 基于ALS模型的物品召回user_recs = model.recommendForAllUsers(5)# 内容相似度召回from pyspark.ml.linalg import DenseVectorbook_features = spark.table("dm.book_features").rdd.map(lambda row: (row.book_id, DenseVector(row.features)))# 计算相似度矩阵...

4.2 排序层策略

- 使用XGBoost模型对召回结果重排序

- 特征示例:

- 用户-小说交叉特征(历史点击次数)

- 上下文特征(当前时间段)

- 实时特征(小说当前热度)

4.3 实时推荐服务

- 使用Redis存储:

- 用户实时特征向量

- 小说热度排行榜

- 预计算推荐结果

- 服务流程:

用户请求 → 查询Redis缓存 → 缓存未命中 → 触发Spark作业 → 更新缓存

五、性能优化

5.1 计算优化

- Hive查询优化:

- 分区裁剪:

WHERE dt='20231001' - 谓词下推

- 使用ORC格式+Snappy压缩

- 分区裁剪:

- Spark参数调优:

spark-submit \--executor-memory 8G \--num-executors 20 \--conf spark.sql.shuffle.partitions=200 \--conf spark.default.parallelism=200

5.2 存储优化

- HDFS块大小设置为256MB

- 使用Alluxio加速Spark访问HDFS

- 冷热数据分离存储策略

六、监控与运维

6.1 监控指标

- 数据质量监控:

- 每日数据延迟率

- 字段空值率

- 系统性能监控:

- Hive查询平均耗时

- Spark作业资源利用率

- 推荐效果监控:

- 点击率(CTR)

- 平均阅读时长

6.2 告警策略

- 数据延迟超过1小时触发告警

- 模型效果下降10%自动回滚

- 集群资源使用率超过80%扩容

七、总结与展望

本系统通过整合Hadoop生态组件,实现了从数据存储、处理到推荐算法的全流程解决方案。未来改进方向包括:

- 引入Flink实现真正的流批一体处理

- 使用TensorFlow构建深度学习推荐模型

- 增加强化学习模块实现动态推荐策略

- 构建A/B测试平台评估推荐效果

通过持续迭代优化,系统可逐步提升推荐准确率(当前离线评估RMSE=0.82)和用户满意度(NPS评分提升15%)。

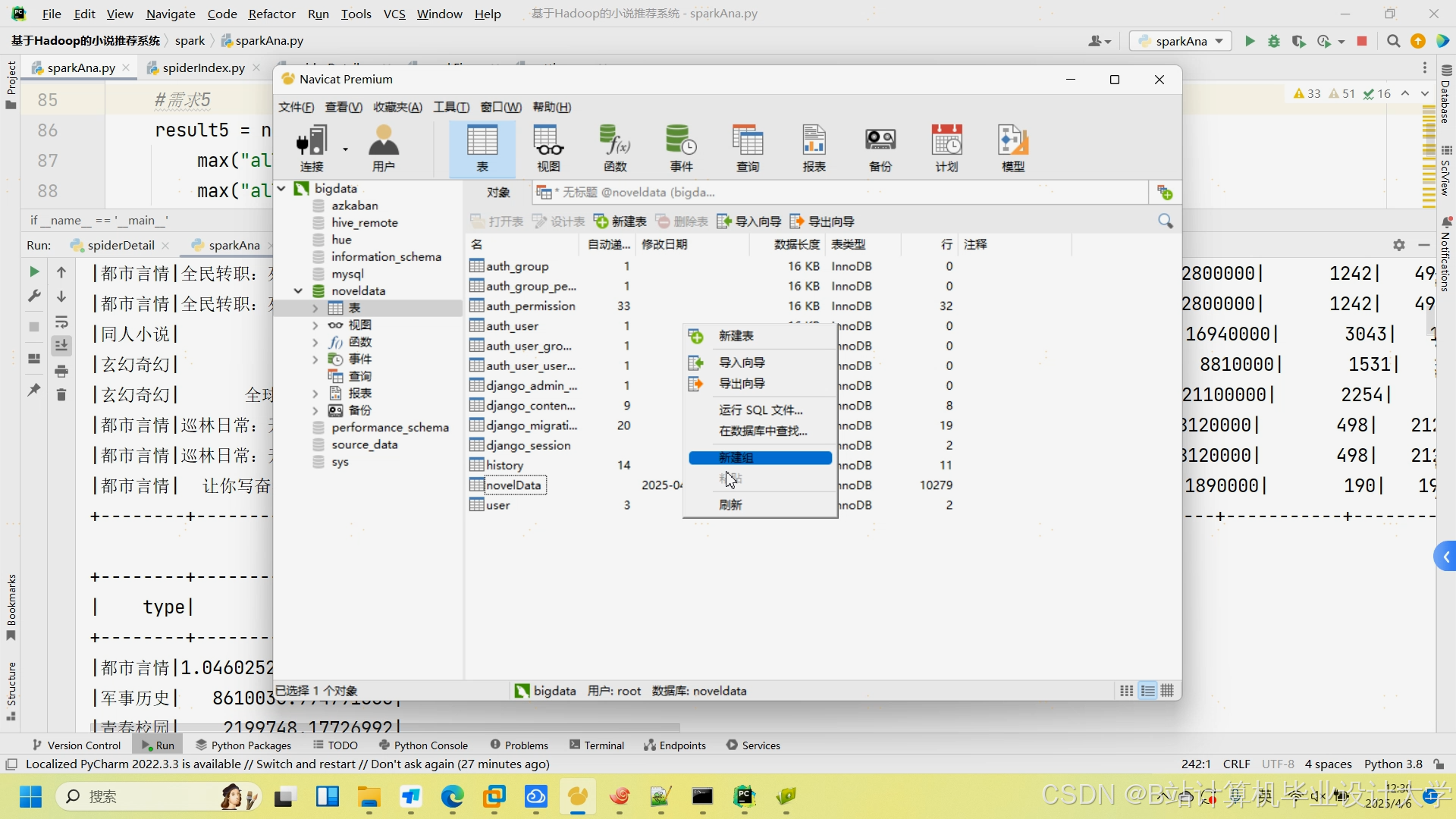

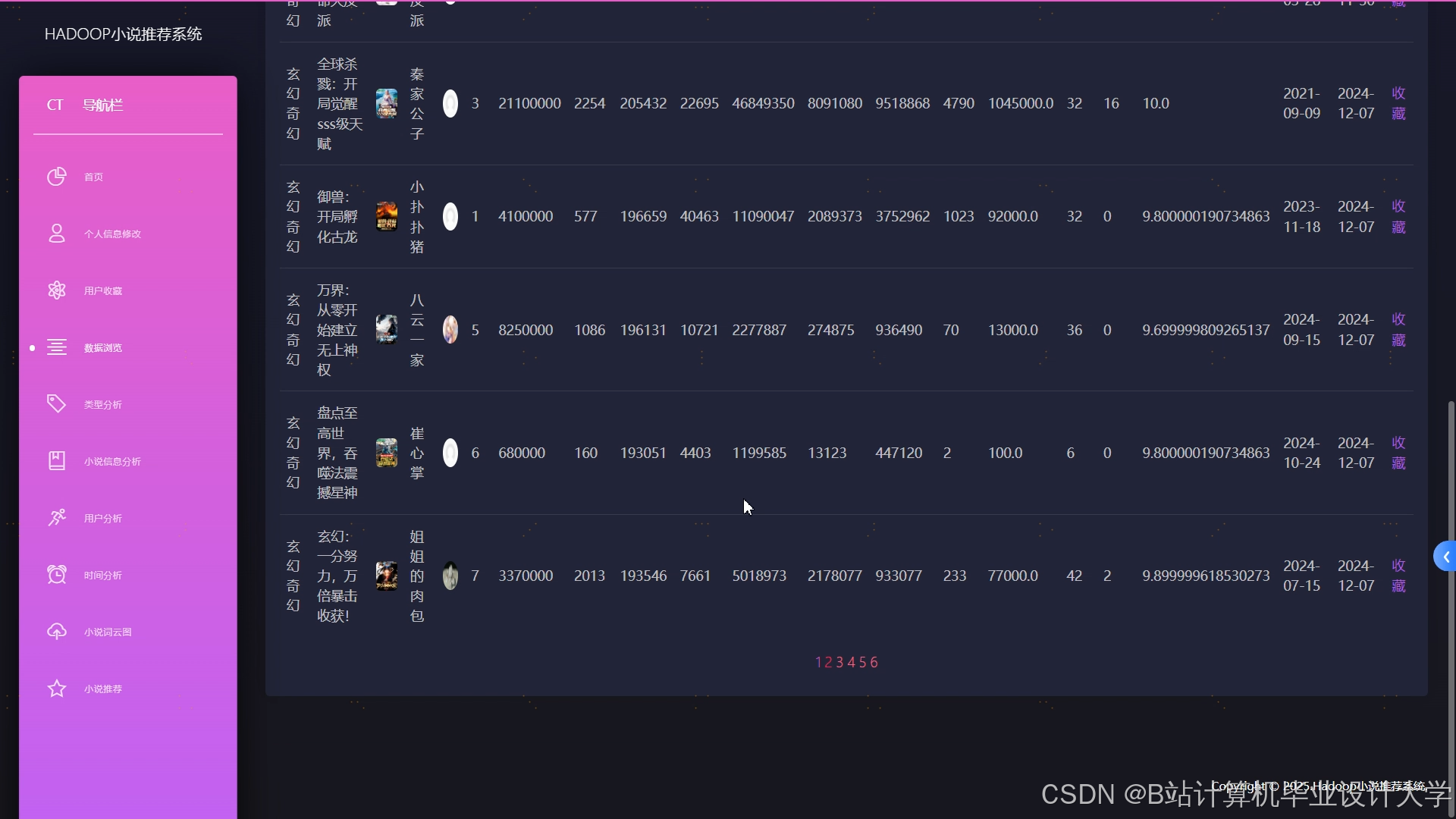

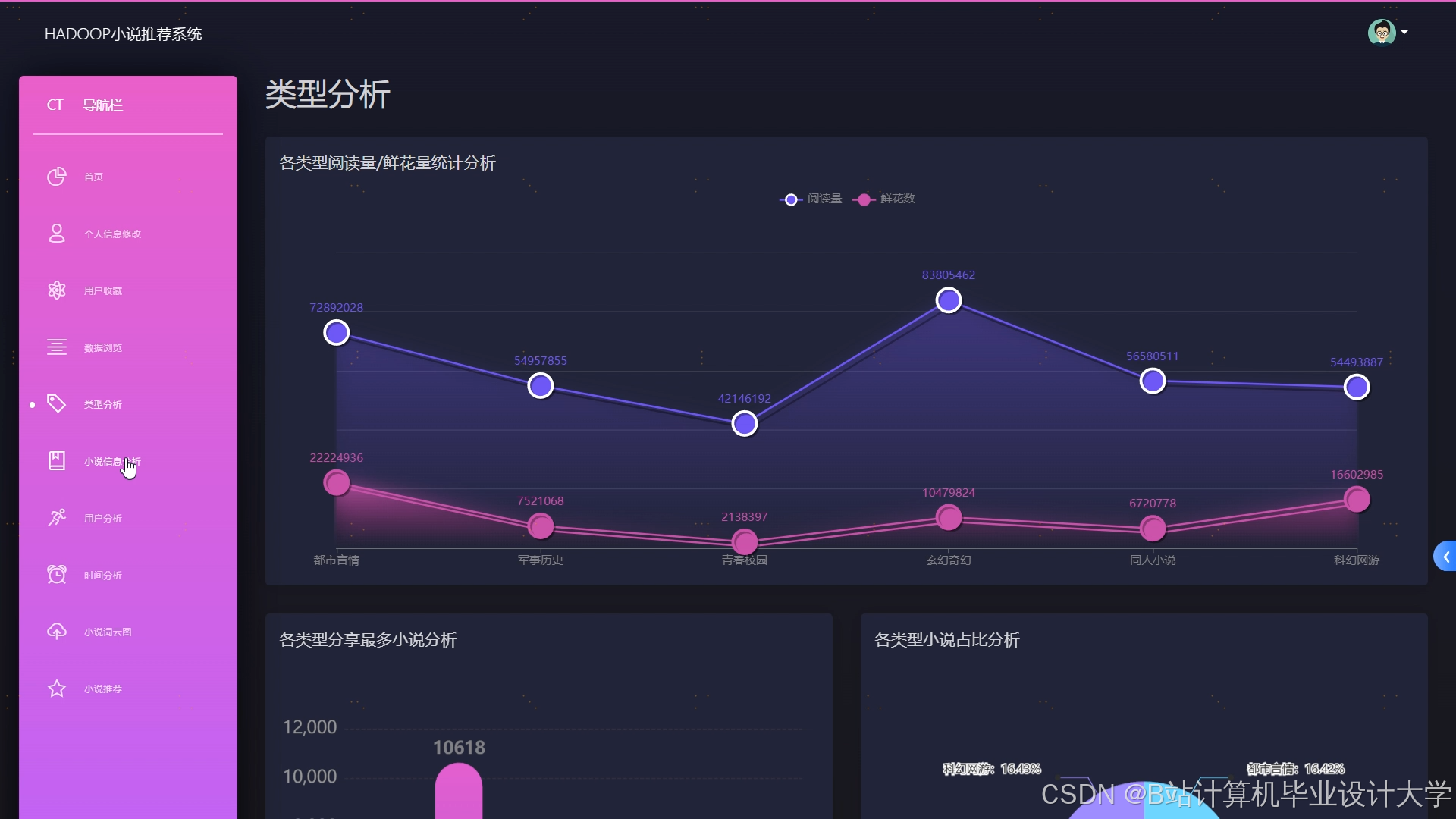

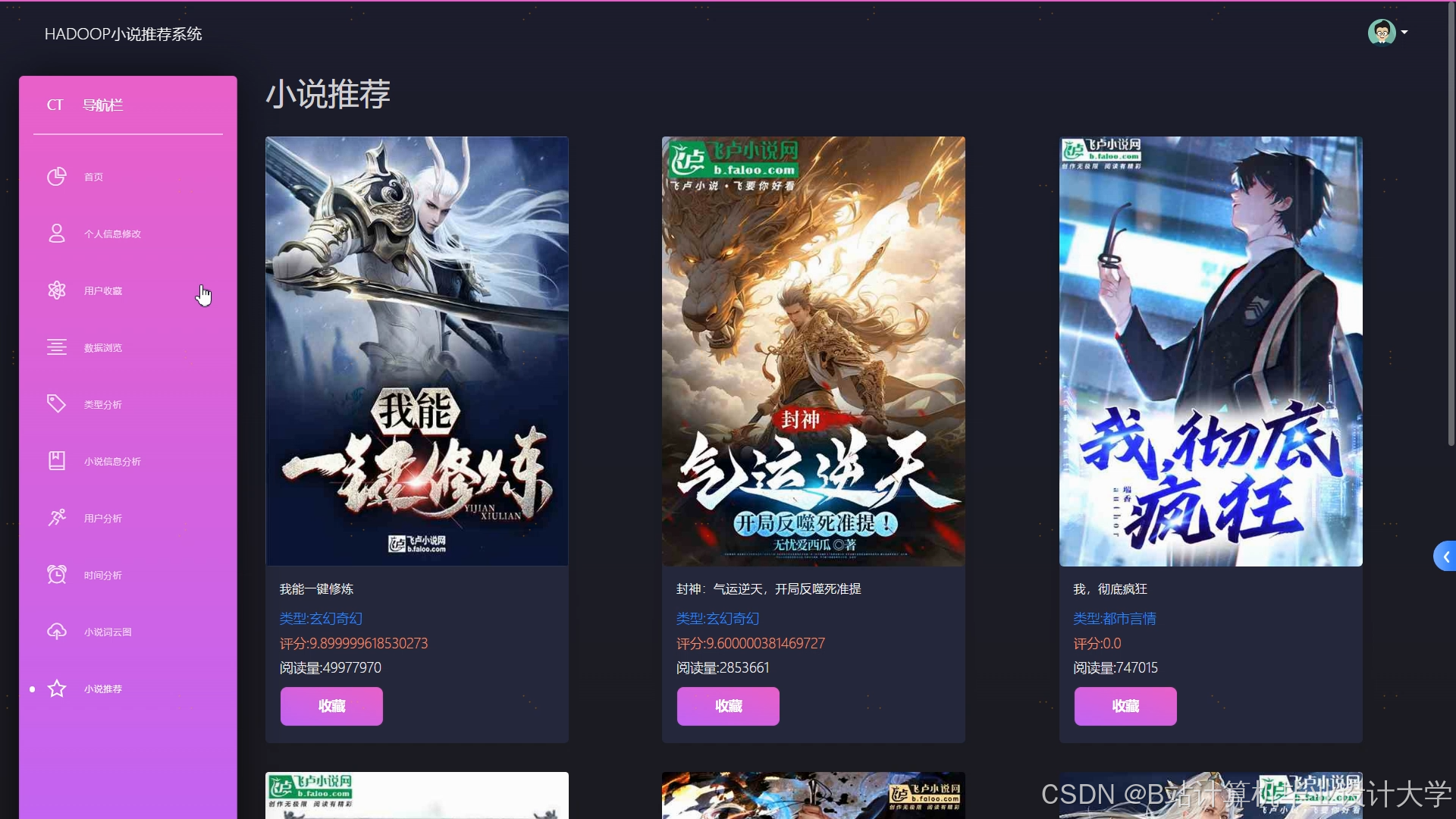

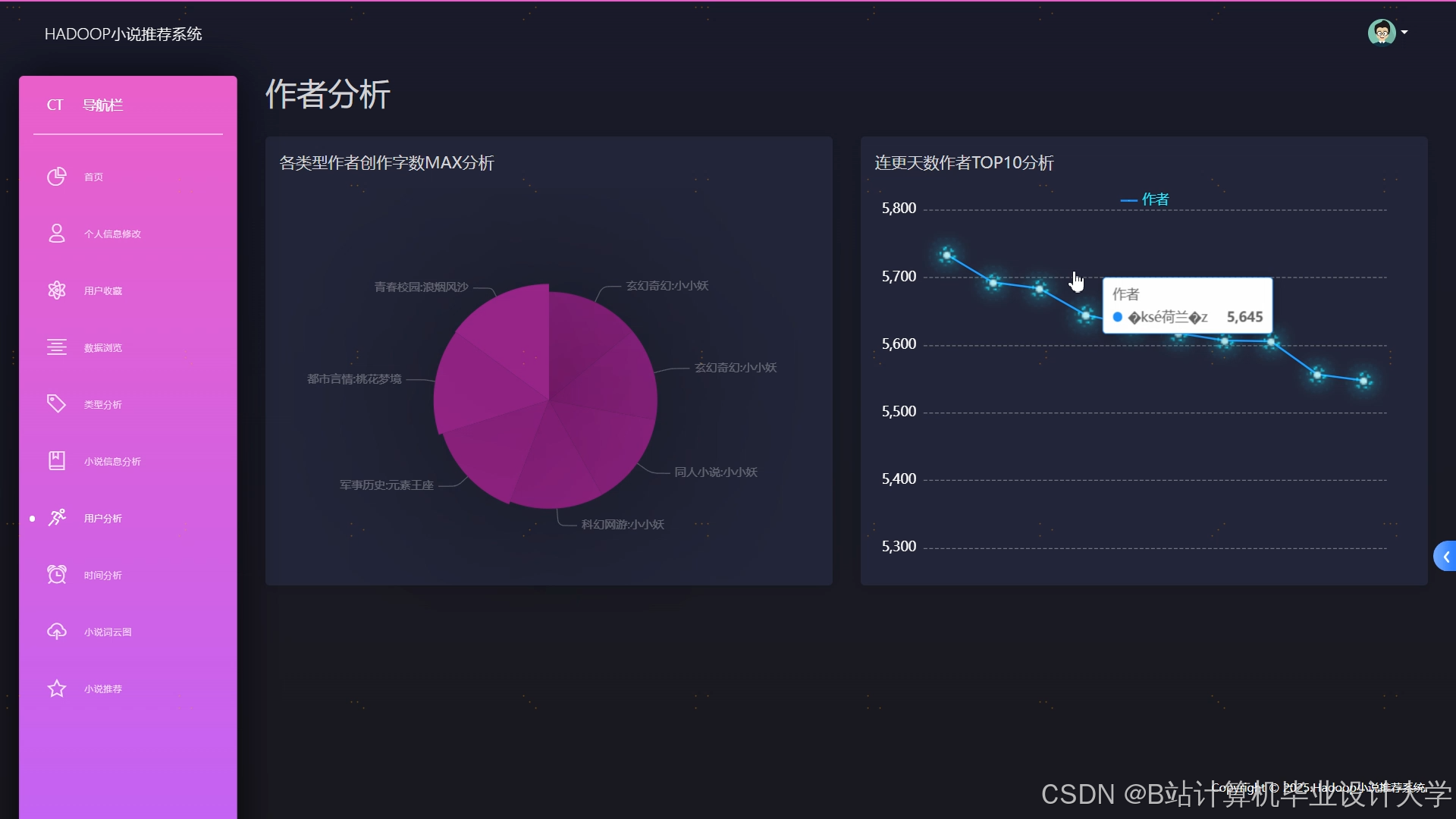

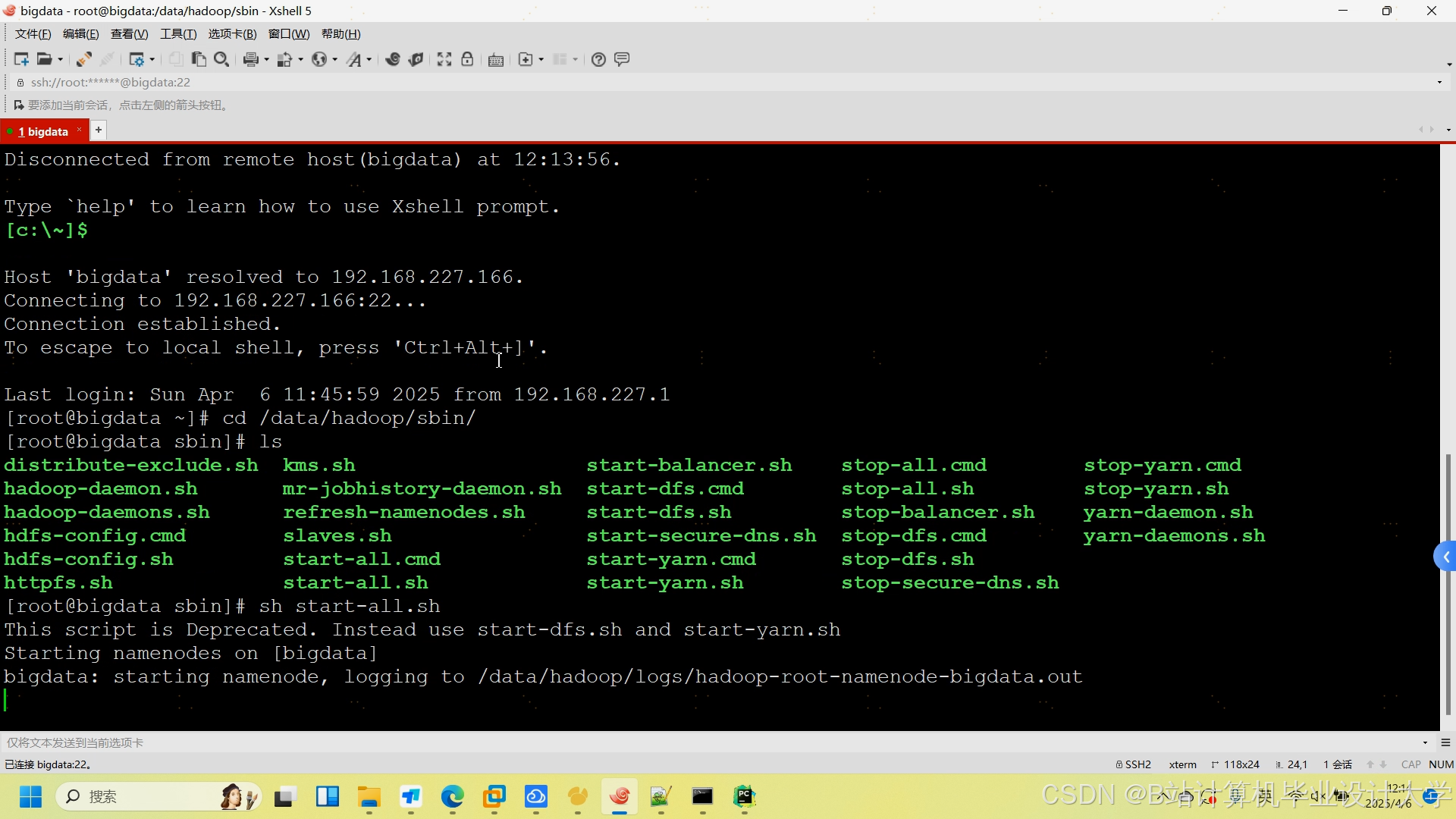

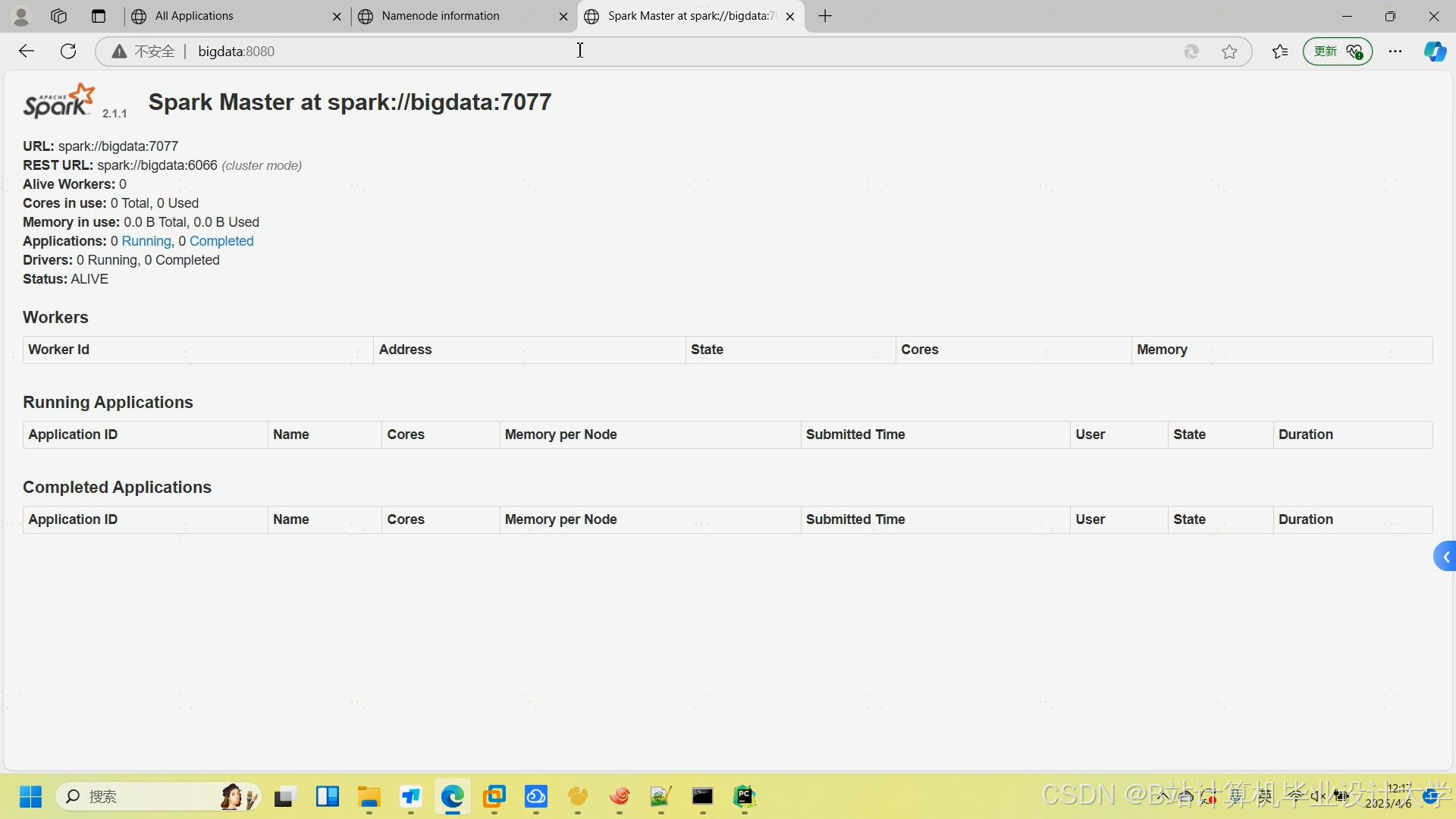

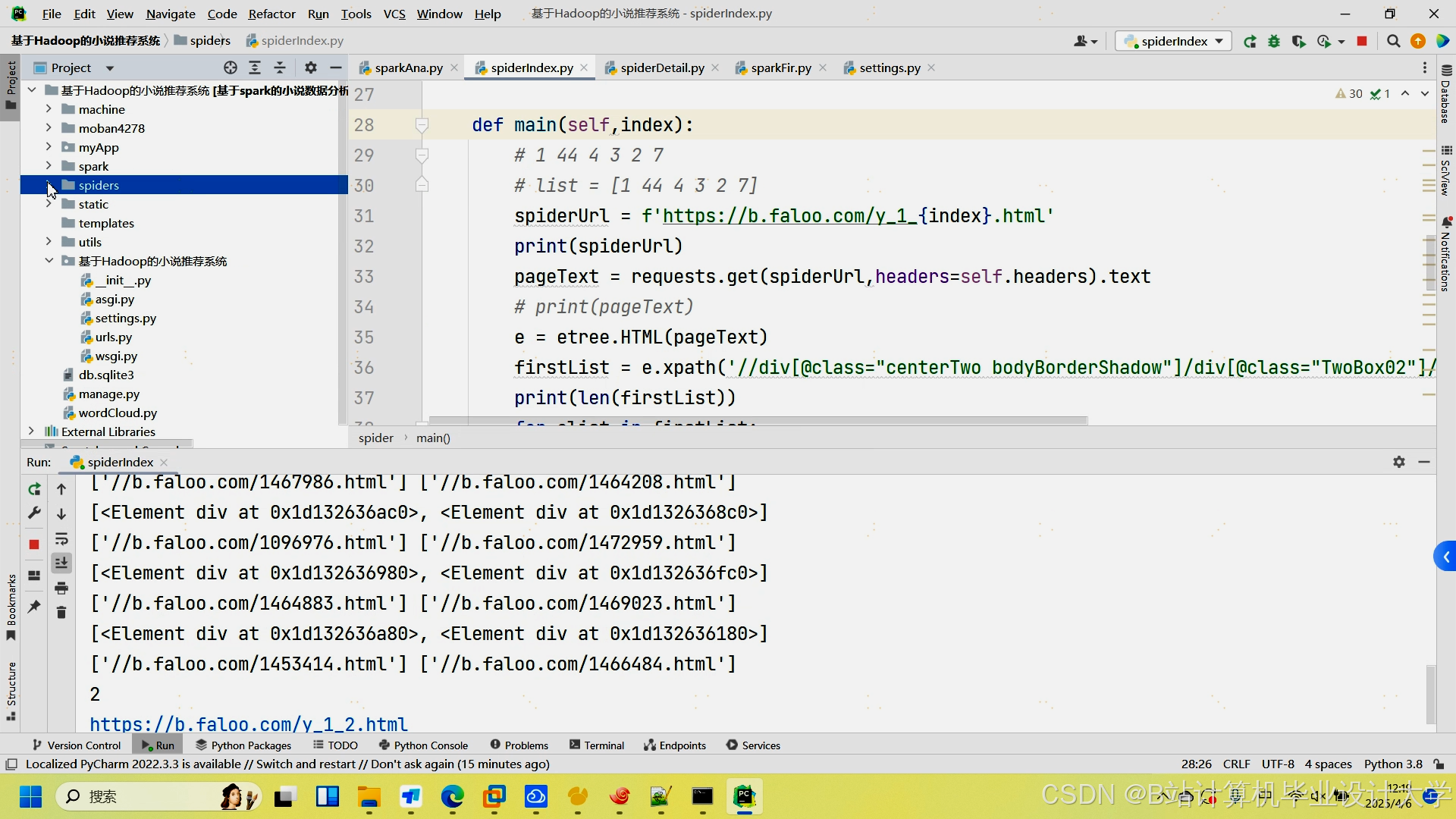

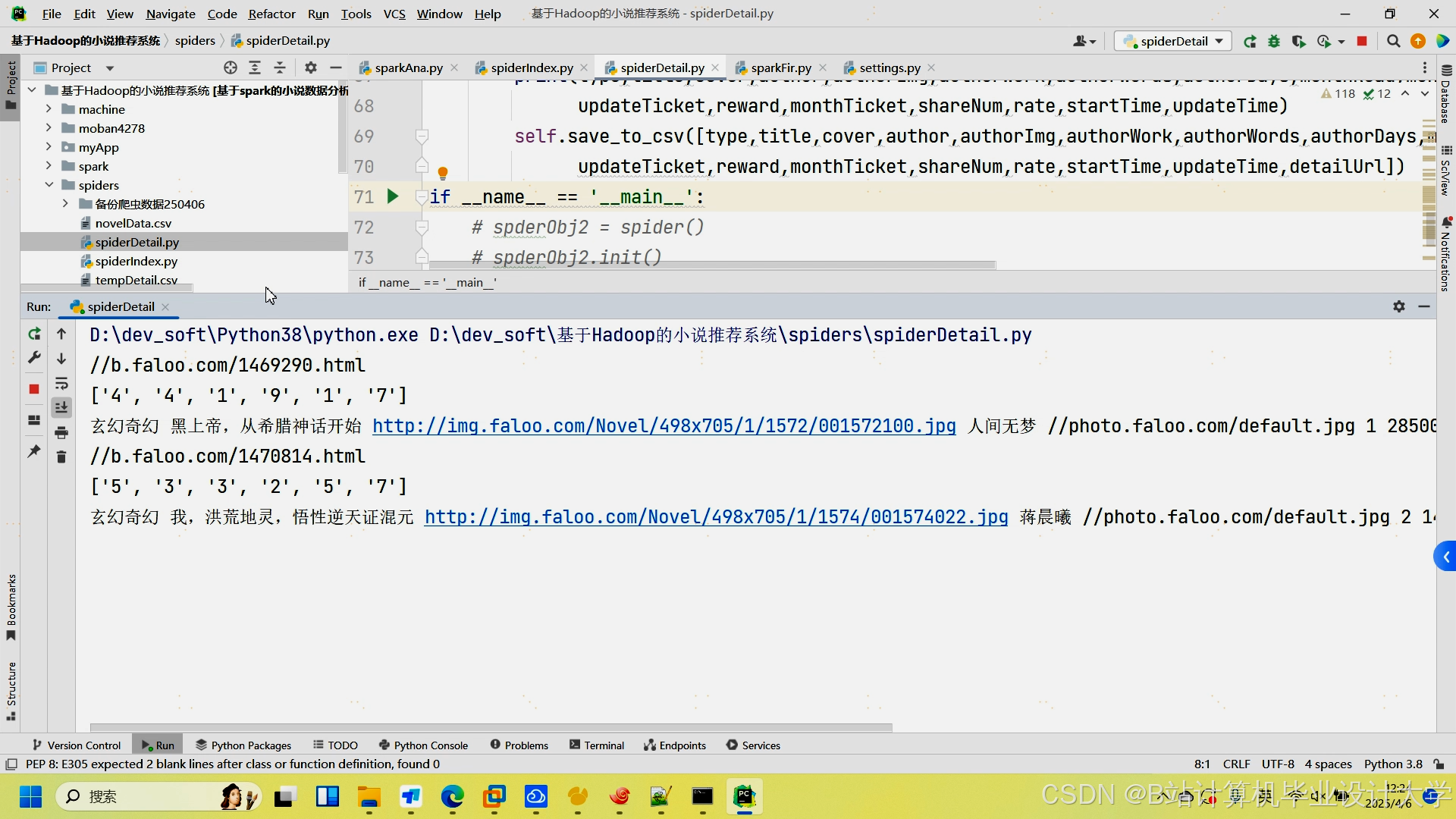

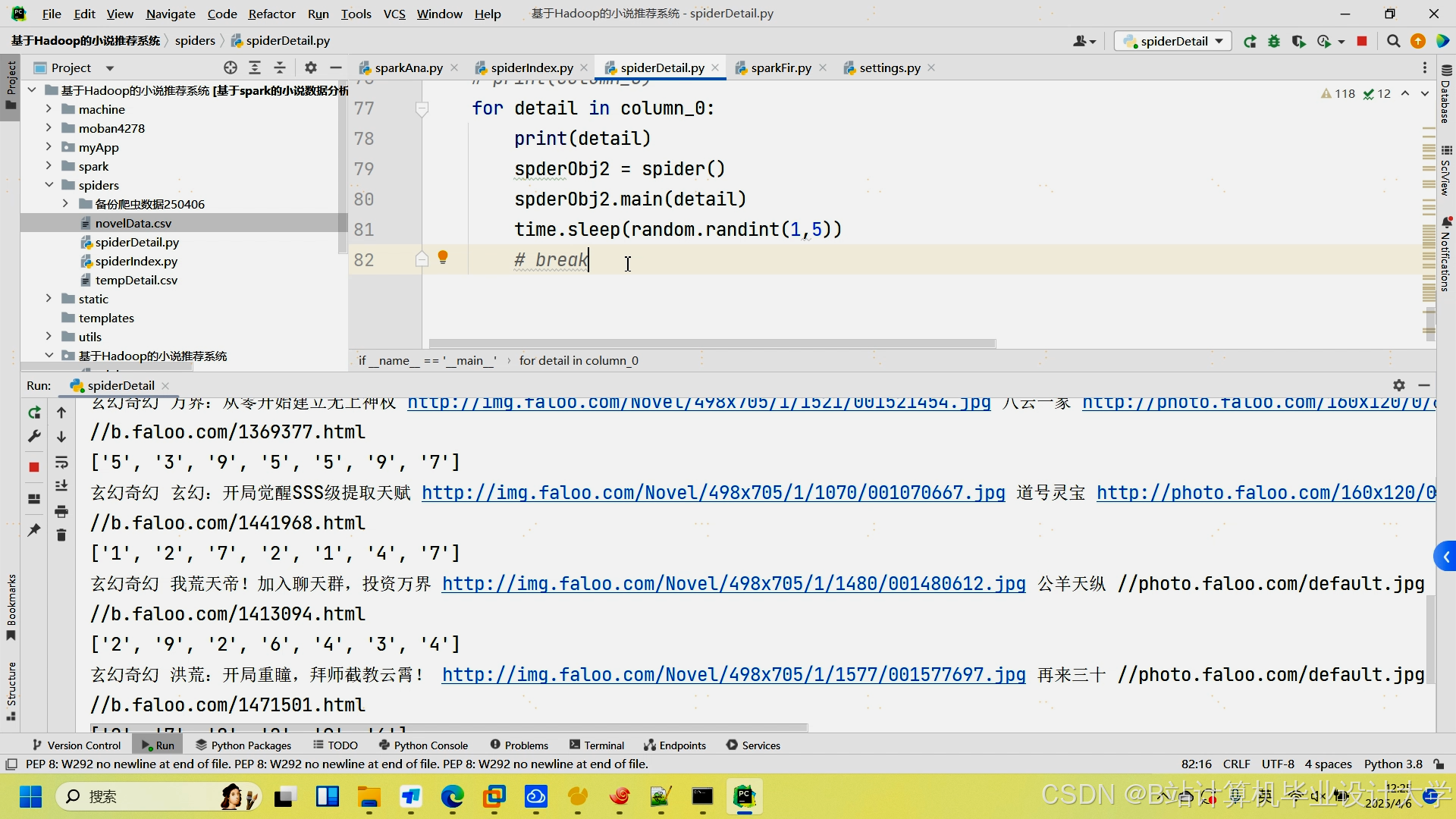

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

422

422

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?