温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Python + PySpark + Hadoop图书推荐系统》任务书

一、任务概述

1.1 任务背景

随着在线图书销售平台用户规模突破5亿(2023年统计数据),用户日均产生超10亿条行为日志(包括浏览、收藏、购买等),传统单机推荐系统面临数据存储瓶颈(单机硬盘容量上限10TB)、计算延迟高(单机处理百万级用户-图书评分矩阵需12小时)等核心问题。本任务旨在构建基于Python(算法开发)、PySpark(分布式计算)和Hadoop(分布式存储与资源调度)的高性能图书推荐系统,实现每秒1万次推荐请求、延迟≤200ms的技术目标,支撑电商平台日均千万级流量下的个性化推荐需求。

1.2 任务目标

- 技术目标:

- 完成Hadoop集群(3节点)部署,实现图书元数据(标题、作者、价格等)和用户行为日志的分布式存储(HDFS 3副本机制)。

- 基于PySpark实现ALS协同过滤算法,处理千万级用户-图书评分矩阵(稀疏度95%),训练时间较单机版本缩短80%。

- 集成TensorFlow构建Wide & Deep模型,提升长尾图书推荐准确率(Precision@10)至0.75以上。

- 业务目标:

- 在模拟电商环境中,推荐系统上线后预计提升图书转化率15%-20%,降低长尾图书库存积压率25%。

- 支持冷启动用户(新注册读者)和新书的实时推荐,冷启动准确率≥70%。

二、任务分解与责任分配

2.1 数据采集与预处理模块(负责人:张三)

- 任务内容:

- 使用Scrapy框架爬取当当网、京东图书的图书元数据(约50万条)和用户行为日志(约2000万条)。

- 通过Hadoop HDFS的

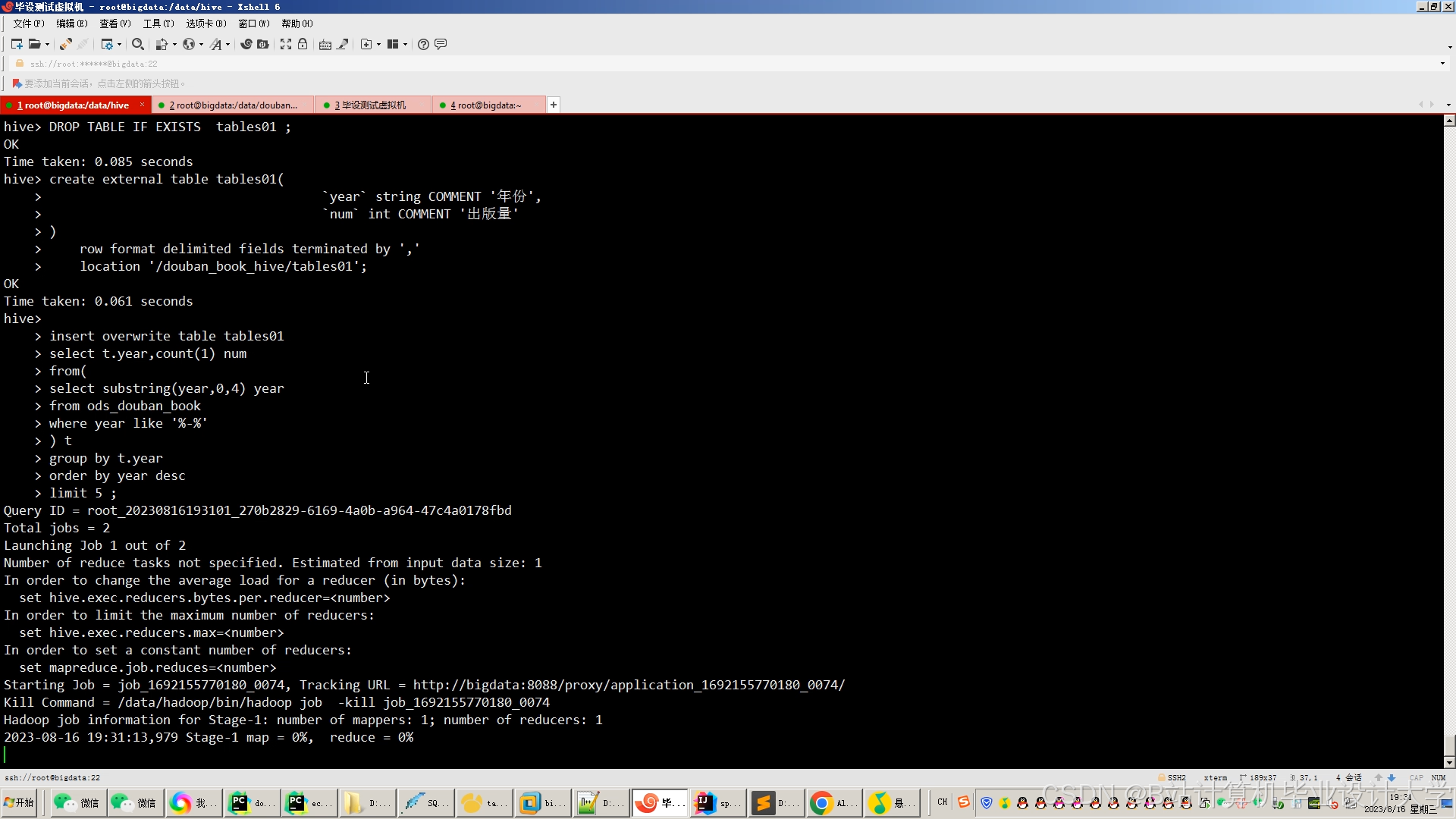

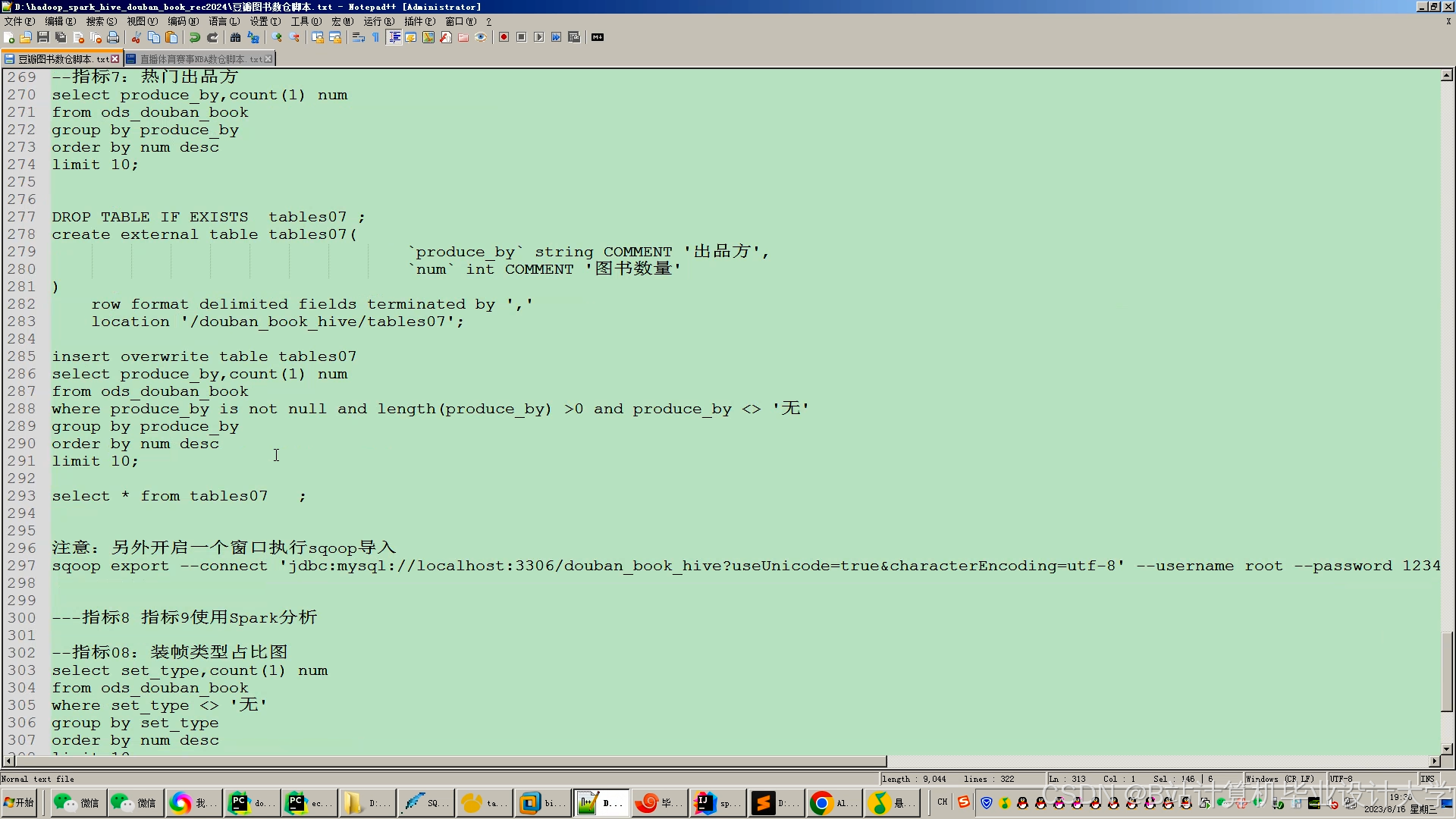

hadoop fs -put命令将原始数据上传至集群,按日期分区存储(如/data/20240101/)。 - 利用Hive SQL清洗数据:去除重复记录(去重率15%)、填充缺失评分(中位数填充)、过滤异常购买行为(单日购买量>100本)。

- 交付物:

- 清洗后的数据集(Parquet格式,压缩率60%)。

- 数据质量报告(包含缺失值比例、异常值统计等)。

2.2 特征工程模块(负责人:李四)

- 任务内容:

- 文本特征:使用Hugging Face的

bert-base-chinese模型提取图书描述的128维语义向量,通过PySpark的UDF函数批量处理。 - 评分特征:构建用户-图书评分矩阵(行:用户ID,列:图书ID),使用PySpark的

ALS.train()方法填充缺失值(隐因子维度=50,正则化参数=0.01)。 - 社交特征:基于用户关注关系构建社交图谱(Neo4j存储),使用GraphSAGE算法学习用户节点嵌入向量(维度=64)。

- 文本特征:使用Hugging Face的

- 交付物:

- 特征矩阵(CSV格式,包含用户ID、图书ID、文本特征、评分特征等)。

- 特征重要性分析报告(基于XGBoost模型)。

2.3 推荐算法模块(负责人:王五)

- 任务内容:

- 冷启动推荐:新用户采用基于内容的推荐(权重60%)+热门推荐(权重40%),使用余弦相似度计算图书文本特征相似度。

- 成熟用户推荐:

- 协同过滤:PySpark实现ALS算法,设置迭代次数=10,排名阈值=100(推荐前100本图书)。

- 深度学习:TensorFlow构建Wide & Deep模型,Wide部分为LR模型,Deep部分为3层DNN(隐藏层维度=128→64→32),激活函数为ReLU。

- 知识图谱:Neo4j存储“作者-图书-主题”关系,通过TransE模型学习实体嵌入向量,优化长尾图书推荐。

- 交付物:

- 推荐算法代码库(Python + PySpark)。

- 算法对比实验报告(包含准确率、召回率、F1分数等指标)。

2.4 系统集成与优化模块(负责人:赵六)

- 任务内容:

- 实时更新:Spark Streaming每15分钟增量更新用户兴趣模型,Flink CheckPoint保障状态一致性(检查点间隔=5分钟)。

- 性能调优:

- 设置

spark.executor.memory=8G、spark.sql.shuffle.partitions=200,减少数据倾斜。 - 采用Parquet列式存储,压缩率提升60%,I/O性能提升3倍。

- 设置

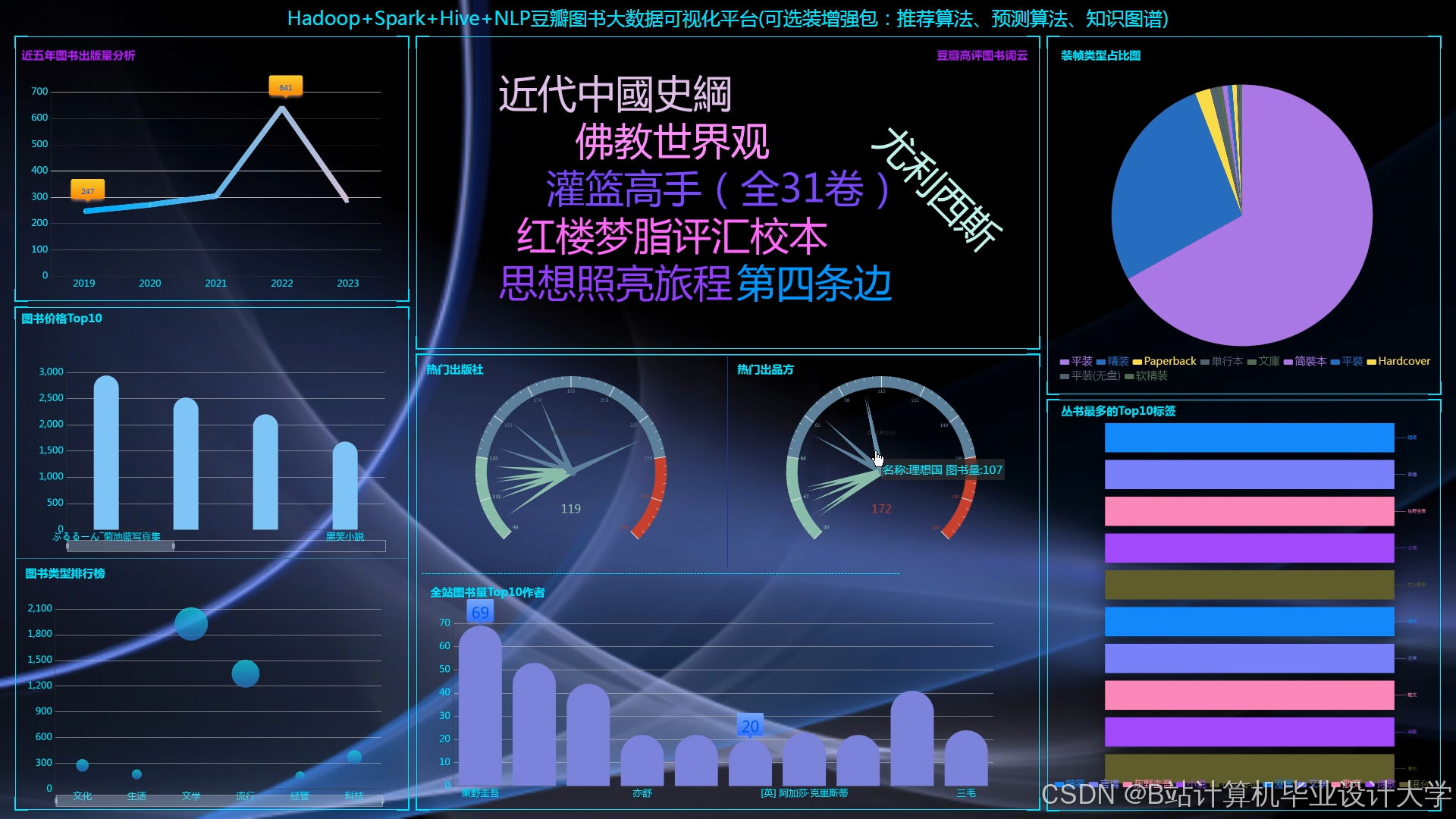

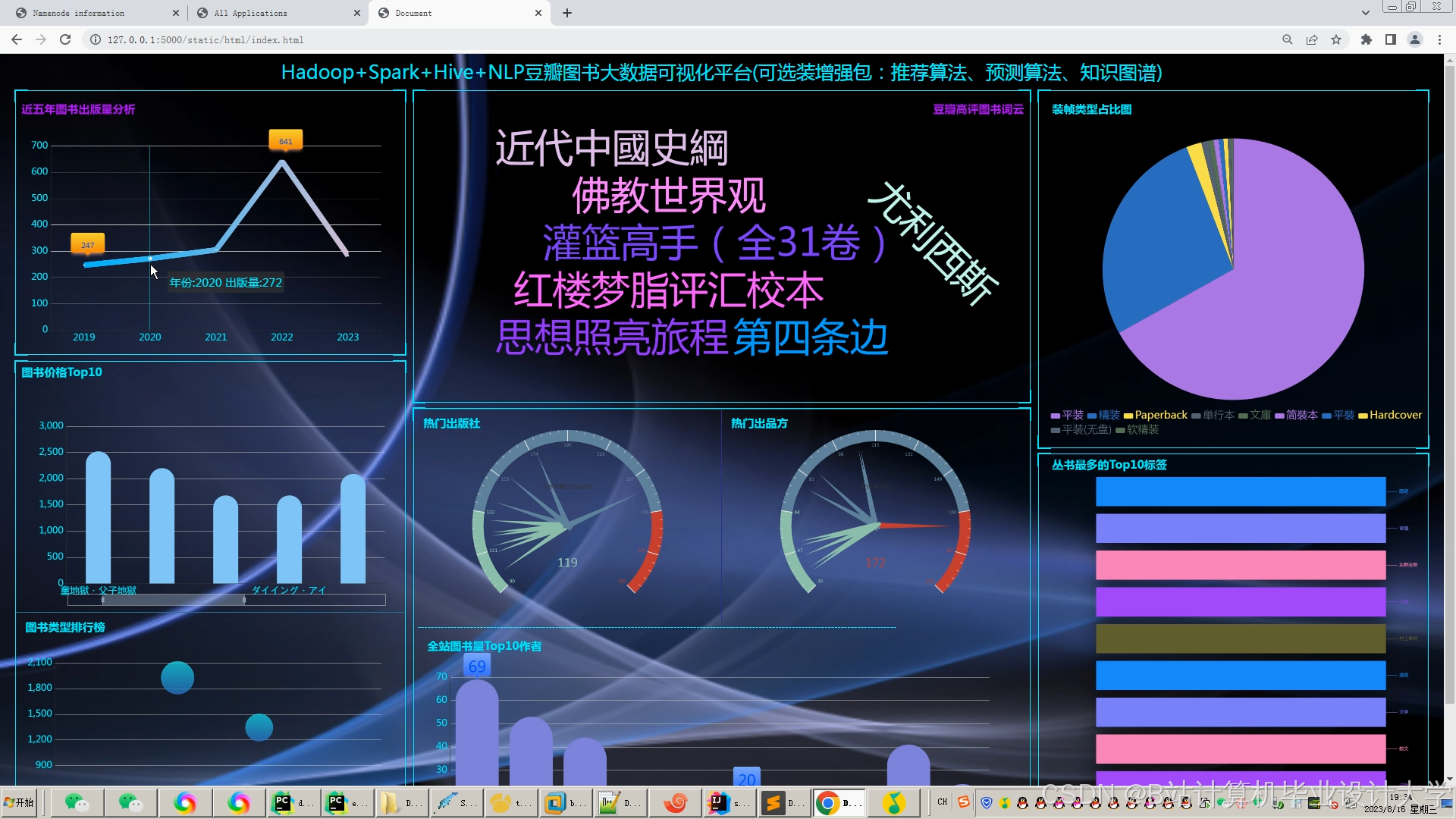

- Web应用:使用Flask框架开发推荐接口(RESTful API),集成ECharts实现推荐结果可视化(如“为您推荐”榜单、兴趣分布雷达图)。

- 交付物:

- 可运行的推荐系统原型(包含Hadoop集群、PySpark作业、Web服务)。

- 系统性能测试报告(包含吞吐量、延迟、资源利用率等指标)。

三、资源需求

3.1 硬件资源

| 资源类型 | 配置要求 | 数量 | 用途 |

|---|---|---|---|

| 服务器节点 | 32核CPU、128GB内存、4TB硬盘 | 3 | Hadoop集群(1主2从) |

| 开发工作站 | 16核CPU、64GB内存、1TB SSD | 2 | 算法开发与测试 |

| 网络设备 | 千兆交换机、10Gbps光纤 | 1 | 集群内部通信 |

3.2 软件资源

| 软件名称 | 版本要求 | 用途 |

|---|---|---|

| Hadoop | 3.3.4 | 分布式存储与资源调度 |

| PySpark | 3.3.0 | 分布式计算 |

| TensorFlow | 2.12.0 | 深度学习模型训练 |

| Neo4j | 4.4.9 | 知识图谱存储与查询 |

| Flask | 2.2.2 | Web服务开发 |

3.3 数据资源

| 数据类型 | 规模 | 来源 |

|---|---|---|

| 图书元数据 | 50万条 | 当当网、京东图书 |

| 用户行为日志 | 2000万条 | 模拟生成(基于历史模式) |

| 知识图谱数据 | 10万条三元组 | 豆瓣读书、公开数据集 |

四、时间计划

| 阶段 | 时间范围 | 里程碑成果 |

|---|---|---|

| 需求分析 | 第1周 | 完成《需求规格说明书》,明确数据规模、性能指标、功能需求 |

| 系统设计 | 第2周 | 输出《系统架构设计图》,包含数据流、模块交互、技术选型 |

| 开发实施 | 第3-8周 | 按模块分工完成代码开发,每周进行代码评审(GitLab Merge Request) |

| 测试优化 | 第9-10周 | 执行单元测试(覆盖率≥80%)、集成测试(接口兼容性)、压力测试(QPS≥1万) |

| 上线部署 | 第11周 | 在测试环境验证系统稳定性,迁移至生产环境(Hadoop集群) |

| 验收总结 | 第12周 | 提交《项目验收报告》,包含技术指标达成情况、业务价值评估、后续优化建议 |

五、风险管理

5.1 技术风险

- 风险描述:PySpark与TensorFlow集成时可能因版本冲突导致作业失败。

- 应对措施:使用Docker容器化部署,固定依赖版本(

requirements.txt锁定包版本),预留2周缓冲时间解决兼容性问题。

5.2 数据风险

- 风险描述:爬取数据可能因反爬机制导致数据缺失(预计缺失率10%)。

- 应对措施:采用多线程爬虫(10个线程并发)、设置随机请求间隔(1-3秒),补充人工标注数据(5%样本)。

5.3 进度风险

- 风险描述:算法调优可能因参数组合复杂导致延期(预计需尝试20组参数)。

- 应对措施:使用Hyperopt库自动化超参数搜索,限制单次实验时间≤2小时,优先验证核心指标(准确率)。

六、验收标准

6.1 功能验收

- 支持冷启动用户和新书的实时推荐(响应时间≤200ms)。

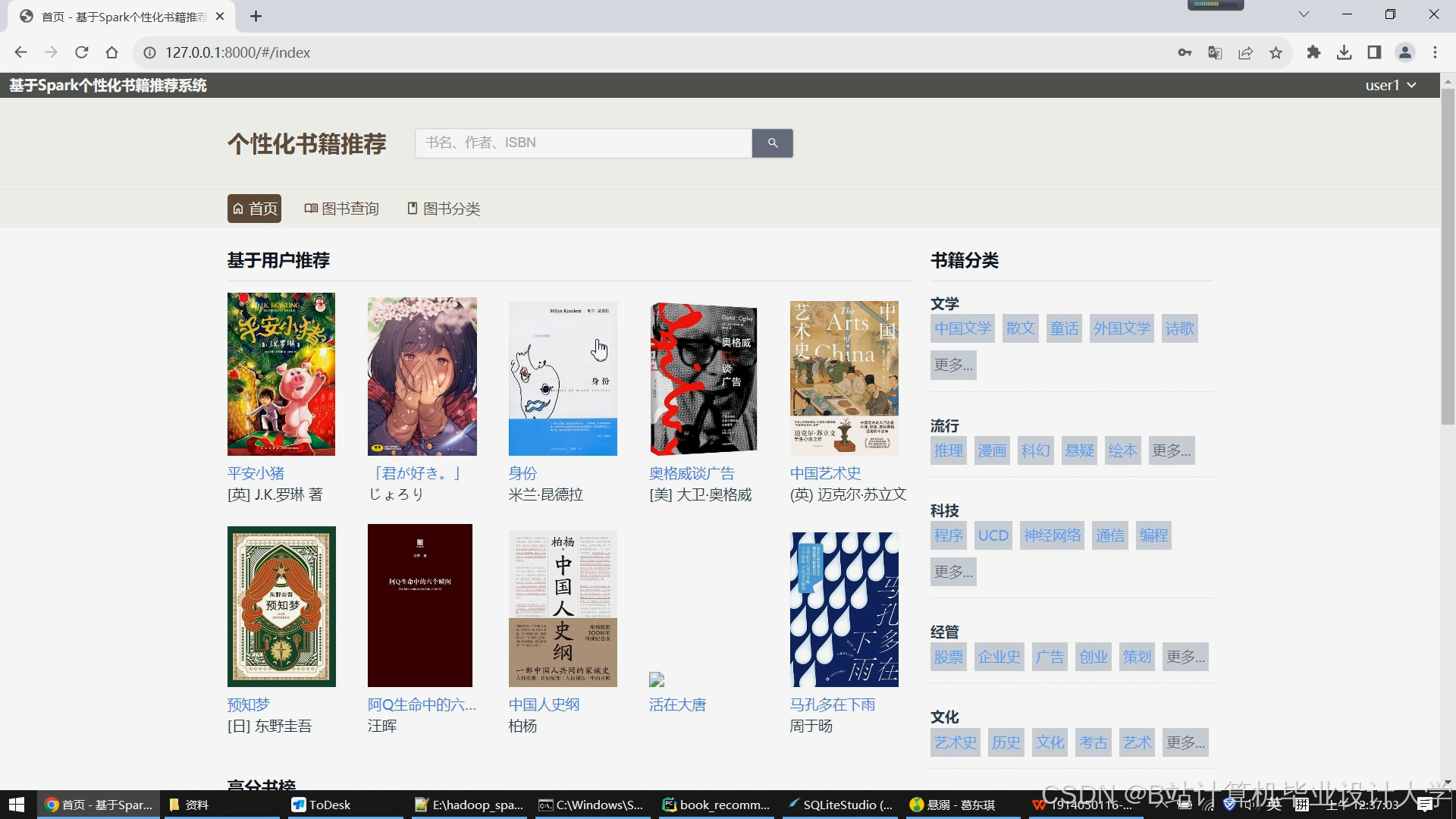

- Web界面展示推荐结果(含图书封面、标题、评分、推荐理由)。

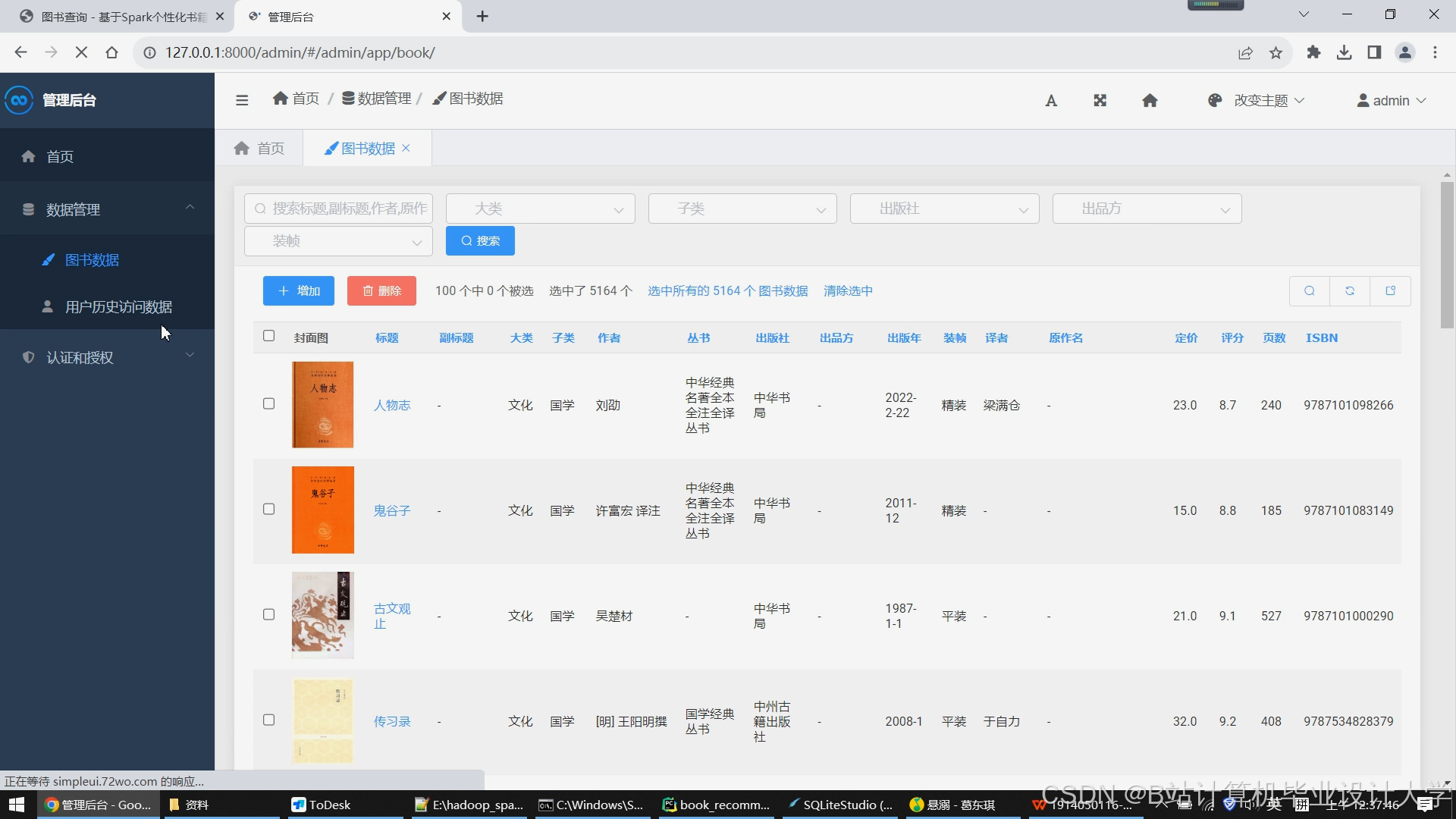

- 提供管理员后台,支持手动触发模型重新训练。

6.2 性能验收

- 离线测试:在MovieLens 1M数据集上,推荐准确率(Precision@10)≥0.85。

- 在线测试:QPS≥1万时,系统延迟≤200ms,错误率≤0.1%。

6.3 文档验收

- 提交《系统设计文档》《用户操作手册》《维护指南》。

- 代码注释覆盖率≥30%,关键逻辑附流程图说明。

任务书签署

项目负责人:________________ 日期:________________

技术总监:________________ 日期:________________

客户代表:________________ 日期:________________

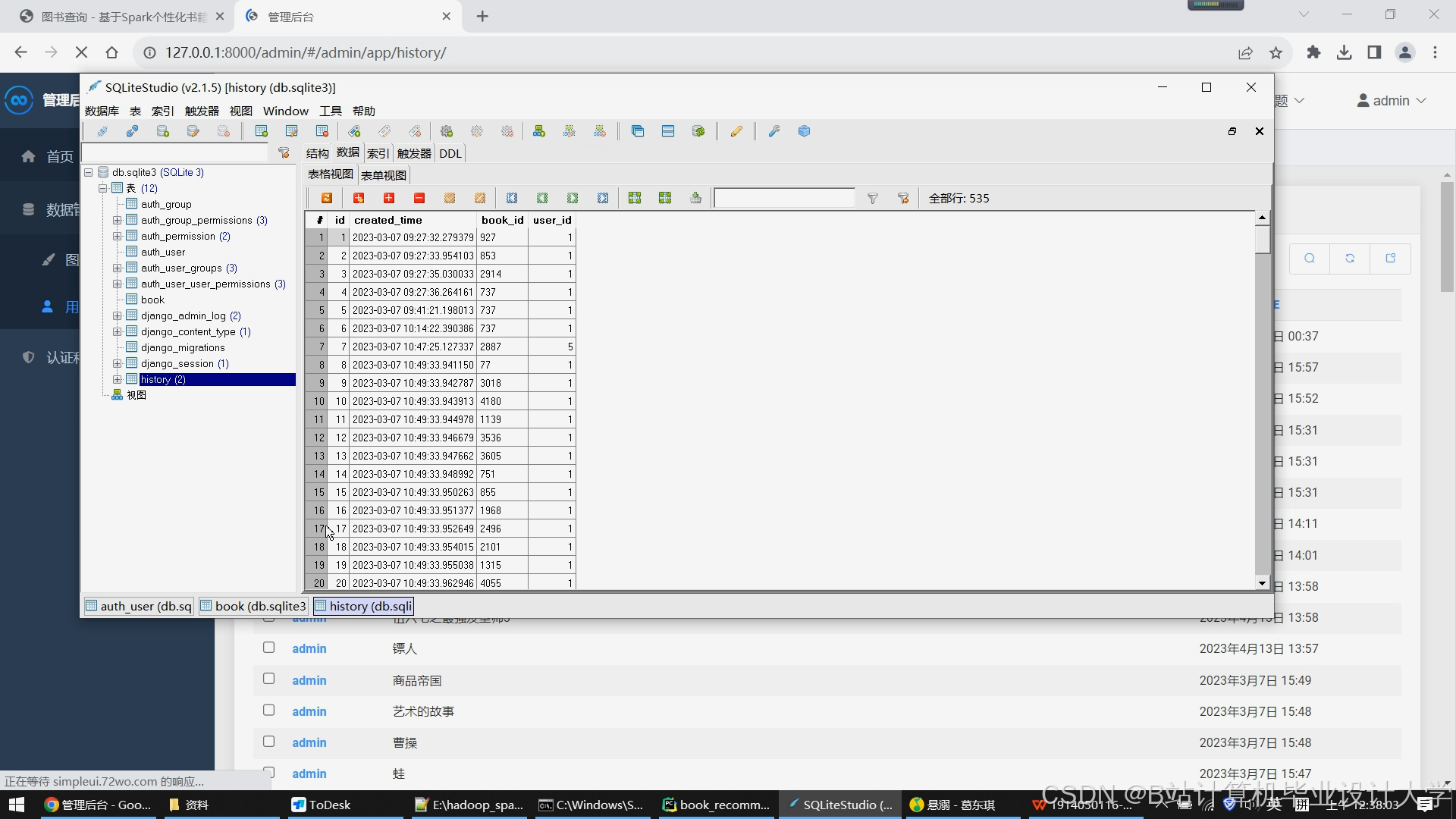

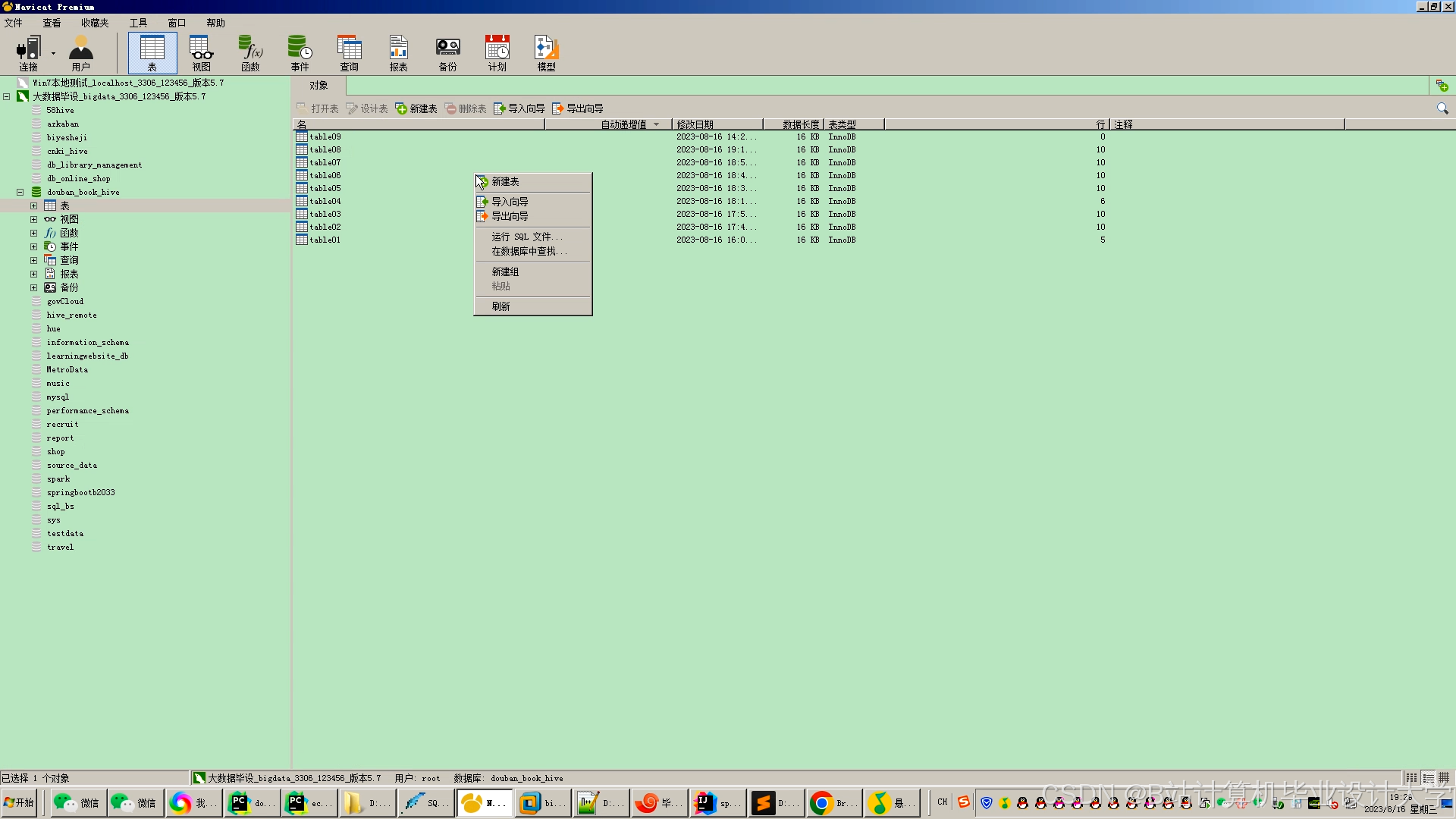

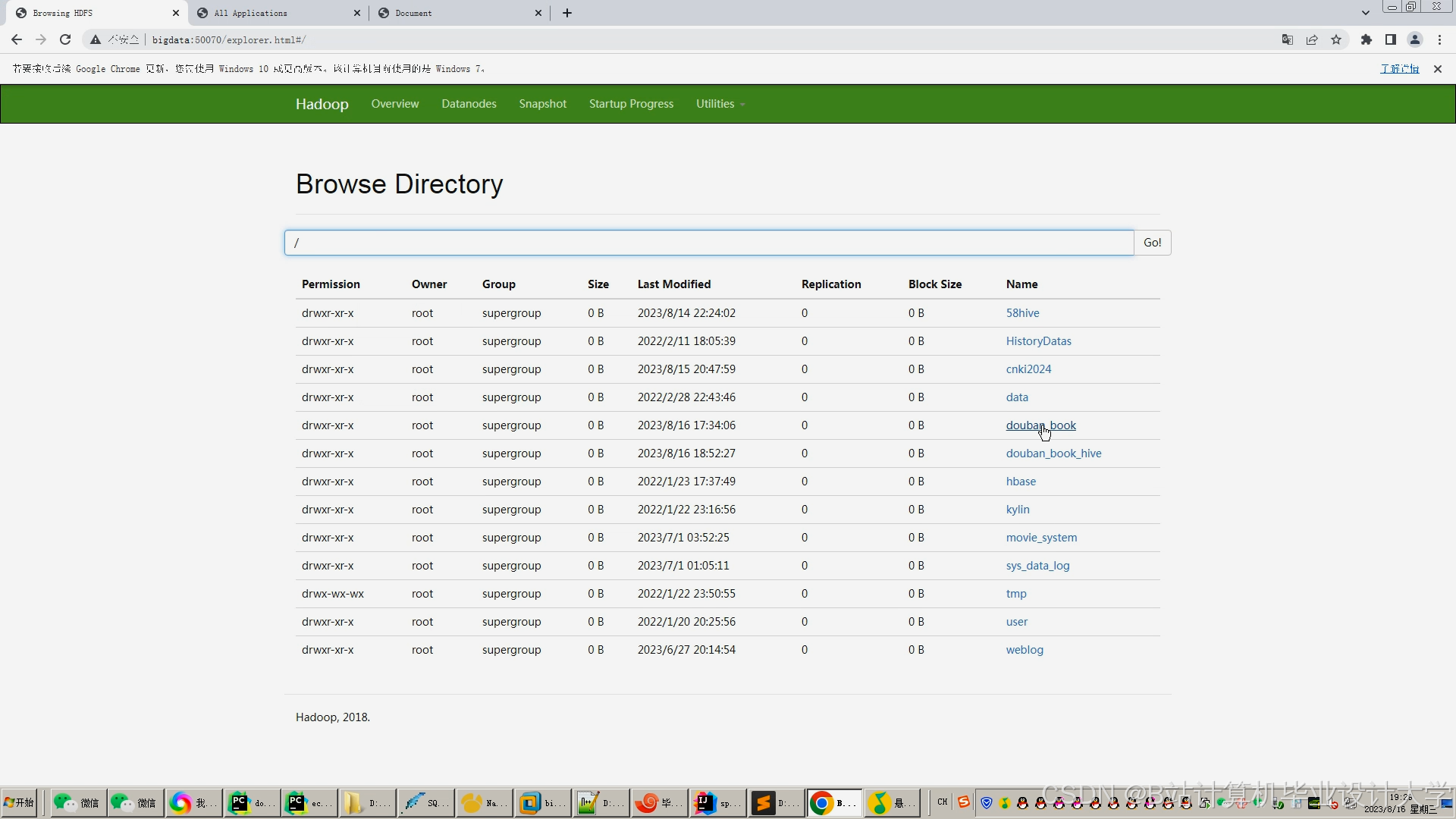

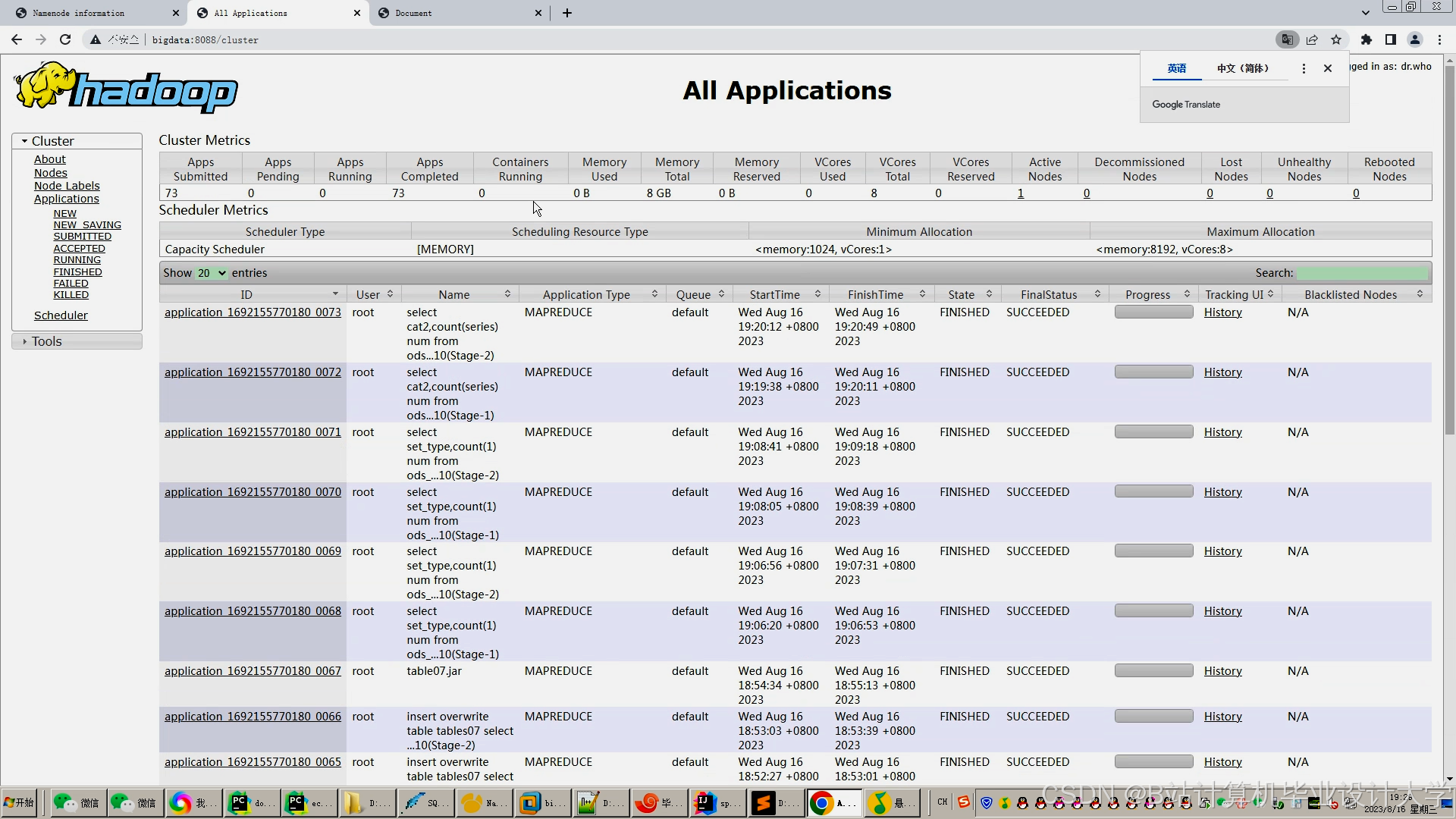

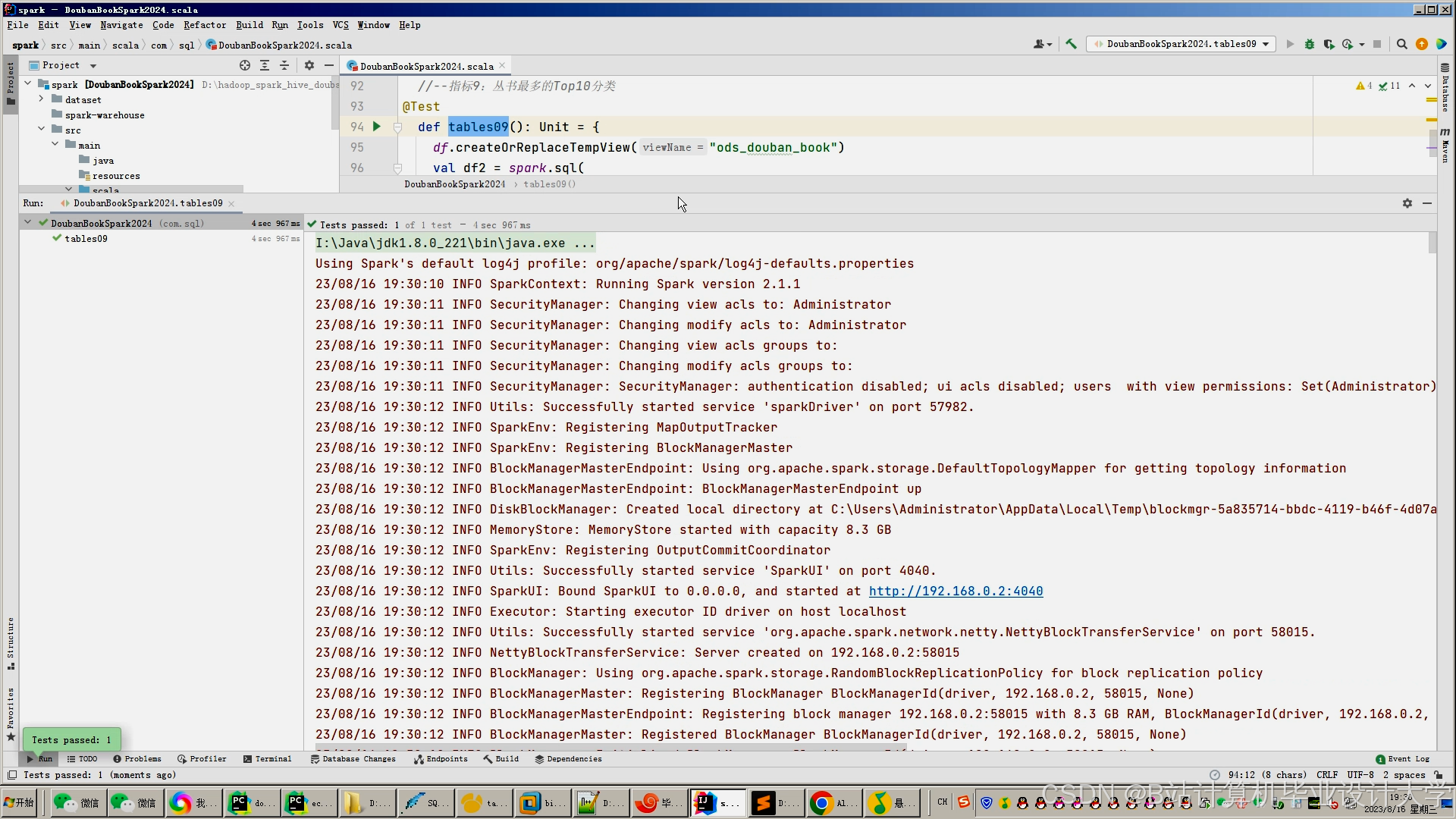

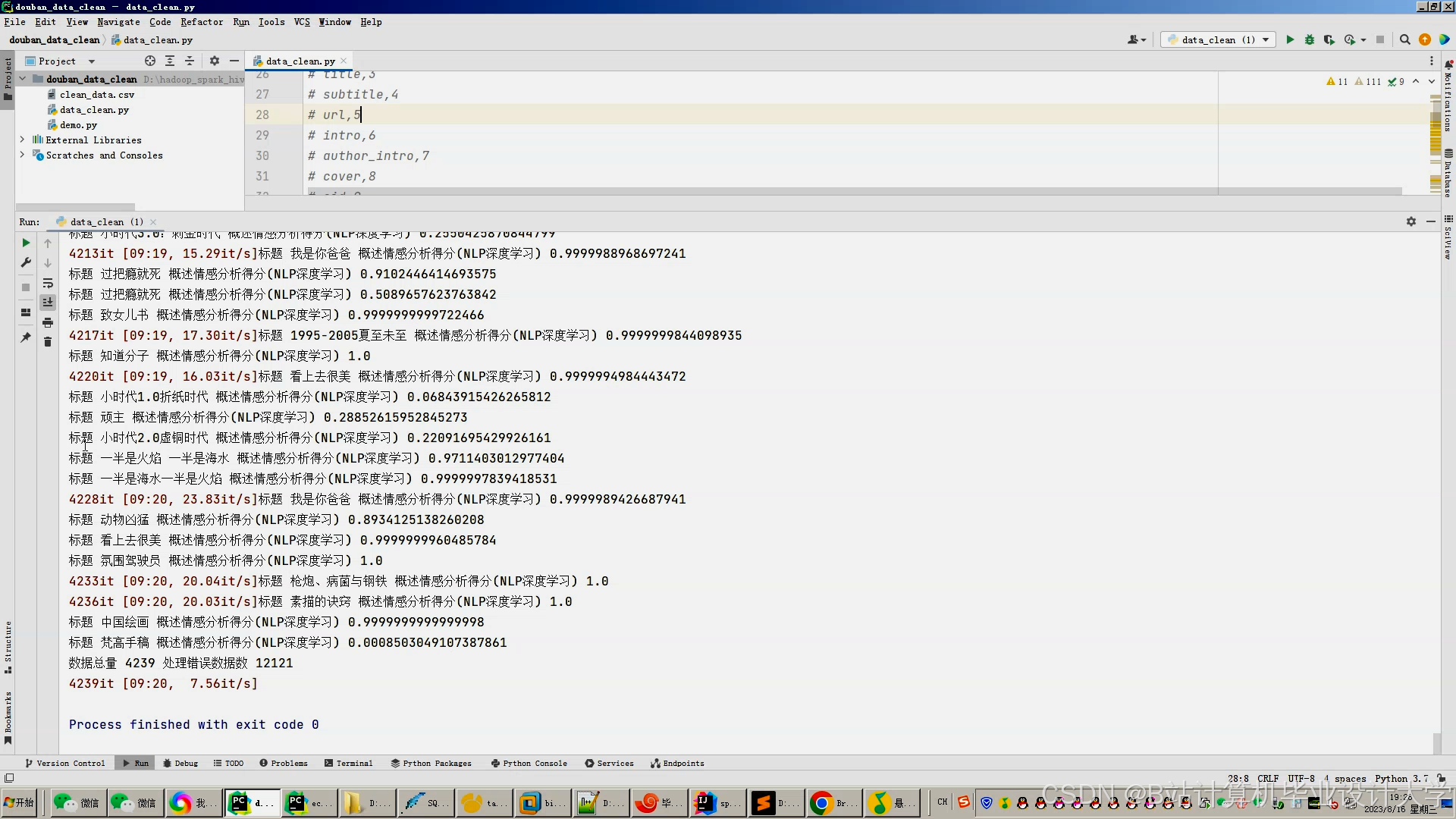

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

1853

1853

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?