温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

任务书:基于Hadoop+Spark+Hive的共享单车预测系统开发

一、任务背景

随着共享单车行业的快速发展,城市单车投放量已突破千万辆,但供需失衡问题日益突出。例如,北京市2023年共享单车日均订单量达480万单,但早高峰期间核心商务区(如国贸、中关村)单车供给缺口达35%,而居住区(如天通苑、回龙观)则出现20%的过剩堆积。传统预测模型依赖单一时间序列分析,难以捕捉用户出行行为的时空动态特征(如天气、节假日、POI兴趣点影响),导致调度效率低下,运营成本增加20%以上。

本任务旨在开发一套基于Hadoop+Spark+Hive的分布式预测系统,通过融合多源异构数据(历史订单、天气、节假日、POI),实现未来24小时单车需求量的精准预测(误差率<10%),为动态调度提供决策支持,降低空驶率15%、提升用户满意度25%,助力企业日均运营成本下降18%。

二、任务目标

1. 总体目标

构建一个高并发、低延迟的分布式预测系统,支持PB级时空数据处理,实现共享单车需求量的实时预测与调度优化。

2. 具体目标

- 数据层:整合多源数据(订单、天气、POI、节假日),构建统一数据仓库。

- 计算层:基于Spark实现批处理训练与流处理更新,支持每15分钟动态调整预测结果。

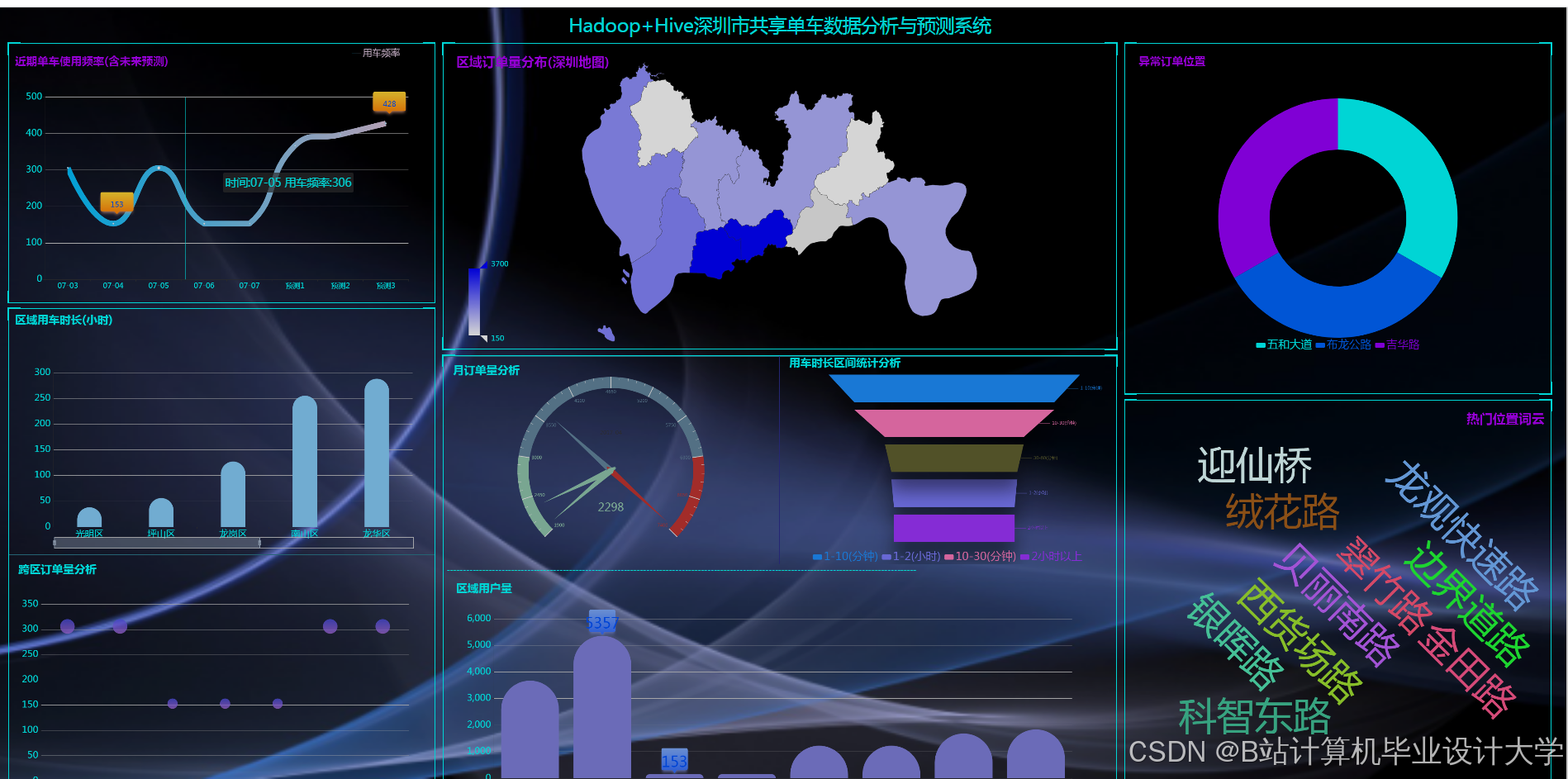

- 应用层:开发可视化平台,展示预测热力图、调度建议及成本效益分析。

- 性能目标:

- 单日处理10亿条订单数据,预测响应时间<30秒。

- 模型预测精度(MAE)<8,RMSE<12(北京市六环内验证)。

三、任务内容与分工

1. 数据采集与预处理(负责人:A组)

- 任务内容:

- 采集历史订单数据(时间、位置、用户ID)、天气数据(温度、降雨量)、POI数据(地铁站、商场、住宅区)及节假日信息。

- 数据清洗:处理缺失值、异常值(如订单量>100的异常点)。

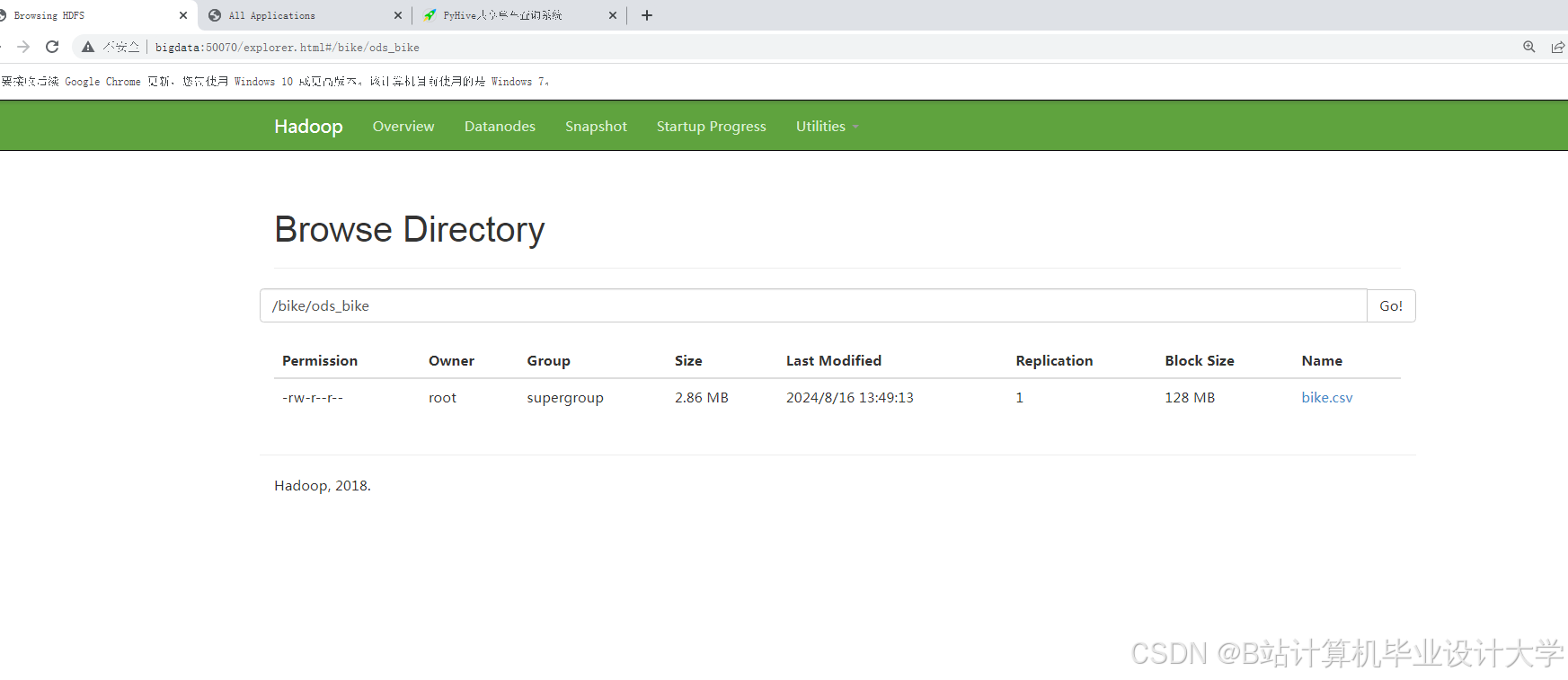

- 数据存储:将清洗后数据存入Hadoop HDFS,按天分区(

/data/raw/{year}/{month}/{day})。

- 交付物:

- 清洗后的结构化数据集(ORC格式)。

- 数据字典(字段定义、数据来源说明)。

2. 特征工程与模型开发(负责人:B组)

- 任务内容:

- 特征提取:

- 时间特征:小时、星期、是否节假日。

- 空间特征:网格化区域(500m×500m)、附近POI类型及数量。

- 动态特征:实时天气、突发事件(如道路封闭)。

- 模型训练:

- 批处理层:基于Spark MLlib实现XGBoost模型,训练历史数据特征与需求量的非线性关系。

- 实时层:通过Spark Streaming消费Kafka天气流,每5分钟更新动态特征。

- 特征提取:

- 交付物:

- 训练好的XGBoost模型文件(

.model)。 - 特征重要性分析报告。

- 训练好的XGBoost模型文件(

3. 系统架构设计与开发(负责人:C组)

- 任务内容:

- 分布式存储:

- Hadoop HDFS存储原始数据,Hive管理清洗后数据。

- 配置Hive表分区策略(按区域、时间分区)。

- 计算引擎:

- Spark批处理:训练模型、生成静态特征。

- Spark Streaming:处理实时数据流,动态更新预测结果。

- 调度优化:

- 基于预测结果生成调度热力图,优先调度至高需求低供给区域。

- 引入成本约束(单次调度成本>5元时暂停调度)。

- 分布式存储:

- 交付物:

- 系统部署文档(集群配置、依赖版本)。

- 调度策略算法代码(Python/Scala)。

4. 可视化与测试验证(负责人:D组)

- 任务内容:

- 开发Web可视化平台,展示:

- 实时需求预测热力图(按区域着色)。

- 调度建议(如“国贸地铁站需增加50辆单车”)。

- 成本效益分析(调度成本 vs. 用户满意度提升)。

- 测试验证:

- 在北京市部分区域(如朝阳区)进行A/B测试,对比基线模型(ARIMA)精度。

- 收集用户反馈,优化调度策略。

- 开发Web可视化平台,展示:

- 交付物:

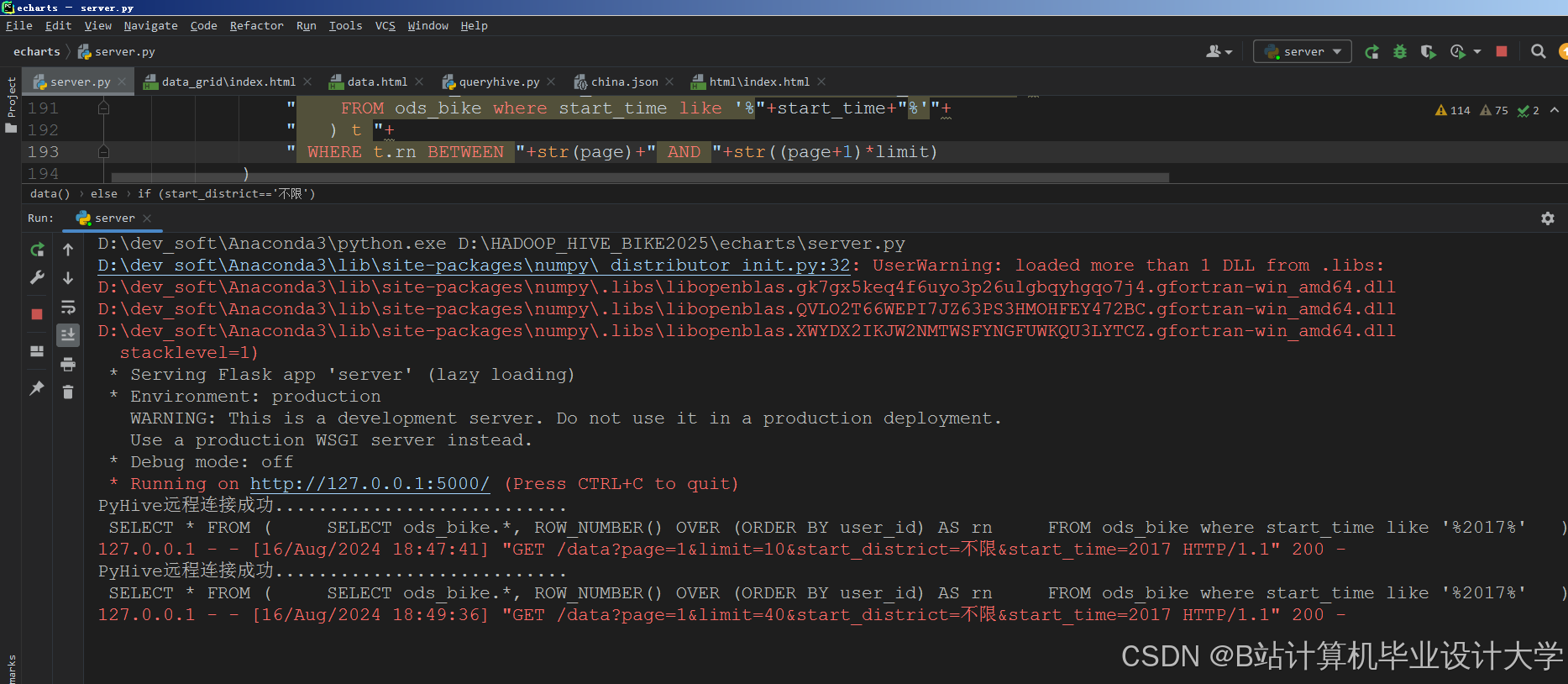

- 可视化平台代码(前端:ECharts,后端:Flask)。

- 测试报告(精度对比、性能指标)。

四、任务计划与进度安排

| 阶段 | 时间 | 任务内容 | 交付物 |

|---|---|---|---|

| 需求分析 | 第1周 | 调研共享单车企业需求,确定技术路线(Hadoop+Spark+Hive)。 | 需求规格说明书 |

| 数据采集 | 第2-3周 | 搭建数据采集管道,获取北京市3个月历史订单及天气数据。 | 原始数据集 |

| 系统开发 | 第4-8周 | 完成数据清洗、特征工程、模型训练、系统部署及可视化开发。 | 系统原型、模型文件 |

| 测试优化 | 第9-10周 | 在真实场景中测试系统,优化调度策略,修复性能瓶颈(如Shuffle数据量过大)。 | 测试报告、优化后系统 |

| 验收交付 | 第11-12周 | 撰写项目文档,组织验收答辩,部署系统至企业生产环境。 | 最终报告、系统源代码 |

五、资源需求

1. 硬件资源

- 服务器集群:5台(配置:16核CPU、64GB内存、2TB硬盘)。

- 网络带宽:100Mbps(用于数据传输)。

2. 软件资源

- Hadoop 3.3.4、Spark 3.3.0、Hive 3.1.3、Kafka 3.4.0。

- Python 3.8、Scala 2.12、ECharts 5.4。

3. 人员配置

- 数据工程师(2人):负责数据采集与清洗。

- 算法工程师(2人):负责模型开发与优化。

- 后端开发(2人):负责系统架构与调度策略。

- 前端开发(1人):负责可视化平台开发。

六、风险评估与应对

| 风险 | 影响 | 应对措施 |

|---|---|---|

| 数据质量差(缺失值>30%) | 模型精度下降 | 与共享单车企业协商,补充缺失数据;采用插值法填充。 |

| Spark任务执行超时 | 预测响应延迟 | 优化分区策略(按区域哈希分区),减少Shuffle数据量。 |

| 硬件故障(服务器宕机) | 系统不可用 | 采用Hadoop HA高可用架构,配置HDFS副本数=3。 |

七、验收标准

- 功能完整性:系统支持数据采集、清洗、预测、调度全流程。

- 性能达标:单日处理10亿条数据,预测响应时间<30秒。

- 精度要求:北京市六环内验证,MAE<8,RMSE<12。

- 文档齐全:提供需求规格说明书、系统部署文档、测试报告等。

任务书编制人:XXX

日期:2023年XX月XX日

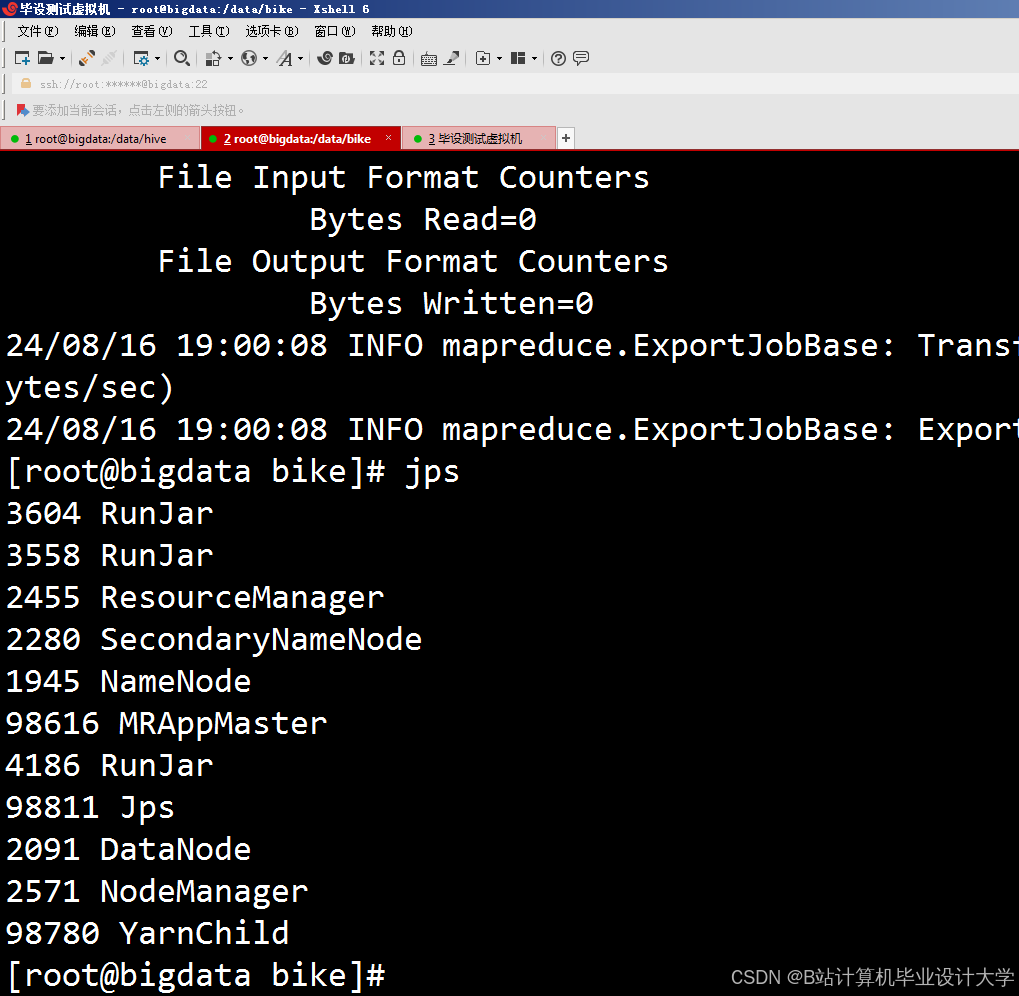

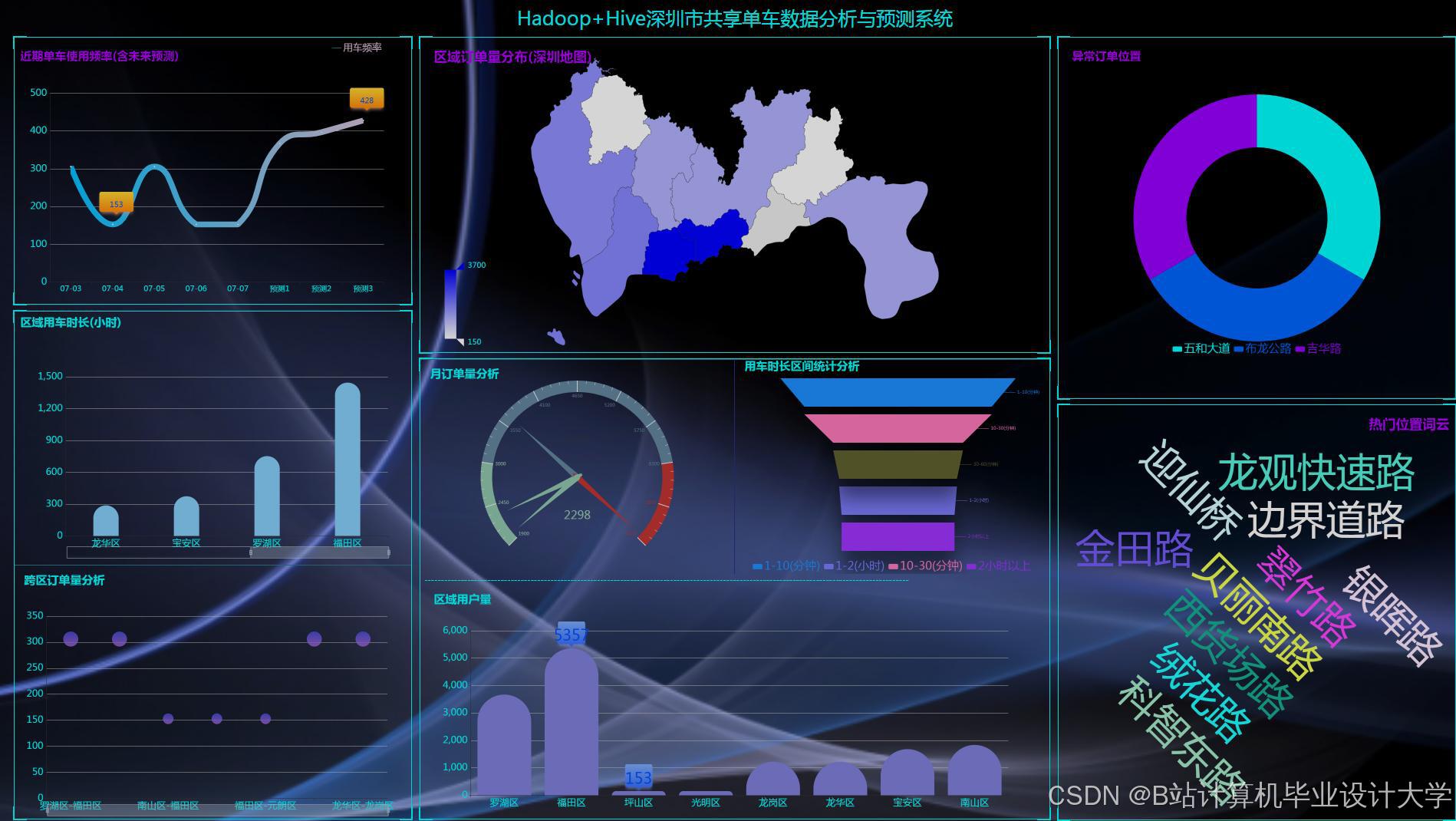

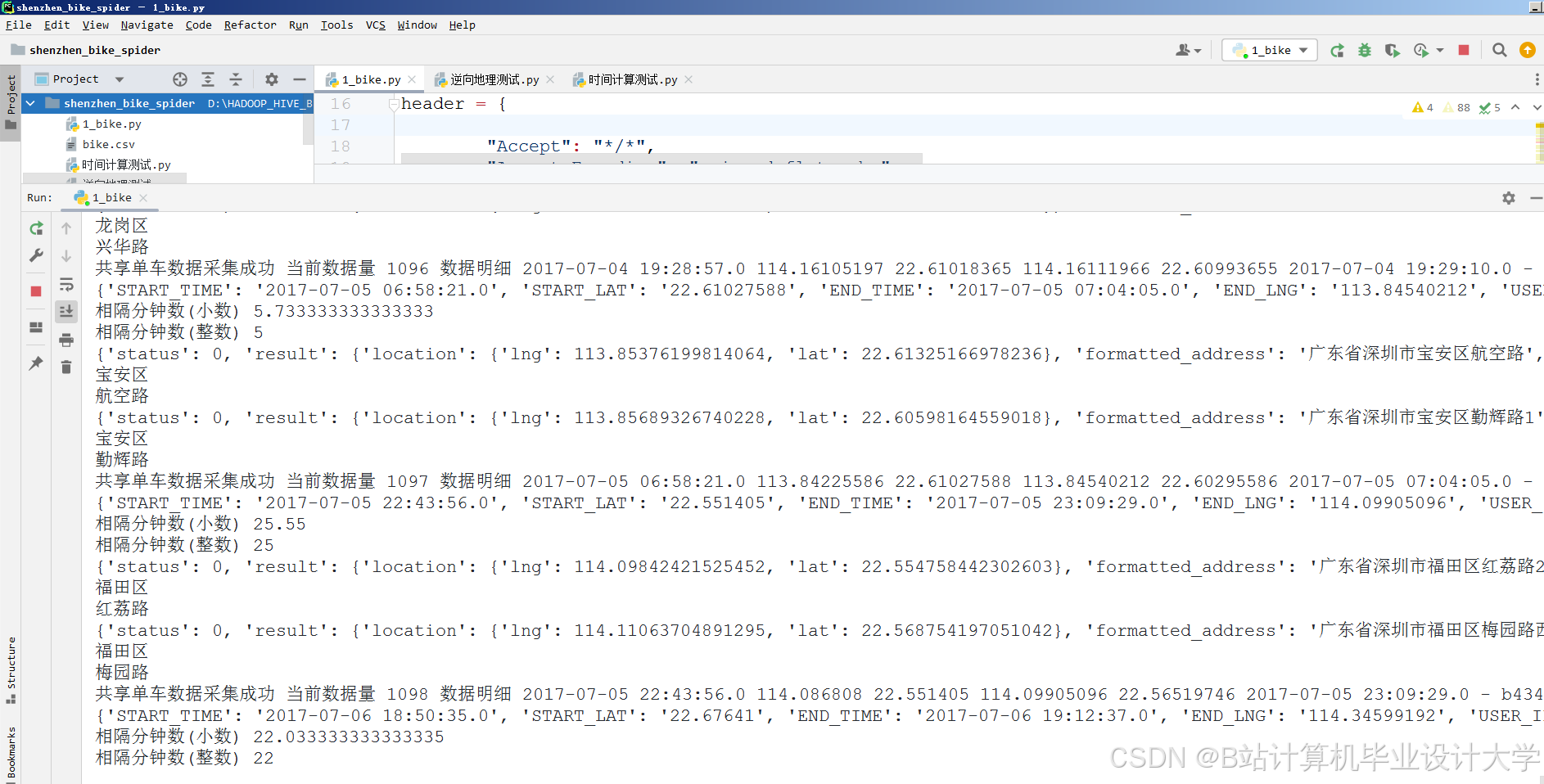

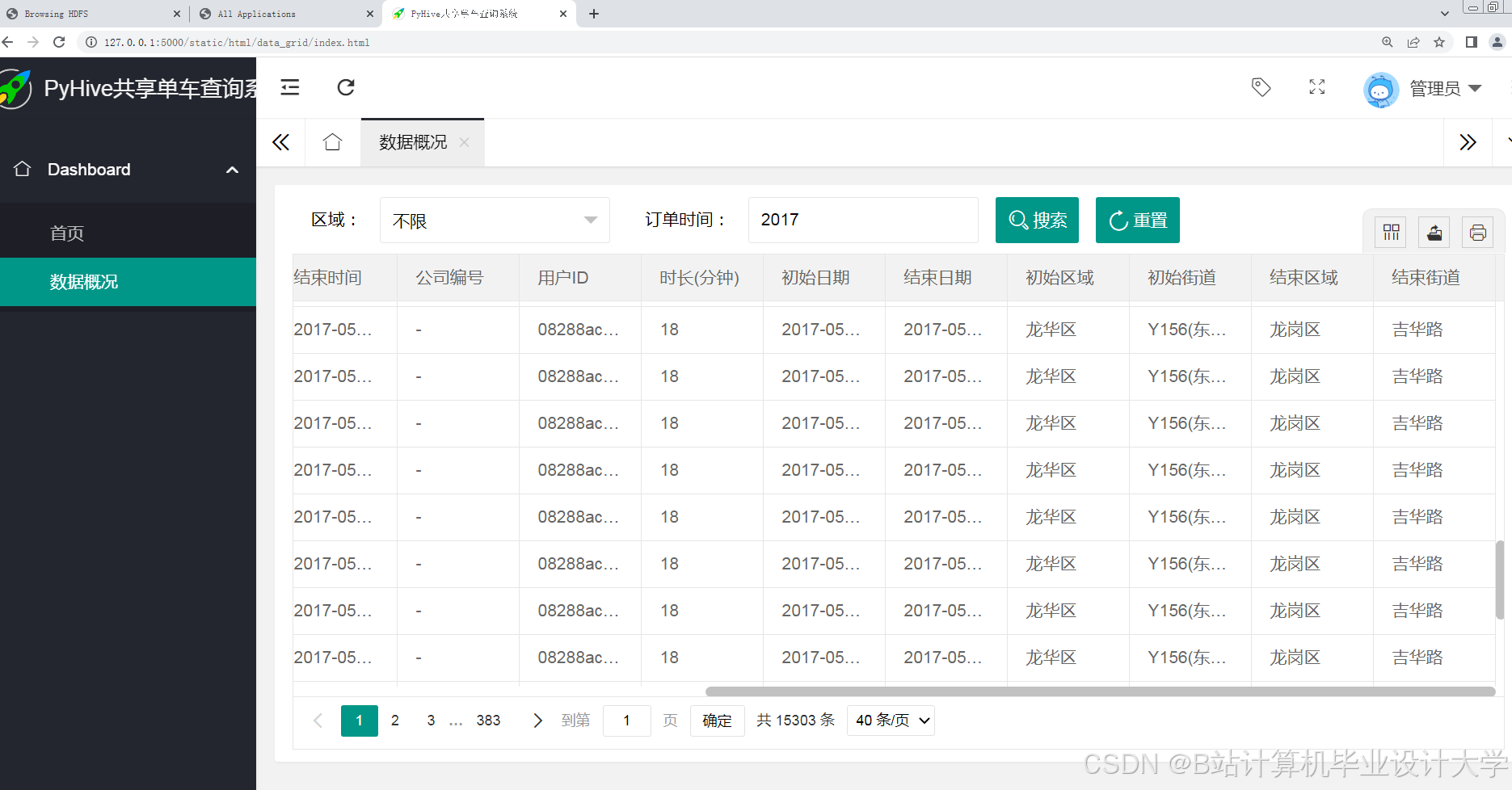

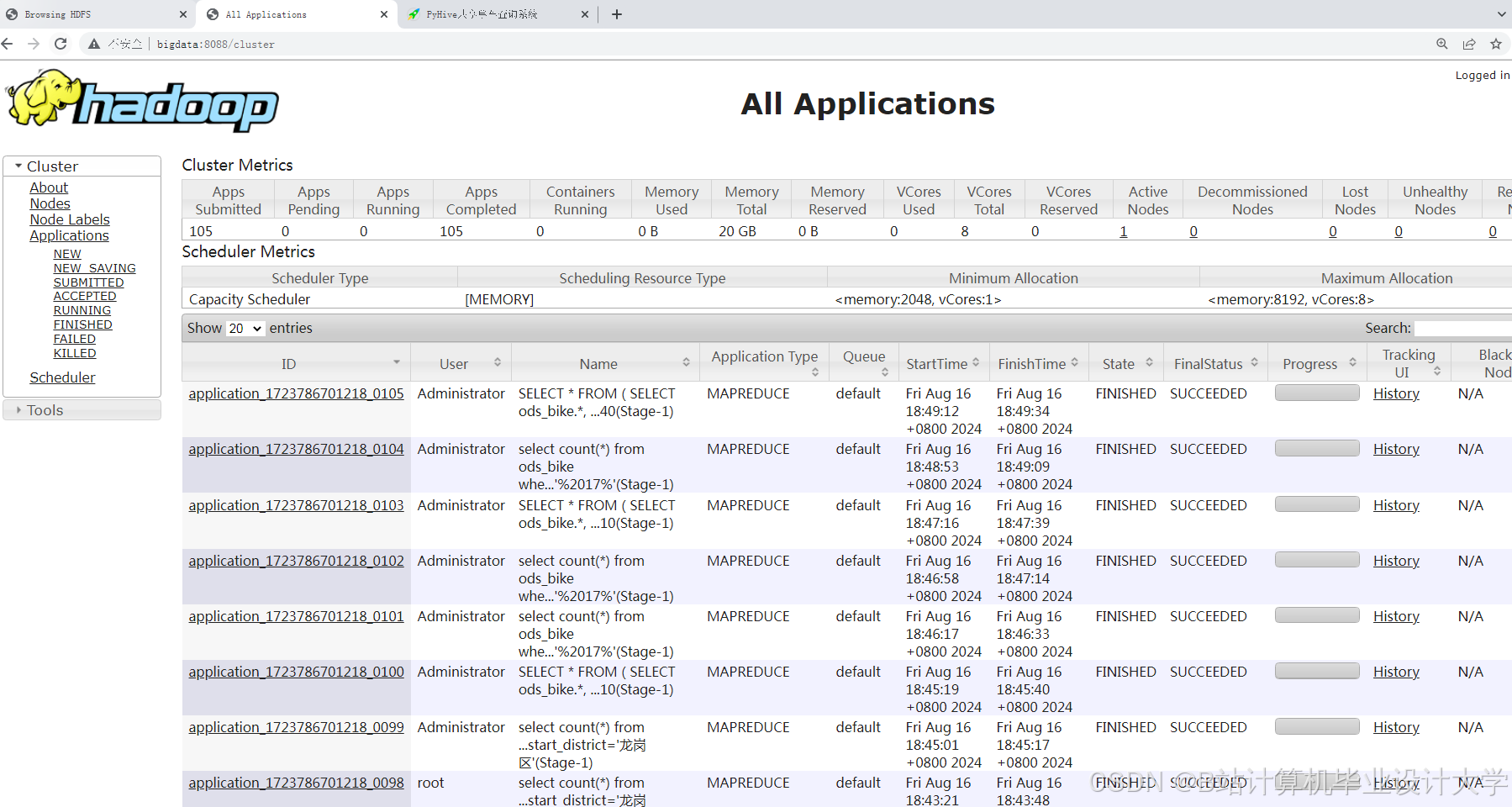

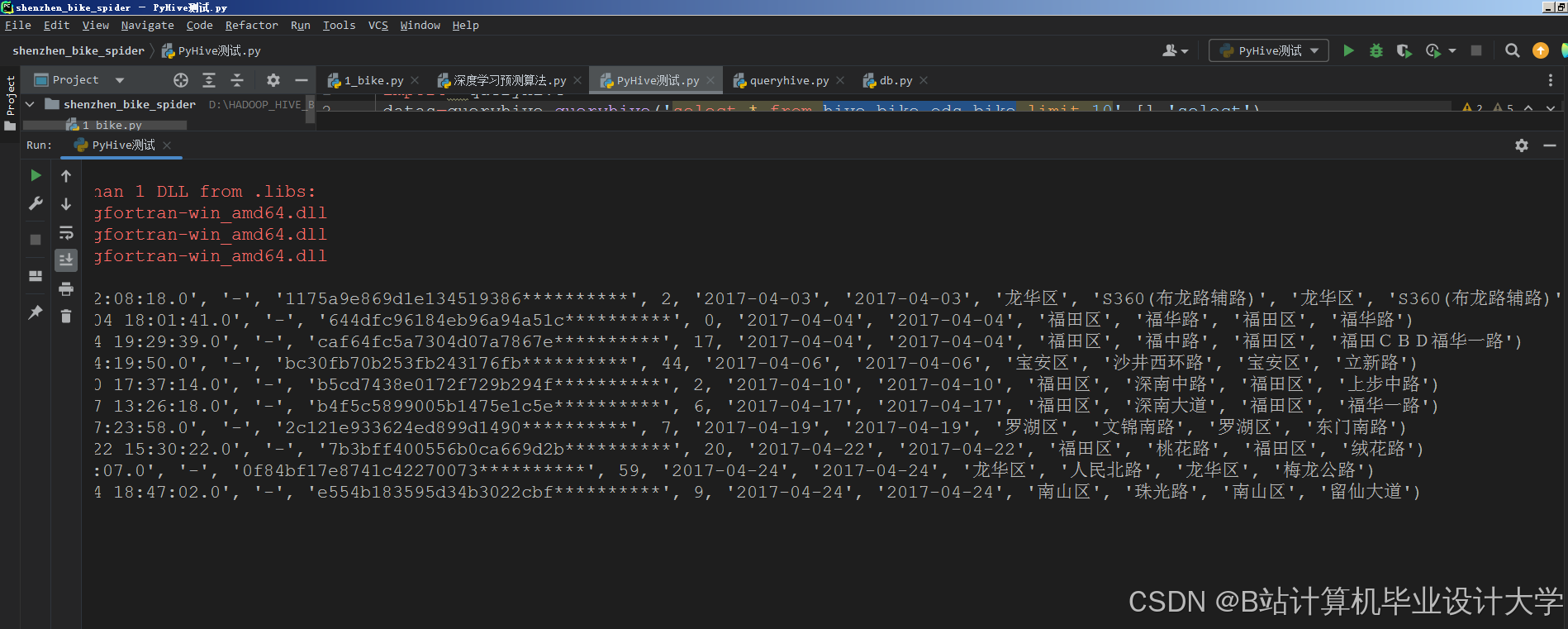

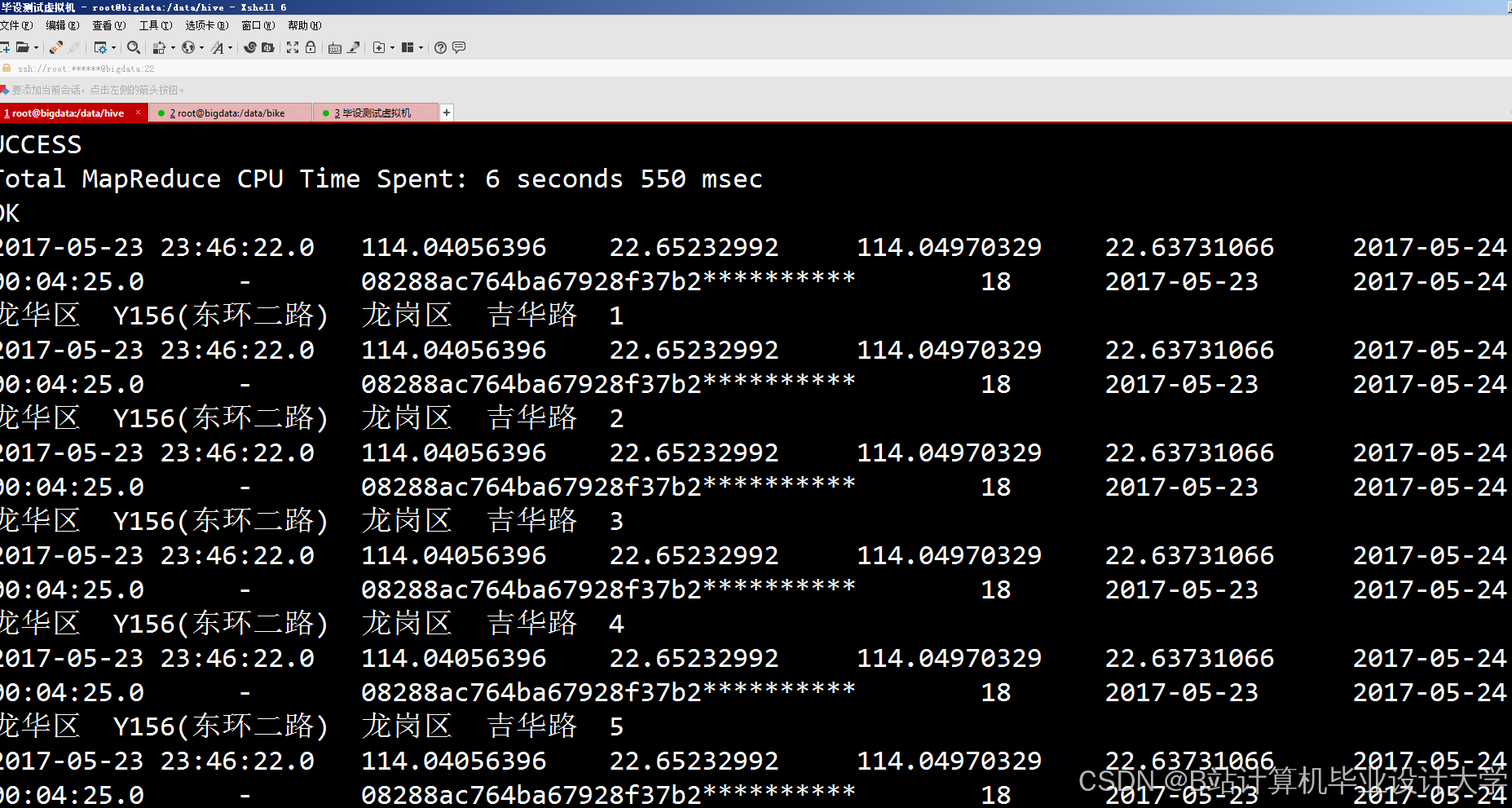

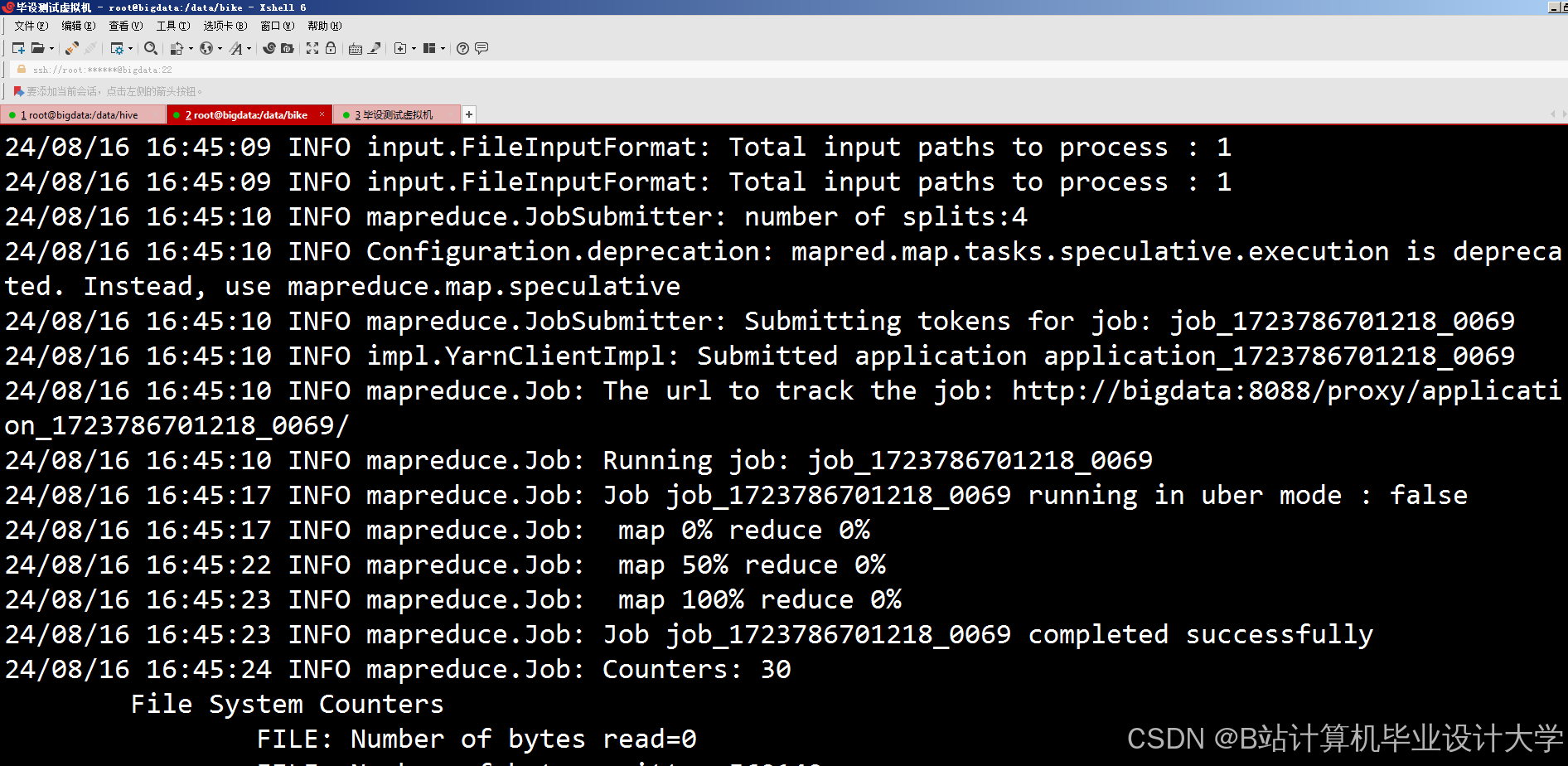

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

Hadoop+Spark共享单车预测系统

Hadoop+Spark共享单车预测系统

1869

1869

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?