温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

开题报告:基于Hadoop+Spark+Hive的招聘推荐系统设计与实现

一、选题背景与意义

1.1 选题背景

随着互联网招聘平台的快速发展,企业发布的职位信息和求职者投递的简历数量呈爆炸式增长。传统招聘系统主要依赖关键词匹配或简单排序算法,存在以下问题:

- 信息过载:求职者难以从海量职位中快速找到匹配岗位,企业也难以精准筛选合适人才。

- 匹配效率低:传统方法无法充分挖掘求职者技能、经验与职位要求的潜在关联,导致推荐结果相关性不足。

- 冷启动问题:新注册用户或新发布职位因历史数据缺失,难以获得有效推荐。

1.2 选题意义

本课题旨在构建一个基于Hadoop+Spark+Hive的智能招聘推荐系统,通过分布式计算与机器学习技术,实现以下目标:

- 提升匹配精度:结合求职者简历特征、职位需求及企业偏好,构建多维度推荐模型。

- 支持大规模数据处理:利用Hadoop分布式存储与Spark内存计算,处理亿级用户行为日志与简历数据。

- 解决冷启动问题:通过混合推荐策略(协同过滤+内容推荐),优化新用户与新职位的推荐效果。

- 实时推荐能力:基于Spark Streaming实现用户行为实时分析,动态调整推荐结果。

本系统可应用于招聘平台、企业HR系统等领域,具有较高的商业价值与社会意义。

二、国内外研究现状

2.1 招聘推荐系统研究现状

- 国外研究:

- LinkedIn采用图神经网络(GNN)建模求职者与职位的关系网络,提升推荐准确性(如Job2Vec模型)。

- Indeed平台结合BERT自然语言处理技术,提取简历与职位描述的语义特征,优化匹配效果。

- 国内研究:

- 智联招聘提出多模态推荐框架,融合文本、图像(如证书扫描件)与行为数据。

- BOSS直聘基于强化学习动态调整推荐策略,提高用户响应率。

2.2 技术框架应用现状

- Hadoop生态:广泛应用于企业数据仓库建设,但传统MapReduce计算效率较低,需结合Spark提升实时性。

- Spark技术栈:

- Spark MLlib支持多种机器学习算法(如ALS协同过滤、XGBoost分类),适用于推荐场景。

- Spark Streaming可处理实时用户行为数据,支持增量模型更新。

- Hive数据仓库:作为结构化数据存储中间层,简化复杂SQL查询,但需优化分区策略以提升性能。

2.3 现有研究不足

- 数据规模限制:多数研究基于小规模数据集,缺乏对亿级数据的处理能力验证。

- 特征工程单一:仅依赖文本匹配或简单统计特征,未充分挖掘用户行为序列与社交关系。

- 系统架构耦合:推荐引擎与数据处理模块未解耦,导致扩展性与维护性较差。

三、研究内容与技术路线

3.1 研究内容

- 数据采集与预处理:

- 采集求职者简历、职位详情、用户行为日志(如点击、投递、收藏)等多源数据。

- 使用Flume+Kafka实现实时数据管道,清洗异常值与缺失数据。

- 分布式存储与计算:

- 基于Hadoop HDFS存储原始数据,Hive管理结构化数据仓库。

- 利用Spark进行特征工程(如TF-IDF向量化、Word2Vec语义嵌入)与模型训练。

- 推荐算法设计:

- 协同过滤:基于ALS算法挖掘求职者与职位的隐式关联。

- 内容推荐:结合简历技能标签与职位描述关键词,计算相似度。

- 混合模型:融合协同过滤与内容推荐结果,通过加权投票或神经网络融合层优化输出。

- 实时推荐与性能优化:

- Spark Streaming监控用户实时行为,触发模型增量更新。

- Redis缓存高频推荐结果,降低系统延迟。

3.2 技术路线

mermaid

graph TD | |

A[数据采集] --> B[Flume+Kafka] | |

B --> C[Hadoop HDFS存储] | |

C --> D[Hive数据仓库] | |

D --> E[Spark特征工程] | |

E --> F[推荐算法模块] | |

F --> G[Spark MLlib训练] | |

G --> H[模型评估与调优] | |

H --> I[实时推荐服务] | |

I --> J[Redis缓存] | |

J --> K[Web API输出] |

四、系统架构设计

4.1 整体架构

系统分为五层:

- 数据采集层:Flume(日志收集)、Kafka(消息队列)。

- 存储层:HDFS(原始数据)、Hive(结构化数据)、Redis(缓存)。

- 计算层:Spark Core(批处理)、Spark Streaming(实时处理)、Spark MLlib(机器学习)。

- 推荐引擎层:ALS协同过滤、内容匹配、混合模型。

- 应用层:Web服务(Flask/Django)、移动端API。

4.2 核心模块设计

- 特征工程模块:

- 提取求职者特征(技能、工作年限、教育背景)、职位特征(行业、薪资、要求技能)。

- 使用Spark实现TF-IDF、Word2Vec、Graph Embedding(如DeepWalk)生成特征向量。

- 推荐算法模块:

- 离线训练:每日全量数据训练ALS模型,保存至HDFS。

- 在线推理:用户请求触发Spark加载模型,结合Redis缓存生成推荐列表。

- 实时更新模块:

- 监控用户投递行为,通过Spark Streaming更新用户偏好向量,动态调整推荐权重。

五、实验方案与预期成果

5.1 实验环境

- 集群配置:

- Hadoop 3.3.0(3台Master + 10台Worker,每节点32核CPU/128GB内存/10TB磁盘)。

- Spark 3.3.0(Standalone模式,动态资源分配)。

- Hive 3.1.2(MySQL元数据库)。

- 数据集:

- 模拟数据:生成1000万条求职者简历、50万条职位信息、1亿条用户行为日志。

- 公开数据集:使用Kaggle招聘数据集(如“Resume Dataset”)扩展测试。

5.2 评估指标

- 准确率:推荐职位中用户实际投递的比例(Precision@K)。

- 多样性:推荐职位覆盖的行业、薪资范围分布(Shannon熵)。

- 实时性:从用户请求到返回推荐列表的延迟(<500ms)。

5.3 预期成果

- 完成系统原型开发,支持日均处理1亿条用户行为日志。

- 推荐准确率较传统关键词匹配提升20%以上(Precision@10≥0.75)。

- 发表核心期刊论文1篇,申请软件著作权1项。

六、进度安排

| 阶段 | 时间 | 任务 |

|---|---|---|

| 需求分析 | 第1-2周 | 调研招聘平台业务逻辑,确定功能需求 |

| 数据准备 | 第3-4周 | 搭建Hadoop集群,生成模拟数据集 |

| 系统开发 | 第5-10周 | 实现特征工程、推荐算法与Web服务 |

| 测试优化 | 第11-12周 | 性能调优,撰写论文与专利 |

七、参考文献

- Zhang Y, et al. "Job Recommendation with Deep Learning and Graph Embedding." WWW 2022.

- 王伟等. "基于Spark的实时推荐系统设计与实现." 计算机工程与应用, 2021.

- Apache Hadoop Documentation. Hadoop – Apache Hadoop 3.4.1.

- Apache Spark MLlib Guide. MLlib: Main Guide - Spark 4.0.0 Documentation.

指导教师意见:

(待填写)

开题日期:

(待填写)

备注:本开题报告需结合具体实验数据与代码实现进一步细化,后续可扩展多目标优化(如平衡企业招聘效率与求职者满意度)或引入联邦学习保护隐私。

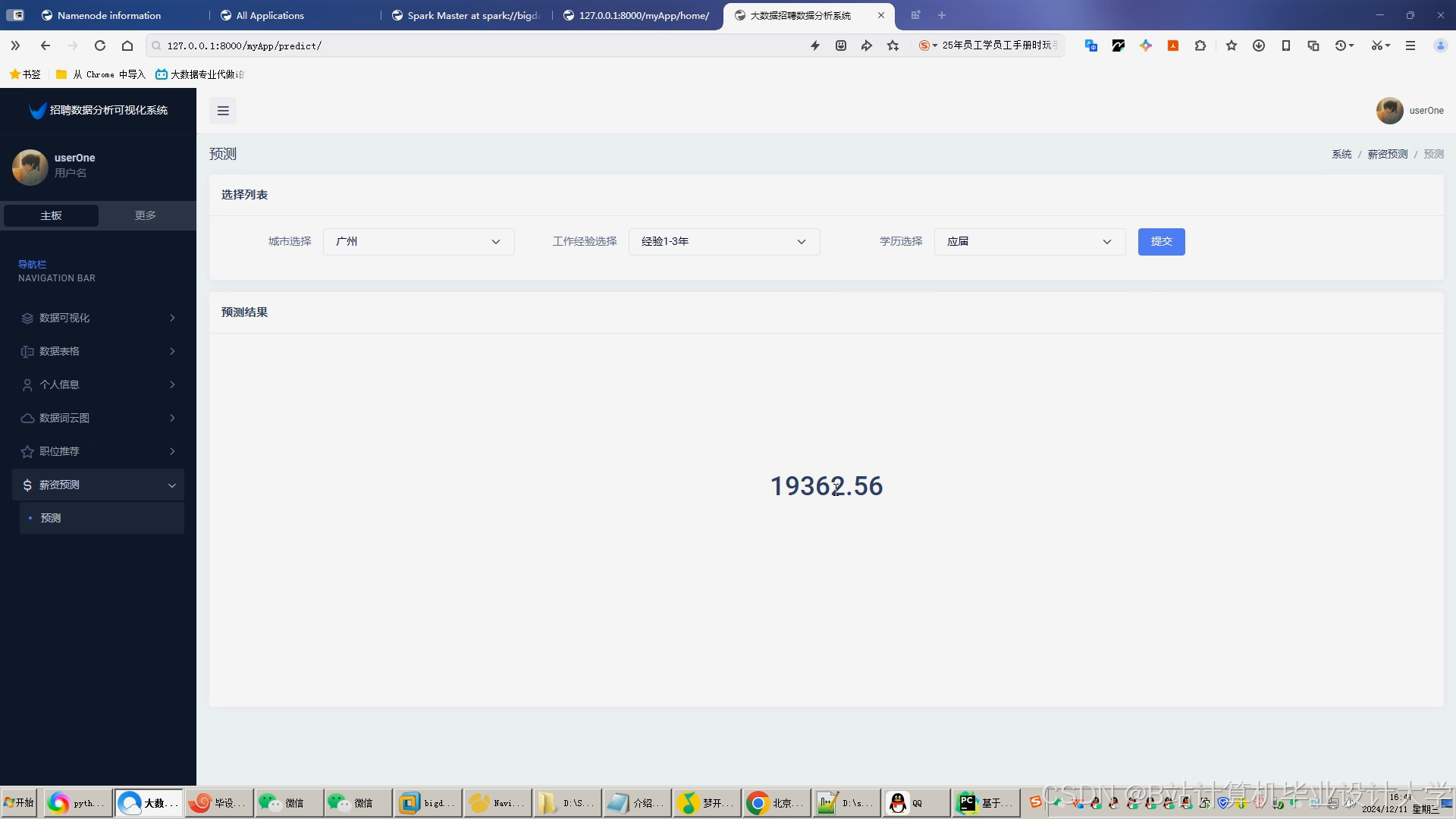

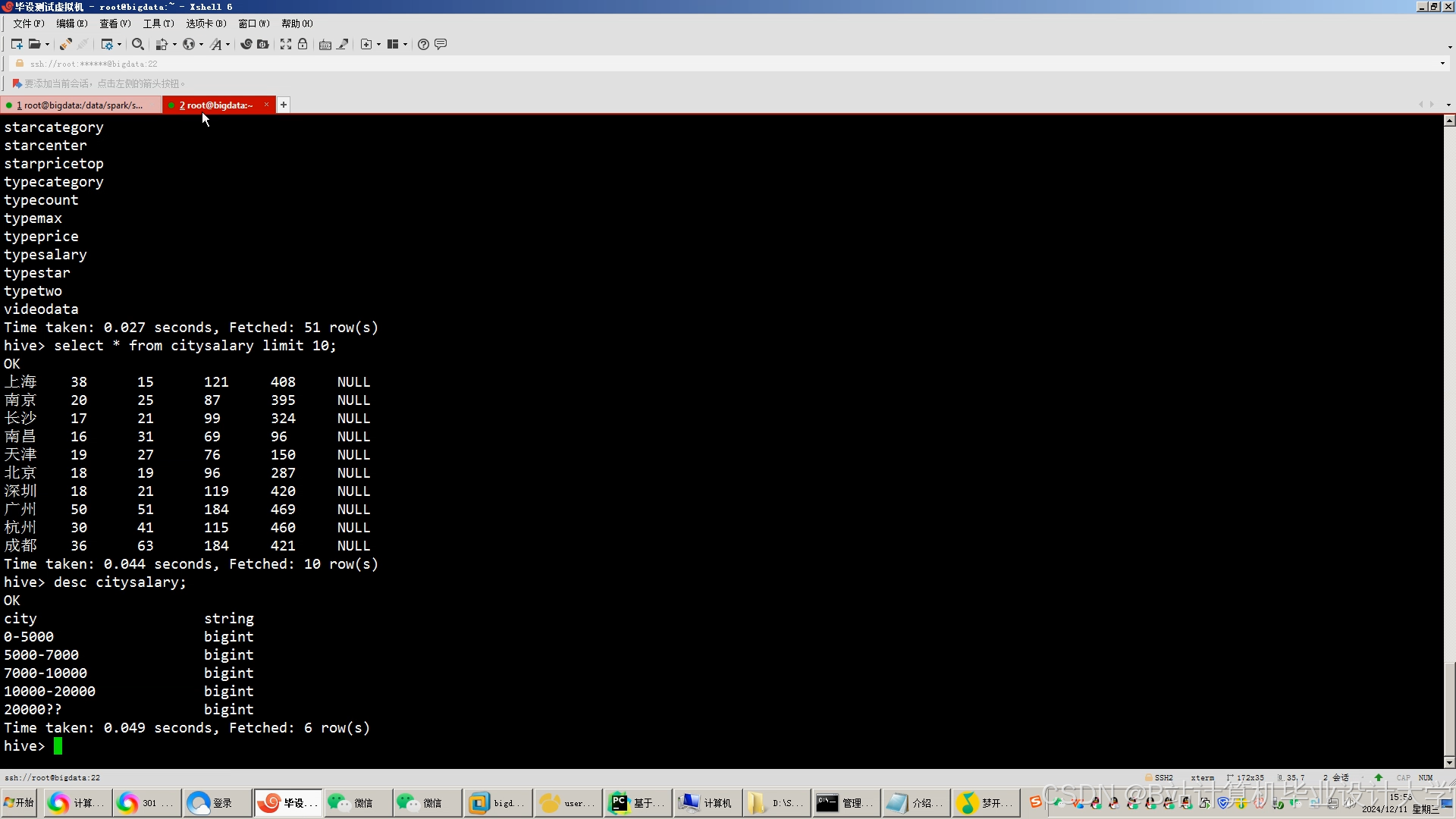

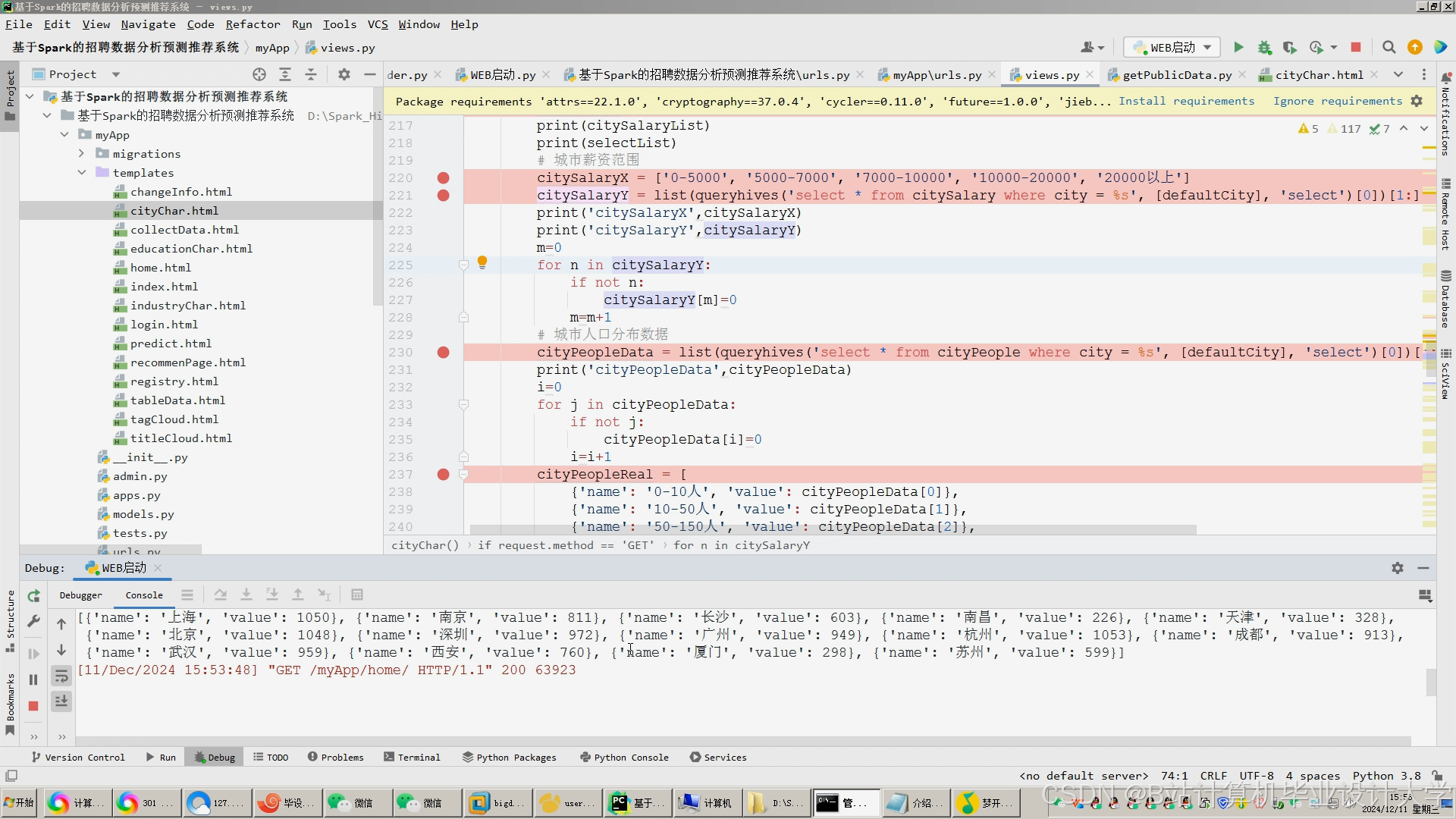

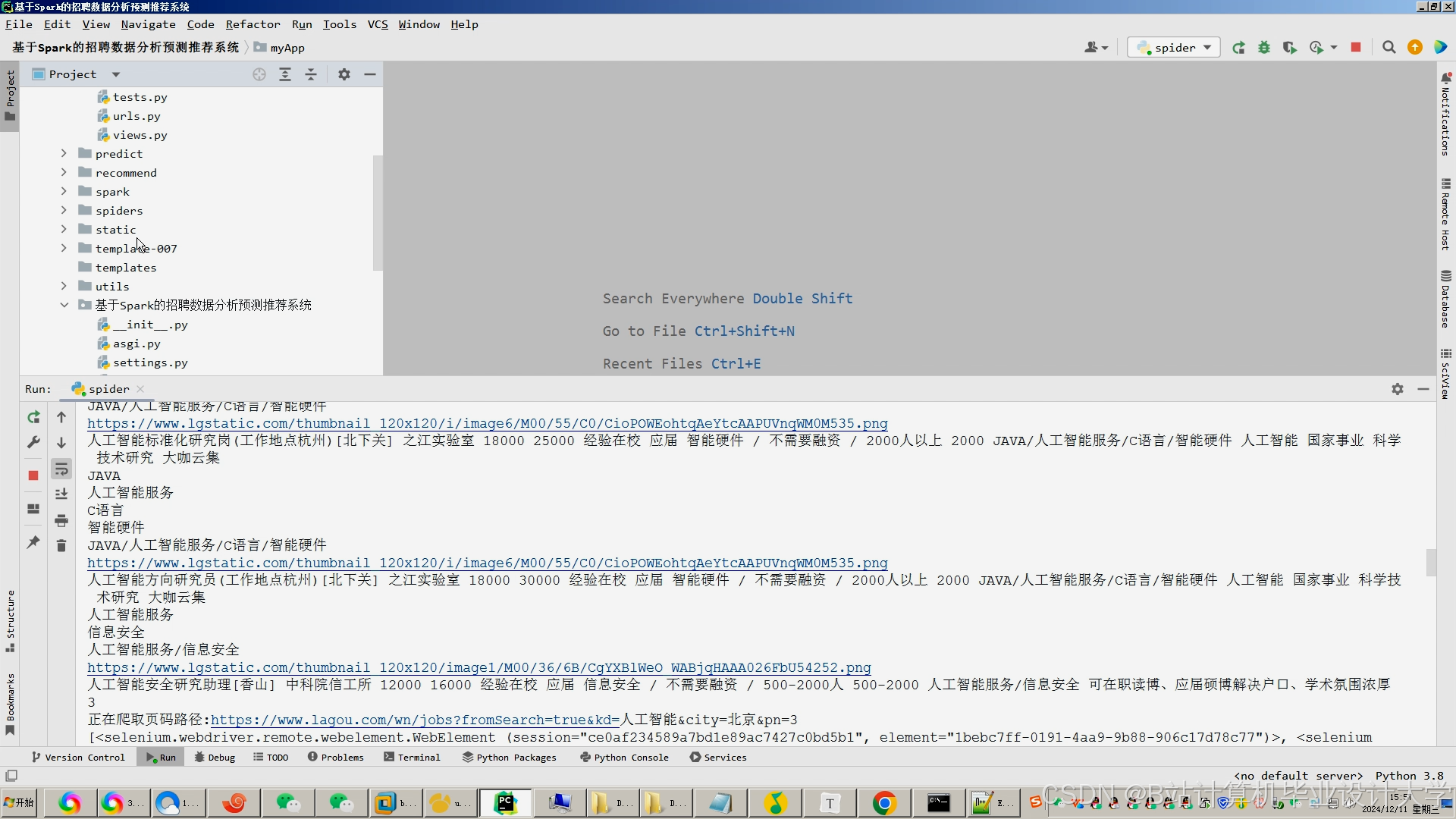

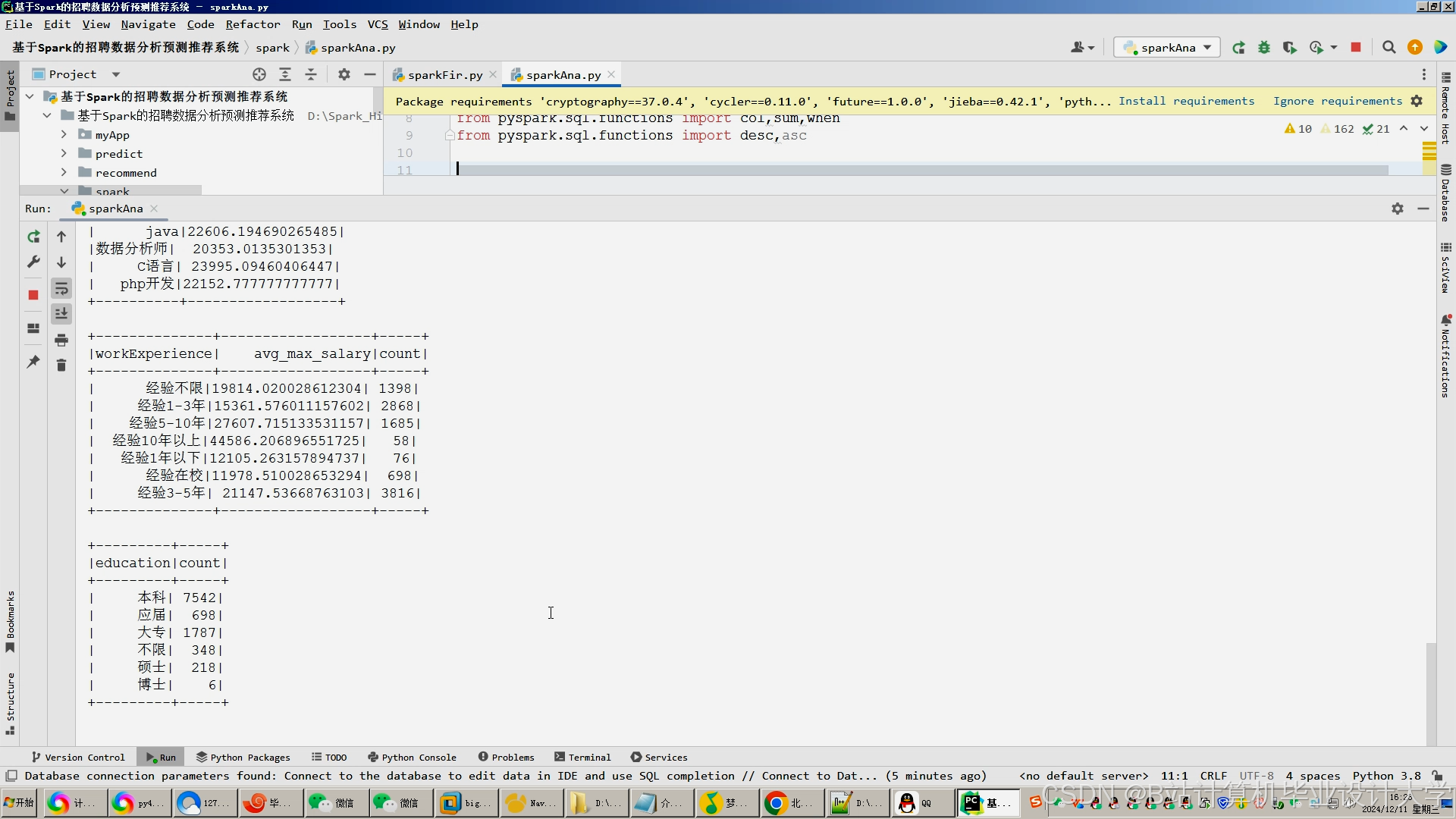

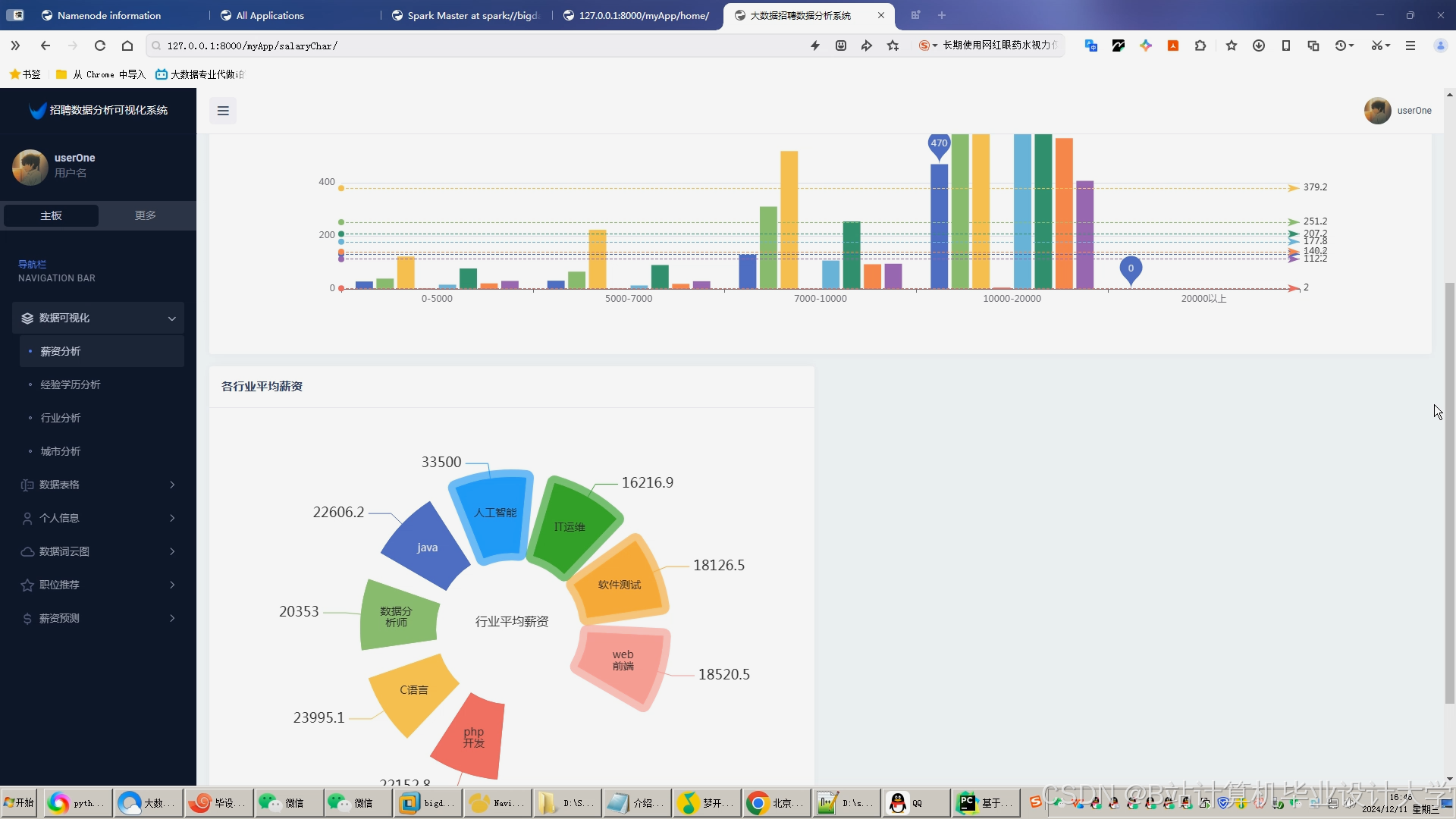

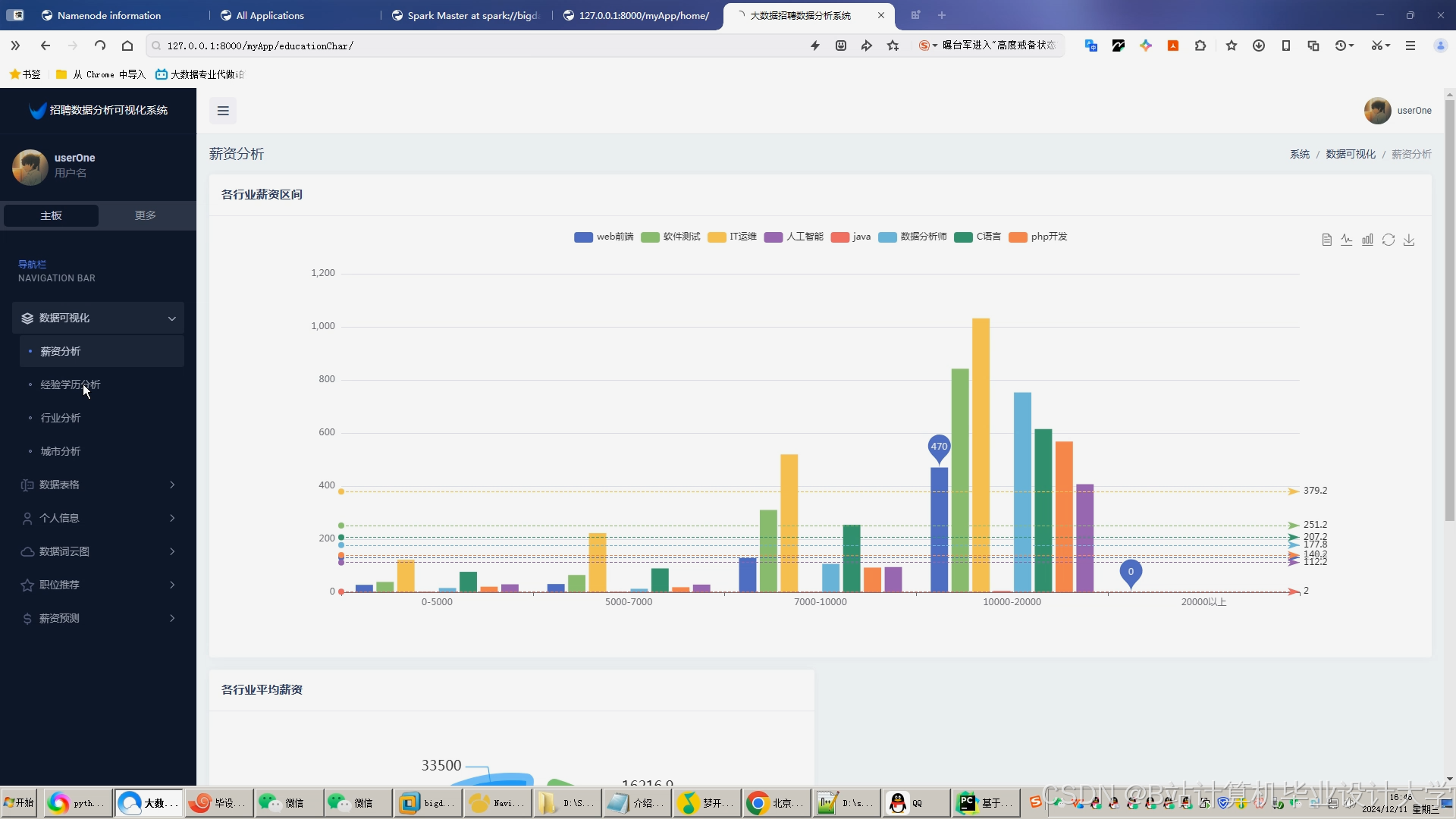

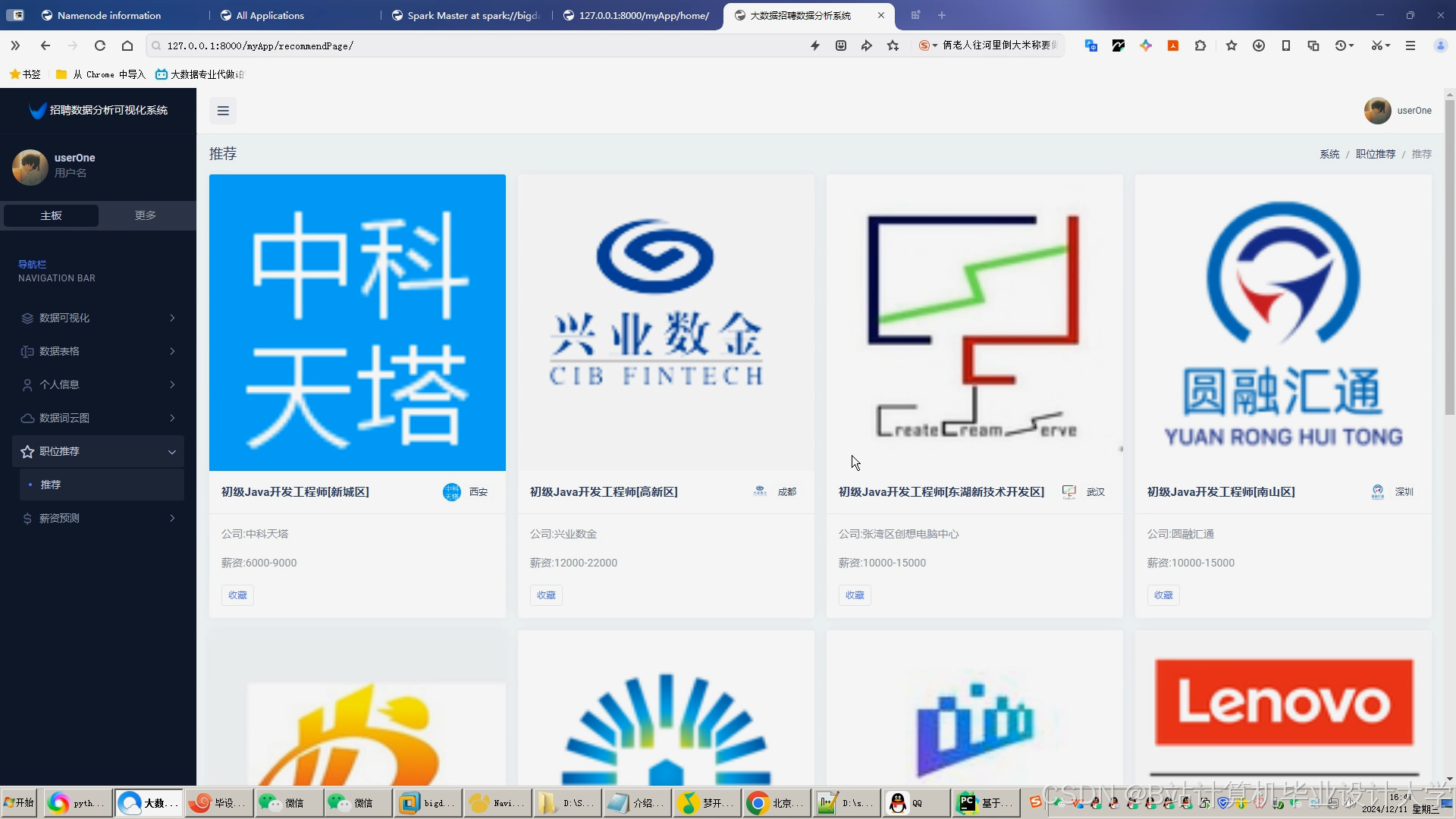

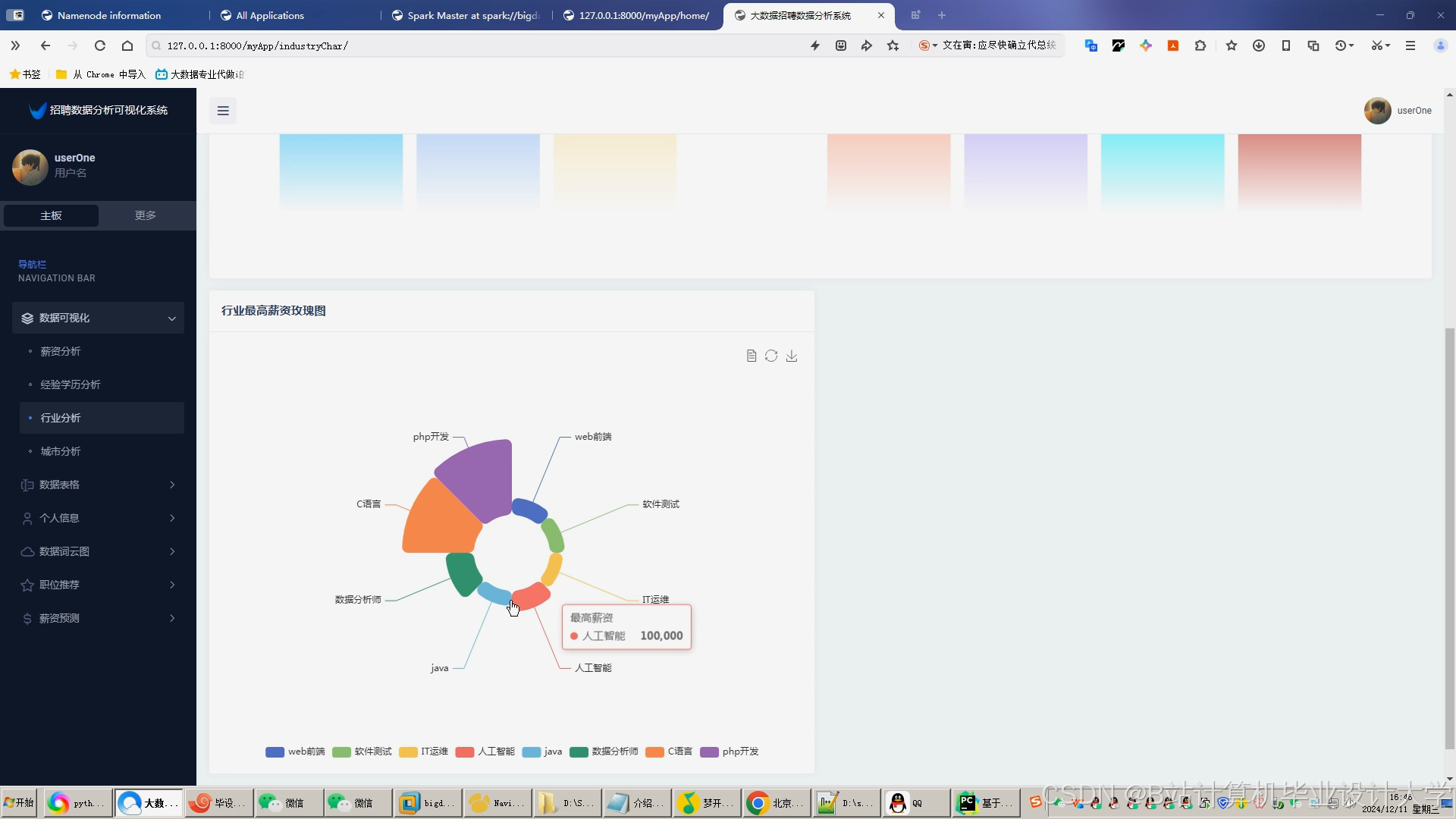

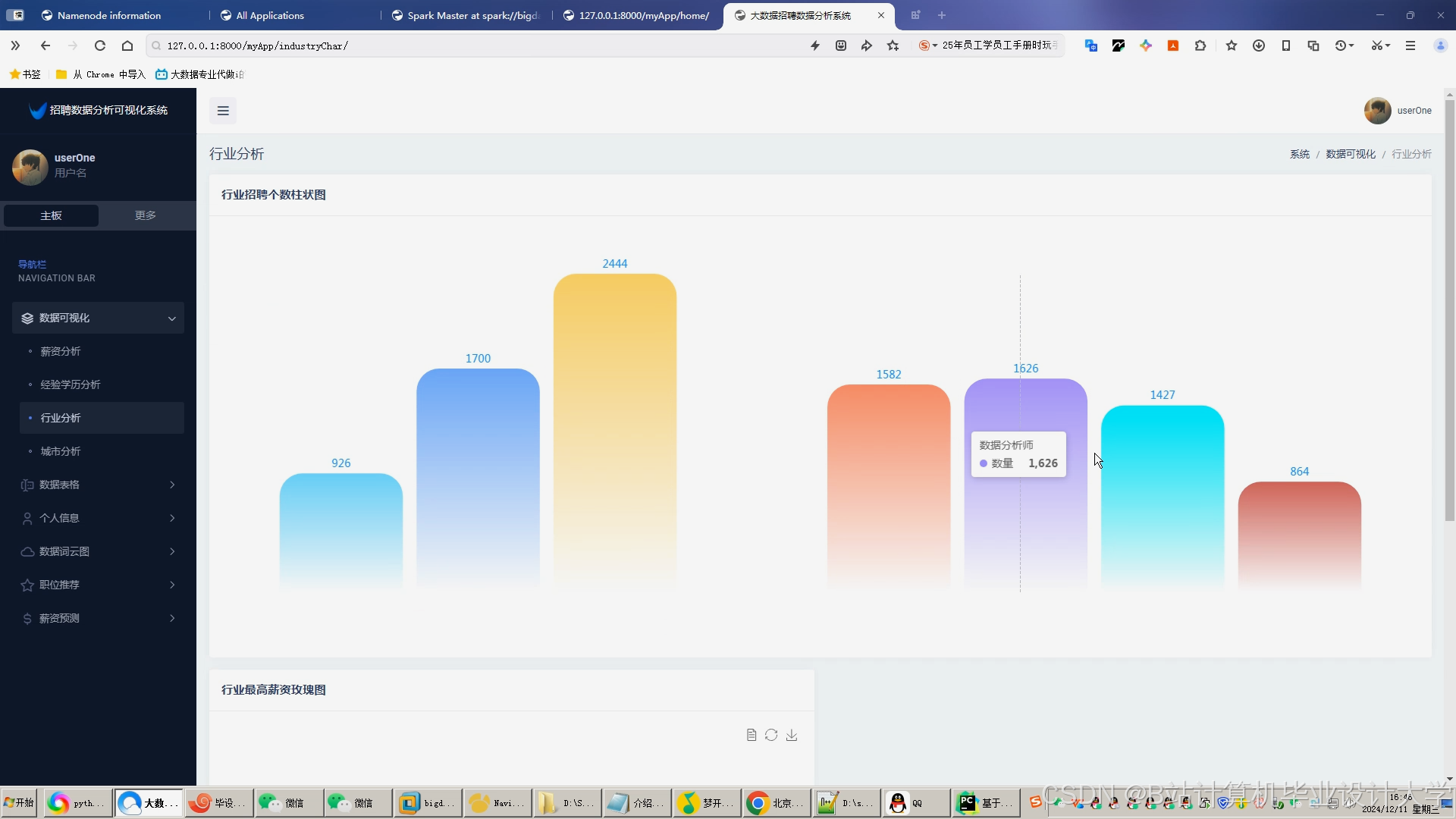

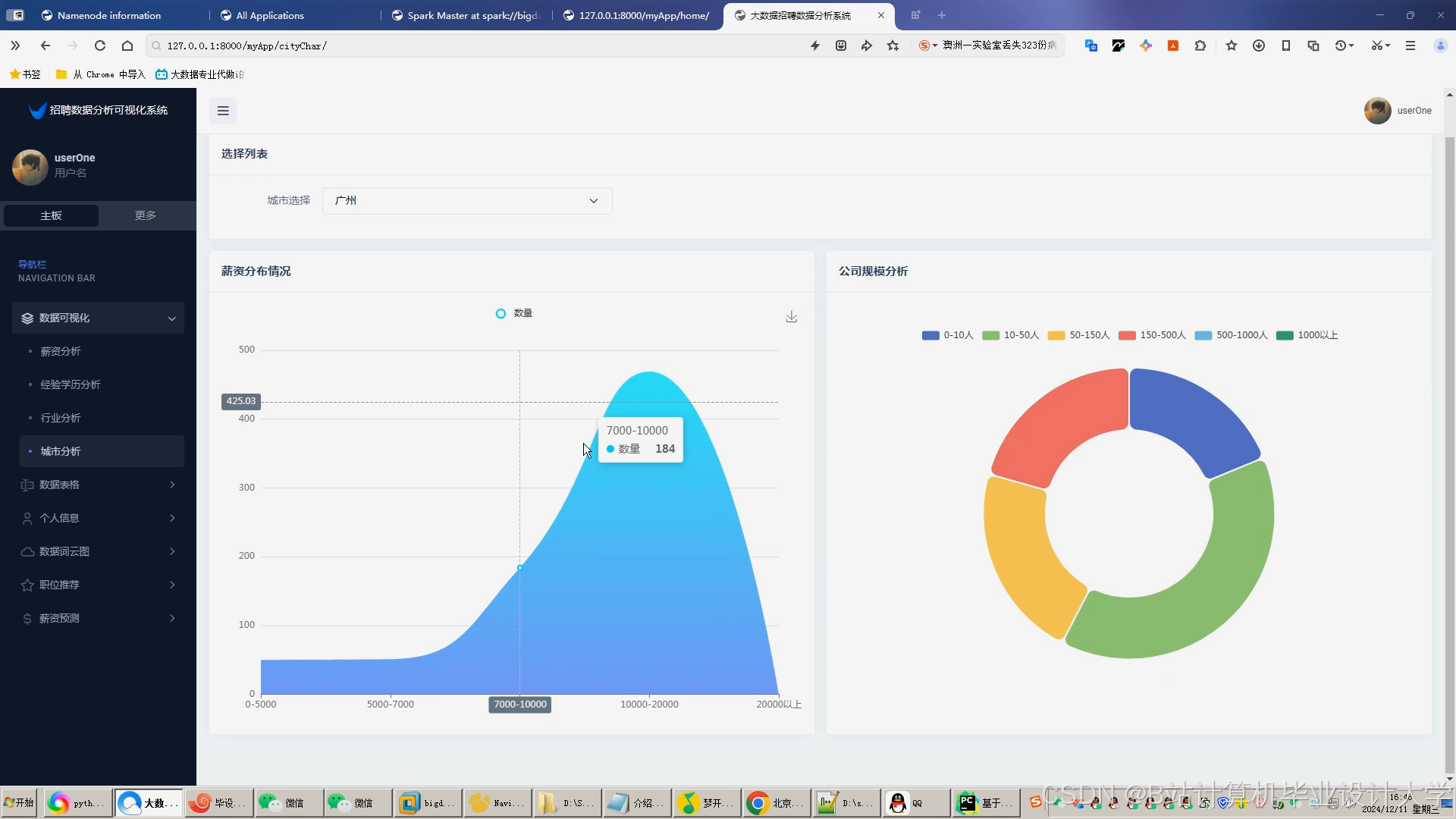

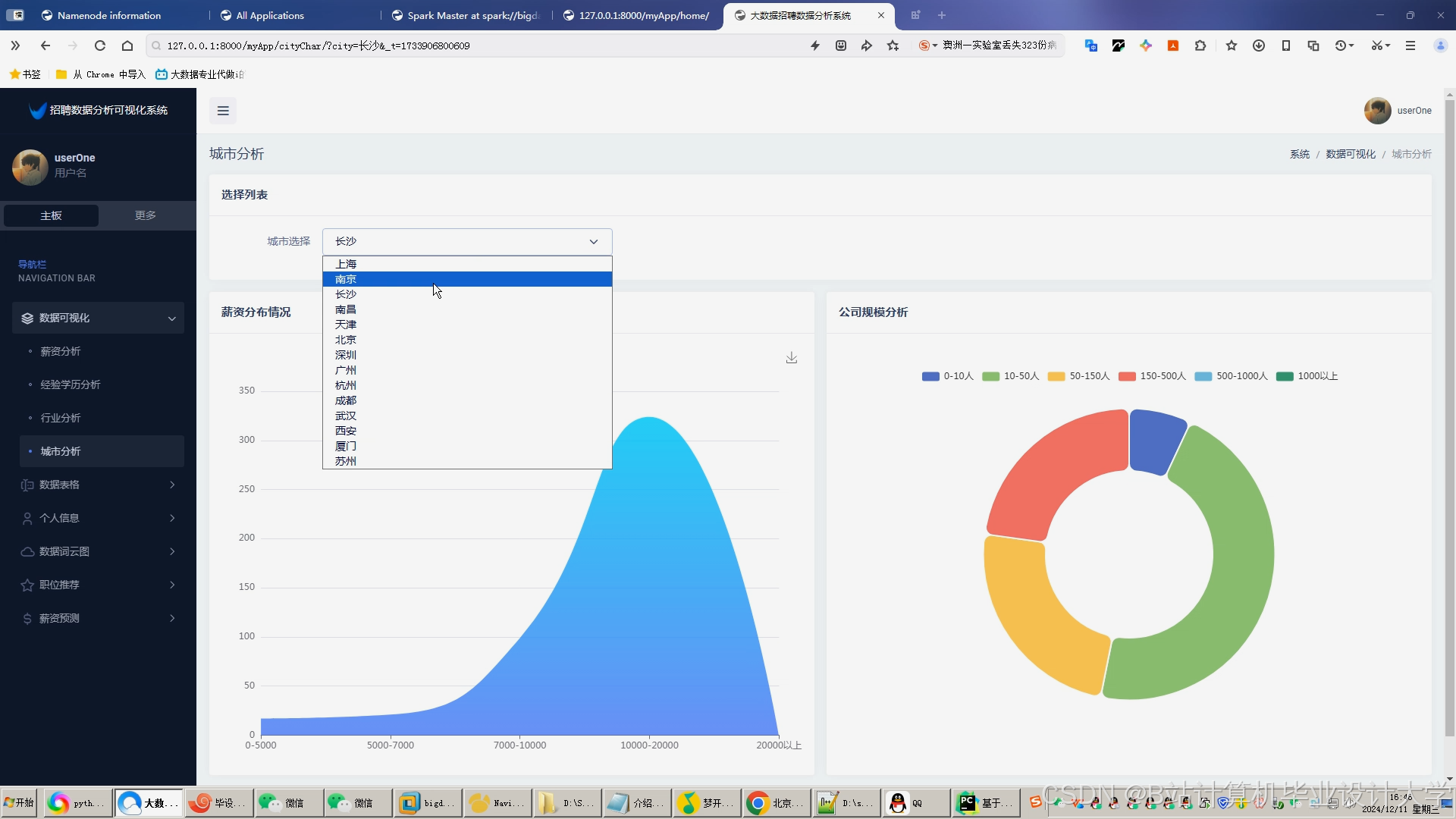

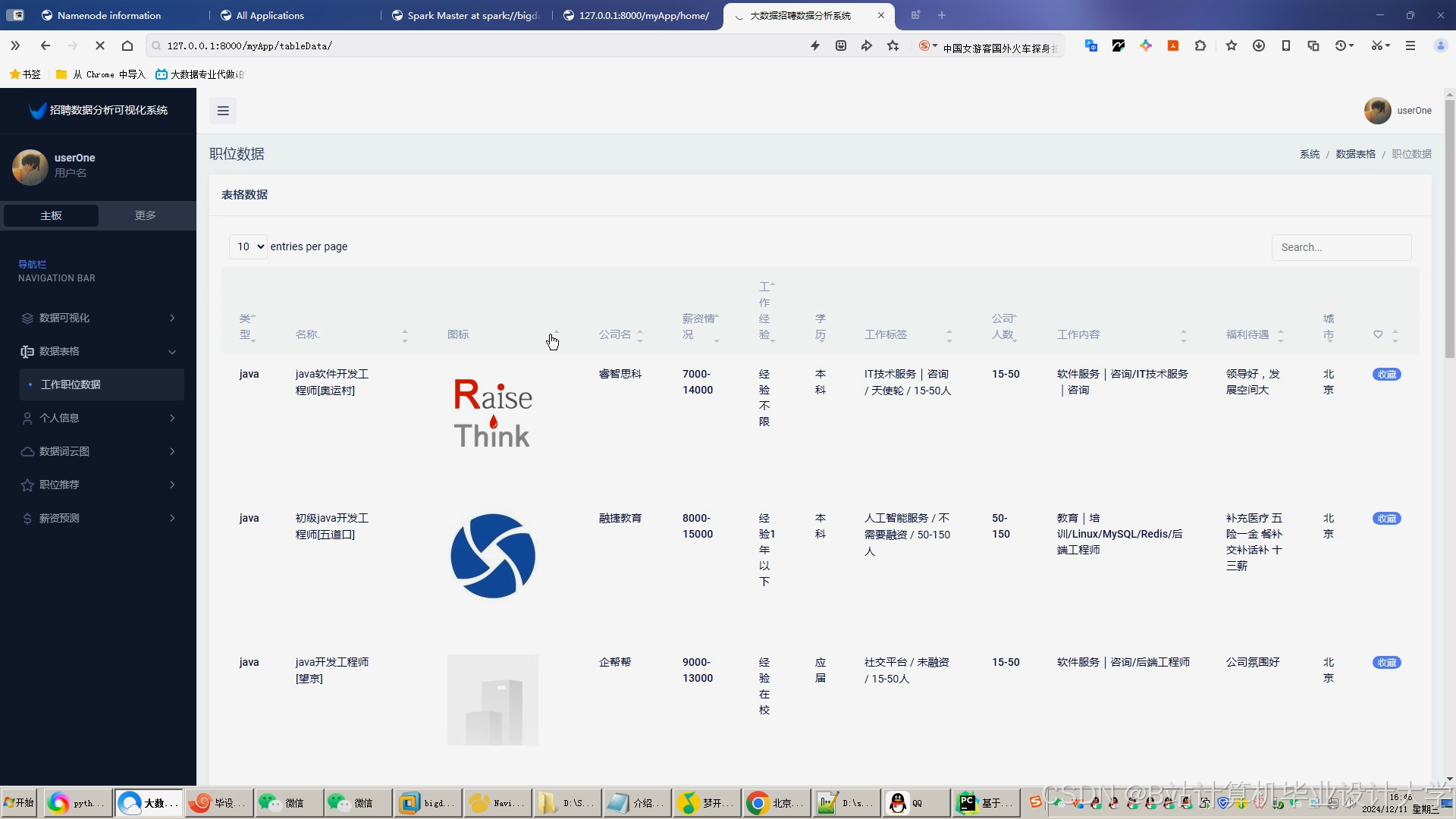

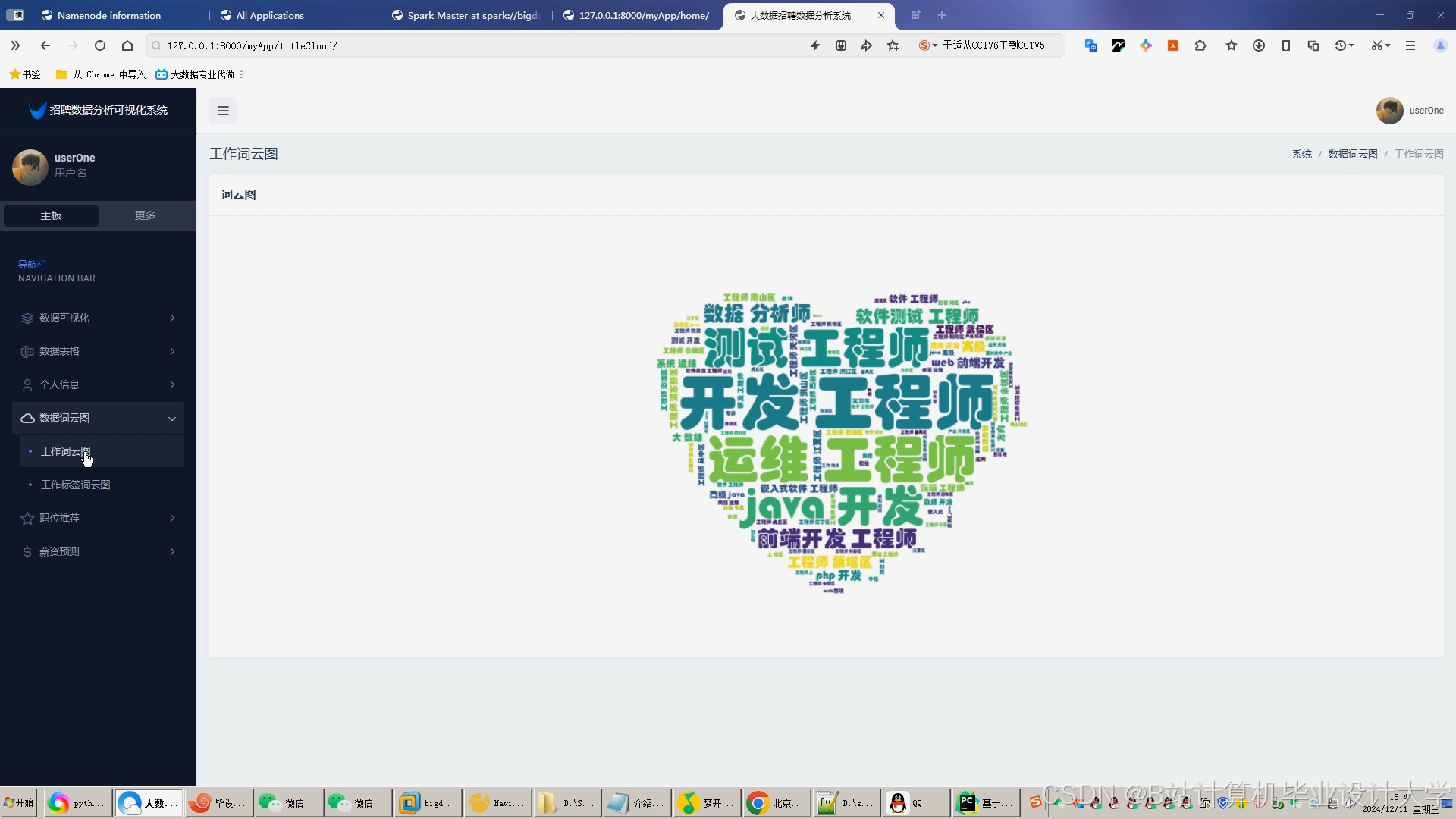

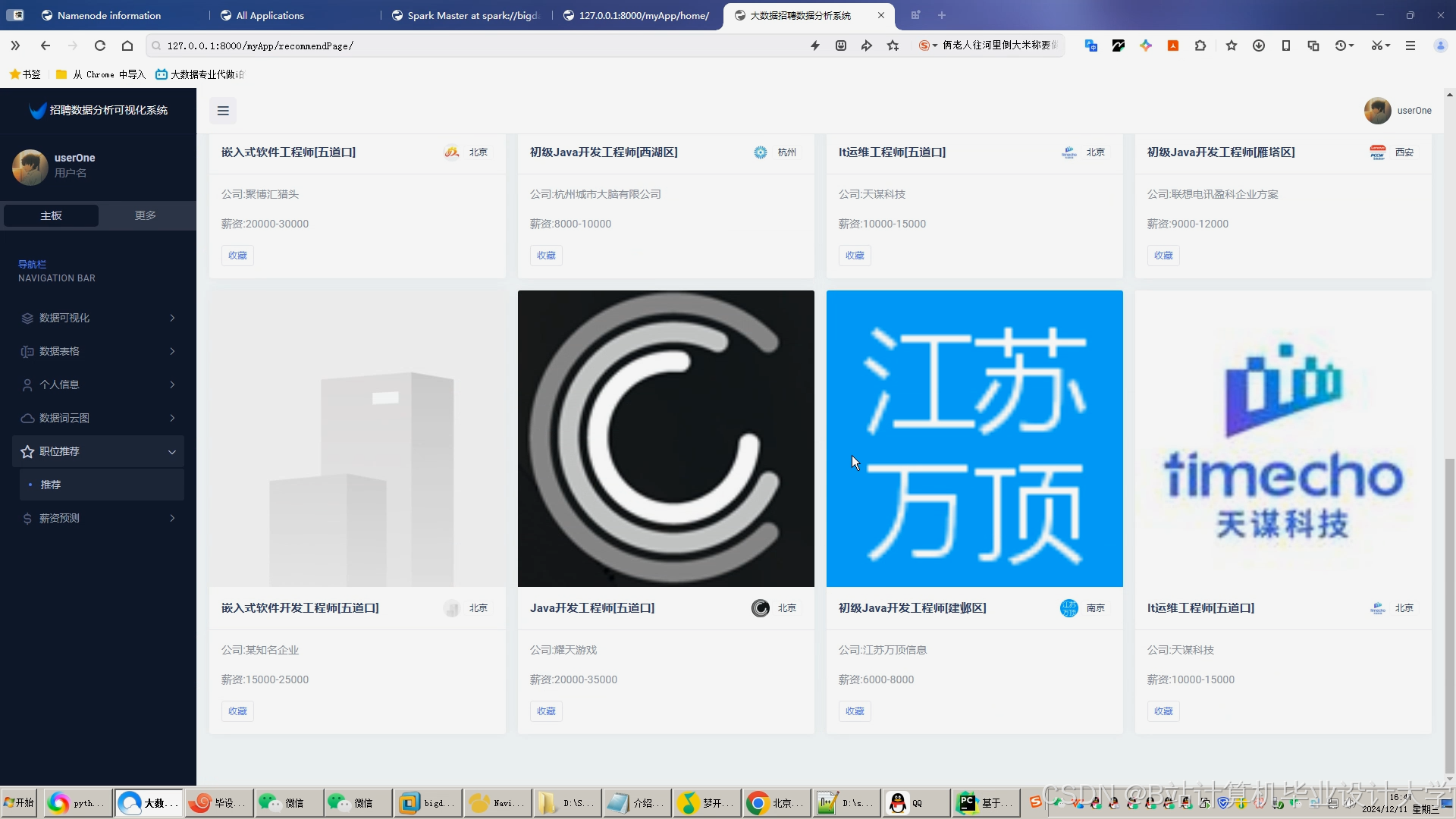

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

413

413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?