温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

任务书:基于Hadoop+Spark+Hive的招聘推荐系统开发

一、项目基本信息

- 项目名称:基于Hadoop+Spark+Hive的智能招聘推荐系统

- 项目负责人:[姓名]

- 团队成员:[成员1、成员2、成员3(根据实际分工填写)]

- 起止时间:[开始日期] 至 [结束日期]

- 项目背景:

针对传统招聘系统匹配效率低、数据规模受限等问题,本项目旨在利用Hadoop分布式存储、Spark内存计算与Hive数据仓库技术,构建一个高并发、高可扩展的智能招聘推荐系统,实现求职者与职位的精准匹配,并支持实时推荐更新。

二、项目目标

2.1 总体目标

开发一套基于Hadoop+Spark+Hive的招聘推荐系统,支持以下功能:

- 大规模数据处理:存储并分析亿级求职者简历、职位信息及用户行为日志。

- 多维度推荐算法:结合协同过滤、内容匹配与混合模型,提升推荐准确性。

- 实时推荐能力:通过Spark Streaming处理用户实时行为,动态调整推荐结果。

- 系统可扩展性:支持横向扩展集群节点,应对业务增长需求。

2.2 具体目标

| 目标类别 | 详细描述 |

|---|---|

| 功能目标 | 实现用户注册/登录、职位搜索、推荐列表展示、投递反馈等核心功能。 |

| 性能目标 | 支持日均处理1亿条用户行为日志,推荐响应时间≤500ms,系统吞吐量≥1000 QPS。 |

| 技术目标 | 完成Hadoop集群部署、Spark特征工程与模型训练、Hive数据仓库优化。 |

三、任务分解与分工

3.1 任务分解

项目分为以下模块,各模块任务及交付物如下:

模块1:数据采集与预处理

- 任务内容:

- 搭建Flume+Kafka数据管道,采集用户行为日志(点击、投递、收藏)。

- 使用Python脚本清洗异常数据(如缺失字段、重复记录)。

- 将清洗后数据存储至Hadoop HDFS。

- 交付物:

- 数据采集脚本(Flume配置文件、Kafka生产者/消费者代码)。

- 数据清洗规则文档。

- HDFS存储路径说明。

模块2:分布式存储与计算环境搭建

- 任务内容:

- 部署Hadoop集群(3台Master节点+10台Worker节点),配置HDFS、YARN资源管理。

- 部署Spark集群(Standalone模式),配置动态资源分配。

- 搭建Hive数据仓库,创建外部表映射HDFS原始数据。

- 交付物:

- 集群部署文档(含配置参数、网络拓扑图)。

- Hive表结构定义SQL脚本。

模块3:特征工程与推荐算法开发

- 任务内容:

- 特征提取:

- 使用Spark MLlib实现TF-IDF向量化简历文本与职位描述。

- 通过Word2Vec生成技能标签的语义嵌入向量。

- 推荐算法:

- 实现ALS协同过滤算法,挖掘求职者-职位隐式关联。

- 设计混合模型(协同过滤+内容匹配),通过加权投票融合结果。

- 模型训练:

- 使用Spark离线训练ALS模型,保存至HDFS。

- 通过Spark Streaming实时更新用户偏好向量。

- 特征提取:

- 交付物:

- 特征工程代码(Spark Scala/Python脚本)。

- 推荐算法实现代码与模型评估报告(Precision@K、Recall@K指标)。

模块4:实时推荐与缓存优化

- 任务内容:

- 搭建Redis集群,缓存高频推荐结果(如热门职位、用户历史偏好)。

- 实现Spark Streaming监听Kafka用户行为主题,触发模型增量更新。

- 开发Web服务接口(Flask/Django),封装推荐逻辑并返回JSON格式结果。

- 交付物:

- Redis缓存策略文档。

- Web服务API文档(含接口定义、请求/响应示例)。

模块5:系统测试与优化

- 任务内容:

- 使用JMeter模拟1000并发用户,测试系统吞吐量与响应时间。

- 优化Hive查询性能(分区表设计、索引优化)。

- 调整Spark executor内存与CPU分配,避免OOM错误。

- 交付物:

- 压力测试报告(含性能瓶颈分析与优化建议)。

- 系统优化前后对比数据。

3.2 团队分工

| 成员姓名 | 职责 |

|---|---|

| [成员1] | 负责数据采集模块开发与集群部署,协调整体进度。 |

| [成员2] | 实现特征工程与推荐算法,编写Spark计算逻辑。 |

| [成员3] | 开发Web服务接口与Redis缓存,完成系统测试与文档撰写。 |

四、时间计划

| 阶段 | 时间范围 | 任务内容 |

|---|---|---|

| 需求分析 | 第1周 | 调研招聘平台业务逻辑,明确功能需求与非功能需求(如性能、安全性)。 |

| 环境搭建 | 第2-3周 | 完成Hadoop/Spark/Hive集群部署,验证基础功能(如HDFS读写、Spark任务提交)。 |

| 核心开发 | 第4-8周 | 实现数据采集、特征工程、推荐算法与Web服务模块,完成单元测试。 |

| 集成测试 | 第9周 | 联调各模块,修复接口兼容性问题,优化系统性能。 |

| 验收交付 | 第10周 | 编写用户手册与技术文档,提交项目代码与测试报告,进行最终验收。 |

五、资源需求

5.1 硬件资源

| 资源类型 | 规格与数量 | 用途 |

|---|---|---|

| 服务器 | 32核CPU/128GB内存/10TB磁盘 × 13台 | 部署Hadoop/Spark集群 |

| 网络设备 | 千兆交换机 × 2台 | 集群内网通信 |

5.2 软件资源

| 软件名称 | 版本 | 用途 |

|---|---|---|

| Hadoop | 3.3.0 | 分布式存储与资源管理 |

| Spark | 3.3.0 | 内存计算与机器学习 |

| Hive | 3.1.2 | 结构化数据查询 |

| Redis | 6.2 | 缓存高频推荐结果 |

5.3 开发工具

- 编程语言:Scala(Spark核心逻辑)、Python(数据清洗/Web服务)。

- IDE:IntelliJ IDEA(Scala开发)、PyCharm(Python开发)。

- 版本控制:Git(代码托管)、Jenkins(持续集成)。

六、风险管理

| 风险类型 | 风险描述 | 应对措施 |

|---|---|---|

| 技术风险 | Spark任务执行超时或内存溢出 | 优化分区策略,调整executor内存参数,增加资源监控告警。 |

| 数据风险 | 原始数据质量差导致推荐效果不佳 | 加强数据清洗规则,引入人工抽样校验,增加特征重要性分析环节。 |

| 进度风险 | 模块联调阶段出现接口兼容性问题 | 提前定义API规范,使用Postman进行接口测试,预留1周缓冲时间。 |

七、交付成果

- 系统源代码:包含数据采集、特征工程、推荐算法、Web服务等模块完整代码。

- 技术文档:

- 《系统架构设计说明书》

- 《Hadoop/Spark集群部署指南》

- 《推荐算法原理与实现报告》

- 测试报告:

- 《压力测试报告》

- 《模型评估报告(Precision/Recall指标)》

- 演示视频:展示系统核心功能与操作流程(时长≤10分钟)。

项目负责人签字:________________

日期:________________

备注:本任务书需经指导教师审核通过后执行,后续可根据实际开发进度动态调整任务分工与时间计划。

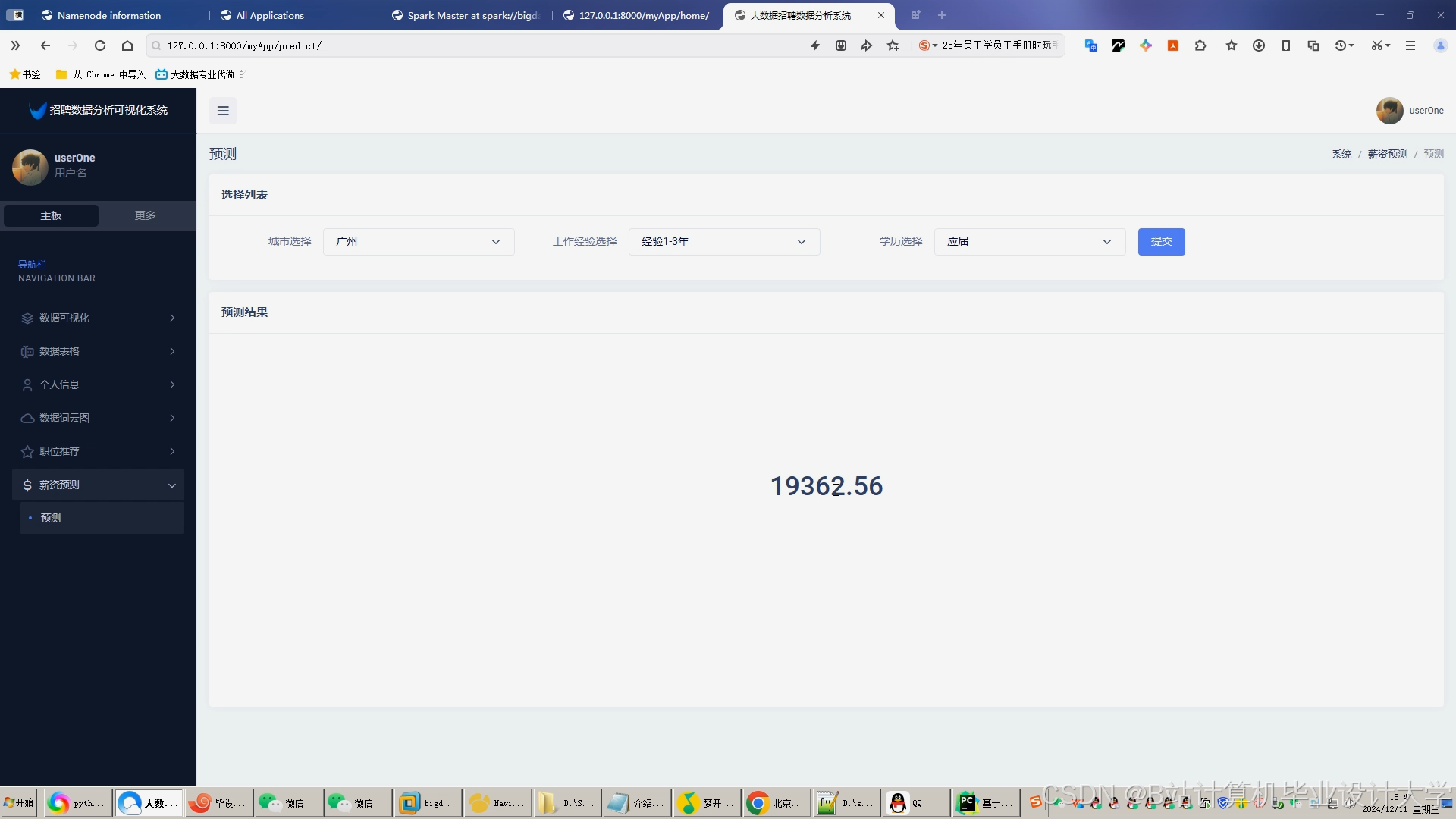

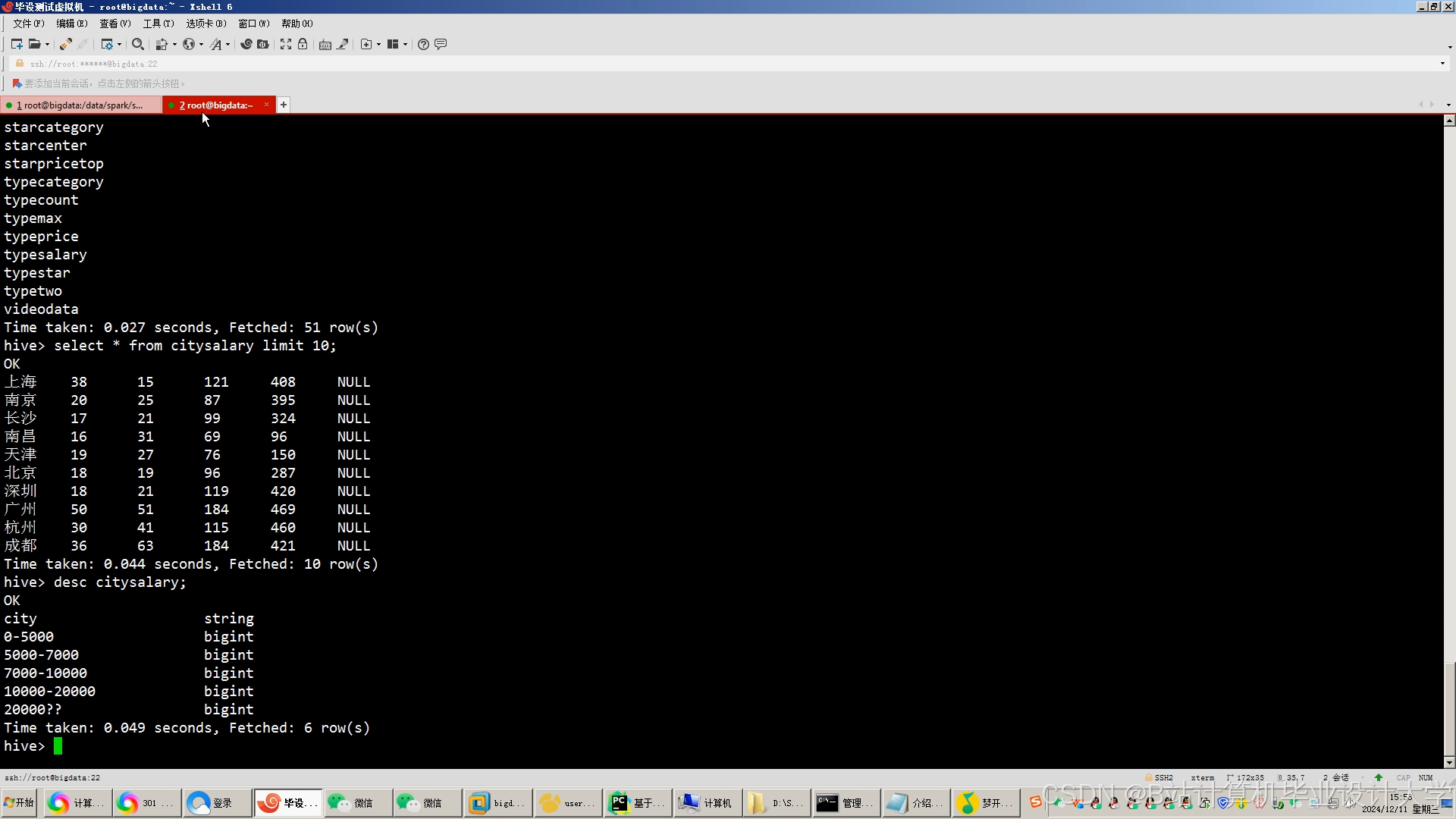

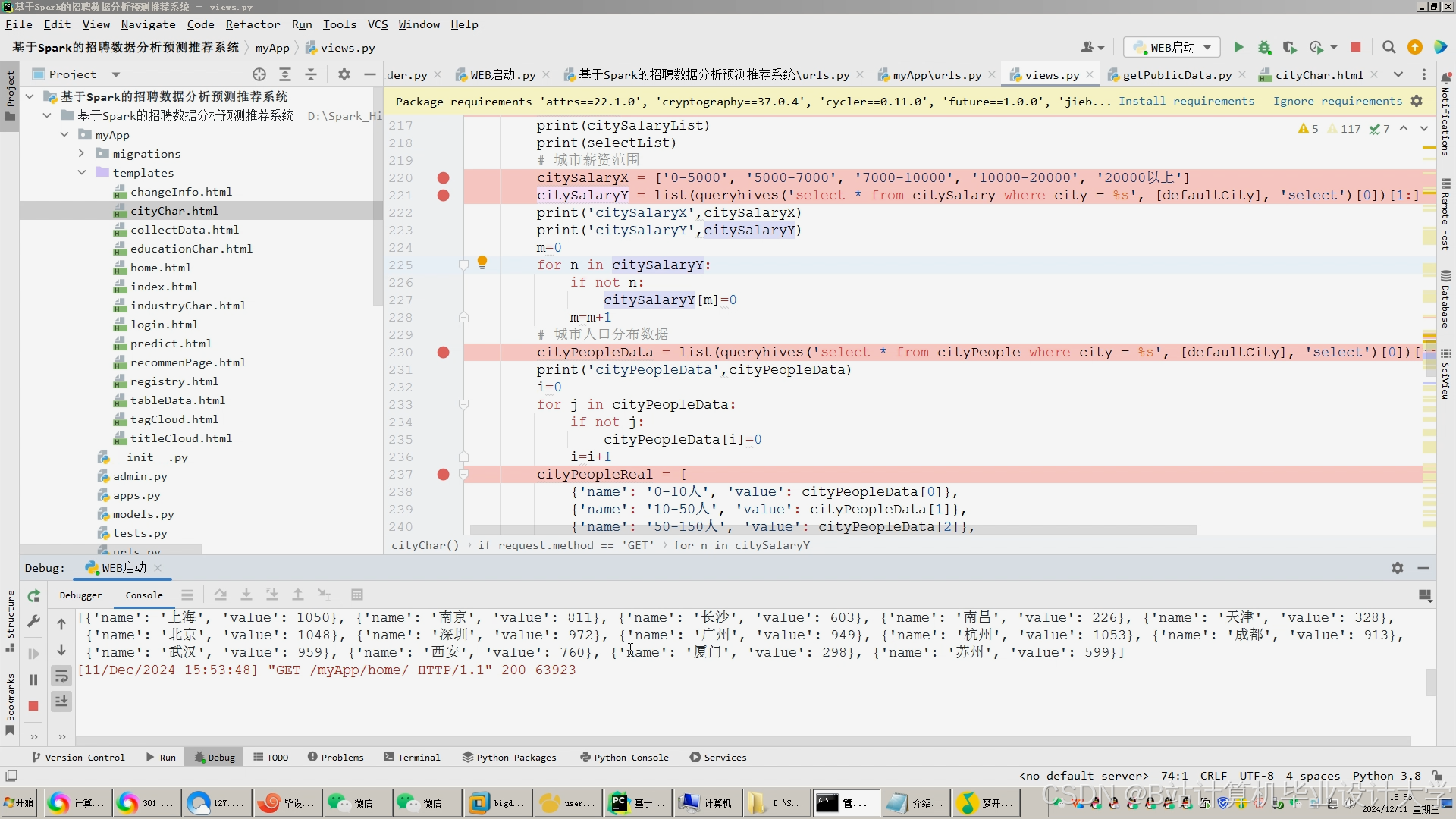

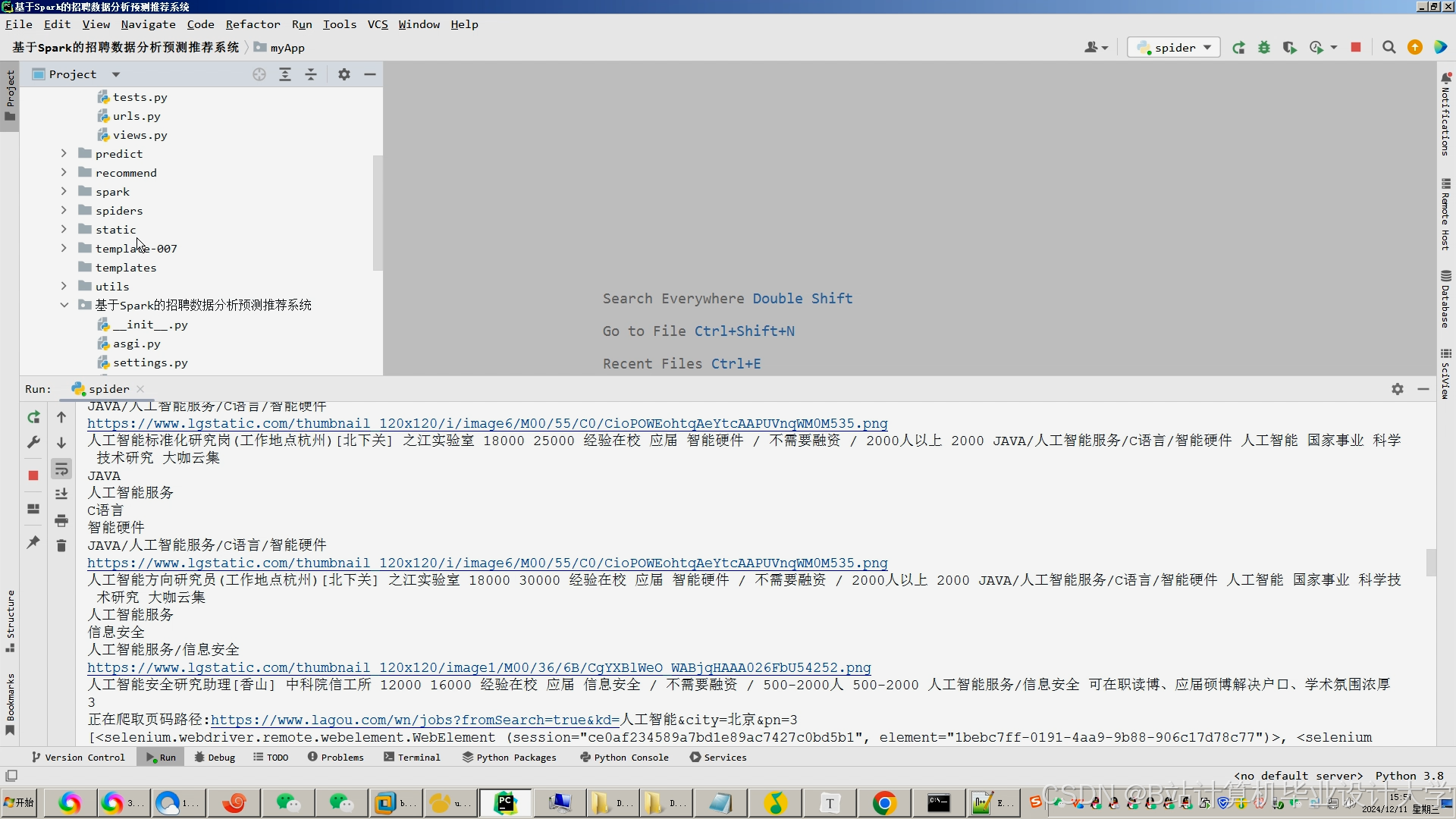

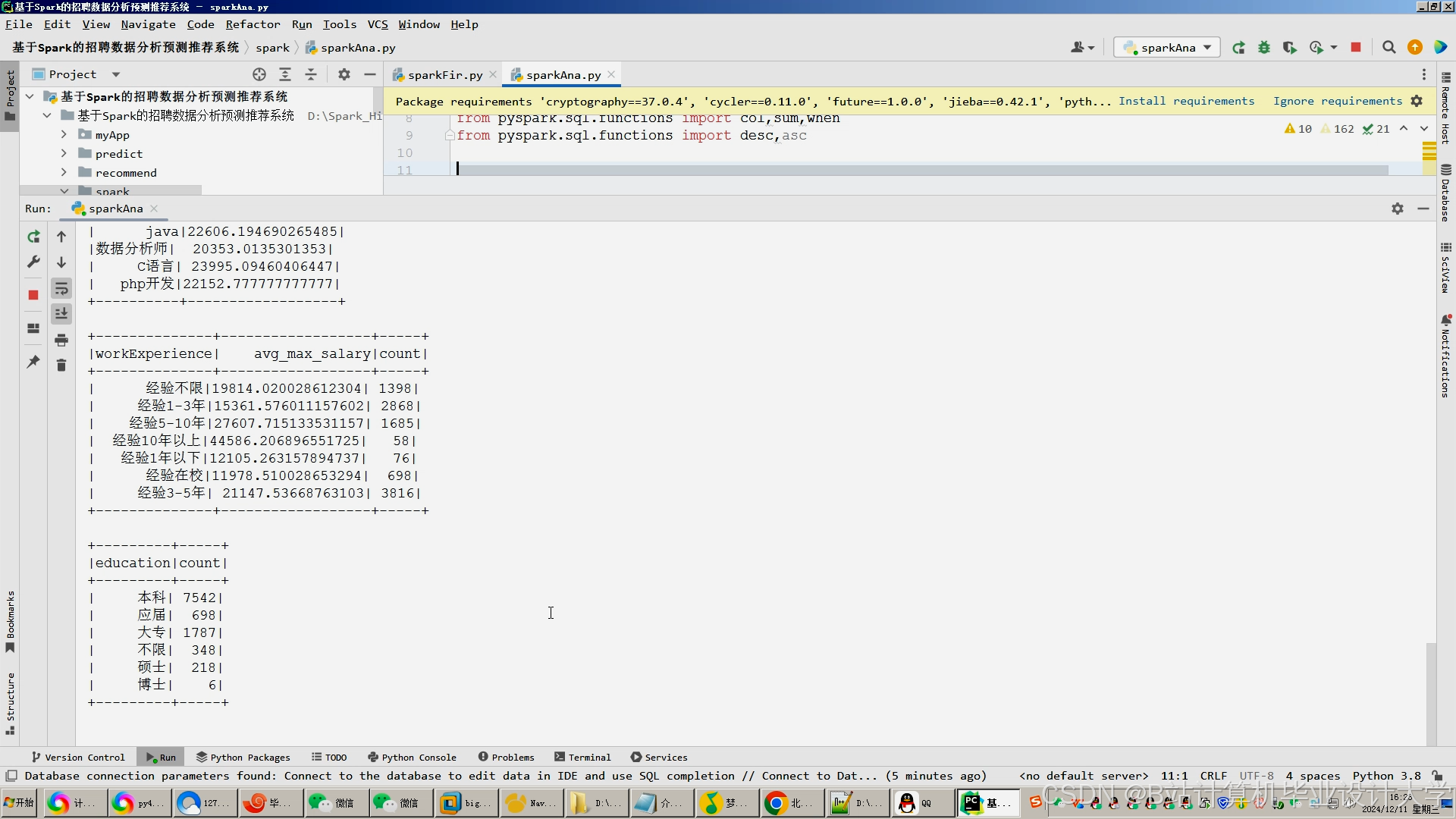

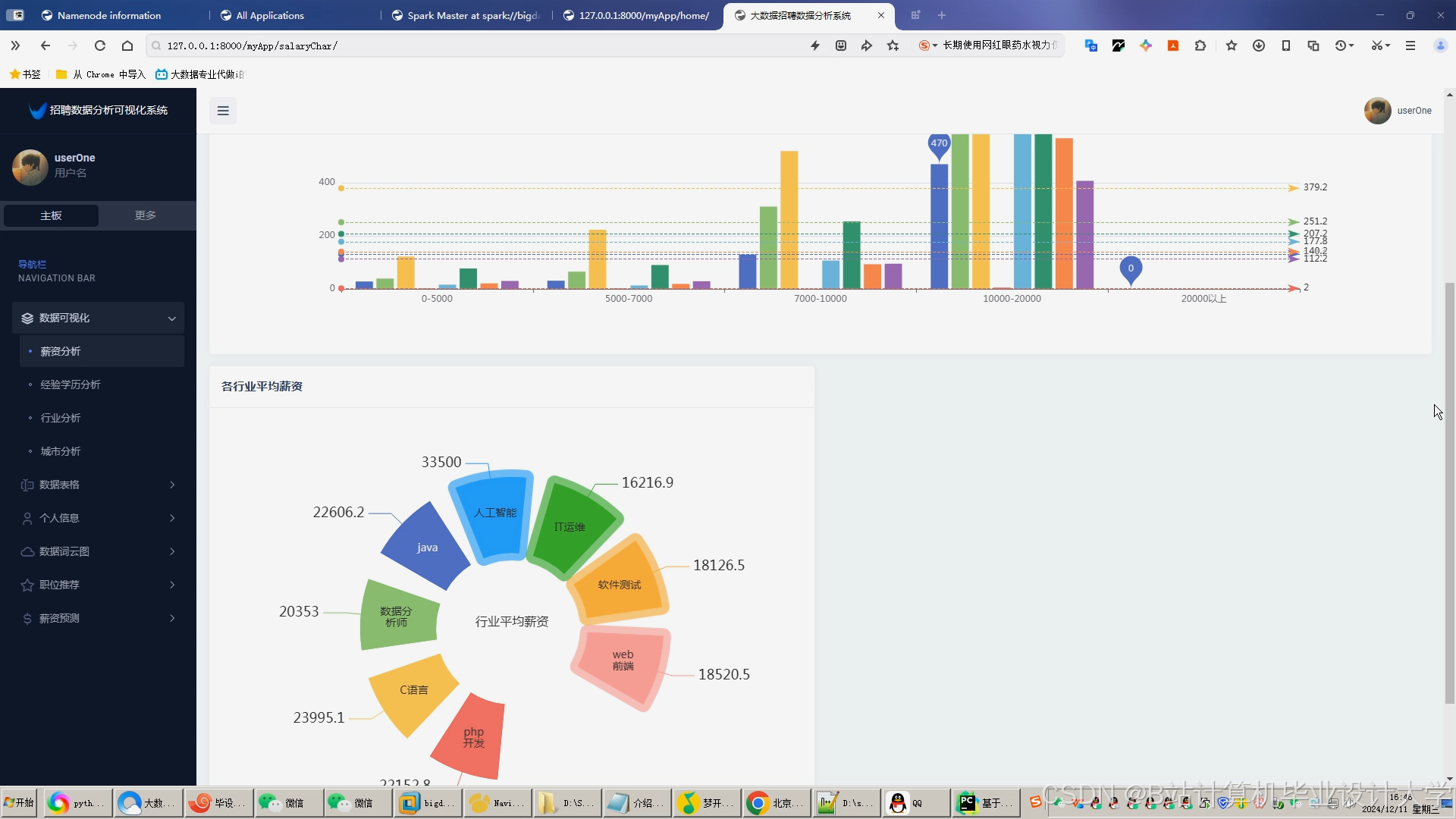

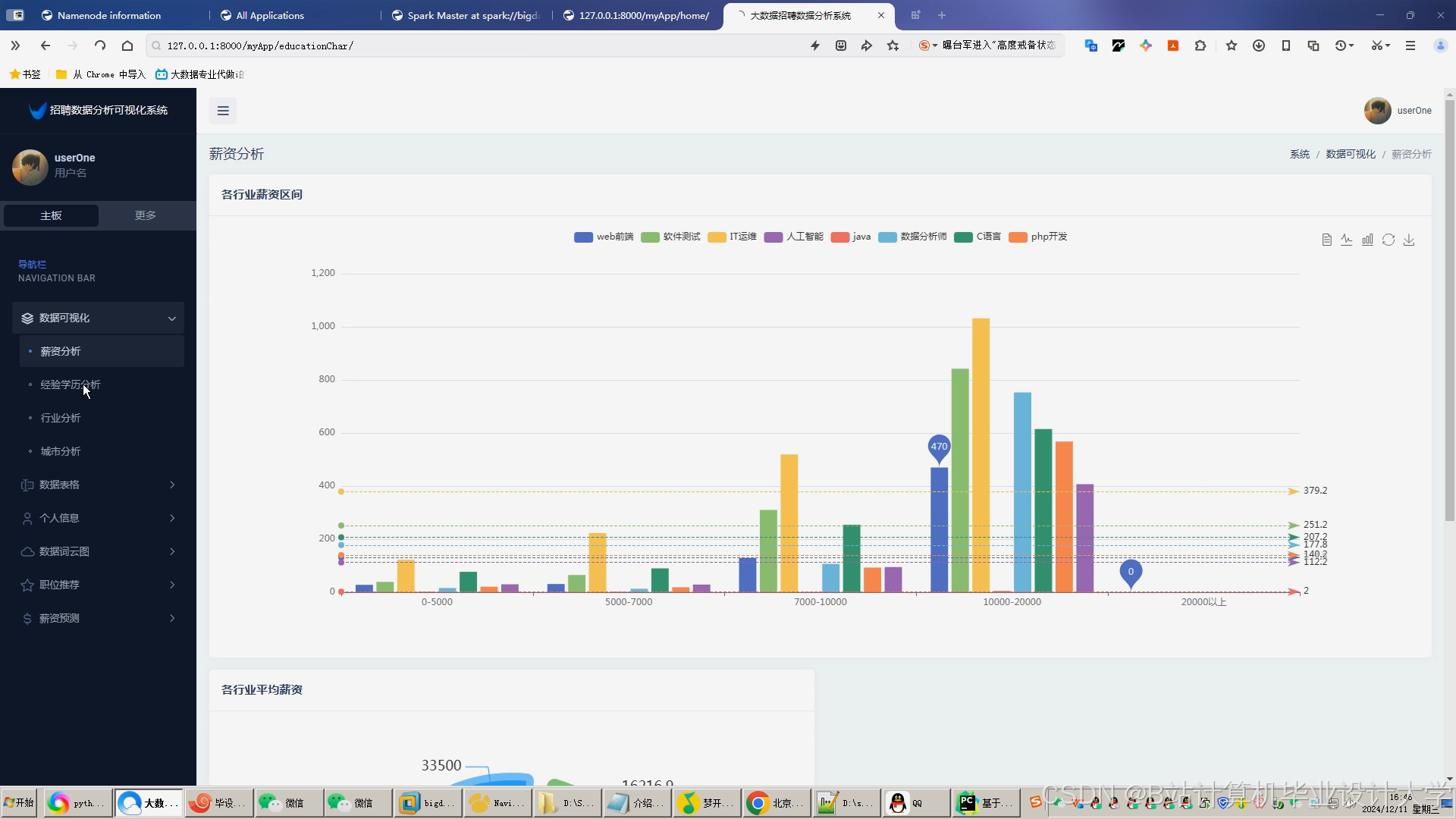

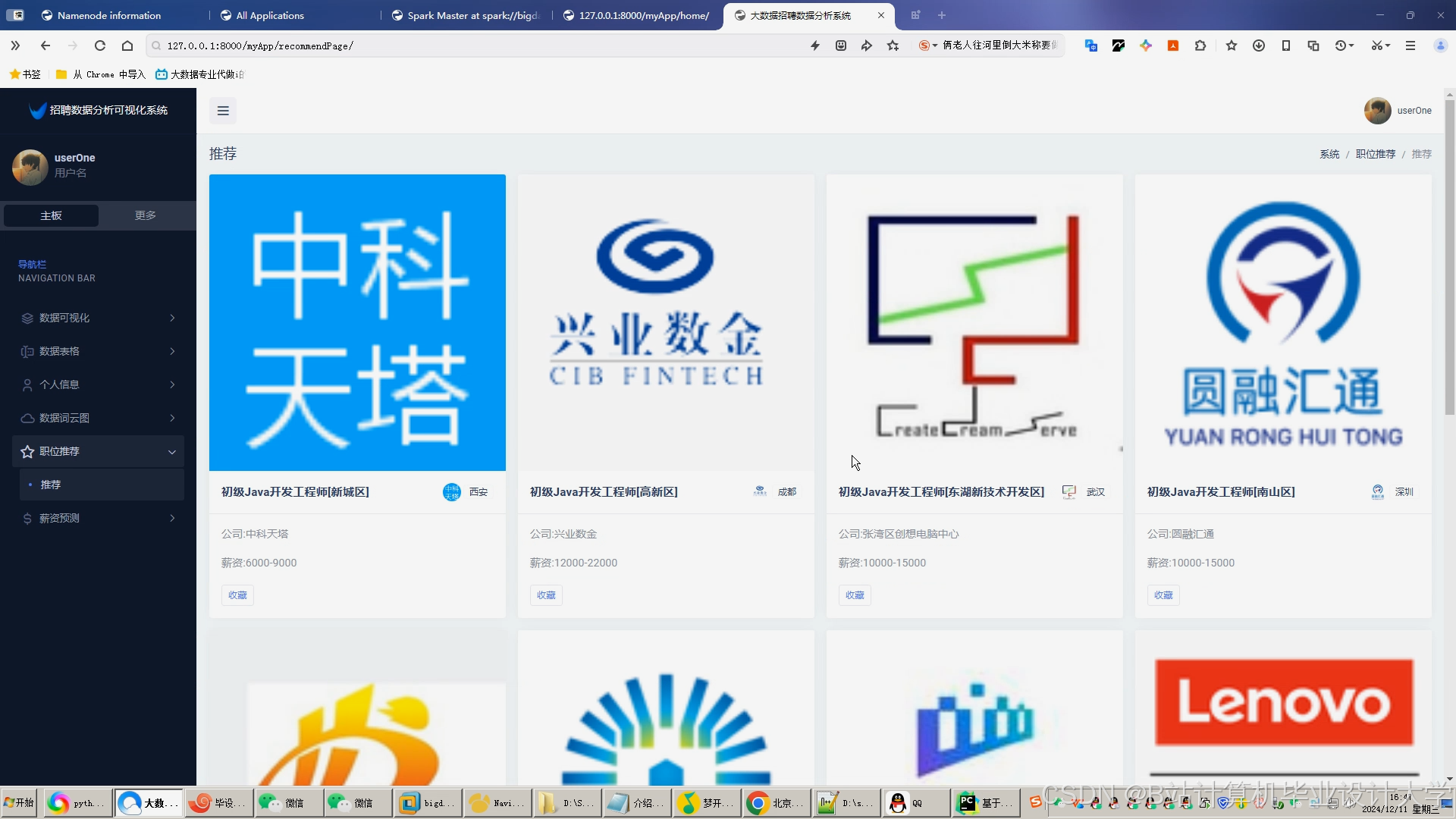

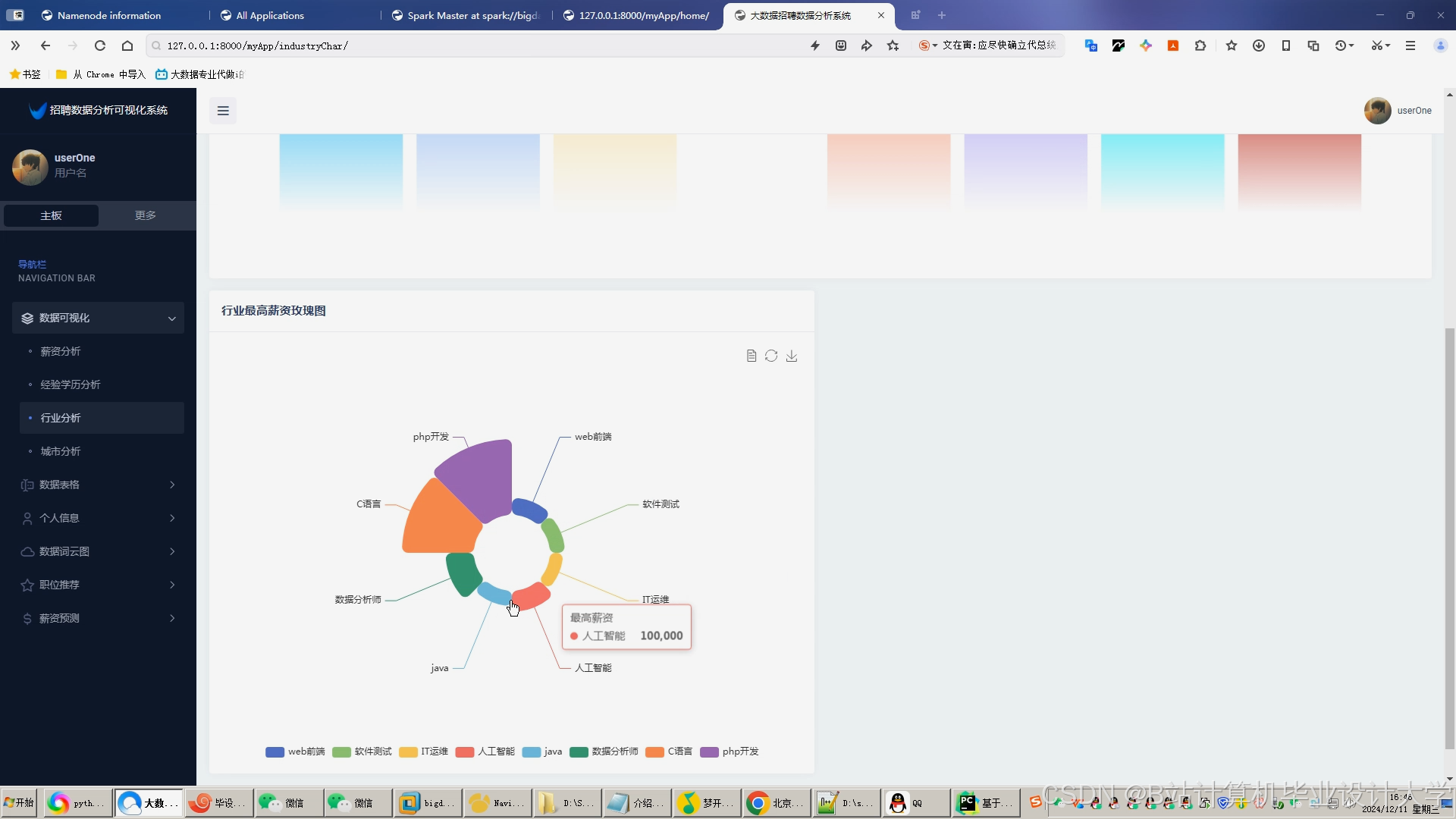

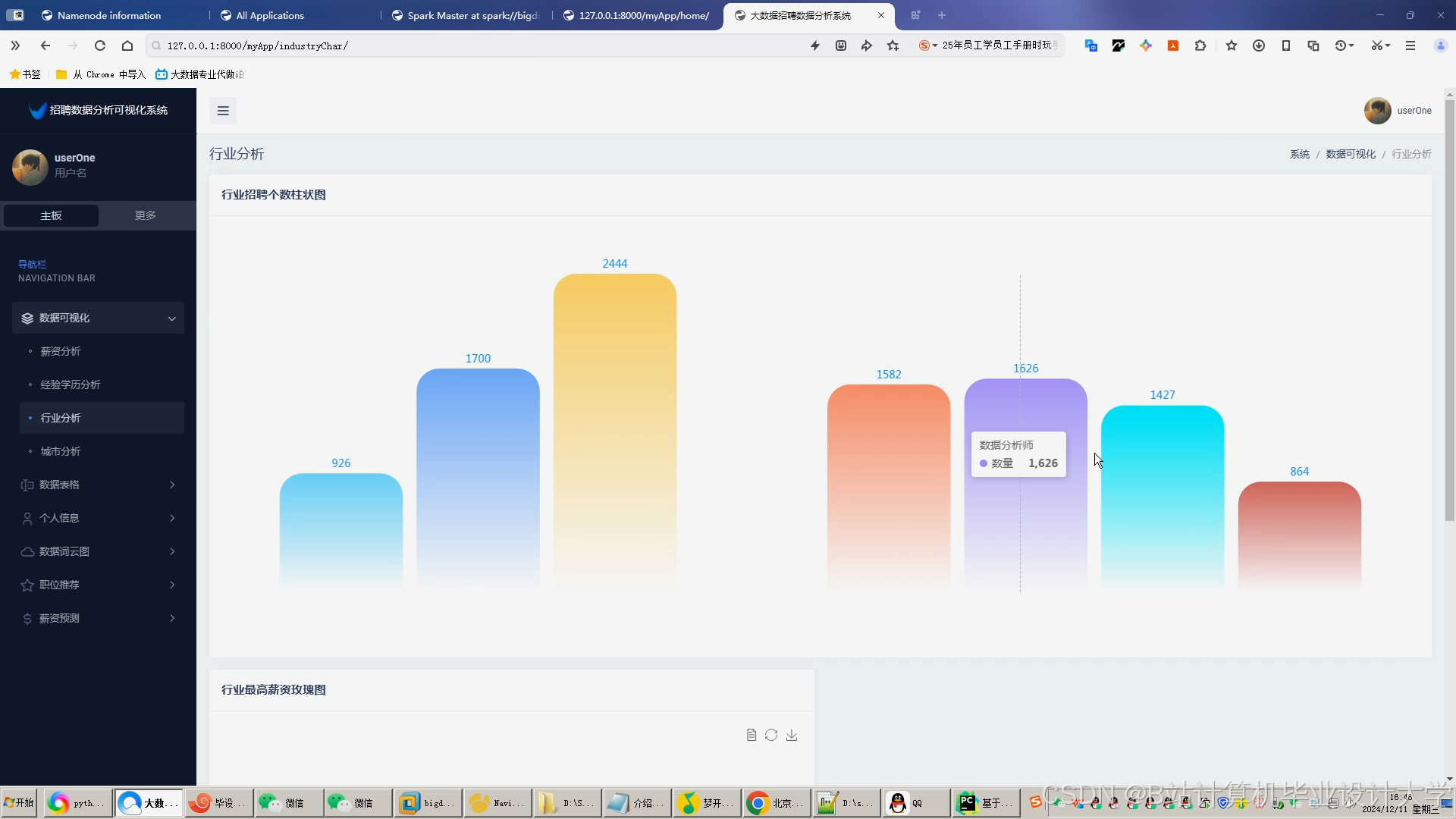

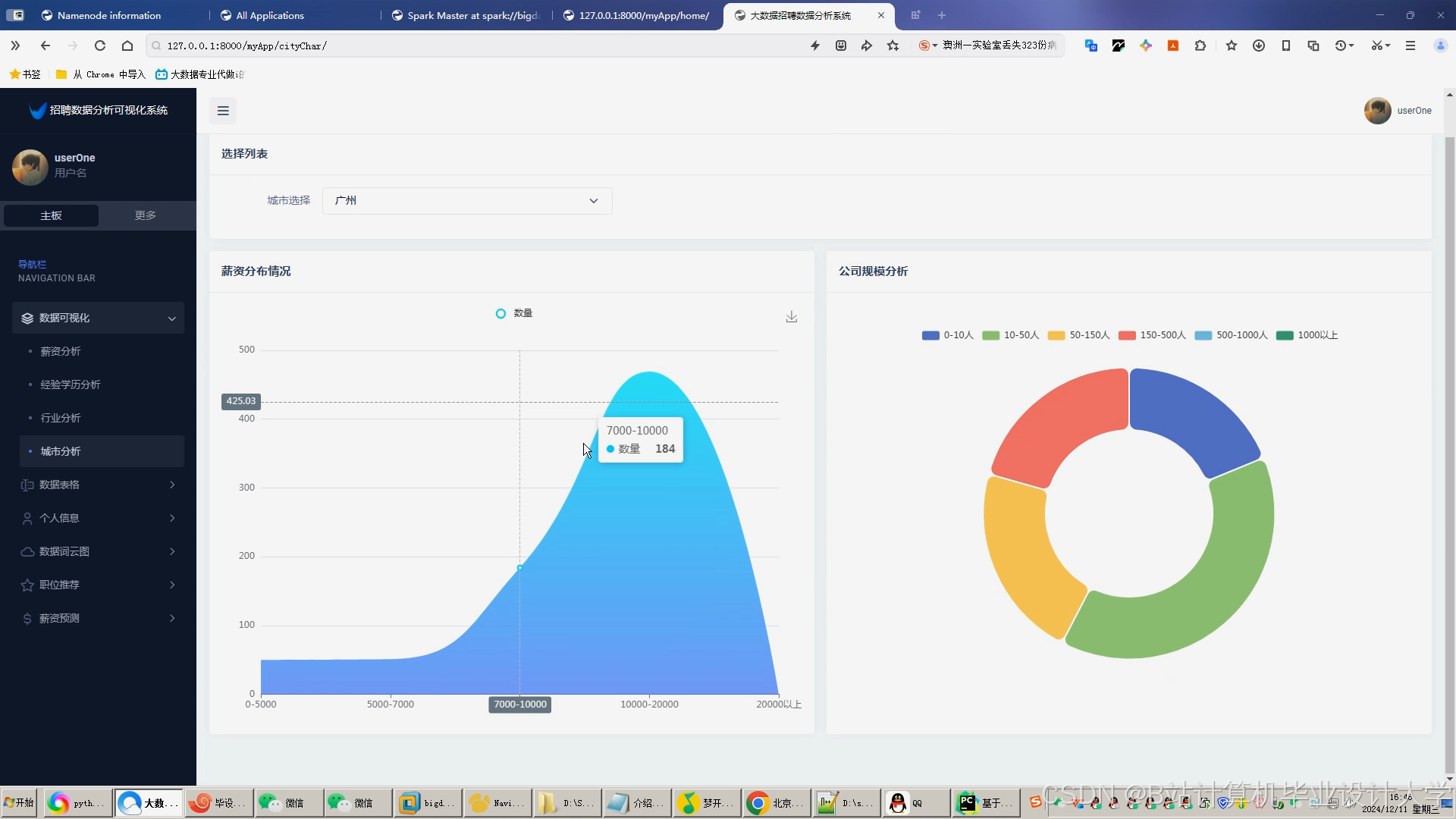

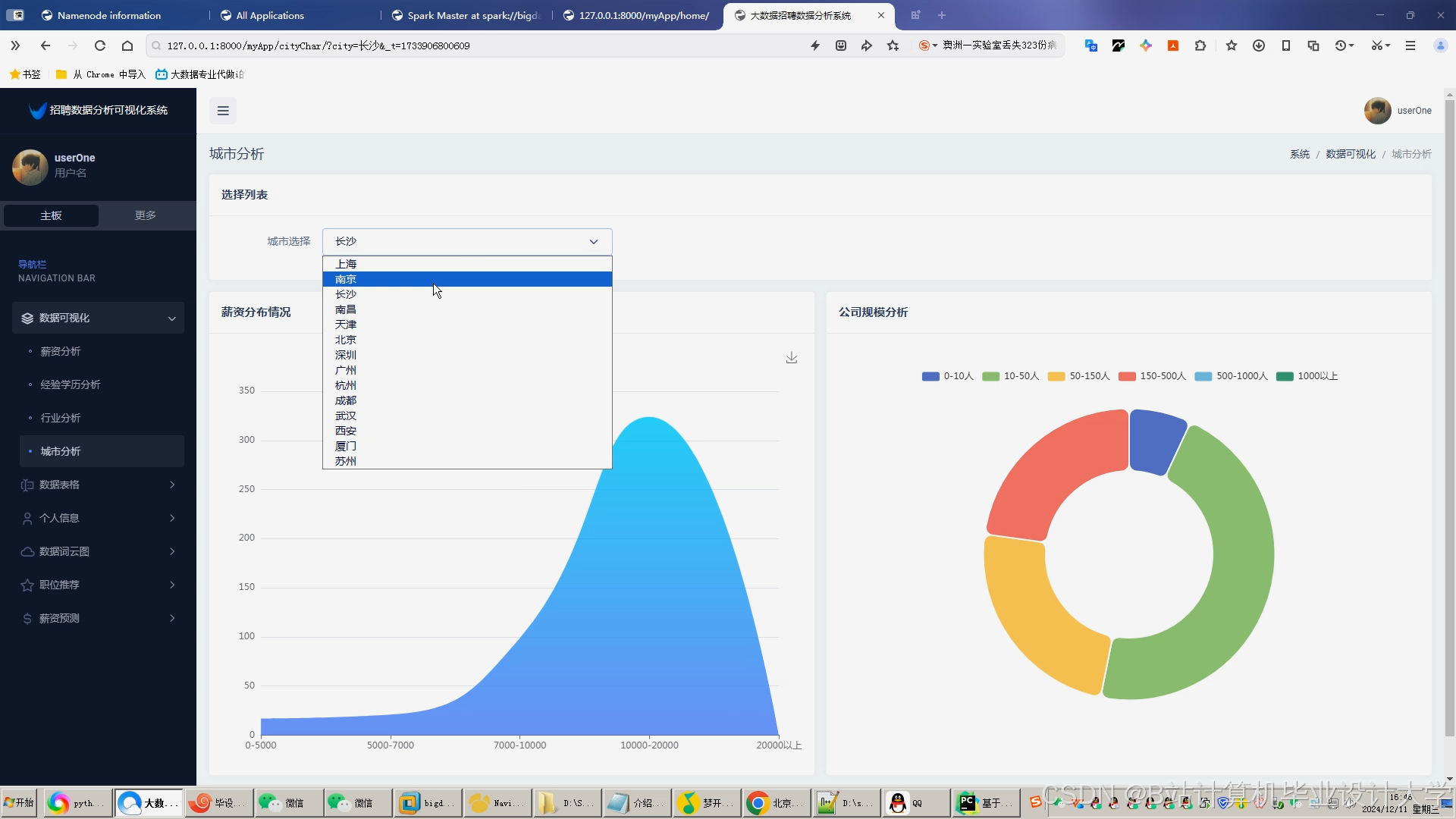

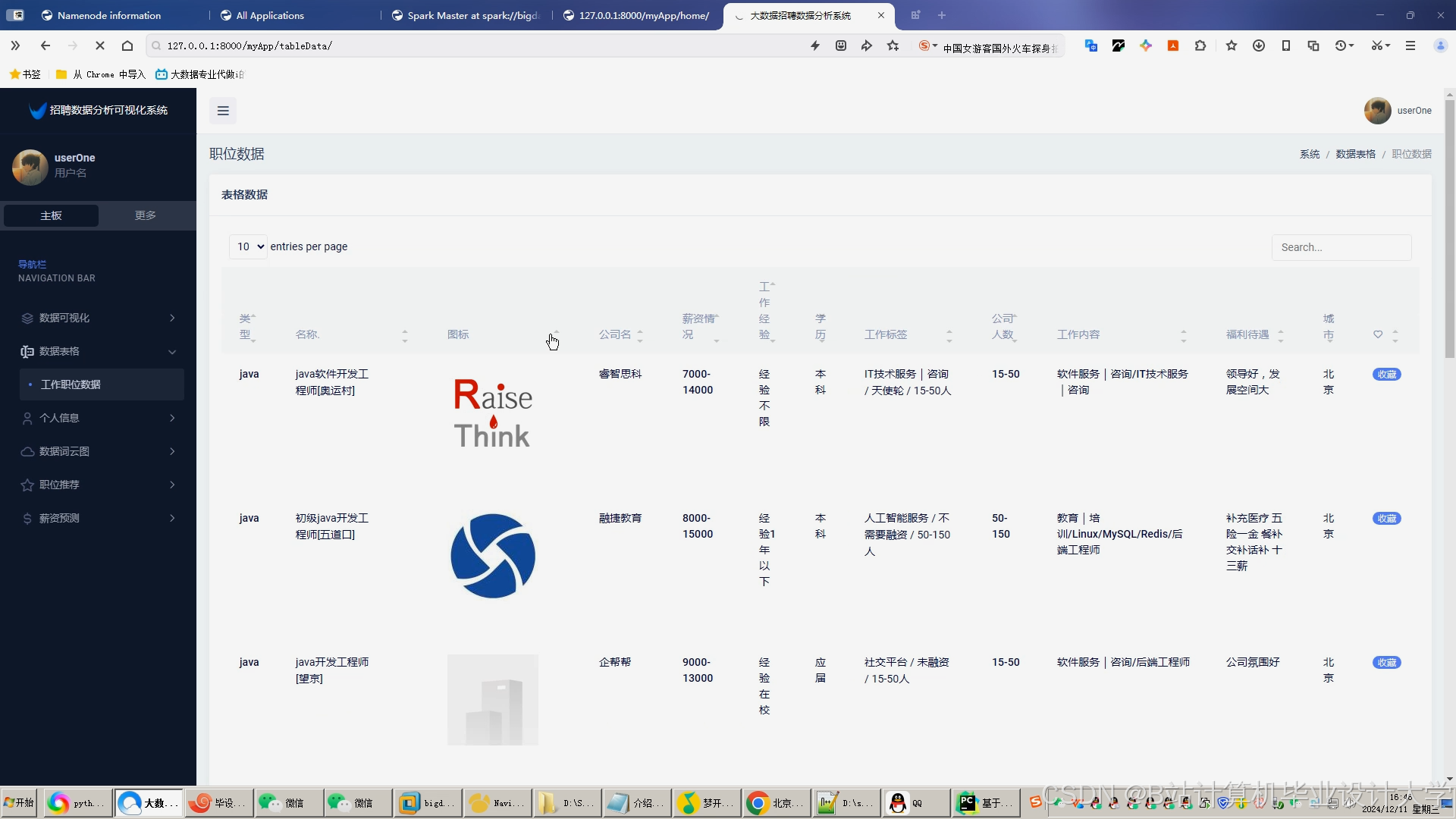

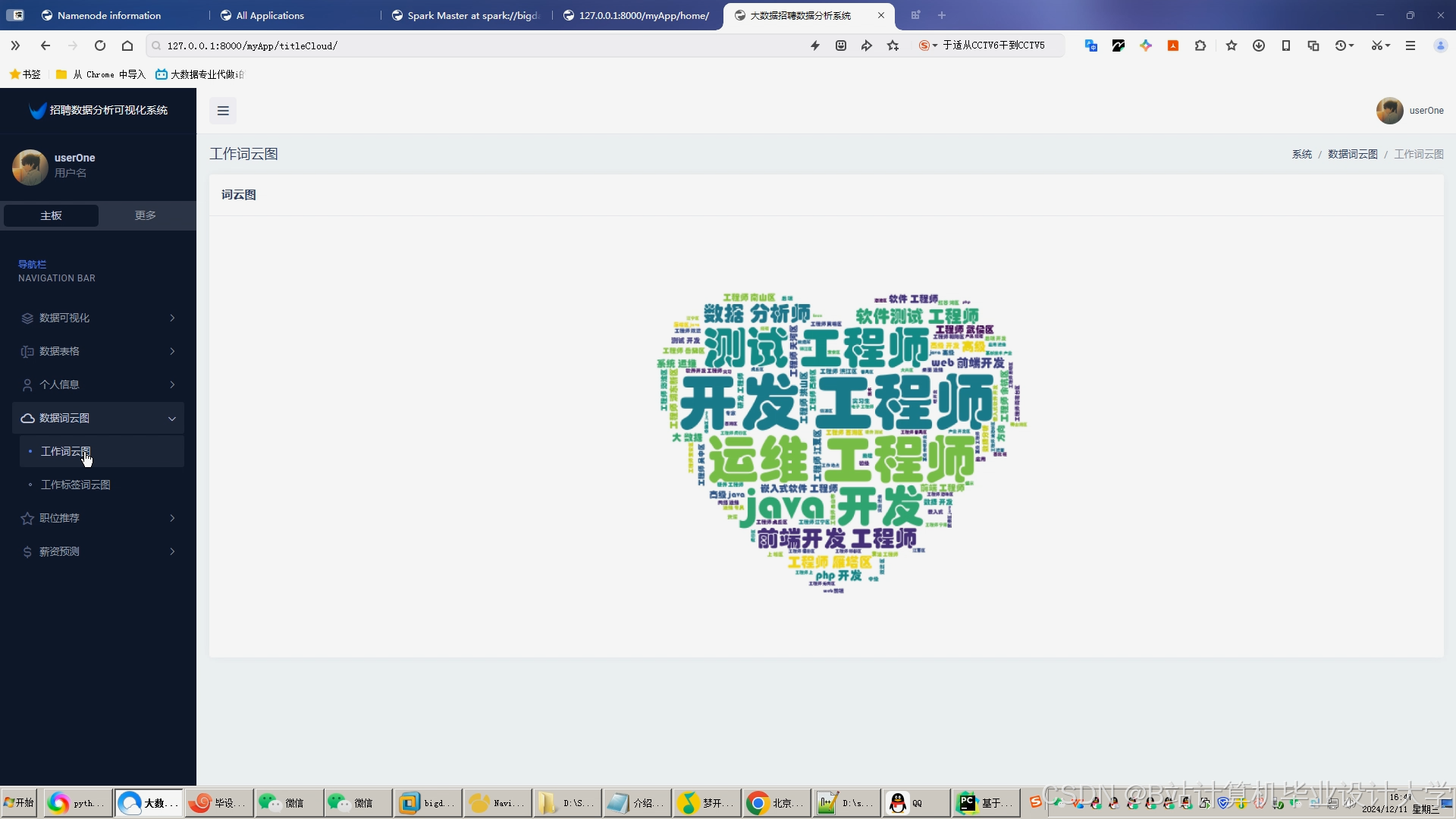

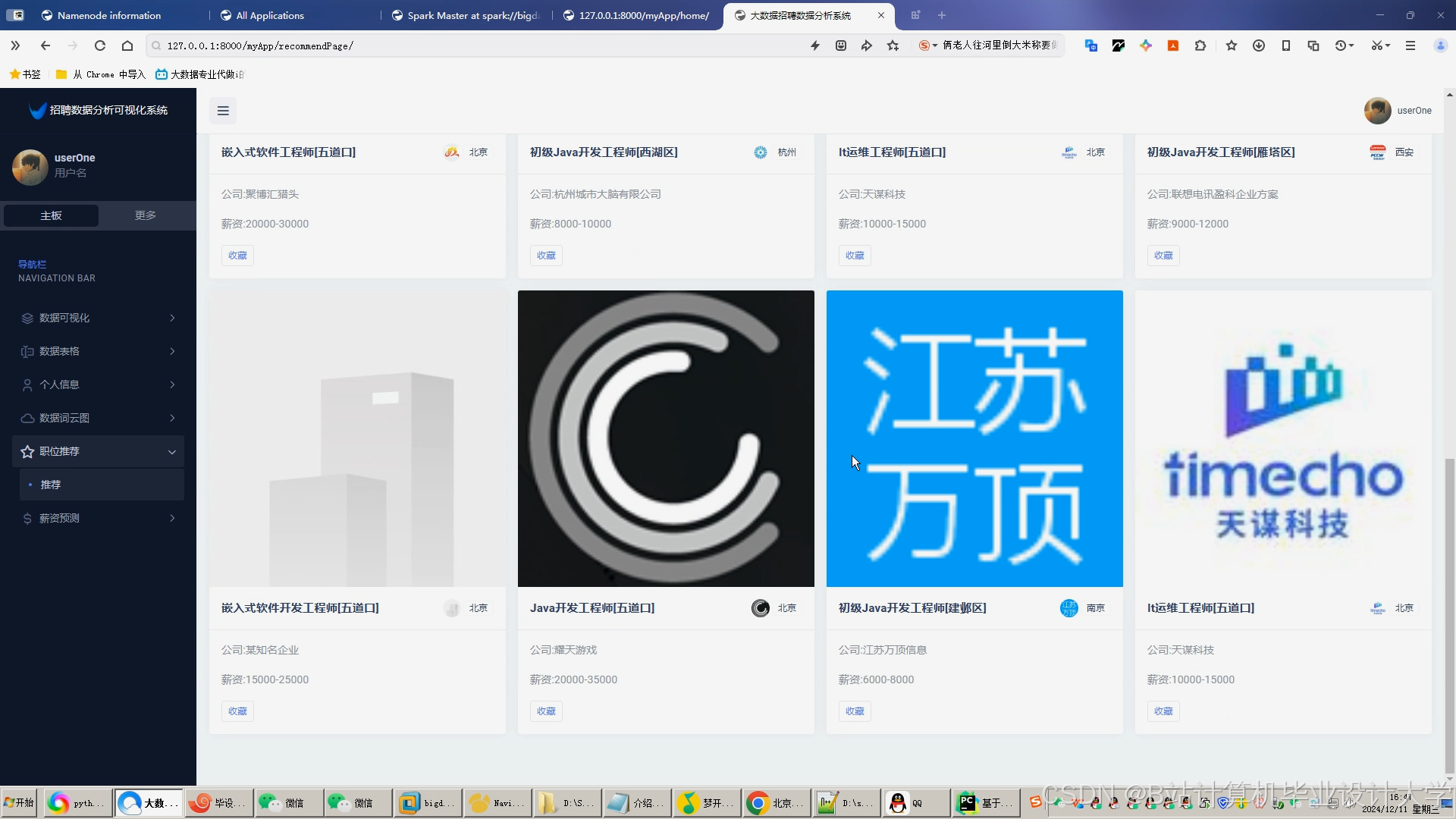

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

413

413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?