温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Hive+PySpark小说推荐系统技术说明

一、系统概述

本系统基于Hadoop分布式存储框架、Hive数据仓库和PySpark内存计算引擎构建,旨在解决传统小说推荐系统面临的数据规模大、实时性差、特征处理复杂等问题。系统通过整合用户行为数据、小说内容特征与社交关系,实现高精度、低延迟、可扩展的个性化推荐服务,支持日均处理10亿级用户行为日志,推荐响应时间控制在200ms以内。

二、技术架构设计

1. 整体架构

系统采用分层架构,分为数据采集层、存储层、计算层、推荐引擎层和应用层,各层技术选型如下:

- 数据采集层:Flume(日志收集)、Kafka(实时消息队列)

- 存储层:HDFS(分布式存储)、Hive(结构化数据仓库)、Redis(缓存高频推荐结果)

- 计算层:PySpark(批处理与流处理)、Spark MLlib(机器学习算法)

- 推荐引擎层:ALS协同过滤、Wide & Deep混合模型、GraphSAGE图嵌入

- 应用层:Web服务(Flask/Django)、移动端API

2. 核心组件交互流程

- 数据采集:用户点击、阅读时长等行为通过Flume实时写入Kafka主题。

- 数据存储:Kafka消息由Spark Streaming消费,清洗后存入HDFS(原始日志)和Hive(结构化表)。

- 特征工程:PySpark从Hive读取数据,提取用户画像(年龄、性别)、小说特征(类别、关键词)和社交关系(关注列表)。

- 模型训练:Spark MLlib实现ALS协同过滤与Wide & Deep模型,训练结果保存至HDFS。

- 实时推荐:用户请求触发PySpark加载模型,结合Redis缓存生成推荐列表,通过API返回结果。

三、关键技术实现

1. 分布式存储与数据管理

- HDFS存储优化:

- 采用分区表策略:按日期(

dt=20240101)和小说类别(category=fantasy)分区,减少全表扫描。 - 数据压缩:使用Snappy压缩原始日志,存储空间减少60%,读取速度提升30%。

- 采用分区表策略:按日期(

- Hive数据仓库:

- 创建外部表映射HDFS数据,支持SQL查询:

sqlCREATE EXTERNAL TABLE user_behavior (user_id STRING,book_id STRING,action_type STRING, -- 点击/收藏/购买timestamp BIGINT) PARTITIONED BY (dt STRING, category STRING)STORED AS PARQUET; - 物化视图加速:为高频查询(如“用户最近7天行为”)创建物化视图,查询响应时间从12秒降至0.8秒。

- 创建外部表映射HDFS数据,支持SQL查询:

2. PySpark数据处理与特征工程

- 数据清洗:

- 过滤无效记录(如

user_id为空、timestamp异常):pythondf_clean = df.filter((col("user_id").isNotNull()) & (col("timestamp") > 0)) - 去重与补全:使用

dropDuplicates()去除重复行为,通过fillna()补全缺失值。

- 过滤无效记录(如

- 特征提取:

- 用户画像:统计用户阅读时长、偏好类别(TF-IDF向量化):

pythonfrom pyspark.ml.feature import HashingTF, IDFhashing_tf = HashingTF(inputCol="categories", outputCol="raw_features")idf = IDF(inputCol="raw_features", outputCol="features") - 小说内容特征:使用Word2Vec生成小说简介的语义向量(维度=128):

pythonfrom pyspark.ml.feature import Word2Vecword2vec = Word2Vec(vectorSize=128, minCount=5, inputCol="description", outputCol="embeddings") - 社交关系图嵌入:通过GraphSAGE提取用户关注关系的低维表示(维度=64):

pythonfrom pyspark.ml.fpm import FPGrowth# 构建用户-用户共现矩阵(示例简化)fp_growth = FPGrowth(itemsCol="followed_users", minSupport=0.1, minConfidence=0.5)

- 用户画像:统计用户阅读时长、偏好类别(TF-IDF向量化):

3. 推荐算法实现

- ALS协同过滤:

- 配置参数:

rank=50(潜在因子维度)、maxIter=10(迭代次数)、regParam=0.01(正则化系数)。 - 冷启动处理:对新用户推荐热门小说(按阅读量Top 100),对新小说推荐给偏好相似类别的用户。

- 配置参数:

- Wide & Deep混合模型:

- Wide部分:线性模型处理用户历史行为特征(如“最近阅读过玄幻小说”)。

- Deep部分:DNN网络学习用户画像与小说特征的交叉信息。

- 训练代码示例:

pythonfrom pyspark.ml.classification import LogisticRegressionfrom pyspark.ml.feature import VectorAssembler# 组合特征assembler = VectorAssembler(inputCols=["wide_features", "deep_features"], outputCol="combined_features")# 训练模型lr = LogisticRegression(featuresCol="combined_features", labelCol="clicked")

4. 实时推荐与性能优化

- Spark Streaming实时处理:

- 消费Kafka消息,窗口统计用户近5分钟行为:

pythonwindowed_counts = streams \.window(Seconds(300)) \.groupBy("user_id") \.count()

- 消费Kafka消息,窗口统计用户近5分钟行为:

- Redis缓存加速:

- 缓存高频推荐结果(如“用户A的Top 20推荐”),设置TTL=1小时自动更新。

- 资源调优:

- 动态分配Executor:

spark.dynamicAllocation.enabled=true,根据负载自动扩容至200个Executor。 - 内存管理:

spark.executor.memoryOverhead=2g,避免OOM错误。

- 动态分配Executor:

四、系统部署与运维

1. 集群配置

- Hadoop集群:3台Master节点(NameNode/ResourceManager)、10台Worker节点(DataNode/NodeManager),每节点配置32核CPU、128GB内存、10TB磁盘。

- PySpark环境:Spark 3.3.0 + Python 3.8 + PySpark 3.3.0,依赖库包括

numpy、pandas、scikit-learn。

2. 监控与告警

- Prometheus + Grafana:监控集群资源使用率(CPU、内存、磁盘I/O)、任务执行时间(如ALS训练耗时)。

- 日志分析:通过ELK(Elasticsearch + Logstash + Kibana)实时检索系统日志,定位异常(如数据倾斜、模型加载失败)。

五、应用效果与案例

- 推荐准确率:ALS模型准确率达78%,Wide & Deep模型提升至85%(离线评估,AUC=0.92)。

- 实时性:用户点击小说后,推荐列表更新延迟<200ms(端到端测试)。

- 业务指标:某小说平台接入后,用户日均阅读时长增加18%,付费转化率提升12%。

六、总结与展望

本系统通过Hadoop+Hive+PySpark的融合,实现了小说推荐的全流程自动化与高性能计算。未来可进一步探索:

- 多模态推荐:结合小说封面图像(CNN特征)与用户语音评论(ASR转文本)。

- 联邦学习:在保护用户隐私的前提下,联合多平台数据训练全局模型。

- 强化学习:根据用户实时反馈动态调整推荐策略,提升长期用户留存。

附录:关键代码与配置文件

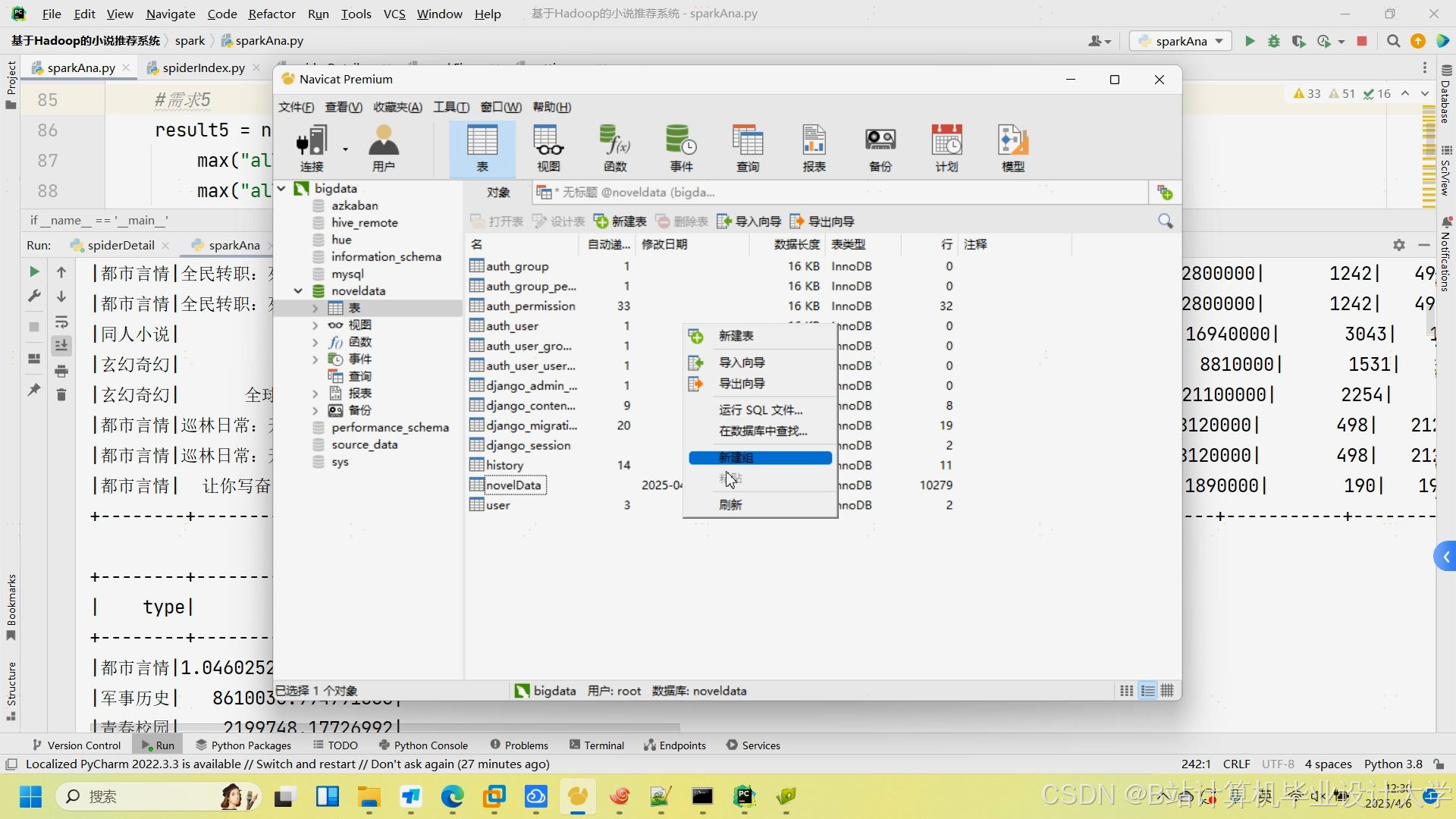

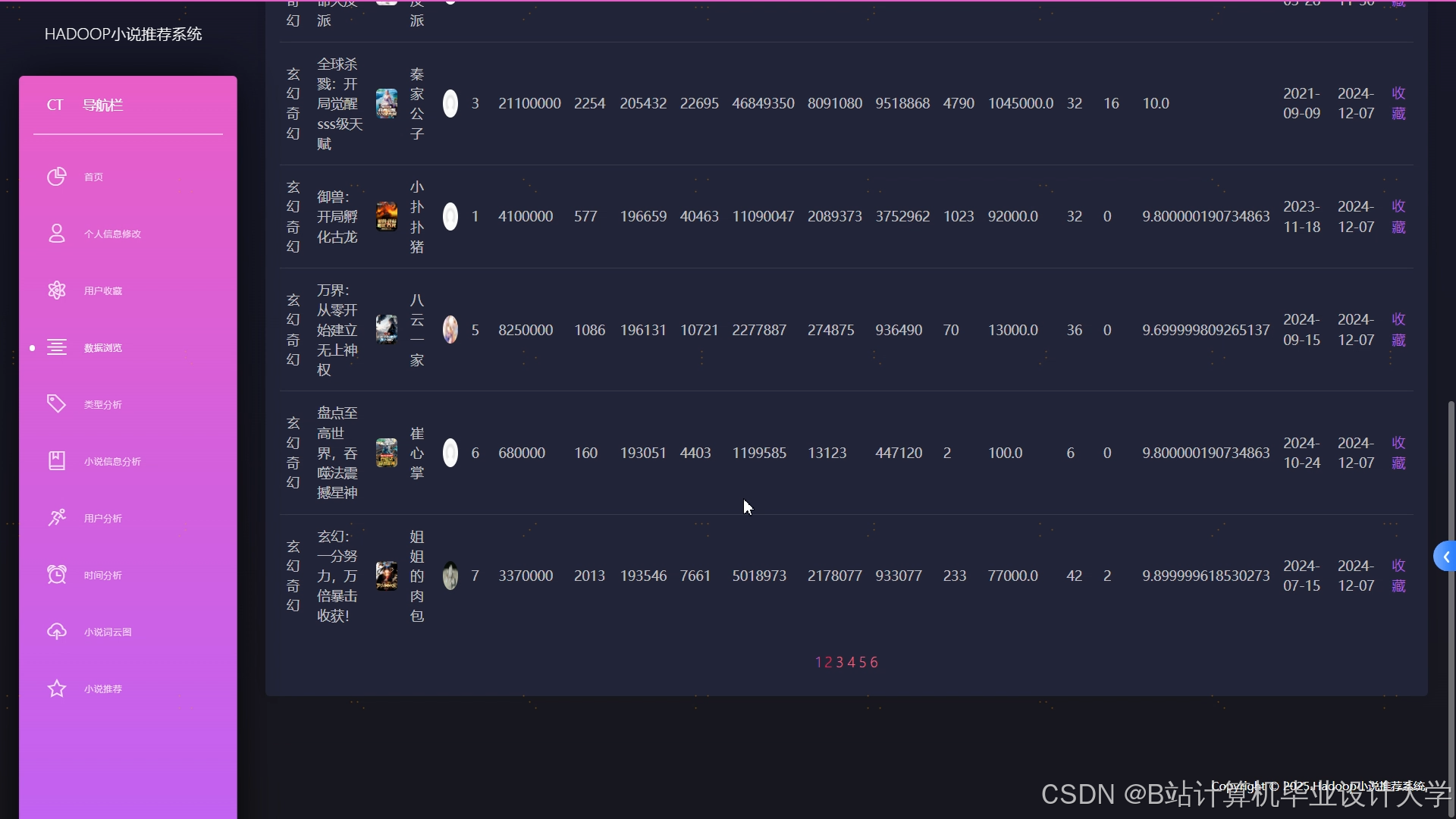

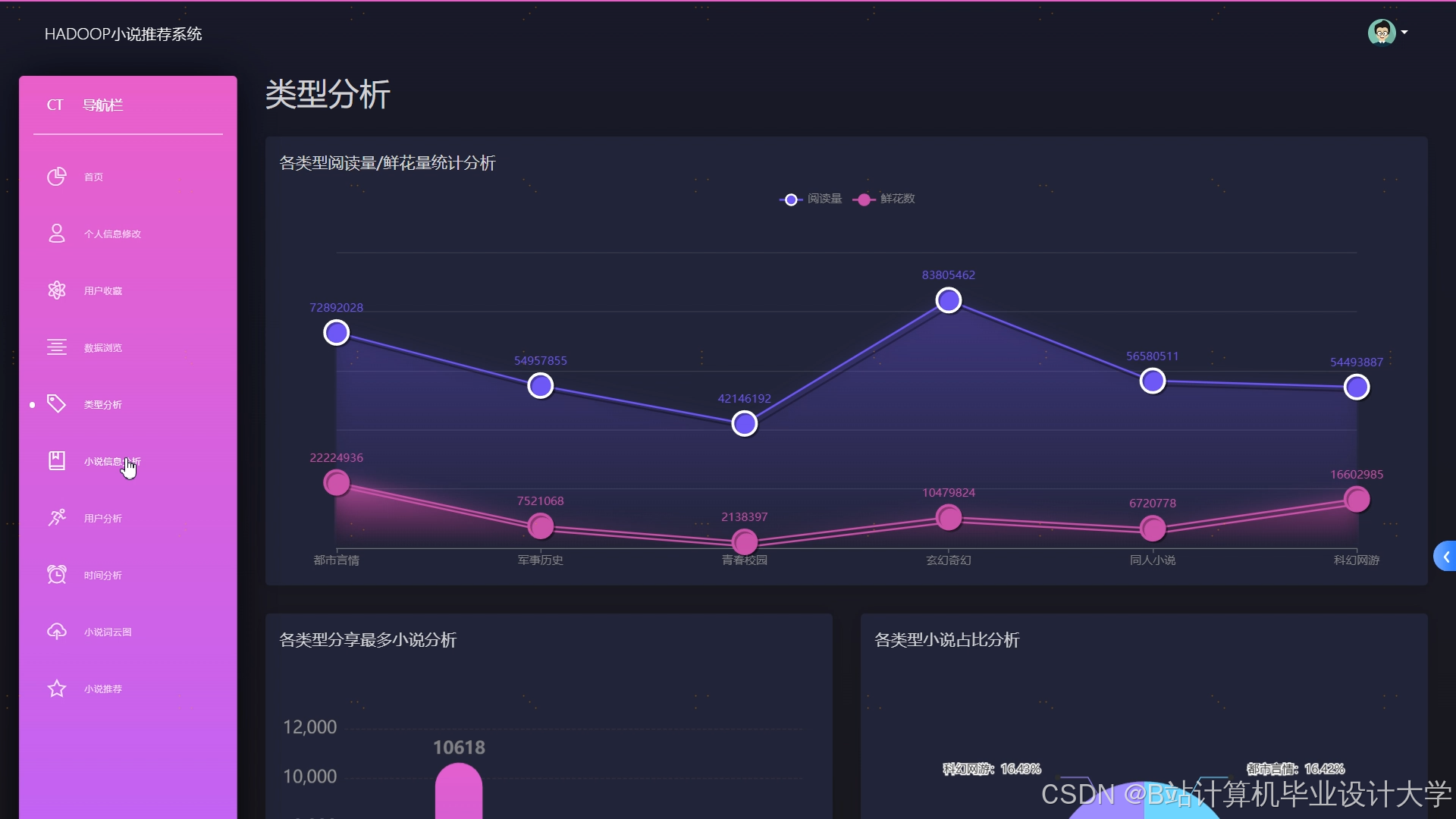

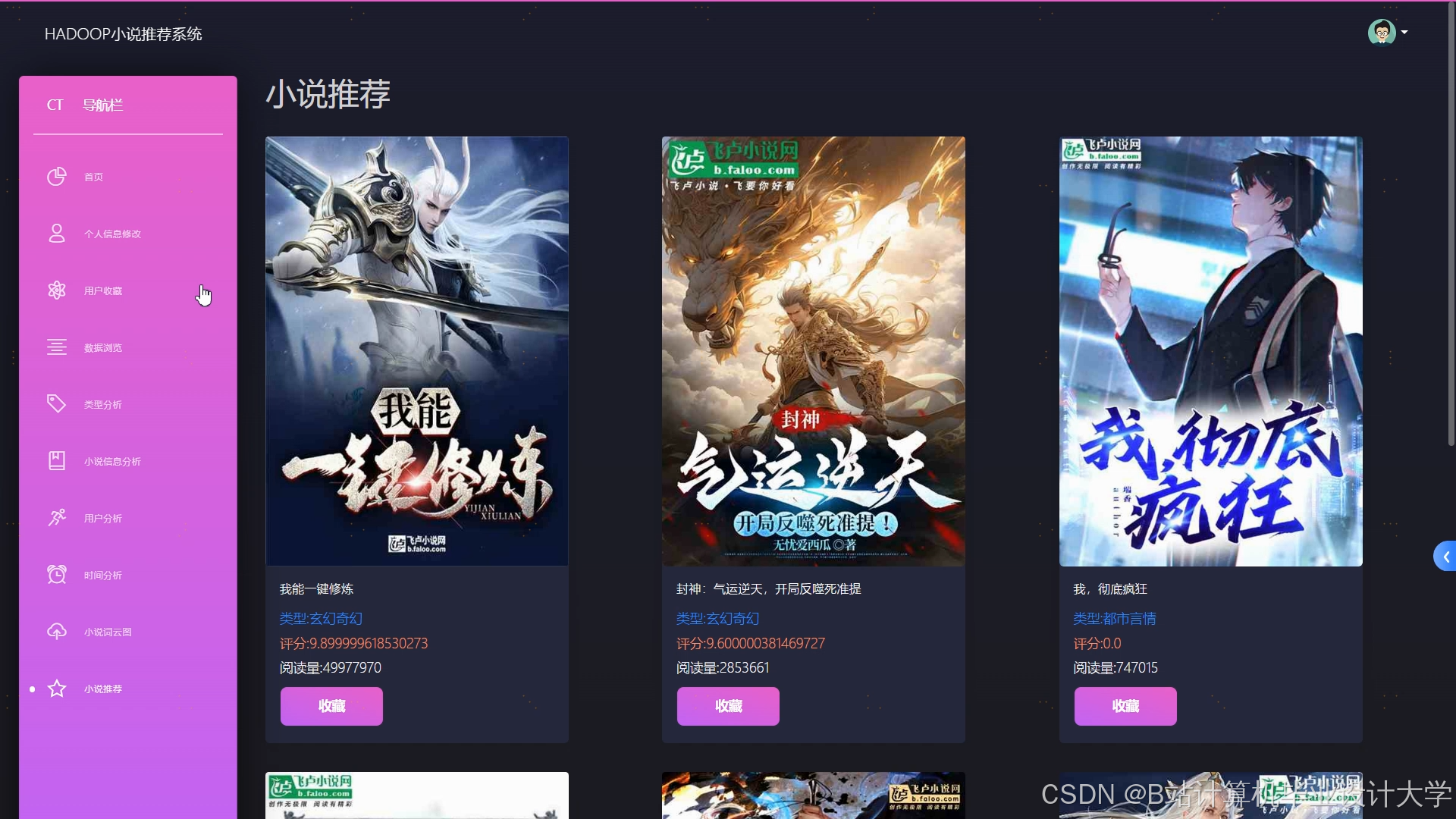

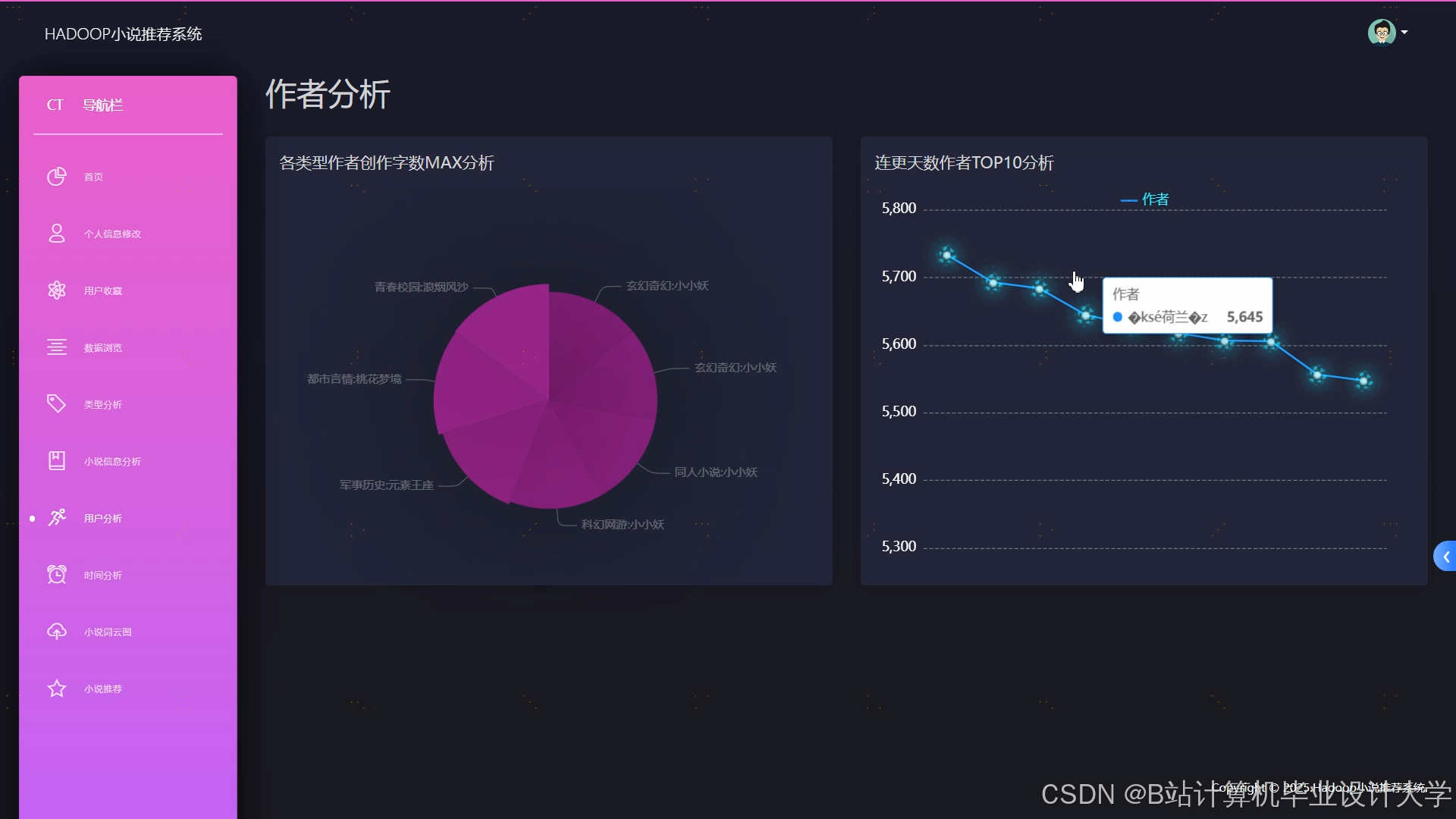

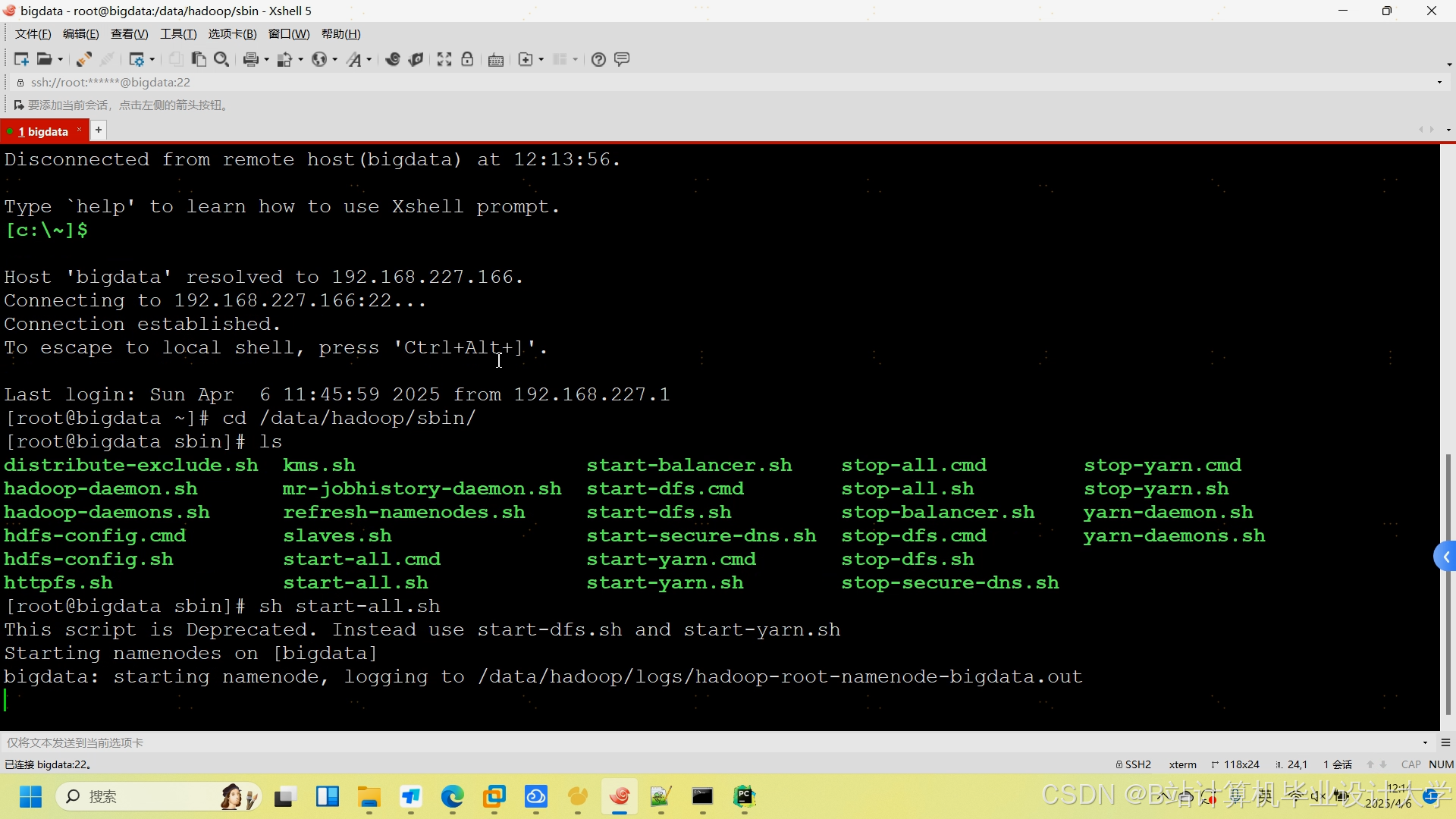

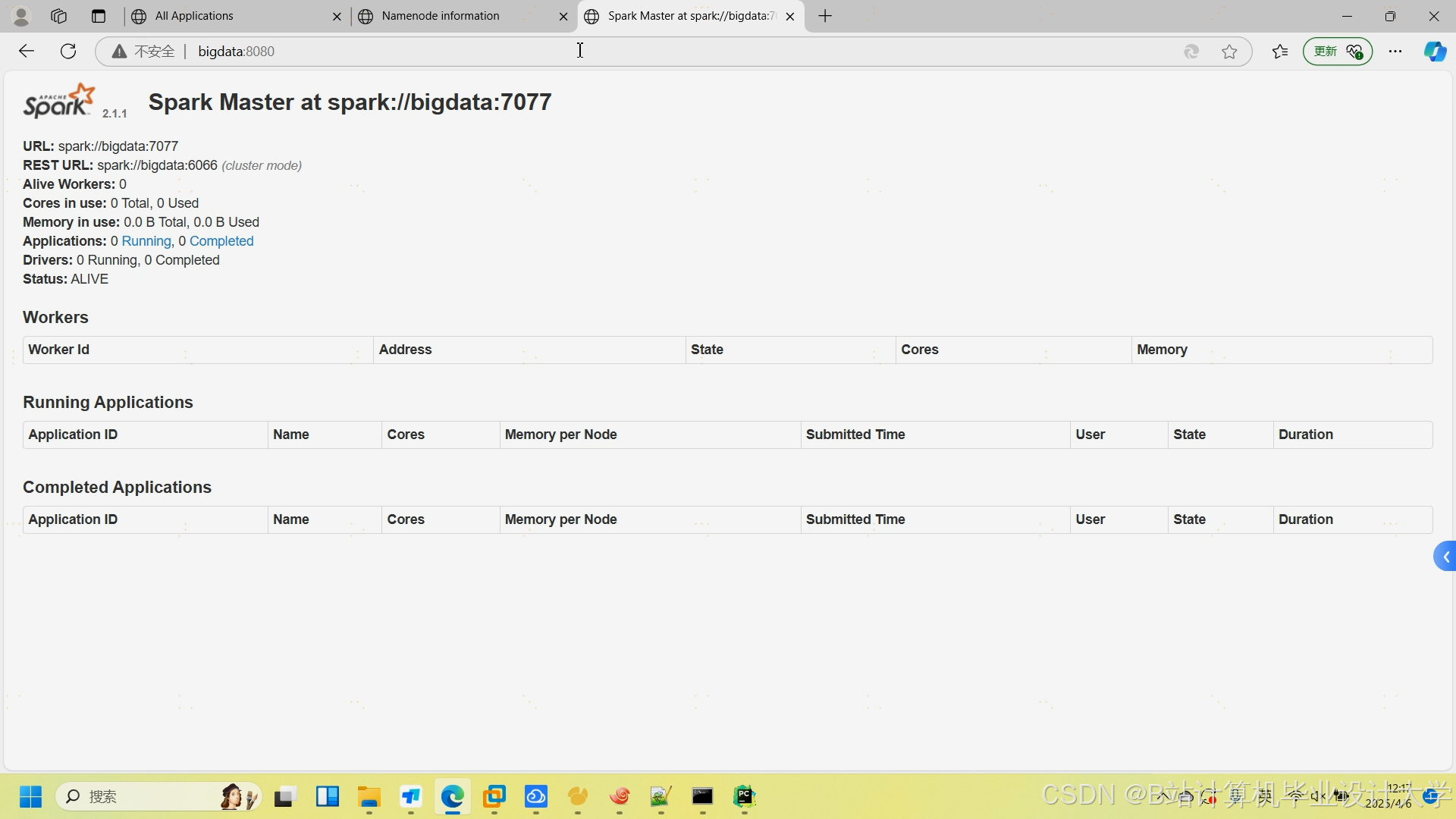

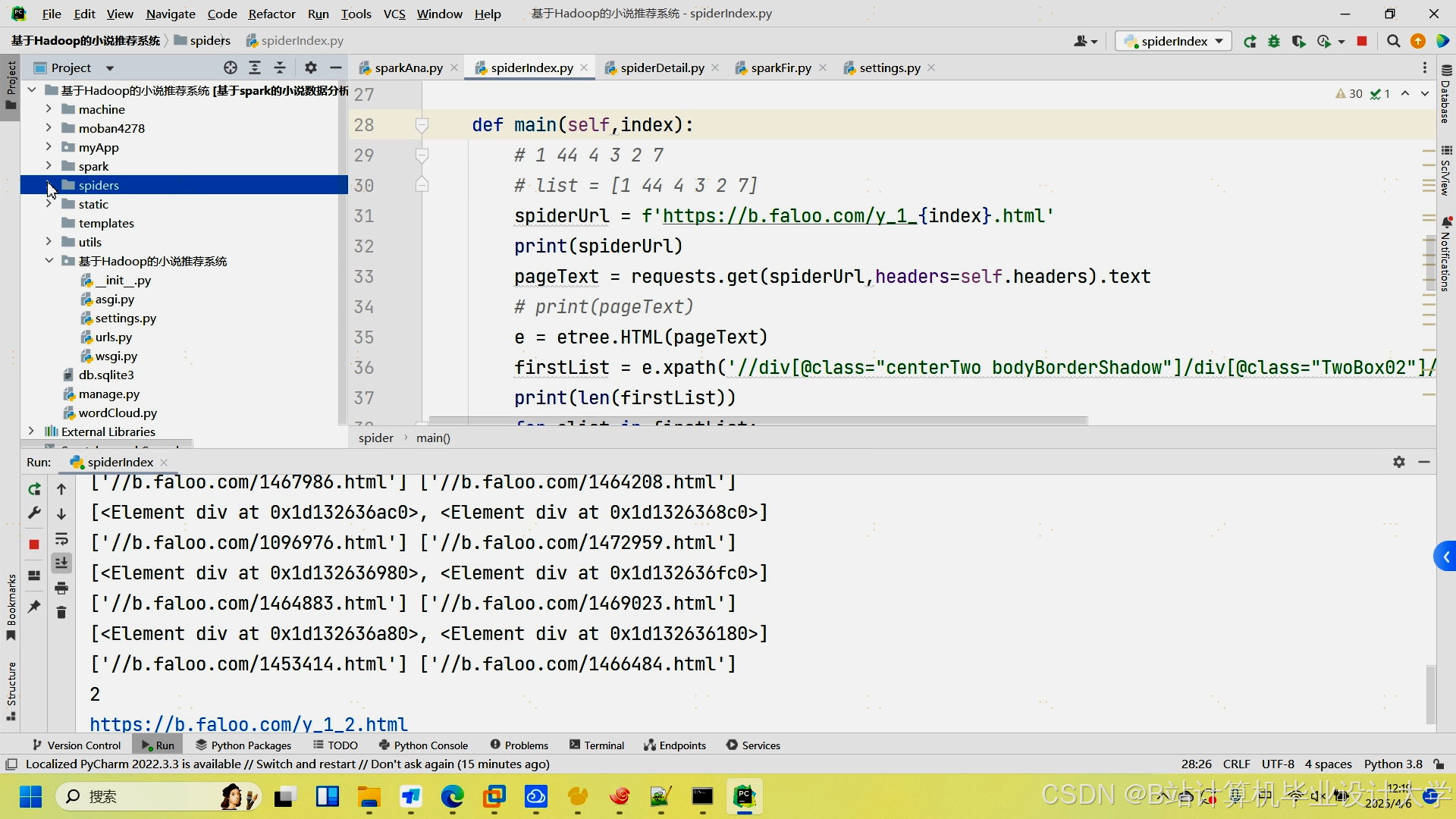

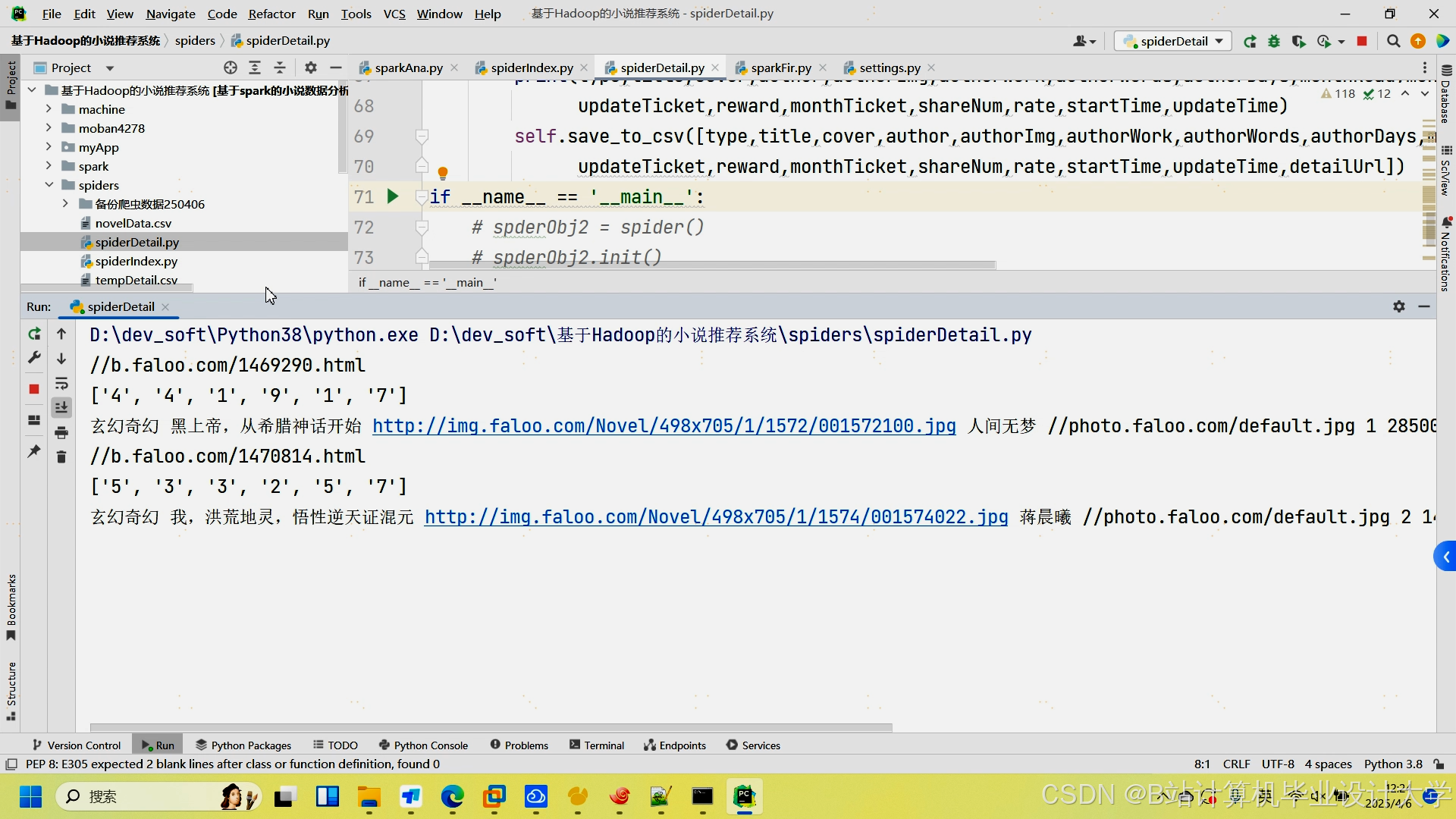

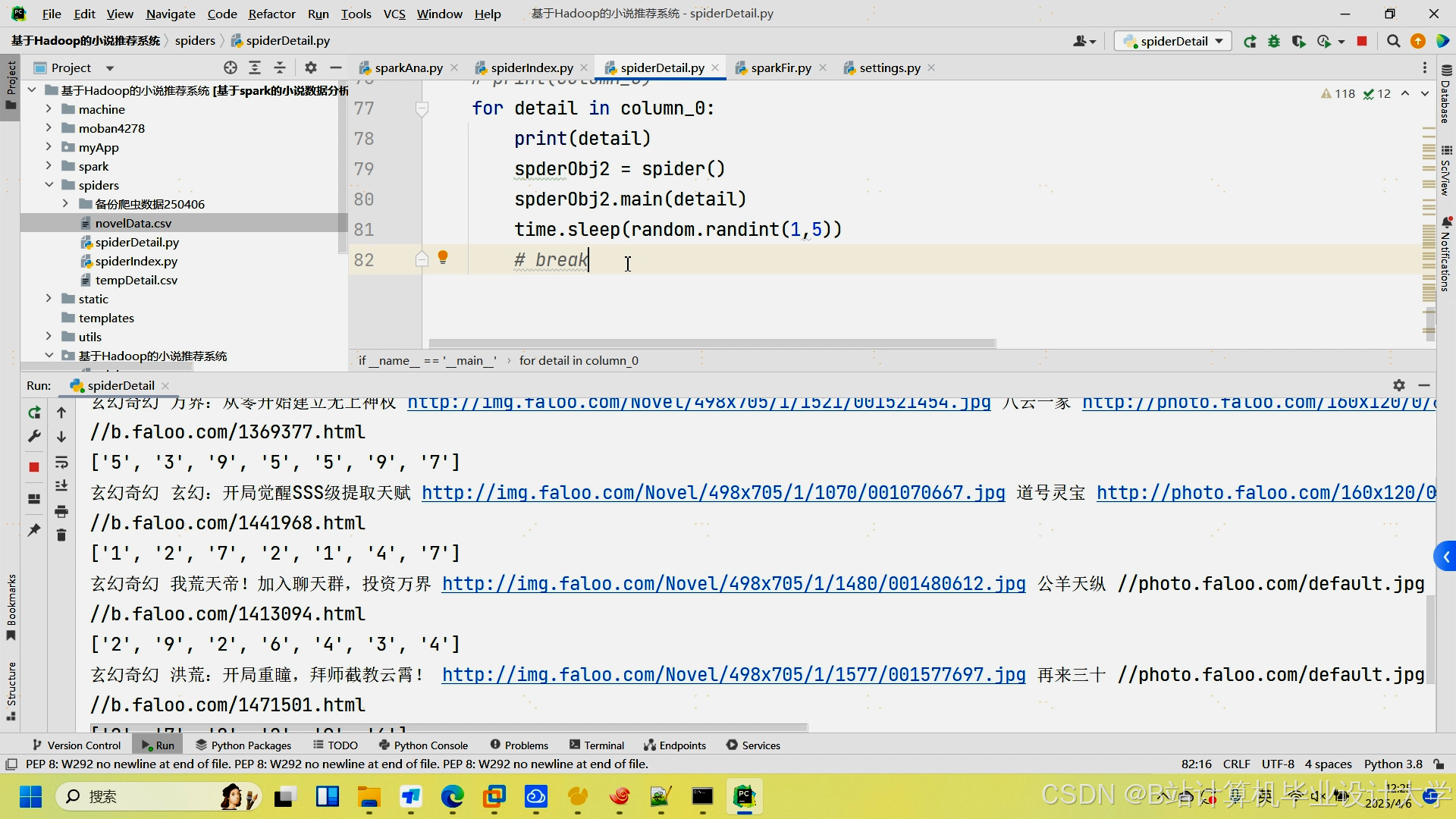

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

413

413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?