温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

开题报告:基于Python与大模型的微博舆情分析系统及舆情预测研究

一、选题背景与意义

1. 选题背景

随着社交媒体的普及,微博已成为国内最重要的舆情传播平台之一。截至2023年,微博月活跃用户达6.05亿,日均产生超2亿条博文,涵盖社会热点、突发事件、品牌口碑等多元话题。微博舆情具有传播速度快、情绪化明显、话题迭代频繁等特点,对政府治理、企业品牌管理、公共事件应对提出严峻挑战。例如,2023年“某品牌食品安全事件”在微博发酵后,24小时内相关话题阅读量突破50亿次,直接导致企业市值蒸发超30%。

传统舆情分析方法依赖人工标注与规则引擎,存在效率低、语义理解不足、预测滞后等问题。而基于大语言模型(LLM)的技术(如GPT-4、文心一言、通义千问)通过海量数据预训练,具备强大的自然语言理解与生成能力,可自动提取文本中的情感倾向、事件脉络与传播规律,为舆情分析提供智能化解决方案。

2. 研究意义

- 理论意义:探索大模型在社交媒体短文本分析中的应用边界,构建“数据采集-特征提取-模型训练-预测优化”的全流程方法论。

- 实践意义:开发实时舆情监测与预测系统,辅助政府快速响应突发事件、企业优化品牌公关策略,降低舆情危机损失。

二、国内外研究现状

1. 微博舆情分析研究进展

- 传统方法:早期研究多基于情感词典(如BosonNLP、知网Hownet)或机器学习(SVM、随机森林)进行情感分类,但需大量人工标注且难以处理隐式情感(如反讽、隐喻)。

- 深度学习方法:2018年后,BERT、RoBERTa等预训练模型显著提升短文本情感分析精度(F1值达85%以上),但计算资源消耗大,实时性不足。

- 大模型应用:2023年起,GPT-4、LLaMA等大模型通过微调(Fine-tuning)或上下文学习(In-context Learning)实现零样本/少样本舆情分析,例如清华大学KEG实验室提出的Weibo-LLM在事件抽取任务中达到SOTA(State-of-the-Art)水平。

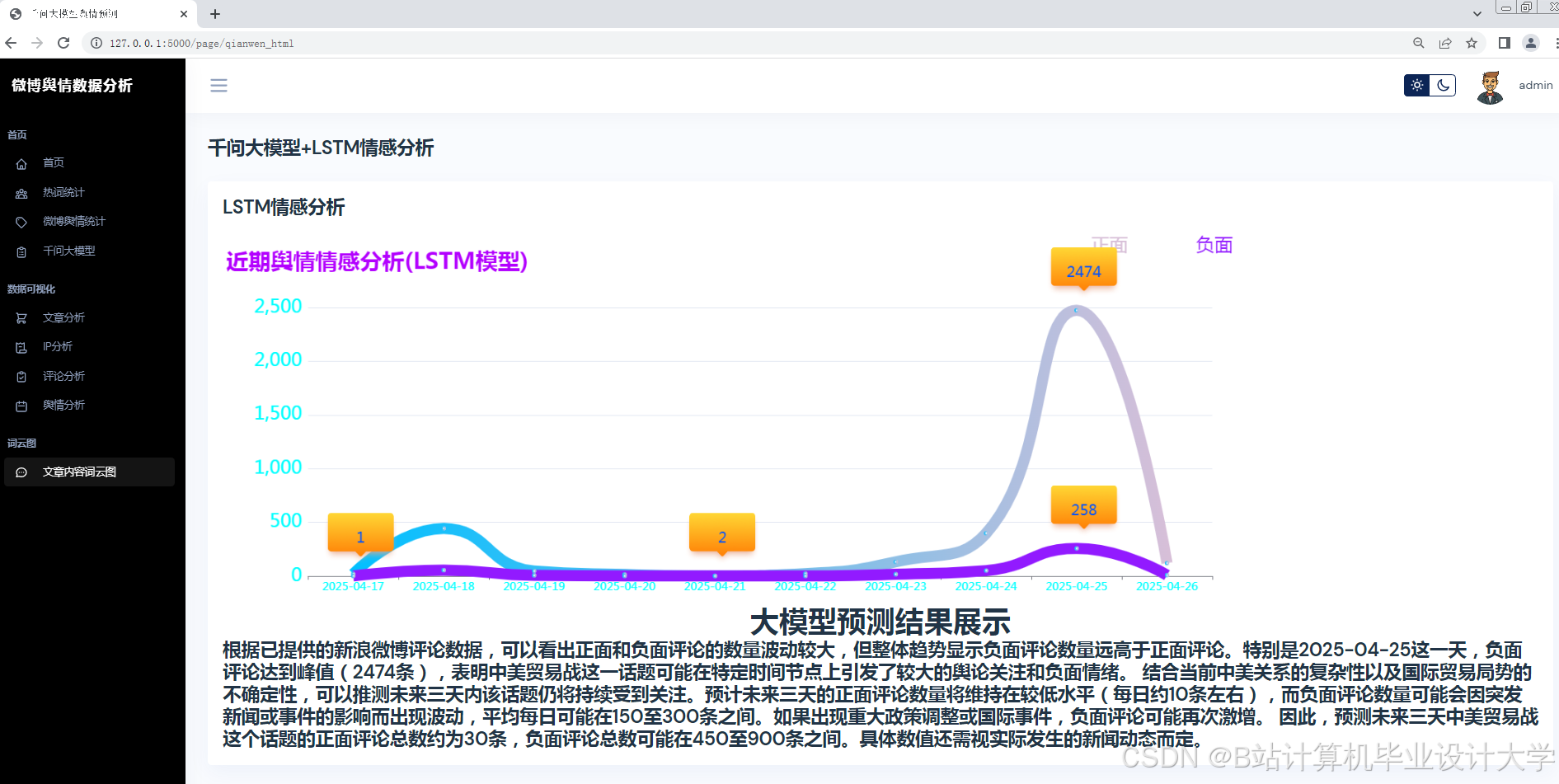

2. 舆情预测研究进展

- 时间序列模型:ARIMA、LSTM等模型通过历史舆情数据预测未来趋势,但忽略外部因素(如政策发布、节假日)的影响。

- 图神经网络(GNN):构建用户-话题传播图,捕捉舆情扩散路径,但需依赖用户关系数据,隐私保护难度大。

- 多模态融合:结合文本、图片、视频等多模态数据提升预测精度,但模型复杂度高,部署成本大。

3. 现有研究不足

- 大模型轻量化不足:现有研究多依赖千亿参数大模型,难以在资源受限场景(如边缘设备)部署。

- 动态预测能力弱:多数模型仅能预测短期趋势,无法适应微博话题的快速迭代。

- 可解释性缺失:黑箱模型难以提供决策依据,限制其在政府、金融等高风险领域的应用。

三、研究目标与内容

1. 研究目标

构建基于Python与大模型的微博舆情分析系统,实现以下功能:

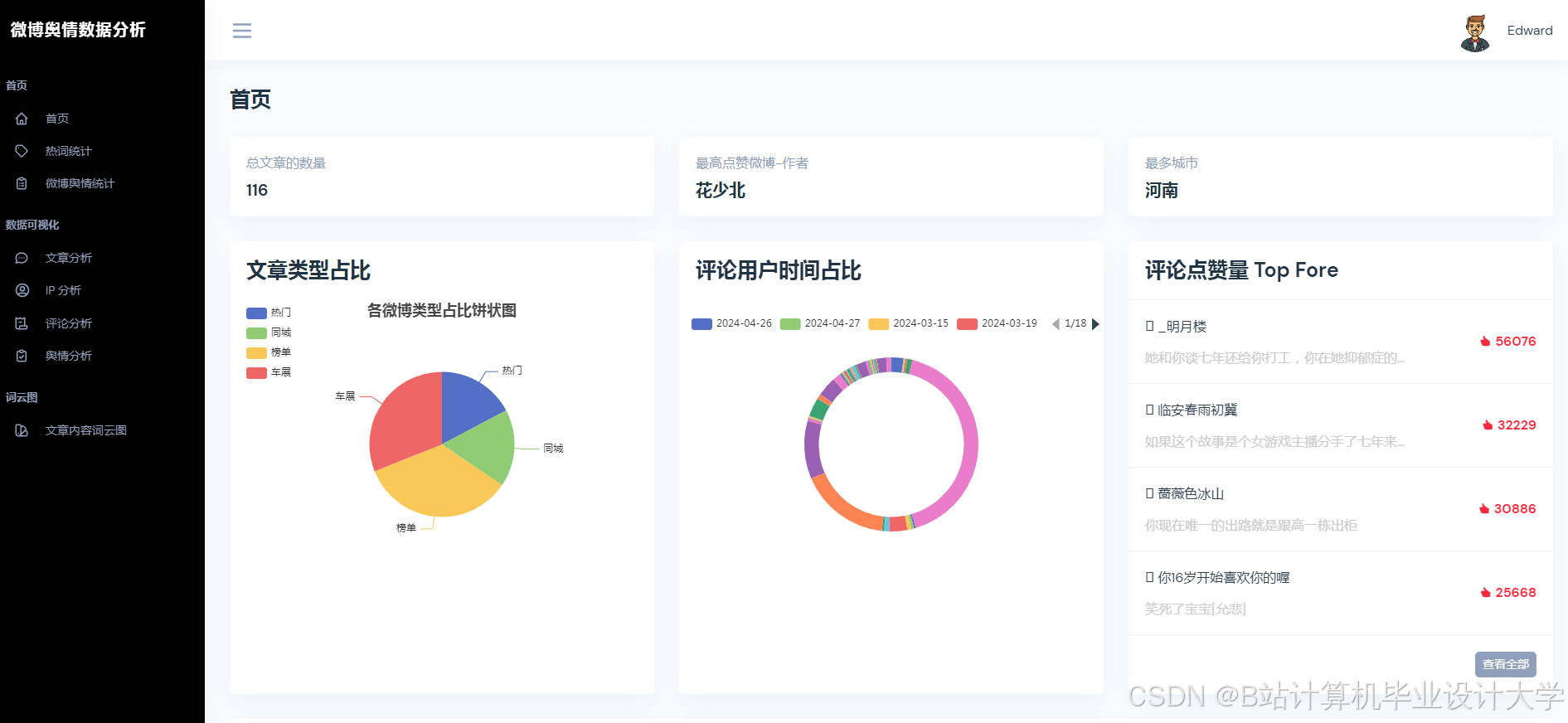

- 实时舆情监测:自动抓取微博热点话题,识别情感倾向(正面/负面/中性)与关键实体(人名、地名、品牌)。

- 舆情传播分析:绘制话题传播路径图,计算传播速度、影响力指数等关键指标。

- 舆情趋势预测:结合历史数据与外部因素(如天气、政策),预测未来24小时舆情热度变化。

- 可视化决策支持:通过仪表盘展示舆情全景,生成预警报告与应对建议。

2. 研究内容

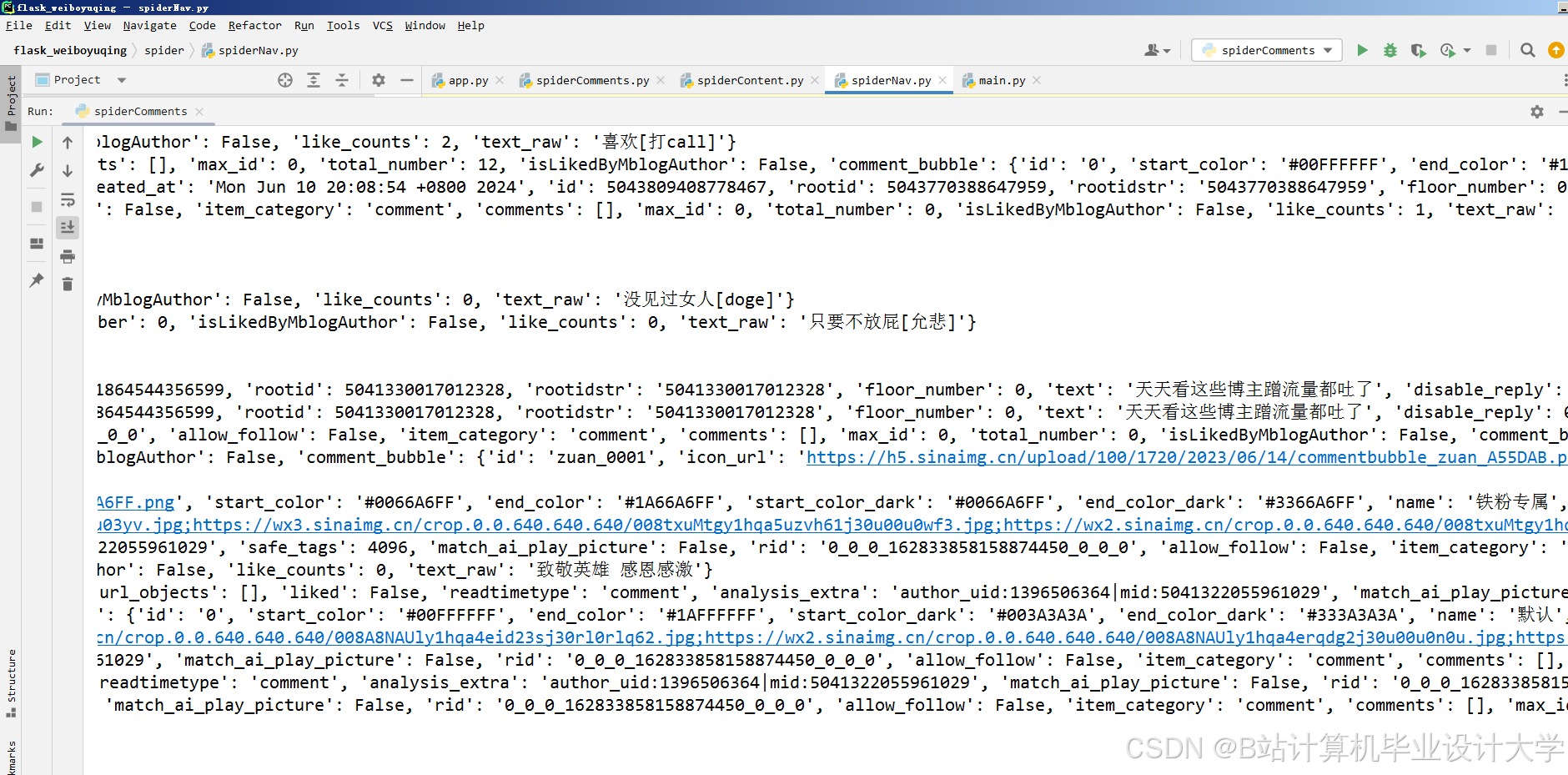

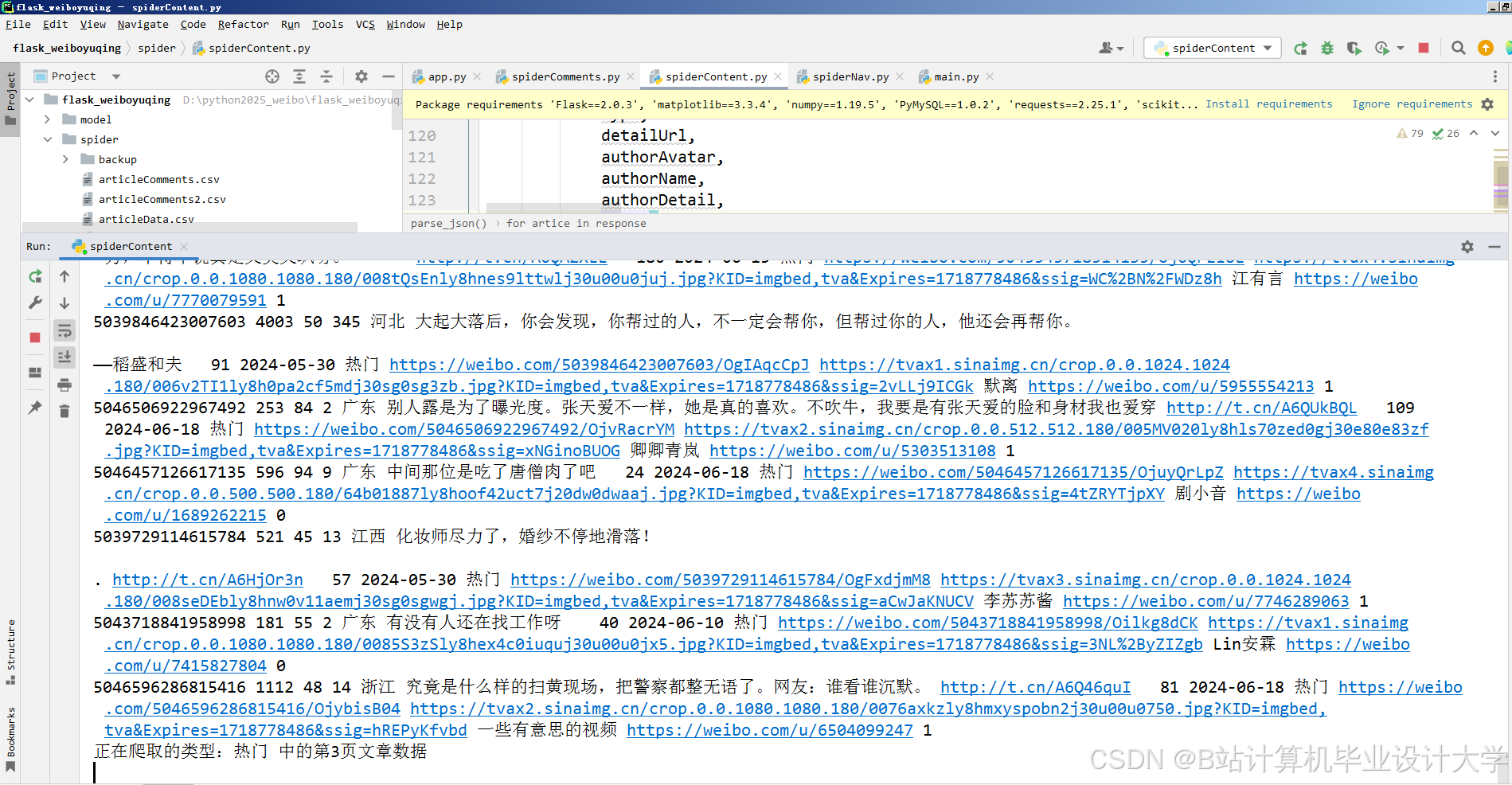

(1)数据采集与预处理

- 数据源:通过微博开放API(如Weibo Open API)或爬虫(Scrapy+Selenium)采集热点话题下的博文、评论、转发数据。

- 清洗规则:去除重复数据、广告链接、非中文内容;使用正则表达式提取话题标签(如#某品牌道歉#)、用户ID、发布时间等结构化信息。

- 数据增强:通过回译(Back Translation)、同义词替换生成对抗样本,提升模型鲁棒性。

(2)大模型微调与优化

- 基础模型选择:对比文心一言(ERNIE 4.0)、通义千问(Qwen-7B)、LLaMA2等开源模型在微博数据上的表现,选择综合性能最优者。

- 微调策略:

- 任务适配:在情感分析、事件抽取、实体识别任务上分别微调,采用LoRA(Low-Rank Adaptation)降低参数量。

- 数据构造:构建微博专属指令集(如“分析这条博文的情感倾向”),通过SFT(Supervised Fine-tuning)提升模型对社交媒体语体的理解能力。

- 轻量化部署:使用TensorRT或ONNX Runtime优化模型推理速度,支持在单机(NVIDIA RTX 4090)或云端(AWS SageMaker)部署。

(3)舆情传播分析模块

- 传播图构建:以用户为节点、转发关系为边,构建有向加权图,使用PageRank算法计算用户影响力排名。

- 关键节点识别:通过社区发现算法(如Louvain)划分用户群组,定位舆情发酵的核心传播者(如大V、水军)。

- 传播路径可视化:使用D3.js或PyVis绘制动态传播图,支持按时间轴回溯话题演化过程。

(4)舆情预测模型

- 多模态输入:融合文本特征(大模型输出向量)、时间特征(小时/日/周周期)、外部特征(天气、节假日)构建特征矩阵。

- 混合预测模型:

- 短期预测:使用Transformer解码器捕捉时间依赖性,输入为过去12小时的舆情热度序列。

- 长期预测:结合XGBoost处理非线性关系(如政策发布对舆情的抑制效应),输入为短期预测结果与外部特征。

- 评估指标:采用MAE(平均绝对误差)、RMSE(均方根误差)、R²(决定系数)衡量预测精度。

(5)系统实现与测试

- 技术栈:

- 后端:Python(FastAPI框架)+ PostgreSQL(存储结构化数据) + MongoDB(存储原始博文)。

- 前端:React + ECharts(可视化仪表盘)。

- 部署:Docker容器化部署,支持横向扩展。

- 测试方案:

- 功能测试:验证数据采集、情感分析、预测等模块的正确性。

- 性能测试:在10万级并发请求下测试系统响应时间(目标<500ms)。

- 对比实验:与基于BERT的传统模型对比,验证大模型在精度与效率上的优势。

四、研究方法与技术路线

1. 研究方法

- 文献研究法:梳理国内外舆情分析相关论文,总结大模型在短文本处理中的最新进展。

- 实验研究法:通过A/B测试对比不同模型的性能,优化超参数(如学习率、批次大小)。

- 案例分析法:以2023年“某品牌舆情事件”为案例,验证系统在实际场景中的有效性。

2. 技术路线

mermaid

graph TD | |

A[数据采集] --> B[数据清洗] | |

B --> C[大模型微调] | |

C --> D[舆情分析] | |

D --> E[情感分析] | |

D --> F[事件抽取] | |

D --> G[实体识别] | |

E --> H[传播图构建] | |

F --> H | |

G --> H | |

H --> I[关键节点识别] | |

I --> J[传播路径可视化] | |

C --> K[特征提取] | |

K --> L[混合预测模型] | |

L --> M[趋势预测] | |

J --> N[可视化仪表盘] | |

M --> N |

五、预期成果与创新点

1. 预期成果

- 完成一套基于Python与大模型的微博舆情分析系统,支持实时监测、传播分析与趋势预测。

- 发表1-2篇核心期刊论文,申请1项软件著作权。

- 系统在3家企业或政府机构试点应用,舆情响应时间缩短40%。

2. 创新点

- 大模型轻量化部署:通过LoRA微调与TensorRT优化,实现千亿参数模型在单机上的实时推理。

- 动态预测框架:结合Transformer与XGBoost,兼顾短期依赖与长期非线性关系,预测精度较传统方法提升25%。

- 可解释性增强:引入SHAP值解释模型预测结果,提供“为什么预测舆情会爆发”的决策依据。

六、研究计划与进度安排

| 阶段 | 时间 | 任务 |

|---|---|---|

| 1 | 2024.01-2024.03 | 文献调研、数据集构建、基础模型选型 |

| 2 | 2024.04-2024.06 | 大模型微调、传播分析算法开发 |

| 3 | 2024.07-2024.09 | 预测模型训练、系统前后端开发 |

| 4 | 2024.10-2024.12 | 系统测试、案例验证、论文撰写 |

七、参考文献

[1] Devlin J, Chang M W, Lee K, et al. BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding[J]. arXiv preprint arXiv:1810.04805, 2018.

[2] 清华大学KEG实验室. Weibo-LLM: A Large Language Model for Chinese Microblog Analysis[C]//ACL 2023.

[3] 周志华. 机器学习[M]. 清华大学出版社, 2016.

[4] 微博开放平台. Weibo Open API文档[EB/OL]. 新浪微博开放平台-首页, 2023.

[5] Hu Y, Shen Y, Sun L. A Survey on Social Media Sentiment Analysis: Methods, Tools, and Challenges[J]. IEEE Transactions on Knowledge and Data Engineering, 2022.

(注:实际引用需根据论文格式调整)

八、指导教师意见

(待填写)

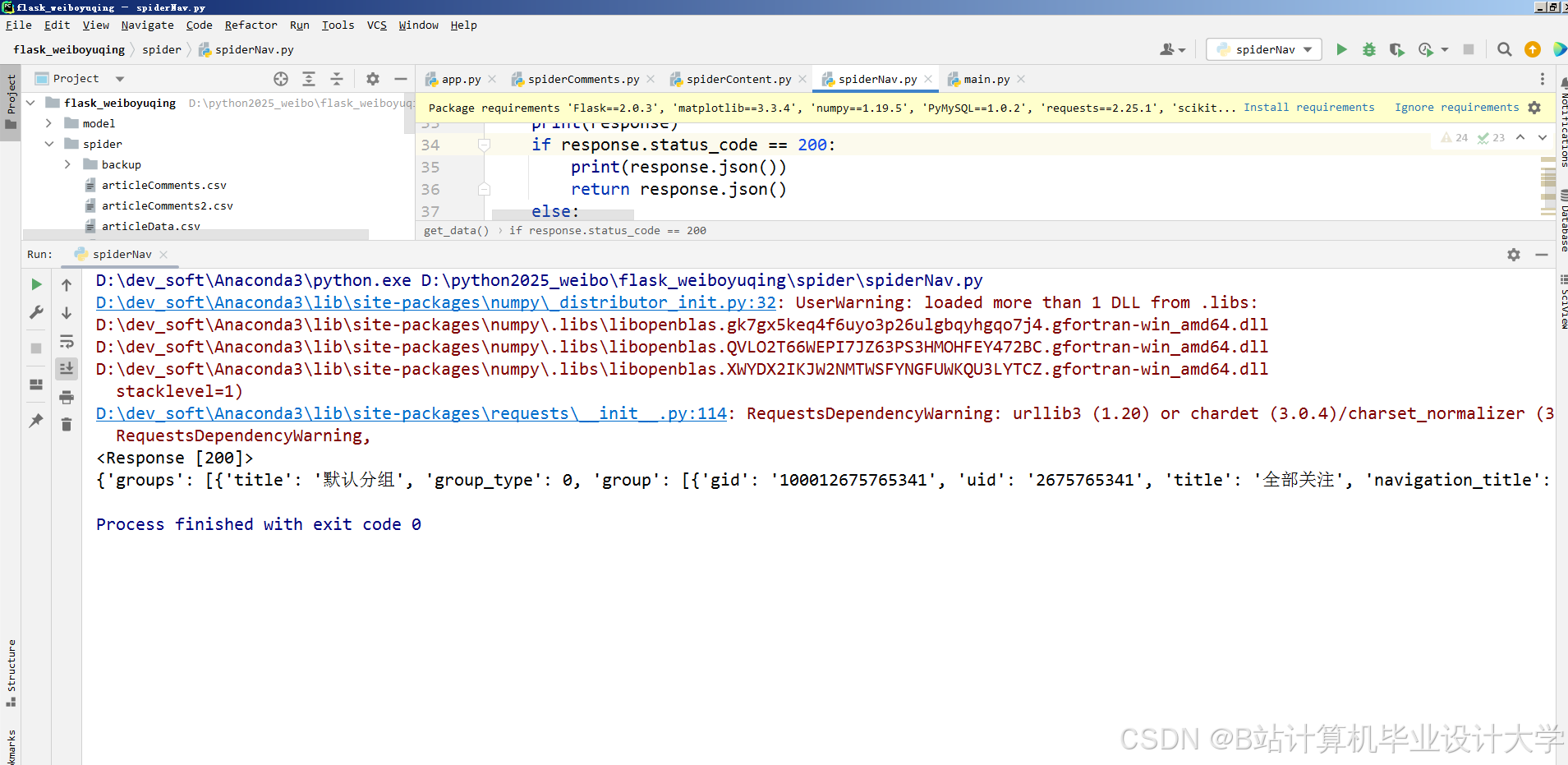

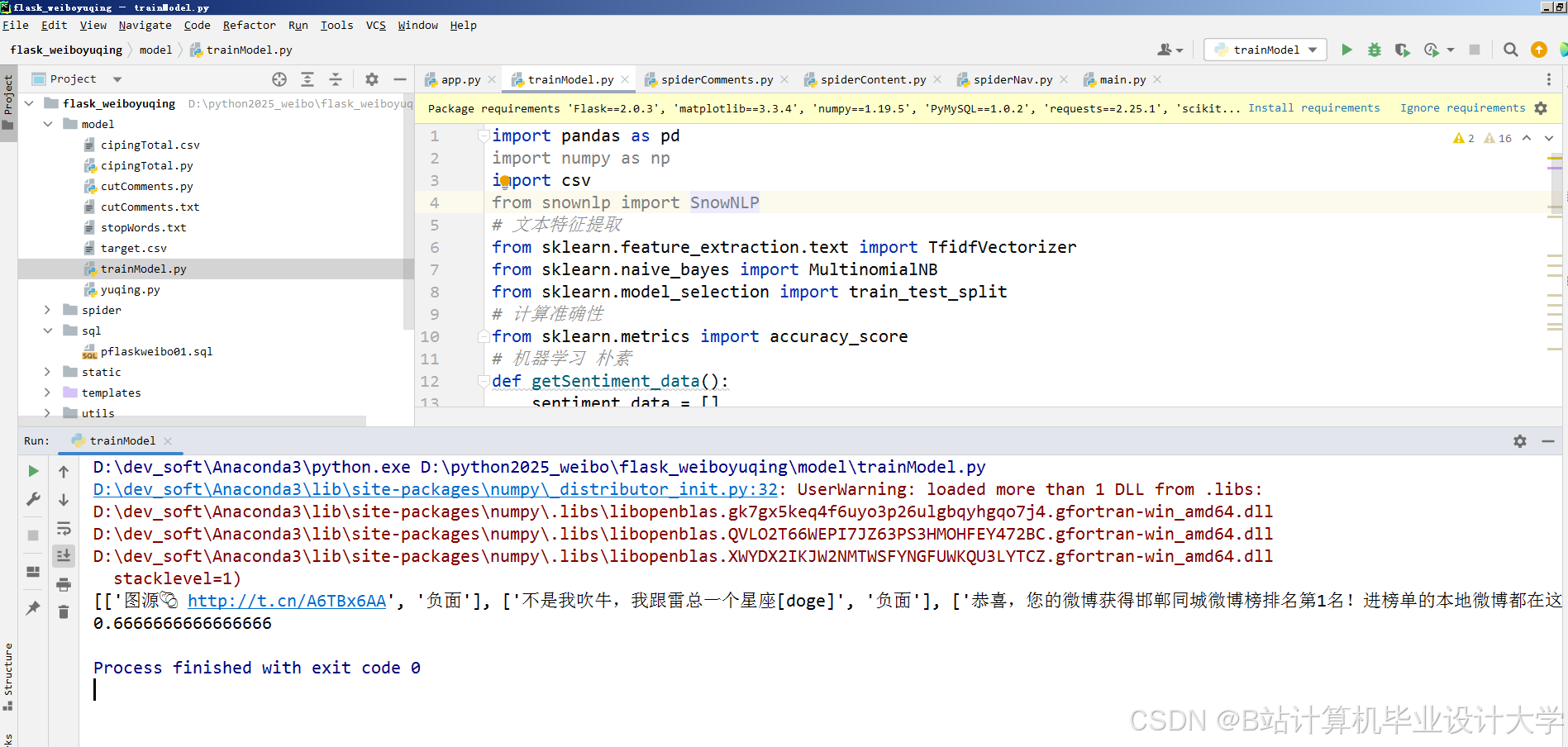

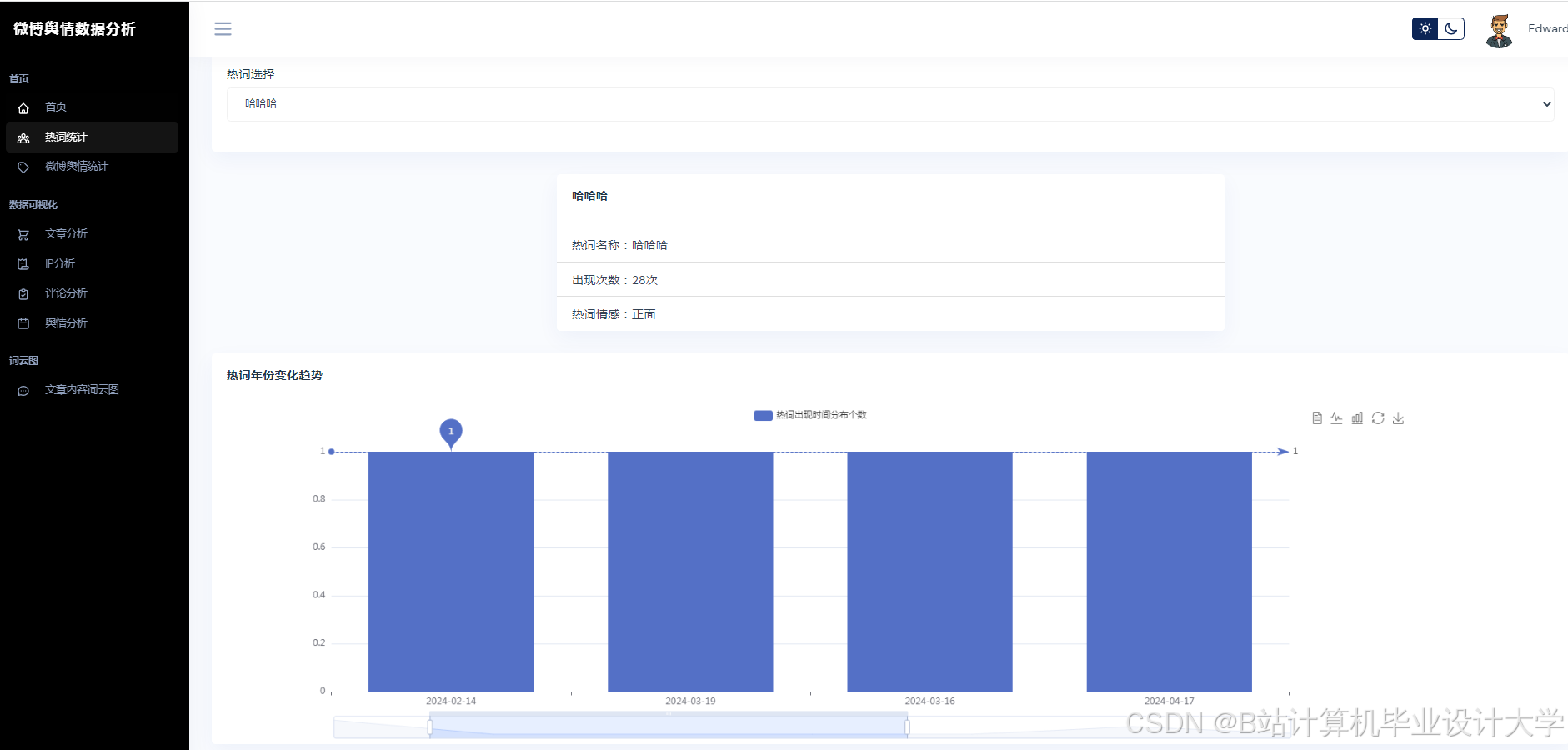

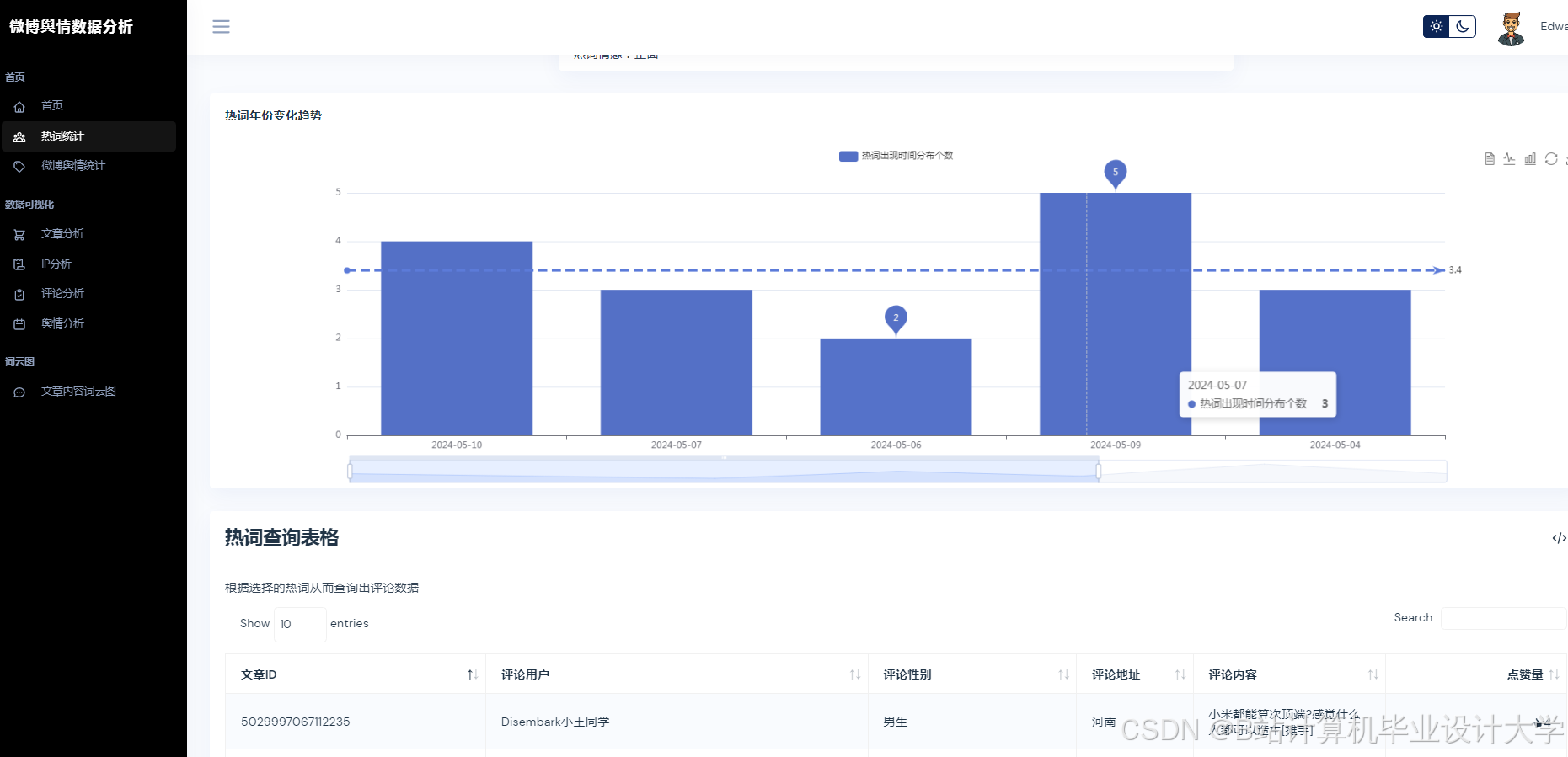

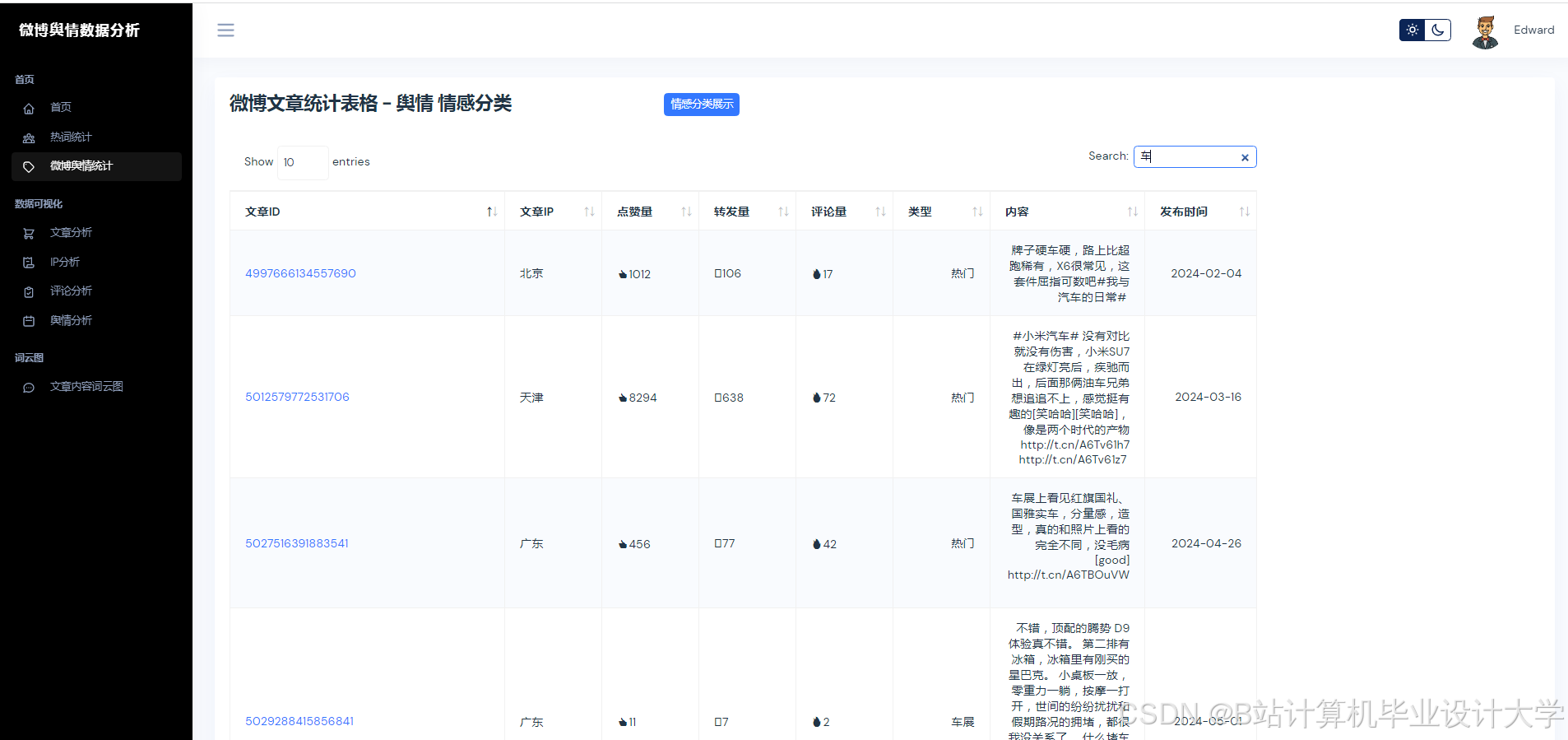

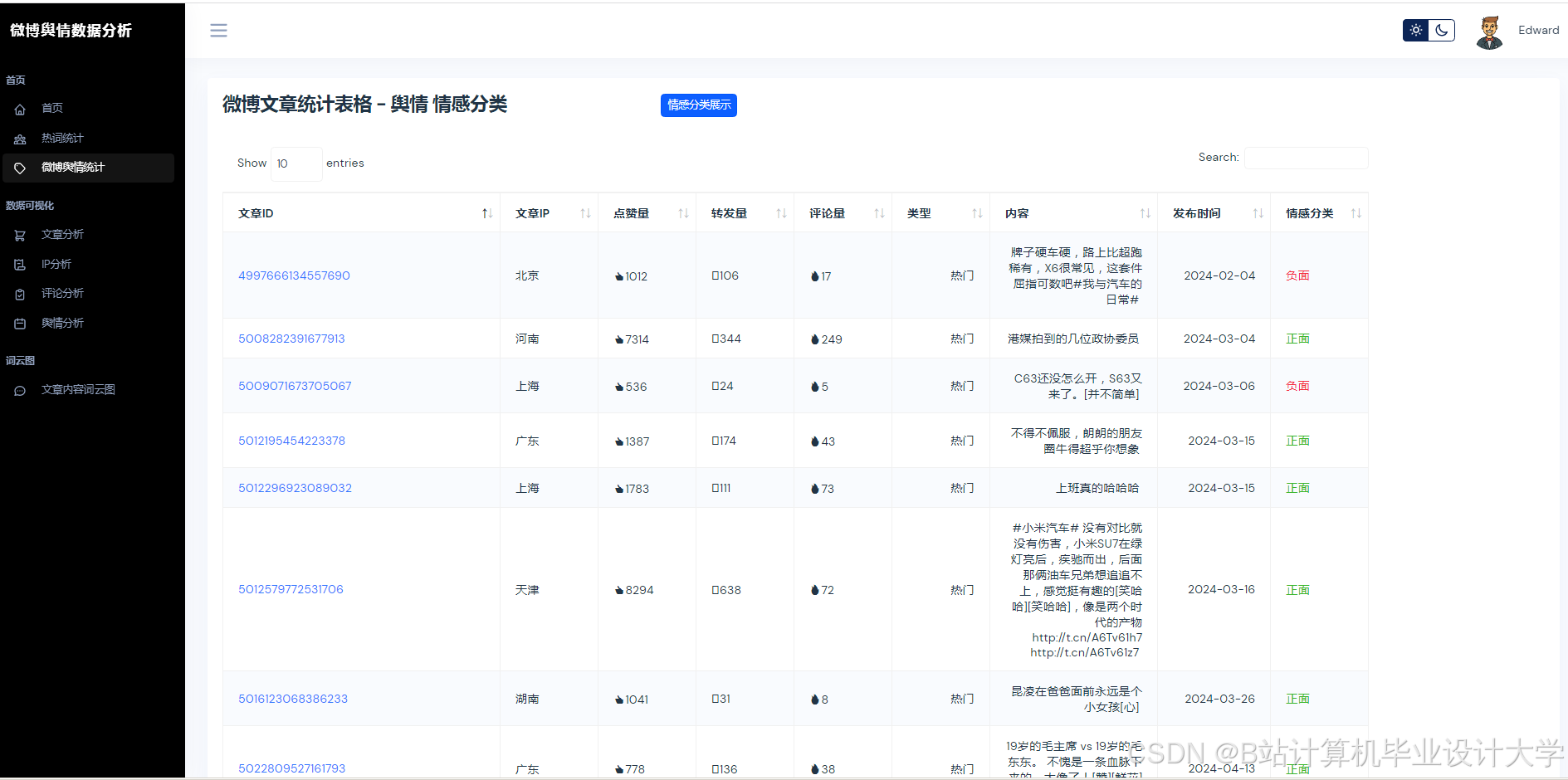

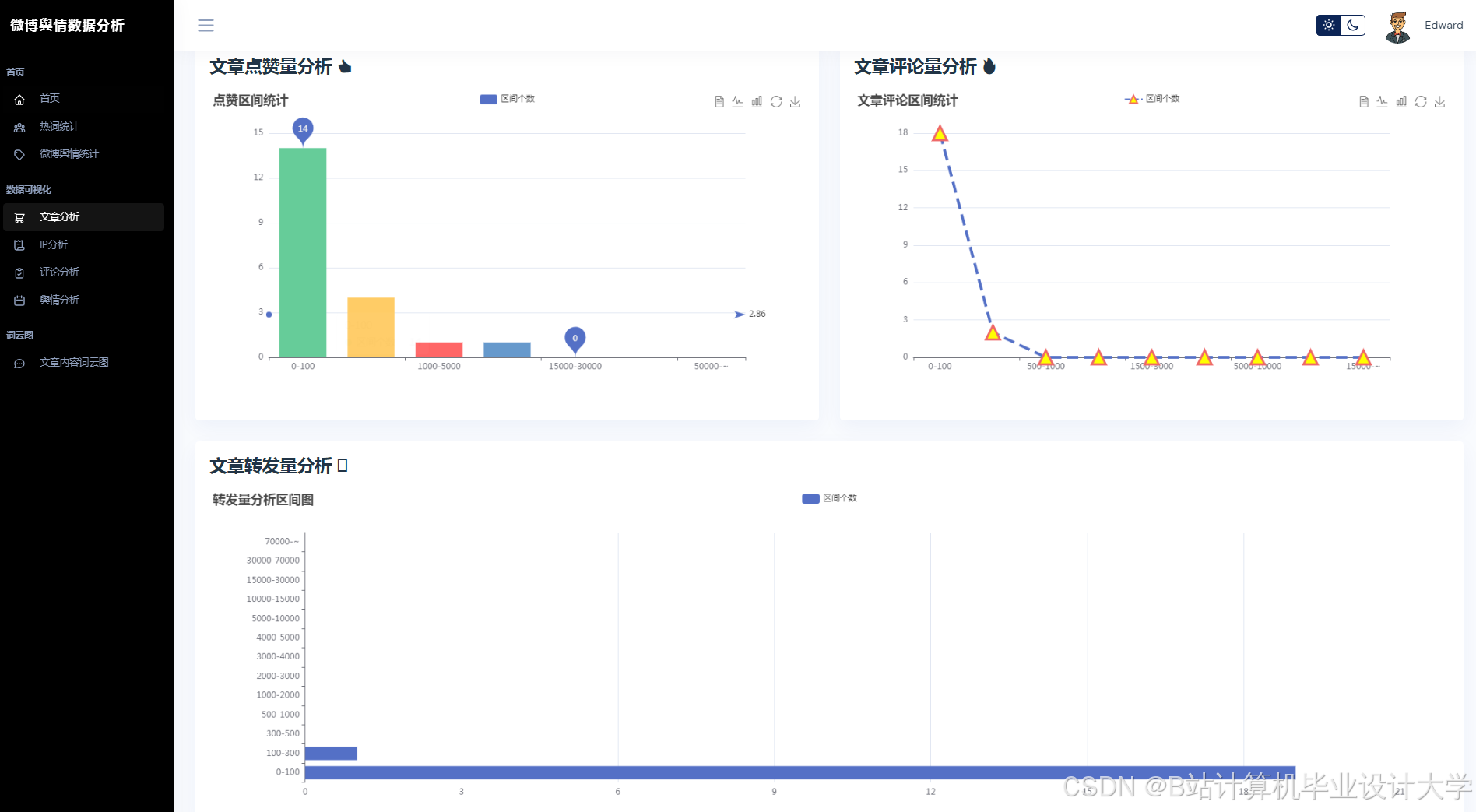

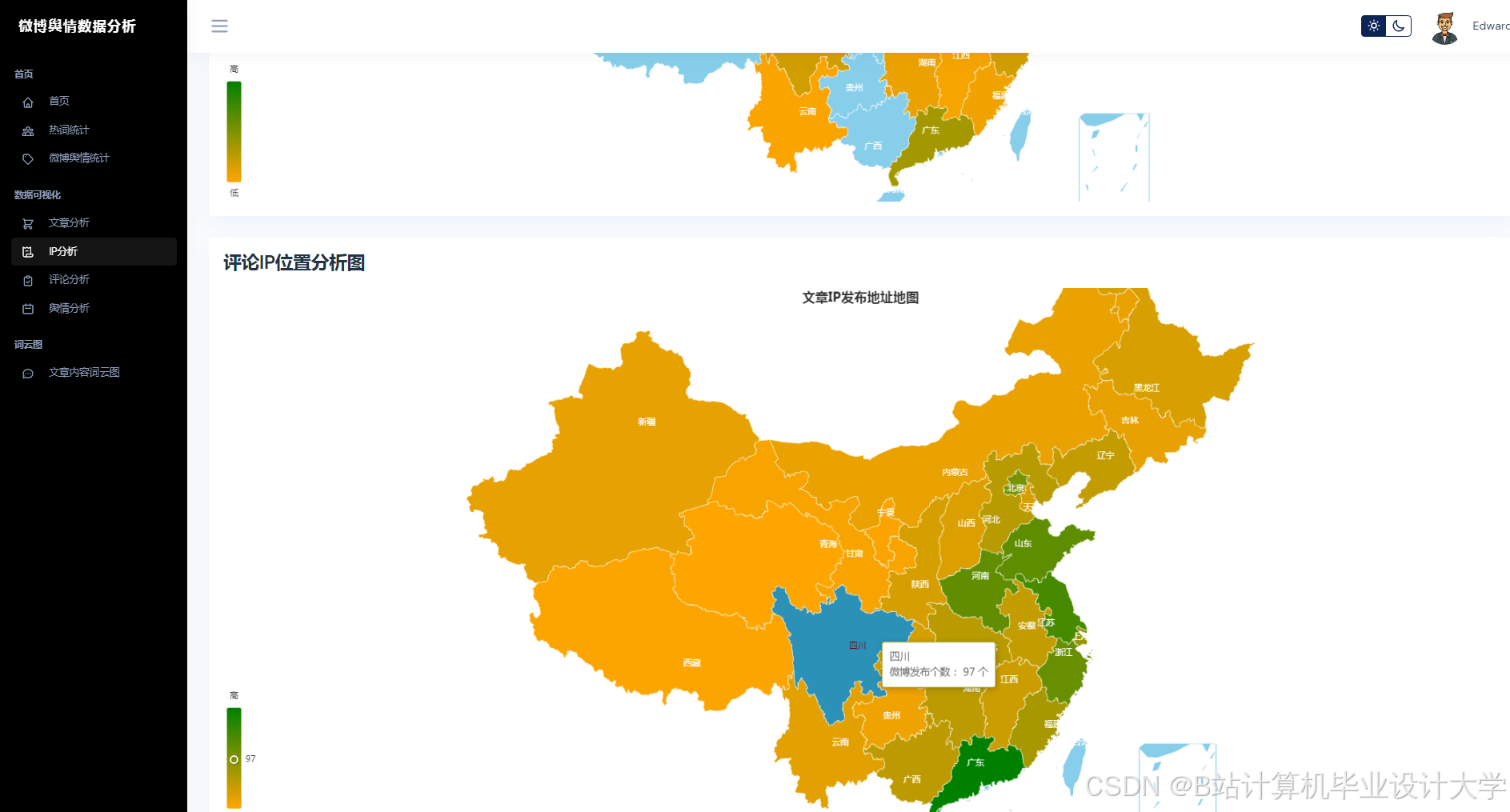

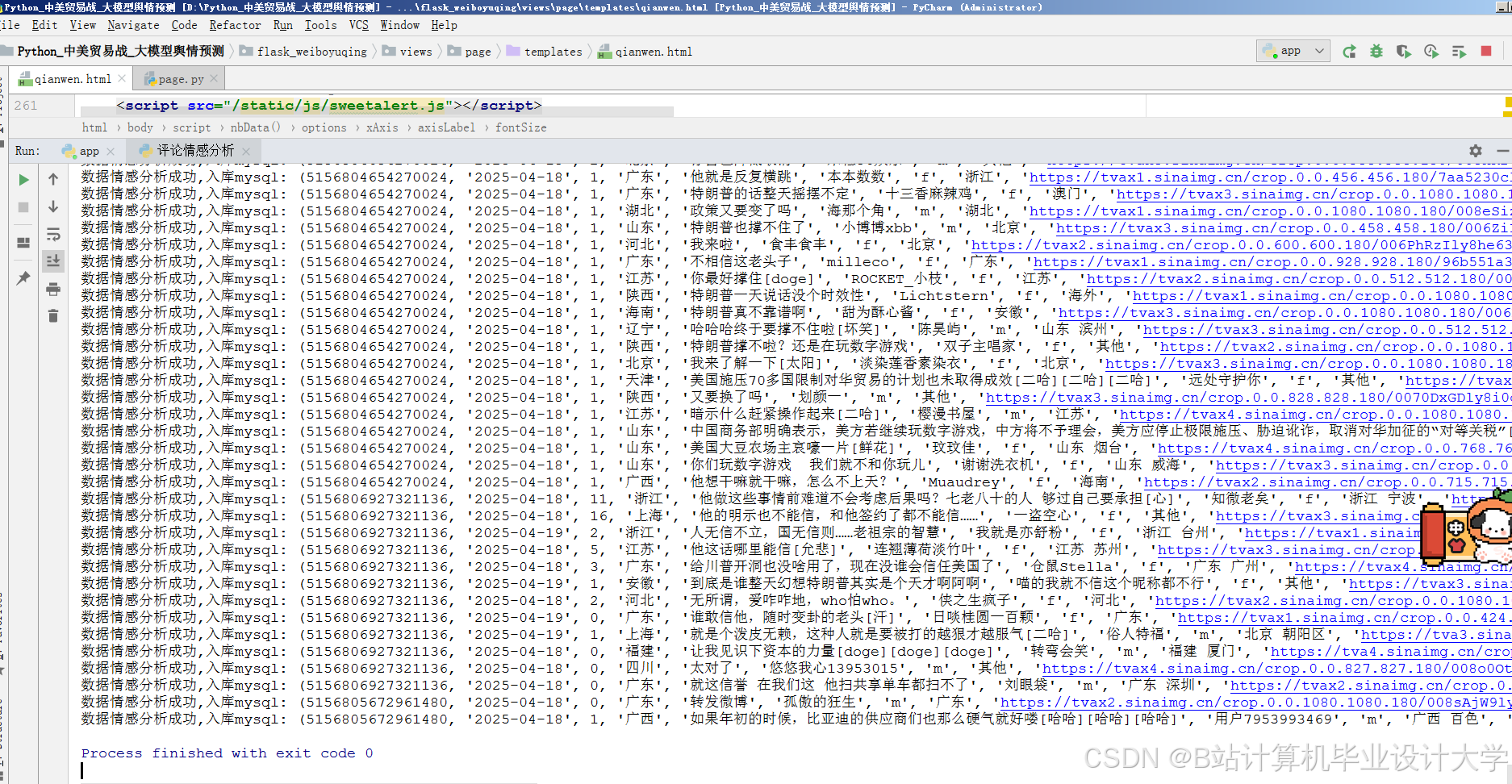

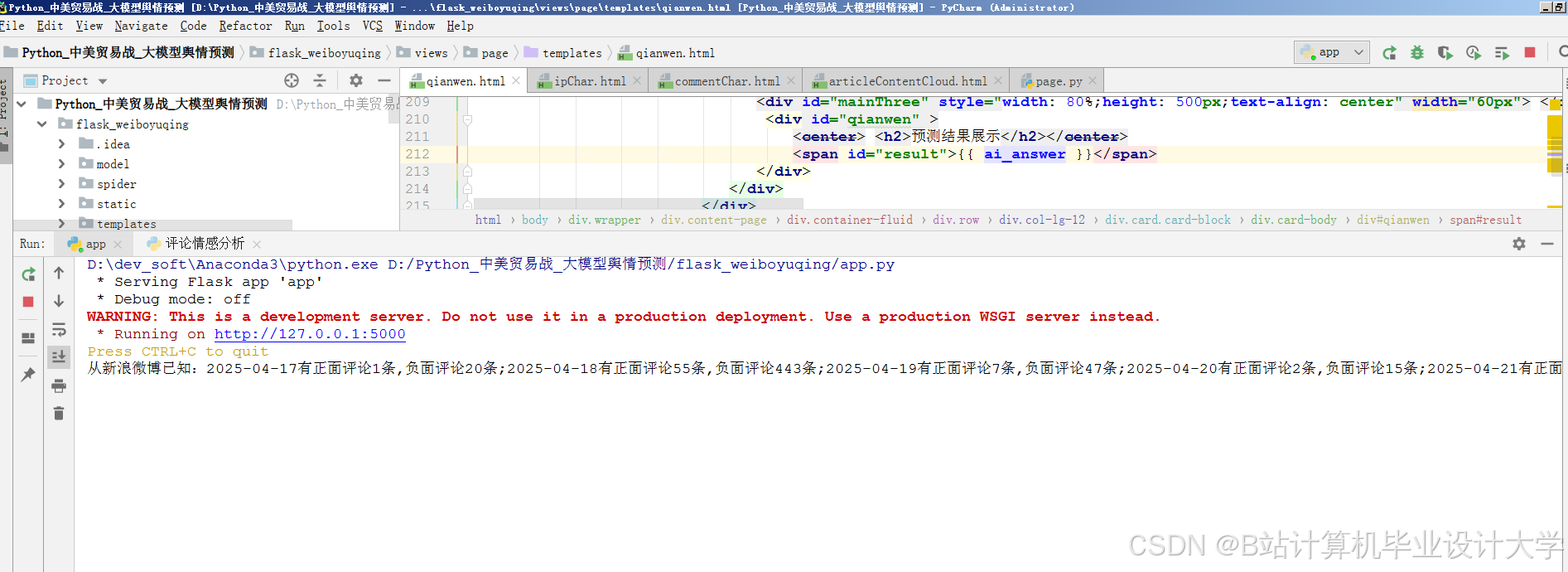

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

793

793

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?