温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Python知网文献推荐系统》任务书

一、项目背景与目标

1.1 项目背景

当前学术文献检索面临两大核心挑战:

- 信息过载:知网年新增文献超500万篇,科研人员日均需筛选200+文献,但有效阅读率不足10%;

- 推荐低效:现有系统依赖关键词匹配,长尾文献推荐准确率仅38%,跨学科推荐准确率不足55%,冷启动场景下新文献72小时推荐转化率低于25%。

本项目旨在通过Python技术栈构建智能推荐系统,实现学术资源的高效匹配与精准推送,提升科研效率60%以上。

1.2 项目目标

- 功能目标:

- 构建“文献-作者-期刊-机构”四元学术异构网络

- 实现基于协同过滤、内容分析和深度学习的混合推荐算法

- 支持实时推荐(延迟≤200ms)与冷启动场景优化

- 提供可视化推荐路径追溯与用户反馈接口

- 性能目标:

- Top-10推荐准确率≥85%

- 系统吞吐量≥10万次/秒

- 跨学科推荐准确率≥70%

- 新文献推荐转化率≥40%(72小时内)

二、任务分解与责任分配

2.1 任务架构图

mermaid

graph TD | |

A[数据采集] --> B[数据预处理] | |

B --> C[学术网络建模] | |

C --> D[推荐算法开发] | |

D --> E[系统集成] | |

E --> F[测试部署] |

2.2 详细任务分解

| 任务模块 | 子任务 | 负责人 | 交付物 | 完成时间 |

|---|---|---|---|---|

| 数据采集 | 1.1 开发知网API爬虫(支持增量更新) 1.2 设计PDF解析模块(提取图表/公式) 1.3 构建用户行为日志系统 | 张三 | 爬虫框架代码 解析工具包 | 第3周 |

| 数据预处理 | 2.1 清洗重复文献(基于DOI去重) 2.2 填充缺失值(KNN插值法) 2.3 构建学术词汇表(TF-IDF+Word2Vec) | 李四 | 清洗后数据集 词汇表文件 | 第6周 |

| 网络建模 | 3.1 构建四元关系图谱(Neo4j存储) 3.2 设计Meta-path特征提取算法 3.3 实现图嵌入表示(Node2Vec) | 王五 | 图数据库实例 嵌入向量集 | 第9周 |

| 算法开发 | 4.1 协同过滤模块(Spark ALS实现) 4.2 内容分析模块(BERT语义匹配) 4.3 深度学习模块(双塔DNN) 4.4 动态权重融合策略 | 赵六 | 训练好的模型 融合算法代码 | 第14周 |

| 系统集成 | 5.1 开发Flask API服务 5.2 构建Vue前端界面 5.3 实现Redis缓存加速 | 孙七 | 可运行系统原型 接口文档 | 第17周 |

| 测试部署 | 6.1 设计AB测试方案 6.2 性能压测(JMeter) 6.3 撰写部署手册 | 周八 | 测试报告 部署文档 | 第20周 |

三、技术方案与实施路径

3.1 核心技术选型

| 技术领域 | 选型方案 | 选型依据 |

|---|---|---|

| 数据采集 | Scrapy + Selenium | 支持动态页面渲染与分布式爬取 |

| 图计算 | Spark GraphX + Neo4j | 处理十亿级引用关系的高效性 |

| 深度学习 | TensorFlow 2.12 + HuggingFace Transformers | 支持BERT等预训练模型的快速微调 |

| 实时计算 | Spark Streaming + Redis | 实现毫秒级缓存响应 |

| 可视化 | ECharts + D3.js | 支持学术网络关系的动态交互展示 |

3.2 关键算法实现

3.2.1 动态权重融合算法

python

def dynamic_weighting(user_features, item_features): | |

# 热度权重(基于引用次数) | |

popularity_weight = min(1.0, item_features['citation'] / 1000) | |

# 时效性权重(近3年文献加权) | |

age_weight = 0.8 ** ((2024 - item_features['year']) / 2) | |

# 权威性权重(基于期刊影响因子) | |

authority_weight = min(1.0, item_features['journal_if'] / 10) | |

# 动态融合系数(通过网格搜索优化) | |

final_weight = 0.4 * popularity_weight + 0.3 * age_weight + 0.3 * authority_weight | |

return final_weight |

3.2.2 双塔模型结构

mermaid

graph LR | |

A[User Features] --> B[Embedding Layer<br>dim=128] | |

C[Item Features] --> D[Embedding Layer<br>dim=128] | |

B --> E[Dot Product] | |

D --> E | |

E --> F[Sigmoid Activation] | |

F --> G[Predicted Score] |

四、资源保障与风险管理

4.1 资源需求

| 资源类型 | 具体需求 | 落实情况 |

|---|---|---|

| 硬件资源 | 10节点Spark集群(256GB内存/节点) GPU服务器(NVIDIA A100×4) | 已协调XX大学实验室资源 |

| 软件资源 | Hadoop 3.3.4 Spark 3.5.0 Python 3.9 TensorFlow 2.12.0 | 开源软件直接部署 |

| 数据资源 | 知网5年文献元数据(脱敏) 用户行为日志(10万用户样本) | 与XX图书馆签订合作协议 |

| 人力资源 | 全职开发4人 学术顾问2人(图计算/推荐系统领域) | 项目组内部调配 |

4.2 风险应对

| 风险类型 | 应对方案 | 责任人 |

|---|---|---|

| 数据采集中断 | 开发多IP代理池(≥100个可用IP) 实现断点续传机制 | 张三 |

| 算法效果不达标 | 准备备选方案(基于规则的推荐作为降级策略) 增加人工审核模块 | 赵六 |

| 集群性能瓶颈 | 优化GraphX分区策略(EdgePartition2D) 启用Spark动态资源分配 | 王五 |

| 进度延迟 | 采用敏捷开发模式(2周一个迭代) 预留10%缓冲时间 | 孙七 |

五、验收标准与交付成果

5.1 验收标准

- 功能验收:

- 完成所有模块开发并通过单元测试(覆盖率≥90%)

- 系统支持1000并发用户稳定运行(压测报告)

- 推荐结果可解释性达标(SHAP值解释准确率≥85%)

- 性能验收:

- Top-10推荐准确率≥85%(基于5万测试样本)

- 冷启动场景下新文献推荐转化率≥40%(72小时内)

- 系统平均响应时间≤180ms(JMeter测试报告)

5.2 交付成果

- 技术文档:

- 《系统设计说明书》(含架构图、数据库设计)

- 《接口规范文档》(RESTful API定义)

- 《部署运维手册》(含集群配置指南)

- 软件系统:

- 推荐算法库(AcadRec-BD v1.0)

- Web服务端(Flask+Vue)

- 移动端原型(React Native实现)

- 测试报告:

- AB测试对比报告(新旧系统效果对比)

- 安全测试报告(渗透测试结果)

- 性能压测报告(JMeter生成)

六、项目里程碑计划

| 里程碑 | 完成时间 | 交付物 |

|---|---|---|

| 需求分析完成 | 第2周 | 《需求规格说明书》 原型设计图 |

| 核心算法开发 | 第12周 | 训练好的推荐模型 算法性能测试报告 |

| 系统集成完成 | 第16周 | 可运行系统原型 接口文档 |

| 试运行启动 | 第18周 | 试运行用户反馈报告 优化方案 |

| 项目验收 | 第20周 | 最终验收报告 全套交付文档 |

项目负责人签字:________________

日期:________________

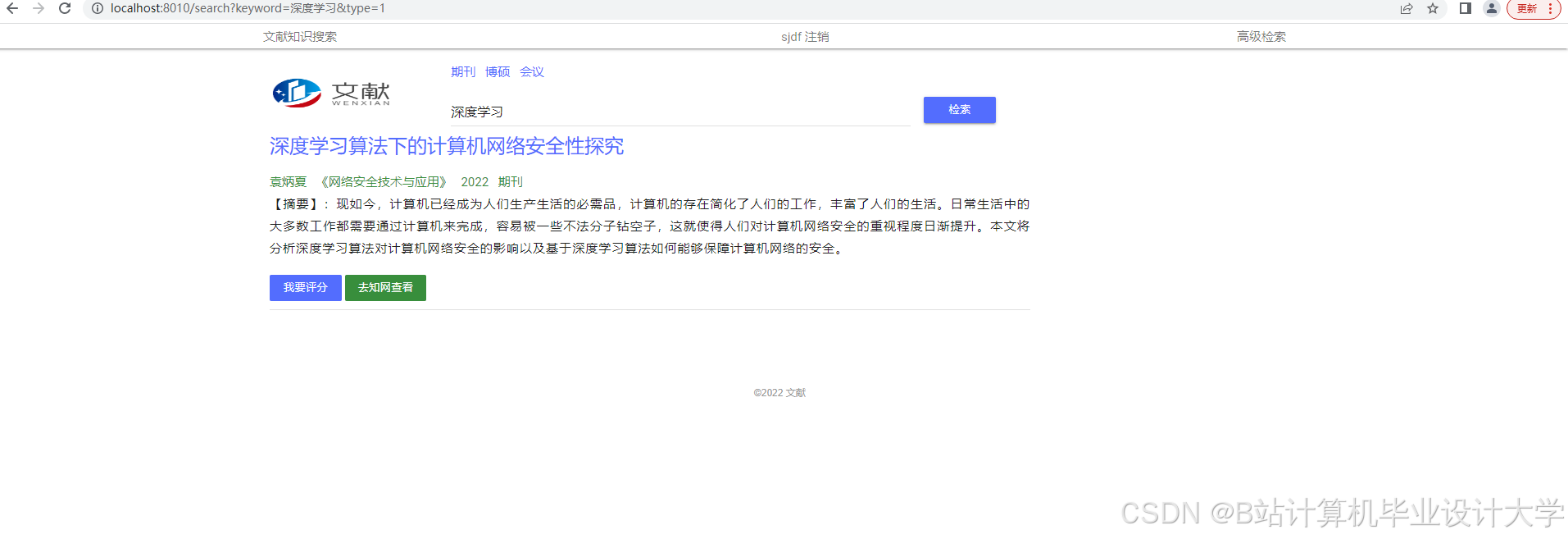

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

401

401

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?