温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Hadoop+Spark+Hive 招聘推荐系统》任务书

一、基本信息

- 项目名称:Hadoop+Spark+Hive 招聘推荐系统

- 项目负责人:[姓名]

- 项目成员:[成员 1 姓名]、[成员 2 姓名]……

- 项目起止时间:[开始日期]-[结束日期]

二、项目背景与目标

(一)项目背景

在当今数字化时代,招聘行业面临着海量求职者信息和众多招聘岗位的匹配难题。传统招聘方式效率低下,无法快速精准地为求职者推荐合适岗位,也难以让招聘方高效筛选到符合要求的候选人。随着大数据技术的兴起,Hadoop、Spark 和 Hive 作为大数据领域的关键技术框架,具备强大的数据处理和分析能力,为解决招聘推荐问题提供了有效途径。Hadoop 提供了分布式存储和计算的基础架构,Spark 以其内存计算优势实现快速数据处理,Hive 则提供类似 SQL 的查询语言方便数据操作。因此,构建基于 Hadoop+Spark+Hive 的招聘推荐系统具有重要的现实意义。

(二)项目目标

- 搭建基于 Hadoop、Spark 和 Hive 的大数据处理平台,实现对招聘相关数据的高效存储、管理和分析。

- 收集并整合多源招聘数据,包括求职者简历信息、招聘岗位信息、用户行为数据等,构建全面的数据仓库。

- 运用数据挖掘和机器学习技术,从数据中提取有价值的信息和特征,设计并实现精准的招聘推荐算法。

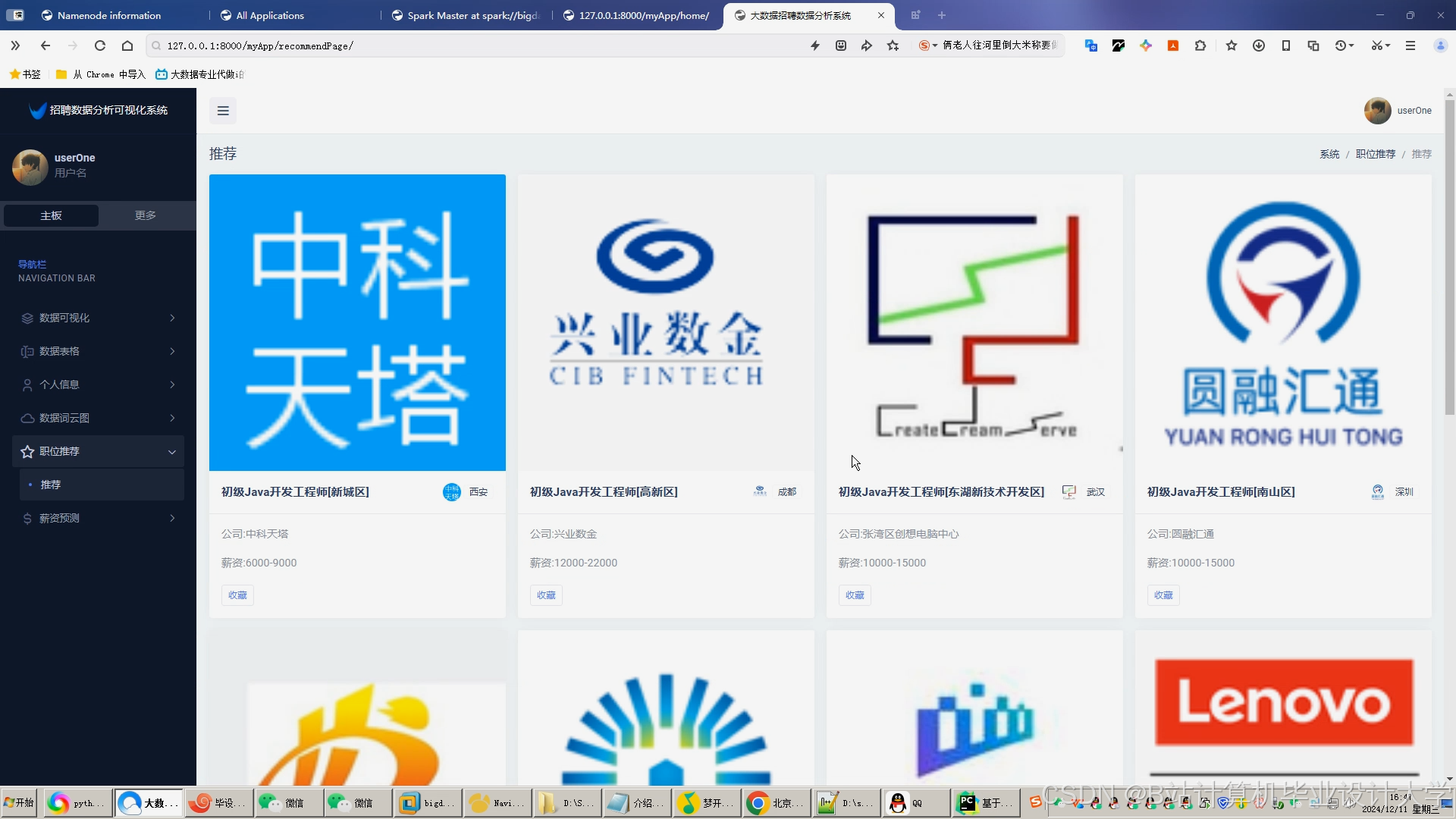

- 开发招聘推荐系统的前端界面和后端服务,为用户提供友好的交互体验,实现求职者与招聘岗位的精准匹配和推荐。

- 对招聘推荐系统进行性能评估和优化,提高推荐的准确性、实时性和用户满意度。

三、项目任务与分工

(一)数据采集与预处理组

- 任务内容

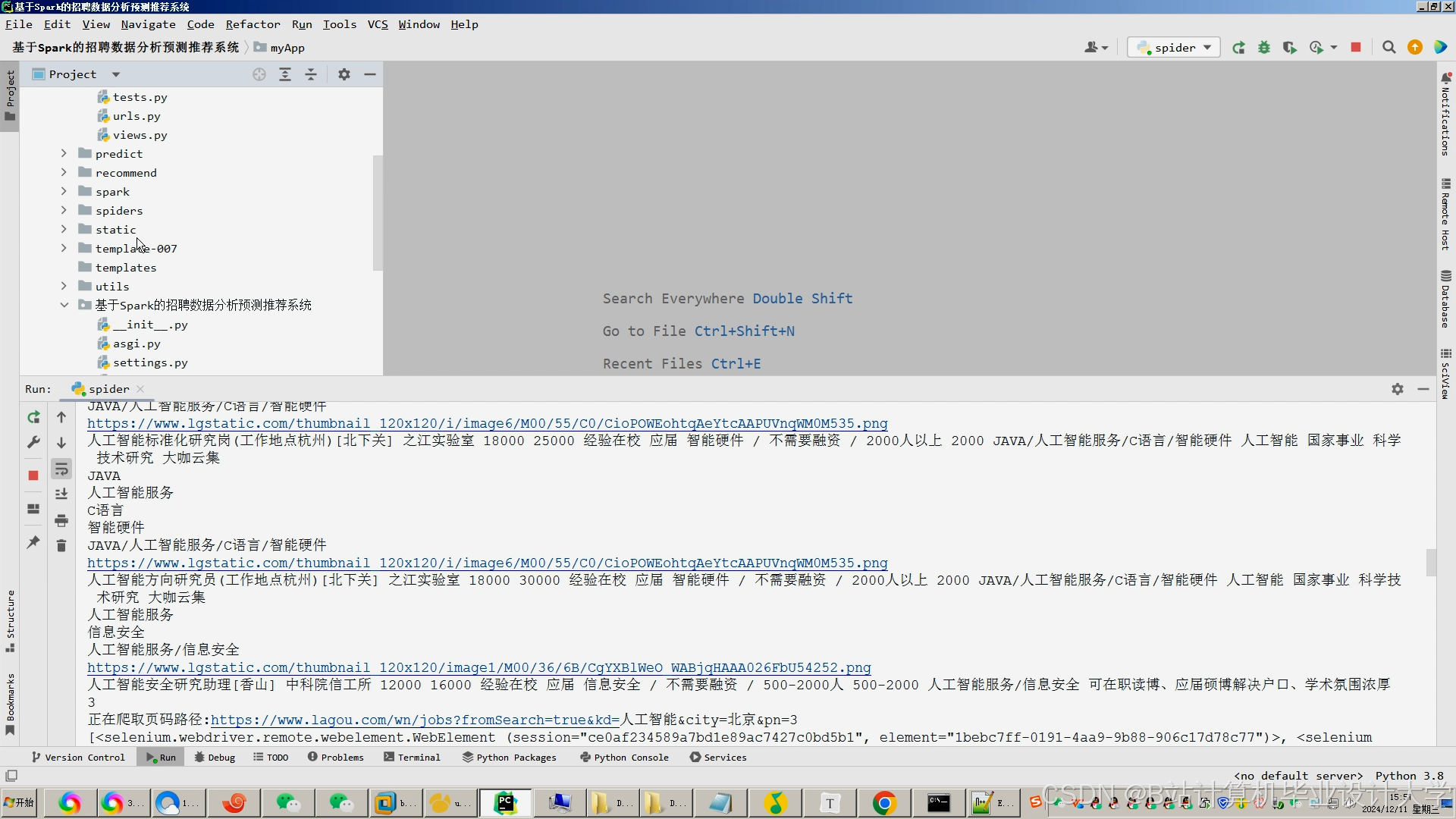

- 研究并选择合适的数据采集方法,从招聘网站、社交媒体、企业招聘系统等多源渠道采集求职者和招聘岗位的相关数据。

- 对采集到的数据进行清洗,去除噪声数据、重复数据和无效数据,进行数据格式转换和标准化处理。

- 构建数据采集和预处理的流程与规范,确保数据的准确性和一致性。

- 成员分工

- [成员 1 姓名]:负责招聘网站数据采集模块的开发与维护。

- [成员 2 姓名]:负责社交媒体数据采集及数据清洗工作。

- [成员 3 姓名]:制定数据采集和预处理的整体流程与规范,并协调各成员工作。

(二)数据仓库构建组

- 任务内容

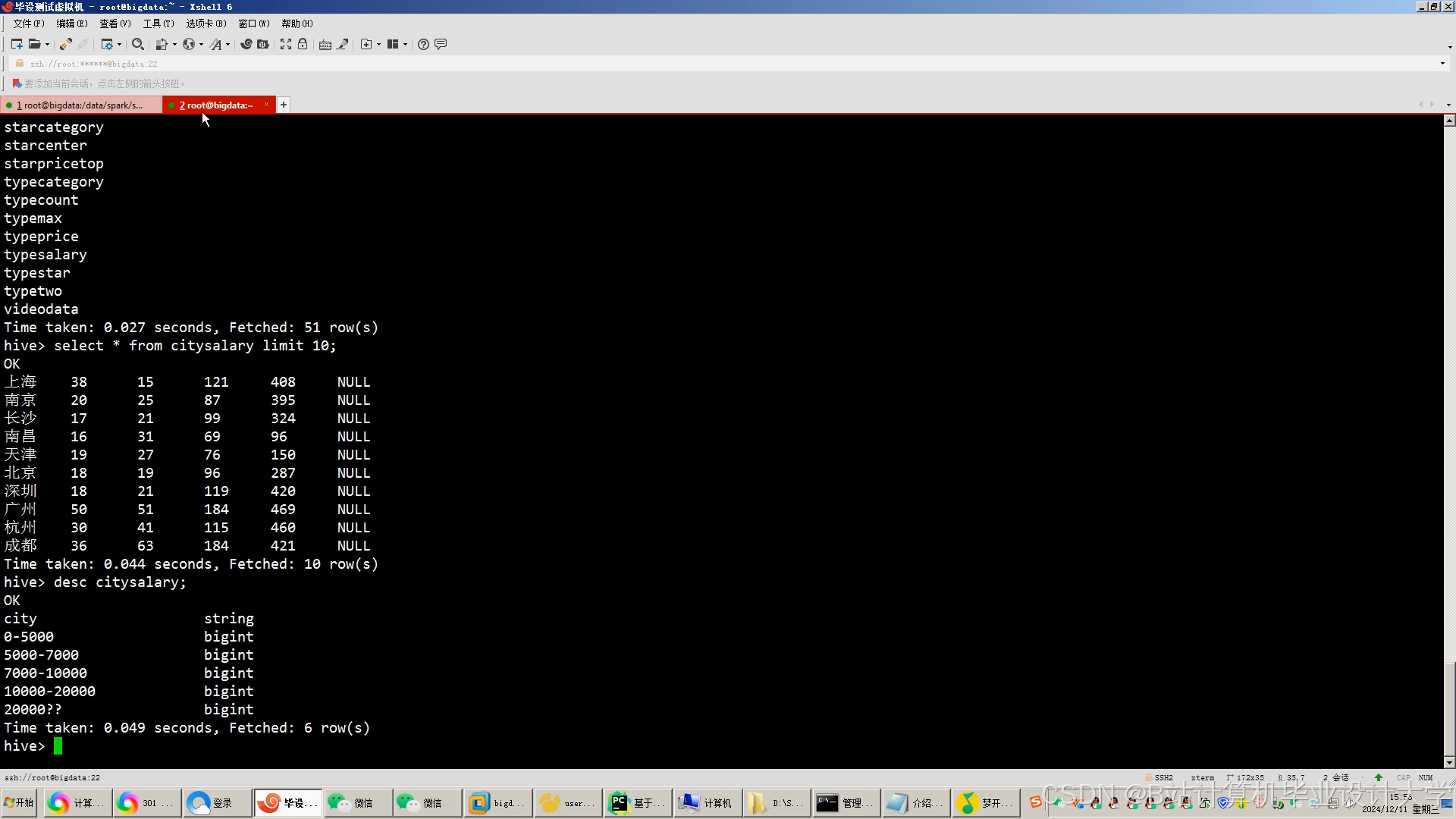

- 利用 Hive 设计并构建招聘数据仓库,定义合理的数据表结构,包括求职者信息表、招聘岗位信息表、用户行为表等。

- 将预处理后的数据导入到 Hadoop 分布式文件系统(HDFS)中,并建立索引以提高数据查询效率。

- 实现数据仓库的日常管理和维护,包括数据的备份、恢复和更新。

- 成员分工

- [成员 4 姓名]:负责 Hive 数据仓库的设计与表结构定义。

- [成员 5 姓名]:完成数据导入 HDFS 及索引建立工作。

- [成员 6 姓名]:负责数据仓库的管理和维护,制定数据备份与恢复策略。

(三)数据分析与特征提取组

- 任务内容

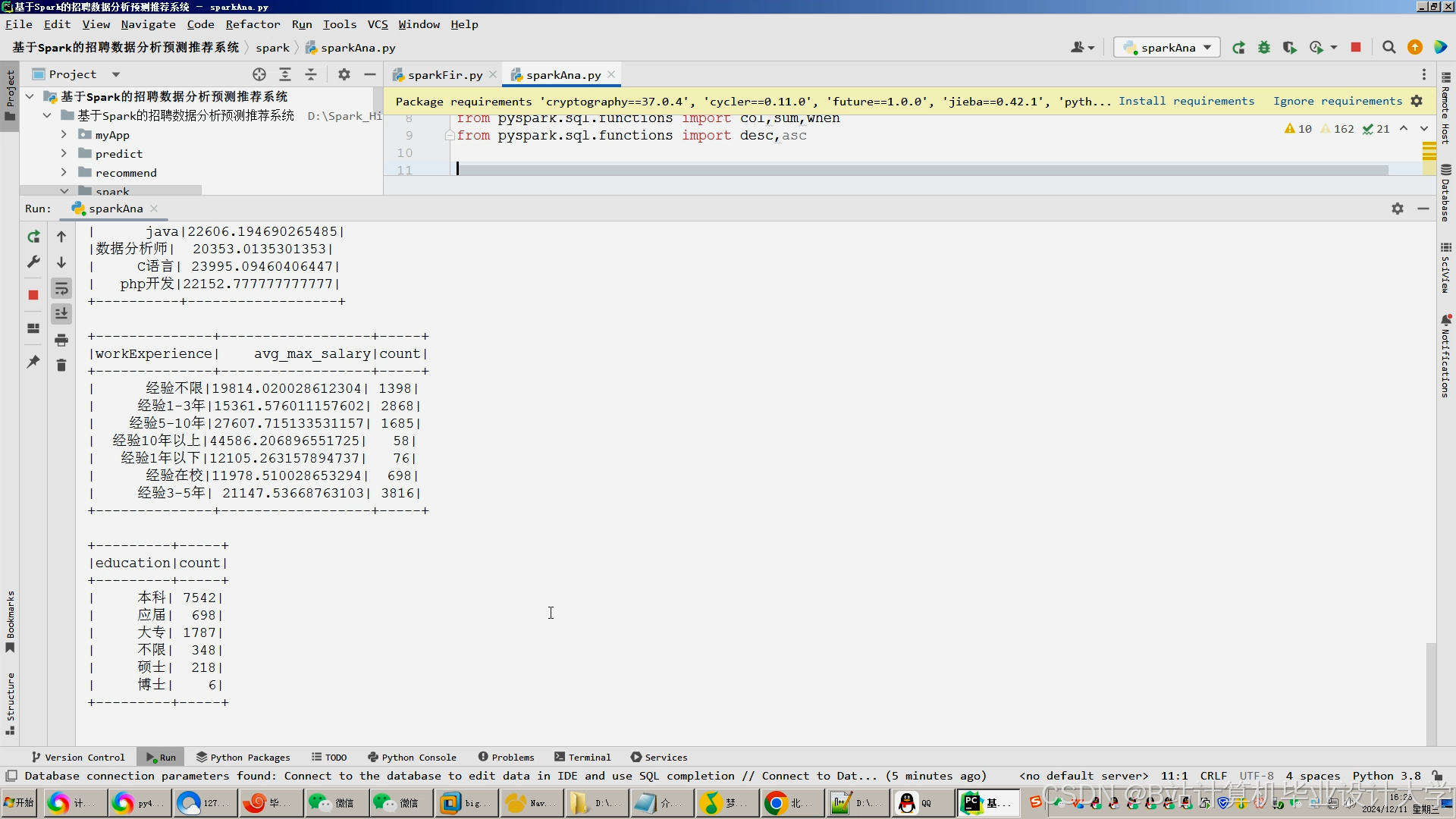

- 使用 Spark 对数据仓库中的数据进行深入分析,包括统计分析、关联规则挖掘、聚类分析等,挖掘求职者和招聘岗位的特征。

- 提取的特征包括求职者的技能、工作经验、教育背景、求职意向等,以及招聘岗位的职责、要求、薪资待遇、行业类别等。

- 对提取的特征进行评估和优化,确保特征的有效性和代表性。

- 成员分工

- [成员 7 姓名]:运用 Spark 进行数据统计分析,挖掘基础特征。

- [成员 8 姓名]:负责关联规则挖掘和聚类分析,提取更深层次的特征。

- [成员 9 姓名]:对提取的特征进行评估和优化,与算法设计组沟通特征使用。

(四)推荐算法设计与实现组

- 任务内容

- 研究并比较不同的推荐算法,如协同过滤算法、基于内容的推荐算法、混合推荐算法等,结合招聘推荐场景选择合适的算法。

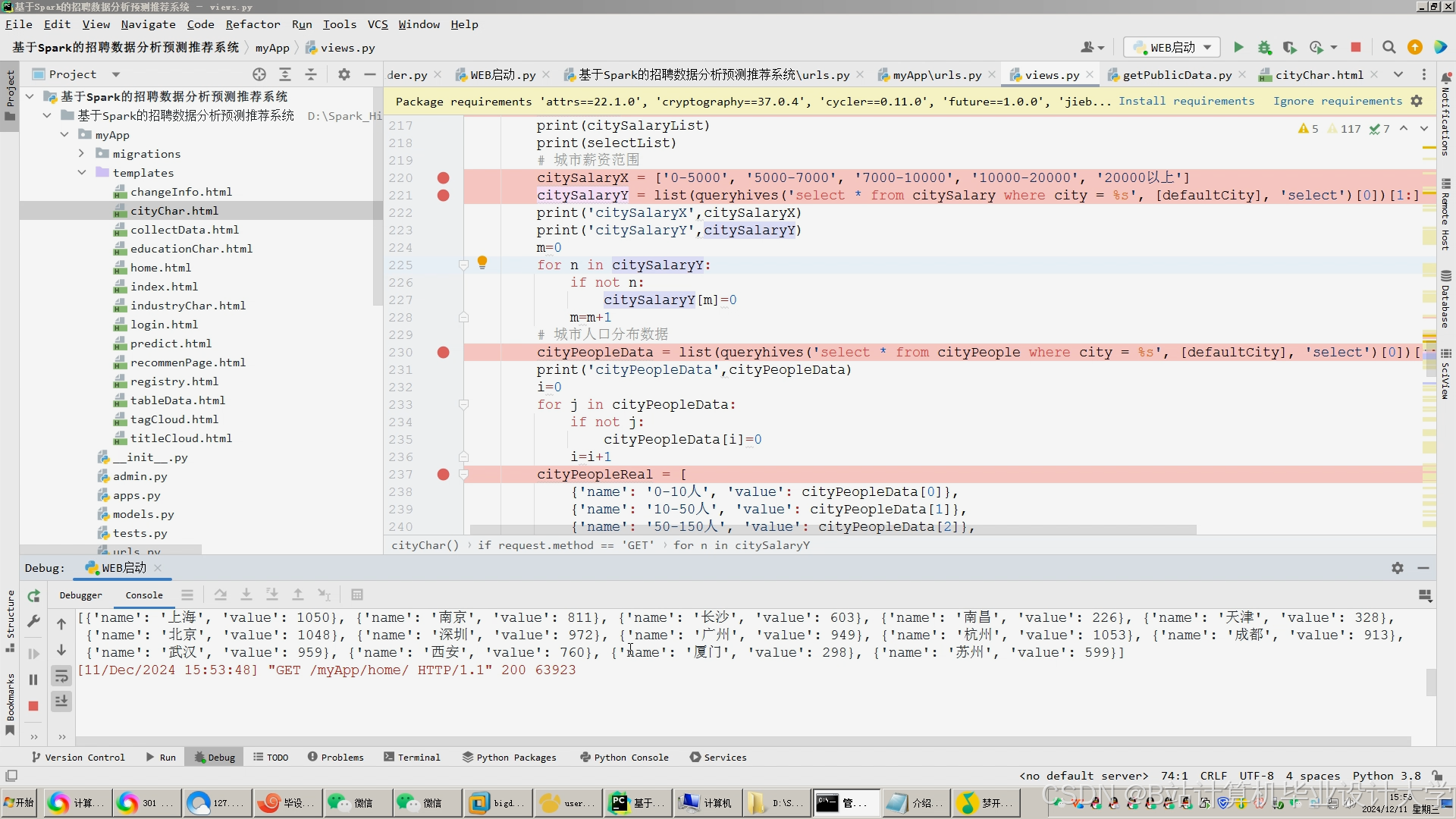

- 基于 Spark 实现所选的推荐算法,根据求职者和招聘岗位的特征进行相似度计算和匹配,生成推荐结果。

- 对推荐算法进行训练和调优,提高推荐的准确性和个性化程度。

- 成员分工

- [成员 10 姓名]:研究推荐算法理论,选择适合招聘推荐的算法。

- [成员 11 姓名]:使用 Spark MLlib 等机器学习库实现推荐算法。

- [成员 12 姓名]:负责算法的训练、调优和性能评估。

(五)系统开发与测试组

- 任务内容

- 开发招聘推荐系统的前端界面,采用合适的 Web 开发技术,如 HTML、CSS、JavaScript 等,实现用户注册、登录、信息展示、推荐结果查看等功能。

- 开发系统的后端服务,使用 Java、Python 等编程语言,实现数据处理、推荐算法调用、用户管理等业务逻辑。

- 对系统进行全面的测试,包括功能测试、性能测试、安全测试等,发现并修复系统中的漏洞和问题。

- 成员分工

- [成员 13 姓名]:负责前端界面的设计与开发。

- [成员 14 姓名]:开发后端服务,实现业务逻辑。

- [成员 15 姓名]:制定测试计划,进行系统测试并记录测试结果。

(六)项目评估与优化组

- 任务内容

- 设计评估指标,如准确率、召回率、F1 值、用户满意度等,对招聘推荐系统的性能进行评估。

- 根据评估结果,分析系统存在的问题和不足,提出优化方案。

- 对系统进行优化和改进,包括算法优化、系统架构调整、用户体验提升等。

- 成员分工

- [成员 16 姓名]:设计评估指标体系,对系统进行性能评估。

- [成员 17 姓名]:分析评估结果,提出优化建议。

- [成员 18 姓名]:负责系统的优化和改进工作,跟踪优化效果。

四、项目进度安排

(一)第一阶段(第 1 - 2 个月):项目启动与需求分析

- 成立项目团队,明确各成员职责。

- 开展市场调研,了解招聘行业现状和用户需求。

- 撰写项目需求规格说明书,确定系统的功能和性能要求。

(二)第二阶段(第 3 - 4 个月):数据采集与预处理

- 完成数据采集工具的开发和测试。

- 从多源渠道采集招聘相关数据。

- 对采集到的数据进行清洗和预处理,构建初始数据集。

(三)第三阶段(第 5 - 6 个月):数据仓库构建

- 设计 Hive 数据仓库的表结构和数据模型。

- 将预处理后的数据导入到 HDFS 中,建立索引。

- 完成数据仓库的初步搭建和测试。

(四)第四阶段(第 7 - 8 个月):数据分析与特征提取

- 使用 Spark 对数据仓库中的数据进行深入分析。

- 提取求职者和招聘岗位的特征,并进行评估和优化。

- 形成特征数据集,为推荐算法提供输入。

(五)第五阶段(第 9 - 10 个月):推荐算法设计与实现

- 研究并选择合适的推荐算法。

- 基于 Spark 实现推荐算法,进行初步训练和测试。

- 对推荐算法进行调优,提高推荐效果。

(六)第六阶段(第 11 - 12 个月):系统开发与测试

- 开发招聘推荐系统的前端界面和后端服务。

- 进行系统的集成测试和功能测试,修复发现的问题。

- 开展性能测试和安全测试,确保系统的稳定性和安全性。

(七)第七阶段(第 13 - 14 个月):项目评估与优化

- 设计评估指标,对招聘推荐系统进行全面评估。

- 根据评估结果,分析系统存在的问题,提出优化方案。

- 对系统进行优化和改进,提高系统的性能和用户体验。

(八)第八阶段(第 15 - 16 个月):项目验收与总结

- 整理项目文档,包括需求规格说明书、设计文档、测试报告等。

- 组织项目验收,向相关部门和人员展示项目成果。

- 对项目进行总结和反思,提炼经验教训,为后续项目提供参考。

五、项目资源需求

(一)硬件资源

- 服务器:至少[X]台,用于搭建 Hadoop 集群、Spark 集群和存储数据。

- 开发工作站:为项目成员提供开发环境,每人一台。

(二)软件资源

- 操作系统:Linux 发行版(如 CentOS、Ubuntu)。

- 大数据框架:Hadoop、Spark、Hive。

- 开发工具:IntelliJ IDEA、Eclipse、PyCharm 等。

- 数据库管理系统:MySQL(用于存储系统元数据和配置信息)。

- Web 服务器:Tomcat、Nginx 等。

(三)人力资源

项目团队成员需具备大数据技术、软件开发、数据挖掘等相关领域的知识和技能。在项目实施过程中,可根据实际需要邀请相关专家进行指导和培训。

六、项目风险管理

(一)技术风险

- 风险描述:Hadoop、Spark 和 Hive 等大数据技术较为复杂,可能存在技术难题无法及时解决,影响项目进度。

- 应对措施:加强团队成员的技术培训,提前学习相关技术文档和案例;建立技术交流群,及时解决遇到的问题;必要时邀请专家进行指导。

(二)数据风险

- 风险描述:数据采集过程中可能遇到数据源不稳定、数据质量差等问题,导致数据不完整或不准确。

- 应对措施:与多个数据源建立合作关系,确保数据的稳定供应;在数据采集和预处理阶段加强数据质量检查,对异常数据进行处理。

(三)进度风险

- 风险描述:项目实施过程中可能出现任务延期、资源不足等情况,导致项目无法按时完成。

- 应对措施:制定详细的项目进度计划,明确各阶段的任务和时间节点;定期召开项目进度会议,及时解决项目中出现的问题;合理安排资源,确保项目顺利进行。

(四)需求变更风险

- 风险描述:在项目开发过程中,用户需求可能发生变更,导致项目范围扩大或技术方案调整。

- 应对措施:加强与用户的沟通和交流,及时了解用户需求的变化;对需求变更进行评估和分析,确定变更的影响范围和成本;在项目合同中明确需求变更的处理流程和责任。

七、项目成果交付

(一)软件系统

交付基于 Hadoop+Spark+Hive 的招聘推荐系统,包括前端界面、后端服务和相关文档。

(二)技术文档

- 项目需求规格说明书

- 系统设计文档(包括数据仓库设计、算法设计、系统架构设计等)

- 用户使用手册

- 测试报告

- 项目总结报告

(三)研究成果

发表与本项目相关的学术论文[X]篇,申请软件著作权[X]项。

项目负责人(签字):__________________

日期:______年____月____日

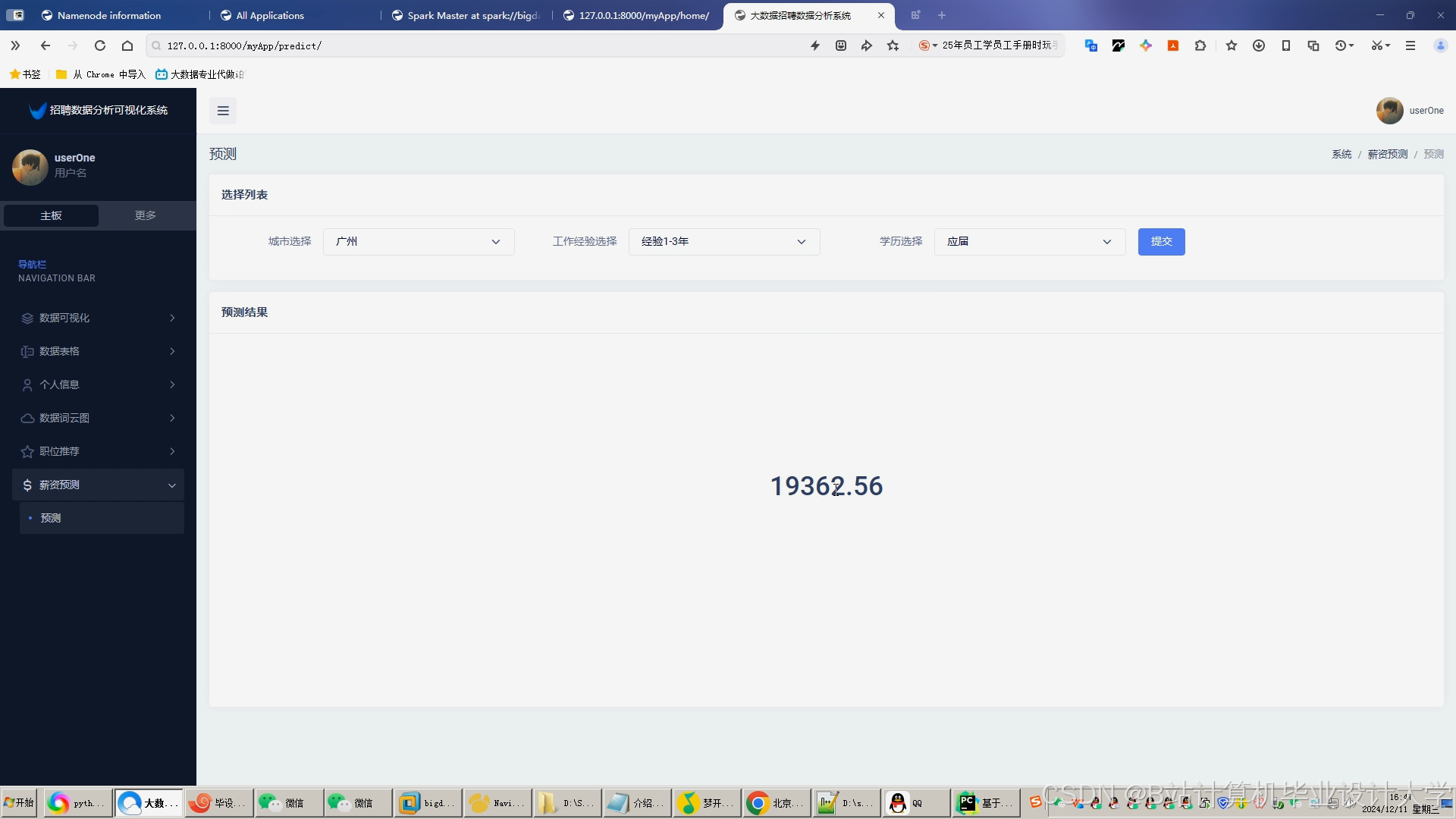

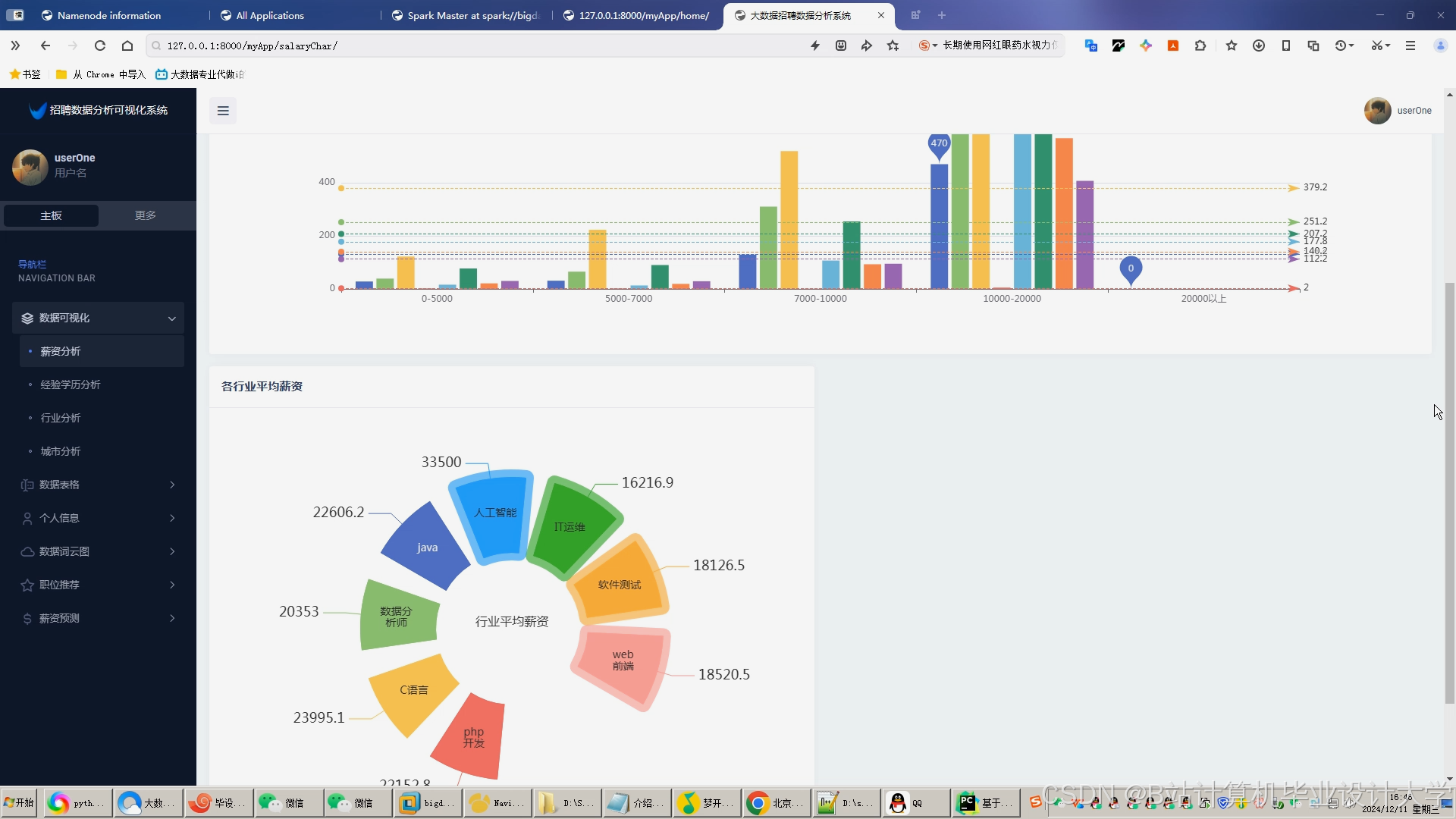

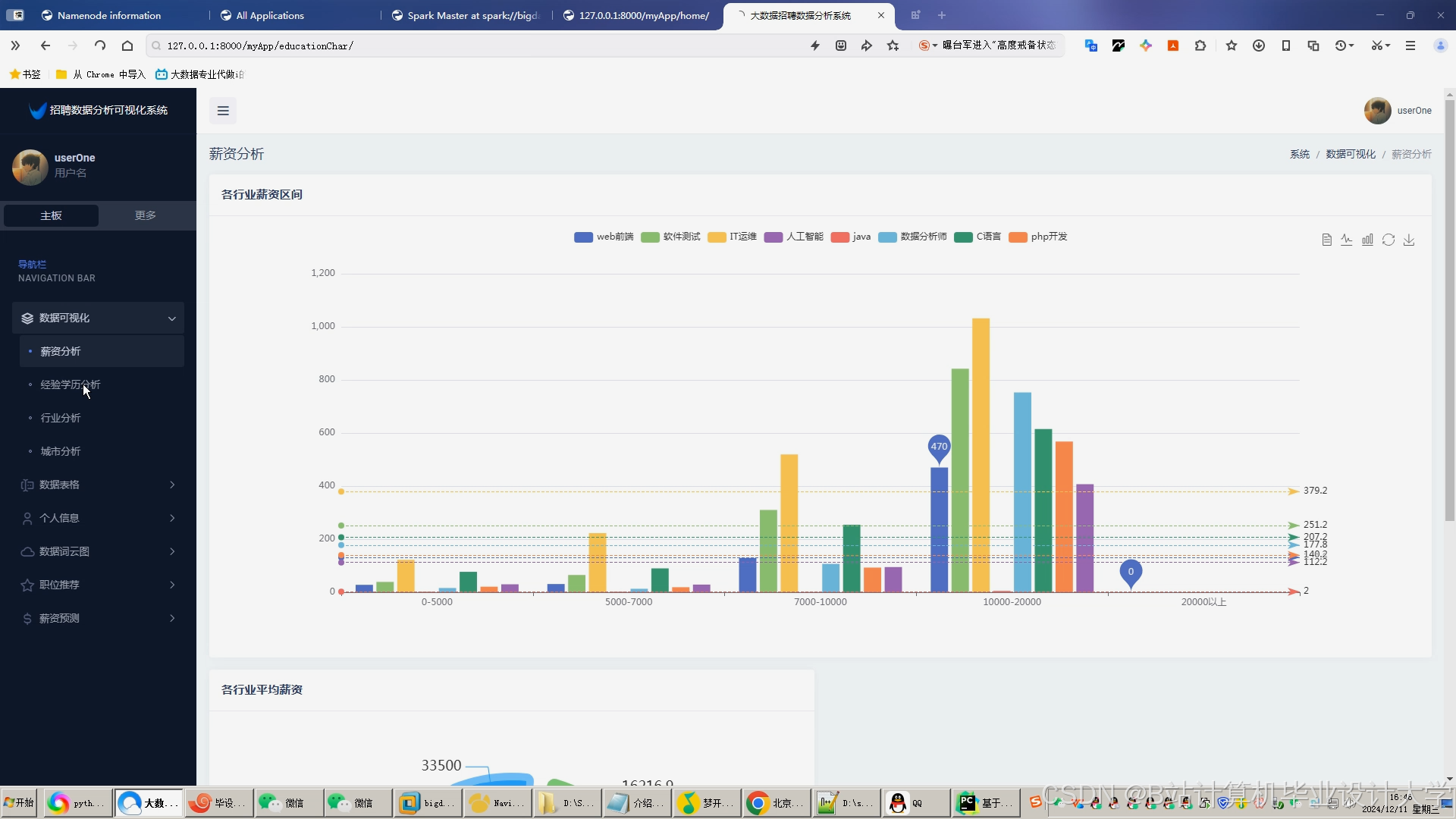

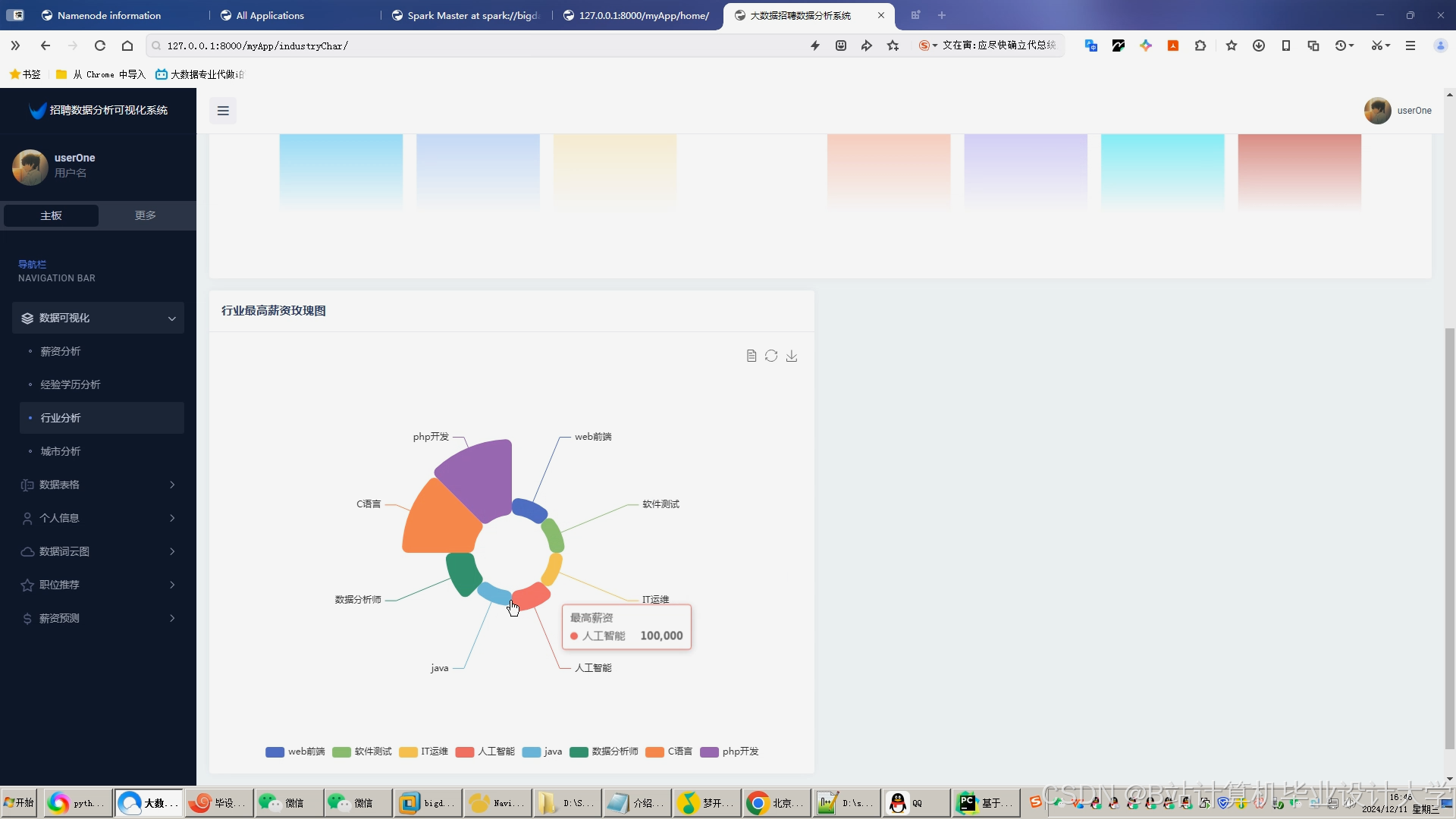

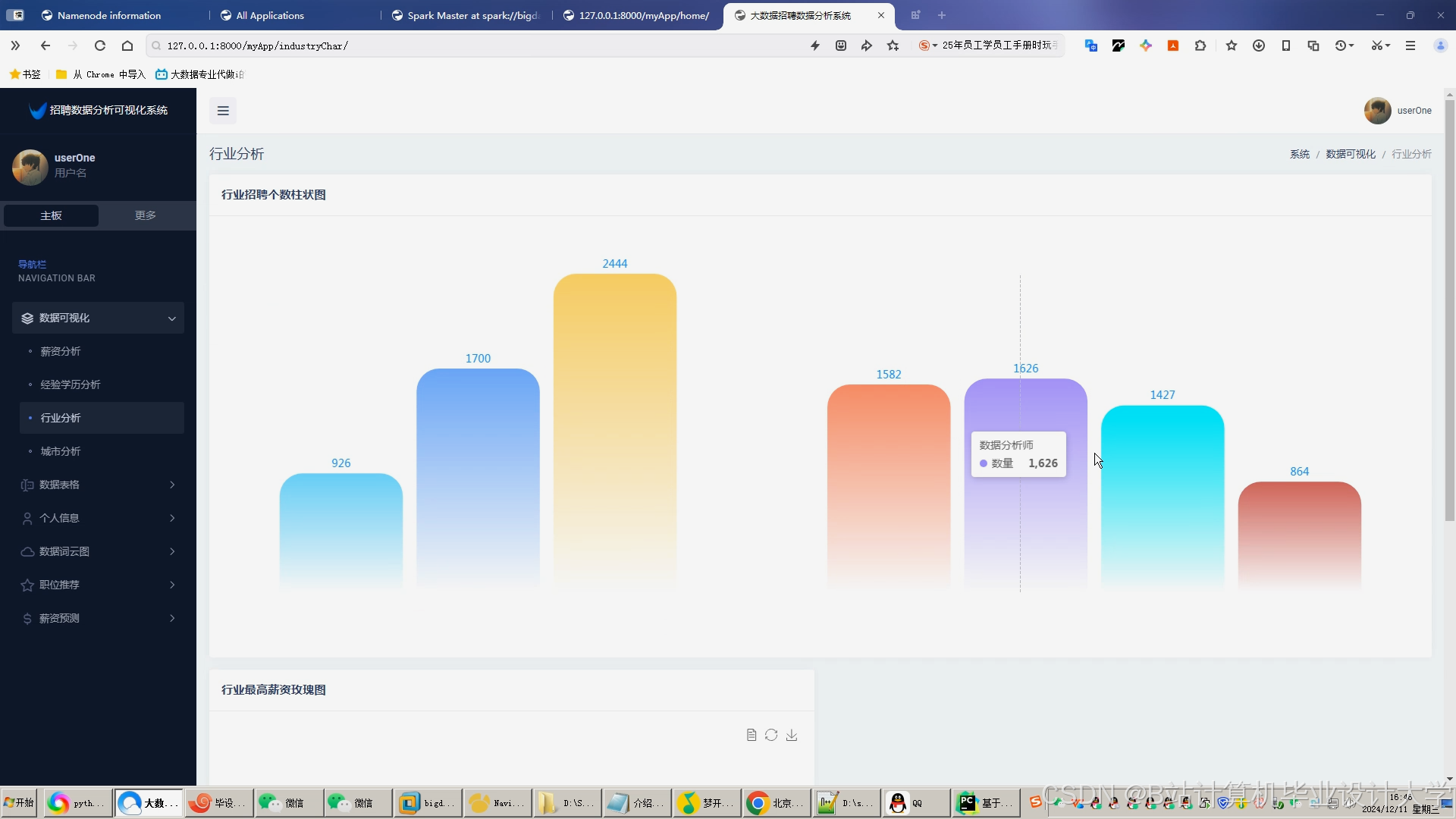

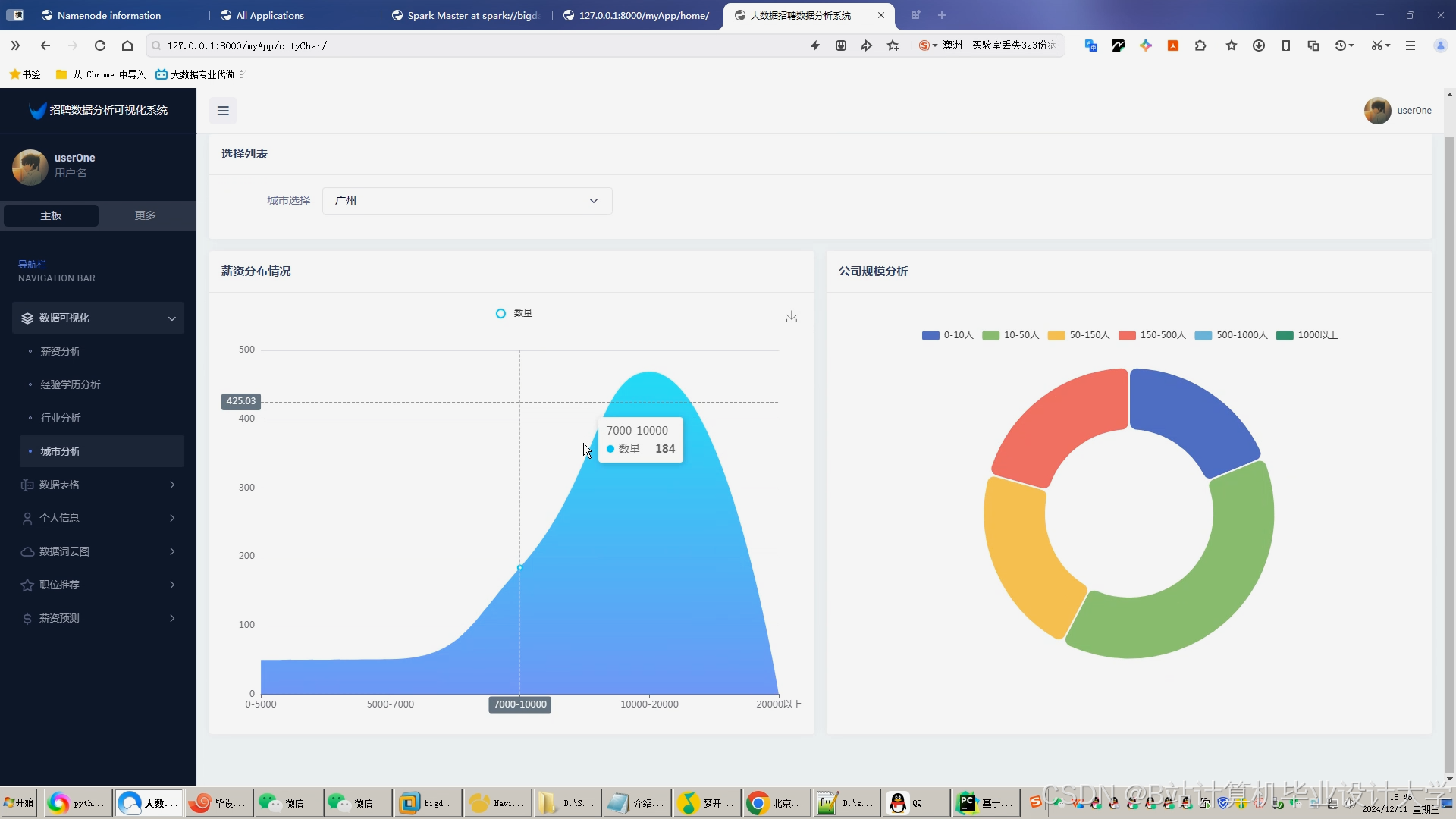

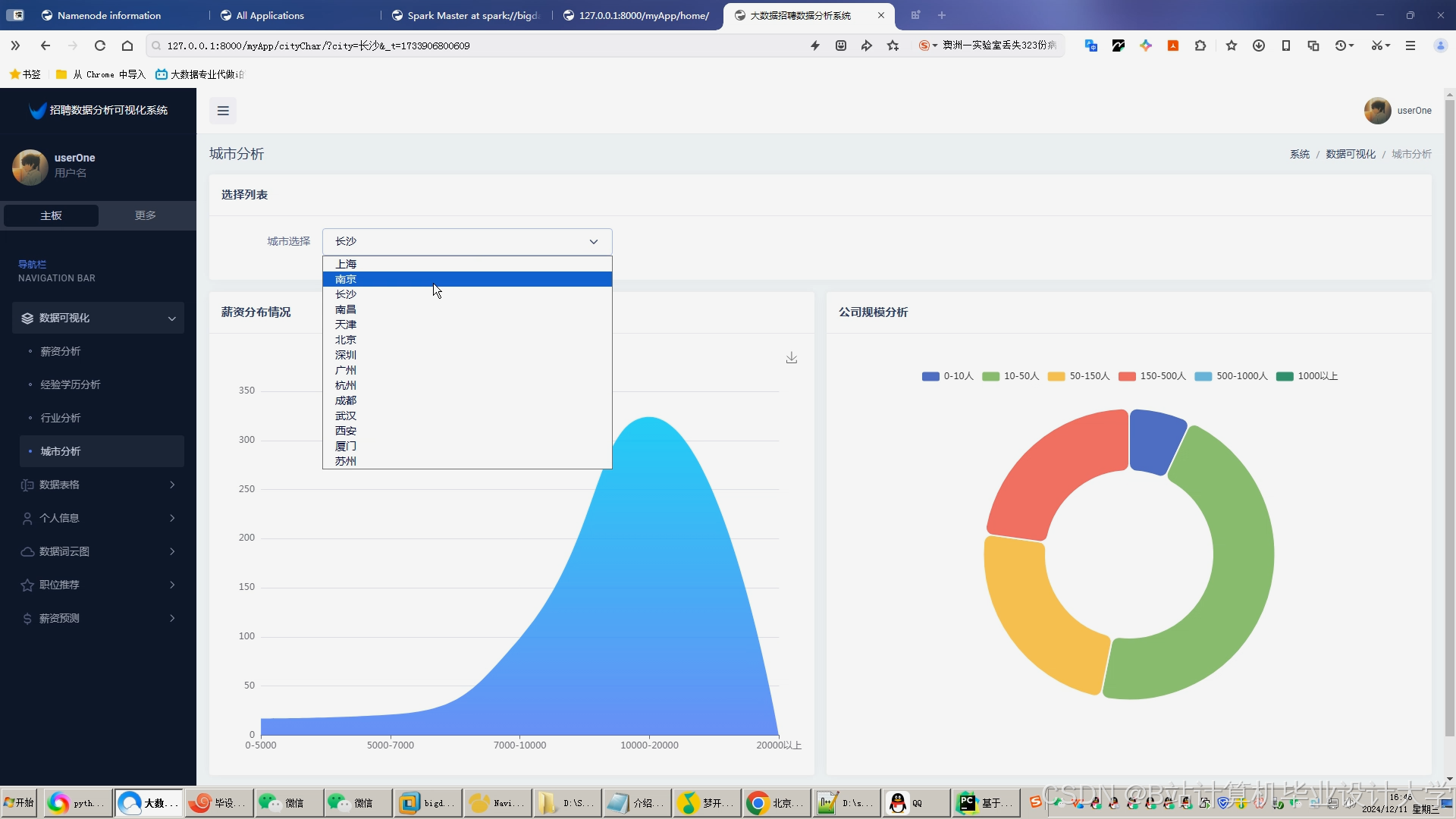

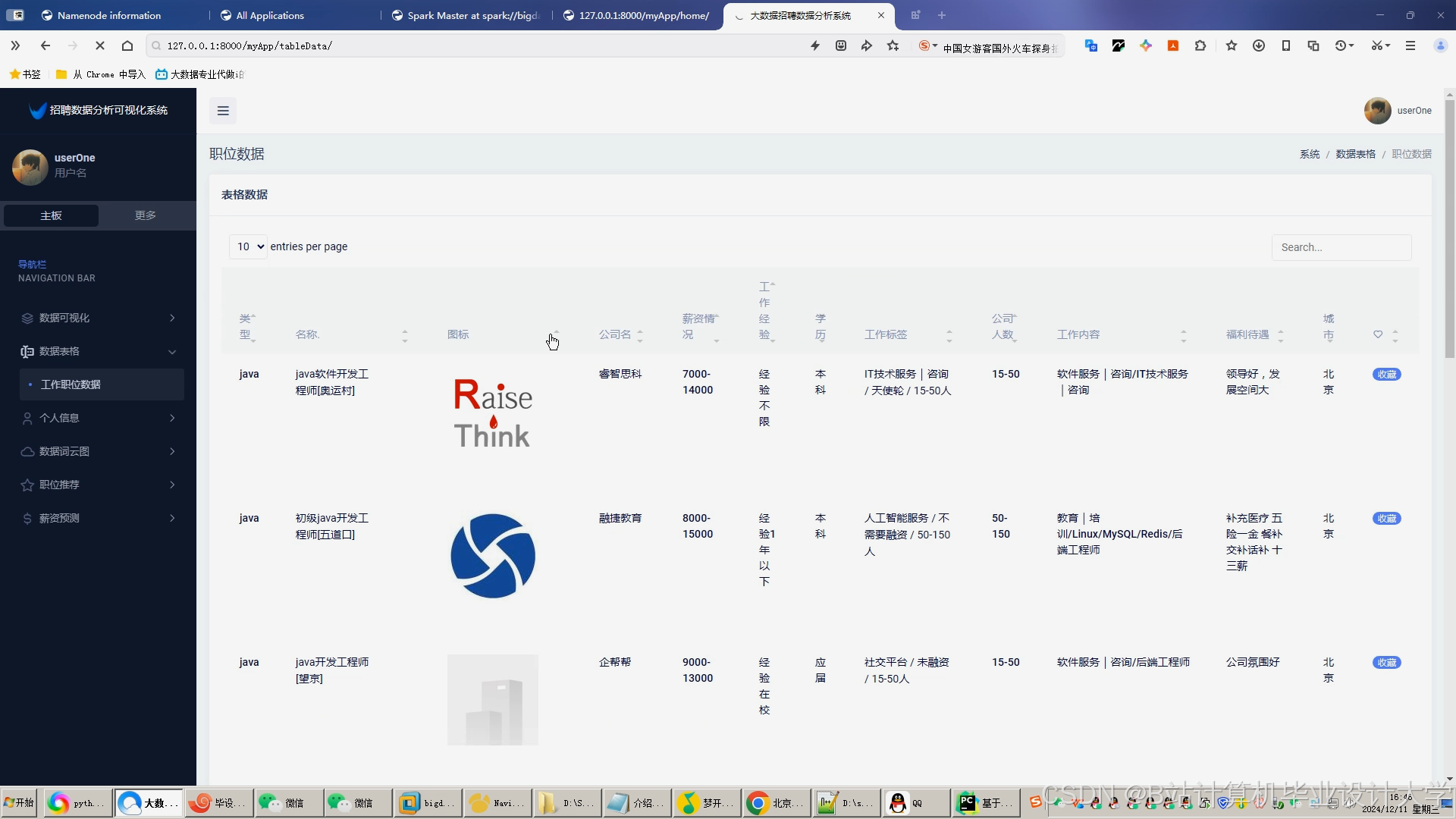

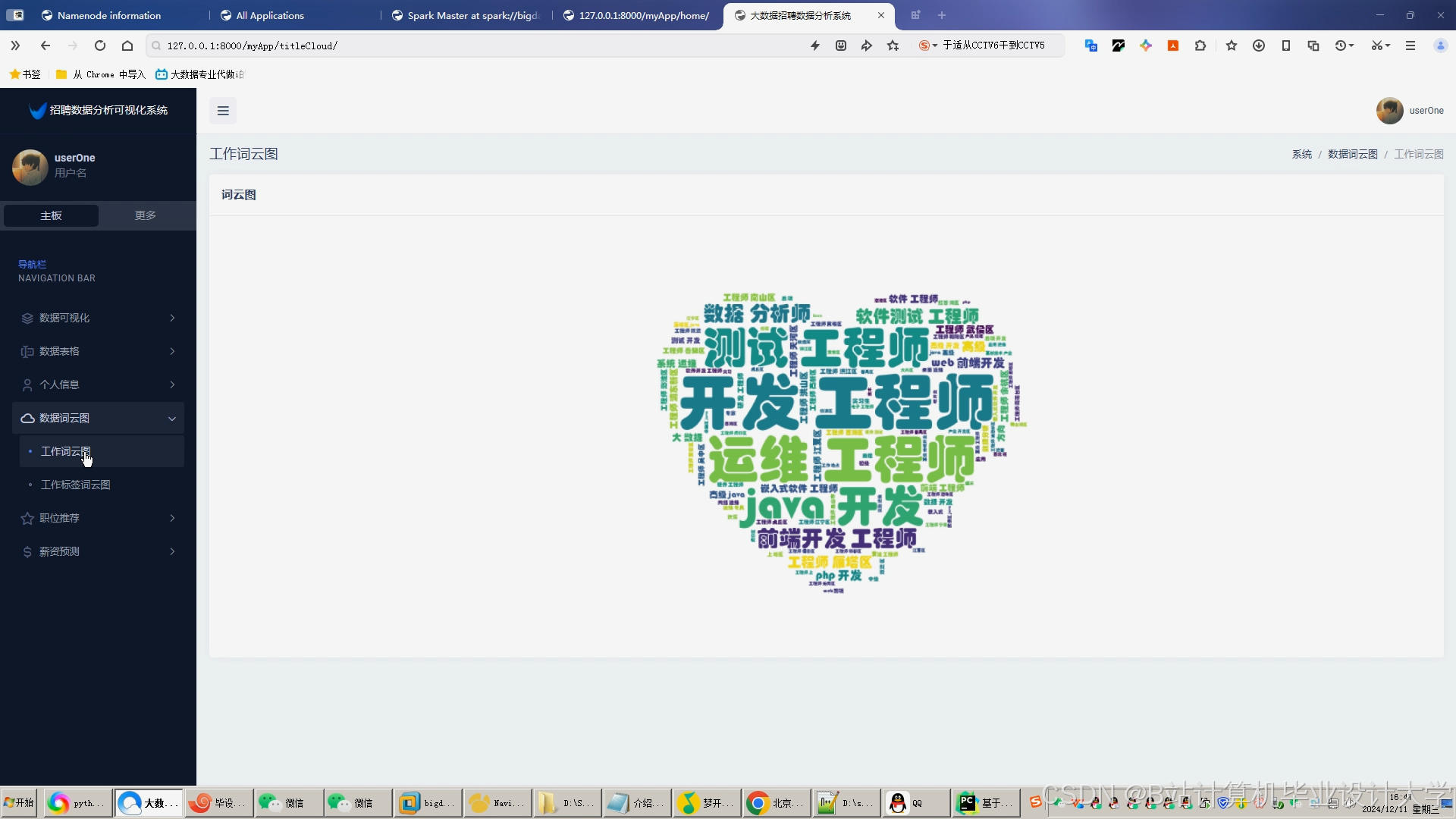

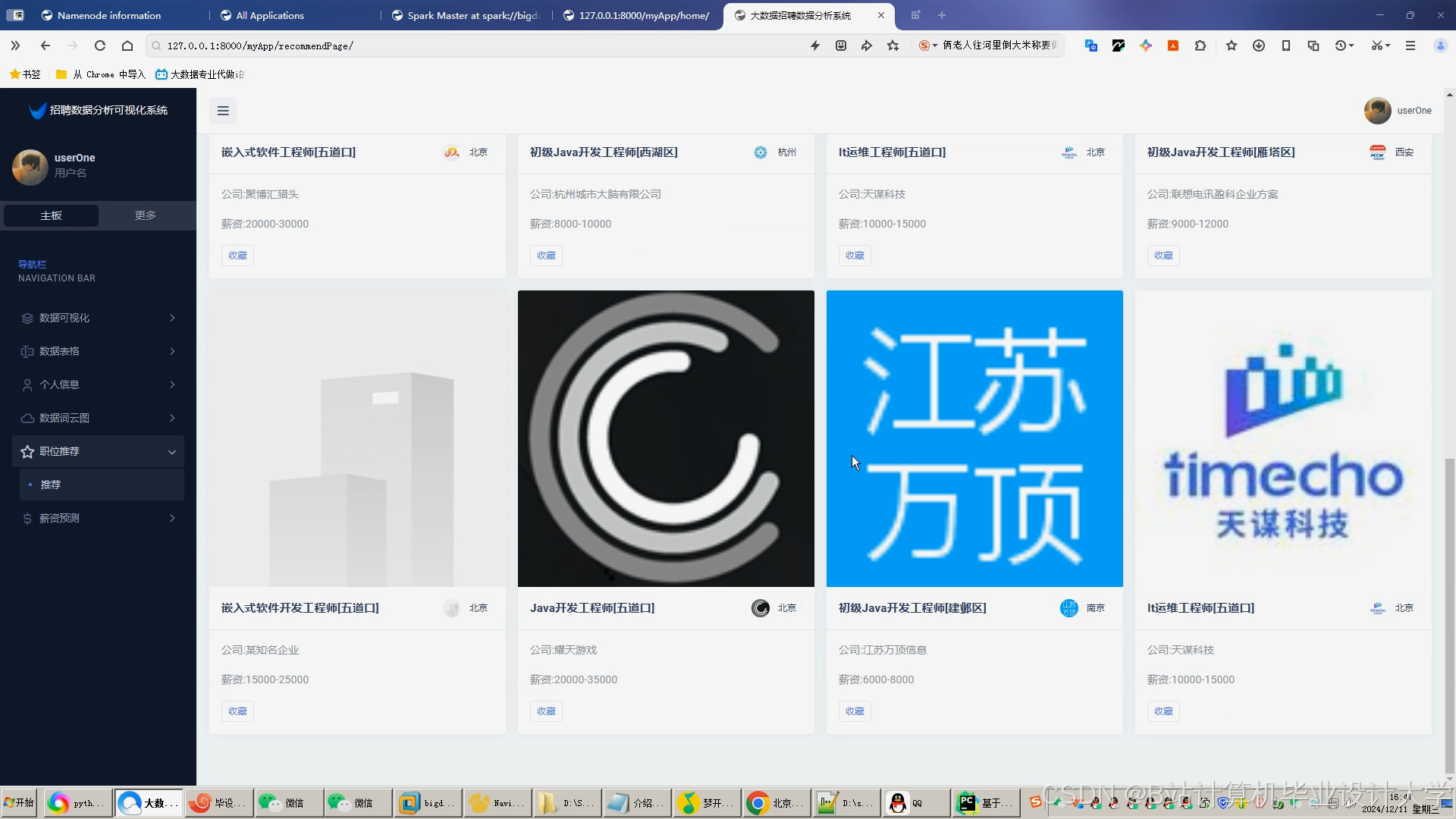

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

413

413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?