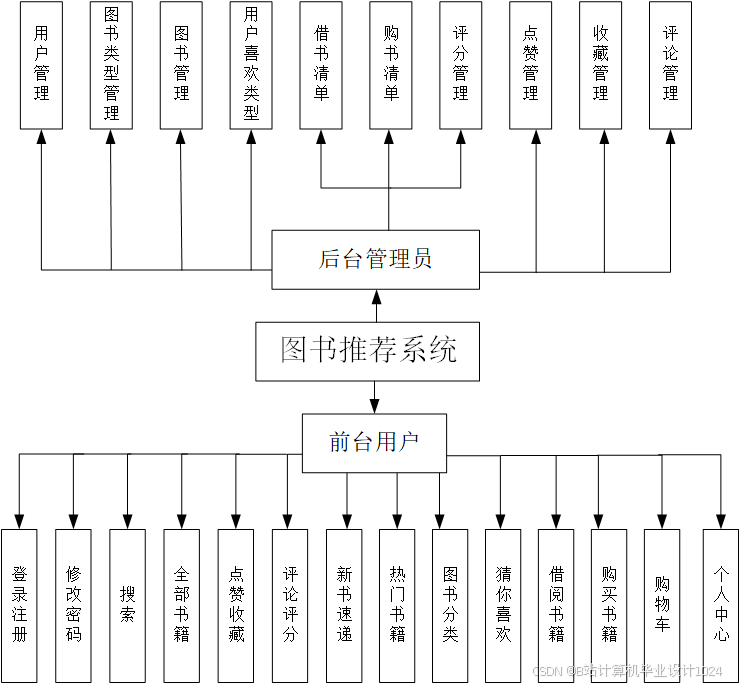

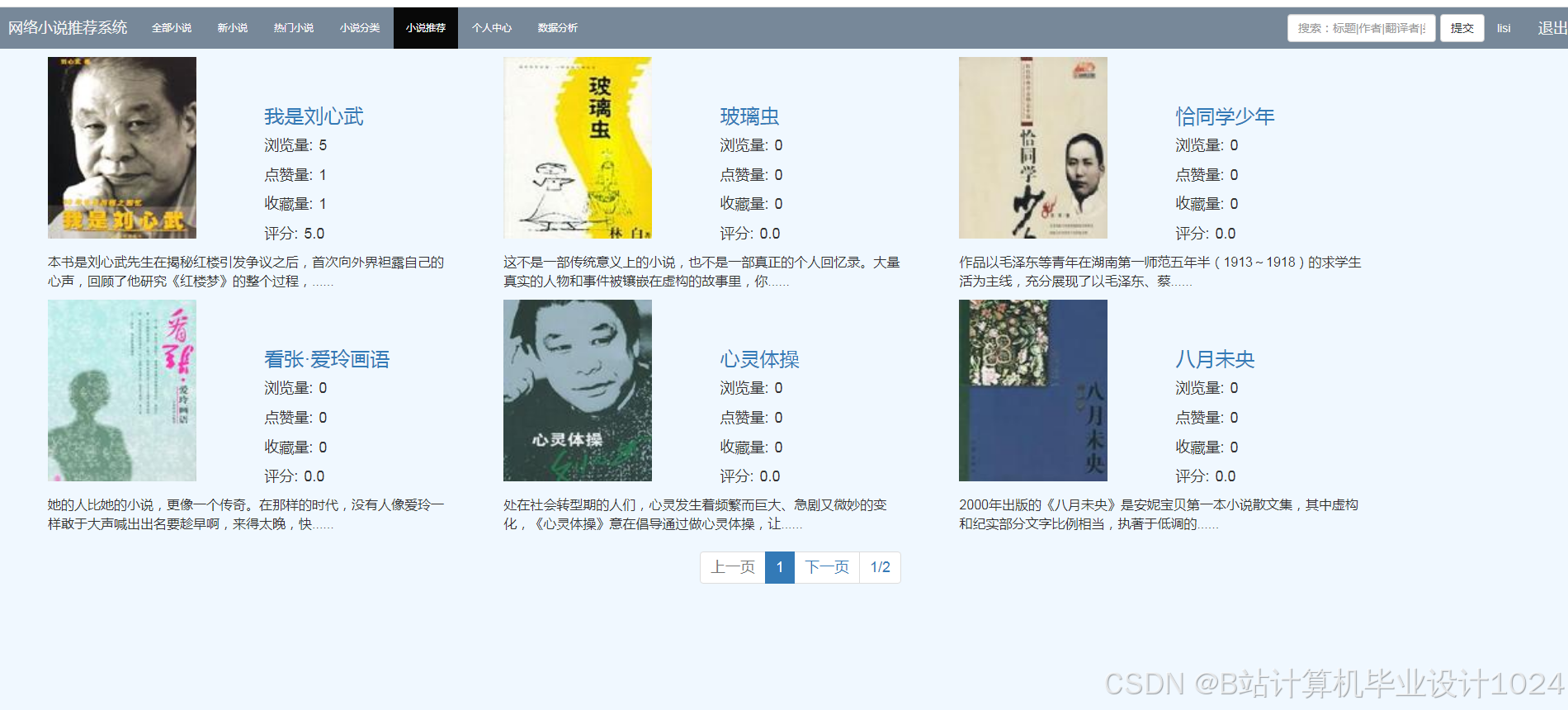

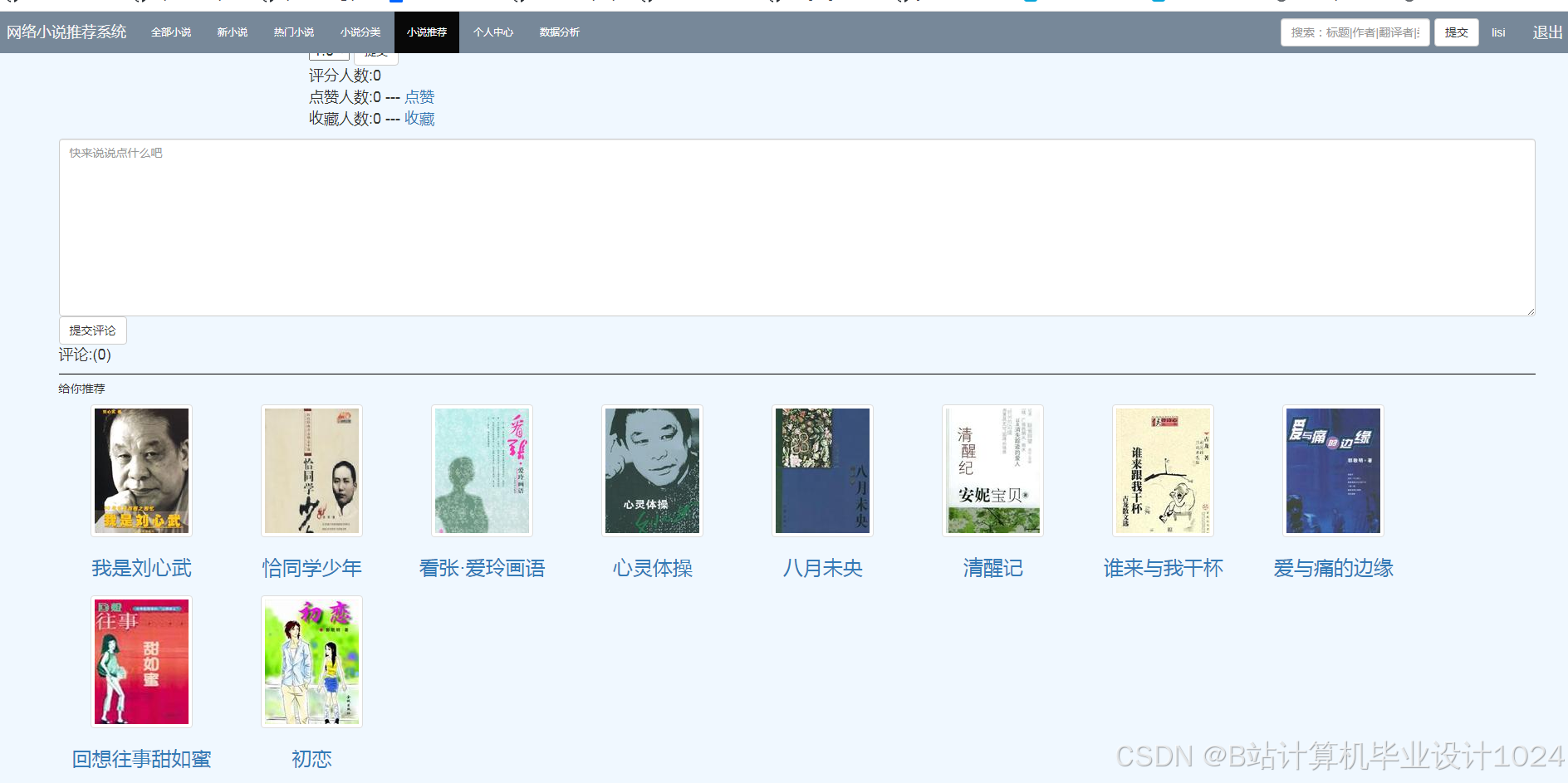

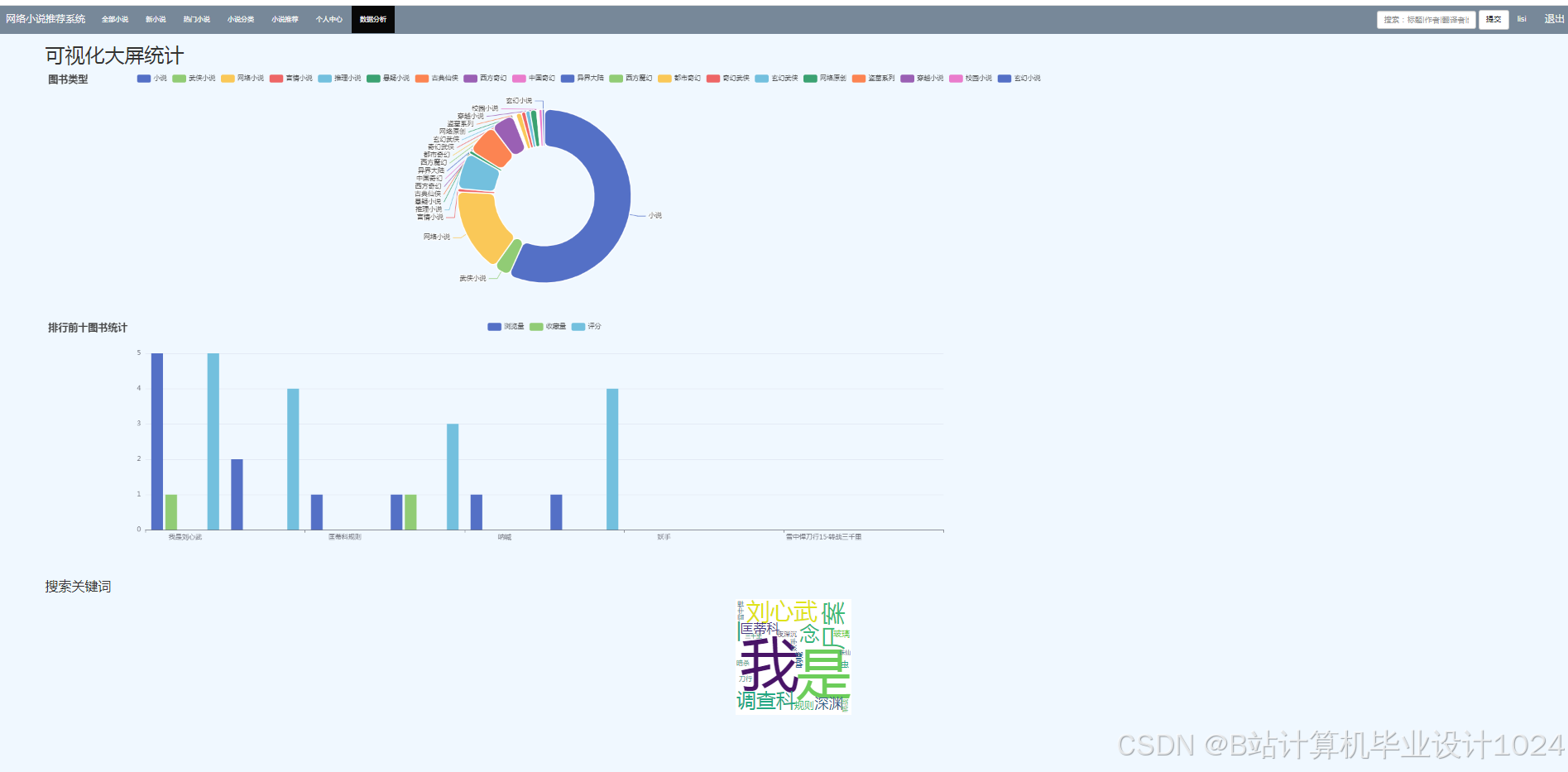

本系统基于推荐算法给用户实现精准推荐图书。

根据用户对物品或者信息的偏好,发现物品或者内容本身的相关性,或者是发现用户的相关性,然后再基于这些关联性进行推荐,种被称为基于协同过滤的推荐。

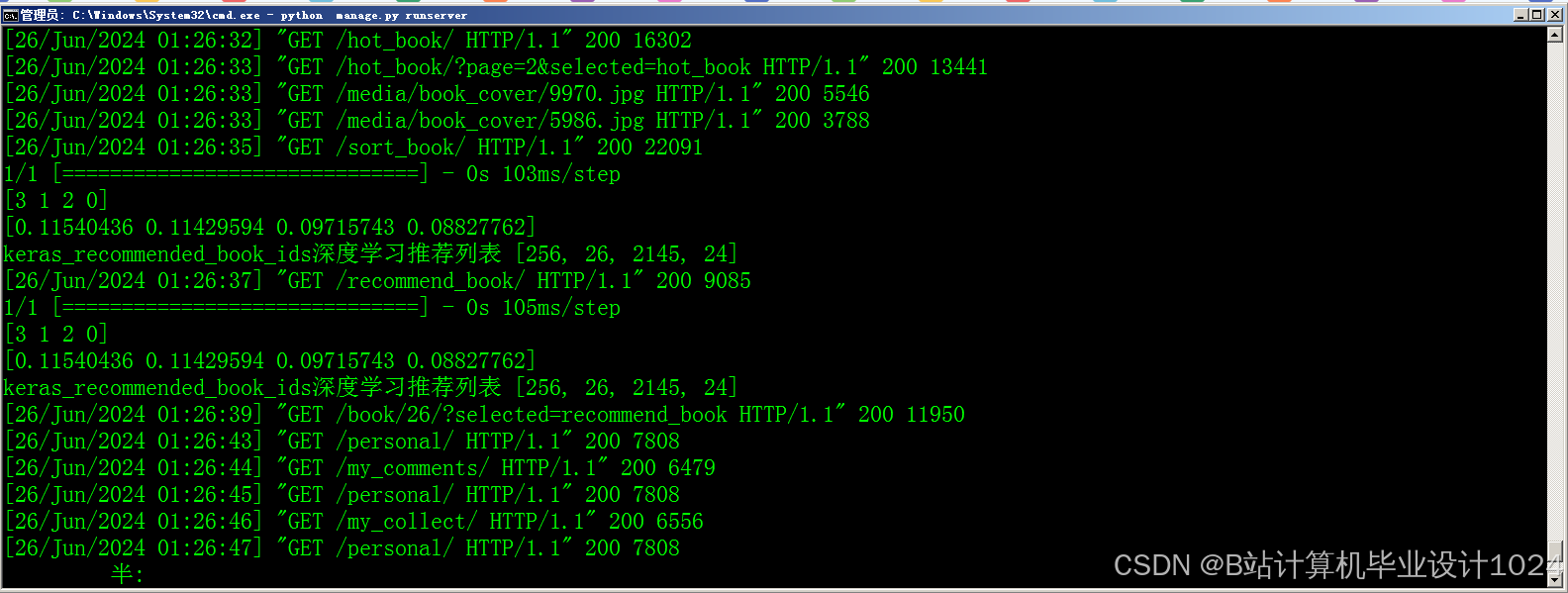

本系统使用了三种推荐算法:基于用户的协同过滤算法、基于物品的协同过滤算法、基于机器学习k-means聚类的过滤算法,以及三种算法的混合推荐算法。

二、使用到的技术

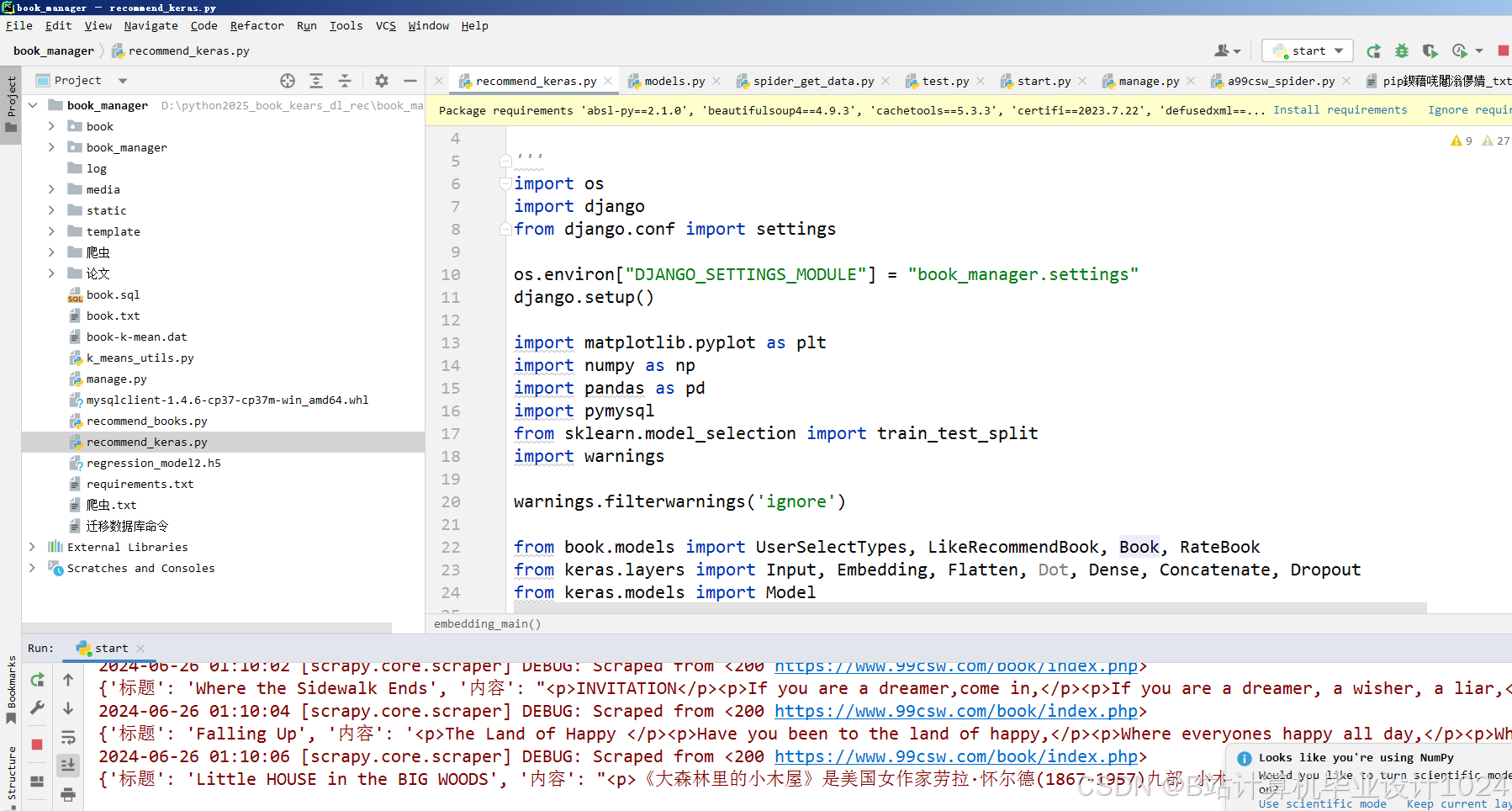

开发语言是python3.7,框架是Django3.0,采用的是djanog前后端相结合的技术,后台管理系统是xadmin,数据库是Mysql5.7。

1、Django的MTV架构

所谓MTV就是:数据模型(M)-前端界面(T)-调度控制器(V).

用户在浏览器发起一个请求:通过V对M和T进行连接,用户通过T(界面)对服务器进行访问(发送请求),T把请求传给V(调度),V调用M(数据模型)获取数据,把数据给模板T进行渲染,然后再把渲染后的模板返回给用户。

MTV框架是一种 把业务逻辑、数据、界面显示分离而设计创建的Web应用程序的开发模式。在web开发中应该尽量使代码高内聚低耦合,这样利于代码复用、维护、管理,MTV框架就是这样分层的。

M对应于Model,即数据模型(数据层),用于管理数据库,对数据进行增删改查;

T对应于视图,template(即T),模板,用于管理html文件,呈现给用户的界面;

V对应于控制层,views(即V),视图调度器,用于访问数据层,获取数据,把数据调度给模板进行渲染,把渲染的结果返回给客户端。

MTV框架的大体流程是:

1、客户端发起请求,路由对客户发起的请求进行统一处理和分发给控制层;

2、控制层获取请求,访问数据层;

3、数据层对数据进行增删改查,把数据返回给控制层;

4、控制层获取数据,把数据调度给视图(模板);

5、视图(模板)对数据进行渲染,形成html文件返回给控制层;

6、控制层把渲染后的视图(模板)返回给客户端。

三、开发流程

1、环境搭建:创建虚拟环境、创建数据库

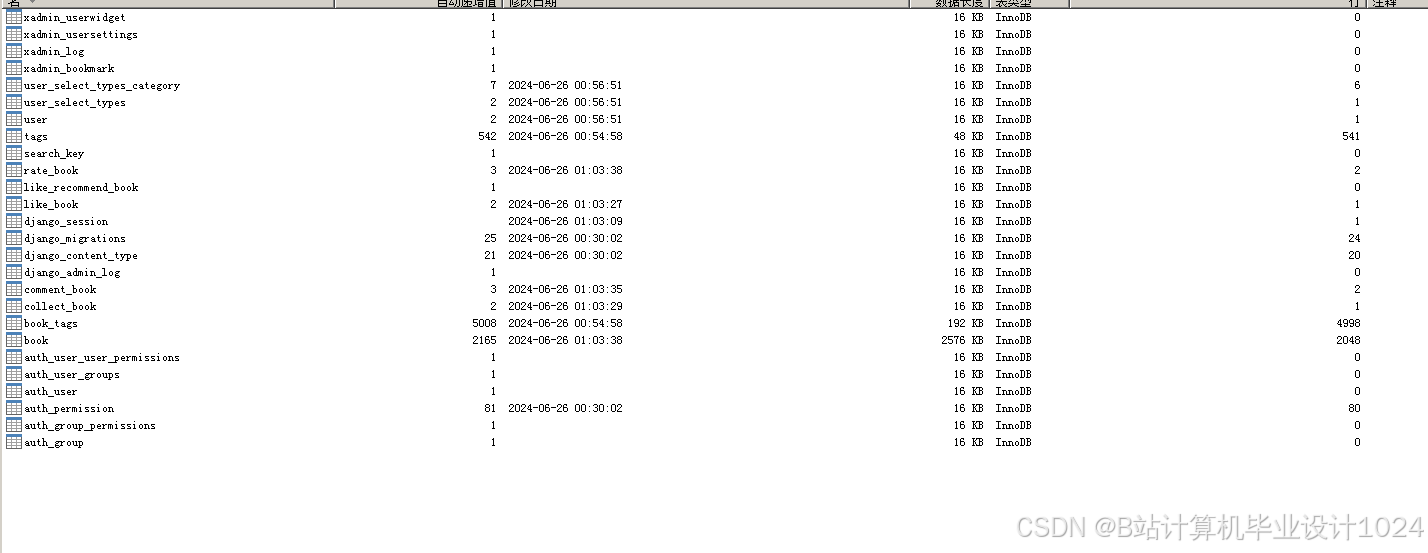

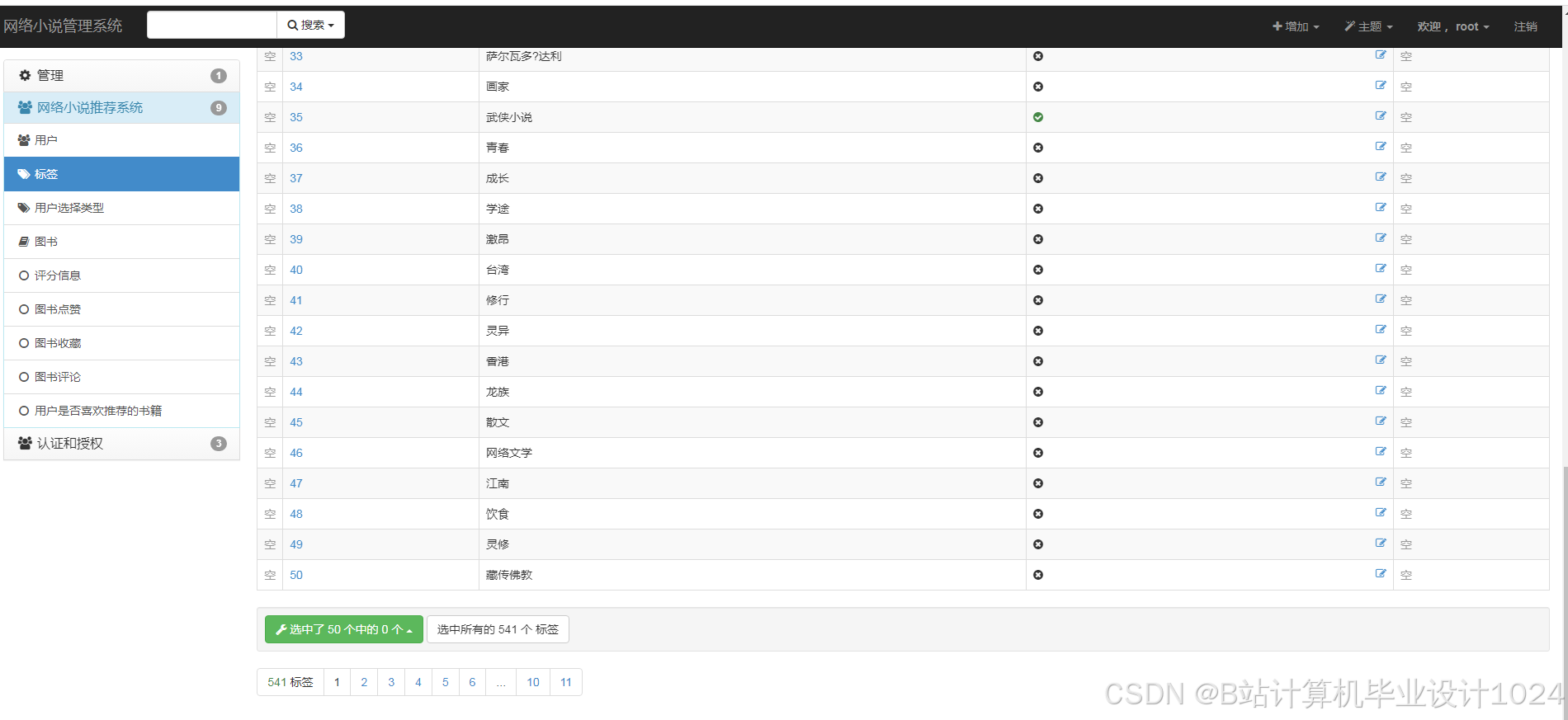

2、创建数据库模型:用户表、图书标签表、用户选择类型表(用户解决推荐算法冷启动问题)、借书清单表、购书清单表、评分表、收藏表、点赞表、评论表、推荐反馈表。然后数据迁移,把表映射到数据库中。

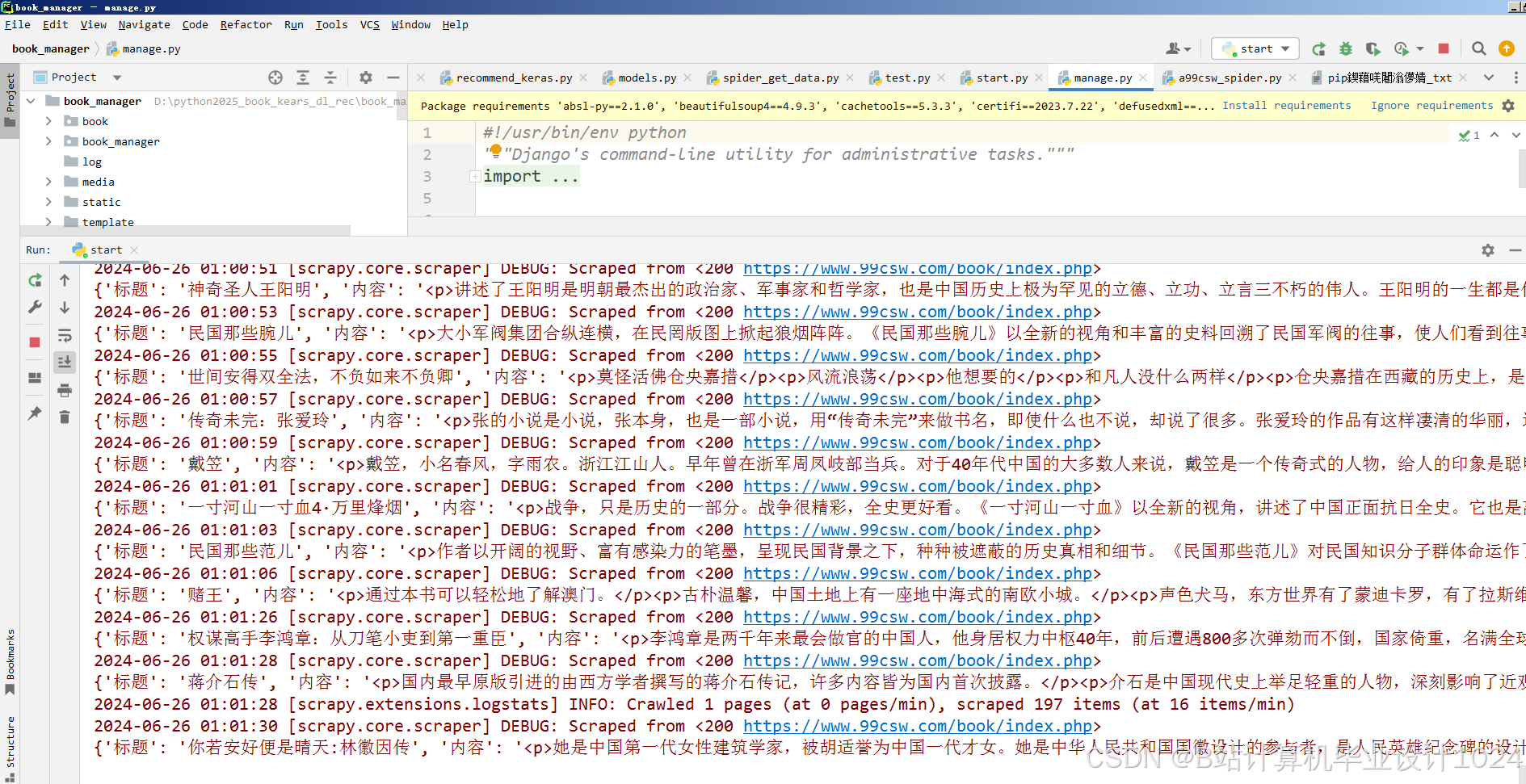

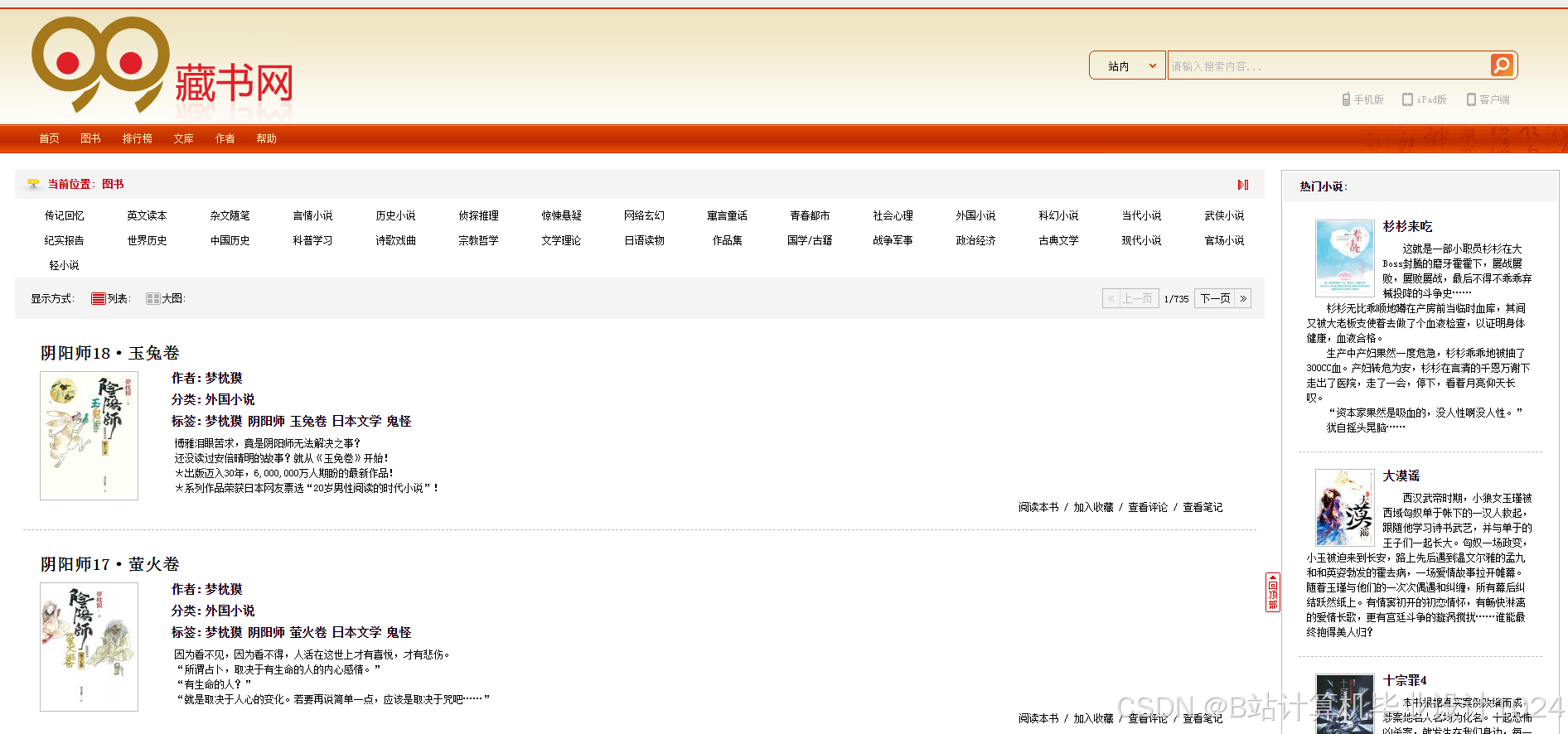

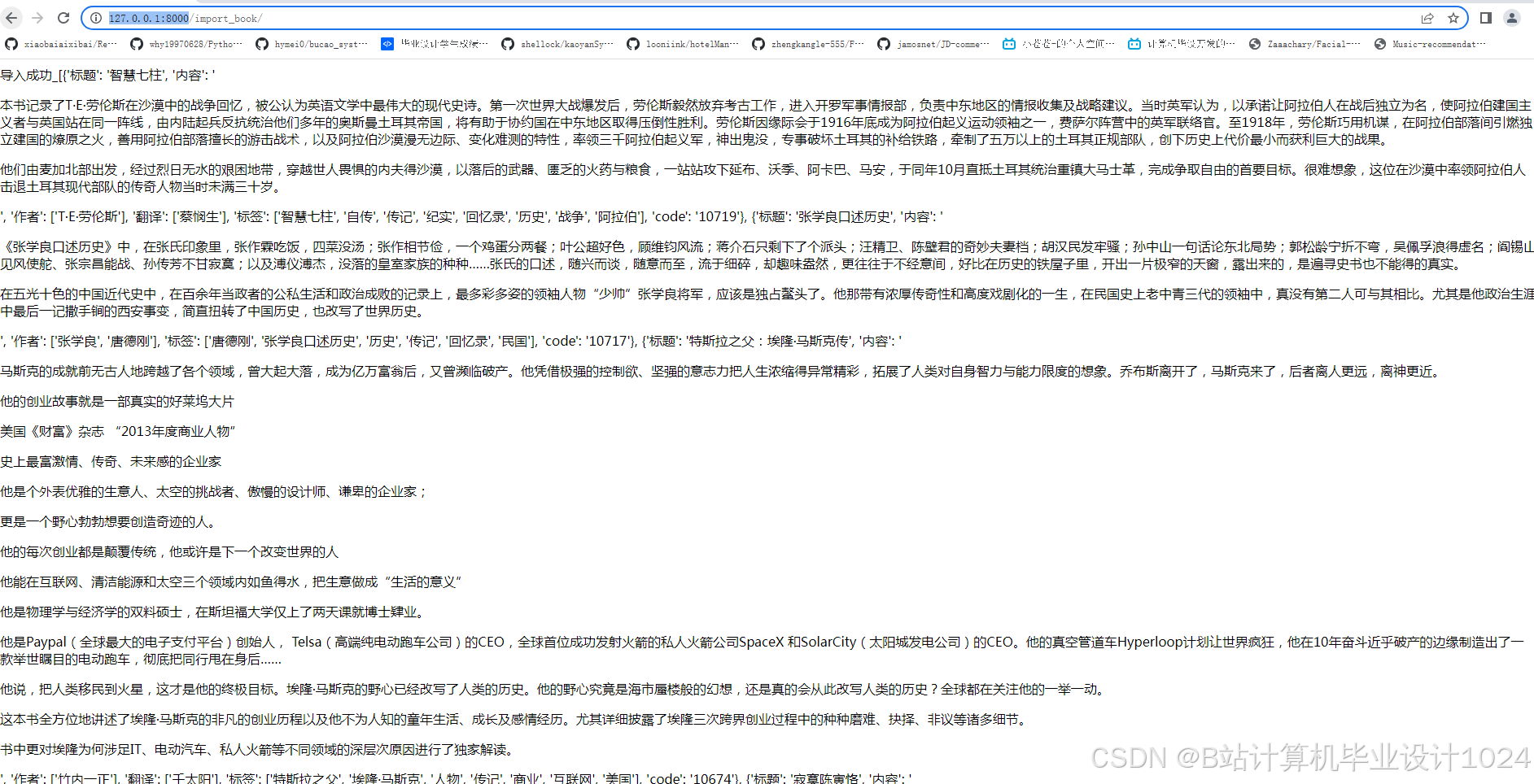

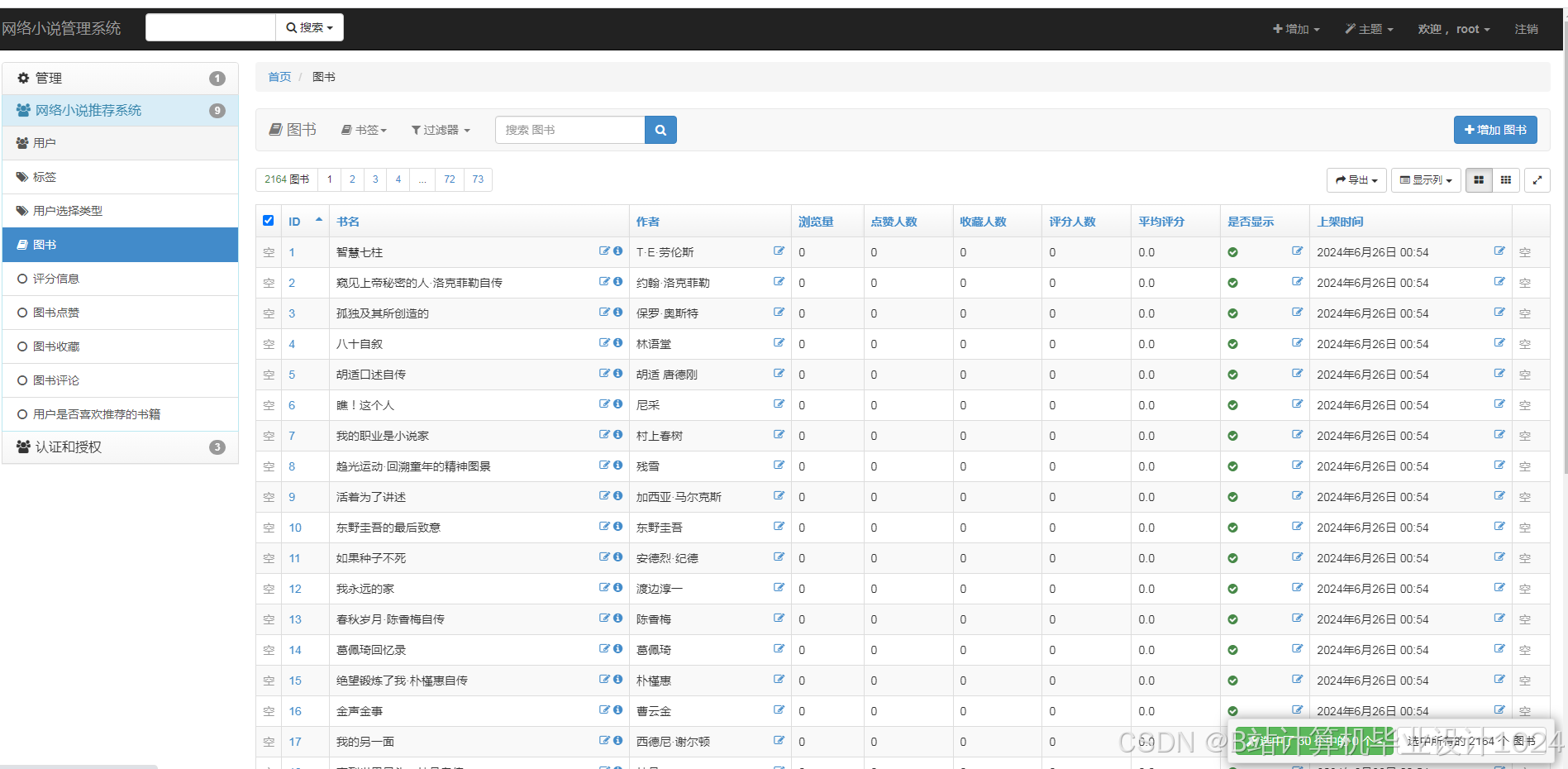

3、爬取数据,然后把数据经过预处理存放到数据库中。

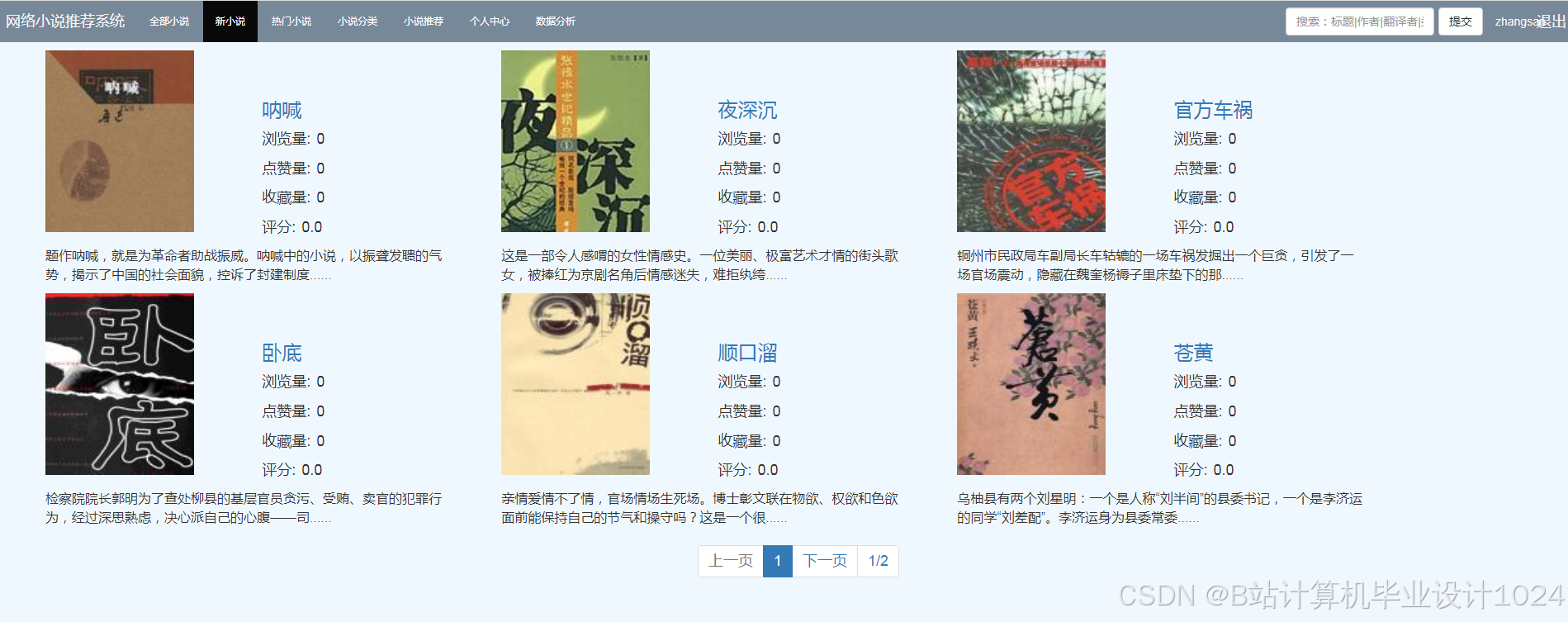

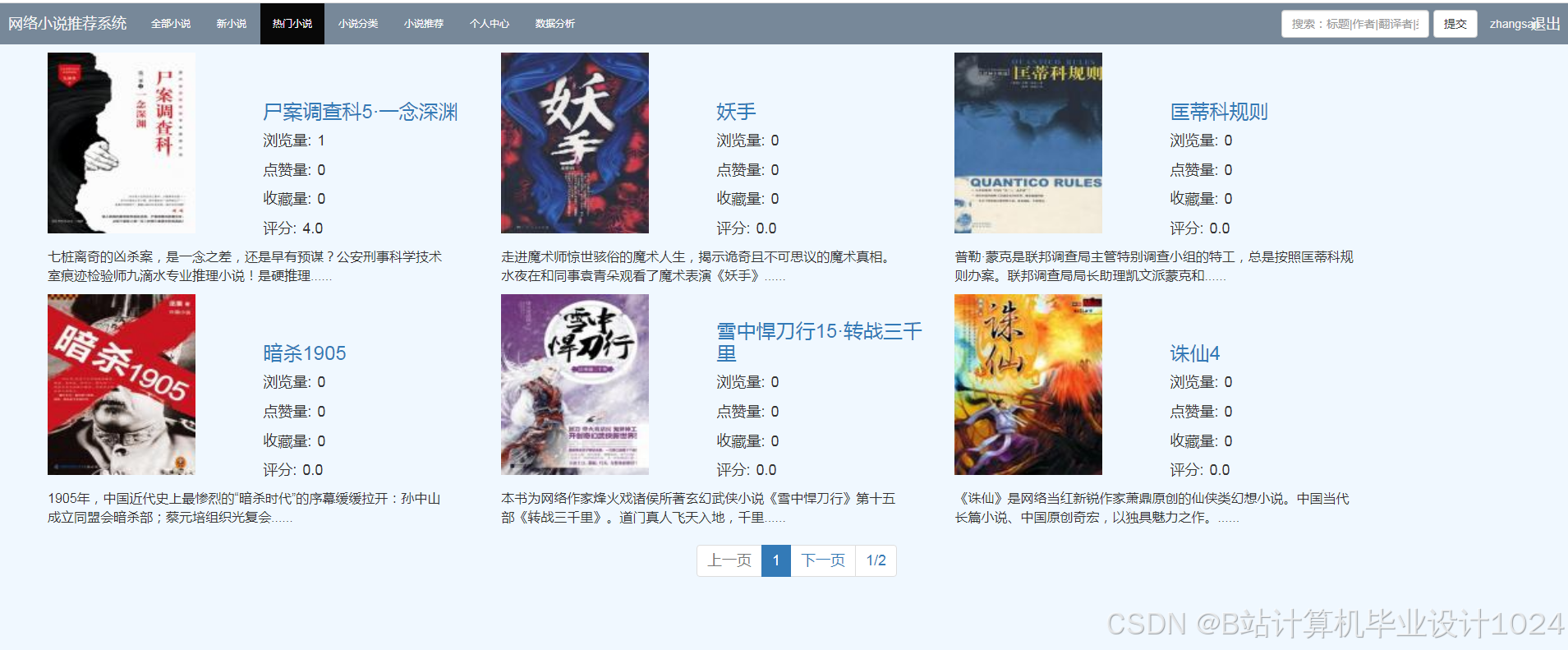

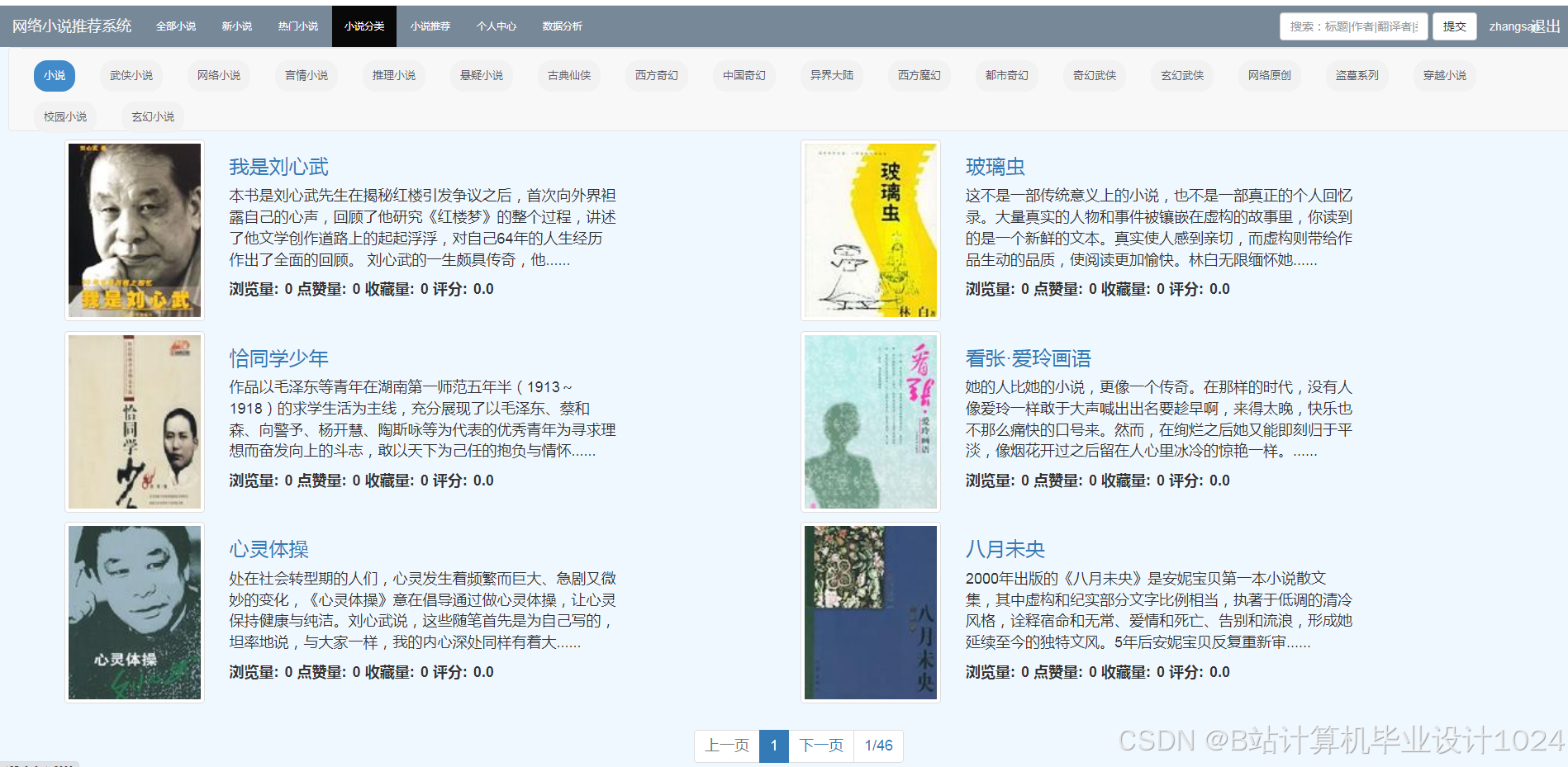

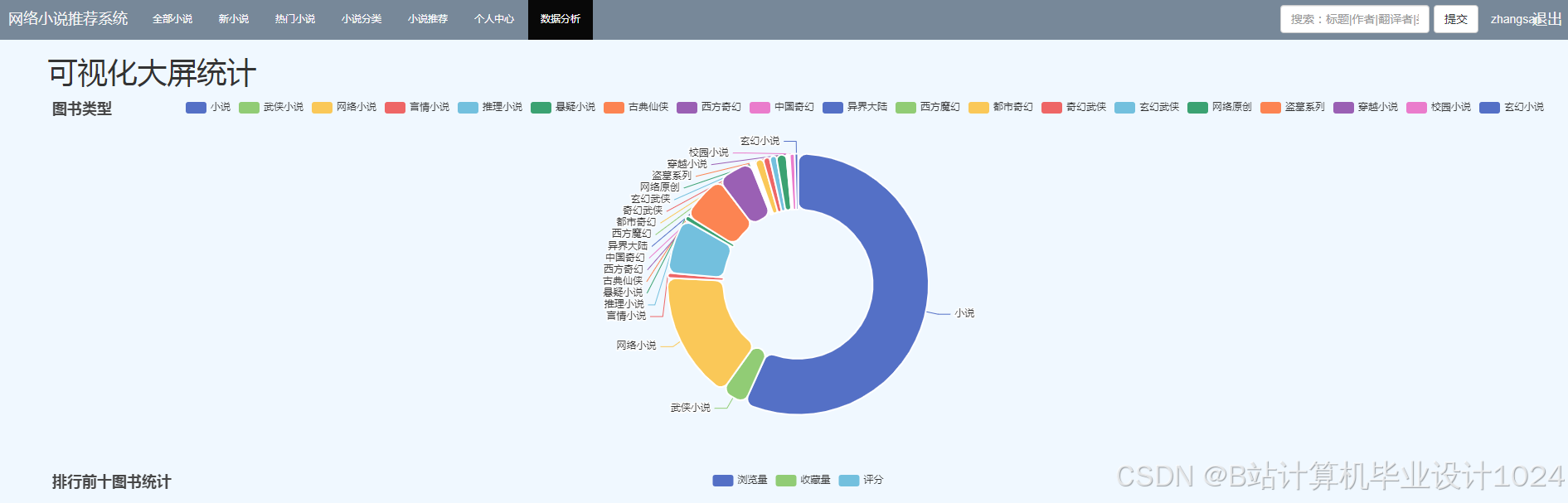

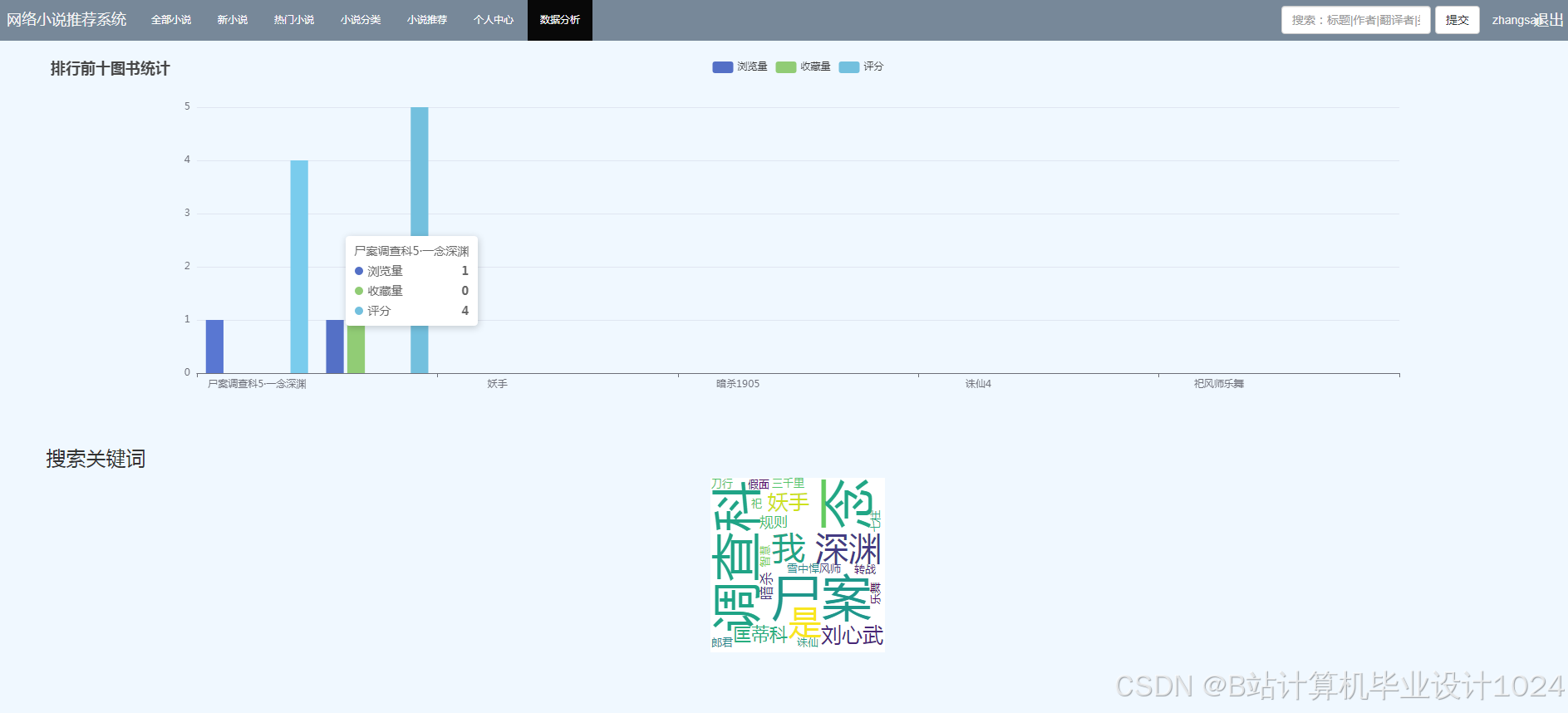

4、编写用户界面框架,完成各种功能点击响应事件

5、编写后台管理文件,管理数据。

6、系统测试,检验完成的功能。

具体开发过程可以查看【开发文档.pdf】

272

272

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?