**开题报告**

---

**题目:Spark+Hadoop+Kafka+Flume实时电商用户数据分析与预测**

**研究背景与意义**

随着电子商务的迅猛发展,大数据技术在电商领域中的应用日益广泛。传统的批处理数据处理方式已经不能满足电商行业对实时数据处理和预测的需求。因此,引入实时数据处理技术成为解决方案之一。Spark作为一种高效的分布式计算框架,结合Hadoop作为大数据存储与管理平台,以及Kafka和Flume作为实时数据采集工具,能够有效地实现电商用户行为数据的实时分析和预测。

本研究旨在探索如何利用Spark、Hadoop、Kafka和Flume构建一个完整的实时数据处理系统,以应对电商领域中多样化和高频率的用户数据产生和分析需求。通过实时监控和分析用户行为数据,电商企业可以更加及时地响应市场变化、优化服务策略,并预测用户行为趋势,从而提升运营效率和用户满意度。

**研究内容与目标**

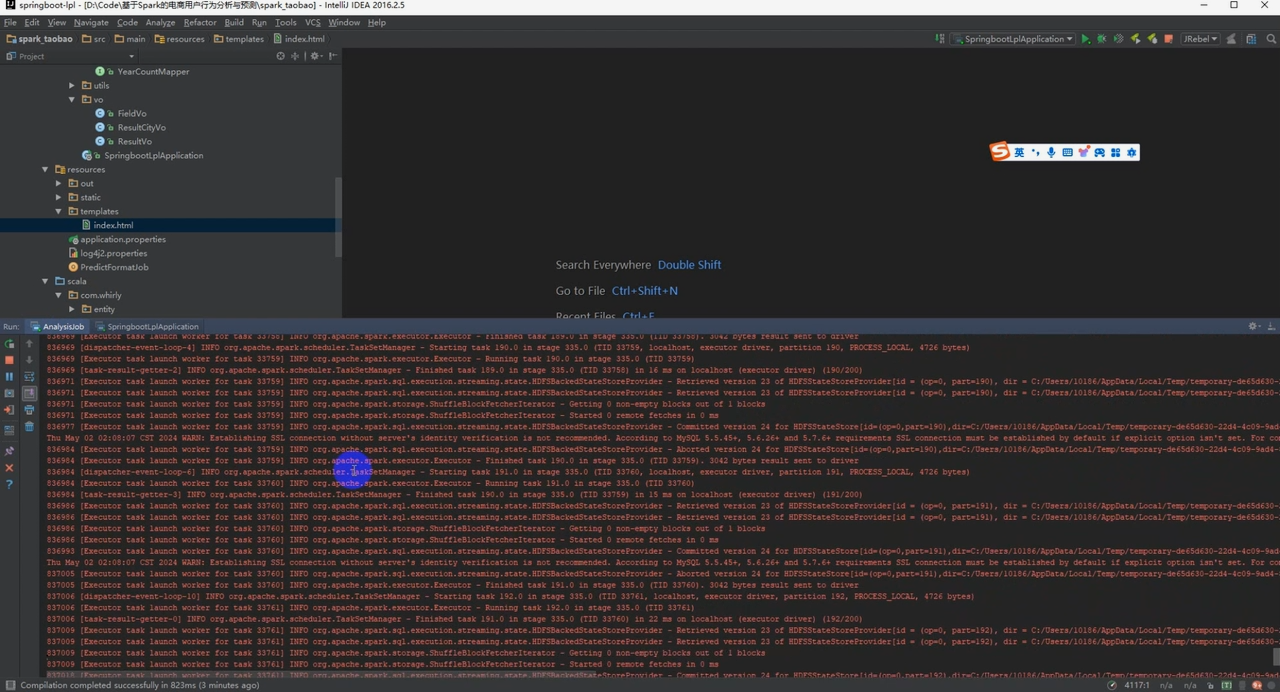

1. **系统架构设计**:设计基于Spark、Hadoop、Kafka和Flume的实时数据处理系统架构,包括数据采集、存储、处理和分析的流程与模块。

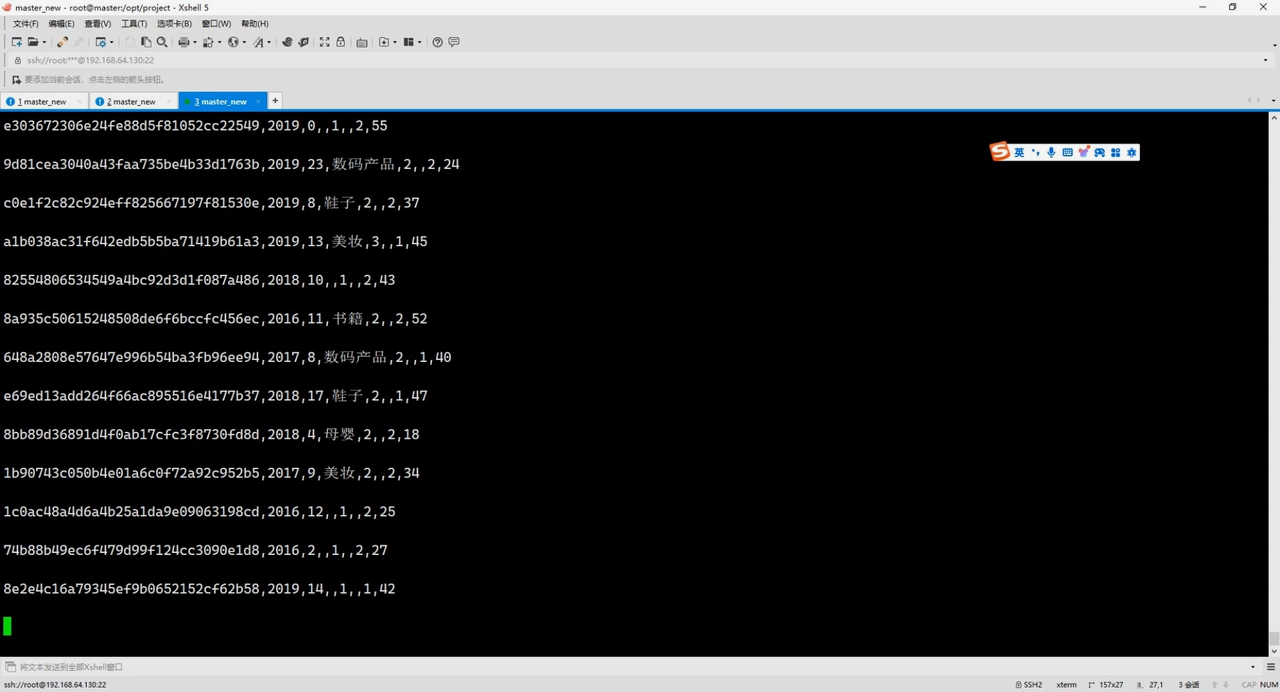

2. **实时数据采集与传输**:探索Kafka和Flume在电商场景下的应用,实现数据的高效、实时采集和传输。

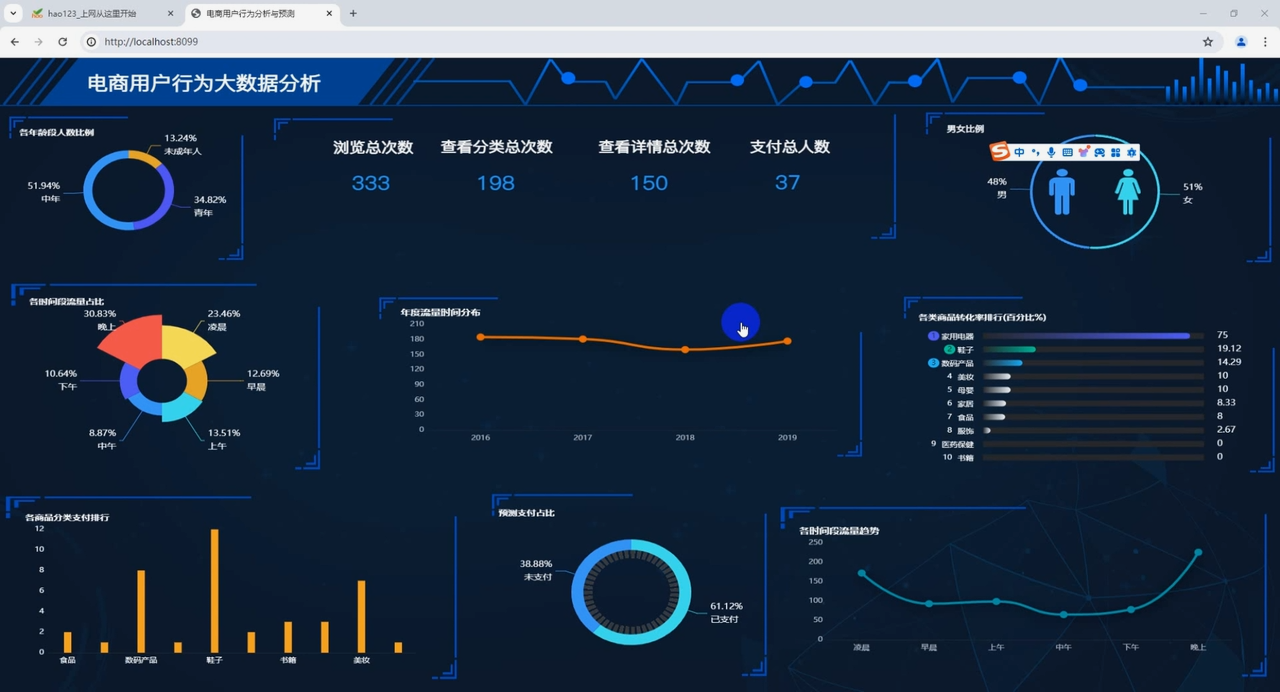

3. **数据处理与分析**:利用Spark实现用户行为数据的实时处理和分析,包括数据清洗、特征提取、模式识别等关键步骤。

4. **用户行为预测与优化**:通过构建机器学习模型,实现对用户行为的实时预测,进而优化个性化推荐、精准营销等业务策略。

**研究方法与技术路线**

本研究将采用实验研究方法,通过构建实际的电商用户数据处理与预测系统,验证Spark、Hadoop、Kafka和Flume在实时数据处理中的可行性和效果。具体技术路线包括:

1. **环境搭建**:配置和部署Spark、Hadoop、Kafka和Flume环境,确保系统能够稳定运行和高效处理数据。

2. **数据集成与采集**:设计并实现数据集成方案,使用Flume进行数据采集,并通过Kafka实现数据的高吞吐量传输。

3. **数据处理与分析**:利用Spark Streaming实现实时数据处理和分析,包括数据转换、特征计算、模型训练等核心功能。

4. **用户行为预测与评估**:构建预测模型,并通过实验评估模型的准确性和实时性。

**预期成果与创新点**

通过本研究,预期可以实现以下成果和创新点:

1. **技术实施方案**:提供一套基于Spark、Hadoop、Kafka和Flume的实时电商用户数据处理和预测的完整技术方案。

2. **业务应用价值**:实现电商用户行为的实时监控与预测,为电商企业提供更加精准和个性化的服务能力,提升市场竞争力。

3. **学术贡献**:在大数据和实时计算领域积累相关的理论和实践经验,为类似场景的研究和应用提供参考。

**研究计划与进度安排**

1. **系统设计与环境搭建**:完成系统架构设计和环境配置,确保基础设施的稳定性和可用性(第1-2个月)。

2. **数据集成与采集**:设计并实现数据集成方案,建立Kafka和Flume的数据采集通道(第3-4个月)。

3. **数据处理与分析**:开发实时数据处理和分析模块,实现基本的数据清洗和特征提取功能(第5-7个月)。

4. **用户行为预测与优化**:构建用户行为预测模型,并进行实时性和准确性的测试与优化(第8-10个月)。

5. **论文撰写与提交**:撰写学位论文,并准备相关的学术论文投稿(第11-12个月)。

**预期研究结果**

通过本研究,预期可以形成一篇完整的学位论文,并可能在相关领域的学术期刊或国际会议上发表相关的技术和应用成果。

**参考文献**

具体参考文献将根据研究过程中的实际需要和相关领域的最新进展进行选择和引用。

---

**指导教师签字:**

日期:__________

---

本开题报告旨在为后续研究工作提供一个清晰的方向和框架,确保研究过程中的科学性和系统性。

186

186

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?