最近几天,裸眼3D领域迎来里程碑突破,复旦大学26岁博士生马炜杰以独立一作身份在《Nature》发表研究成果《Glasses-free 3D display with ultrawide viewing range using deep learning》(使用深度学习的超宽视角无眼镜3D显示)。

作为XR从业者,本文仅从工程思想层面讨论该成果与XR中的相关技术存在的底层共性,旨在提供一个XR技术视角。至于论文涉及到的具体技术原理,鉴于笔者也是这方面的外行,说得越多,暴露的也就越多,所以更多技术细节,读者可访问《Nature》官网检索原文,以作更加深入的了解。

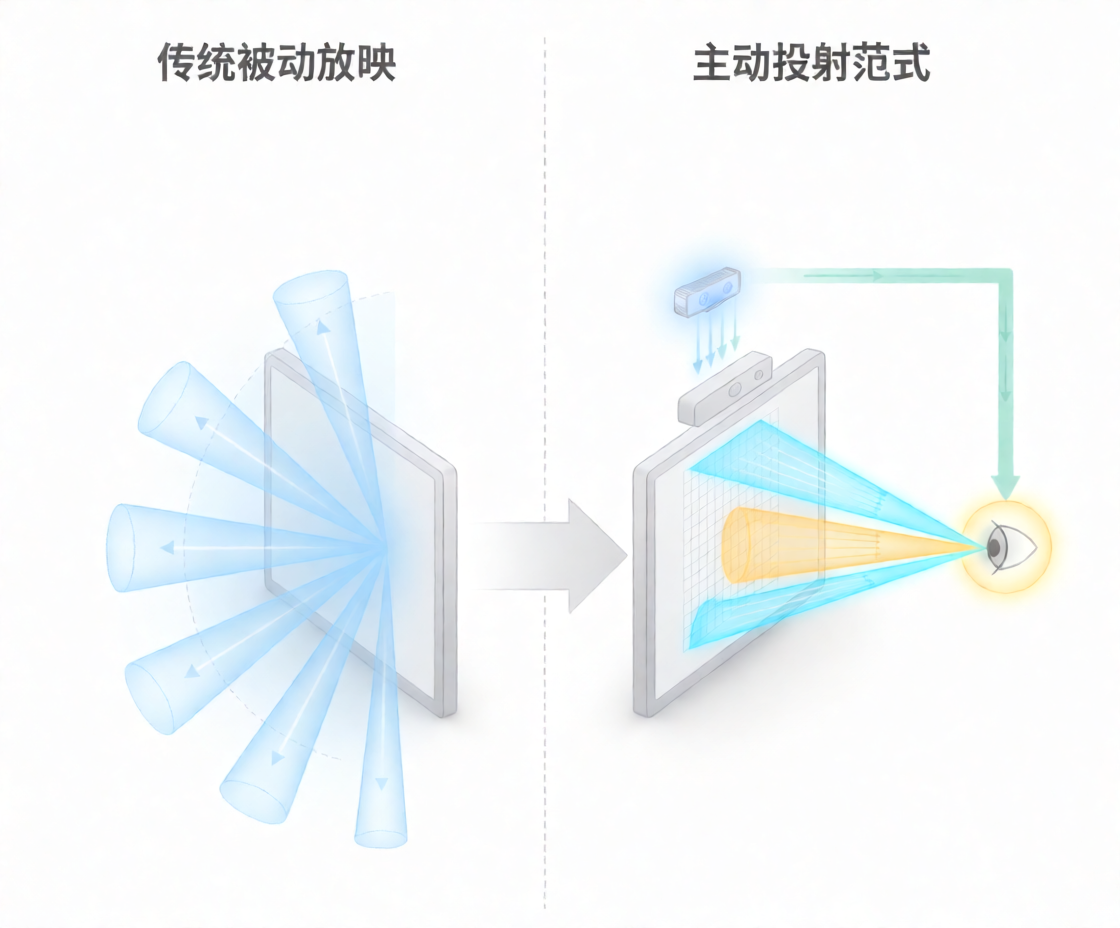

从被动放映到主动投射

为方便后续理解,先简要介绍一下此次的核心技术突破。

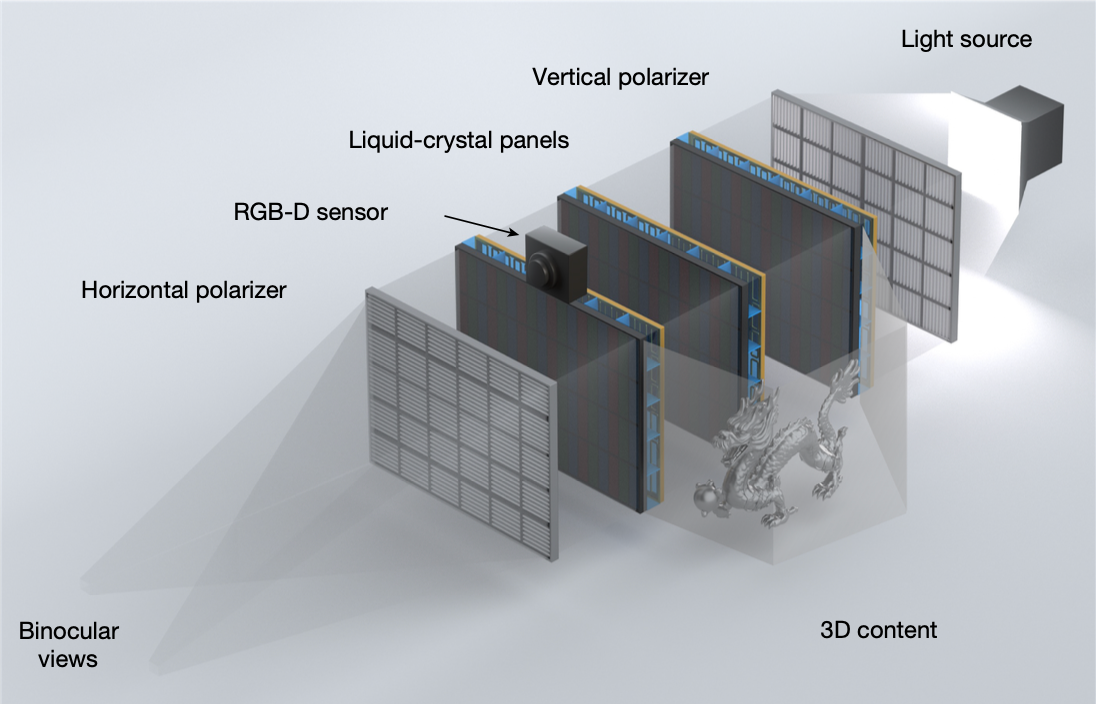

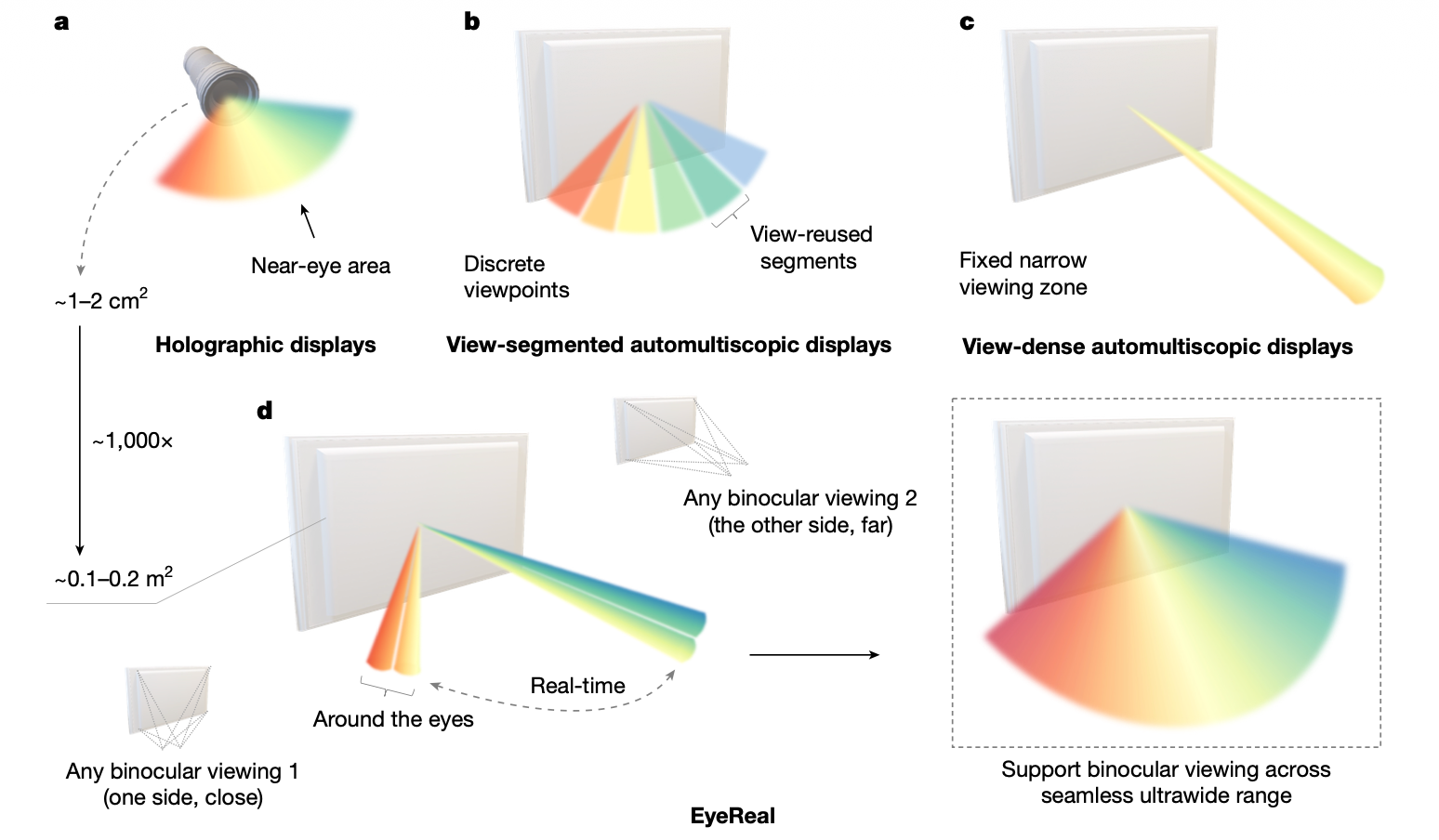

该研究提出了一种基于“计算显示”的全新范式,通过按需生成光场(注:光场是指空间中所有位置、所有方向的光线集合),成功突破了制约传统裸眼3D长达数十年的“空间带宽乘积(SBP)”物理极限,最终在桌面级尺度下,实现了兼具高清晰度与超过100度连续视场角的沉浸式无穿戴显示。

打个比方:传统的裸眼3D技术,试图让所有观众都能看到完美的裸眼3D效果。这种“全向发射”或者叫“试图讨好每个人、雨露均沾”的策略,导致了严重的资源浪费——由于光线资源(总带宽)有限,很难兼顾分辨率与视角的双重需求。

而论文所述技术方案,则是摒弃了全域覆盖的执念,转而借助传感器实时追踪用户的双眼,利用AI驱动反向渲染,实现了光场的“定向投递”——只将最清晰、最真实的光场,精准投射到真正观看当前内容的用户眼中。

如果读者是XR从业者,这么说可能就更容易理解了:该技术方案类似XR领域中的眼动追踪驱动的注视点渲染技术(Foveated Rendering),或者说,这简直就是裸眼3D界的注视点渲染技术——传感器实时追踪用户的视线落点,注视点渲染技术根据追踪数据动态调配渲染权重,将品质最好的内容呈现在用户目力所及的范围内。

而这便是本文所要讨论的所谓工程思想上的相通之处。

眼动追踪 vs. RGB-D 双目定位(RGB-D Binocular Localization)

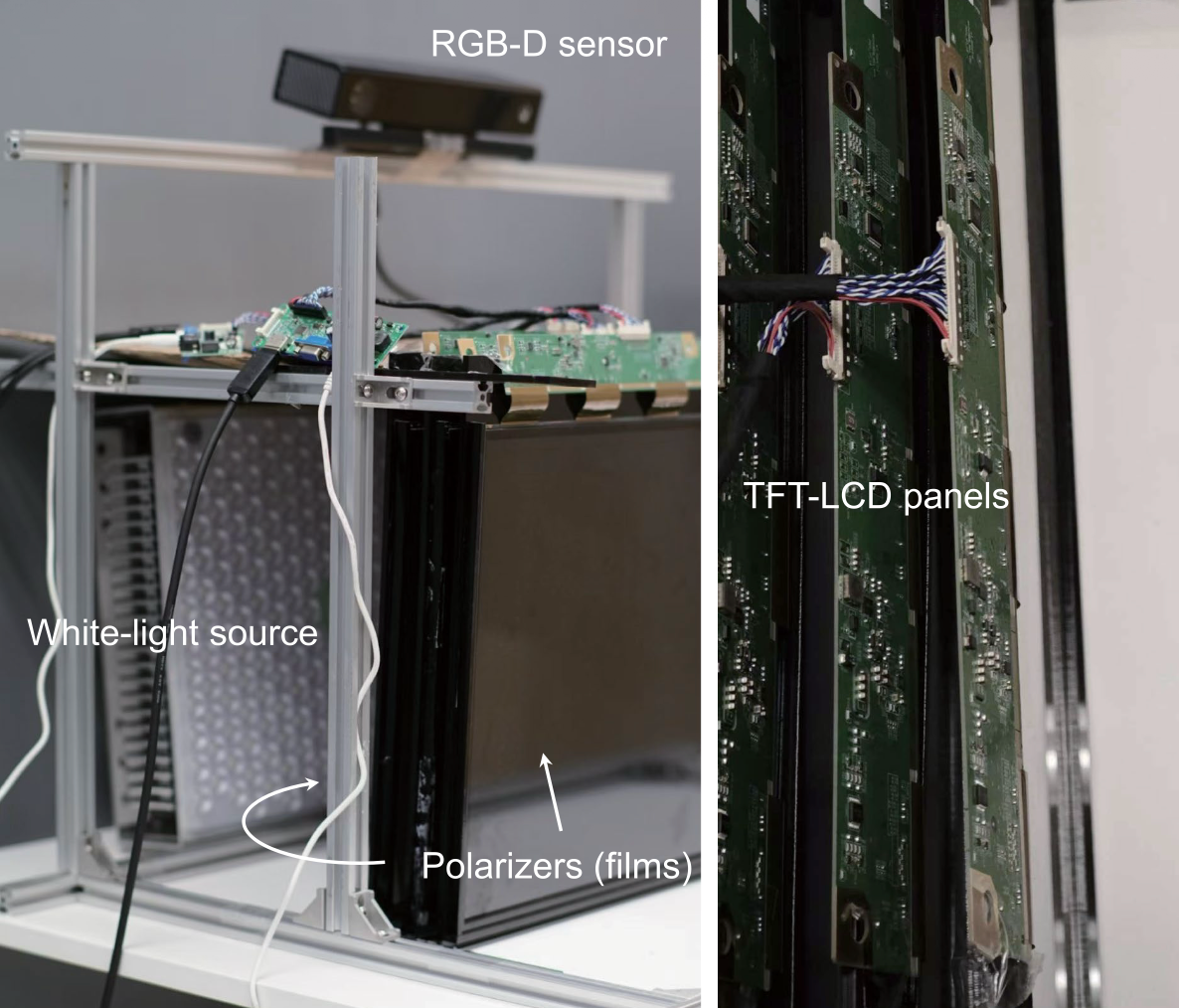

在论文提出的技术方案中,核心技术之一是RGB-D 双目定位。该技术在这套系统中的地位相当于XR头显中的眼动追踪(Eye Tracking)技术。

它通过AI算法实时计算用户双眼的3D空间坐标,得到双眼的6DoF追踪数据,同时也会估算出相对准确的用户瞳距(IPD)。这些数据为后续“计算显示”和光场重建提供了重要的物理建模基础。

捎带一提,论文中实现这一关键功能的传感器,是发布于2013年的微软的Kinect V2,也算是枯木又逢春,老树开新花。

另外,如前所述,该方案引入了AI技术来处理追踪数据,可以想见,未来XR领域的眼动追踪技术,在AI更广泛的加持下,会有更加长足的进步。

注视点渲染 vs. 动态 SBP 利用(Dynamic SBP Utilization)

在得到双眼追踪数据以后,论文使用了一项名为“动态SBP利用”的技术,将有限的屏幕带宽资源集中起来,把最清晰的光场区域“聚合”到真实用户的双眼及其周围的一小片邻域。

而这种思路,与XR领域中的注视点渲染技术如出一辙,不同之处在于,注视点渲染是为了解决GPU算力有限的问题,选择性地模糊周边视野;而论文提出的解决方案,则是为了解决光学带宽不足的问题,而选择性地放弃非观看区域的光场生成。两者本质上都是一种“资源受限下的最优解策略”。

总结:面临相似的问题,使用了相通的解决之道

在XR领域,尤其是移动XR端,核心痛点之一是计算资源与渲染品质之间的矛盾;而在裸眼3D领域,对应的则是显示带宽(光学资源)与视觉沉浸感(分辨率及视角)之间的矛盾。

而解决之道,也存在相通的地方:对于稀缺资源的分配,不是“大锅饭一刀切”,而是采用感知导向的精准分配策略。

综上,当硬件资源遇到瓶颈时,采用基于人类感知特性的“智能资源分配策略”,往往能打开新的突破口。无论是XR中的注视点渲染,还是论文中的动态光场技术,甚至是Unity中的遮挡剔除,本质上都在验证同一个工程理念:

“只有上帝才全渲染,我们只计算目光所及。”

164

164

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?