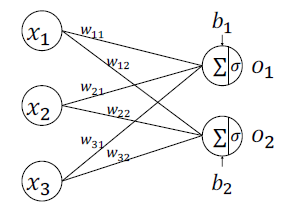

- 全连接层

由于每个输出节点与全部的输入节点相连接,这种网络层称为全连接层(Fully-connected Layer),或者稠密连接层(Dense Layer),W 矩阵叫做全连接层的权值矩阵,𝒃向量叫做全连接层的偏置。

- 神经网络

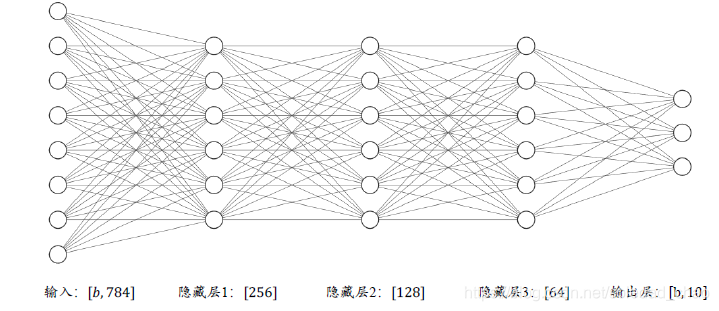

通过层层堆叠图 6.5 中的全连接层,保证前一层的输出节点数与当前层的输入节点数匹配,即可堆叠出任意层数的网络。我们把这种由神经元构成的网络叫做神经网络。

- 张量

https://www.cnblogs.com/abella/p/10142935.html

- 层方式实现神经网络

首先新建各个网络层,并指定各层的激活函数类型:

fc1 = layers.Dense(256, activation=tf.nn.relu) # 隐藏层1

fc2 = layers.Dense(128, activation=tf.nn.relu) # 隐藏层2

fc3 = layers.Dense(64, activation=tf.nn.relu) # 隐藏层3

fc4 = layers.Dense(10, activation=None) # 输出层

对于这种数据依次向前传播的网络,也可以通过Sequential 容器封装成一个网络大类对

象,调用大类的前向计算函数即可完成所有层的前向计算:

# 通过Sequential 容器封装为一个网络类

model = layers.Sequential([

layers.Dense(256, activation=tf.nn.relu) , # 创建隐藏层1

layers.Dense(128, activation=tf.nn.relu) , # 创建隐藏层2

layers.Dense(64, activation=tf.nn.relu) , # 创建隐藏层3

layers.Dense(10, activation=None) , # 创建输出层

])

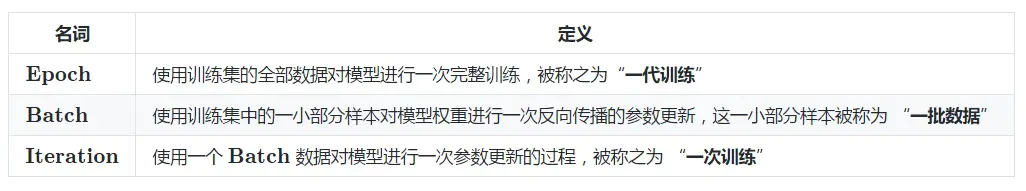

- 三个概念:Epoch, Batch, Iteration

https://www.jianshu.com/p/22c50ded4cf7

9100

9100

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?