导读

在过去两年里,我们不断看到这样的画面:

机械臂按着语言指令冲咖啡、摆盘、擦桌子,具身机器人像“带身体的 GPT”一样执行任务;研究者讨论着 π0、OpenVLA、MolmoAct、SpatialVLA,每一个模型都在尝试回答同一个问题:“如何让机器人真正听懂我们说的每一句话?”

Vision-Language-Action(VLA)模型的出现,让机器人具备了“看得懂、听得懂、动得起来”的雏形。但现实世界比数据集难多了,也比任何算法的想象更宽广。于是,来自 NTU、Stanford、NUS、A*STAR 等机构的研究者共同提出了一份“VLA 发展路线图”,总结了 10 大尚未攻克的核心挑战,清晰地指出:

VLA 想要走向真正的通用具身智能,还差哪些关键拼图?我们结合原文,写下这篇深度盘点,让你系统理解 VLA 的痛点所在,也能看到它的未来走向。

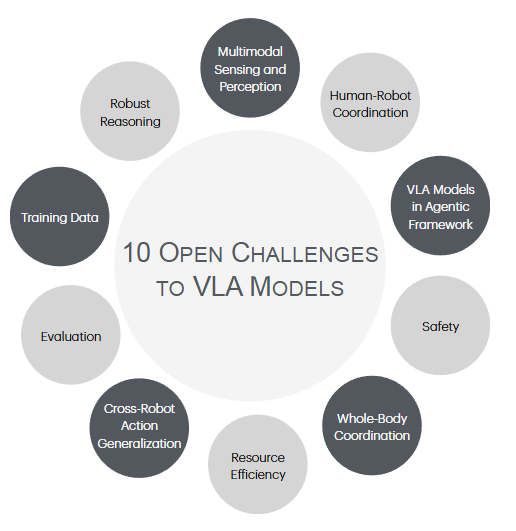

▲图1|当前VLA存在的十大挑战一览

多模态感知:机器人的“眼睛”和“耳朵”仍不够好

论文首先指出了一个简单却残酷的事实:

绝大多数 VLA 仍然是“RGB-only”的二维世界生物。

它们几乎没有深度、没有触觉、没有声音,就像蒙着一只眼睛在工作。

缺深度 → 立体理解极为薄弱

除了 MolmoAct 和 SpatialVLA 等个别模型会用深度 supervision,大部分 VLA 完全依赖 RGB 推测空间结构,这带来严重限制:

● 物体远近难把握

● 小尺度操作不稳定

● 运动推理容易混乱(尤其是移动机器人)

现实世界复杂到离谱:反光、灰尘、水汽、镜面、光照变化,哪一样都是对模型的折磨。

【小编可插入:https://mp.weixin.qq.com/s/Plp1deT5_HjSwUbhO332iQ】(空间理解)

触觉、听觉:未来 VLA 的必需品

作者强调,触觉能让机器人完成精细抓取、料理、装配;声音能帮助机器人在灾难环境定位求救者、识别危险源。

【小编可插入:https://mp.weixin.qq.com/s/Q_RxgkgAFZVWVxuL0GXrEQ】(触觉相关)

如果说 GPT-4 是靠“读”来理解世界,那么机器人需要的是“读 + 看 + 听 + 摸”的全套感知能力。VLA 的多模态感知,仍处在第一阶段。

稳健推理:为什么 VLM 很聪明,但 VLA 动作仍然很蠢?

这一部分说得非常直接:

LLM/VLM 的强推理能力,在落地到 VLA 时大幅削弱。

Emma-X、CoT-VLA、MolmoAct 都在引入 chain-of-thought 或空间推理,但现实依然是:

● 夹取物体会夹歪

● 打开抽屉开不到位

● 长序列任务成功率随时间指数级下降

作者指出一个关键矛盾:

“VLA 的推理任务其实比 LLM 简单得多,但结果却远不如 LLM 稳定。”

核心原因在于:

VLA 不只是“想得对”,它还要“做得对”。

而“做”会暴露各种控制误差 → 累积 → 推理连锁失败。

未来 VLA 必须在 reasoning before action(先推理,再执行)方面更进一步。

高质量训练数据:数据很大,但仍然远远不够

Open-X-Embodiment 贡献了百万级轨迹(太重要),但作者强调:

数据还是不够、还是不干净、还是不稳定。

困难包括:

● 机器人形态不同(action space 不兼容)

● 摄像机位置不同(感知风格变化)

● 操作者不同(演示风格混乱)

● 甚至同一任务会因人而异

更关键的问题在于真实机器人数据太贵、太慢。

Sim2Real 提供部分帮助,但真实世界的光照、材质、柔体、摩擦、反光都很难精确模拟。未来 VLA 必须依赖新的数据获取方式。

【小编可插入:https://mp.weixin.qq.com/s/nvVoSNekAY_Czu72ivy76w】

可靠评估:我们根本没有好办法评估 VLA

目前的 VLA benchmark环境太简单、太固定、太干净。虽然Simulated benchmark 如 SimplerEnv 已改进了:

● 光照扰动

● 纹理变化

● 背景切换

● 相机随机性

但依然无法覆盖现实世界的丰富多样性。

作者指出:

真实及模拟的对应性仍然太弱。

机器人基座稳定性、关节阻尼、夹爪摩擦系数、物体材质,这些在模拟中都难以复刻。

想让 VLA 走向产业,这条评估链还需要大量工程投入。

【小编可插入:https://mp.weixin.qq.com/s/Swo4nzP7JKNEtqzYV5FyAA】

跨机器人泛化:目前基本不可行

这是所有具身智能研究者都在努力解决的问题。

同一个动作:

● 对机械臂是 x/y/z + roll/pitch/yaw

● 对 quadruped 是 leg joint trajectory

● 对 mobile base 是 cmd_vel

● 对仿人机器人是 20+ 自由度

跨机器人动作空间的统一,是 VLA 最大的瓶颈之一。

目前最佳的方法是:

● 先学通用离散行动(codebook)

● 再加 robot-specific decoder 微调

但依然做不到“零样本换机器人”。

未来 VLA 必须像 LLM 的 in-context learning 一样:

通过 prompt 让 VLA 学会新机器人动作空间

这是一个非常大胆、但可能最具前景的方向。

资源效率:机器人本体算力太弱了

作者再次强调一个被忽视的问题:

“机器人机身本地算力很有限,而 VLA 太大了。”

因此业界普遍采用“thin client”(机器人只采数据 → 云端算推理)。

但:

● 延迟高

● 一旦网络断开(如灾害场景)机器人瞬间失能

未来机器人必须本地运行 VLA 的小模型,但小模型性能弱,是必然痛点。

因此效率优化将成为 VLA 规模化部署的前置条件。

【小编可插入https://mp.weixin.qq.com/s/NNciVIDDhO5l0NBUcM7edg】

全身协调:VLA 如何同时控制移动与操作?

具身智能社区正在向“Whole-body control”转型,大名鼎鼎的π系列(π0,π0.5以及最近发布的π0.6)就是移动操作全身控制的VLA范式。

【小编可插入:https://mp.weixin.qq.com/s/v6cnSGvXEWyPNFlOU0PkLw】

作者指出:未来机器人任务不是固定在桌边做 pick-and-place,而是“走过去 → 伸手 → 抓取 → 搬运 → 放置”。

但这意味着:移动控制(base motion)+操作控制(manipulation),这是高度耦合的复杂控制问题,当前主要两条路线:分别是基于模型的 MPC;优点是可解释、安全性强,但由需要精确动力学模型、实时优化代价极高的缺点。而数据驱动控制的优点则是泛化性强、可学习复杂行为,但其不稳定、不好调参、跨 robot 性差限制了其的应用。

未来趋势很明确:

混合控制(Hybrid Control)= MPC 提供安全界限 + VLA 或 RL 提供策略探索。

安全性:VLA 是“可动的 GPT”,风险比 LLM 大多了

LLM 有幻觉无所谓,它最多误导人类决策。

但 VLA 的幻觉,会直接动手破坏东西,甚至伤人。文中提到 SafeVLA(2025)尝试使用 RL-based Safety Alignment,让机器人在执行中主动规避风险。

作者重点提醒:

Safety 不是附加的,而是 VLA 在真实部署前必须集成的核心模块

VLA 在 Agentic 框架中的未来

未来不会是“一台机器人”,而是“一群机器人 + 一群模型”协作完成任务。

这意味着:

● 多机器人互相视角补充

● 任务分解(workflow generation)

● 行为协作

● Agent 之间的语言沟通

● 资源调度

● 任务规划的分布式执行

作者提出:

VLA 将成为多智能体系统中的一个“行动执行体(executor)”,而不是计划者(planner)。

高层规划将由 LLM/VLM 负责。

VLA 未来更像“手脚”,而不是“大脑”

人机协作:VLA 必须学会“和人说话”

现在的人机交互几乎是一条单向通道:

人 → 机器人未来需要双向:

● 机器人解释为什么这么做

● 机器人反问不确定步骤

● 机器人可视化意图(CoT-VLA 中已有雏形)

作者强调:

语言输出是 VLA 与现实环境交互的关键能力

论文在最后给出了面向未来的整体路线图:VLA 想要跨越当下的十个核心瓶颈,必须从体系结构到训练方式进行全面升级。研究者认为,未来的突破将来自六大方向的协同推进:

高层规划与低层控制分离,通过 LLM/VLM 负责计划、VLA 专注执行;强化 3D 空间理解,引入真实深度、RGB-D、LIDAR 与多视角数据让模型真正看懂世界;构建跨机器人共享的通用动作表示,使“原子动作”可被不同机器人复用;借助世界模型预测动作后果,让机器人像人一样“先在脑中推演”;利用视频生成模型合成大规模训练轨迹,缓解真实数据采集昂贵的问题;并最终通过 RL、DPO、偏好优化等后训练方式持续提升行为表现。六条路径相互补充,构成了下一代 VLA 从实验室走向现实场景、迈向具身智能新阶段的技术底座。

阅读这份《10 Open Challenges》最大的感受是:VLA 距离真正的“通用机器人”仍有相当长的路要走,但未来的突破方向已经非常清晰。十个挑战层层递进,每解决一个,机器人就更接近能够像人一样理解世界、推理、协作与行动的那一步。未来的 VLA 不再是“看图 + 生成动作”的模式,而会逐渐拥有多模态 3D 世界理解、类人链式推理、全身协调控制、更高的安全性与效率、多机器人协作,以及自然语言层面的双向交流。当这些能力被逐一补齐,机器人将不再是被动执行指令的工具,而是真正具备计划、感知、推理与迁移的智能体。那一天,也将是具身 AGI 雏形开始在现实世界落地的时刻。

REF

标题:10 Open Challenges Steering the Future of Vision-Language-Action Models

369

369

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?