2.1 二分分类

神经网络的输入矩阵X通常是一个n*m的矩阵。一列为一个样本,即一个n维的列向量。假设图像是一个5*5的rbg图像,则n为5*5*3=75。m表示一共有m个样本。

输出矩阵Y通常为1*m的矩阵,1位表示0或1来实现二分分类。m为样本数。

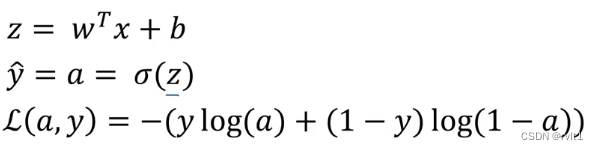

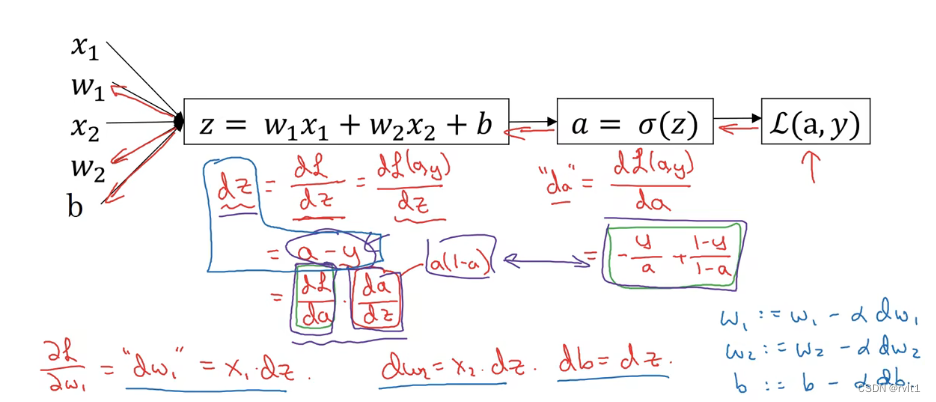

2.2 逻辑回归

为了让模型来通过学习调整参数,要给一个m个样本的训练集。要通过训练集找到w和b来使我们对训练集中的预测值(y-hat)接近训练集中的输出值(y)。

在定义损失函数时要尽可能地凹,这样就可能尽可能少的局部最优值,有助于梯度下降法找到解。

损失函数loss function是在单个训练样本中定义的,它衡量了在单个训练样本上的表现。

成本函数cost function是定义在全局训练样本上的效果。

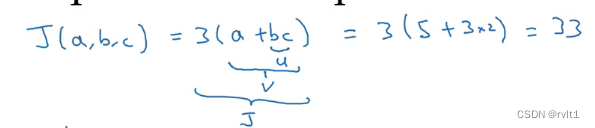

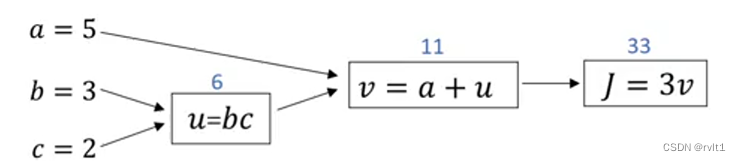

2.3 计算图

对于计算图从左到右计算成本函数,反向从右到左计算导数。

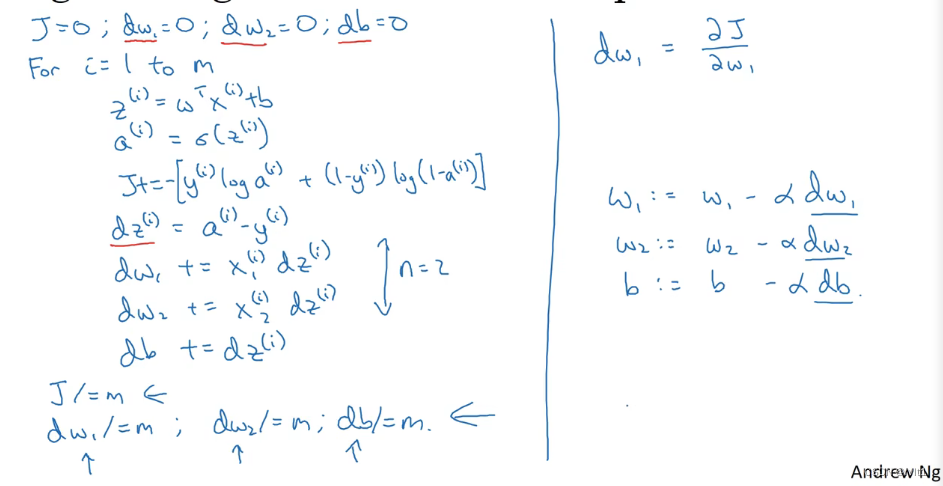

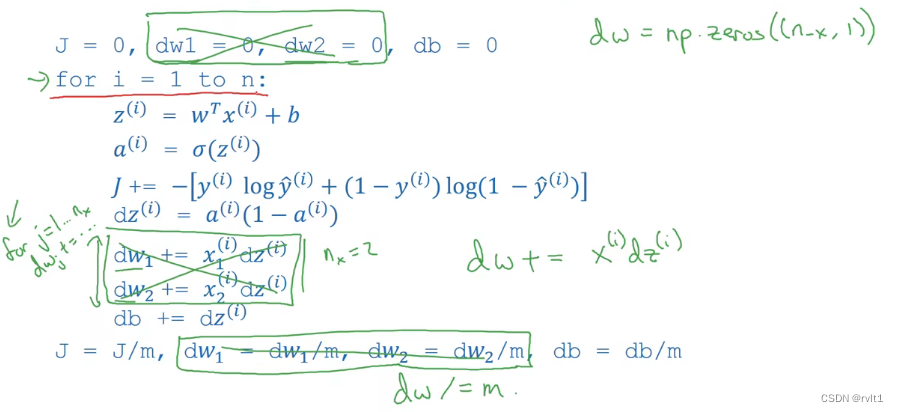

在m个样本中实现逻辑回归和梯度下降

2.4 向量化

循环会比向量化的速度慢上百倍。

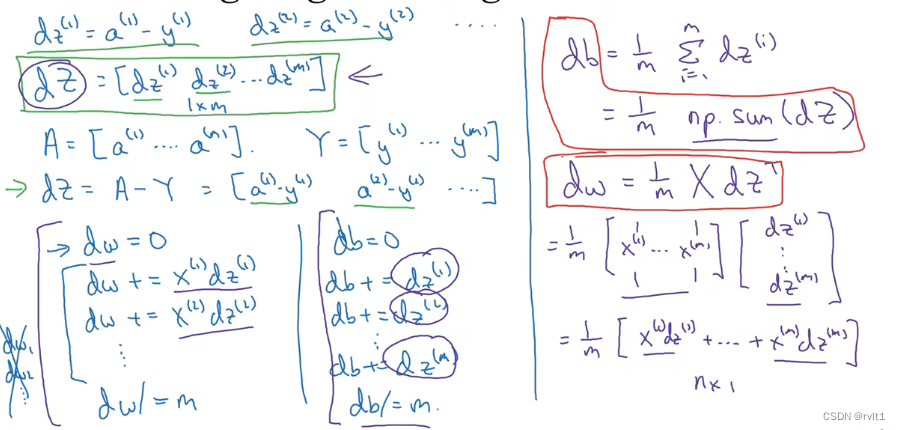

用向量优化之前的算法。

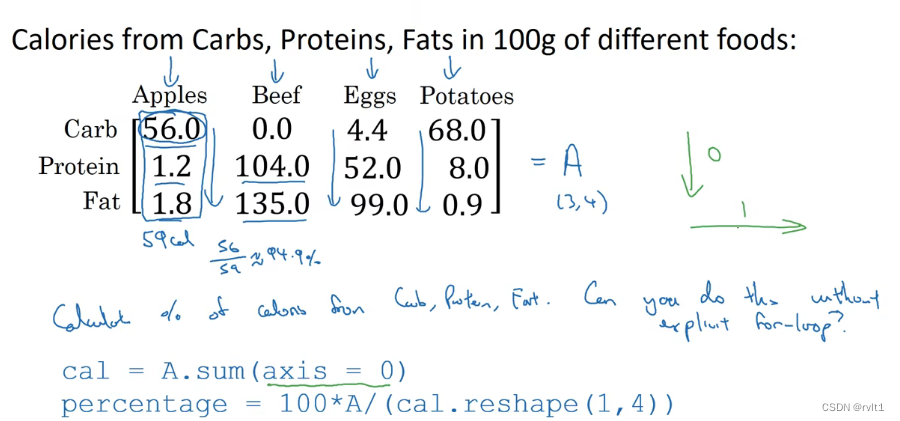

2.5 python广播

计算每种物质所占卡路里的比例。

2.6 numpy

1.消除代码中秩为1的数组,用列向量和行向量来替代。

2.随意插入assert()声明,仔细检查矩阵和数组的维度

3.调用reshape来确保矩阵或向量是需要的维度

本文介绍了神经网络的输入和输出矩阵结构,特别是在处理5x5 RGB图像时的情况。接着讨论了逻辑回归在二分分类中的应用,强调了损失函数和成本函数的重要性,以及如何通过梯度下降优化模型。此外,还提到了向量化运算的效率优势,并解释了Python中的广播机制和NumPy库在数组操作中的作用。

本文介绍了神经网络的输入和输出矩阵结构,特别是在处理5x5 RGB图像时的情况。接着讨论了逻辑回归在二分分类中的应用,强调了损失函数和成本函数的重要性,以及如何通过梯度下降优化模型。此外,还提到了向量化运算的效率优势,并解释了Python中的广播机制和NumPy库在数组操作中的作用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?