作者:Ben Dickson(软件工程师、TechTalks 的创始人)

译者:hhhnoone

原文:Deep learning doesn’t need to be a black box

深度神经网络的成功,要归功于它们极其庞大而复杂的参数网络,但是这种复杂性也导致了某些弊端:神经网络的内部运作通常是一个谜 —— 即使对于其创造者而言也是如此。自从深度学习从 2010 年代初期开始流行以来,这个难题就持续困扰着人工智能社区。

随着深度学习在不同领域的应用和拓展,人们对能够通过验证神经网络结果和学习参数来解释神经网络(内部工作原理)的技术越来越感兴趣。

最近,Nature Machine Intelligence 发表的一篇论文,介绍了一种有潜力的新方法。杜克大学的科学家提出了一种名为 “concept whitening”(概念白化)技术,可在不牺牲性能的前提下帮助引导神经网络学习特定的概念。concept whitening 将可解释性带入了深度学习模型,而不是在数百万经过过训练的参数中寻找答案,显示出令人鼓舞的结果。

深度学习模型的特征和隐空间

如果有足够高质量的训练例子,一个具有合理架构的深度学习模型应该能够区分不同类型的输入。例如,在计算机视觉任务中,经过训练的神经网络将能够将图像的像素值转换为其相应的类别。而 concept whitening,正是在图像识别背景下提出的。

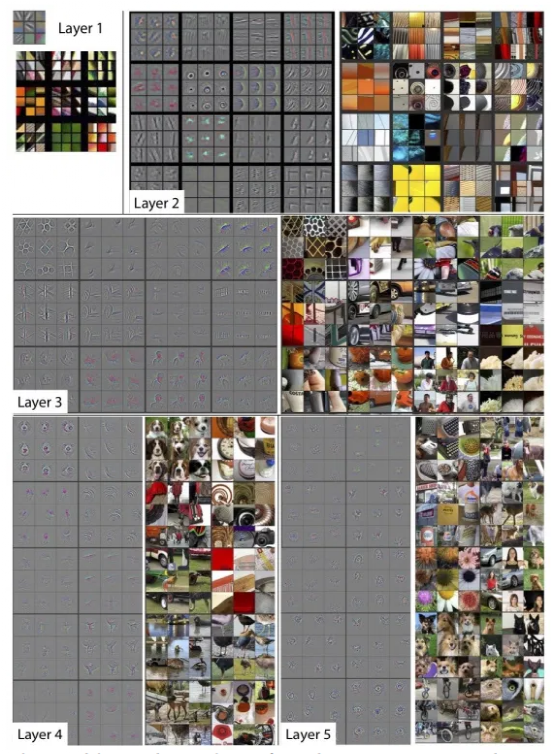

在训练过程中,深度学习模型的每一层都将训练图像的特征编码成一组数值,并存储在其参数中,这被称为 AI 模型的隐空间(Latent Space)。一般来说,多层卷积神经网络的较低层将学习基本特征,如角和边,更高层次的神经网络将学习检测更复杂的特征,如人脸、物体、完整的场景等。

图:神经网络的每一层编码输入图片的特定特征

理想情况下,神经网络的隐空间代表一些概念,这些概念与神经网络要检测的图像类别相关,但是我们通常不能清楚地意识到这一点,并且深度学习模型倾向于学习最具有辨识度的特征,即使这些特征是错误的。

例如,下面的数据集包含一

本文介绍了杜克大学科学家提出的一种新技术——概念白化(Concept Whitening),旨在提高神经网络的可解释性,而不牺牲性能。概念白化通过调整神经网络的隐空间,使其与相关概念对齐,从而帮助理解模型内部工作原理,减少错误学习。这种方法在保持深度学习模型准确性的同时,提供了更好的可解释性,对于理解和改进神经网络具有重要意义。

本文介绍了杜克大学科学家提出的一种新技术——概念白化(Concept Whitening),旨在提高神经网络的可解释性,而不牺牲性能。概念白化通过调整神经网络的隐空间,使其与相关概念对齐,从而帮助理解模型内部工作原理,减少错误学习。这种方法在保持深度学习模型准确性的同时,提供了更好的可解释性,对于理解和改进神经网络具有重要意义。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?