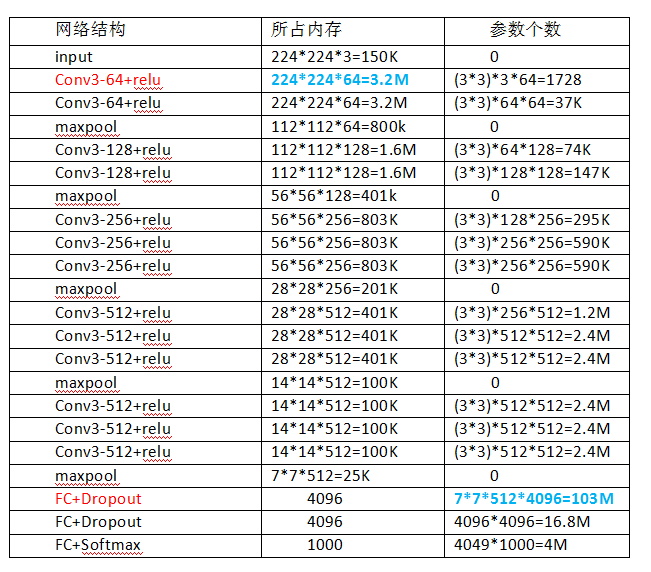

1 网络结构:

以224*224输入图片为例:

感觉VGGNet就是加深版的AlexNet,都是卷积与池化的叠加,最后再加两层全连接,然后softmax输出。VGGNet有5段卷积,每段卷积由2~3个卷积层后加一个最大池化组成。卷积核的数量也随着层数的增加而增多。VGGNet也沿用了AlexNet数据增强的方法(Multi-Scale)防止模型过拟合。

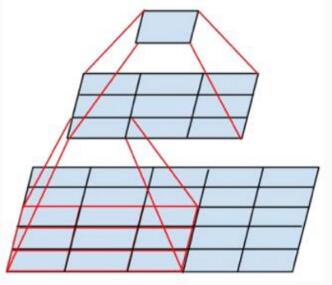

相较与AleNet,VGGNet最大的改进或者说区别就是用小size的Filter代替大size的Filter。比如,在VGGNet中,下面这种结构很常见,就是会用两个3*3的卷积核代替一个5*5的卷积核,

为什么这样呢?这样训练的好处有:

①需要训练的参数减少。如果卷积层C2的卷积核数量是N,上一层C1卷积核数量是M,则用一个5*5 size的卷积核实现该层卷积的参数数量是:5*5*N*M=25N*M;如果用两个3*3 size大小的卷积核代替一个5*5 size大小的卷积核,此时的参数数量是:(3*3*2)*N*M=18N*M。

②增加非线性变换的次数,增加了CNN对特征的学习能力。一个5*5的卷积核,经过一次卷积,则只进行一次非线性变换,而两个3*3的卷积核,则经过两次非线性变换。

2 成绩:

2014年亚军,错误率7.3%左右。

3 新技术点:

①LRN层作用不大,还耗时,抛弃。

②网络越深,效果越好。

③卷积核用较小的卷积核,比如3*3。

VGGNet模型虽然比Alexnet模型层数多,每轮训练的时间会比Alexnet长许多,但是因为更深的网络和更小的卷积核带来的隐式正则化结果,需要的收敛的迭代次数较少许多。

转自:https://blog.youkuaiyun.com/jiafeier_555/article/details/77341290

VGGNet作为深度学习领域的经典模型,其结构相比AlexNet更加深化,通过使用小尺寸的卷积核来替代大尺寸卷积核,有效减少了参数量并增加了非线性变换的次数,提升了CNN对特征的学习能力。VGGNet在2014年的ILSVRC竞赛中获得亚军,错误率约为7.3%,其放弃LRN层,采用3*3的小卷积核,证明了网络深度和小卷积核的优势。

VGGNet作为深度学习领域的经典模型,其结构相比AlexNet更加深化,通过使用小尺寸的卷积核来替代大尺寸卷积核,有效减少了参数量并增加了非线性变换的次数,提升了CNN对特征的学习能力。VGGNet在2014年的ILSVRC竞赛中获得亚军,错误率约为7.3%,其放弃LRN层,采用3*3的小卷积核,证明了网络深度和小卷积核的优势。

2917

2917

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?