目录

算法原理

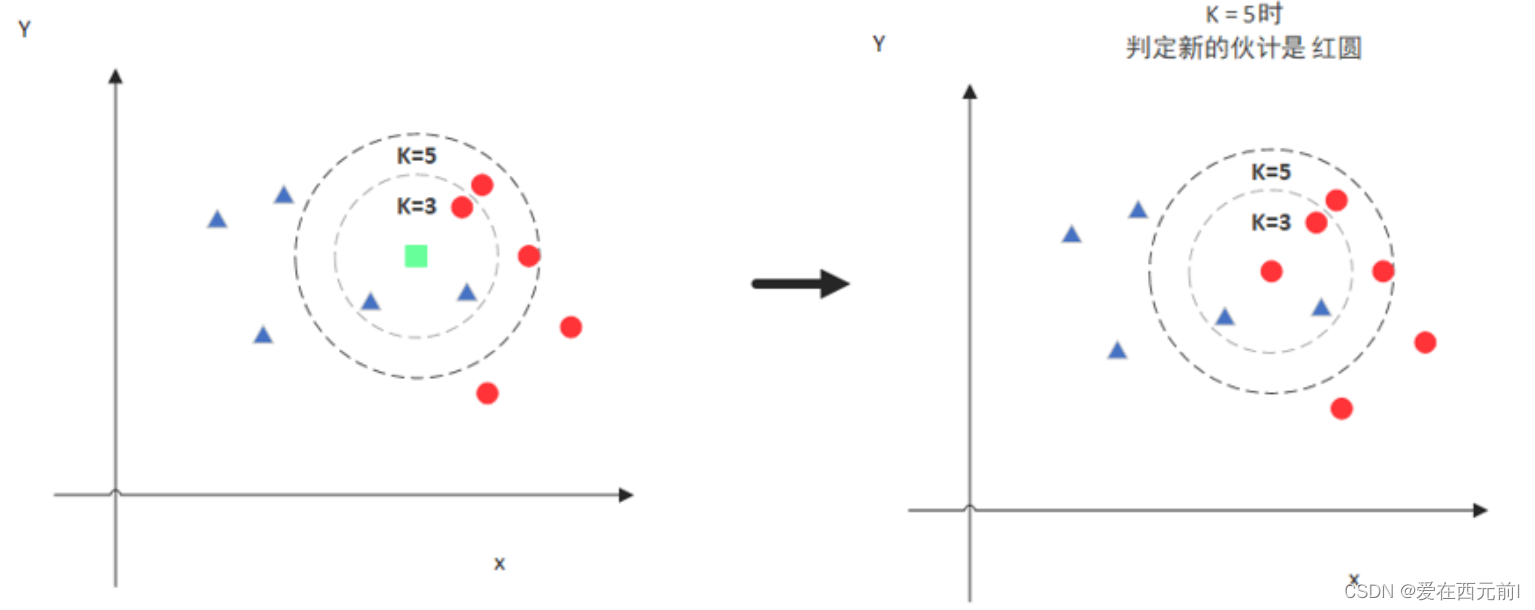

KNN(K-Nearest Neighbor)算法,意思是K个最近的邻居。K个最近邻居,所以说K的取值是至关重要的。那么最近的邻居又是怎么回事呢?其实啊,KNN的原理就是当预测一个新的

值x的时候,根据它距离最近的K个点是什么类别来判断x属于哪个类别。

KNN算法就会找到与它距离最近的三个点(这里用圆圈把它圈起来了),看看哪种类别多一些,K=3是蓝色三角形多一些,新来的绿色点就归类到蓝三角了,K=5时红色圆形多一些,所以就归类到红色点。

实现步骤

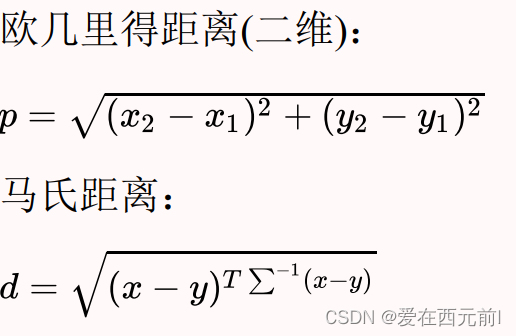

1、计算距离:

2、升序排列

3、取前K个:K值大:导致分类模糊、K值小:受个例影响太大

4、加权平均

实战应用

import csv

import random

# 读取数据

with open(".\Prostate_Cancer.csv", "r") as f:

render = csv.DictReader(f)

datas = [row for row in render]

# 分组,打乱数据

random.shuffle(datas) # 数据打乱

# 将数据划分为3:7的比例,3是测试集,7是训练集

n = len(datas) // 3

test_data = datas[0:n]

train_data = datas[n:]

# print (train_data[0])

# print (train_data[0]["id"])

# 计算对应的距离(欧几里得距离)

def distance(x, y):

res = 0

for k in ("radius", "texture", "perimeter", "area", "smoothness", "compactness", "symmetry", "fractal_dimension"):

res += (float(x[k]) - float(y[k])) ** 2

return res ** 0.5

# K=6

def knn(data, K):

# 1. 计算距离

res = [

{"result": train["diagnosis_result"], "distance": distance(data, train)}

for train in train_data

]

# 2. 排序

sorted(res, key=lambda x: x["distance"]) # sorted函数进行从小到达的排序

# print(res)

# 3. 取前K个

res2 = res[0:K]

# 4. 加权平均

result = {"B": 0, "M": 0}

# 4.1 总距离

sum = 0

for r in res2:

sum += r["distance"]

# 4.2 计算权重

for r in res2:

result[r['result']] += 1 - r["distance"] / sum

# 4.3 得出结果

if result['B'] > result['M']:

return "B"

else:

return "M"

# print(distance(train_data[0],train_data[1]))

# 预测结果和真实结果对比,计算准确率

for k in range(1, 11):

correct = 0

for test in test_data:

result = test["diagnosis_result"]

result2 = knn(test, k)

if result == result2:

correct += 1

print("k=" + str(k) + "时,准确率{:.2f}%".format(100 * correct / len(test_data)))

本文介绍了KNN算法的基本原理,包括如何通过计算距离找到最近的邻居并进行分类。此外还提供了KNN算法的具体实现步骤,并通过实战案例展示了如何使用Python进行KNN分类。

本文介绍了KNN算法的基本原理,包括如何通过计算距离找到最近的邻居并进行分类。此外还提供了KNN算法的具体实现步骤,并通过实战案例展示了如何使用Python进行KNN分类。

408

408

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?