参数调整、正则化、优化

本周学习了深度学习(吴恩达老师的课程)中,提升深度神经网络的一些方法,包括超参数的调整、正则化以及优化算法,明白了网络优化的一些思路以及优化的原理。

1 超参数

在学习率、梯度下降的循环次数(iteration)、隐藏层数目(L)、隐藏层神经元个数、激活函数、momentum、batch size等等超参数中,学习率是其中最为重的超参数。在我们测试学习率的选值测试过程中,我们不能够按照随机均匀取值法,而应该选择对数标尺搜索。下面举个例子:

假设学习率a的取值范围在0.0001-1之间,我们如果随机均匀取值的话,90%的数值会落在0.1到1之间,0.0001到0.1之间只用了10%的资源区搜索(但是学习率恰恰有可能在小区间中取到最优)。这个时候采用对数标尺搜索,分别选取0.0001,0.001,0.01,0.1,1为标尺,在对数轴上面的均匀取点。

2 方差、偏差

方差:描述模型在不同训练集上预测的波动性和分散程度

偏差:描述模型预测值和真实值之间的差异,即准确性

模型在训练集和测试集上的表现会呈现出欠拟合(underfitting)、过拟合(overfitting)、适度拟合(just right)三种情况。在欠拟合中,模型会呈现高偏差,而在过拟合情况下,模型会出现高方差的情况,而适度拟合则是方差和偏差的均衡状态(也是模型的最好状态)

3 正则化

模型出现过拟合的情况,有两种解决方式,一是增加数据量,二是采用正则化来解决。正则化有多种实现方式,常用的方式为

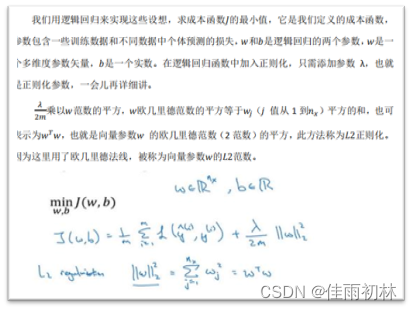

1.L2正则化

在逻辑回归中,我们通常正正则化高维矢量参数W,正则化的过程如下:

2.dropout正则化

dropout正则化的过程就是让神经网络中的神经元以一定概率随机失活

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1285

1285

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?