文章目录

一、朴素贝叶斯是什么

-

朴素贝叶斯法(NaiveBayes)是基于贝叶斯定理与特征条件独立假设的分类方法。对于给定的训练数据集,首先基于特征条件独立假设学习输入/输出的联合概率分布;然后基于此模型,对给定的输入x ,利用贝叶斯定理求出后验概率最大的输出 y 。

-

朴素:特征条件独立;贝叶斯:基于贝叶斯定理。属于监督学习的生成模型,实现简单,没有迭代,并有坚实的数学理论(即贝叶斯定理)作为支撑。在大量样本下会有较好的表现,不适用于输入向量的特征条件有关联的场景。

-

可能读完上面这段话仍旧没办法理解朴素贝叶斯法到底是什么,又是怎样进行分类的。下面我尽可能详细且直观地描述朴素贝叶斯法的工作原理。首先我们需要知道的是,朴素贝叶斯是基于概率论的分类算法。然后我们来了解几个统计学小概念。(我们将使用以下这个例子来贯穿全文进行讲解。)

-

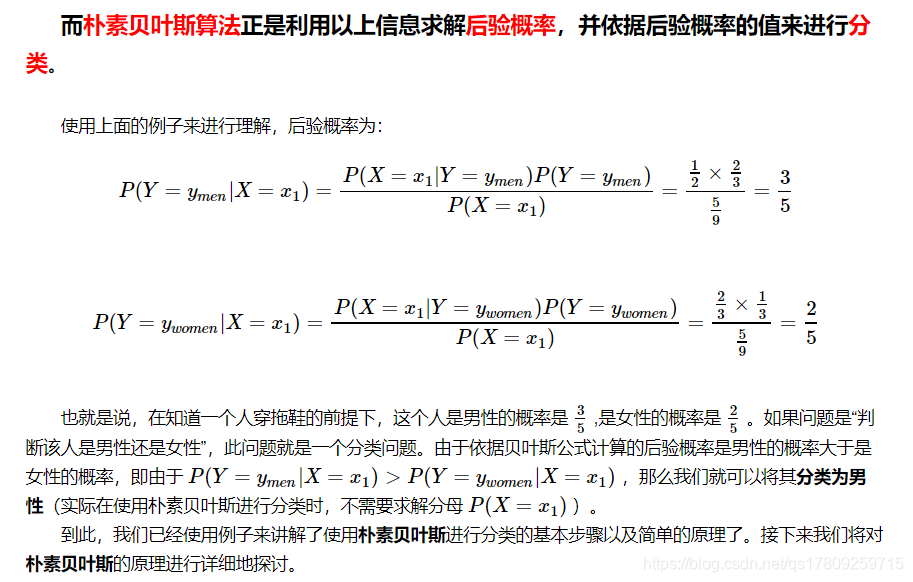

在夏季,某公园男性穿凉鞋的概率为 12 ,女性穿凉鞋的概率为 23 ,并且该公园中男女比例通常为 2:1

,问题:若你在公园中随机遇到一个穿凉鞋的人,请问他的性别为男性或女性的概率分别为多少?

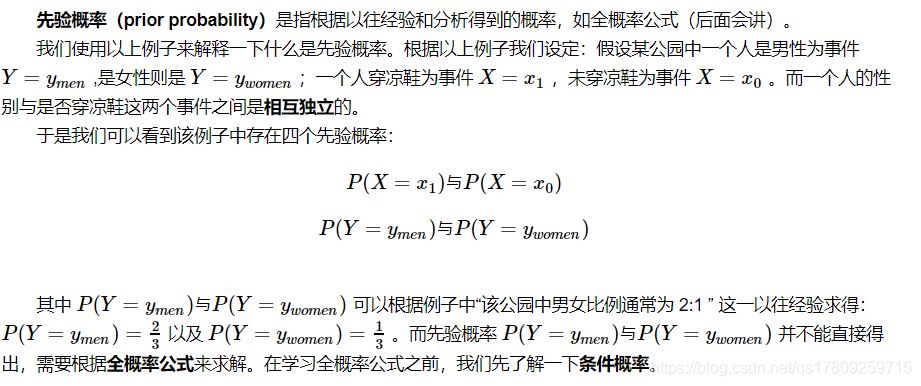

1.先验概率

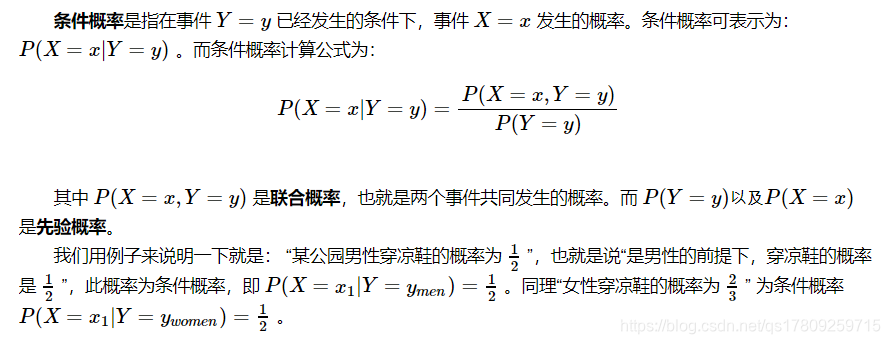

2.条件概率

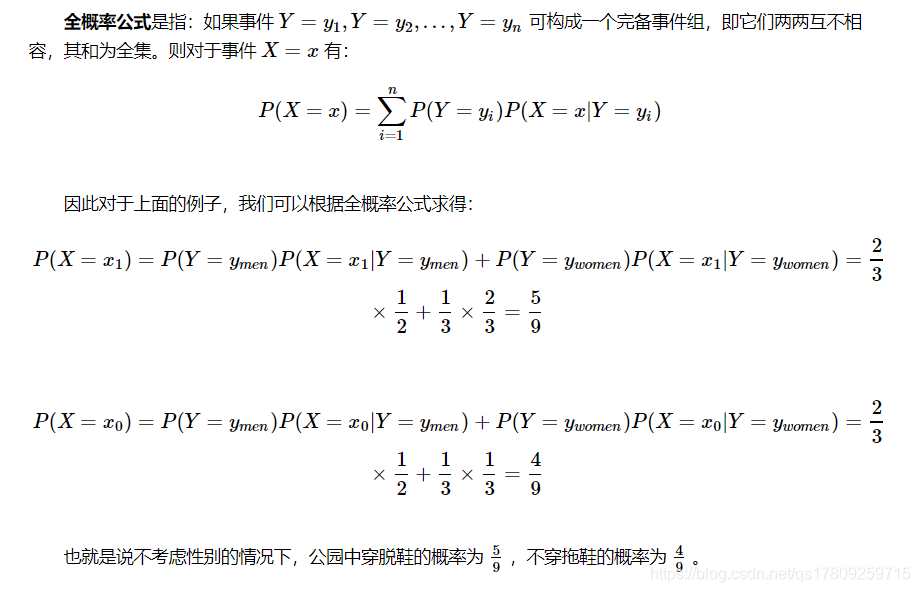

3.全概率公式

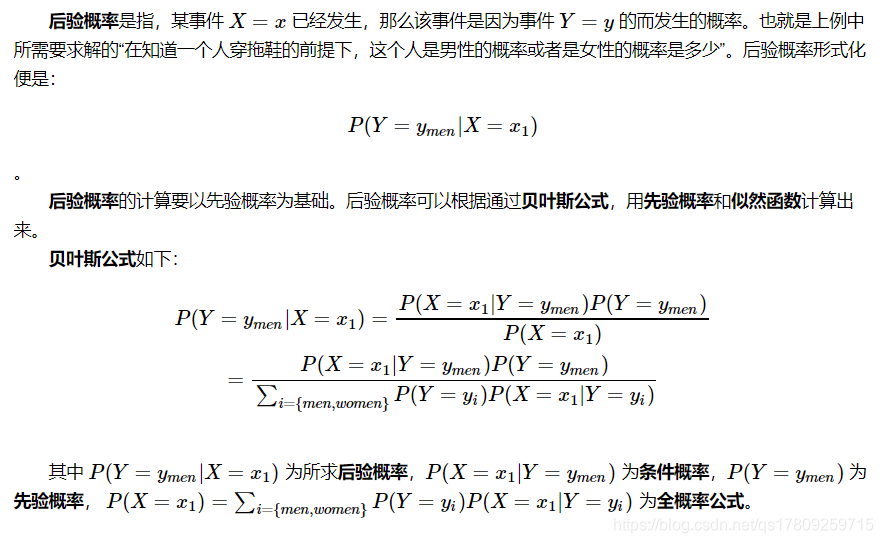

4.后验概率

5.后验概率最大的含义

二、朴素贝叶斯的思想

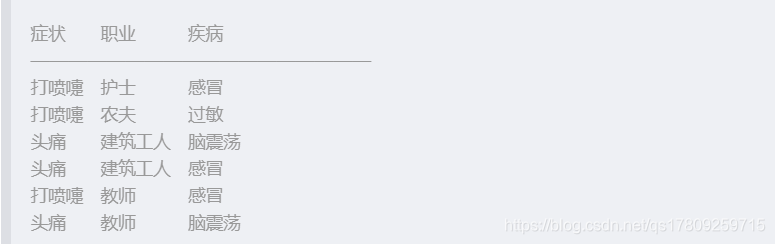

(1)病人分类的例子

某个医院早上收了六个门诊病人,如下表:

现在又来了第七个病人,是一个打喷嚏的建筑工人。请问他患上感冒的概率有多大?

- 根据贝叶斯定理:

P(A|B) = P(B|A) P(A) / P(B)

- 可得

P(感冒|打喷嚏x建筑工人)

= P(打喷嚏x建筑工人|感冒) x P(感冒) / P(打喷嚏x建筑工人)

- 假定”打喷嚏”和”建筑工人”这两个特征是独立的,因此,上面的等式就变成了

P(感冒|打喷嚏x建筑工人)

= P(打喷嚏|感冒) x P(建筑工人|感冒) x P(感冒) / P(打喷嚏) x P(建筑工人)

- 这是可以计算的。

P(感冒|打喷嚏x建筑工人)

= 0.66 x 0.33 x 0.5 / 0.5 x 0.33

= 0.66

因此,这个打喷嚏的建筑工人,有66%的概率是得了感冒。同理,可以计算这个病人患上过敏或脑震荡的概率。比较这几个概率,就可以知道他最可能得什么病。

这就是贝叶斯分类器的基本方法:在统计资料的基础上,依据某些特征,计算各个类别的概率,从而实现分类。

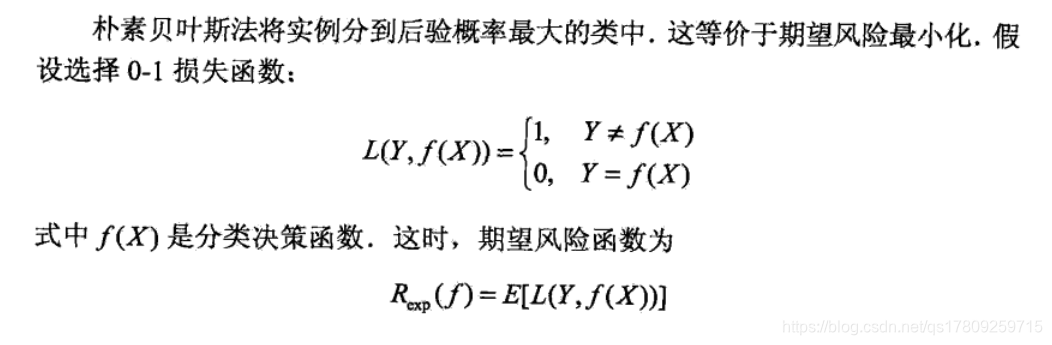

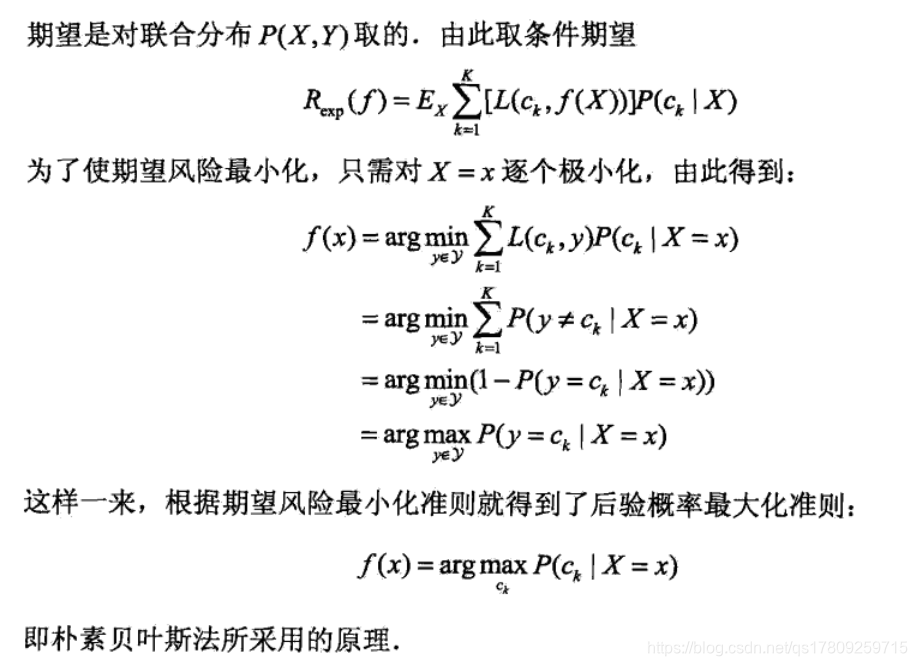

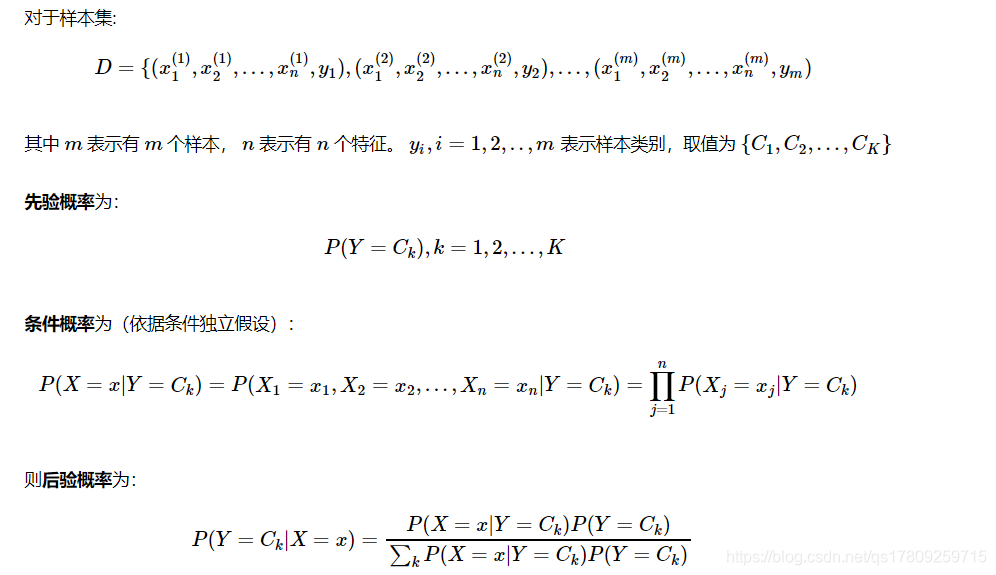

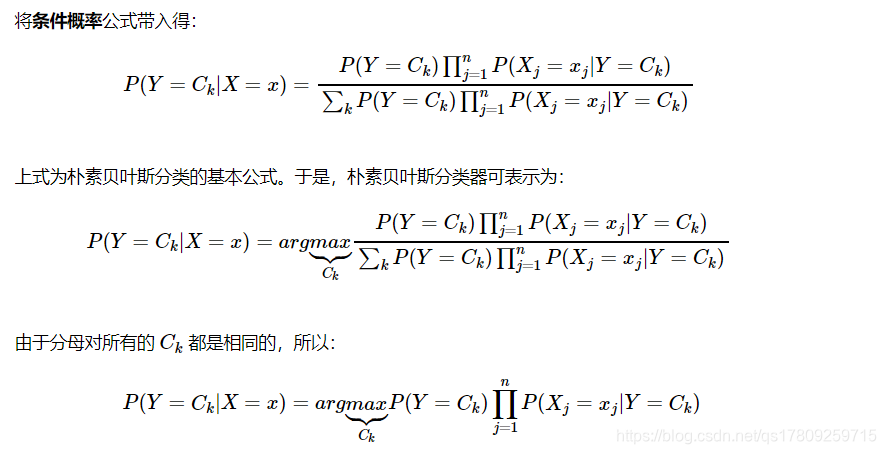

三、朴素贝叶斯的推导

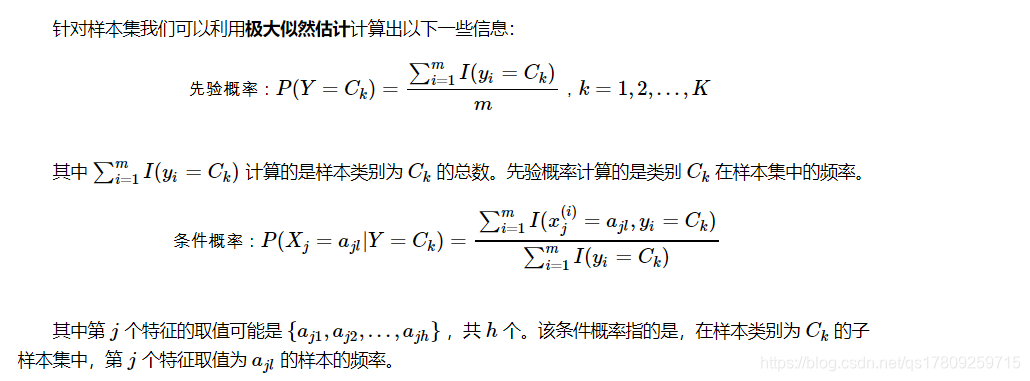

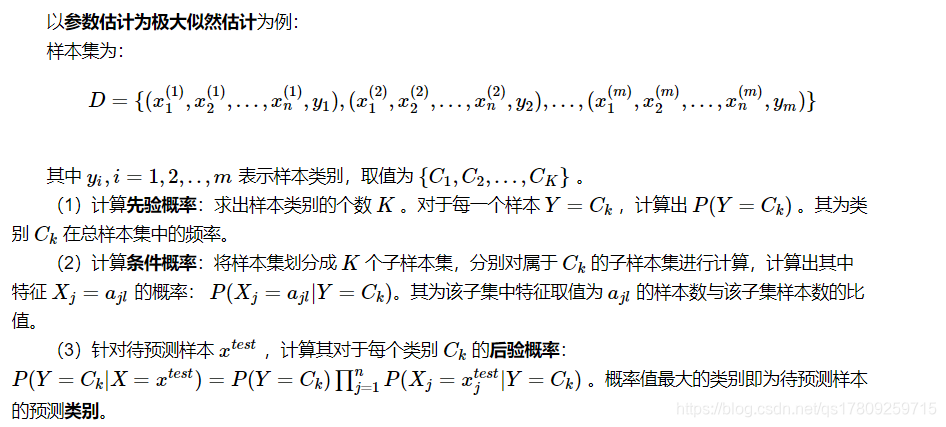

四、参数估计

1.极大似然估计

2.贝叶斯估计

五、朴素贝叶斯算法过程

六、朴素贝叶斯模型

朴素贝叶斯常用的三个模型有:

- 高斯模型:处理特征是连续型变量的情况

- 多项式模型:最常见,要求特征是离散数据

- 伯努利模型:要求特征是离散的,且为布尔类型,即true和false,或者1和0

七、朴素贝叶斯算法分析

优点:

- (1)朴素贝叶斯模型发源于古典数学理论,有稳定的分类效率。

- (2)对小规模的数据表现很好,能个处理多分类任务,适合增量式训练,尤其是数据量超出内存时,我们可以一批批的去增量训练。

- (3)对缺失数据不太敏感,算法也比较简单,常用于文本分类。

缺点:

-

(1)理论上,朴素贝叶斯模型与其他分类方法相比具有最小的误差率。但是实际上并非总是如此,这是因为朴素贝叶斯模型给定输出类别的情况下,假设属性之间相互独立,这个假设在实际应用中往往是不成立的,在属性个数比较多或者属性之间相关性较大时,分类效果不好。而在属性相关性较小时,朴素贝叶斯性能最为良好。对于这一点,有半朴素贝叶斯之类的算法通过考虑部分关联性适度改进。

-

(2)需要知道先验概率,且先验概率很多时候取决于假设,假设的模型可以有很多种,因此在某些时候会由于假设的先验模型的原因导致预测效果不佳。

-

(3)由于我们是通过先验和数据来决定后验的概率从而决定分类,所以分类决策存在一定的错误率。

-

(4)对输入数据的表达形式很敏感。

八、朴素贝叶斯的实际应用场景

- 文本分类

- 垃圾邮件过滤

- 病人分类

- 拼写检查

九、示例:使用朴素贝叶斯过滤垃圾邮件

数据集获取:

链接:https://pan.baidu.com/s/1yjUmdjDvgLmOURXiNzRCrA

提取码:a1oz

#!/usr/bin/env python

# -*- coding:utf-8 -*-

import numpy as np

import re

import random

"""

函数说明:将切分的实验样本词条整理成不重复的词条列表,也就是词汇表

Parameters:

dataSet - 整理的样本数据集

Returns:

vocabSet - 返回不重复的词条列表,也就是词汇表

"""

def createVocabList(dataSet):

vocabSet = set([]) # 创建一个空的不重复列表

for document in dataSet:

vocabSet = vocabSet | set(document) # 取并集

return list(vocabSet)

"""

函数说明:根据vocabList词汇表,将inputSet向量化,向量的每个元素为1或0

Parameters:

vocabList - createVocabList返回的列表

inputSet - 切分的词条列表

Returns:

returnVec - 文档向量,词集模型

"""

def setOfWords2Vec(vocabList, inputSet):

returnVec = [0] * len(vocabList) # 创建一个其中所含元素都为0的向量

for word in inputSet: # 遍历每个词条

if word in vocabList: # 如果词条存在于词汇表中,则置1

returnVec[vocabList.index(word)] = 1

else:

print("the word: %s is not in my Vocabulary!" % word)

return returnVec # 返回文档向量

"""

函数说明:根据vocabList词汇表,构建词袋模型

Parameters:

vocabList - createVocabList返回的列表

inputSet - 切分的词条列表

Returns:

returnVec - 文档向量,词袋模型

"""

def bagOfWords2VecMN(vocabList, inputSet):

returnVec = [0] * len(vocabList) # 创建一个其中所含元素都为0的向量

for word in inputSet: # 遍历每个词条

if word in vocabList: # 如果词条存在于词汇表中,则计数加一

returnVec[vocabList.index(word)] += 1

return returnVec # 返回词袋模型

"""

函数说明:朴素贝叶斯分类器训练函数

Parameters:

trainMatrix - 训练文档矩阵,即setOfWords2Vec返回的returnVec构成的矩阵

trainCategory - 训练类别标签向量,即loadDataSet返回的classVec

Returns:

p0Vect - 正常邮件类的条件概率数组

p1Vect - 垃圾邮件类的条件概率数组

pAbusive - 文档属于垃圾邮件类的概率

"""

def trainNB0(trainMatrix, trainCategory):

numTrainDocs = len(trainMatrix) # 计算训练的文档数目

numWords = len(trainMatrix[0]) # 计算每篇文档的词条数

pAbusive = sum(trainCategory) / float(numTrainDocs) # 文档属于垃圾邮件类的概率

p0Num = np.ones(numWords)

p1Num = np.ones(numWords) # 创建numpy.ones数组,词条出现数初始化为1,拉普拉斯平滑

p0Denom = 2.0

p1Denom = 2.0 # 分母初始化为2 ,拉普拉斯平滑

for i in range(numTrainDocs):

if trainCategory[i] == 1: # 统计属于侮辱类的条件概率所需的数据,即P(w0|1),P(w1|1),P(w2|1)···

p1Num += trainMatrix[i]

p1Denom += sum(trainMatrix[i])

else: # 统计属于非侮辱类的条件概率所需的数据,即P(w0|0),P(w1|0),P(w2|0)···

p0Num += trainMatrix[i]

p0Denom += sum(trainMatrix[i])

p1Vect = np.log(p1Num / p1Denom)

p0Vect = np.log(p0Num / p0Denom) # 取对数,防止下溢出

return p0Vect, p1Vect, pAbusive # 返回属于正常邮件类的条件概率数组,属于侮辱垃圾邮件类的条件概率数组,文档属于垃圾邮件类的概率

"""

函数说明:朴素贝叶斯分类器分类函数

Parameters:

vec2Classify - 待分类的词条数组

p0Vec - 正常邮件类的条件概率数组

p1Vec - 垃圾邮件类的条件概率数组

pClass1 - 文档属于垃圾邮件的概率

Returns:

0 - 属于正常邮件类

1 - 属于垃圾邮件类

"""

def classifyNB(vec2Classify, p0Vec, p1Vec, pClass1):

# p1 = reduce(lambda x, y: x * y, vec2Classify * p1Vec) * pClass1 # 对应元素相乘

# p0 = reduce(lambda x, y: x * y, vec2Classify * p0Vec) * (1.0 - pClass1)

p1 = sum(vec2Classify * p1Vec) + np.log(pClass1)

p0 = sum(vec2Classify * p0Vec) + np.log(1.0 - pClass1)

if p1 > p0:

return 1

else:

return 0

"""

函数说明:接收一个大字符串并将其解析为字符串列表

"""

def textParse(bigString): # 将字符串转换为字符列表

listOfTokens = re.split('\\W+', bigString) # 将特殊符号作为切分标志进行字符串切分,即非字母、非数字

return [tok.lower() for tok in listOfTokens if len(tok) > 2] # 除了单个字母,例如大写的I,其它单词变成小写

"""

函数说明:测试朴素贝叶斯分类器,使用朴素贝叶斯进行交叉验证

"""

def spamTest():

docList = []

classList = []

fullText = []

for i in range(1, 26): # 遍历25个txt文件

wordList = textParse(open('email/spam/%d.txt' % i, 'r').read()) # 读取每个垃圾邮件,并字符串转换成字符串列表

docList.append(wordList)

fullText.append(wordList)

classList.append(1) # 标记垃圾邮件,1表示垃圾文件

wordList = textParse(open('email/ham/%d.txt' % i, 'r').read()) # 读取每个非垃圾邮件,并字符串转换成字符串列表

docList.append(wordList)

fullText.append(wordList)

classList.append(0) # 标记正常邮件,0表示正常文件

print(docList)

vocabList = createVocabList(docList) # 创建词汇表,不重复

print(vocabList)

trainingSet = list(range(50))

testSet = [] # 创建存储训练集的索引值的列表和测试集的索引值的列表

for i in range(10): # 从50个邮件中,随机挑选出40个作为训练集,10个做测试集

randIndex = int(random.uniform(0, len(trainingSet))) # 随机选取索索引值

testSet.append(trainingSet[randIndex]) # 添加测试集的索引值

del (trainingSet[randIndex]) # 在训练集列表中删除添加到测试集的索引值

trainMat = []

trainClasses = [] # 创建训练集矩阵和训练集类别标签系向量

for docIndex in trainingSet: # 遍历训练集

trainMat.append(setOfWords2Vec(vocabList, docList[docIndex])) # 将生成的词集模型添加到训练矩阵中

trainClasses.append(classList[docIndex]) # 将类别添加到训练集类别标签系向量中

p0V, p1V, pSpam = trainNB0(np.array(trainMat), np.array(trainClasses)) # 训练朴素贝叶斯模型

errorCount = 0 # 错误分类计数

for docIndex in testSet: # 遍历测试集

wordVector = setOfWords2Vec(vocabList, docList[docIndex]) # 测试集的词集模型

if classifyNB(np.array(wordVector), p0V, p1V, pSpam) != classList[docIndex]: # 如果分类错误

errorCount += 1 # 错误计数加1

print("分类错误的测试集:", docList[docIndex])

print('错误率:%.2f%%' % (float(errorCount) / len(testSet) * 100))

if __name__ == '__main__':

spamTest()

参考文档:

[1]《统计学习方法》李航著

[2]《机器学习实战》Peter Harrington著

[3]https://blog.youkuaiyun.com/fuqiuai/article/details/79458943

本文详细介绍朴素贝叶斯算法的原理与应用,包括其基本思想、数学推导及参数估计等内容。并通过一个具体的垃圾邮件过滤示例展示了算法的具体实现过程。

本文详细介绍朴素贝叶斯算法的原理与应用,包括其基本思想、数学推导及参数估计等内容。并通过一个具体的垃圾邮件过滤示例展示了算法的具体实现过程。

902

902

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?