论文:https://arxiv.org/pdf/2406.11277

代码:https://github.com/RUCAIBox/HaluAgent

领域:agent、幻觉检测

机构:中国人民大学高瓴人工智能学院

发表/arxiv:arxiv

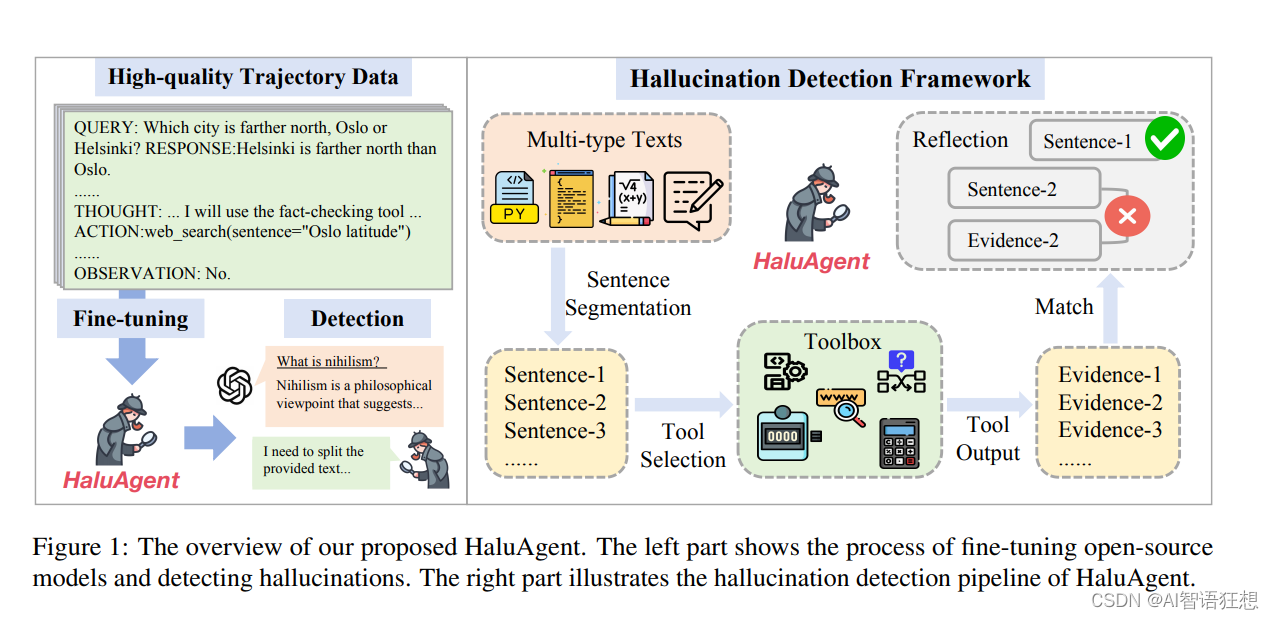

该篇论文提出了HaluAgent框架,这是一个为小型语言模型(LLMs)设计的agent系统,它通过集成多功能工具箱和细粒度的三阶段检测流程(句子分割、工具选择与验证、反思),以及记忆机制,显著提升了这些模型在检测文本、代码和数学表达式中的幻觉现象的能力。该框架利用现有中英文数据集合成检测轨迹进行微调,使得经过少量样本(2K)训练的HaluAgent在多种任务和数据集上的幻觉检测性能达到或超越了依赖于强大闭源模型GPT-4的现有方法,展示了小型开源模型在经过适当训练后,也能在复杂的幻觉检测任务中表现出色。

摘要(Abstract)

- 背景:大型语言模型(LLMs)在生成文本时可能会出现幻觉(hallucinations),即看似合理但实际上没有事实支持的内容。这对于LLMs在现实世界的应用构成了挑战。

- 现有方法:现有研究依赖于强大的闭源LLMs(如GPT-4)进行幻觉检测。

- HaluAgent:本文提出的HaluAgent框架允许相对较小的LLMs(例如Baichuan2-Chat 7B)主动选择适当的工具来检测多种类型的幻觉,如文本、代码和数学表达式。

- 方法:HaluAgent集成了LLM、多功能工具箱,并设计了一个细粒度的三阶段检测框架以及记忆机制。

- 实验:使用2000个样本对LLMs进行微调,HaluAgent在各种任务和数据集上进行幻觉检测,达到了与GPT-4相当的性能,甚至在某些情况下更高。

引言(Introduction)

- LLMs的挑战:LLMs在自然语言处理领域展现出卓越能力,但生成文本中的幻觉问题仍是一个隐患。

- 现有检测方法:分为两类,一类依赖于LLMs的内部知识,另一类通过使用外部工具(如搜索引擎)来扩展检测能力。

方法(Approach)

Figure 1提供了HaluAgent框架的概览,展示了其在幻觉检测流程中的关键组件和步骤。

-

Fine-tuning & Detection Overview (上半部分): 这部分展示了使用高质量检测轨迹数据对开源模型进行微调的过程,以及HaluAgent检测幻觉的流程。

- High-quality Trajectory Data

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

45

45

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?