流处理:

1. Environment

1.1 getExecutionEnvironment

创建一个执行环境,表示当前执行程序的上下文。 如果程序是独立调用的,则此方法返回本地执行环境;如果从命令行客户端调用程序以提交到集群,则此方法返回此集群的执行环境,也就是说,getExecutionEnvironment 会根据查询运行的方式决定返回什么样的运行环境,是最常用的一种创建执行环境的方式。

(1)

val env: ExecutionEnvironment = ExecutionEnvironment. getExecutionEnvironment(2)

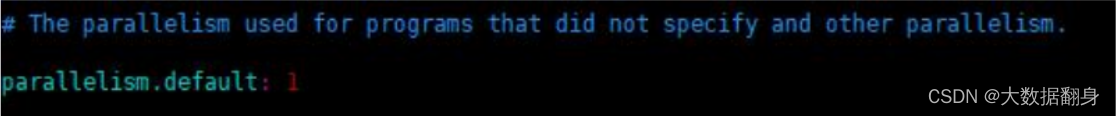

val env = StreamExecutionEnvironment. getExecutionEnvironment如果没有设置并行度,会以 flink-conf.yaml 中的配置为准,默认是 1。

1.2. createLocalEnvironment

返回本地执行环境,需要在调用时指定默认的并行度。

val env = StreamExecutionEnvironment.createLocalEnvironment(1)1.3. createRemoteEnvironment

返回集群执行环境,将 Jar 提交到远程服务器。需要在调用时指定 JobManager的 IP 和端口号,并指定要在集群中运行的 Jar 包。

val env = ExecutionEnvironment.createRemoteEnvironment("jobmanage-hostname",6123,"YOURPATH//wordcount.jar")2. Source

2.1 从集合读取数据

// 定义样例类,传感器 id ,时间戳,温度

case class SensorReading(id: String, timestamp: Long, temperature: Double)

object Sensor {

def main(args: Array[String]): Unit = {

val env = StreamExecutionEnvironment.getExecutionEnvironment

val stream1 = env

.fromCollection(List(

SensorReading("sensor_1", 1547718199, 35.8),

SensorReading("sensor_6", 1547718201, 15.4),

SensorReading("sensor_7", 1547718202, 6.7),

SensorReading("sensor_10", 1547718205, 38.1)

))

stream1.print("stream1:").setParallelism(1)

env.execute()

}

}2.2 从文件读取数据

val stream2 = env.readTextFile("YOUR_FILE_PATH")2.3 以 kafka 消息队列的数据作为来源

需要引入 kafka 连接器的依赖:

pom.xml

<!--

https://mvnrepository.com/artifact/org.apache.flink/flink-connector-kafka-0.11

-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka-0.11_2.12</artifactId>

<version>1.10.1</version>

</dependency>具体代码如下:

val properties = new Properties()

properties.setProperty("bootstrap.servers", "localhost:9092")

properties.setProperty("group.id", "consumer-group")

properties.setProperty("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer")

properties.setProperty("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer")

properties.setProperty("auto.offset.reset", "latest")

val stream3 = env.addSource(new FlinkKafkaConsumer011[String]("sensor", new SimpleStringSchema(), properties))2.4 自定义 Source

除了以上的 source 数据来源,我们还可以自定义 source。需要做的,只是传入一个 SourceFunction 就可以。具体调用如下:

val stream4 = env.addSource( new MySensorSource() )我们希望可以随机生成传感器数据,MySensorSource 具体的代码实现如下:

class MySensorSource extends SourceFunction[SensorReading]{

// flag: 表示数据源是否还在正常运行

var running: Boolean = true

override def cancel(): Unit = {

running = false

}

override def run(ctx: SourceFunction.SourceContext[SensorReading]): Unit

= {

// 初始化一个随机数发生器

val rand = new Random()

var curTemp = 1.to(10).map(

i => ( "sensor_" + i, 65 + rand.nextGaussian() * 20 )

)

while(running){

// 更新温度值

curTemp = curTemp.map(

t => (t._1, t._2 + rand.nextGaussian() )

)

// 获取当前时间戳

val curTime = System.currentTimeMillis()

curTemp.foreach(

t => ctx.collect(SensorReading(t._1, curTime, t._2))

)

Thread.sleep(100)

}

}

}3. Transform

转换算子

1443

1443

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?