1. 数值稳定性

神经网络的梯度

向量对向量求导(梯度)得到矩阵,太多的矩阵进行乘法会导致常见的两个问题

梯度消失和梯度爆炸 MLP MLP使用ReLU作为激活函数 梯度爆炸的问题 输入很大的时候梯度接近为0 梯度消失 梯度消失的问题

只能训练比较浅的神经网络 (底层训练不到)

总结

2. 模型初始化和激活函数

让训练更加稳定

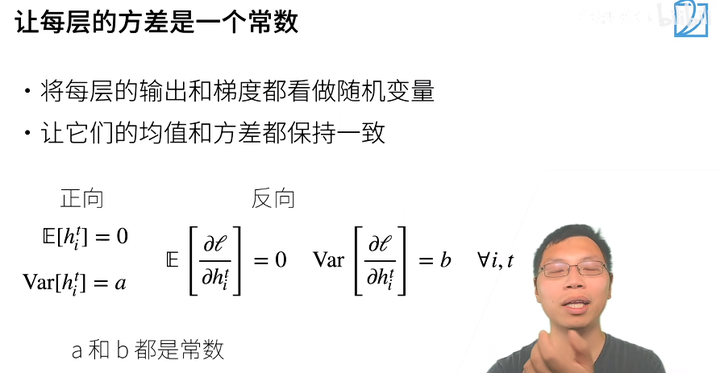

让每层的方差是一个常数

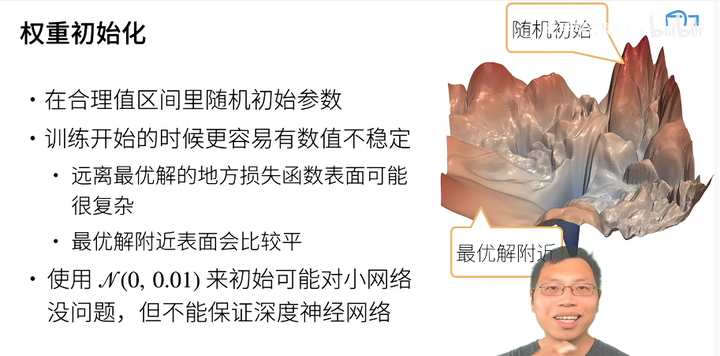

权重初始化

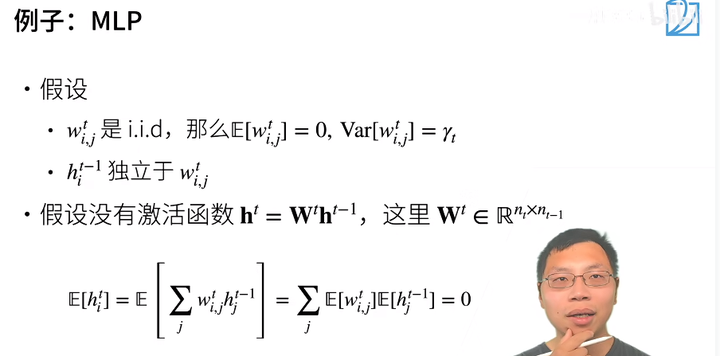

例子:MLP

当前层的权重独立于当前层的输入

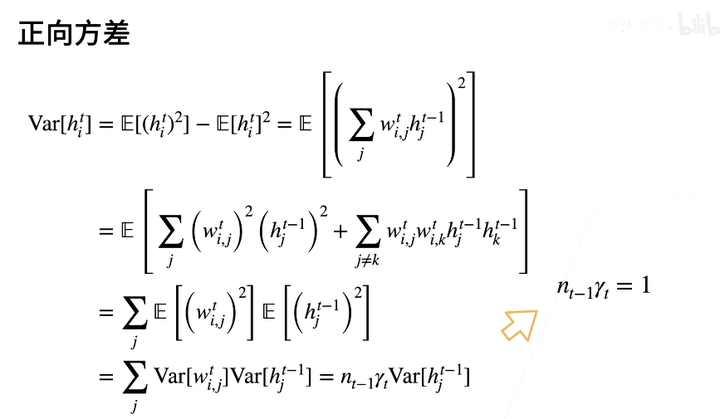

正向方差

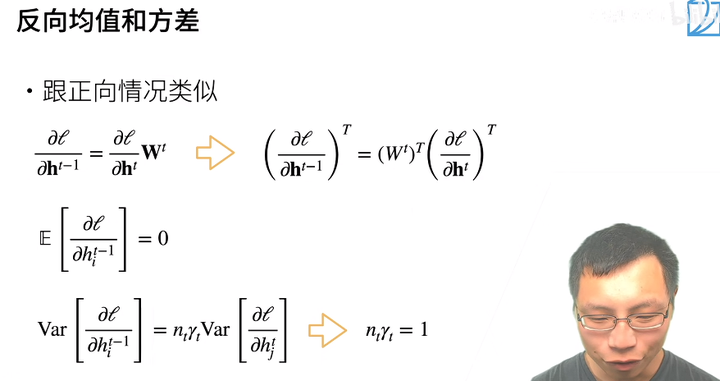

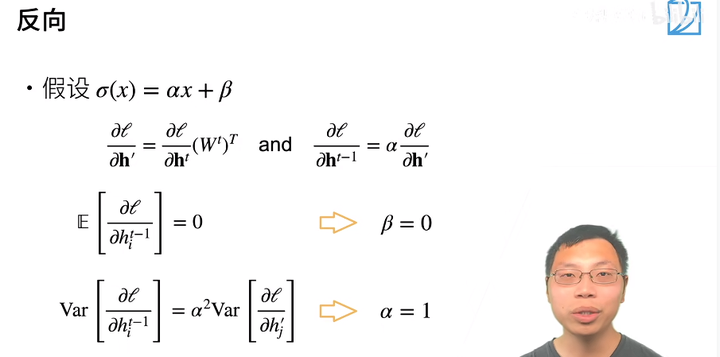

反向均值和方差

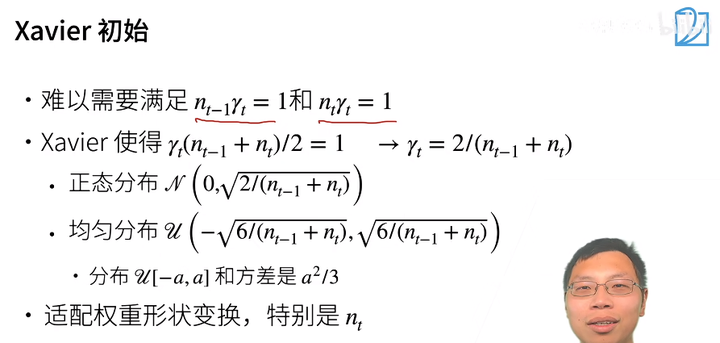

Xavier初始

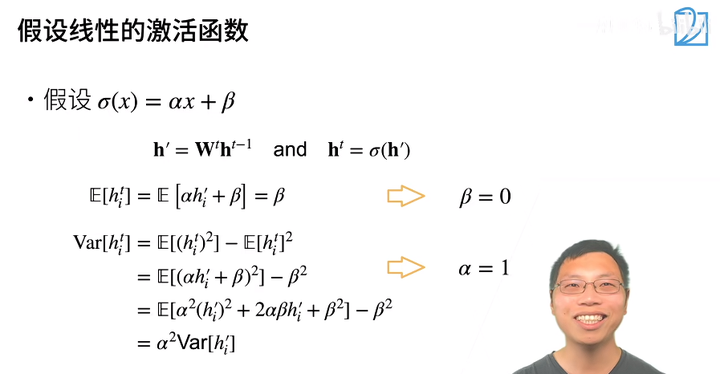

线性激活函数

反向

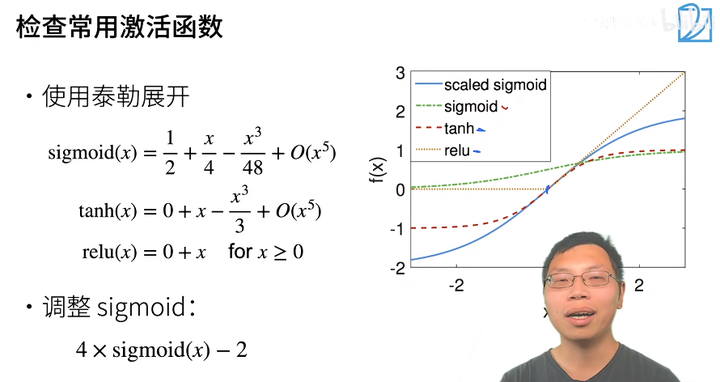

常用激活函数

总结

这一节听不懂了家人们,先这么着,回来懂了再回补

本文探讨了神经网络中的关键问题,如梯度消失和梯度爆炸,尤其关注ReLU激活函数的影响。强调了权重初始化的重要性,如Xavier初始方法,以及如何通过调整模型初始化和激活函数来提高训练稳定性,使深层网络得以训练。

本文探讨了神经网络中的关键问题,如梯度消失和梯度爆炸,尤其关注ReLU激活函数的影响。强调了权重初始化的重要性,如Xavier初始方法,以及如何通过调整模型初始化和激活函数来提高训练稳定性,使深层网络得以训练。

https://zhuanlan.zhihu.com/p/685154434

https://zhuanlan.zhihu.com/p/685154434

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?